Command Palette

Search for a command to run...

積極的な監視を主張するダリオ・アモデイ氏は、OpenAIを去った後、AIの安全性を同社の使命に組み入れた。

コンピューティング能力の獲得競争、巨大テック企業間の競争、そして投資の加速に煽られた現在のAIサイクルにおいて、アントロピックの共同創業者兼CEOであるダリオ・アモデイ氏は、シリコンバレーにおいてごく少数ながら、紛れもない「逆張り」の一人です。多くのテック企業が「より迅速なイテレーションとより強力な機能」を中核目標として優先する中、彼は常に、ますます説得力のある判断を貫いています。「安全はブレーキではなく、業界が前進し続けることを可能にする唯一の制度的安全障壁です。」

ダリオ・アモデイ氏によると、今後 5 年間の大規模モデル機能の爆発的な成長は、必然的に社会統治メカニズムの進化を上回ることになるだろう。トップダウンのセキュリティ ガバナンス フレームワークがなければ、AI 開発は危険な「複雑性の反動サイクル」に陥ってしまいます。— 技術の急速な発展はガバナンス体制を完全に圧倒し、最終的にはリスクが体系的な脅威として蓄積され、個々の企業の危機につながるだけでなく、社会全体の運営を混乱させる可能性もあります。

この技術とガバナンスの乖離の出発点に立ち返ると、「セキュリティは決してイノベーションの対極にあるのではなく、AIが国家インフラの一部となった後も継続的な進化を維持できるようにする唯一の根底にある論理である」という核心的な主張は、ある事実を裏付けているように思われる。ダリオ・アモデイ氏が提唱しているのは「セキュリティ重視のアプローチ」ではなく、AI時代のための「論理プロトコル」である。これは、技術拡大のための制御可能、監査可能、そして停止可能な運用上の前提条件を事前に設定することで、能力の成長がシステムリスクによって突然中断されることを防ぐ。本質的に、この視点はイノベーションに反対し、それを減速させるのではなく、AIの長期的な商業的拡大を安定的に支える基盤を提供する。

OpenAI からの脱退から Anthropic の創設まで: 価値観の分割後の「独立宣言」。

ダリオ・アモデイ氏と「安全ルート」との深い関わりは、彼が OpenAI に在籍していた頃、同社の中核的価値観に同意しなかったことにまで遡ることができる。

2020年頃、GPTシリーズモデルの急速な商用化に伴い、OpenAIは技術の反復と商用化の取り組みを加速しましたが、対応するリスク管理メカニズムとガバナンスシステムはまだ明確に定義されていません。

2023年、ニューヨーク・タイムズ紙がOpenAIをはじめとする企業を相手取り著作権侵害訴訟を起こした後、OpenAI内部の一部研究者は、急速な商業化のペースに既に不安を抱いていました。しかし、ダリオ・アモデイ氏は数年前からこの状況を予見しており、社内におけるより厳格なリスク評価メカニズムの導入を最初に提唱した主要人物の一人でした。彼は、モデルの反復処理の前にリスク予測ステップを追加し、商業化前の安全性試験プロセスを改善することを提唱しました。しかし、制度的発展に傾倒していたこれらの提案は、企業からの商業化圧力の高まりによって徐々に抑制されていきました。

ダリオ・アモデイ氏は、内部組織提案が何度も挫折した後、2021年にOpenAIを正式に退社し、Anthropicを設立した。彼らがビジネスを始めるために会社を離れた背景には、安全性と商業化のどちらを優先するかという哲学の不均衡があることは容易に理解できます。

アンスロピックのミッションステートメントは、この視点の違いを明確に反映しています。業界でよく使われる「強力なAIを構築する」というフレーズではなく、「信頼性が高く、解釈可能で、操作可能なAIシステムを構築します」と明確に述べています。

当時、シリコンバレーの主流は依然として「能力こそが優位性」という考え方で、ほぼすべての企業がモデルパラメータの規模、コンピューティング能力への投資、そしてアプリケーションの導入スピードで競争していました。しかし、ダリオ・アモデイはそれとは逆の道を選んだのです。 「制御可能性」を将来の競争の中核と捉えたこの一見直感に反する選択は、Anthropic のその後のセキュリティ戦略の実装の概念的基礎全体を築きました。

「セキュリティは戦略である」という考え方の基本論理は、機能が向上するにつれて、ガバナンスも連動して向上する必要があるというものです。

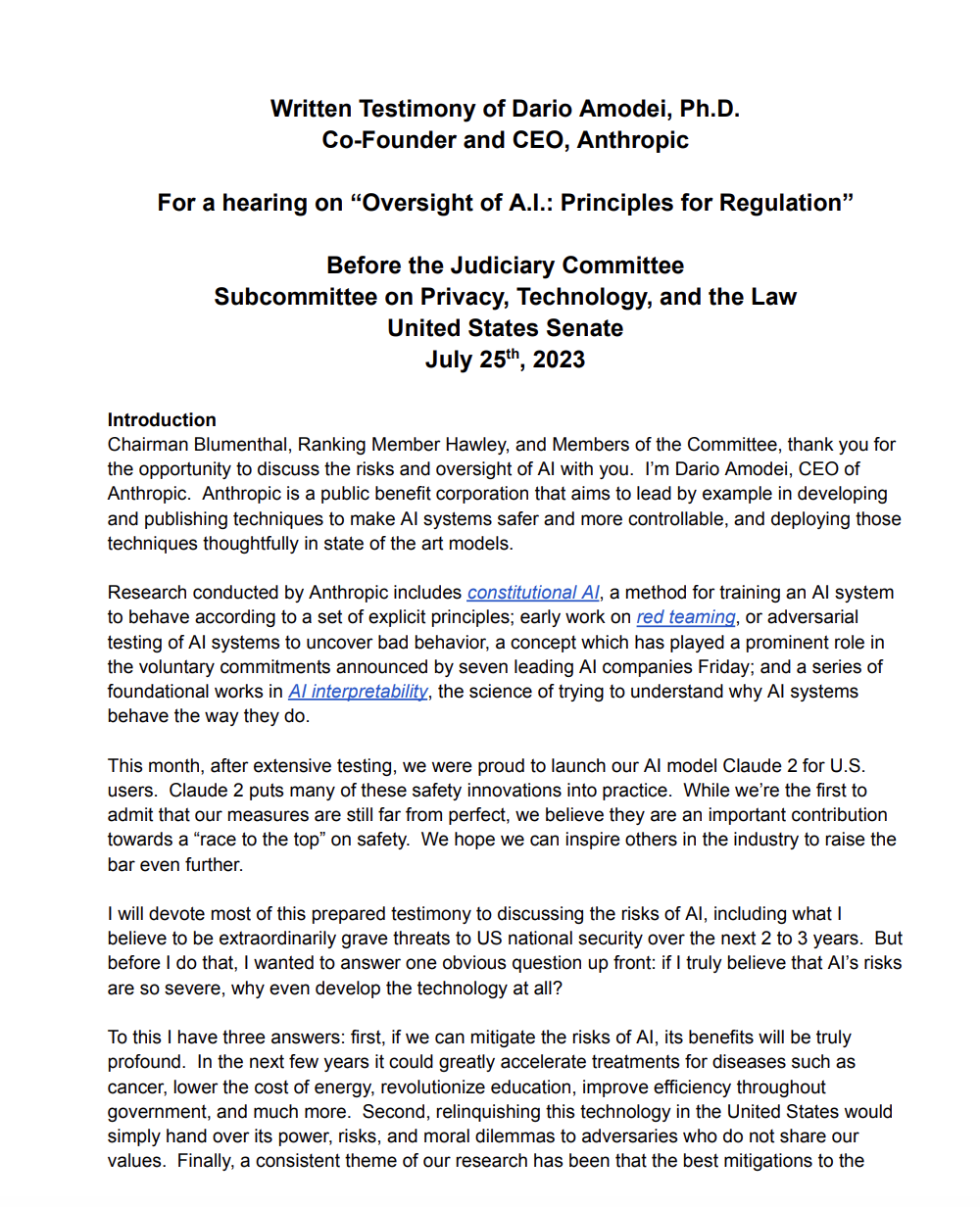

「倫理的安全性」を技術報告書の単なる装飾やユーザー獲得のためのセールスポイントとして扱う多くのテクノロジー企業とは異なり、ダリオ・アモデイ氏は高度に設計された「安全戦略フレームワーク」を推進しています。AIのリスクと規制に関する米国上院への書面証言の中で、彼は次のように強調しました。「次世代モデルの能力を完全に予測することはできないため、リスク発生後に状況を改善しようとするのではなく、モデルを構築する前に段階的な制度的安全策を確立する必要がある。」

この概念に基づいて、Anthropic は完全な「機能とセキュリティの共進化モデル」を構築し、技術開発のあらゆる側面にセキュリティ ガバナンスを組み込んでいます。

* 能力予測:履歴データとアルゴリズム モデルを使用することで、次世代の大規模モデルに出現する可能性のある新しい機能、特に、より正確な偽情報の生成や、より複雑なコードの作成 (サイバー攻撃に使用される可能性がある) など、潜在的なリスクをもたらす可能性のある機能を事前に評価できます。

* 安全レベル:原子力産業のリスクレベルシステムを参考に、モデルの能力の強さと適用シナリオに応じて異なる安全レベルに分けられ、各レベルは異なる試験基準、使用許可、監視メカニズムに対応しています。

* 外部レッドチームと解釈可能性の要件:攻撃テストのために、さまざまな機関や分野からの外部レッドチームの導入を強制するとともに、「ブラックボックスの意思決定」によってもたらされるリスクを回避するために、モデルが主要な意思決定プロセスに解釈可能な論理チェーンを提供することを要求します。

* Go/No-goゲート:モデルの反復における主要なノードに「許可/禁止」ゲートを設定します。セキュリティテストが基準を満たし、リスク評価に合格した場合にのみ、次の開発段階または展開を許可します。「拡張は制御可能な場合にのみ許可される」という原則を明確に定義します。

この体系的なセキュリティアーキテクチャにより、ダリオ・アモデイ氏は米国の政策立案者から「ガバナンスをより深く理解するテクノロジーCEO」とみなされるようになりました。2023年7月、米国上院がAIインサイトフォーラムを開催した際、彼は公聴会への参加を特別に招待されました。「段階的規制」と「事前リスク予測」に関する彼の見解は、その後のAIセキュリティ法に関する議論において、最も頻繁に引用される技術関係者の意見の一つとなりました。

シリコンバレーの企業のほとんどがセキュリティを自社のイメージを高めるための広報資産として扱っているのに対し、ダリオ・アモデイ氏はセキュリティを「業界の長期的な発展を推進する」オペレーティングシステムと捉えています。安定したセキュリティフレームワークを確立することによってのみ、AI が真に「研究室の技術」から「社会インフラ」へと移行できると彼は固く信じています。

なぜ「早期規制」にこだわるのでしょうか?テクノロジーは非線形成長の時代に入りました。

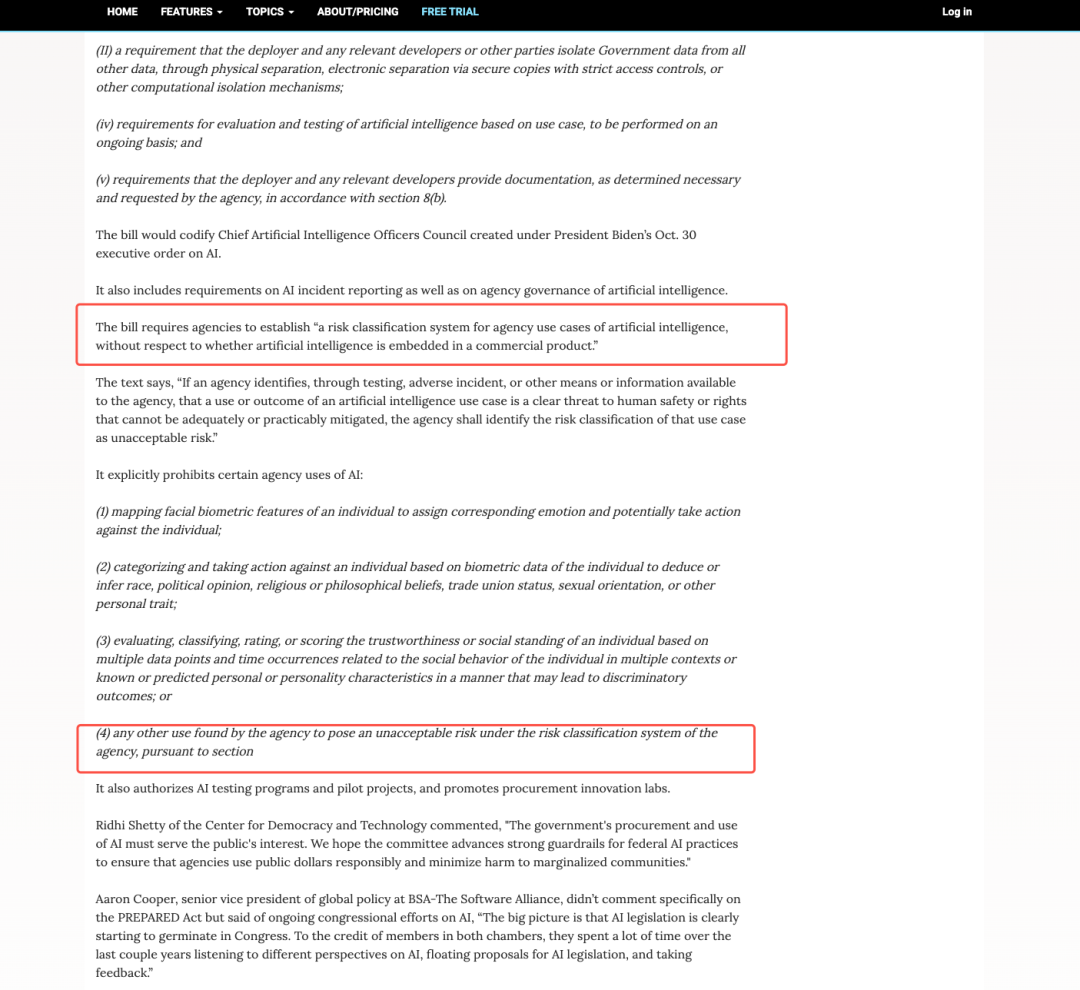

ダリオ・アモデイ氏の見解の中で最も物議を醸しているのは、技術連携へのアプローチではなく、むしろ規制に対する姿勢である。「規制は、リスクが顕在化してから受動的に対応するのではなく、事前に導入されなければならない」という主張は、シリコンバレーの長年の「規制は少なく、自由は多く」という文化とは対照的だが、彼の論理はAI技術の発展パターンに対する深い理解に根ざしており、それは主に以下の3つの側面から生まれている。

モデル機能は指数関数的に成長しますが、規制は線形です。

2020年に約1750億のパラメータを持つGPT-3から、2023年には機能が飛躍的に向上したGPT-4(パラメータサイズは公表されていないが、5000億から1兆の範囲と推測する声が多い)、そして2024年にはAnthropicのClaude 3(複数のベンチマークテストで前任者を上回った)まで、大規模モデルの各世代の機能は飛躍的に向上し、コードの自律最適化、複雑な法律文書の理解、専門家レベルの研究論文の生成など、以前のモデルにはなかった多くの「予想外の機能」が実現されています。この成長は「非線形」であり、多くの場合、業界の期待を超えています。

しかし、規制制度を確立するには、調査、議論、立法、実施など複数の段階が必要であり、そのプロセスには通常何年もかかります。「線形」特性を示します。規制が常に技術に従うと、「能力は整っているがガバナンスが整っていない」という真空状態が生まれ、この真空状態の期間中にリスクが蓄積される可能性があります。

リスクはアプリケーション層の問題ではなく、基本的な機能の問題です。

AIのリスクは、特定のシナリオにおけるフィルタリングルールの設定など、「アプリケーションレベルの制御」によって軽減できると多くの人が考えています。しかし、ダリオ・アモデイ氏は次のように指摘しています…大規模モデルのリスクは本質的に「基本的な能力の問題」です。— 致命的な情報の生成、生物学的リスクの自動化(危険な生物学的実験計画の生成など)、ネットワーク侵入機能(悪意のあるコードの作成など)などの機能はすべて、アプリケーション シナリオではなく、モデルの基本機能から生まれます。

これは、特定のアプリケーションシナリオにおいてリスクが軽減されたとしても、モデルは依然としてその基盤となる機能を悪用し、他のシナリオにおいて新たなリスクを生み出す可能性があることを意味します。したがって、アプリケーション層の制御だけではリスクを排除することはできません。セキュリティの閾値は、規制を通じて基盤モデルレベルで確立する必要があります。

市場競争はその拡大を自ら規制することはできない。

ダリオ・アモデイ氏は業界カンファレンスで繰り返し、「AI業界における競争はプレッシャー効果を伴います。ベンダーは自発的に機能改善のペースを落とすことはありません。一度遅れをとれば、市場から淘汰される可能性があるからです」と強調してきました。このような競争環境において「自己規律」はほぼ不可能であり、企業は安全性テストを最小限に抑えながら、機能改善を優先する傾向があります。

したがって、彼は規制は「外部からの拘束力のある制約」にならなければなりません。業界全体に統一された安全性のベースラインを設定し、企業が悪貨が良い貨幣を追いかける悪循環に陥らないようにします。つまり、「貴社がセキュリティ テストを行わないなら、私も行いません。そうしないと、コストが高くなり、速度が低下します。」という悪循環に陥らないようにします。

これらの理由の背後には、AI 時代に対するダリオ・アモデイ氏の核心的な判断があります。AIは、インターネット時代の「コンテンツ製品」(ソーシャルソフトウェアやビデオプラットフォームなど)ではなく、現実世界の意思決定やリスク構造に直接影響を与えることができる「インフラストラクチャテクノロジー」です。電力や交通機関の場合と同様に、これらの種類のテクノロジーに対する早期規制は、「イノベーションを制限する」ことではなく、「イノベーションの持続可能性を確保する」ことが目的です。

技術的アプローチ: 憲法 AI はパッチ適用ではなく、モデルの動作メカニズムの再構築を目的としています。

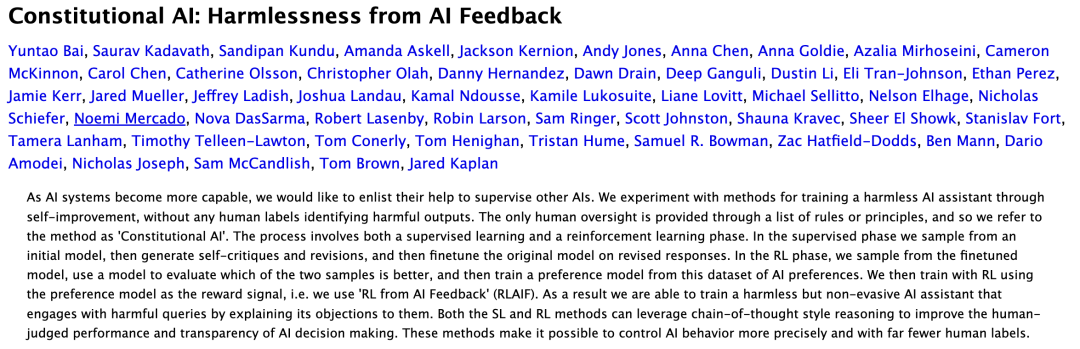

OpenAIが「商業的にリードしている」と評価され、Metaが「オープンソースのエコシステムが支配している」と評価され、Google DeepMindが「研究とエンジニアリングの二重アプローチ」と評価されるならば、Anthropic のキャッチフレーズは非常に明確です。「Alignment-as-Engineering」。 これは、体系的なエンジニアリングアプローチを用いて、AIモデルの行動が人間の価値観と一致するようにすることを意味します。その最も代表的な成果は、ダリオ・アモデイ氏のリーダーシップの下で開発された憲法AI(CAI)です。

論文リンク:https://arxiv.org/abs/2212.08073

Constitutional AIの核となる考え方は、従来のアライメントアプローチを覆すものです。人間のアノテーターによる主観的な価値判断に頼って行動を調整するのではなく、モデルはオープンで監査可能かつ再現可能な「憲法原則」に基づいて自己調整を行います。この「憲法」は、倫理学者、法律専門家、社会科学者と共同でAnthropicチームが開発したもので、「有害な情報を生成しない」、「多様な価値観を尊重する」、「不確かな問題について誠実である」といった数百もの基本原則が含まれています。

実際の応用において、憲法AIは2つの重要なステップを通じて整合を実現します。まず、モデルは「憲法」に基づいて生成したコンテンツを「自己批判」し、原則に適合していない領域を特定します。次に、モデルはこの「自己批判」の結果に基づいて自己修正を行い、出力コンテンツを継続的に最適化します。このアプローチは、以下の3つの重要な効果をもたらします。

* RLHF の値のバイアスを減らす:従来の RLHF (人間のフィードバックに基づく強化学習) は人間の注釈者の判断に依存していますが、注釈者によって価値観の偏り (文化的背景や個人的な立場の違いなど) が生じる可能性があります。一方、統一された「憲法原則」に基づく憲法 AI は、そのような偏りを大幅に削減します。

* 調整プロセスは透明性があり追跡可能です。「憲法原則」は公開されており、モデルの自己調整プロセスも記録および監査可能であるため、モデルが特定の決定を下す理由を外部が明確に理解でき、「ブラックボックス調整」を回避できます。

* セキュリティを、人間の直感に基づいたパッチではなく、「システム エンジニアリング」プロセスにします。従来のセキュリティ対策では、「問題が発生した脆弱性にパッチを当てる」ことが多くありましたが、Constitutional AI はモデルの動作メカニズムを根本から再構築し、セキュリティを外部から追加したパッチではなく、モデルの「本能」にしています。

この技術的アプローチは、Claudeのモデルが2024~2025年に実稼働レベルのアプリケーションに導入される上での重要な利点、すなわち、より高い安定性、優れた制御性、そしてエンタープライズ規模の導入の容易さを直接的に実現します。多くの金融機関、法律事務所、政府機関は、大規模モデルを選択する際にClaudeの「制御性」を主要な要素と見なしています。これらの分野ではリスク許容度が極めて低く、安定的で予測可能なモデル出力が求められるためです。

世界のAI業界において、Amodeiの戦略はますます価値を高めています。同社のモデル機能が金融リスク評価や医療診断といった高価値シナリオに拡大するにつれ、セキュリティと信頼性に対する需要はますます高まっています。

OpenAIの急速な商業化、Metaのオープンソース戦略、DeepMindの論文とAGI探究への注力とは異なり、Anthropicはセキュリティを主要市場参入の基盤と捉えています。同社は社内のセキュリティ評価ツールを外部化することで、高水準の業界へのアクセスを促進しており、将来的には「Safety-as-a-Service(サービスとしての安全性)」の道筋が生まれると予測しています。

この論理は、政策と規制の側面によっても裏付けられています。EUのAI法と米国の連邦調達要件は、高リスクAIに対して厳格な安全基準を義務付けており、安全性は道徳的な問題から政治的・市場的な必要性へと変化しています。Anthropicの市場シェアはOpenAIよりも依然として小さいものの、政策的影響力、中核産業への浸透、そして安全基準の設定権における戦略的重要性は着実に高まっています。これは、Anthropicが少数派ではあるものの、決して弱い立場ではないことを示しています。Anthropicは、市場シェアだけに頼るのではなく、制度的・技術的な手段を通じてAI業界の展望を形成しています。

批判と論争: セキュリティは業界独占のツールになるのか?

ダリオ・アモデイ氏の「セキュリティ・アプローチ」は理想的な未来のトレンドのように思えるかもしれませんが、業界内外から強い反対に直面しています。これらの論争は主に3つの側面に焦点を当てており、AIセキュリティ問題の複雑さを浮き彫りにしています。

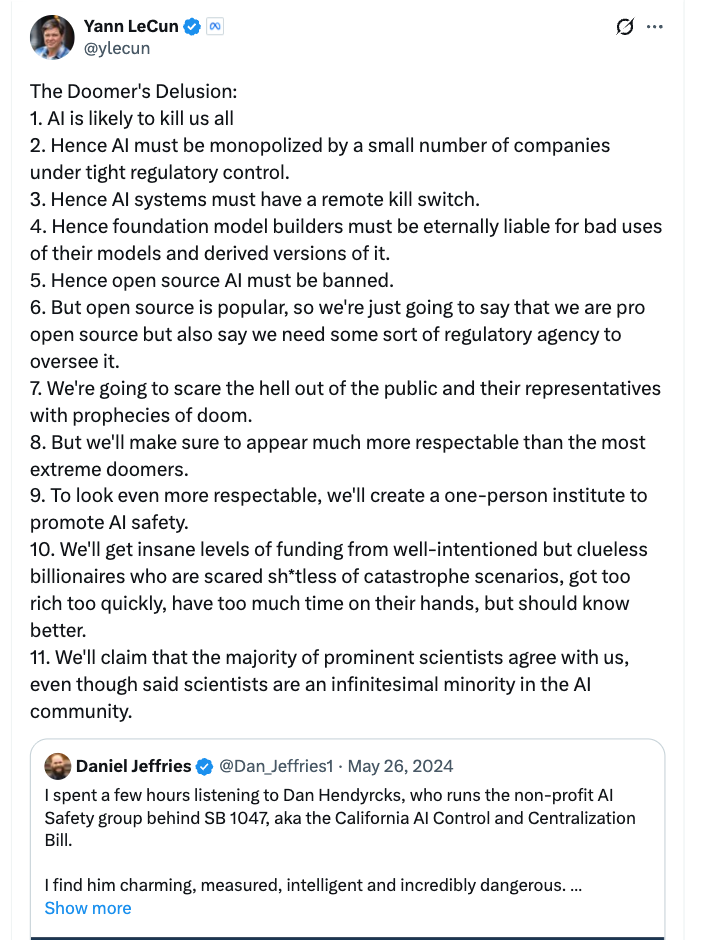

安全保障が「競争制限」の理由になる可能性もある。

Metaのチーフサイエンティスト、ヤン・ルカン氏は、「過度に厳格なセキュリティ規制」に反対する最も率直なテクノロジーリーダーの一人です。彼はソーシャルメディアや業界カンファレンスで、ダリオ・アモデイ氏が提唱する「早期規制」と「高いセキュリティ基準」は、本質的に「スタートアップ企業にとって参入障壁を高く設定する」ものであり、大企業にはセキュリティ研究開発に投資する十分な資金とリソースがある、と繰り返し示唆してきました。スタートアップ企業はセキュリティコストを負担できないために排除され、最終的には業界の独占につながる可能性があります。

ルカン氏の見解は多くのAIスタートアップ企業から支持を集めている。彼らは、現在のセキュリティ基準はまだ統一されておらず、厳格な規制を時期尚早に導入すると、「セキュリティ」が巨大企業による小規模企業への締め出しの道具と化してしまう可能性があると考えている。

安全性は定量化できず、簡単に空虚なスローガンになってしまいます。

もう一つの重要な論点は「セキュリティの測定可能性」です。現在、AIの安全性評価基準は非常に断片化しており、「安全なAIとは何か」を判断する基準は企業によって一貫性がありません。「安全性テスト、評価、レッドチームテスト」の方法、強度、透明性は大きく異なり、「安全なAIとは何か」に対する統一された答えさえ存在しません。例えば、Anthropicは「モデルの自己キャリブレーション」を安全と見なしますが、OpenAIは「外部のレッドチームテストに合格すること」を安全と見なすかもしれません。一方、政府機関は「モデルが有害な情報を生成しないこと」をより重視するかもしれません。

この断片化により、「安全性」を定量化することが困難になり、企業が自社のイメージを「飾る」ための空虚なスローガンと化しやすくなっています。企業は自社のモデルが「非常に安全」であると主張することはできますが、業界で認められた標準を用いてそれを証明することはできません。批評家は、標準が統一される前に「安全性」を過度に強調すると、市場に誤解を招き、AIのリスクが解決されたとユーザーに誤解させてしまう可能性があると主張しています。さらに、学術研究では、AI開発に対する過剰で柔軟性のない規制(または画一的なルール)がイノベーションを阻害する可能性があることが示されています。

記事リンク:https://arxiv.org/abs/2104.03741

テクノロジーと規制の間には当然ながら断絶があります。

多くの技術専門家は、大規模モデルを予測する能力は依然として未解決の科学的課題であると指摘しています。最先端の研究者でさえ、次世代のモデルがどのような機能を備え、どのようなリスクをもたらす可能性があるかを正確に予測することはできません。こうした状況において、「早期規制」は2つの問題に直面する可能性があります。1つは「リスクの誤判断」、つまり無害な技術革新をリスクとみなして規制すること、もう1つは「リスクの見逃し」、つまり真の危険性を予測できず、規制の失敗につながることです。

ダリオ・アモデイ氏はこれらの論争に反応を示しました。セキュリティ基準は「動的に調整」する必要があると認め、競争障壁を下げるためにスタートアップ企業によるセキュリティ研究開発への政府補助金を支持しました。しかし、彼は「たとえ論争があったとしても、リスクが顕在化するまで行動を起こさないわけにはいきません。『規制の欠如』のコストは『過剰規制』のコストよりもはるかに大きいのです」と主張しました。

実際、これらの論争は次の一つのことを浮き彫りにしています。AI セキュリティは技術的、科学的な問題であるだけでなく、政治的、経済的な問題でもあります。 産業構造、競争ルール、世界の権力構造など、複数の側面が絡み合っています。「完璧な答え」は存在せず、議論の中でバランスを探ることしかできません。

アモデイ氏は「安全ルート」ではなく、AI時代のための「論理プロトコル」を推進している。

インターネットの発展の歴史を振り返ると、インターネットが「学術ツール」から「グローバルインフラ」へと進化した理由が分かります。その核となるのは、統一された基盤プロトコルの確立です。 —TCP/IP(伝送制御プロトコル/インターネットプロトコル)、DNS(ドメインネームシステム)、HTTPS(ハイパーテキスト転送セキュリティプロトコル)など。これらのプロトコルは特定のアプリケーションシナリオには関係しませんが、すべてのインターネットサービスに「共通言語」を提供し、さまざまなデバイス、プラットフォーム、地域のユーザーがスムーズに接続できるようにします。

著者の意見では、ダリオ・アモデイ氏は単純な「安全アプローチ」を推進しているのではなく、むしろAI時代のための同様の「論理プロトコル」を確立しようとしています。— 統合され、安全で、監査可能で、複製可能なガバナンス・インフラストラクチャ。この「プロトコル」の中核は、「AIの機能を制限すること」ではなく、「制御可能なフレームワーク内でAIの機能の価値を実現すること」です。

彼がやりたいのは、業界の参入障壁を上げることでも、業界の成長を遅らせることでもなく、「世界中で理解され、複製され、使用できる AI 安全システム」を確立することです。TCP/IPプロトコルがインターネットの「相互接続性」を実現するのと同様に、AI「ガバナンスプロトコル」は、一貫性のない標準によるリスクの拡散やリソースの浪費を回避しながら、グローバルAIテクノロジーが安全な基盤で「共同開発」を実現することを可能にします。

これは技術的な悲観論ではなく、産業工学です。 AIのリスクは認識しているものの、制度設計によって制御できると考えている。AIの革新的価値を否定するわけではないが、イノベーションには限界が必要だと主張している。インターネットがプロトコル化後に指数関数的な拡大を遂げたように、「技術の爆発的発展」から「安定した応用」へと至るAIの第二段階には、支点となる一連の「ガバナンスプロトコル」が必要になるかもしれない。

最後に書きます

AIが生産性、軍事力、そして国家安全保障に影響を与える中核資産へと徐々に移行するにつれ、「セキュリティ」はもはや技術的な問題ではなく、世界秩序に関わる戦略的な問題となるでしょう。将来的には、「セキュリティ」を定義できる者がAI業界のルールを決定づけ、「セキュリティフレームワーク」を構築できる者が、世界的な技術競争で優位に立つことになるでしょう。

ダリオ・アモデイ氏は、この変革における唯一の先駆者ではないかもしれないが、間違いなく最も明晰で、同時に最も物議を醸す人物である。彼の価値は、「完璧な解決策」を提示したことではなく、業界全体と世界社会に重要な問題に立ち向かわせたことにある。AIが未来へと前進するためには、技術的な熱意だけでなく、制度的な合理性も必要だ。そして、まさにこれこそが、AIを「破壊的技術」から「建設的な力」へと変革するための鍵となるのだ。

参考リンク:

1.https://www.anthropic.com/news/claude-3-family

2.https://www.reuters.com/business/retail-consumer/anthropic-ceo-says-proposed-10-year-ban-state-ai-regulation-too-blunt-nyt-op-ed-2025-06-05

3.https://arxiv.org/abs/2212.08073

4.https://arstechnica.com/ai/2025/01/anthropic-chief-says-ai-could-surpass-almost-all-humans-at-almost-everything-shortly-after-2027/

5.https://www.freethink.com/artificial-intelligence/agi-economy