Command Palette

Search for a command to run...

IQuest-Coder-V1 : Un Modèle D’amélioration De La Logique De Programmation Entraîné Sur Le Flux De Code ; Human Face Emotions : Un Ensemble De Données De Reconnaissance Des Émotions Faciales multi-annotées.

Actuellement, bien que les outils de génération de code par IA soient largement utilisés, ils sont souvent confrontés à des défis tels qu'une logique de code générée rigide, une compréhension contextuelle insuffisante et une difficulté à imiter les processus de développement réels.De nombreux modèles n'apprennent qu'à partir d'« instantanés statiques » de fragments de code, sans comprendre en profondeur pourquoi et comment le code devrait être modifié, ce qui limite l'utilisabilité du code généré.

Sur cette base, l'Institut de recherche sur l'innovation Zhizhi, sous l'égide de Jiukun Investment, a lancé la série de modèles de code IQuest-Coder-V1 en janvier 2026.Ce modèle repose sur le concept unique de « flux de code ». Son innovation principale réside dans sa capacité à apprendre d'une quantité massive d'historique de modifications de code réel, lui permettant ainsi de comprendre le processus dynamique d'évolution logicielle à l'instar d'un développeur expérimenté.De plus, le code généré par le modèle offre des performances exceptionnelles en termes d'exactitude, de maintenabilité et de conformité avec l'intention du développeur, et est mieux à même de gérer des tâches de programmation complexes nécessitant un raisonnement en plusieurs étapes.Sa version principale comporte 40 milliards de paramètres et adopte une architecture Loop qui permet une optimisation itérative interne du code et une prise en charge native des contextes de 128 Ko, ce qui améliore considérablement sa capacité à gérer des tâches de programmation complexes.

Le modèle « IQuest-Coder-V1 » est désormais disponible sur le site web d'HyperAI. Essayez-le !

Utilisation en ligne :https://go.hyper.ai/vk4K2

Aperçu rapide des mises à jour du site web officiel d'hyper.ai du 12 au 16 janvier :

* Jeux de données publics de haute qualité : 6

* Sélection de tutoriels de haute qualité : 3

* Interprétation d'articles communautaires : 3 articles

* Entrées d'encyclopédie populaire : 5

Principales conférences avec des dates limites en janvier : 8

Visitez le site officiel :hyper.ai

Ensembles de données publiques sélectionnés

1. Ensemble de données sur les émotions faciales humaines

Human Face Emotions est un jeu de données de classification d'images destiné à la reconnaissance des expressions faciales. Il vise à fournir des données fondamentales d'entraînement et d'évaluation pour la recherche en vision par ordinateur et en reconnaissance des émotions. Le jeu de données est organisé par catégories d'émotions, comprenant cinq catégories d'émotions faciales, chacune avec plus de 8 000 exemples d'images. L'unité d'échantillonnage de base est l'image faciale individuelle, et les données sont organisées en dossiers selon les catégories d'émotions. Elles proviennent de multiples plateformes en ligne publiques et couvrent différentes personnes, conditions de prise de vue et arrière-plans, ce qui témoigne d'une grande diversité.

Utilisation directe :https://go.hyper.ai/Z2ouP

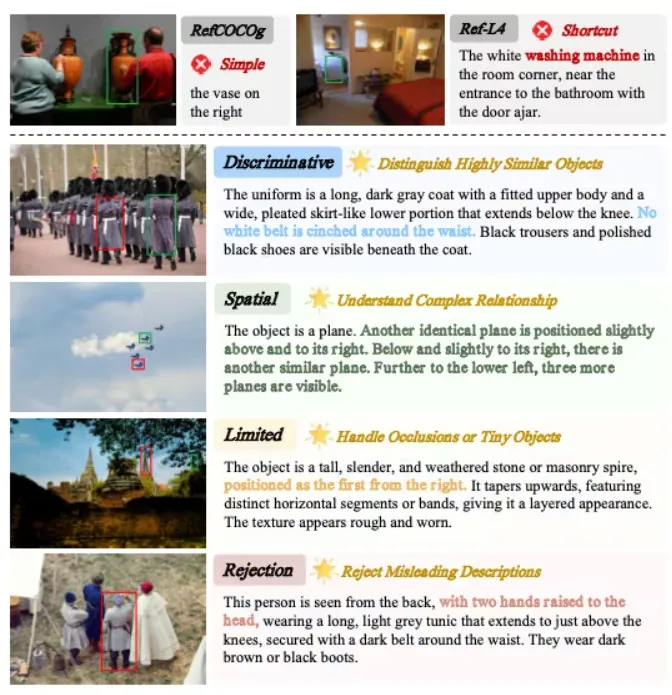

2. Ensemble de données d'évaluation de la compréhension de scènes complexes de GroundingME

GroundingME est un jeu de données d'évaluation de référence visuelle pour les modèles de langage multimodaux de grande taille (MLLM), publié en 2025 par l'Université Tsinghua en collaboration avec Xiaomi et l'Université de Hong Kong. Il vise à évaluer systématiquement la capacité du modèle à associer avec précision le langage naturel à des cibles visuelles dans des scènes complexes du monde réel, en accordant une attention particulière à la compréhension et à la sécurité des performances en présence de références ambiguës, de relations spatiales complexes, de petites cibles, d'occlusions et de situations sans référentiel.

Utilisation directe :https://go.hyper.ai/nJSaK

3. Ensemble de données d'inférence mathématique Nemotron-Math-v2

Nemotron-Math-v2 est un ensemble de données de raisonnement mathématique publié par NVIDIA Corporation en 2025. Il est principalement utilisé pour entraîner les LLM à effectuer un raisonnement mathématique structuré, étudier les différences entre le raisonnement amélioré par des outils et le raisonnement en langage pur, et construire des systèmes de raisonnement à contexte long ou à pistes multiples.

Utilisation directe :https://go.hyper.ai/6OKuq

4. Ensemble de données HydroBASINS sur la répartition mondiale des rivières

HydroBASINS est un jeu de données mondial de subdivision des cours d'eau, basé sur la couche hydrologique centrale d'HydroSHEDS. Il offre une subdivision continue des cours d'eau à l'échelle mondiale avec une résolution spatiale de 15 secondes d'arc. Ce jeu de données est conçu pour faciliter les analyses hydrologiques, écologiques et environnementales, en fournissant des limites de bassins versants et des topologies de réseaux hydrographiques cohérentes et hiérarchisées. Il convient à de nombreuses applications, notamment l'hydrologie et la gestion des ressources en eau, la modélisation du climat et du système terrestre, les programmes de biodiversité et de conservation, l'analyse environnementale des bassins versants, la modélisation spatiale à grande échelle et les flux de travail SIG.

Utilisation directe :https://go.hyper.ai/53vN4

5. Ensemble de données sur les surfaces de défaillance des batteries

Battery Failure Surfaces est un jeu de données de simulation de défaillance de batteries conçu pour étudier le cycle de vie et les modes de défaillance des batteries sous différentes contraintes de fonctionnement. Ce jeu de données synthétiques, inspiré de la physique, simule les changements d'état des batteries lors des cycles de charge-décharge et convient à la modélisation des risques et à la détermination des limites de sécurité.

Utilisation directe :https://go.hyper.ai/hRapq

6. Ensemble de données Global Green Energy Pulse

L'ensemble de données Global Green Energy Pulse est destiné à l'analyse des énergies renouvelables dans les grandes villes du monde. Il vise à aider les chercheurs et les décideurs politiques à comprendre le potentiel en énergie verte de différentes villes, notamment dans le contexte de la transition vers des économies à zéro émission nette, en fournissant une base de données riche pour la recherche en matière de prévision de séries temporelles, d'analyse géospatiale et d'optimisation énergétique mondiale.

Utilisation directe :https://go.hyper.ai/p8NAY

Tutoriels publics sélectionnés

1. Déploiement d'IQuest-Coder-V1 à l'aide de vLLM et d'Open WebUI

IQuest-Coder-V1 est un modèle d'IA avancé développé par IQuestLab, dédié à la génération, la compréhension et l'optimisation de code. Il propose différentes échelles de paramètres (7 milliards, 14 milliards et 40 milliards de bits) et versions (Instruction, Réflexion et Boucle) afin de répondre à divers besoins de développement. Grâce à une stratégie d'apprentissage par flux de code multi-étapes, il apprend à partir d'extraits de code statiques, acquérant ainsi des connaissances grâce au processus d'évolution du code et améliorant considérablement sa compréhension des scénarios de développement réels.

Exécutez en ligne :https://go.hyper.ai/vk4K2

2.vLLM + Déploiement WebUI ouvert de QwenLong-L1.5

QwenLong-L1.5 est une série de modèles de raisonnement sur contexte long et de gestion de la mémoire développée par Alibaba Tongyi Lab. Ce tutoriel utilise QwenLong-L1.5-30B-A3B, un modèle Transformer de décodage comportant environ 30 milliards de paramètres. Ce modèle est obtenu par un post-entraînement systématique basé sur le modèle de base Qwen3-30B-A3B-Thinking et est disponible en open source sur des plateformes telles que Hugging Face. Il met en œuvre plusieurs techniques de post-entraînement, notamment un pipeline de synthèse de données sur contexte long, un apprentissage par renforcement stable pour les longues séquences et un cadre d'optimisation de la mémoire pour les contextes ultra-longs, ce qui lui confère des performances supérieures dans les benchmarks sur contexte long. De plus, ces capacités ont été appliquées à des tâches générales, telles que le raisonnement mathématique, l'utilisation d'outils et la cohérence des dialogues longs.

Exécutez en ligne :https://go.hyper.ai/6mD9U

3. Qwen-Image-2512 : Générer des portraits et des paysages naturels plus réalistes

Qwen-Image-2512 est un modèle de base de conversion texte-image de la série Qwen-Image. Cette version améliorée a été publiée en fin d'année. Ce modèle est principalement conçu pour la génération d'images de haute qualité et les scénarios d'expression de contenu multimodal complexes. Par rapport aux versions précédentes, Qwen-Image-2512 a bénéficié d'une optimisation systématique sur plusieurs points clés, améliorant considérablement le réalisme et l'ergonomie des images générées. Plus précisément, le naturel des portraits est nettement amélioré : la structure du visage, le grain de peau et l'éclairage se rapprochent davantage des effets photographiques réalistes. Dans les scènes naturelles, le modèle génère des textures de terrain plus détaillées, des détails de végétation et des informations haute fréquence comme le pelage des animaux. Parallèlement, sa capacité à générer et à formater du texte dans les images a également été améliorée, permettant une présentation plus stable des textes lisibles et des mises en page complexes.

Exécutez en ligne :https://go.hyper.ai/rODFG

Interprétation des articles communautaires

1. Tutoriel en ligne | Qwen-Image-2512 Logiciel libre officiel : Dites adieu à l’aspect plastique des images RAW IA, obtenez un rendu de cheveux réaliste grâce à de simples commandes textuelles

Bien que les modèles de génération d'images open source puissent produire rapidement des images, ils peinent souvent à atteindre un réalisme optimal, notamment pour les portraits et les scènes naturelles complexes. Les visages générés paraissent souvent artificiels ou présentent des traits flous, et la peau manque de texture réaliste. Pour les paysages naturels, les modèles semblent souvent rigides lorsqu'il s'agit de représenter les textures délicates de l'eau et de la végétation. Afin de remédier à ces problèmes, le laboratoire Tongyi d'Alibaba a récemment publié en open source son modèle de génération d'images de nouvelle génération, Qwen-Image-2512. Ses caractéristiques sont très distinctes et reposent sur une avancée majeure dans trois domaines clés : des textures humaines plus réalistes ; des textures naturelles plus fines ; et un rendu plus précis des textes complexes.

Voir le rapport complet :https://go.hyper.ai/S3HJE

2. La précision atteint 97% ! L'université de Princeton et d'autres proposent MOFSeq-LMM, prédisant efficacement si les MOF peuvent être synthétisés.

L'énergie libre est un indicateur crucial pour évaluer la stabilité thermodynamique et la synthétisabilité des MOF, mais les méthodes de calcul traditionnelles sont extrêmement coûteuses pour les grands ensembles de données de MOF, ce qui freine leur criblage rapide. Pour pallier ce problème, une équipe de recherche conjointe de l'Université de Princeton et de la Colorado School of Mines a proposé une méthode de prédiction efficace basée sur l'apprentissage automatique. Cette méthode utilise un modèle de langage étendu (LLM) pour prédire directement l'énergie libre à partir des séquences structurales des MOF, réduisant considérablement les coûts de calcul et permettant une évaluation thermodynamique à haut débit et évolutive des MOF. Le modèle présente une grande polyvalence sans nécessiter de réentraînement : son score F1 atteint 97% lorsqu'il détermine si l'énergie libre des MOF est supérieure ou inférieure à un seuil de faisabilité de synthèse empirique.

Voir le rapport complet :https://go.hyper.ai/gBEeA

3. ChatGPT revendique des centaines de millions d'utilisateurs, mais un taux de conversion payant inférieur à 101 000 000. Comment l'IA peut-elle se traduire par des profits durables ?

Depuis 2025, le décalage entre les investissements massifs dans l'intelligence artificielle et les retours commerciaux est devenu un sujet de préoccupation majeur pour l'opinion publique. D'un côté, les géants mondiaux de la tech continuent de miser sur l'infrastructure et le développement des algorithmes d'IA, la présentant comme le moteur de la prochaine révolution industrielle. De l'autre, les marchés financiers, les analystes macroéconomiques et les observateurs indépendants suivent de près la performance boursière des entreprises du secteur. Dans ce contexte, l'évaluation des investissements en IA et de leurs retours commerciaux est passée d'une vision élitiste à une analyse financière pragmatique, centrée principalement sur les deux secteurs clés du B2B et du B2C, qui mobilisent d'importants capitaux.

Voir le rapport complet :https://go.hyper.ai/hE5yN

Articles populaires de l'encyclopédie

1. Images par seconde (IPS)

2. Mémoire à long terme bidirectionnelle (Bi-LSTM)

3. Navigation incarnée

4. RewardMap, un cadre d'apprentissage par renforcement multi-étapes

5. Deviner – Réfléchir – Répondre

Voici des centaines de termes liés à l'IA compilés pour vous aider à comprendre « l'intelligence artificielle » ici :

Suivi unique des principales conférences universitaires sur l'IA :https://go.hyper.ai/event

Voici tout le contenu de la sélection de l’éditeur de cette semaine. Si vous avez des ressources que vous souhaitez inclure sur le site officiel hyper.ai, vous êtes également invités à laisser un message ou à soumettre un article pour nous le dire !

À la semaine prochaine !