Command Palette

Search for a command to run...

Wöchentlicher Überblick Über KI-Veröffentlichungen | Aufmerksamkeitsmechanismen / NVIDIA VLA-Modell / TTS-Modell / Graph-Neuronale Netze... Ein Umfassender Überblick Über Die Neuesten KI-Entwicklungen

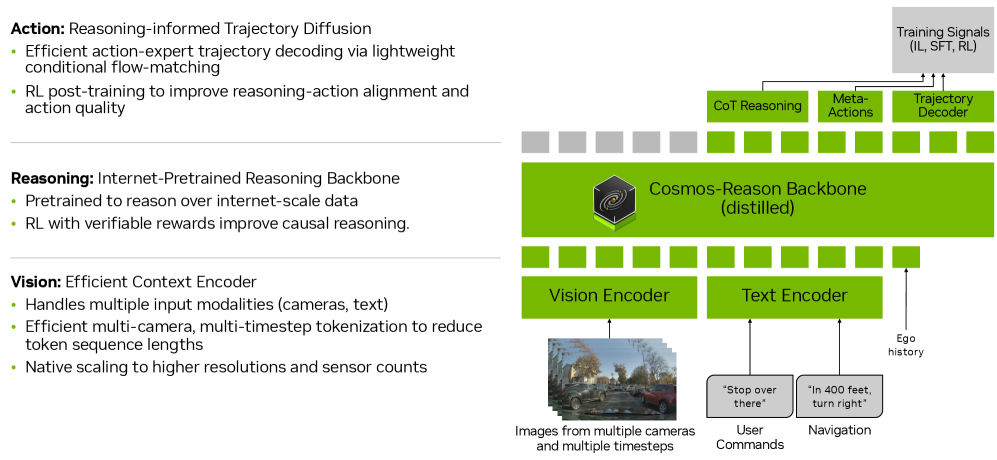

Visuelle Sprachmodelle (VLMs) und visuelle Spracharchitekturen (VLAs) finden im Bereich des autonomen Fahrens breite Anwendung. Die meisten bestehenden Methoden weisen jedoch deutliche Einschränkungen auf: Entweder fehlen ihnen explizite Schlussfolgerungsmechanismen oder sie führen Schlussfolgerungen auf freie und unstrukturierte Weise durch, was es den Modellen erschwert, über die Verteilung der Trainingsdaten hinaus zu generalisieren.

Nvidia hat Alpamayo-R1 (AR1) vorgestellt, ein Bildverarbeitungs- und Aktionsmodell (VA-Modell) mit strukturierten Schlussfolgerungsfunktionen. AR1 erweitert das zuvor vorgestellte Alpamayo-VA-Modell und verbessert die Entscheidungsfindung in komplexen Fahrsituationen durch die Verknüpfung von Schlussfolgerung und Handlungsvorhersage. Dadurch unterstützt es das allgemeine autonome Fahren. Durch die Kombination von interpretierbarer Schlussfolgerung mit präziser Steuerung zeigt AR1 einen praktikablen Weg zum autonomen Fahren der Stufe 4 auf.

Link zum Artikel:https://go.hyper.ai/Q15y9

Neueste KI-Artikel:https://go.hyper.ai/hzChC

Um mehr Benutzer über die neuesten Entwicklungen im Bereich der künstlichen Intelligenz in der Wissenschaft zu informieren, wurde auf der offiziellen Website von HyperAI (hyper.ai) jetzt der Bereich „Neueste Artikel“ eingerichtet, in dem täglich hochmoderne KI-Forschungsartikel aktualisiert werden.Hier sind 5 beliebte KI-Artikel, die wir empfehlen, werfen wir einen kurzen Blick auf die bahnbrechenden KI-Errungenschaften dieser Woche ⬇️

Die Zeitungsempfehlung dieser Woche

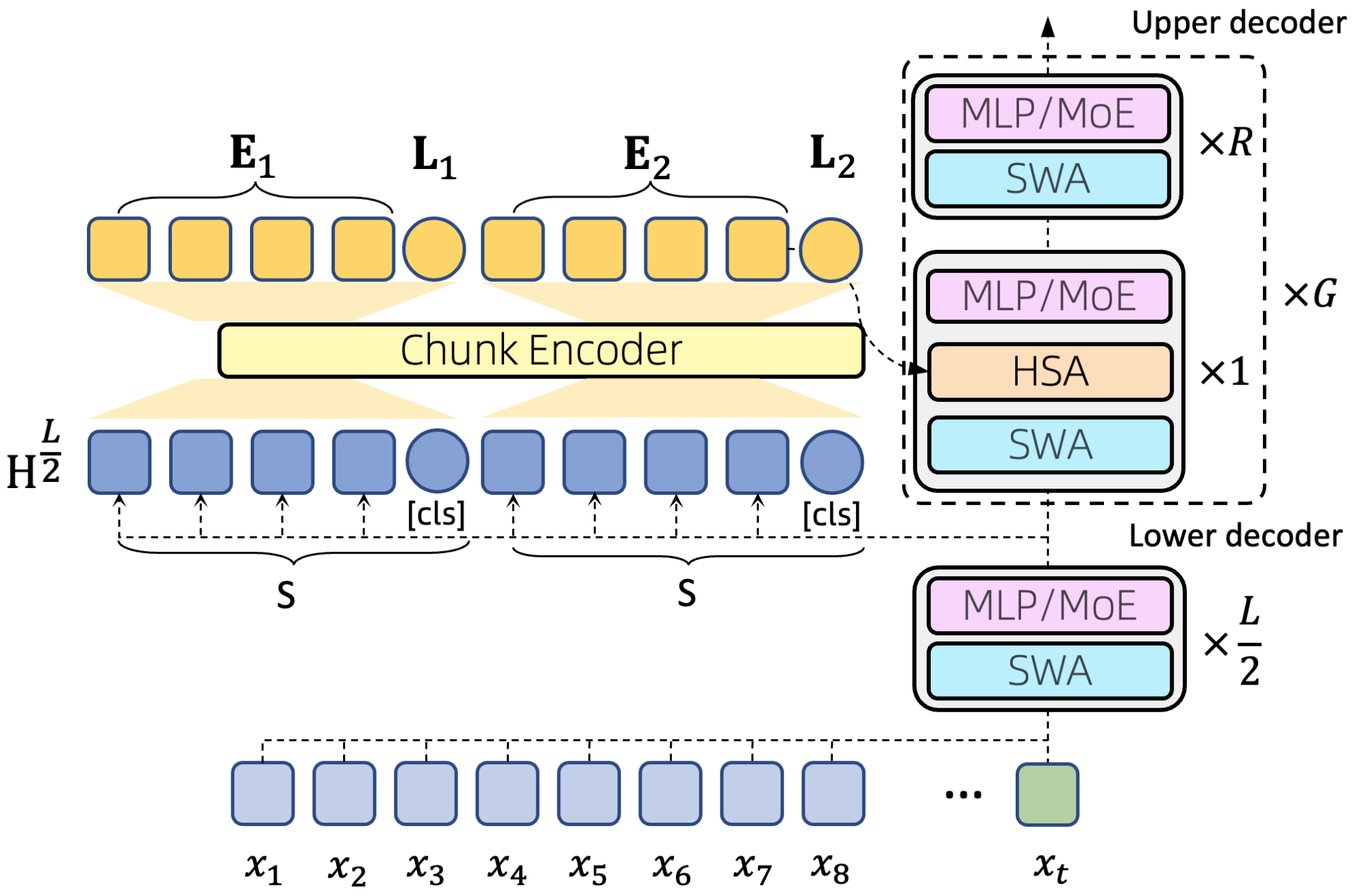

1. Jedes Token zählt: Generalisierung des 16 Millionen langen Kontextes in großen Sprachmodellen

Diese Arbeit untersucht die Herausforderung, „Maschinen mit Erinnerungsvermögen“ zu entwickeln, und definiert das Langzeitgedächtnisproblem als die effiziente Modellierung extrem langer Kontexte. Die Forschenden argumentieren, dass dies drei Schlüsseleigenschaften erfordert: Sparsität, Flexibilität beim Direktzugriff und die Fähigkeit zur Längengeneralisierung. Um die Modellierung extrem langer Kontexte zu bewältigen, stellt diese Arbeit einen neuartigen Aufmerksamkeitsmechanismus vor – Hierarchical Sparse Attention (HSA) –, der die drei genannten Eigenschaften gleichzeitig erfüllt. Durch die Integration von HSA in die Transformer-Architektur konstruierten die Forschenden ein hybrides Expertenmodell (MoE), HSA-UltraLong, mit 8 Milliarden Parametern.

Link zum Artikel:https://go.hyper.ai/axKy6

2. Alpamayo-R1

Titel: Alpamayo-R1: Die Verbindung von Schlussfolgerung und Handlungsvorhersage für generalisierbares autonomes Fahren im Long Tail

Diese Arbeit stellt Alpamayo-R1 (AR1) vor, ein Bild-Sprache-Aktions-Modell (VLA), das kausales Denken und Trajektorienplanung integriert, um die Entscheidungsfindung in komplexen Fahrszenarien zu verbessern. Die Auswertungsergebnisse zeigen, dass AR1 im Vergleich zu einem Basismodell, das ausschließlich auf Trajektorien basiert, eine um bis zu 121 TP3T höhere Planungsgenauigkeit in komplexen Szenarien erzielt. In Simulationen mit geschlossenem Regelkreis weicht das Fahrzeug um 351 TP3T von der Fahrbahn ab, und die Beinahekollisionsrate sinkt um 251 TP3T. Durch die Kombination von interpretierbarem Denken und präziser Steuerung bietet AR1 einen praktikablen technischen Weg zur Erreichung von autonomem Fahren der Stufe 4.

Link zum Artikel:https://go.hyper.ai/Q15y9

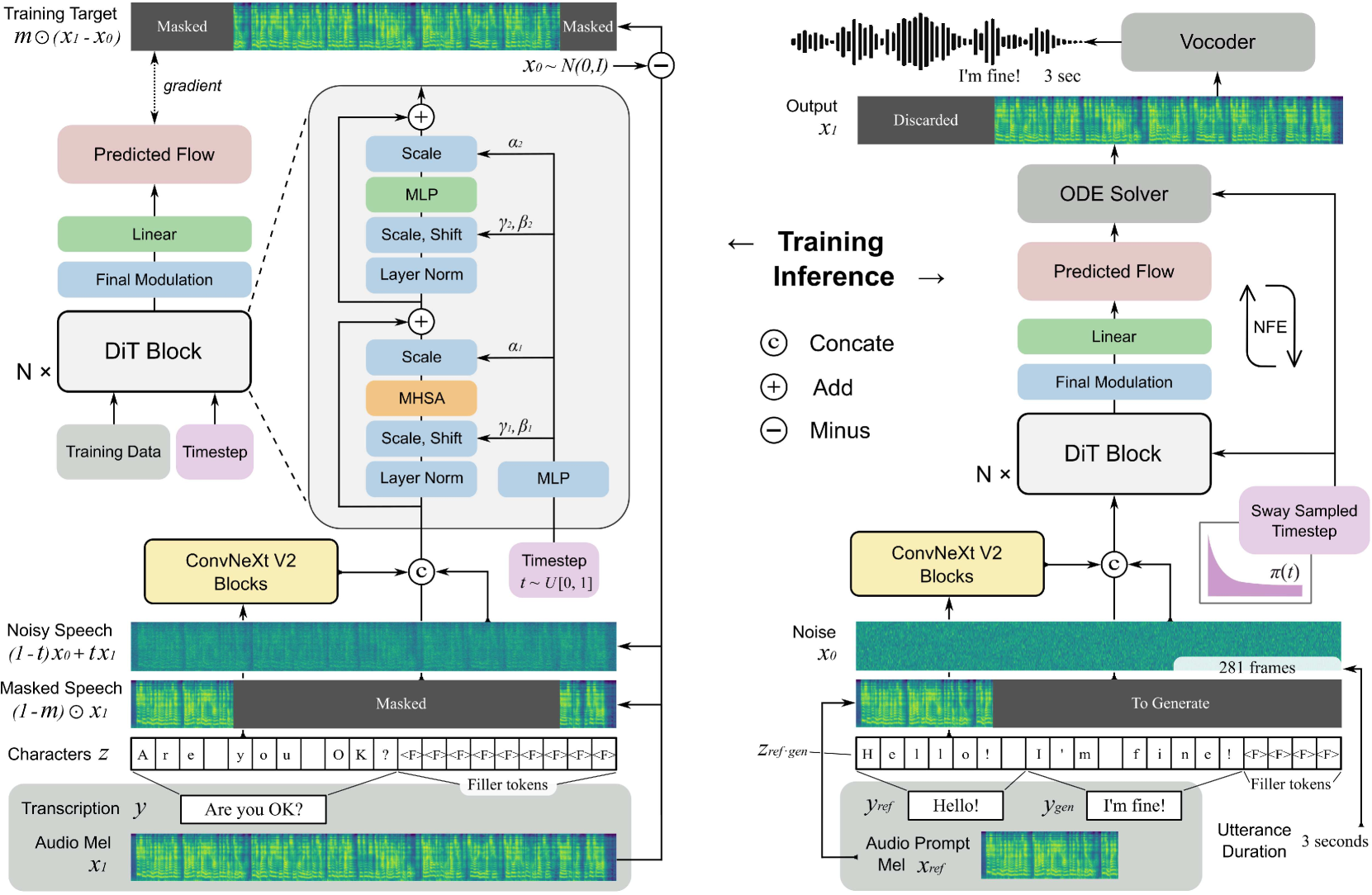

3. F5-TTS: Ein Märchenerzähler, der flüssige und authentische Sprache durch Flow-Matching vortäuscht

Diese Arbeit stellt F5-TTS vor, ein vollständig nicht-autoregressives Text-zu-Sprache-System (TTS), das auf Flow Matching und Diffusion Transformer (DiT) basiert. Nach dem Training mit einem öffentlich verfügbaren, 100.000 Stunden umfassenden mehrsprachigen Datensatz zeigt F5-TTS eine hohe Natürlichkeit und Ausdrucksstärke bei der Zero-Shot-Generierung, unterstützt nahtloses Code-Switching und zeichnet sich durch eine effiziente Sprechgeschwindigkeitssteuerung aus.

Link zum Artikel:https://go.hyper.ai/Q15y9

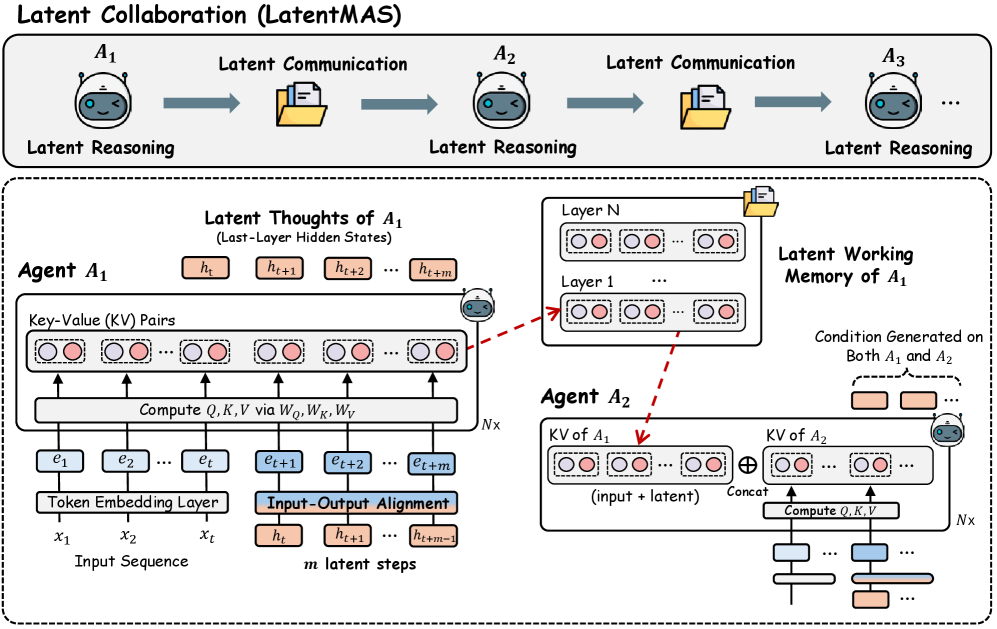

4. Latente Kollaboration in Multiagentensystemen

Diese Arbeit stellt LatentMAS vor – ein durchgängiges, trainingsfreies Framework, das die reine latente Raumkollaboration zwischen LLM-Agenten unterstützt. In LatentMAS generiert jeder Agent zunächst autoregressiv latente Raum-Gedankenrepräsentationen durch Einbettung der letzten Schicht verborgener Zustände. Anschließend speichert und überträgt der gemeinsame latente Raum-Arbeitsspeicher die internen Repräsentationen jedes Agenten und gewährleistet so einen verlustfreien Informationsaustausch.

Link zum Artikel:https://go.hyper.ai/M587U

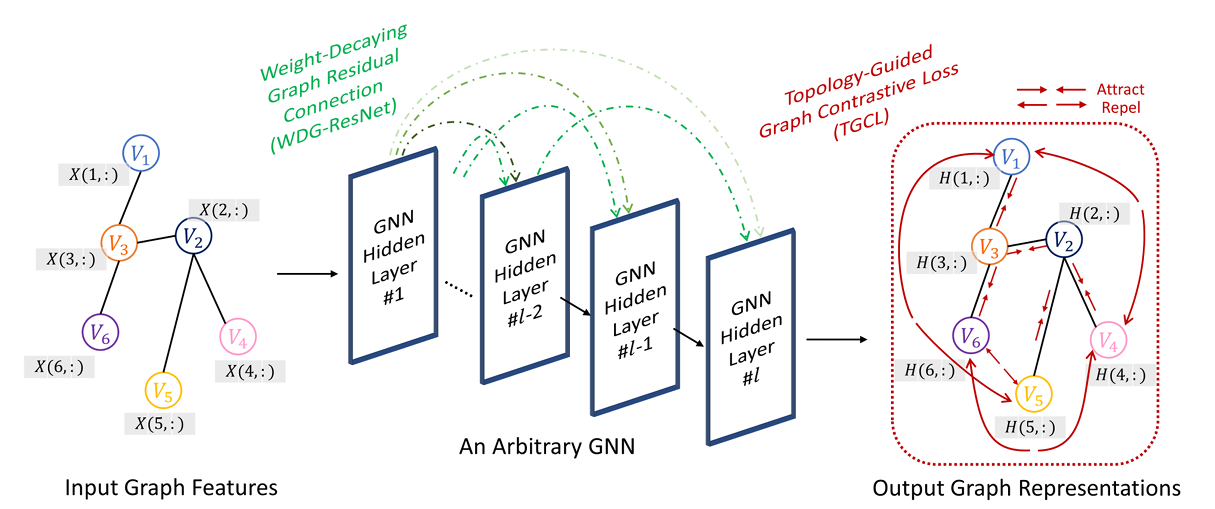

5. Deeper-GXX: Vertiefung beliebiger GNNs

Diese Arbeit stellt eine neuartige Methode für Graph-Neuronale Netze (GNN) namens Deeper-GXX vor. Diese Methode besteht aus zwei Kernmodulen: einem Modul für gewichtsreduzierende Graph-Residualverbindungen (WDG-ResNet) und einer topologiebasierten Graph-Kontrastverlustfunktion (TGCL). WDG-ResNet mindert effektiv das Problem verschwindender Gradienten durch einen dynamischen Gewichtungsreduktionsmechanismus und unterdrückt gleichzeitig den Schattennachbareffekt. TGCL nutzt die topologische Struktur des Graphen, um kontrastives Lernen zu steuern, wodurch die Unterscheidungskraft der Knotendarstellungen verbessert und übermäßige Glättung verhindert wird.

Link zum Artikel:https://go.hyper.ai/gwM7J