Command Palette

Search for a command to run...

Online-Tutorial | dots.ocr Durchbricht Die Abhängigkeit Von Strukturierten Dokumenten Und Erreicht Modernste OCR-Leistung in Hunderten Von Sprachen Basierend Auf 1,7 Milliarden Parametern.

Vor kurzem hat ein Modell namens dots.ocr mit seinem einzigartigen, leichtgewichtigen Design und seinen präzisen Textextraktionsfunktionen im Bereich der OCR-Technologie für Aufsehen gesorgt. dots.ocr ist ein mehrsprachiges Dokumentlayout-Parsing-Modell, das im August 2025 vom hi-Labor von Xiaohongshu veröffentlicht wurde.Das Modell basiert auf einem visuellen Sprachmodell (VLM) mit 1,7 Milliarden Parametern, das Layouterkennung und Inhaltserkennung auf einheitliche Weise durchführen kann.Ob es sich um einen verschwommenen Scan, einen geneigten Handy-Schnappschuss oder einen Screenshot mit niedriger Auflösung handelt, dots.ocr kann fragmentierte Textinformationen durch adaptive Rauschunterdrückungsalgorithmen und dynamische Segmentierungstechnologie präzise erfassen.Die Mikroarchitektur mit einer Modellgröße von weniger als 2 B ermöglicht Industrieanlagen, mobilen Terminals und sogar eingebetteten Systemen eine Texterkennung in Echtzeit im Millisekundenbereich und löst sich so vollständig von der Cloud-Abhängigkeit..

Besonders bemerkenswert ist, dass dots.ocr die Abhängigkeit der traditionellen OCR von strukturierten Dokumenten durchbricht. Durch die Integration eines mehrstufigen Merkmalsfusionsmechanismus mit kontextueller semantischer Fehlerkorrektur behält das Modell eine Kohärenz und Genauigkeit bei, die der menschlichen Lesbarkeit nahekommt, wenn es handschriftliche, schlampige Handschrift, dichte Tabellendaten oder gemischten Satztext erkennt. Darüber hinausIm Hinblick auf die mehrsprachige Dokumentenverarbeitung unterstützt es 100 Sprachen, darunter Chinesisch und Englisch, und kann Textinhalte und Layoutelemente in mehrsprachigen Dokumenten präzise identifizieren und verarbeiten.Ob mehrsprachige Dokumente oder komplexe Sprachumgebungen – dots.ocr liefert stabile und präzise Analyseergebnisse. In Benchmarks wie OmniDocBench kann die Formelerkennungsleistung von dots.ocr mit der größerer Modelle wie Doubao-1.5 und Gemini2.5-Pro mithalten. Es bietet einen deutlichen Vorteil bei der Analyse von Minderheitensprachen und erfüllt damit das Ziel „klein, aber präzise“.

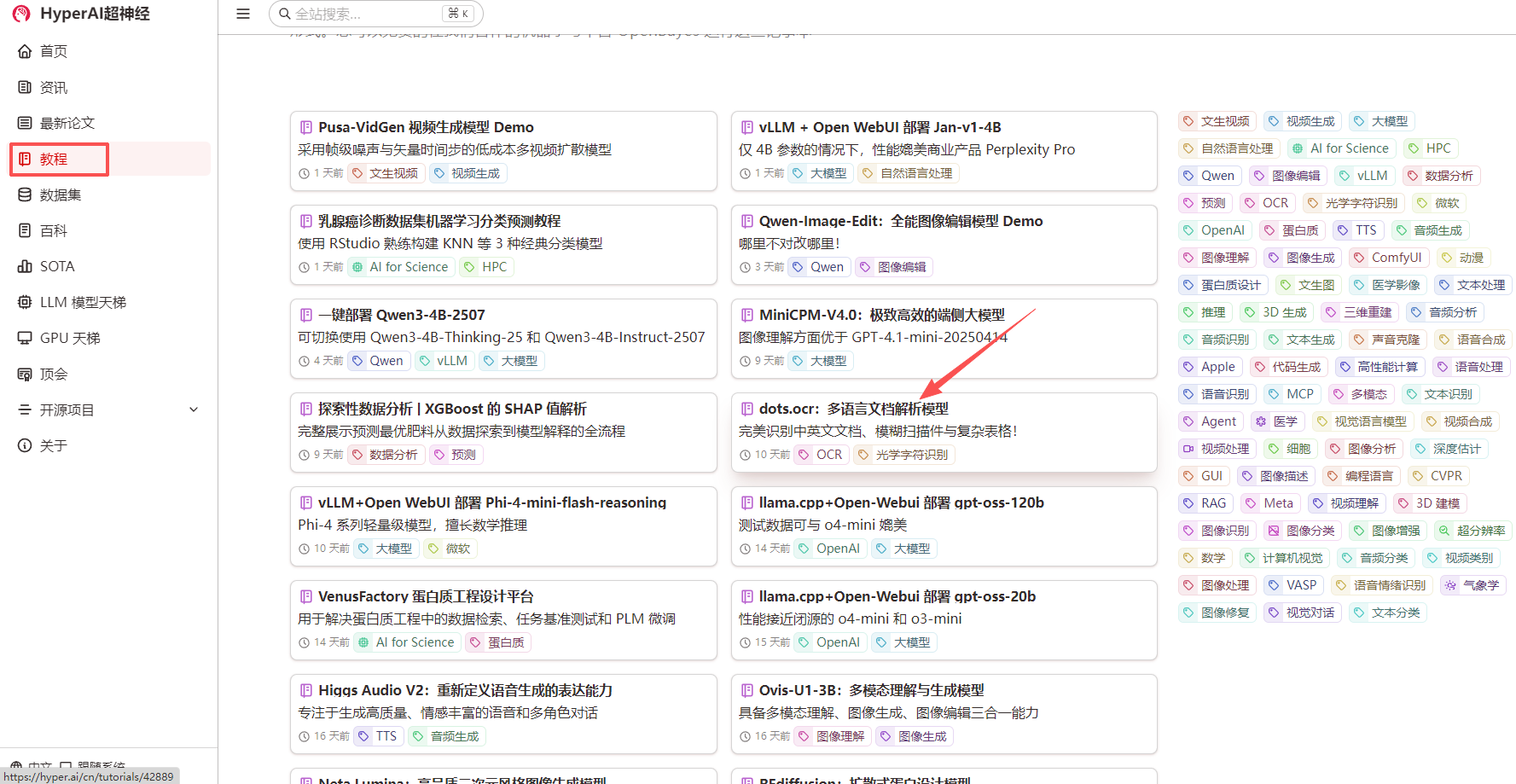

derzeit,dots.ocr: Ein mehrsprachiges DokumentanalysemodellEs wurde in den Bereich „Tutorial“ der offiziellen HyperAI-Website hochgeladen. Klicken Sie auf den unten stehenden Link, um es mit einem Klick bereitzustellen.

Link zum Tutorial:

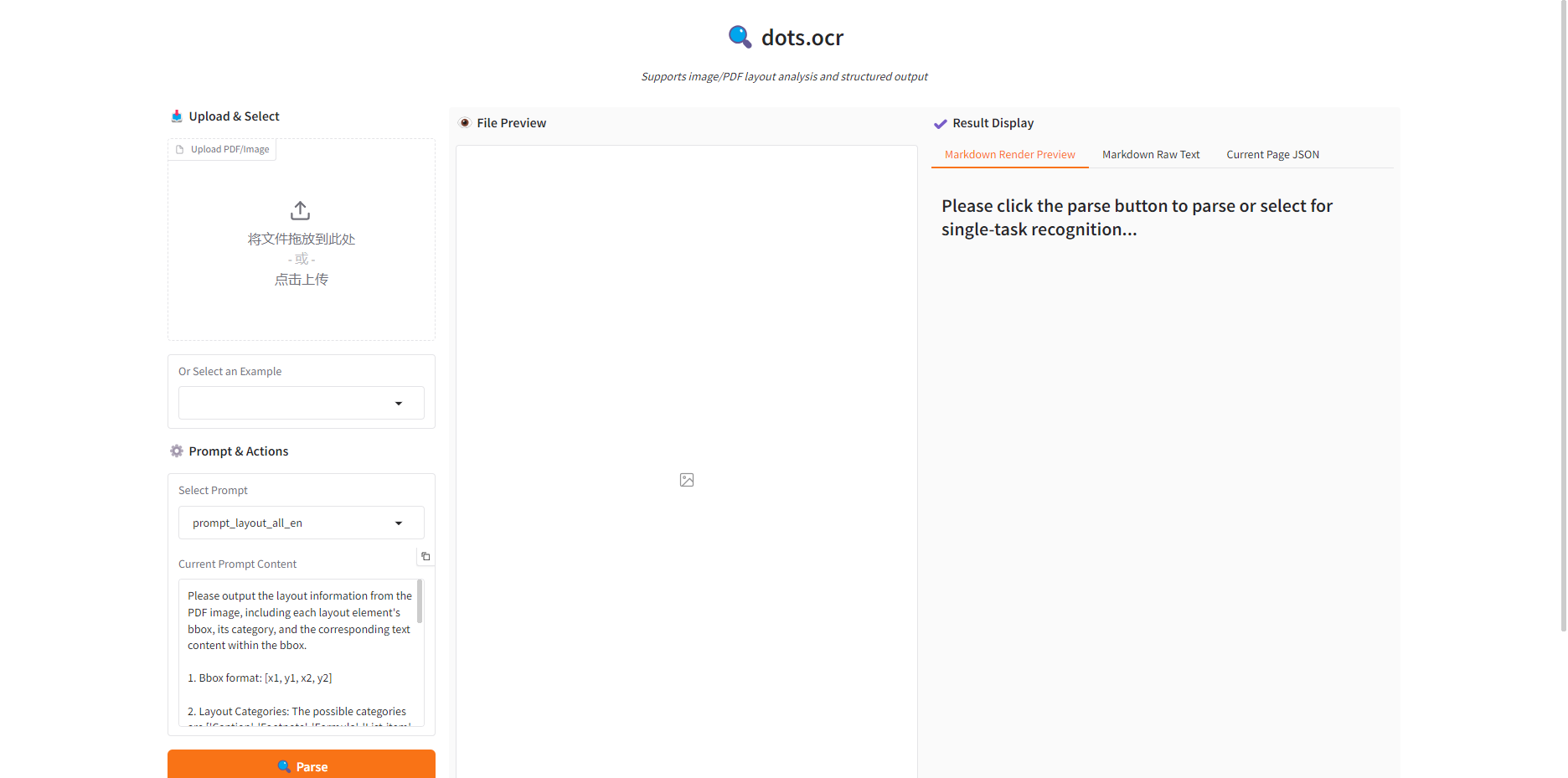

Demolauf

1. Wählen Sie auf der Homepage von hyper.ai die Seite „Tutorials“ aus, wählen Sie „dots.ocr: Multilingual Document Parsing Model“ und klicken Sie auf „Dieses Tutorial online ausführen“.

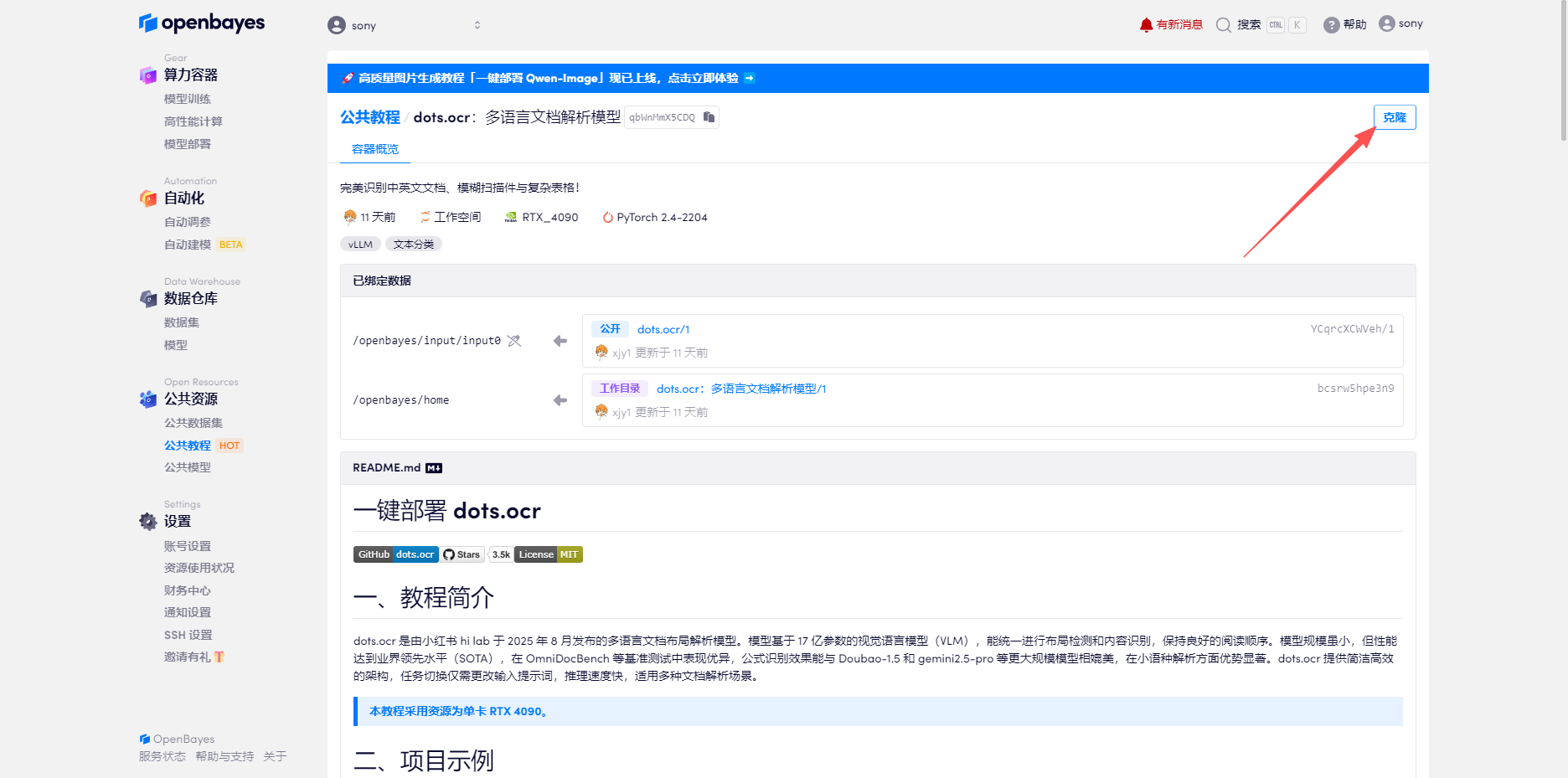

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

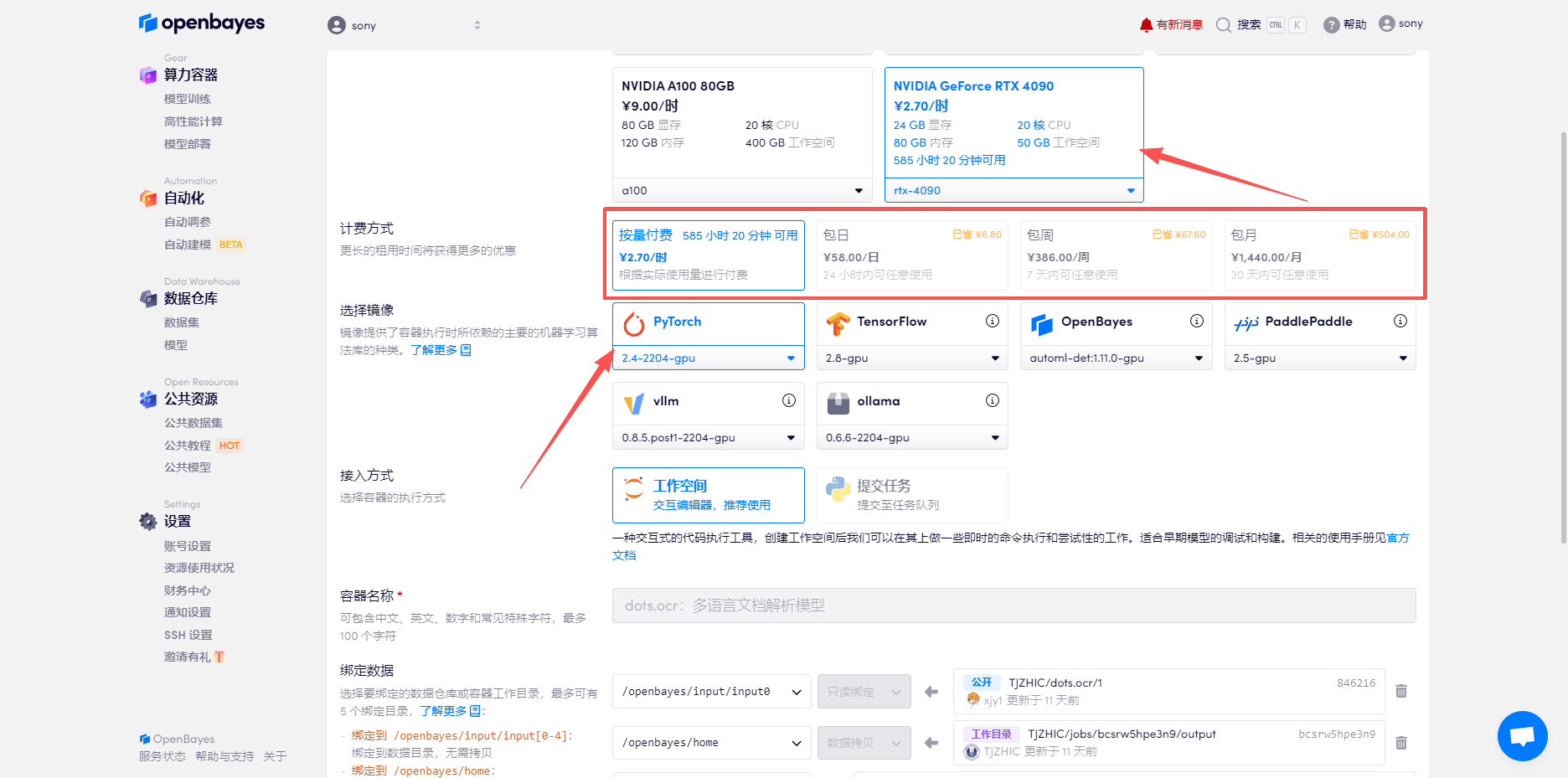

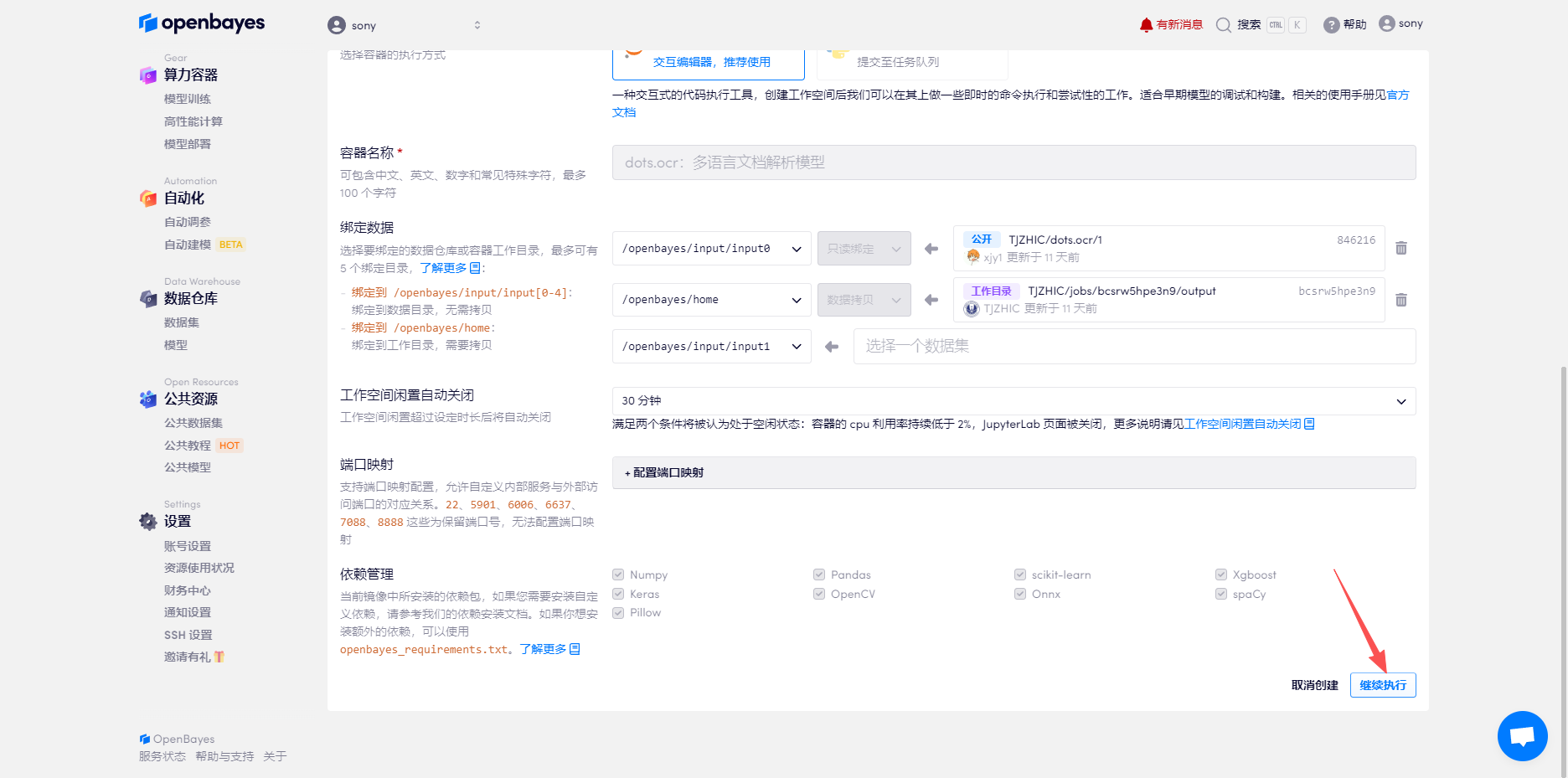

3. Wähle die Bilder „NVIDIA GeForce RTX 4090“ und „PyTorch“ aus, wähle je nach Bedarf „Pay as you go“ oder „Tages-/Wochen-/Monatspaket“ und klicke auf „Weiter“. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren und erhalten 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://openbayes.com/console/signup?r=Ada0322_NR0n

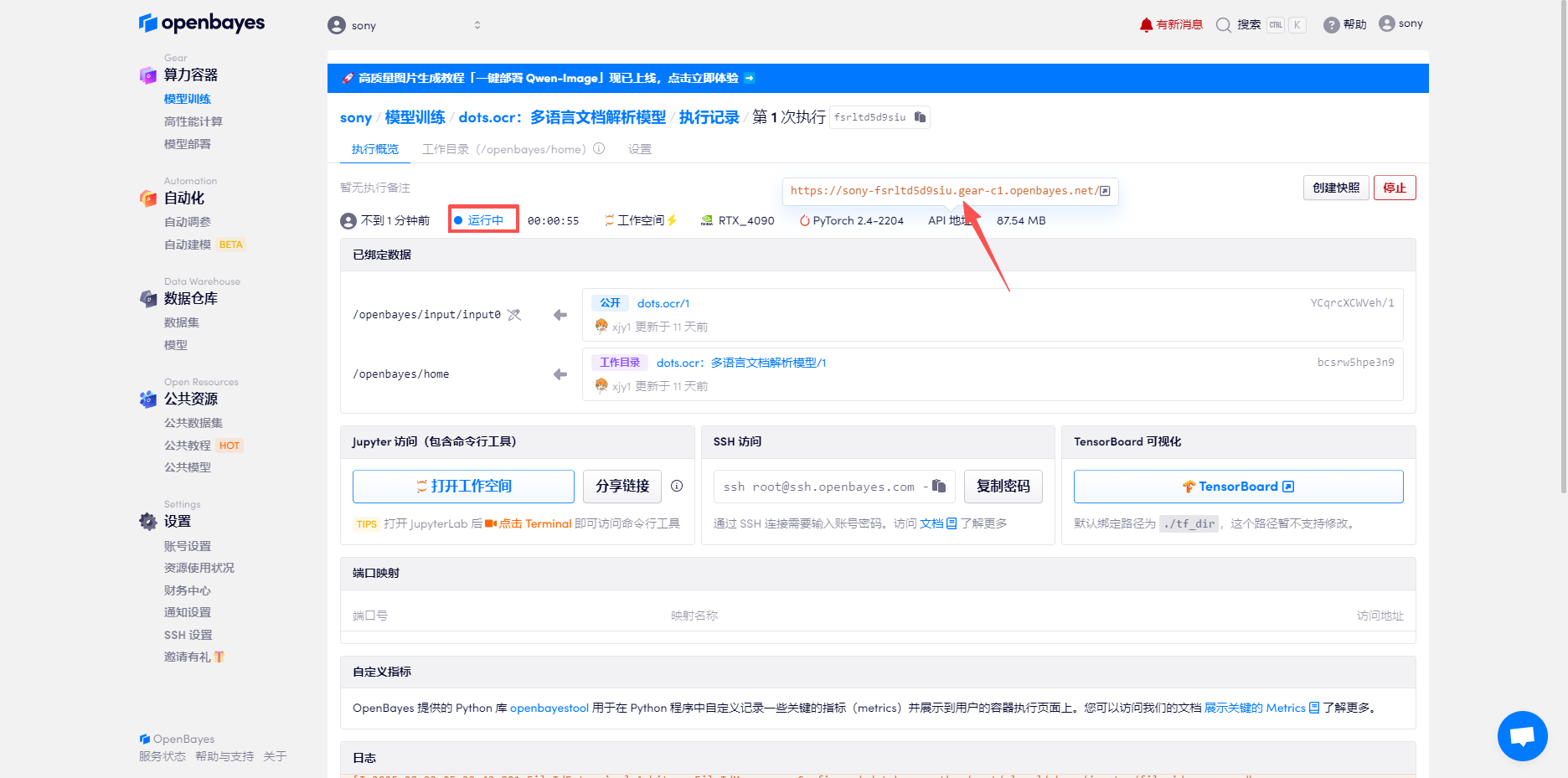

4. Warten Sie, bis die Ressourcen zugewiesen sind. Der erste Klonvorgang dauert etwa 3 Minuten. Wenn der Status auf „Läuft“ wechselt, klicken Sie auf den Pfeil neben „API-Adresse“, um zur Demoseite zu gelangen. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresse eine Echtnamen-Authentifizierung durchführen müssen.

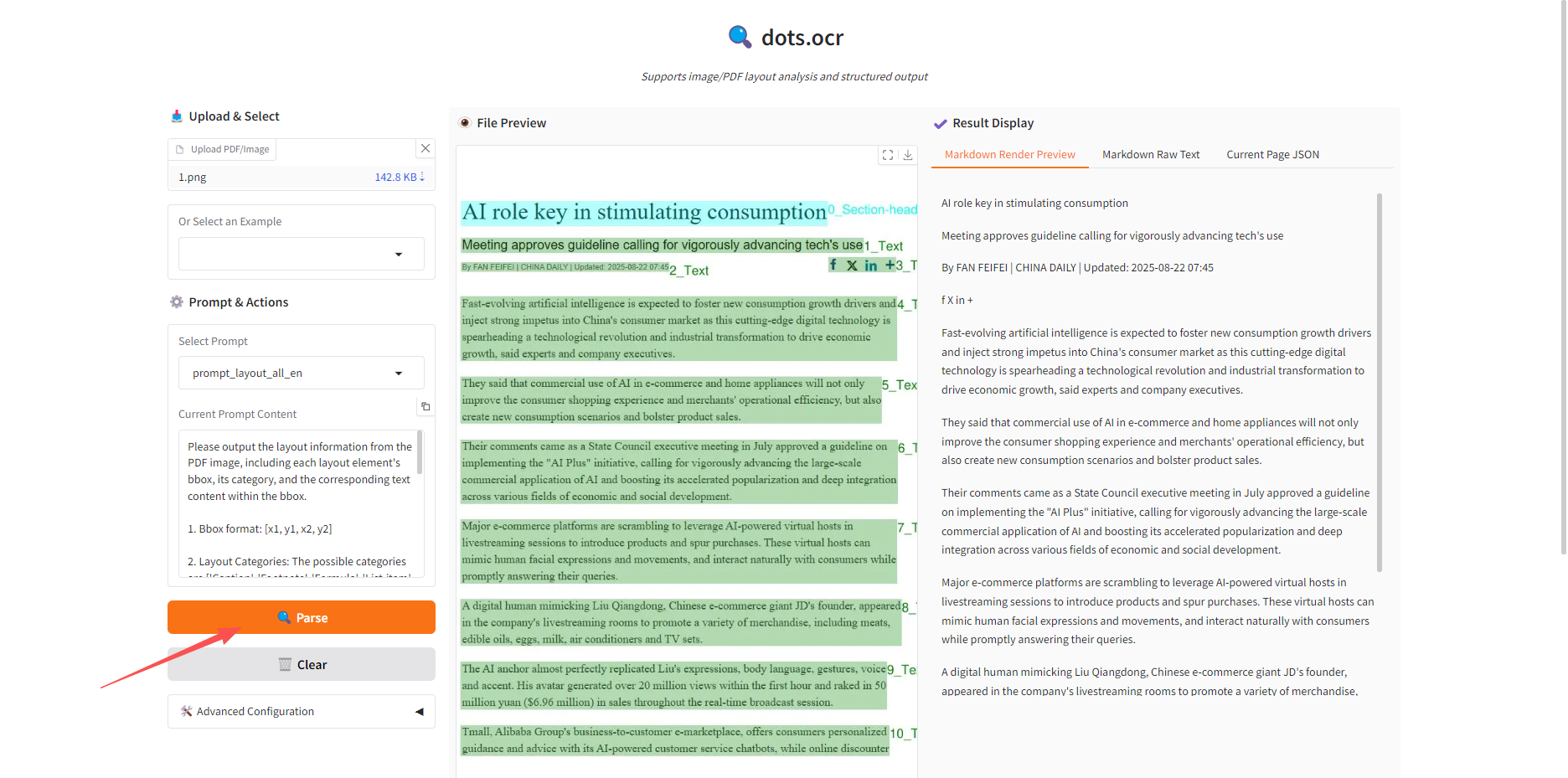

Effektdemonstration

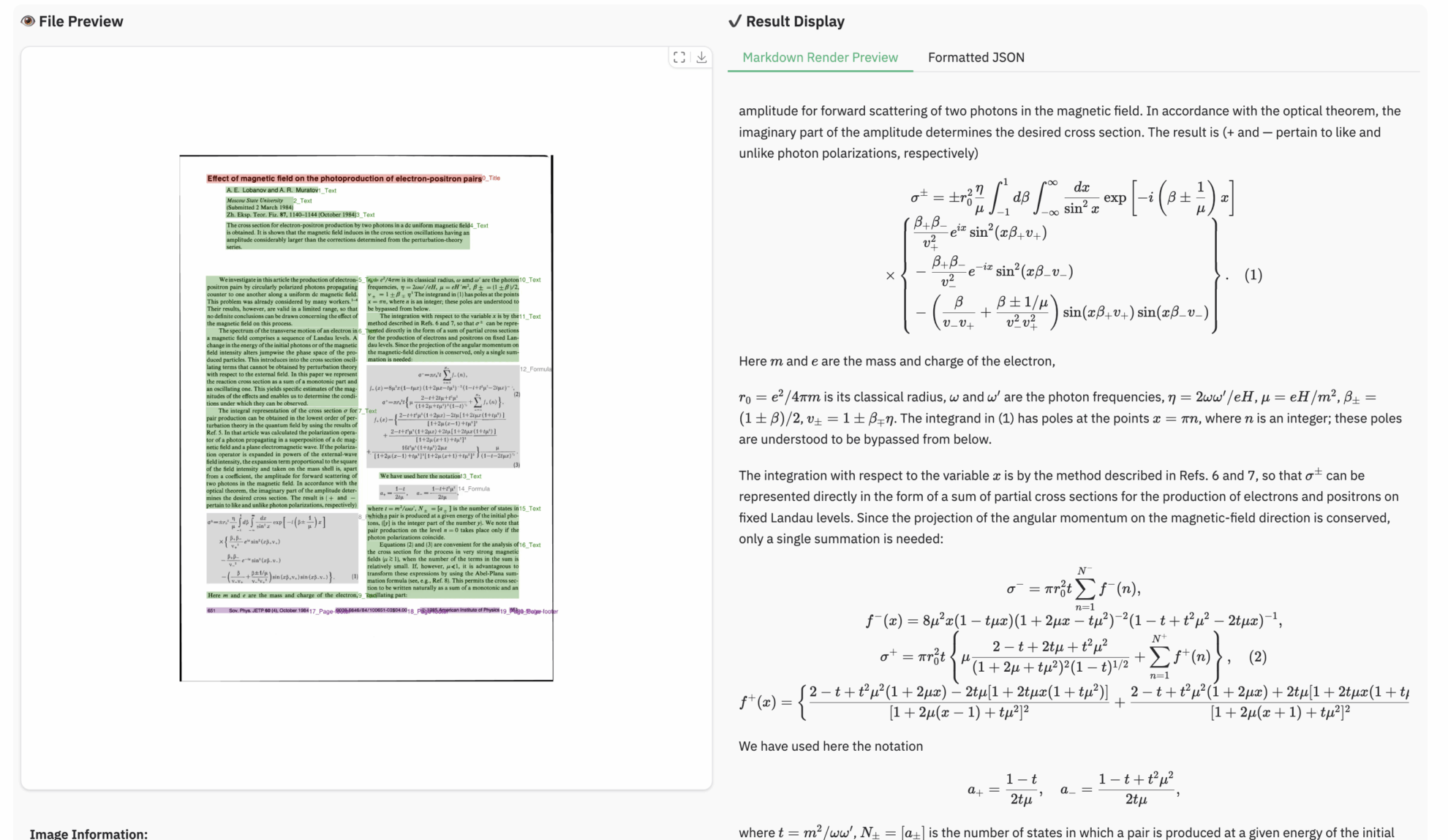

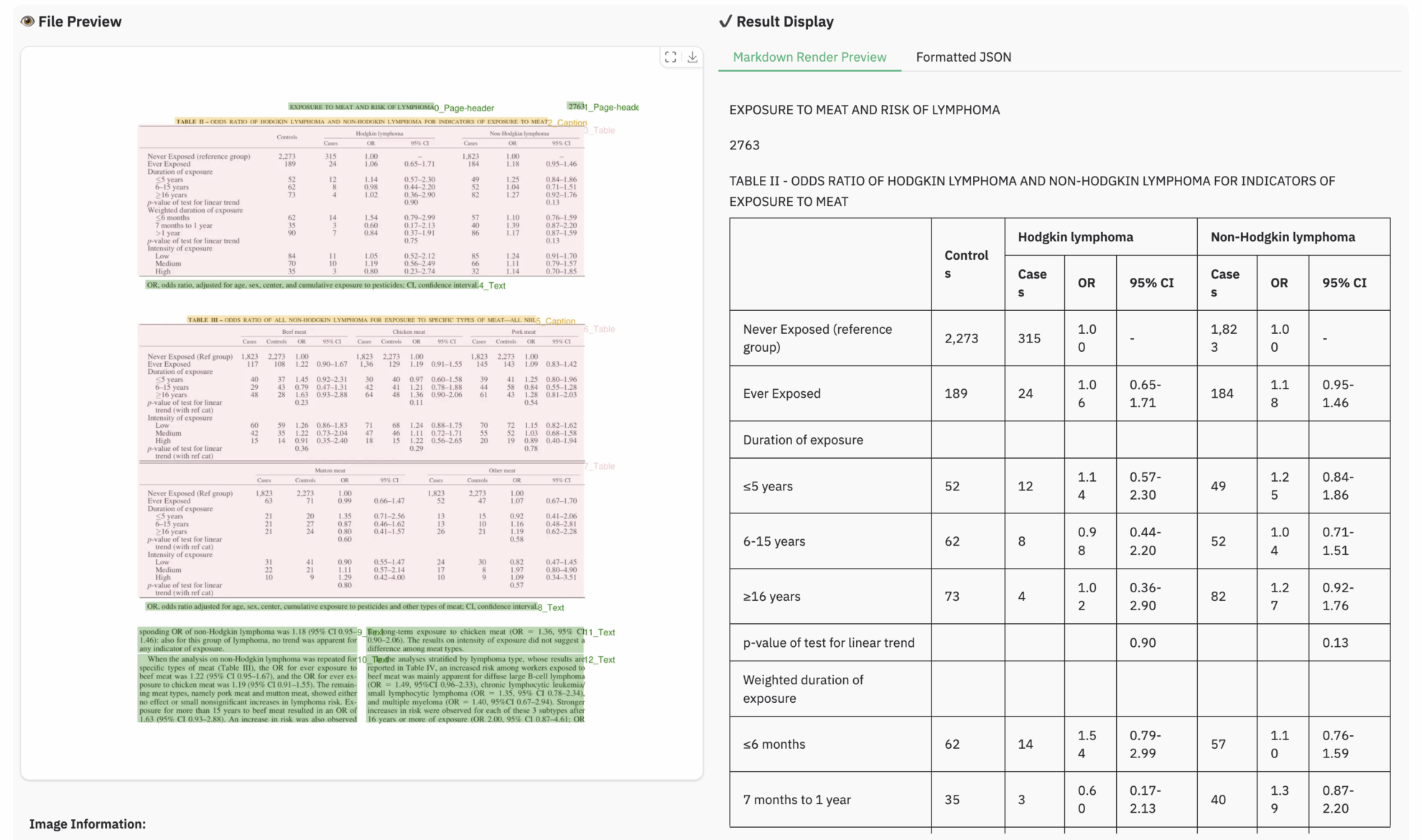

Am Beispiel der Funktion „Parse“ habe ich ein englisches Dokument hochgeladen. Der Effekt ist wie folgt:

Unabhängig davon, ob es sich um eine Tabelle oder eine Formel handelt, kann das Modell Folgendes hervorragend erkennen:

Das Obige ist das diesmal von HyperAI empfohlene Tutorial. Jeder ist herzlich eingeladen, vorbeizukommen und es auszuprobieren!

Link zum Tutorial:https://go.hyper.ai/49mZU

Erhalten Sie mit einem Klick hochwertige Papiere und ausführliche Interpretationsartikel im Bereich AI4S von 2023 bis 2024 ⬇️