Command Palette

Search for a command to run...

Online-Tutorial – Wichtige Neuerungen in Der YOLO-Reihe! Das Tsinghua-Team Veröffentlicht YOLOE, Das Objekte in Offenen Szenen in Echtzeit Erkennen Und Segmentieren Kann

Seit seiner Erstveröffentlichung im Jahr 2015 hat sich YOLO (You Only Look Once) zu einem der einflussreichsten Echtzeit-Objekterkennungsmodelle im Bereich der Computervision entwickelt. Diese End-to-End-Zielerkennungstechnologie, die auf einer einstufigen Erkennungsarchitektur basiert, wurde in den letzten 10 Jahren um mehr als zehn Versionen aktualisiert. Dank der Echtzeitverarbeitung hochpräziser Bilder mit hoher Bildrate wird es in vielen Bereichen eingesetzt, beispielsweise beim autonomen Fahren, in der medizinischen Bildanalyse und in der Robotersicht.

Obwohl die traditionellen Modelle der YOLO-Reihe Faltungsneuronale Netzwerke verwenden, um eine leistungsstarke Echtzeiterkennung zu erreichen,Allerdings basiert es auf vordefinierten Zielkategorien und es mangelt ihm an Flexibilität in praktischen offenen Szenarien.

Um dieses Problem zu lösen, hat das Team der Tsinghua-Universität auf der Grundlage von YOLOEs wird das offene Objekterkennungs- und -segmentierungsmodell YOLOE vorgeschlagen, das drei Arten von Szenarien unterstützt: Textaufforderungen, visuelle Hinweise und aufforderungsfreie Szenarien.Diese multimodale Fähigkeit ermöglicht es ihm, Sprachbefehle zu verstehen, Bilder zu sehen und sogar selbstständig neue Dinge zu entdecken, wodurch er wirklich „alles in Echtzeit sehen“ kann.

Derzeit wurde im Tutorial-Bereich der offiziellen Website von HyperAI ein Ein-Klick-Bereitstellungstutorial „YOLOE: Alles in Echtzeit sehen“ veröffentlicht. Interessierte Freunde, kommt und erlebt es!

Link zum Tutorial:

Demolauf

1. Melden Sie sich bei hyper.ai an, wählen Sie auf der Seite „Tutorials“ „YOLOE: Alles in Echtzeit sehen“ aus und klicken Sie auf „Dieses Tutorial online ausführen“.

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

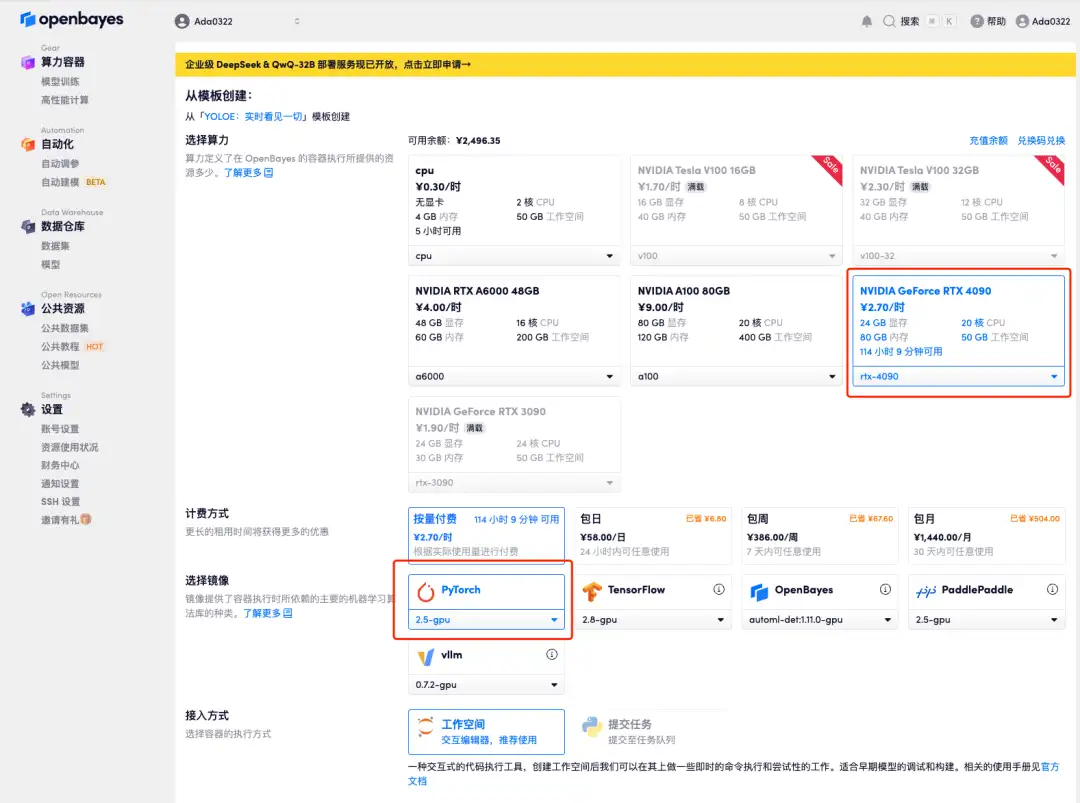

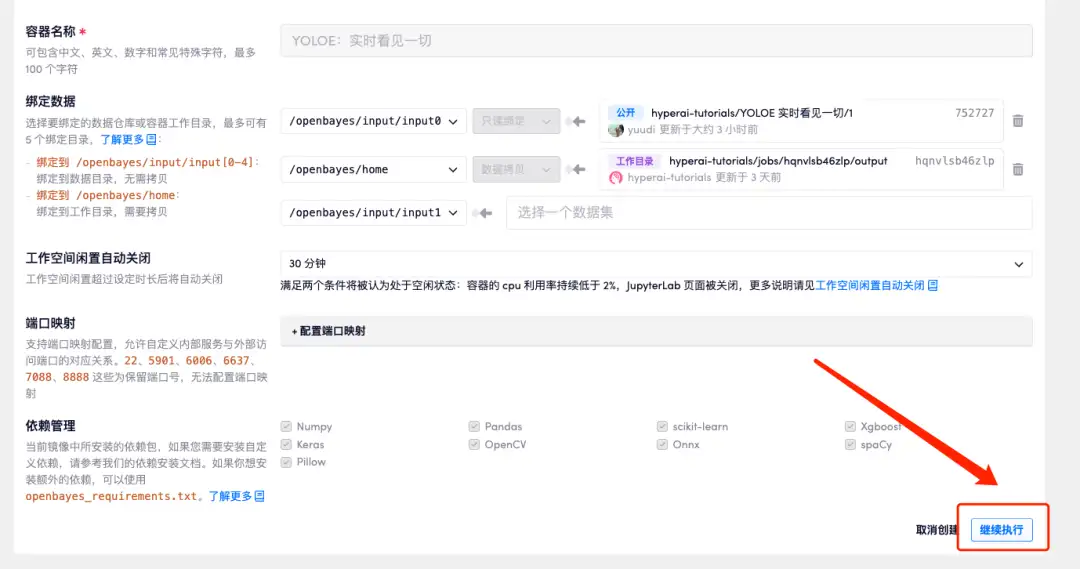

3. Wählen Sie die Bilder „NVIDIA RTX 4090“ und „PyTorch“ aus. Die OpenBayes-Plattform hat eine neue Abrechnungsmethode eingeführt. Sie können je nach Bedarf zwischen „Pay as you go“ oder „Tages-/Wochen-/Monatspaket“ wählen. Klicken Sie auf „Weiter“. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren, um 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit zu erhalten!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://go.openbayes.com/9S6Dr

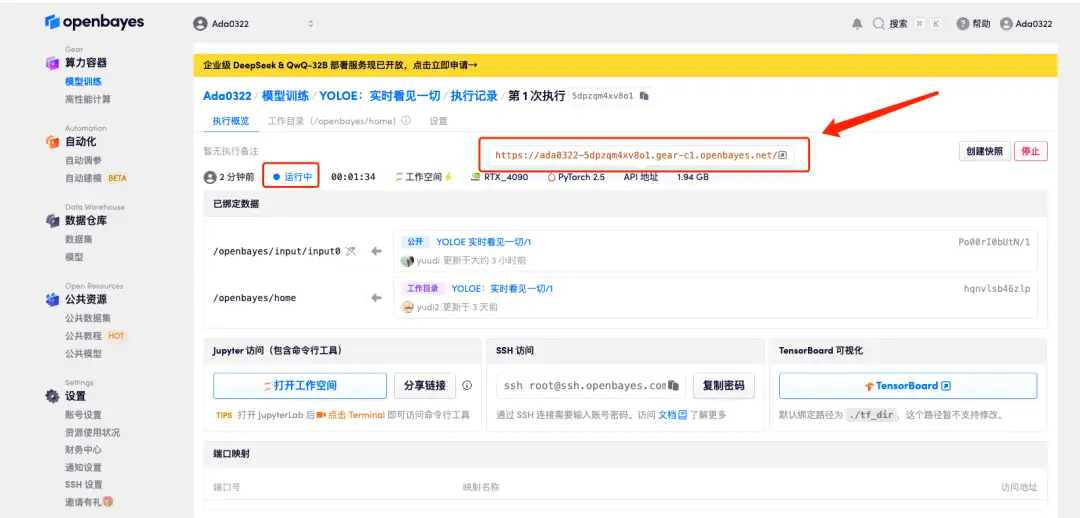

4. Warten Sie, bis die Ressourcen zugewiesen wurden. Der erste Klonvorgang dauert etwa 2 Minuten. Wenn sich der Status in „Läuft“ ändert, klicken Sie auf den Sprungpfeil neben „API-Adresse“, um zur Demoseite zu springen. Da das Modell groß ist, dauert es etwa 3 Minuten, bis die WebUI-Schnittstelle angezeigt wird, andernfalls wird „Bad Gateway“ angezeigt. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresszugriffsfunktion eine Echtnamenauthentifizierung durchführen müssen.

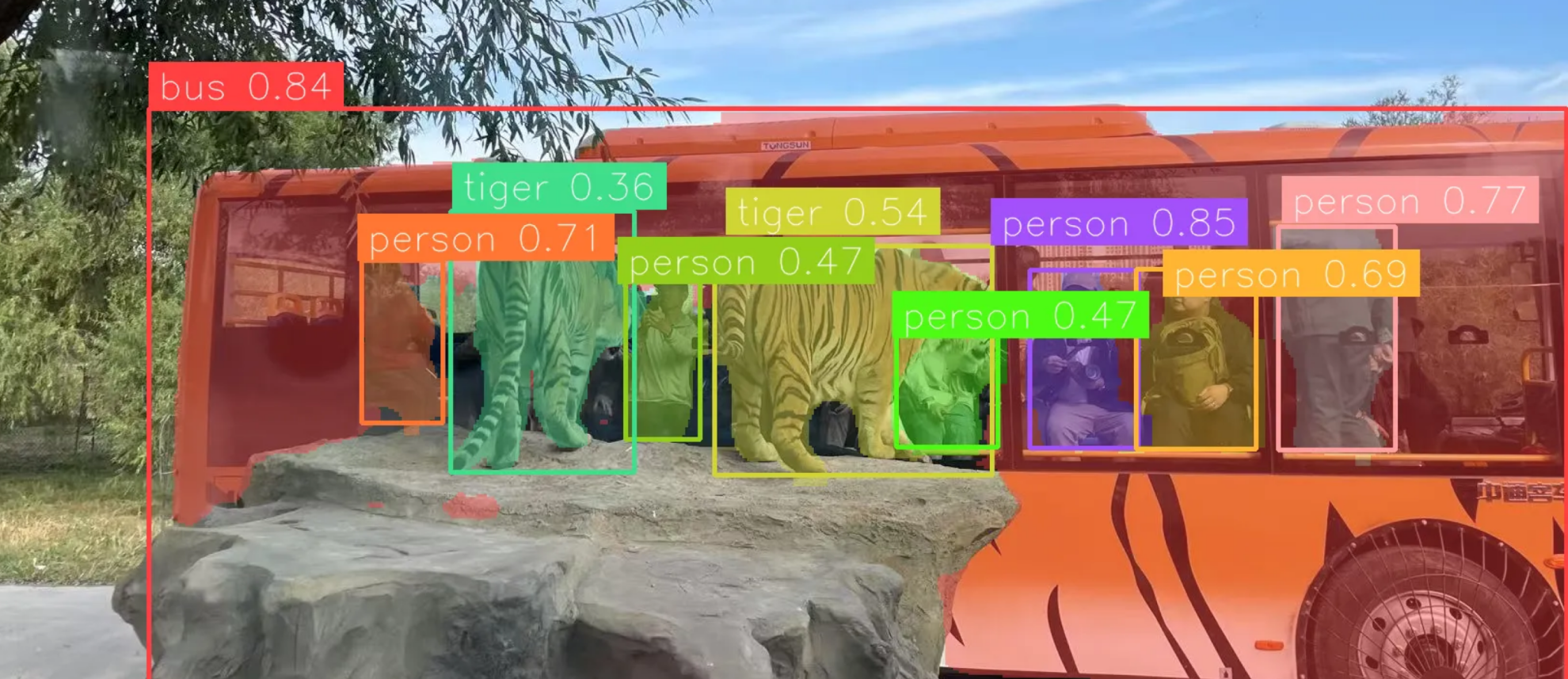

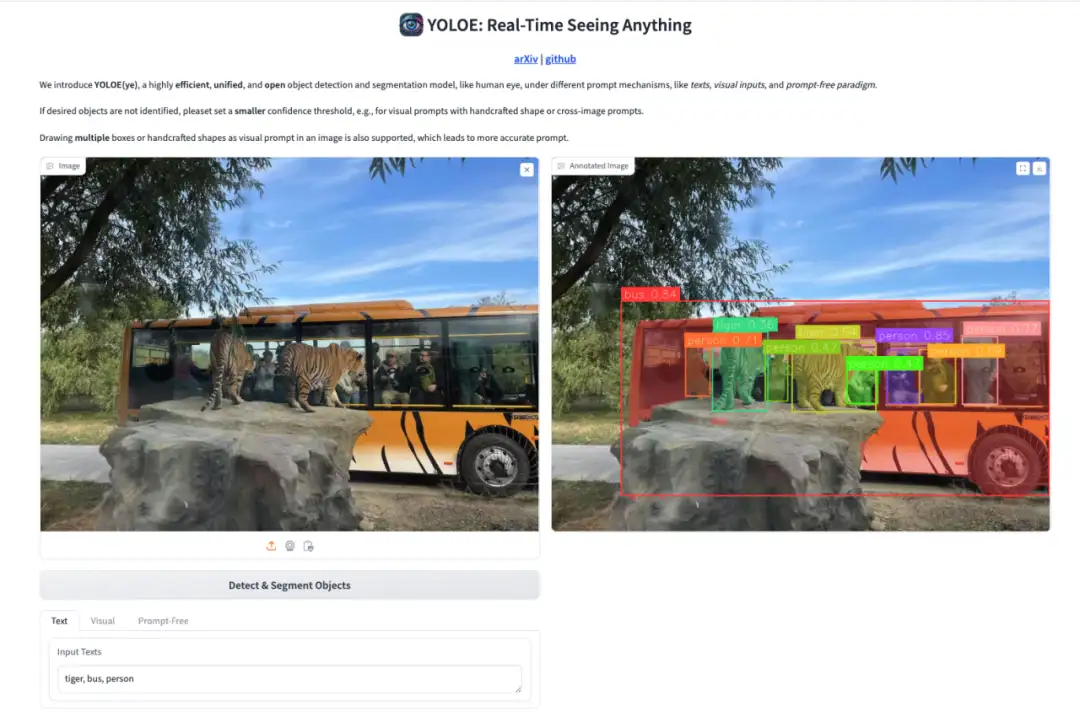

Effektanzeige

Die erste ist die Texteingabeaufforderungserkennung.YOLOE unterstützt die Erkennung und Segmentierung von Texthinweisen für jede Textkategorie. Die Texteingabe in der folgenden Abbildung lautet „Tiger, Bus, Person“. Das Erkennungsergebnis ist in der Abbildung rechts dargestellt. Der Tiger, der Sightseeing-Bus und die Touristen auf dem Bild sind deutlich zu erkennen. Es ist ersichtlich, dass selbst Touristen mit verdecktem Kopf oder an dunklen Orten eindeutig identifiziert werden können.

Der zweite Grund sind visuelle Hinweise.Nach der Festlegung des Erkennungsziels mittels Kästchen/Punkten/handgezeichneten Formen/Referenzbildern können ähnliche Erkennungsobjekte genau identifiziert werden, wie in der folgenden Abbildung dargestellt:

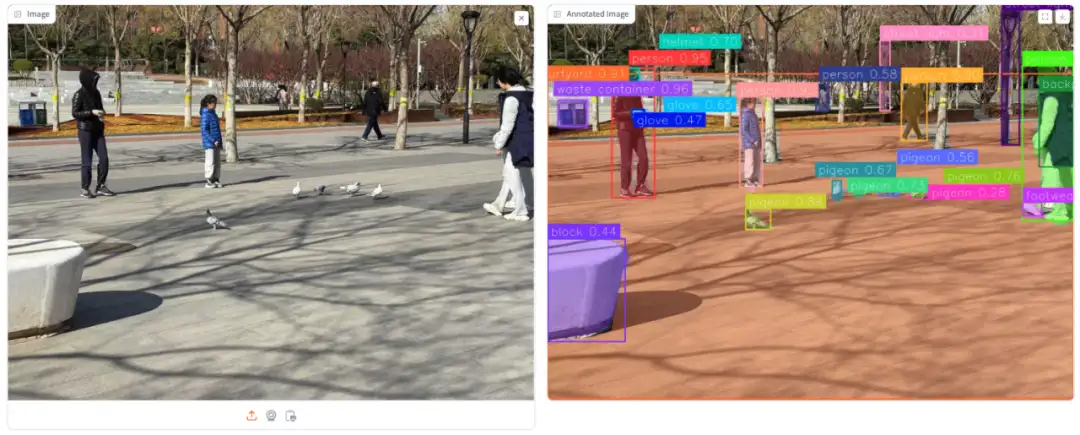

Schließlich gibt es eine vollautomatische Lautloserkennung.Es kann Szenenobjekte automatisch identifizieren, wie in der folgenden Abbildung dargestellt:

Das Obige ist das diesmal von HyperAI empfohlene Tutorial. Kommen Sie vorbei und probieren Sie es selbst aus!

Link zum Tutorial: