Command Palette

Search for a command to run...

قام داريو أمودي، الذي يصر على الإشراف الاستباقي، بدمج سلامة الذكاء الاصطناعي في مهمة الشركة بعد مغادرته شركة OpenAI.

في دورة الذكاء الاصطناعي الحالية، التي تغذيها المنافسة على قوة الحوسبة، والتنافس بين عمالقة التكنولوجيا، والاستثمار المتسارع، يُعد داريو أمودي، المؤسس المشارك والرئيس التنفيذي لشركة أنثروبيك، أحد القلائل، وإن كان لا يُنكر، من "المخالفين" في وادي السيليكون. فبينما تُعطي معظم شركات التكنولوجيا الأولوية لـ"التطوير الأسرع والقدرات الأقوى" كأهداف أساسية، يلتزم هو باستمرار برأي يزداد إقناعًا:"السلامة ليست مكبحًا، بل هي الحاجز المؤسسي الوحيد الذي يسمح للصناعة بمواصلة التقدم."

بحسب داريو أمودي، فإن النمو الهائل لقدرات النماذج واسعة النطاق خلال السنوات الخمس المقبلة سيتجاوز حتماً تطور آليات الحوكمة الاجتماعية.بدون إطار حوكمة أمنية من أعلى إلى أسفل، سيقع تطوير الذكاء الاصطناعي في "حلقة رد فعل عكسي معقدة" خطيرة.إن سرعة النمو التكنولوجي تطغى تماماً على نظام الحوكمة، مما يؤدي في النهاية إلى تراكم المخاطر لتصبح تهديدات نظامية، الأمر الذي قد لا يؤدي فقط إلى أزمات للمؤسسات الفردية، بل قد يعطل أيضاً عمل المجتمع بأكمله.

بالعودة إلى نقطة انطلاق هذا التباين التكنولوجي والحوكمي، يبدو أن الحجة الأساسية القائلة بأن "الأمن ليس نقيضًا للابتكار، بل هو المنطق الكامن الوحيد الذي يسمح للذكاء الاصطناعي بالتطور المستمر بعد أن يصبح جزءًا من البنية التحتية الوطنية" تؤكد حقيقةً: داريو أمودي لا يروج لنهجٍ أمنيٍّ بحت، بل لبروتوكولٍ منطقيٍّ لعصر الذكاء الاصطناعي. هذا البروتوكول يضع متطلبات تشغيلية قابلة للتحكم والتدقيق والإيقاف للتوسع التكنولوجي، مما يمنع توقف نمو القدرات فجأةً بسبب خطرٍ نظامي. باختصار، توفر هذه الرؤية دعمًا أساسيًا مستقرًا للتوسع التجاري طويل الأجل للذكاء الاصطناعي، بدلًا من أن تعارض الابتكار وتبطئه.

من مغادرة OpenAI إلى إنشاء Anthropic: "إعلان الاستقلال" بعد انقسام القيم.

يمكن إرجاع ارتباط داريو أمودي العميق بـ "المسار الآمن" إلى الفترة التي قضاها في شركة OpenAI واختلافاته مع القيم الأساسية للشركة.

في حوالي عام 2020، ومع التسويق السريع لنماذج سلسلة GPT، قامت OpenAI بتسريع جهودها في التكرار التكنولوجي والتسويق، ولكن آليات إدارة المخاطر وأنظمة الحوكمة المقابلة لم يتم تحديدها بوضوح بعد.

في عام ٢٠٢٣، وبعد أن رفعت صحيفة نيويورك تايمز دعوى قضائية ضد شركة OpenAI وشركات أخرى بتهمة انتهاك حقوق النشر، أبدى بعض الباحثين داخل OpenAI قلقهم إزاء وتيرة التسويق السريع. إلا أن داريو أمودي كان قد تنبأ بهذا الأمر قبل سنوات، وكان من أبرز الشخصيات التي دعت إلى آلية أكثر دقة لتقييم المخاطر داخل الشركة. فقد دعا إلى إضافة خطوة للتنبؤ بالمخاطر قبل تطوير النموذج، وتحسين عملية اختبار السلامة قبل طرحه في السوق. ومع ذلك، فقد تم تجاهل هذه المقترحات، التي كانت تميل نحو التطوير المؤسسي، تدريجيًا بفعل ضغوط التسويق المتزايدة التي واجهتها الشركة.

بعد انتكاسات متكررة في مقترحاته المؤسسية الداخلية، غادر داريو أمودي ومجموعة من الباحثين الأساسيين شركة OpenAI رسميًا في عام 2021 لتأسيس شركة Anthropic.وراء هذا الانطلاق لبدء مشروع تجاري، ليس من الصعب رؤية عدم التوازن في فلسفاتهم فيما يتعلق بإعطاء الأولوية للسلامة مقابل التسويق التجاري.

يعكس بيان مهمة شركة أنثروبيك بوضوح هذا الاختلاف في المنظور. فبدلاً من استخدام العبارة الشائعة في هذا المجال "بناء ذكاء اصطناعي قوي"، تنص الشركة صراحةً على أنها "تبني أنظمة ذكاء اصطناعي موثوقة وقابلة للتفسير والتوجيه".

في ذلك الوقت، كانت الرواية السائدة في وادي السيليكون لا تزال تتمحور حول فكرة "القدرة هي الميزة"، حيث كانت جميع الشركات تقريبًا تتنافس على نطاق معايير النموذج، والاستثمار في قوة الحوسبة، وسرعة نشر التطبيقات. ومع ذلك، اختار داريو أمودي مسارًا معاكسًا. إن اعتبار "القدرة على التحكم" جوهر المنافسة المستقبلية، هذا الخيار الذي يبدو غير بديهي، وضع الأساس المفاهيمي الكامل لتنفيذ استراتيجية الأمن اللاحقة لشركة أنثروبيك.

المنطق الأساسي لـ "الأمن كاستراتيجية" هو: مع تحسن القدرات، يجب أن تتحسن الحوكمة بالتوازي.

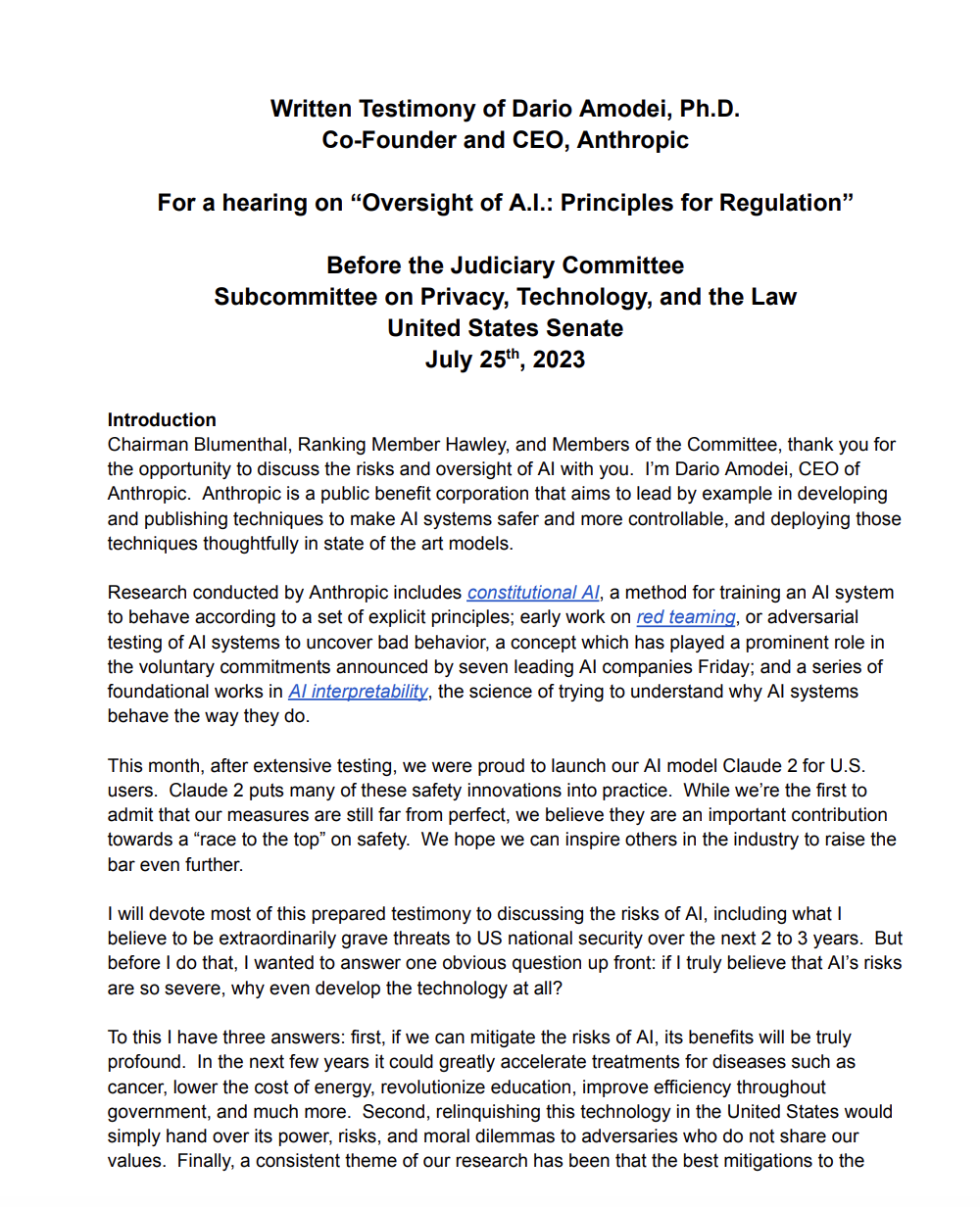

على عكس العديد من شركات التكنولوجيا التي تتعامل مع "السلامة الأخلاقية" كمجرد زينة في التقارير الفنية أو كنقطة بيع لجذب المستخدمين، يروج داريو أمودي لإطار عمل استراتيجي متطور للسلامة. في شهادته المكتوبة أمام مجلس الشيوخ الأمريكي حول مخاطر الذكاء الاصطناعي وتنظيمه، أكد قائلاً: "لا يمكننا التنبؤ بشكل كامل بقدرات الجيل القادم من النماذج، لذلك يجب علينا وضع ضمانات مؤسسية متعددة المستويات قبل بنائها، بدلاً من محاولة معالجة الوضع بعد وقوع المخاطر".

وبناءً على هذا المفهوم، قامت شركة أنثروبيك ببناء "نموذج التطور المشترك للقدرات والأمن" الكامل، حيث قامت بتضمين حوكمة الأمن في كل جانب من جوانب تطوير التكنولوجيا.

* التنبؤ بالقدرات:باستخدام البيانات التاريخية ونماذج الخوارزميات، يمكننا تقييم القدرات الجديدة التي قد تظهر في الجيل القادم من النماذج الكبيرة مسبقًا، وخاصة تلك القدرات التي قد تنطوي على مخاطر محتملة، مثل توليد معلومات مضللة أكثر دقة وكتابة أكواد أكثر تعقيدًا (والتي يمكن استخدامها في الهجمات الإلكترونية).

* مستويات الأمان:بالاستناد إلى نظام مستوى المخاطر في صناعة الطاقة النووية، يتم تقسيم مستويات السلامة المختلفة وفقًا لقوة قدرة النموذج وسيناريوهات التطبيق، حيث يتوافق كل مستوى مع معايير اختبار مختلفة، وتصاريح استخدام، وآليات مراقبة؛

* فرق الاختبار الخارجية ومتطلبات قابلية التفسير:فرض إدخال فرق حمراء خارجية من مختلف المؤسسات والمجالات لاختبار الهجمات، مع اشتراط أن يوفر النموذج سلسلة منطقية قابلة للتفسير لعمليات صنع القرار الرئيسية لتجنب المخاطر الناجمة عن "صنع القرار في الصندوق الأسود"؛

* بوابات السماح/عدم السماح:قم بإنشاء بوابات "قبول/منع" عند العقد الرئيسية لتكرار النموذج. لا يُسمح بالمرحلة التالية من التطوير أو النشر إلا بعد استيفاء اختبارات الأمان للمعايير واجتياز تقييم المخاطر، مما يُحدد بوضوح مبدأ "التوسع مسموح فقط إذا كان قابلاً للتحكم".

بفضل هذا الهيكل الأمني المنهجي، أصبح داريو أمودي، في نظر صانعي السياسات الأمريكيين، "رئيسًا تنفيذيًا لشركة تقنية يتمتع بفهم أعمق للحوكمة". وفي يوليو/تموز 2023، عندما عقد مجلس الشيوخ الأمريكي منتدىً حول الذكاء الاصطناعي، دُعي خصيصًا للمشاركة في جلسة الاستماع. وأصبحت آراؤه حول "التنظيم المتدرج" و"التنبؤ المسبق بالمخاطر" من بين أكثر الآراء التقنية استشهادًا بها في المناقشات اللاحقة حول قانون أمن الذكاء الاصطناعي.

بينما تتعامل معظم شركات وادي السيليكون مع الأمن كأصل للعلاقات العامة لتحسين صورتها، يرى داريو أمودي أنه نظام تشغيل "يدفع التطور طويل الأجل للصناعة" - فهو يؤمن إيماناً راسخاً بأنه فقط من خلال إنشاء إطار أمني مستقر يمكن للذكاء الاصطناعي أن ينتقل حقاً من "تكنولوجيا المختبر" إلى "البنية التحتية الاجتماعية".

لماذا الإصرار على "التنظيم المبكر"؟ لقد دخلت التكنولوجيا مرحلة من النمو غير الخطي.

من بين جميع آراء داريو أمودي، لا يُعدّ نهجه في التوافق التكنولوجي الأكثر إثارة للجدل، بل موقفه من التنظيم: "يجب أن يأتي التنظيم مُسبقًا، بدلًا من رد الفعل السلبي بعد ظهور المخاطر". يتناقض هذا الطرح بشكلٍ صارخ مع ثقافة وادي السيليكون الراسخة التي تدعو إلى "تنظيم أقل، وحرية أكبر"، لكن منطقه متجذر في فهم عميق لأنماط تطور تكنولوجيا الذكاء الاصطناعي، والتي تنبع أساسًا من ثلاثة أبعاد:

تنمو قدرات النماذج بشكل كبير، بينما التنظيم خطي.

من GPT-3 الذي احتوى على ما يقارب 175 مليار مُعامل في عام 2020، إلى GPT-4 في عام 2023 الذي شهد قفزة نوعية في القدرات (لم يُكشف عن حجم المُعاملات علنًا، لكن يُرجّح الكثيرون أنه يتراوح بين 500 مليار وتريليون مُعامل)، ثم إلى Claude 3 من Anthropic في عام 2024 (الذي تفوّق على سابقيه في العديد من اختبارات الأداء)، شهدت قدرات كل جيل من النماذج واسعة النطاق تحسّنًا هائلاً، وبرزت العديد من "القدرات غير المتوقعة" التي لم تكن موجودة في النماذج السابقة، مثل تحسين الشيفرة البرمجية تلقائيًا، وفهم النصوص القانونية المعقدة، وإنتاج أوراق بحثية بمستوى احترافي تقريبًا. هذا النمو "غير خطي" وغالبًا ما يتجاوز توقعات الصناعة.

ومع ذلك، فإن إنشاء نظام تنظيمي يتطلب مراحل متعددة، بما في ذلك البحث والمناقشة والتشريع والتنفيذ، وعادة ما تستغرق هذه العملية سنوات.يُظهر خاصية "خطية".إذا كانت اللوائح تتبع التكنولوجيا دائمًا، فسيتم خلق فراغ حيث "تكون القدرات موجودة ولكن الحوكمة غير موجودة"، وقد تتراكم المخاطر خلال فترة الفراغ هذه.

إن الخطر ليس مشكلة على مستوى التطبيق، بل مشكلة تتعلق بالقدرات الأساسية.

يعتقد الكثيرون أن مخاطر الذكاء الاصطناعي يمكن التخفيف منها من خلال "التحكم على مستوى التطبيق"، مثل وضع قواعد تصفية في سيناريوهات محددة. ومع ذلك، يشير داريو أمودي إلى أن...إن خطر النماذج واسعة النطاق هو في الأساس "مشكلة قدرات أساسية".— إن القدرات مثل توليد المعلومات القاتلة، وأتمتة المخاطر البيولوجية (على سبيل المثال، توليد خطط تجريبية بيولوجية خطيرة)، وقدرات اختراق الشبكة (على سبيل المثال، كتابة التعليمات البرمجية الخبيثة) كلها تنبع من القدرات الأساسية للنموذج، بدلاً من سيناريوهات التطبيق.

هذا يعني أنه حتى في حال تخفيف المخاطر في سيناريو تطبيق معين، قد يستغل النموذج قدراته الكامنة لخلق مخاطر جديدة في سيناريوهات أخرى. لذا، لا يمكن لضوابط طبقة التطبيق وحدها القضاء على المخاطر؛ بل يجب وضع عتبات أمنية على مستوى النموذج الأساسي من خلال التنظيم.

لا يمكن للمنافسة في السوق أن تنظم توسعها ذاتياً.

أكد داريو أمودي مرارًا وتكرارًا في المؤتمرات الصناعية أن "المنافسة في صناعة الذكاء الاصطناعي لها تأثير ضغط، فلن يُبطئ أي مورد طواعيةً وتيرة تطوير قدراته، لأنه بمجرد تخلفه عن الركب، قد يُقصى من السوق". في هذه البيئة التنافسية، يكاد يكون "الانضباط الذاتي" مستحيلاً، وغالبًا ما تُعطي الشركات الأولوية لتحسين القدرات مع تقليص اختبارات السلامة إلى الحد الأدنى.

لذلك، فهو يعتقد أنيجب أن يصبح التنظيم "قيداً خارجياً ملزماً".وضع معيار أمان موحد للصناعة بأكملها ومنع الشركات من الوقوع في حلقة مفرغة من الأموال السيئة التي تطارد الأموال الجيدة - أي "إذا لم تقم بإجراء اختبارات أمنية، فلن أقوم بها أنا أيضًا، وإلا ستكون التكلفة أعلى والسرعة أبطأ".

وراء هذه الأسباب يكمن جوهر حكم داريو أمودي على عصر الذكاء الاصطناعي:إن الذكاء الاصطناعي ليس "منتج محتوى" لعصر الإنترنت (مثل برامج التواصل الاجتماعي ومنصات الفيديو)، بل هو "تقنية بنية تحتية" يمكنها التأثير بشكل مباشر على عملية صنع القرار في العالم الحقيقي وهياكل المخاطر.وكما هو الحال مع الكهرباء والنقل، فإن التنظيم المبكر لهذه الأنواع من التقنيات لا يتعلق بـ "تقييد الابتكار"، بل يتعلق بـ "ضمان استدامة الابتكار".

النهج التقني: لا يتعلق الذكاء الاصطناعي الدستوري بالتصحيح، بل بإعادة بناء الآليات السلوكية للنماذج.

إذا وُصفت شركة OpenAI بأنها "رائدة تجارياً"، ووُصفت شركة Meta بأنها "تهيمن عليها منظومة المصادر المفتوحة"، ووُصفت شركة Google DeepMind بأنها "تتبع نهجاً مزدوجاً في البحث والهندسة".شعار شركة أنثروبيك واضح للغاية: المحاذاة كهندسة. وهذا يعني استخدام منهج هندسي منظم لضمان توافق سلوك نماذج الذكاء الاصطناعي مع القيم الإنسانية. ويُعدّ الذكاء الاصطناعي الدستوري (CAI) أبرز إنجازات هذا النهج، والذي طُوّر تحت قيادة داريو أمودي.

رابط الورقة:https://arxiv.org/abs/2212.08073

تقوم الفكرة الأساسية للذكاء الاصطناعي الدستوري على قلب نهج المواءمة التقليدي رأساً على عقب: فبدلاً من الاعتماد على الأحكام القيمية الذاتية للمعلقين البشريين لتعديل سلوكه، يقوم النموذج بمعايرة نفسه ذاتياً وفقاً لمجموعة من "المبادئ الدستورية" المفتوحة والقابلة للتدقيق والتكرار. يحتوي هذا "الدستور"، الذي طوره فريق أنثروبيك بالتعاون مع علماء الأخلاق والخبراء القانونيين وعلماء الاجتماع، على مئات المبادئ الأساسية، مثل "عدم توليد معلومات ضارة" و"احترام القيم المتنوعة" و"التحلي بالصدق بشأن القضايا غير المؤكدة".

في التطبيق العملي، يحقق الذكاء الاصطناعي الدستوري التوافق من خلال خطوتين أساسيتين: أولاً، يقوم النموذج بتقييم محتواه المُولّد ذاتياً استناداً إلى الدستور، مُحدداً الجوانب التي لا تتوافق مع المبادئ؛ ثم يُصحح النموذج نفسه بناءً على نتائج هذا التقييم الذاتي، مُحسّناً المحتوى الناتج باستمرار. ويُحقق هذا النهج ثلاثة آثار رئيسية:

* تقليل التحيز في قيمة RLHF:يعتمد التعلم المعزز التقليدي القائم على التغذية الراجعة البشرية على حكم المعلقين البشريين، ولكن قد يكون لدى المعلقين المختلفين تحيزات قيمية (مثل الخلفية الثقافية والاختلافات في الموقف الشخصي)، في حين أن الذكاء الاصطناعي الدستوري، القائم على "المبادئ الدستورية" الموحدة، يقلل بشكل كبير من هذه التحيزات؛

* عملية المحاذاة شفافة وقابلة للتتبع:إن "المبادئ الدستورية" عامة، كما أن عملية المعايرة الذاتية للنموذج قابلة للتسجيل والتدقيق، مما يسمح للعالم الخارجي بفهم سبب اتخاذ النموذج لقرار معين بوضوح، وبالتالي تجنب "التوافق الصندوق الأسود".

* اجعل الأمن عملية "هندسة أنظمة"، وليس مجرد حل مؤقت يعتمد على الحدس البشري:غالباً ما تتضمن التدابير الأمنية التقليدية "معالجة الثغرة الأمنية حيث تحدث المشكلة"، بينما يقوم الذكاء الاصطناعي الدستوري بإعادة بناء آلية سلوك النموذج من الصفر، مما يجعل الأمن "غريزة" للنموذج، بدلاً من كونه تصحيحاً خارجياً.

يُشكّل هذا النهج التكنولوجي الميزة الأساسية لنماذج كلود لدخول تطبيقات الإنتاج في الفترة 2024-2025، ألا وهي: استقرار أكبر، وتحكم أفضل، وسهولة أكبر في النشر على نطاق واسع. وتعتبر العديد من المؤسسات المالية وشركات المحاماة والدوائر الحكومية "التحكم" في نماذج كلود عاملاً جوهرياً عند اختيار النماذج واسعة النطاق، لأن هذه المجالات تتسم بانخفاض مستوى تحمل المخاطر وتتطلب مخرجات نموذجية مستقرة وقابلة للتنبؤ.

في المشهد العالمي لصناعة الذكاء الاصطناعي، تكتسب استراتيجية أمودي أهمية متزايدة. ومع توسع قدرات نماذجها لتشمل سيناريوهات عالية القيمة مثل تقييم المخاطر المالية والتشخيص الطبي، تزداد الحاجة إلى الأمن والموثوقية بشكل ملح.

على عكس التوسع التجاري السريع لشركة OpenAI، واستراتيجية Meta مفتوحة المصدر، وتركيز DeepMind على الأبحاث واستكشاف الذكاء الاصطناعي العام، تعتبر Anthropic الأمن أساسًا لدخول الأسواق الرئيسية. وهي تروج للوصول إلى معايير عالية في هذا المجال من خلال إتاحة أدوات تقييم الأمن الداخلية الخاصة بها لجهات خارجية، وتتوقع ظهور مسار "الأمن كخدمة" في المستقبل.

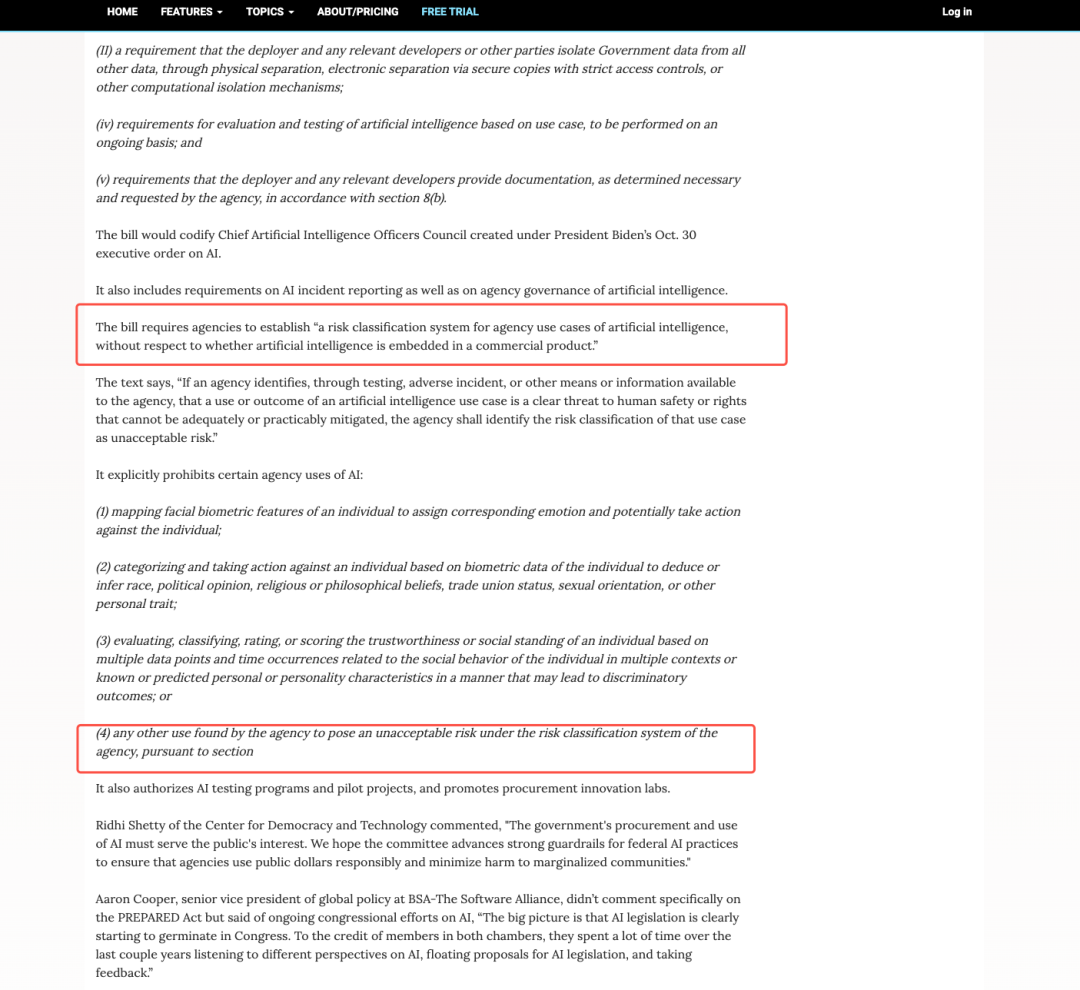

ويدعم هذا المنطق أيضاً الجوانب المتعلقة بالسياسات واللوائح التنظيمية:يفرض قانون الذكاء الاصطناعي في الاتحاد الأوروبي ومتطلبات المشتريات الفيدرالية الأمريكية معايير سلامة صارمة لأنظمة الذكاء الاصطناعي عالية المخاطر، مما يحوّل السلامة من قضية أخلاقية إلى ضرورة سياسية وسوقية. ورغم أن حصة أنثروبيك السوقية لا تزال أقل من حصة أوبن إيه آي، إلا أن أهميتها الاستراتيجية في التأثير على السياسات، واختراقها للصناعة الأساسية، وقدرتها على وضع معايير السلامة تتزايد باطراد. وهذا يُبرز موقع أنثروبيك، وإن كان موقعًا أقلية ولكنه ليس ضعيفًا، إذ تُساهم في تشكيل مشهد صناعة الذكاء الاصطناعي من خلال الوسائل المؤسسية والتكنولوجية، بدلاً من الاعتماد فقط على حصتها السوقية.

الانتقادات والجدل: هل سيصبح الأمن أداةً لاحتكارات الصناعة؟

رغم أن "نهج الأمن" الذي يتبناه داريو أمودي قد يبدو وكأنه توجه مثالي للمستقبل، إلا أنه يواجه معارضة شديدة من داخل وخارج قطاع الذكاء الاصطناعي. وتتركز هذه الخلافات بشكل أساسي على ثلاثة جوانب، مما يُبرز مدى تعقيد قضايا أمن الذكاء الاصطناعي:

قد يصبح الأمن سبباً لـ "تقييد المنافسة".

يُعد يان ليكان، كبير علماء شركة ميتا، أحد أبرز قادة التكنولوجيا المعارضين لـ "لوائح الأمن التقييدية المفرطة". وقد ألمح مرارًا وتكرارًا على وسائل التواصل الاجتماعي وفي المؤتمرات الصناعية إلى أن دعوة داريو أمودي إلى "التنظيم المبكر" و"معايير الأمن العالية" هي في الأساس "وضع حواجز عالية أمام دخول الشركات الناشئة" - فالشركات الكبيرة لديها أموال وموارد كافية للاستثمار في البحث والتطوير الأمني.قد يتم القضاء على الشركات الناشئة لأنها لا تستطيع تحمل تكاليف الأمن، مما يؤدي في النهاية إلى احتكارات صناعية.

حظيت آراء لوكون بدعم العديد من الشركات الناشئة في مجال الذكاء الاصطناعي. فهم يعتقدون أن معايير الأمان الحالية غير موحدة بعد، وأن التطبيق المبكر للوائح صارمة قد يسمح بأن يصبح "الأمان" أداة تستخدمها الشركات العملاقة لإقصاء الشركات الصغيرة.

لا يمكن قياس السلامة كمياً، وسرعان ما تصبح مجرد شعار فارغ.

ومن النقاط الرئيسية الأخرى للخلاف "إمكانية قياس الأمن".تتسم معايير تقييم سلامة الذكاء الاصطناعي حاليًا بتشتت كبير، حيث تتبنى الشركات المختلفة معايير غير متسقة لتحديد "مفهوم الذكاء الاصطناعي الآمن". وتختلف أساليب وكثافة وشفافية "اختبارات السلامة والتقييم واختبارات الاختراق" اختلافًا كبيرًا، بل لا يوجد حتى تعريف موحد لمفهوم "الذكاء الاصطناعي الآمن". فعلى سبيل المثال، تعتبر شركة أنثروبيك "المعايرة الذاتية للنموذج" آمنة، بينما قد تعتبر شركة أوبن إيه آي "اجتياز اختبارات الاختراق الخارجية" آمنة، في حين قد تهتم الوكالات الحكومية أكثر بـ "عدم توليد النموذج لمعلومات ضارة".

يُصعّب هذا التشتت قياس مفهوم "الأمان"، مما يجعله مجرد شعارٍ فارغٍ تستخدمه الشركات لتحسين صورتها؛ إذ يمكن لشركةٍ ما أن تدّعي أن نموذجها "آمنٌ للغاية"، لكنها لا تستطيع إثبات ذلك باستخدام المعايير المعترف بها في هذا المجال. ويرى النقاد أنه قبل توحيد المعايير، قد يُضلل التركيز المفرط على "الأمان" السوق، ويجعل المستخدمين يعتقدون خطأً أن مخاطر الذكاء الاصطناعي قد تم التغلب عليها. علاوةً على ذلك، تشير الأبحاث الأكاديمية إلى أن التنظيم المفرط أو غير المرن (أو تطبيق قواعد موحدة على الجميع) لتطوير الذكاء الاصطناعي قد يُعيق الابتكار.

رابط المقال:https://arxiv.org/abs/2104.03741

هناك انفصال طبيعي بين التكنولوجيا والتنظيم.

يشير العديد من خبراء التكنولوجيا إلى أن القدرة على التنبؤ بالنماذج واسعة النطاق لا تزال مشكلة علمية لم تُحل بعد، فحتى أكثر الباحثين تقدماً لا يستطيعون التنبؤ بدقة بقدرات الجيل القادم من النماذج، والمخاطر التي قد تنطوي عليها هذه القدرات. في هذا السياق، قد يواجه "التنظيم المبكر" مشكلتين: إما "سوء تقدير المخاطر"، أي التعامل مع الابتكارات التكنولوجية غير الضارة على أنها مخاطر وتقييدها؛ أو "تجاهل المخاطر"، أي الفشل في توقع المخاطر الحقيقية، مما يؤدي إلى فشل التنظيم.

وقد ردّ داريو أمودي على هذه الانتقادات. وأقرّ بضرورة "تعديل معايير الأمن بشكل ديناميكي"، ودعم الدعم الحكومي لأبحاث وتطوير الأمن التي تُجريها الشركات الناشئة بهدف تذليل العقبات أمام المنافسة. ومع ذلك، أكد قائلاً: "حتى في حال وجود انتقادات، لا يمكننا الانتظار حتى تتجسّد المخاطر قبل اتخاذ الإجراءات اللازمة، فتكلفة "غياب التنظيم" تفوق بكثير تكلفة "الإفراط في التنظيم".

في الواقع، تُسلط هذه الخلافات الضوء على أمر واحد:إن أمن الذكاء الاصطناعي ليس مجرد قضية تقنية وعلمية، بل هو أيضاً قضية سياسية واقتصادية. يشمل ذلك أبعادًا متعددة كالهيكل الصناعي، وقواعد المنافسة، وتوزيع القوة العالمية. لا يوجد حل "مثالي"، ولا يسعنا إلا استكشاف التوازن وسط هذا الجدل.

لا يسعى أمودي إلى "مسار آمن"، بل إلى "بروتوكول منطقي" لعصر الذكاء الاصطناعي.

إذا نظرنا إلى تاريخ تطور الإنترنت، فسنجد أن السبب وراء تطور الإنترنت من "أداة أكاديمية" إلى "بنية تحتية عالمية" هو...يكمن جوهر الأمر في إنشاء بروتوكول أساسي موحد. —بروتوكول التحكم في الإرسال/بروتوكول الإنترنت (TCP/IP)، ونظام أسماء النطاقات (DNS)، وبروتوكول أمان نقل النص التشعبي (HTTPS)، وما إلى ذلك. لا تتضمن هذه البروتوكولات سيناريوهات تطبيق محددة، ولكنها توفر "لغة عالمية" لجميع خدمات الإنترنت، مما يسمح للمستخدمين من مختلف الأجهزة والمنصات والمناطق بالاتصال بسلاسة.

في رأيي،لا يسعى داريو أمودي إلى اتباع "نهج السلامة" البسيط، بل يحاول وضع "بروتوكول منطقي" مماثل لعصر الذكاء الاصطناعي.— بنية حوكمة موحدة وآمنة وقابلة للتدقيق والتكرار. لا يهدف هذا "البروتوكول" في جوهره إلى "تقييد قدرات الذكاء الاصطناعي"، بل إلى "تمكين قدرات الذكاء الاصطناعي من تحقيق قيمتها ضمن إطار عمل قابل للتحكم".

ما يريد فعله ليس رفع حواجز الدخول إلى الصناعة، ولا إبطاء نمو الصناعة، بل إنشاء "نظام أمان قائم على الذكاء الاصطناعي يمكن فهمه وتكراره واستخدامه على مستوى العالم".وكما أن بروتوكول TCP/IP يمكّن الإنترنت من تحقيق "الترابط"، فإن "بروتوكولات الحوكمة" الخاصة بالذكاء الاصطناعي يمكنها تمكين تقنيات الذكاء الاصطناعي العالمية من تحقيق "التطوير التعاوني" على أساس آمن، وتجنب انتشار المخاطر وإهدار الموارد الناجم عن المعايير غير المتسقة.

هذا ليس تشاؤماً تكنولوجياً، بل هندسة صناعية. يُقرّ هذا النهج بمخاطر الذكاء الاصطناعي، لكنه يعتقد بإمكانية السيطرة عليها من خلال التصميم المؤسسي؛ ولا ينكر قيمته الابتكارية، لكنه يُصرّ على ضرورة وجود حدود للابتكار. وكما شهد الإنترنت نموًا هائلاً بعد اعتماد البروتوكولات، فإن المرحلة الثانية من الذكاء الاصطناعي، من "الانفجار التكنولوجي" إلى "التطبيق المستقر"، قد تتطلب مجموعة من "بروتوكولات الحوكمة" كركيزة أساسية.

الكلمات الأخيرة

مع تحوّل الذكاء الاصطناعي تدريجياً إلى ركيزة أساسية تؤثر على الإنتاجية والقدرات العسكرية والأمن القومي، لن يصبح "الأمن" قضية تقنية فحسب، بل قضية استراتيجية تتعلق بالنظام العالمي. في المستقبل، من يستطيع تعريف "الأمن" سيتمكن من وضع قواعد صناعة الذكاء الاصطناعي؛ ومن يستطيع وضع "إطار أمني" سيحظى بالأفضلية في المنافسة التكنولوجية العالمية.

قد لا يكون داريو أمودي الرائد الوحيد في هذا التحول، لكنه بلا شك الأكثر وضوحًا والأكثر إثارة للجدل. تكمن قيمته لا في اقتراح "حل مثالي"، بل في إجبار قطاع الذكاء الاصطناعي والمجتمع العالمي على مواجهة قضية جوهرية: لكي يتقدم الذكاء الاصطناعي نحو المستقبل، لا يمكنه الاعتماد فقط على الحماس التكنولوجي، بل أيضًا على العقلانية المؤسسية. وهذا تحديدًا هو مفتاح تحويل الذكاء الاصطناعي من "تقنية ثورية" إلى "قوة بناءة".

روابط مرجعية:

1.https://www.anthropic.com/news/claude-3-family

2.https://www.reuters.com/business/retail-consumer/anthropic-ceo-says-proposed-10-year-ban-state-ai-regulation-too-blunt-nyt-op-ed-2025-06-05

3.https://arxiv.org/abs/2212.08073

4.https://arstechnica.com/ai/2025/01/anthropic-chief-says-ai-could-surpass-almost-all-humans-at-almost-everything-shortly-after-2027/

5.https://www.freethink.com/artificial-intelligence/agi-economy