Command Palette

Search for a command to run...

برنامج تعليمي عبر الإنترنت: Wan2.2-S2V-14B، وهو نموذج توليد فيديو بجودة الفيلم، يقوم بإنشاء مقاطع فيديو بشرية رقمية مدتها دقيقة واحدة باستخدام الصور الثابتة والصوت فقط.

شاركت HyperAI مؤخرًا دورةً تعليميةً عبر الإنترنت حول Wan2.2، وهو نموذج توليد فيديو مفتوح المصدر بتقنية الذكاء الاصطناعي من مختبر تونغيي وانكسيانغ التابع لشركة علي بابا. وبصفته أول نموذج فيديو قائم على تقنية MoE في العالم، أبهرنا Wan2.2 بجودته السينمائية وكفاءته الحسابية العالية. ما رأيكم في استخدامه؟ شاركونا آراءكم في قسم التعليقات.

في أغسطس من هذا العام، حقق فريق تونغي وانكسيانغ تقدمًا جديدًا. بناءً على نموذج Wan2.2 الأساسي لتحويل النصوص إلى مقاطع فيديو، قاموا ببناء Wan-14B.وبناءً عليه، تم إطلاق نموذج مفتوح المصدر لتوليد الفيديو المعتمد على الصوت Wan2.2-S2V-14B.يتطلب النموذج صورة ثابتة ومقطع صوتي فقط.يمكنه إنشاء مقاطع فيديو بشرية رقمية بجودة الفيلم، مع مدة تصل إلى عدة دقائق، ويدعم مجموعة متنوعة من أنواع الصور والإطارات.أجرى فريق البحث تجارب قارنتها بالنماذج المتطورة الموجودة، وأظهرت النتائج أن Wan2.2-S2V-14B لديه تحسينات كبيرة في كل من التعبير ومصداقية المحتوى الناتج.

لدعم جودة إنشاء النموذج في السيناريوهات المعقدة، اعتمد فريق البحث استراتيجية مزدوجة لتجميع مجموعة بيانات تدريبية أكثر شمولاً.من جهة، قام الفريق بفحص البيانات تلقائيًا من مجموعات بيانات مفتوحة المصدر واسعة النطاق مثل OpenHumanViD. ومن جهة أخرى، اختار الباحثون يدويًا بيانات عينات عالية الجودة وخصّصوها. وخضعت كلتا المجموعتين من البيانات للتصفية بشكل موحد من خلال طرق متعددة، بما في ذلك تتبع الوضعية، وتقييم الوضوح والجماليات، واكتشاف التزامن السمعي البصري، مما أدى في النهاية إلى إنشاء مجموعة بيانات للرأس الناطق. وباستخدام استراتيجية تدريب متوازية هجينة، حققوا كفاءة في استخراج بيانات أداء النموذج.

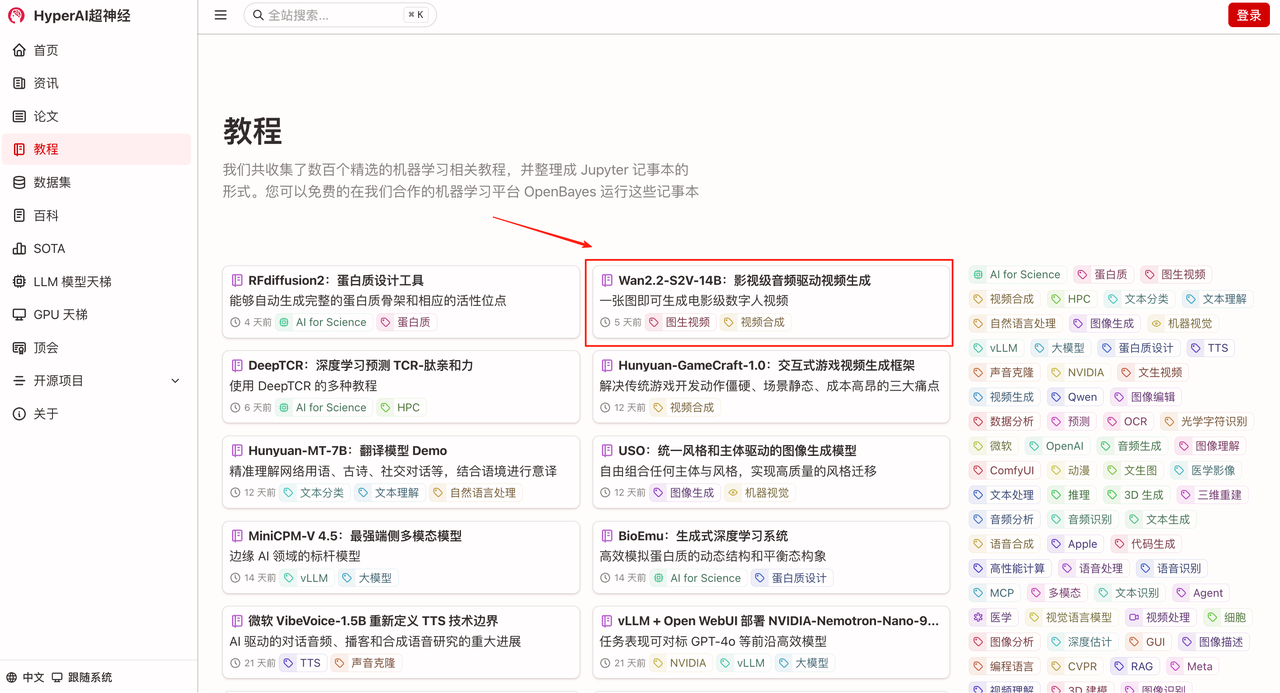

"Wan2.2-S2V-14B: إنشاء فيديو سينمائي مُدار بالصوت" متوفر الآن في قسم "الدروس التعليمية" على الموقع الرسمي لشركة HyperAI (hyper.ai). انضم إلينا لإنشاء إنسانك الرقمي الخاص!

رابط البرنامج التعليمي:

تشغيل تجريبي

1. في الصفحة الرئيسية لـ hyper.ai، حدد صفحة البرامج التعليمية، واختر Wan2.2-S2V-14B: Film-Quality Audio-Driven Video Generation، ثم انقر فوق تشغيل هذا البرنامج التعليمي عبر الإنترنت.

2. بعد الانتقال إلى الصفحة التالية، انقر فوق "استنساخ" في الزاوية اليمنى العليا لاستنساخ البرنامج التعليمي في الحاوية الخاصة بك.

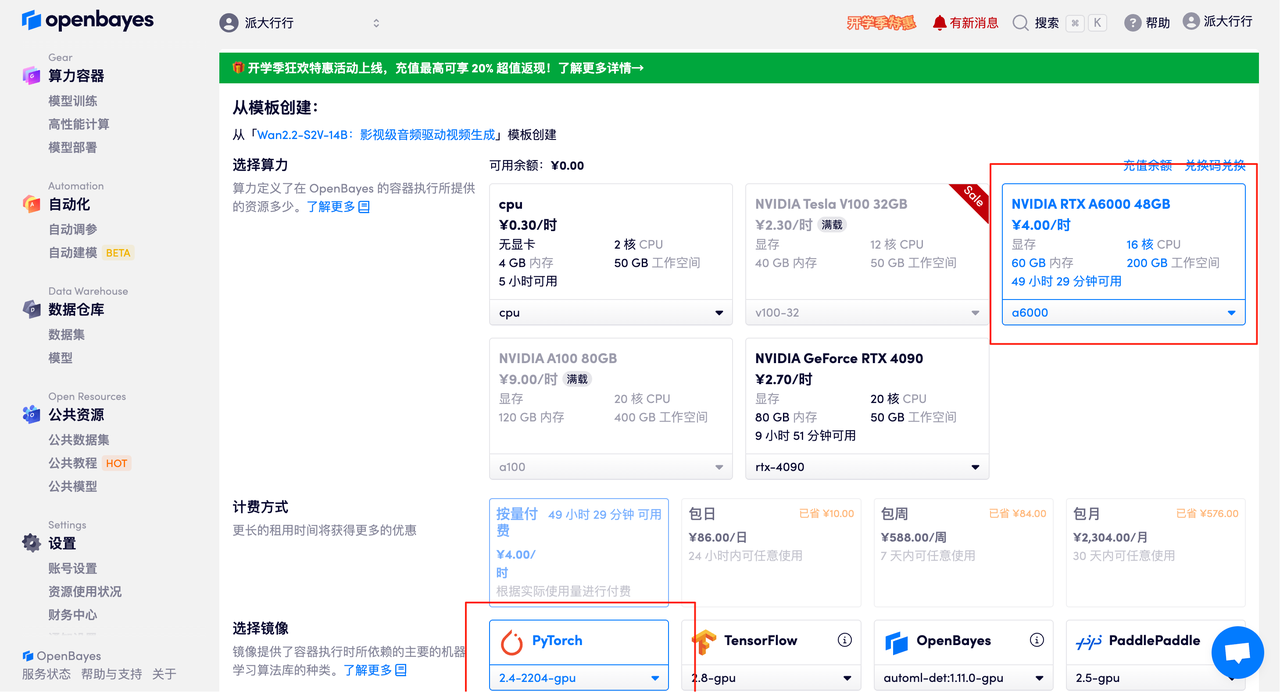

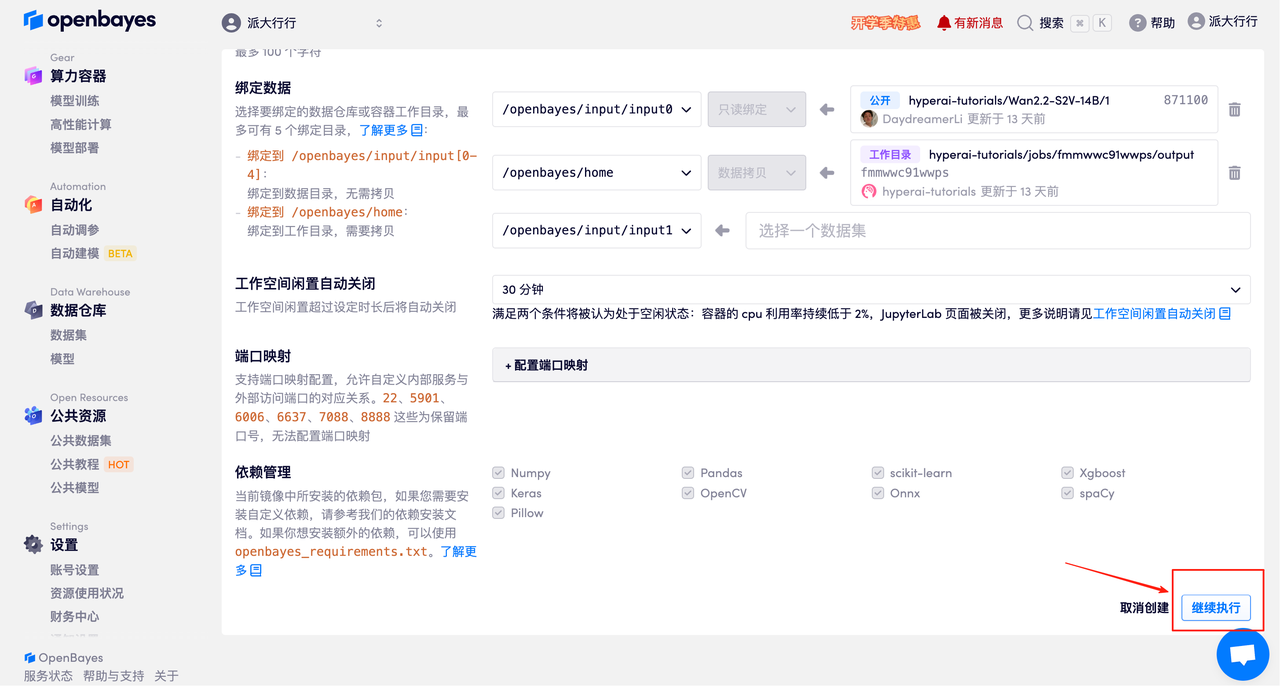

٣. اختر بطاقة الرسومات NVIDIA RTX A6000 سعة 48 جيجابايت وبطاقة PyTorch، ثم انقر على "متابعة". توفر منصة OpenBayes أربعة خيارات للدفع: الدفع حسب الاستخدام أو باقات يومية/أسبوعية/شهرية. يمكن للمستخدمين الجدد التسجيل باستخدام رابط الدعوة أدناه للحصول على 4 ساعات مجانية من بطاقة RTX 4090 و5 ساعات مجانية من استخدام المعالج!

رابط دعوة حصرية لـ HyperAI (انسخ وافتح في المتصفح):

https://openbayes.com/console/signup?r=Ada0322_NR0n

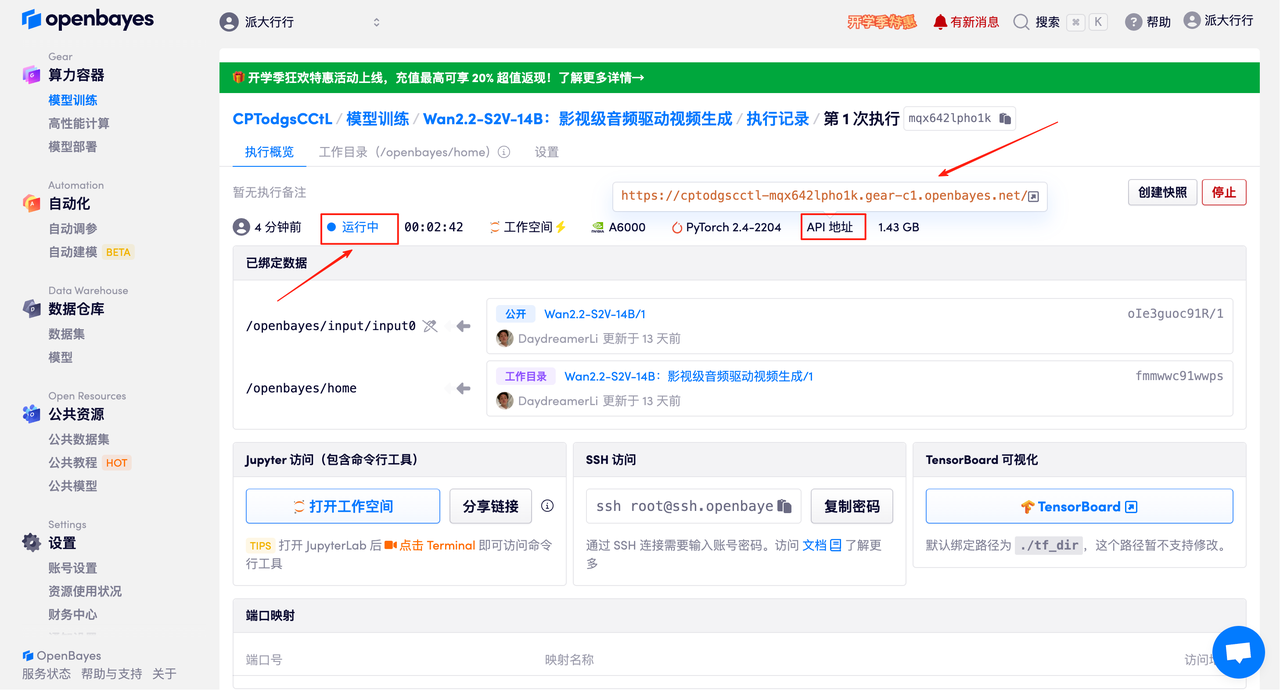

٤. انتظر حتى يتم تخصيص الموارد. تستغرق عملية الاستنساخ الأولى حوالي ٣ دقائق. عندما تتغير الحالة إلى "قيد التشغيل"، انقر على السهم بجوار "عنوان واجهة برمجة التطبيقات" للانتقال إلى صفحة العرض التوضيحي. يُرجى العلم أنه يجب على المستخدمين إكمال مصادقة الاسم الحقيقي قبل استخدام عنوان واجهة برمجة التطبيقات.

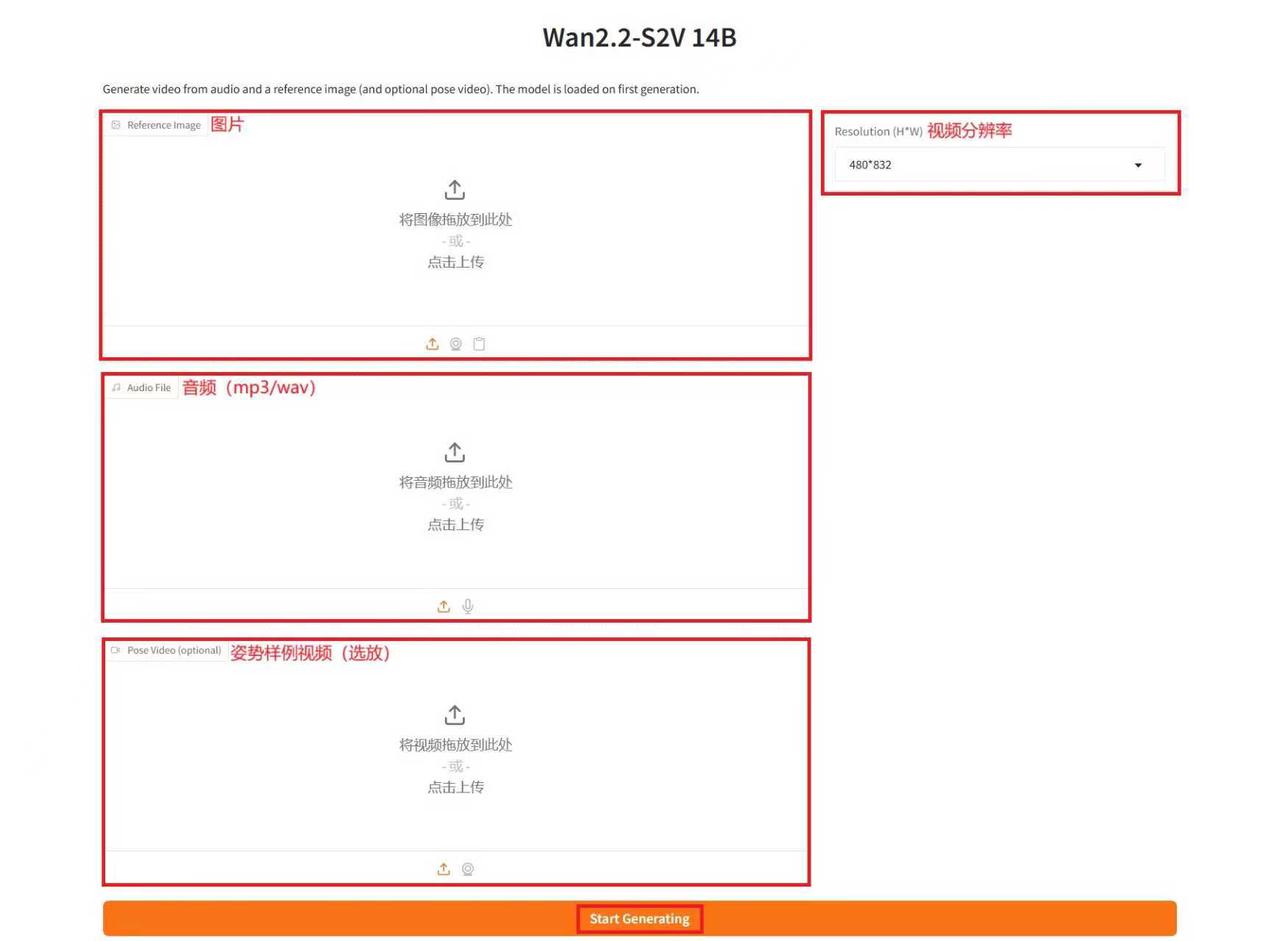

عرض التأثير

بعد الدخول إلى صفحة "تشغيل العرض التوضيحي"، أدخل وصفًا في مربع النص، ثم حمّل الصور والصوت، واضبط المعلمات حسب الحاجة، ثم انقر على "بدء التوليد" لإنشاء الفيديو. (ملاحظة: كلما زاد عدد خطوات الاستدلال، كانت النتائج أفضل، ولكن إنتاجه يستغرق وقتًا أطول. تأكد من ضبط عدد خطوات الاستدلال بشكل صحيح. على سبيل المثال، مع ١٠ خطوات استدلال، يستغرق إنشاء الفيديو حوالي ١٥ دقيقة.)

إنشاء مثال

ما سبق هو البرنامج التعليمي الذي توصي به HyperAI هذه المرة. الجميع مدعوون للحضور وتجربته!

رابط البرنامج التعليمي: