Command Palette

Search for a command to run...

AIペーパーウィークリーレポート | NVIDIAオープンソースモデル / OpenAIベンチマーク / エージェントシステム / ロングコンテキスト推論…AIアップデートのまとめ

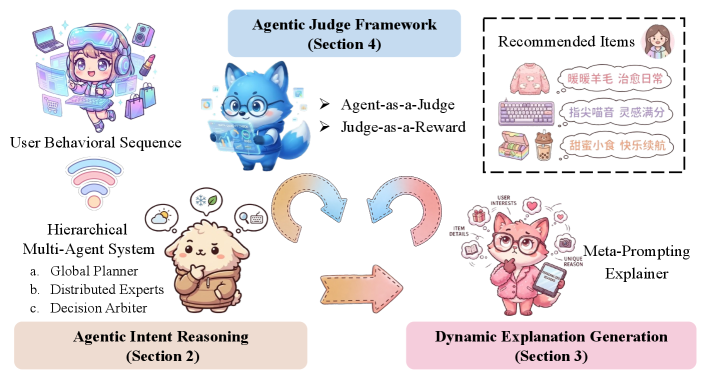

大規模言語モデル(LLM)は、暗黙的な行動パターンマッチングから明示的な意図推論へとレコメンデーションシステムを変革する上で大きな可能性を示しています。RecGPT-V1は、LLMベースの推論をユーザーの興味関心マイニングとアイテムタグ予測に統合することで、このパラダイムの先駆者として成功を収めましたが、4つの根本的な限界があります。

* 複数の推論パスにわたる計算効率と認知冗長性が低い。

* 固定テンプレート生成における解釈可能性が不十分。

* 教師あり学習パラダイム内での適用範囲が限られている。

* 単純な結果重視の評価は人間の基準を満たしません。

既存の限界を克服するため、アリババの研究チームは最新バージョンであるRecGPT-V2をリリースしました。このバージョンには、4つの主要な革新が含まれています。

* 階層型マルチエージェントシステムを構築します。

* メタプロンプトフレームワークを提案する。

* 制約ベースの強化学習メカニズムを導入する。

* エージェントを裁判官として評価するフレームワークを設計します。

RecGPT-V2 は、大規模言語モデルに基づく意図推論の技術的な実現可能性を検証しただけでなく、大規模な産業シナリオでの商業的実現可能性も証明し、認知探索と産業応用の間のギャップをうまく埋めました。

ペーパーリンク:https://go.hyper.ai/wftNU

最新のAI論文:https://go.hyper.ai/hzChC

学術界における人工知能分野の最新動向をより多くのユーザーに知ってもらうため、HyperAI の公式サイト (hyper.ai) に「最新論文」セクションが開設され、最先端の AI 研究論文が毎日更新されます。おすすめのAI論文5選今週の最先端のAIの成果を簡単に見てみましょう⬇️

今週のおすすめ紙

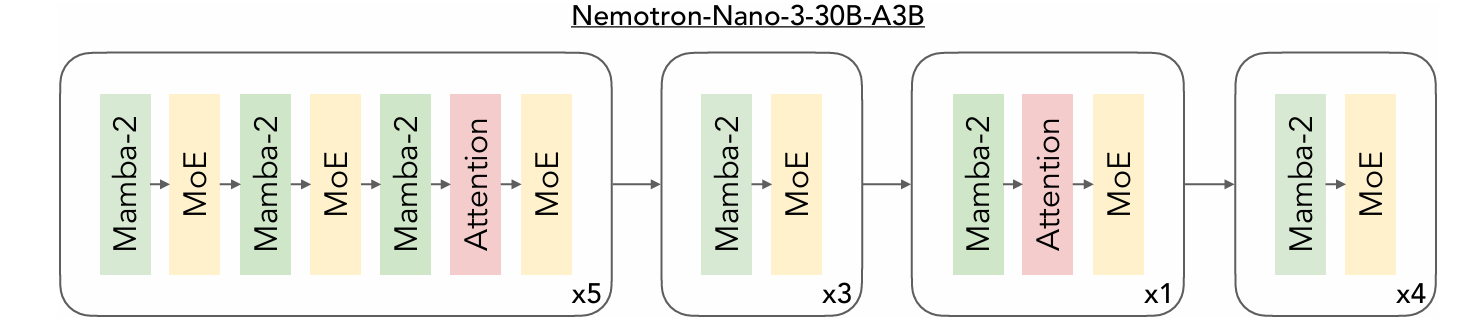

1.Nemotron 3 Nano: エージェント推論のためのオープンで効率的な専門家混合ハイブリッドMamba-Transformerモデル

本稿では、Mixture-of-Expertsアーキテクチャに基づくMamba-Transformerハイブリッド言語モデルであるNemotron 3 Nano 30B-A3Bを紹介します。Nemotron 3 Nanoは、Nemotron 2と比較して3兆個以上の固有タグが追加され、合計25兆個のテキストタグで事前学習されています。その後、教師ありファインチューニングと大規模強化学習によって、多様な環境における学習が行われました。このモデルは、エージェントの行動、推論能力、対話インタラクションを大幅に向上させ、最大100万タグのコンテキスト長をサポートします。

論文リンク:https://go.hyper.ai/LtmY3

2. 先端科学

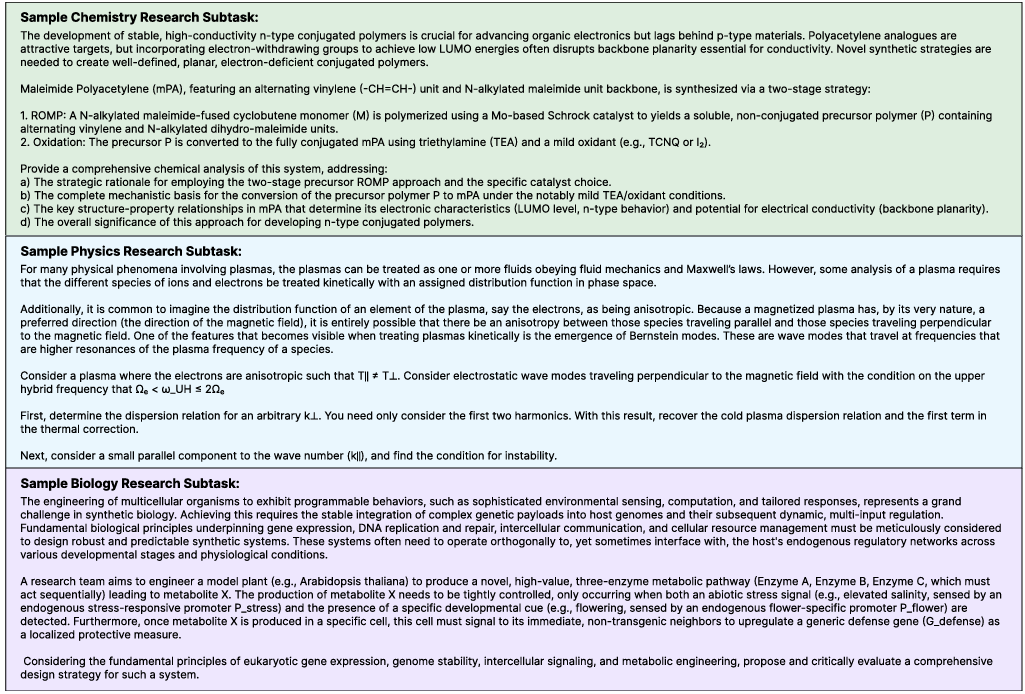

本論文では、人工知能の専門家レベルの科学的推論能力を評価するためのベンチマークテストであるFrontierScienceを提案する。FrontierScienceは、(1) 国際オリンピック(IPhO、IChO、IBO)の問題を網羅するオリンピックトラックと、(2) 科学研究における典型的なサブプロブレムを代表する博士レベルのオープンエンド問題を含む研究トラックの2つのトラックから構成される。

論文リンク:https://go.hyper.ai/XanPc

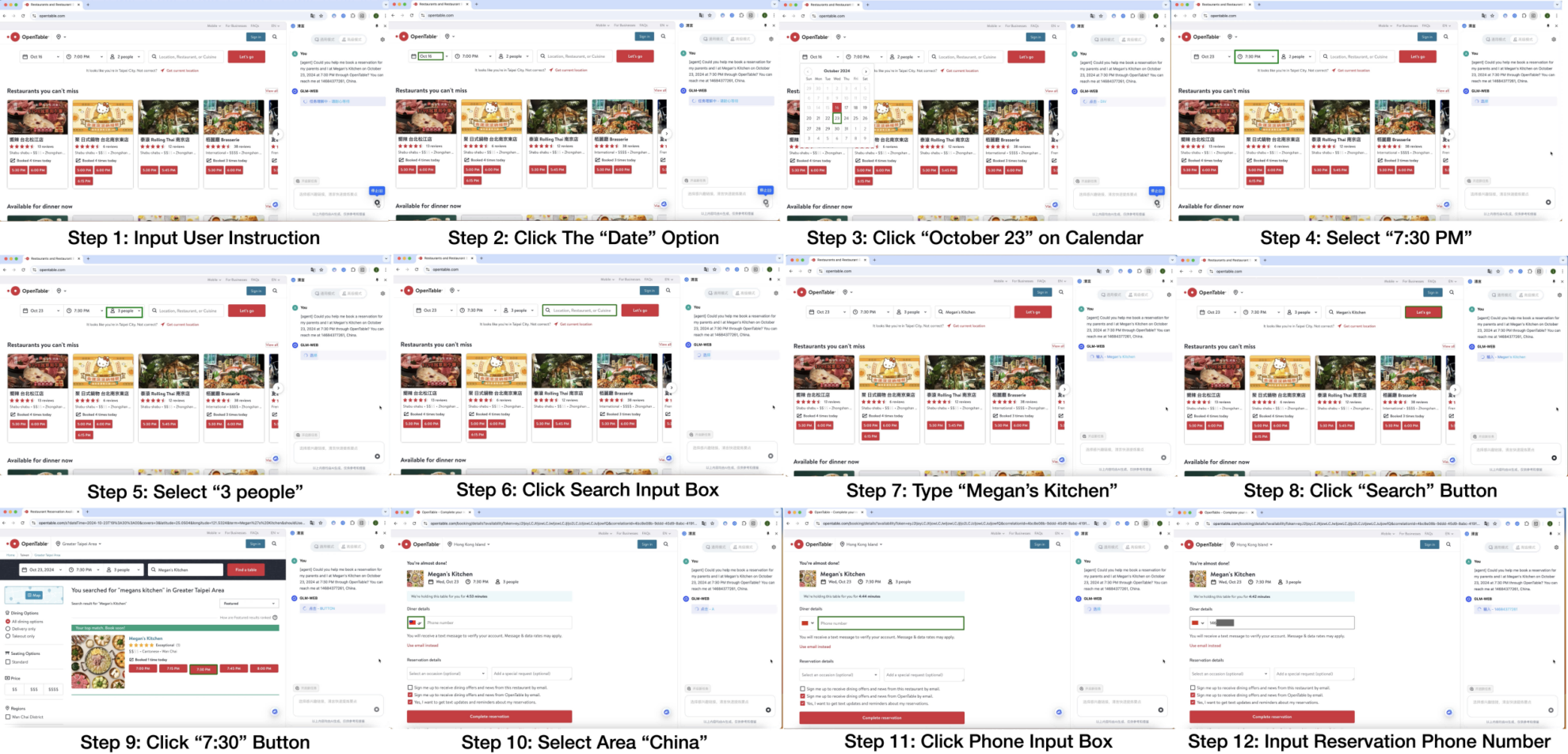

3.AutoGLM: GUI用の自律型基盤エージェント

本論文では、ChatGLMファミリーの新シリーズであるAutoGLMを提案します。AutoGLMは、グラフィカルユーザーインターフェース(GUI)を介してデジタルデバイスの自律制御を可能にする基盤エージェントとして設計されています。研究チームは、Webブラウザと携帯電話を典型的なGUIシナリオとしてAutoGLMを構築し、実世界のGUIインタラクションのための実用的な基盤エージェントシステムを構築しました。

論文リンク:https://go.hyper.ai/SLjro

4. RecGPT-V2 技術レポート

本論文では、4つのコアイノベーションを含むRecGPT-V2を提案します。第一に、階層型マルチエージェントシステムの構築、第二に、メタプロンプティングフレームワークの提案、第三に、制約付き強化学習メカニズムの導入、そして第四に、エージェントを裁判官とする評価フレームワークの設計です。RecGPT-V2は、大規模言語モデルに基づく意図推論の技術的実現可能性を検証するだけでなく、大規模な産業シナリオにおける商業的実現可能性も実証し、認知探索と産業応用の間のギャップを埋めることに成功しました。

論文リンク:https://go.hyper.ai/TdjZJ

5.Deeper-GXX: 任意のGNNの深化

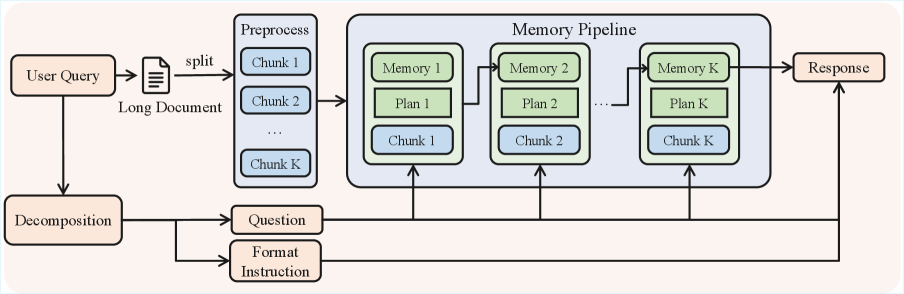

本稿では、体系的な学習後イノベーションを通じて優れたロングコンテキスト推論能力を実現するモデル、QwenLong-L1.5を紹介します。Qwen3-30B-A3B-ThinkingアーキテクチャをベースとするQwenLong-L1.5は、ロングコンテキスト推論ベンチマークにおいてGPT-5およびGemini-2.5-Proに近いパフォーマンスを示し、ベースラインモデルと比較して平均9.90ポイントの向上を達成しました。超長時間タスク(100万~400万トークン)では、メモリエージェントフレームワークがベースラインエージェントと比較して9.48ポイントの大幅な向上を達成しました。

論文リンク:https://go.hyper.ai/vViJi

今週の論文推薦は以上です。さらに最先端のAI研究論文をご覧になりたい方は、hyper.ai公式サイトの「最新論文」セクションをご覧ください。

質の高い研究成果や論文の提出を歓迎いたします。ご興味のある方は、NeuroStar WeChat(WeChat ID: Hyperai01)にご登録ください。

また来週お会いしましょう!