Command Palette

Search for a command to run...

Dernier Discours De Jensen Huang : 5 Innovations, Données De Performance De Rubin Révélées Pour La Première Fois ; Divers Logiciels Libres, Couvrant Les Agents, Les Robots, La Conduite Autonome Et l’IA4S

Au début de l'année, le CES 2026 (Consumer Electronics Show), souvent surnommé le « gala printanier de la technologie », a ouvert ses portes à Las Vegas, aux États-Unis. Outre la présence toujours aussi forte de la bionique, des robots humanoïdes et des technologies de conduite autonome au cœur du salon, la concurrence féroce entre les fabricants tels qu'Intel, AMD, Qualcomm et Nvidia – vitrine exceptionnelle des nouvelles puces – a également constitué un point fort du CES.

Selon diverses sources, Intel prévoit de lancer officiellement ses processeurs Panther Lake, la troisième génération de Core Ultra, au CES. Qualcomm présentera les dernières nouveautés de ses plateformes Snapdragon X2 Elite et Snapdragon X2 Elite Extreme pour PC. La PDG d'AMD, Lisa Su, prévoit de dévoiler de nouvelles puces Ryzen lors de sa conférence du 5 janvier au soir, notamment le Ryzen 7 9850X3D, dont des informations ont récemment fuité, et la série Ryzen 9000G basée sur l'architecture Zen 5.

Bien que Jensen Huang ne figurât pas sur la liste officielle des intervenants principaux du CES, il a multiplié les apparitions lors de divers événements. On retiendra notamment sa présentation solo à NVIDIA LIVE, prévue le 5 janvier à 5h00, heure de Pékin. Selon toute vraisemblance, Huang y dévoilera les dernières avancées concernant la plateforme Rubin, ainsi que les développements connexes en matière d'IA physique et de conduite autonome.

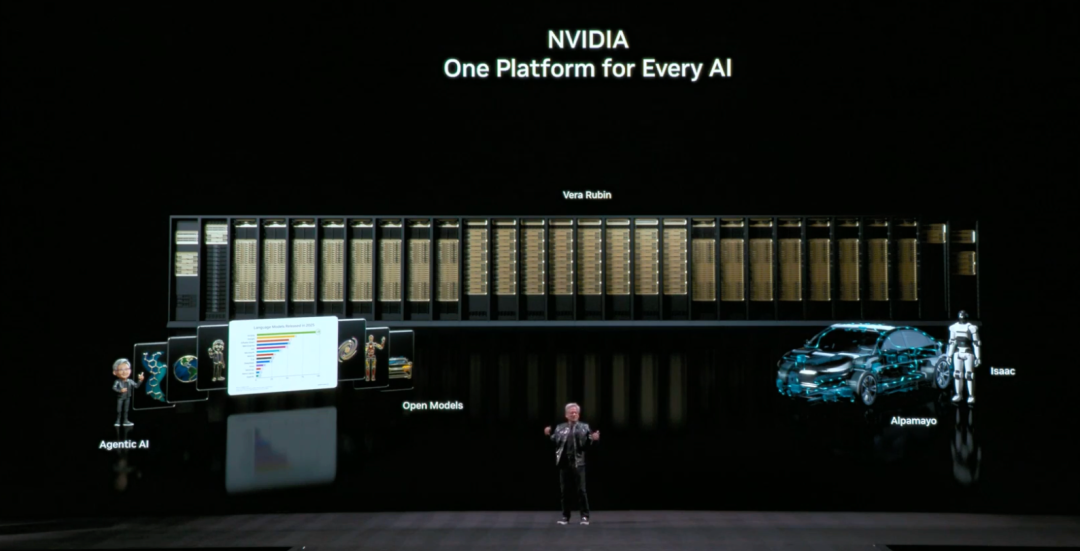

Jensen Huang n'a pas déçu le secteur ; dans son discours récemment prononcé,Vêtu de son emblématique veste en cuir noir, Lao Huang a présenté plus en détail la plateforme Rubin, qui intègre cinq innovations, et a dévoilé plusieurs réalisations open source.Spécifiquement:

* Série NVIDIA Nemotron pour l'IA agentique

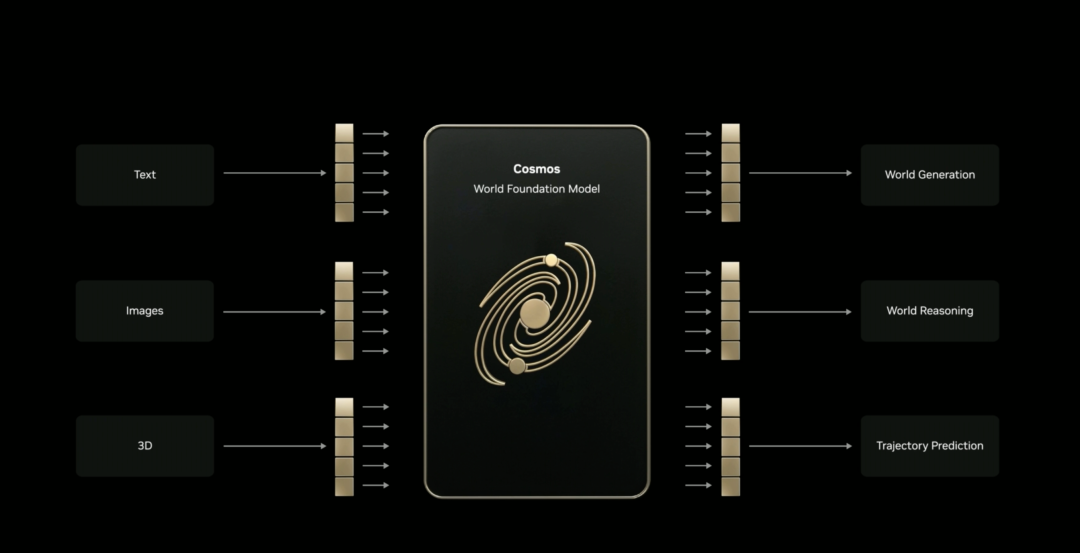

* Plateforme NVIDIA Cosmos pour l'IA physique

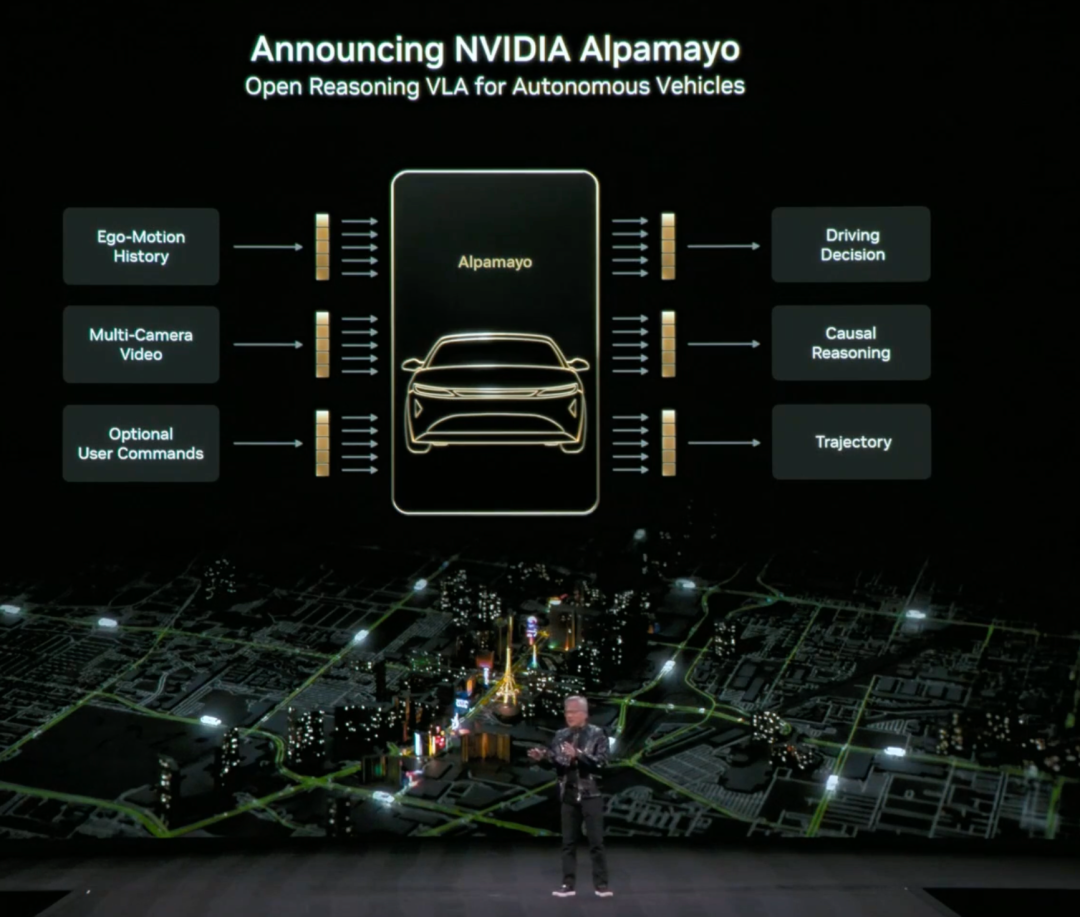

* Série NVIDIA Alpamayo pour la recherche et le développement de la conduite autonome

* NVIDIA Isaac GR00T pour le domaine de la robotique

NVIDIA Clara au service du secteur biomédical

Avec ses cinq fonctionnalités innovantes, Rubin est arrivé à point nommé.

« Les besoins en puissance de calcul de l'IA pour l'entraînement et l'inférence augmentent actuellement de façon spectaculaire, et la sortie de Rubin arrive à point nommé. »Jensen Huang nourrit de grands espoirs pour la plateforme Rubin, affirmant que Rubin est désormais en pleine production et devrait être livrée au premier groupe d'utilisateurs au cours du second semestre 2026.

Axée sur les performances de la plateforme, la plateforme Rubin bénéficie d'une « coconception extrême » sur six puces, incluant le processeur NVIDIA Vera, le GPU NVIDIA Rubin, le commutateur NVIDIA NVLink 6, la carte réseau NVIDIA ConnectX-9, le processeur graphique NVIDIA BlueField-4 et le commutateur Ethernet NVIDIA Spectrum-6. De ce fait, comparée à la plateforme NVIDIA Blackwell,Il peut réduire le coût par jeton dans la phase d'inférence jusqu'à 10 fois et le nombre de GPU nécessaires pour entraîner le modèle MoE (Hybrid Expert) par 4 fois.

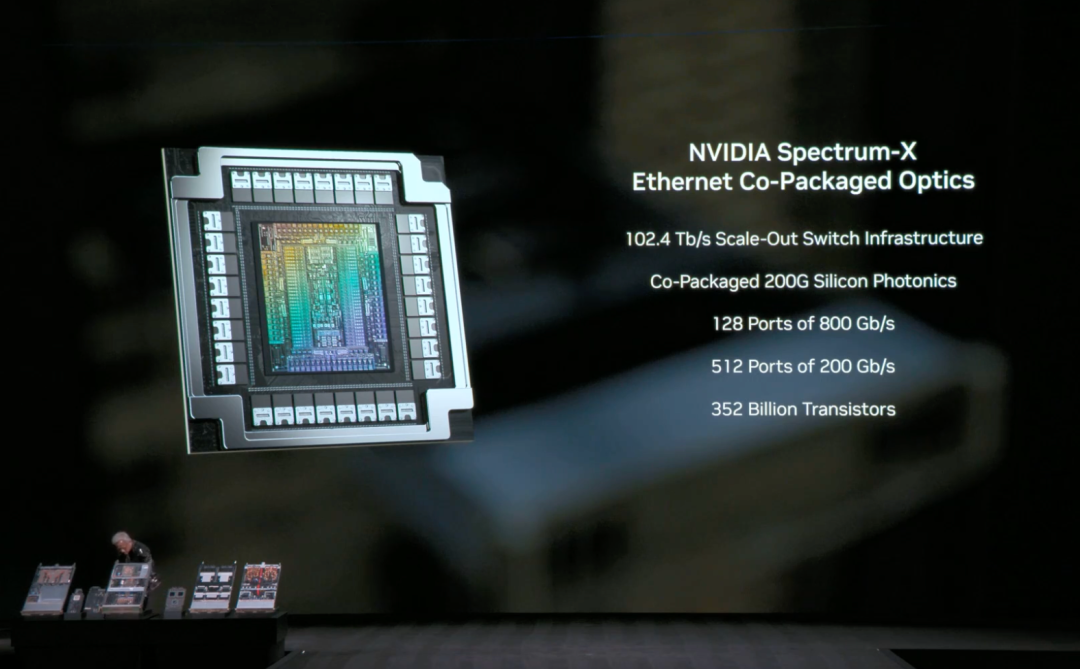

Parmi ces solutions, NVIDIA Spectrum-6 Ethernet est la nouvelle génération d'Ethernet pour les réseaux d'IA. Utilisant des SerDes 200G, des composants optiques intégrés et une architecture réseau optimisée pour l'IA, elle offre à l'usine d'IA de Rubin une efficacité et une résilience accrues. Le système de commutation photonique Ethernet Spectrum-X, basé sur l'architecture Spectrum-6, atteint une efficacité énergétique cinq fois supérieure, une fiabilité dix fois plus élevée et une disponibilité cinq fois plus longue.

Selon la présentation officielle, la plateforme Rubin introduit cinq innovations :

NVIDIA NVLink de 6e génération

Fournit une communication GPU-GPU haut débit et fluide pour les modèles MoE à grande échelle. La bande passante d'un seul GPU atteint 3,6 To/s, et la bande passante totale d'un rack Vera Rubin NVL72 atteint 260 To/s, dépassant ainsi la bande passante totale d'Internet. La puce de commutation NVLink 6 intègre des capacités de calcul réseau, accélérant la communication agrégée et introduisant de nouvelles fonctionnalités en matière de maintenabilité et de résilience, permettant un entraînement et une inférence IA à grande échelle plus rapides et plus efficaces.

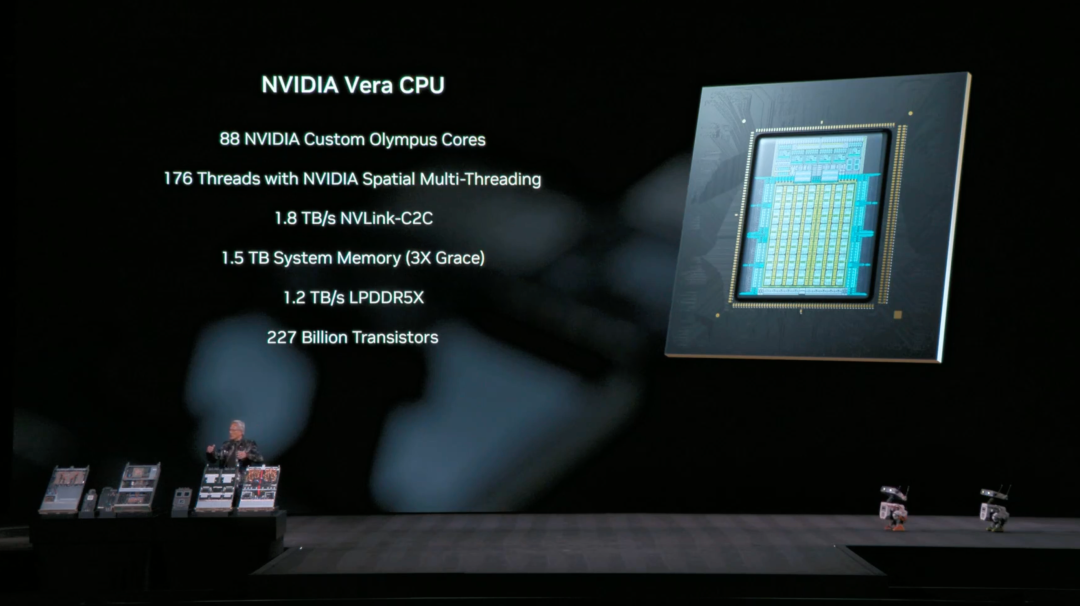

* Processeur NVIDIA Vera

Conçu spécifiquement pour l'inférence d'agents, ce processeur est le plus écoénergétique des centres de données d'IA à grande échelle. Il utilise 88 cœurs NVIDIA Olympus, est entièrement compatible avec Armv9.2 et prend en charge l'interconnexion NVLink-C2C ultra-rapide, offrant ainsi des performances, une bande passante et une efficacité énergétique de pointe pour les charges de travail des centres de données modernes.

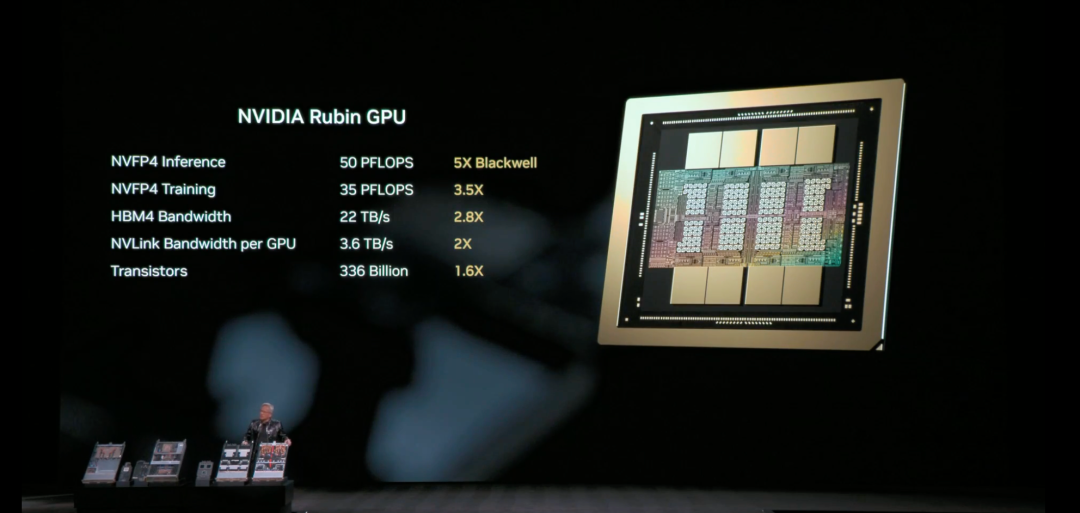

* GPU NVIDIA Rubin

Doté d'un moteur Transformer de troisième génération et prenant en charge la compression adaptative accélérée par matériel, il offre une performance de calcul NVFP4 de 50 PFLOPS en inférence IA.

* Informatique confidentielle NVIDIA de troisième génération

La Vera Rubin NVL72 est la première plateforme à implémenter le calcul confidentiel NVIDIA au niveau du rack, garantissant la sécurité des données sur les domaines CPU, GPU et NVLink, protégeant ainsi le plus grand modèle propriétaire au monde et ses tâches d'entraînement et d'inférence.

Moteur RAS de deuxième génération

La surveillance en temps réel de l'état de santé, la tolérance aux pannes et les mécanismes de maintenance prédictive couvrant le GPU, le CPU et NVLink maximisent la productivité du système ; la conception modulaire et sans câble des plateaux permet des vitesses d'assemblage et de maintenance jusqu'à 18 fois plus rapides que Blackwell.

Parallèlement, la plateforme Rubin introduit la plateforme de stockage de mémoire de contexte d'inférence NVIDIA, une nouvelle infrastructure de stockage native pour l'IA conçue pour permettre une mise à l'échelle du contexte d'inférence à l'échelle du gigabit. Basée sur NVIDIA BlueField 4, cette plateforme permet un partage et une réutilisation efficaces des données de cache clé-valeur au sein de l'infrastructure d'IA, améliorant ainsi la réactivité et le débit tout en assurant une mise à l'échelle prévisible et économe en énergie des agents d'IA.

Bien que la plateforme Rubin ne soit pas encore officiellement commercialisée, elle a déjà reçu le soutien de nombreux leaders du secteur. Dans un article de blog officiel de NVIDIA, Sam Altman (PDG d'OpenAI), Dario Amodei (PDG d'Anthropic), Mark Zuckerberg (PDG de Meta), Elon Musk (qui y apparaissait en tant que PDG de xAI) et les dirigeants de grandes entreprises technologiques comme Microsoft, Google, AWS et Dell l'ont tous encensée. Musk a notamment déclaré :« Rubin prouvera une fois de plus au monde entier que NVIDIA est la référence absolue du secteur. »

Diverses technologies open source : agents, IA4S, conduite autonome, robotique

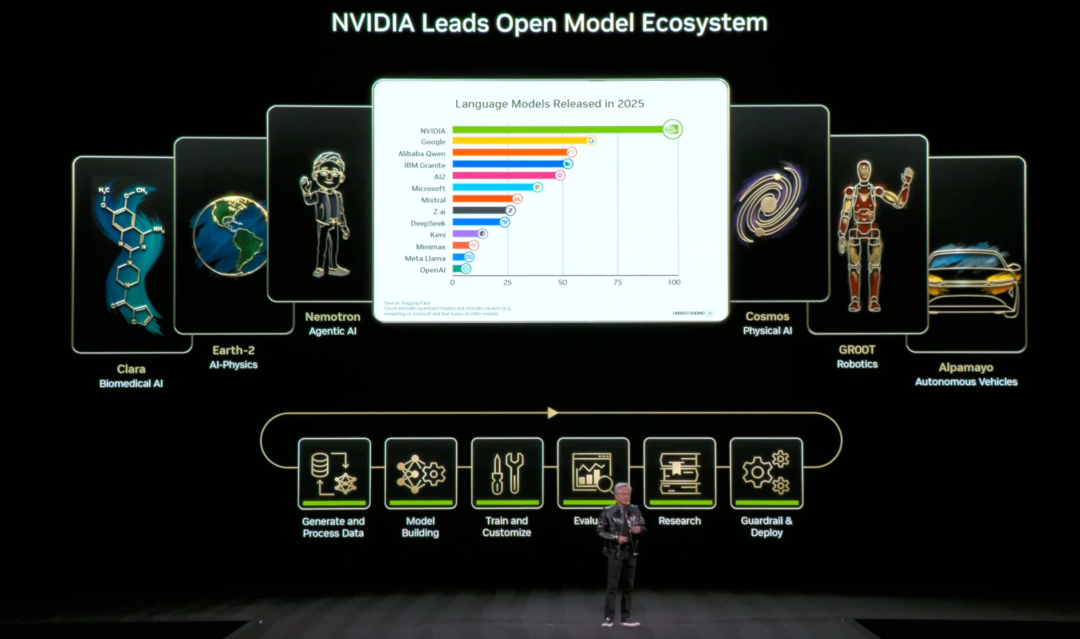

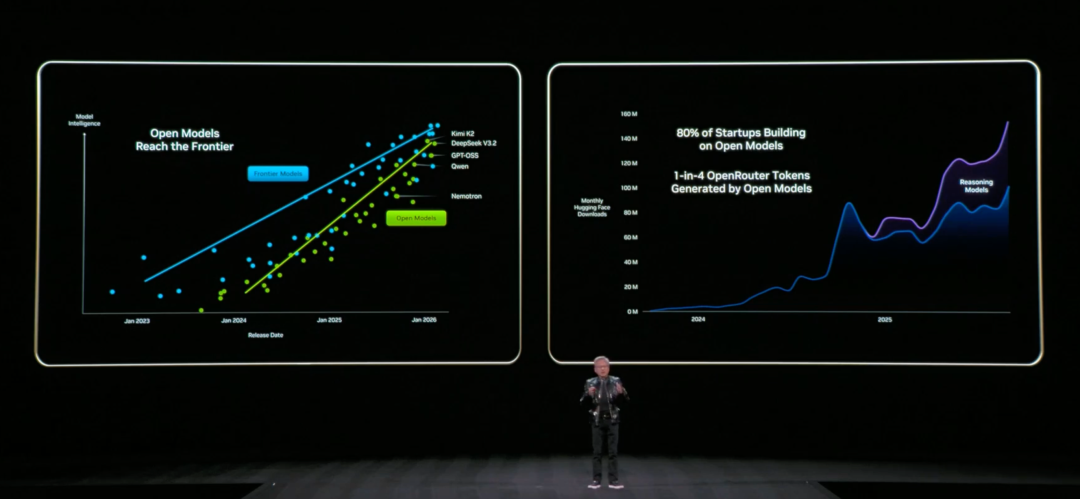

Outre la plateforme Rubin, qui a fait couler beaucoup d'encre, le terme « open source » était un autre mot-clé important dans le discours de Jensen Huang.

Tout d'abord, NVIDIA Nemotron pour agents IA. S'appuyant sur le modèle ouvert et les données NVIDIA Nemotron 3 précédemment publiés, NVIDIA a lancé de nouveaux modèles Nemotron pour la parole, la génération augmentée multimodale (RAG) et la sécurité.

* Discours du Nemotron

Composé de plusieurs modèles ouverts de pointe, dont un tout nouveau modèle de reconnaissance vocale automatique (ASR), il offre des capacités de reconnaissance vocale en temps réel et à faible latence pour le sous-titrage instantané et les applications d'IA vocale. Les tests de performance quotidiens et modaux montrent qu'il est 10 fois plus rapide que les modèles similaires.

* Nemotron RAG

Il comprend un tout nouveau modèle d'intégration et un modèle de langage visuel (VLM) réorganisé, qui peuvent fournir des informations multilingues et multimodales de haute précision, améliorant considérablement les capacités de recherche de documents et de récupération d'informations.

* Sécurité Nemotron

Le système modèle conçu pour améliorer la sécurité et la fiabilité des applications d'IA comprend désormais le modèle de sécurité de contenu Llama Nemotron (qui prend en charge davantage de langues) et Nemotron PII, qui peut identifier les données sensibles avec une grande précision.

Deuxièmement, NVIDIA a mis à jour ses modèles de la série Cosmos pour les domaines de l'IA physique et de la robotique :

* Cosmos Raison 2

Le nouveau VLM basé sur l'inférence et classé parmi les meilleurs, aide les robots et les agents d'IA à atteindre une plus grande précision dans la perception, la compréhension et l'interaction avec le monde physique.

* Cosmos Transfer 2.5 et Cosmos Predict 2.5

Il peut générer des vidéos synthétiques à grande échelle dans des environnements et des conditions variés.

S’appuyant sur Cosmos, NVIDIA a également publié des modèles open source pour différents paradigmes d’IA physique :

* Isaac GR00T N1.6

Un modèle de raisonnement ouvert vision-langage-action (VLA) pour les robots humanoïdes, permettant un contrôle complet du corps et améliorant les capacités de raisonnement et de compréhension contextuelle grâce à Cosmos Reason.

* Recherche vidéo et résumé NVIDIA Blueprint

Appartenant à la plateforme NVIDIA Metropolis, il fournit un flux de travail de référence pour la création d'agents d'IA visuelle capables d'analyser de grandes quantités de vidéos enregistrées et en temps réel afin d'améliorer l'efficacité opérationnelle et la sécurité publique.

Troisièmement, pour le secteur de la conduite autonome, NVIDIA a récemment rendu open source Alpamayo, qui comprend des modèles open source, des outils de simulation et des ensembles de données à grande échelle.

* Alpamayo 1

Le premier modèle VLA open-source à grande échelle basé sur l'inférence pour véhicules autonomes (VA) permet aux véhicules non seulement de comprendre leur environnement, mais aussi d'expliquer leur propre comportement.

* AlpaSim

Un cadre de simulation open source qui prend en charge l'entraînement et l'évaluation en boucle fermée de modèles de conduite autonome basés sur l'inférence dans des environnements divers et des scénarios complexes en situation de pointe.

En outre, NVIDIA a publié le Physical AI Open Dataset, qui contient plus de 1 700 heures de données de conduite réelles provenant d’un large éventail de régions géographiques et de conditions environnementales à travers le monde, couvrant un grand nombre de scénarios rares et complexes du monde réel, ce qui est crucial pour faire progresser les architectures d’inférence.

Enfin, pour le domaine de l'IA au service de la sécurité (AI4S), NVIDIA a lancé le modèle d'IA Clara, qui comprend :

* La-Protéine

Il soutient la conception de protéines à grande échelle, au niveau atomique, pour la recherche scientifique et le développement de candidats médicaments, fournissant de nouveaux outils pour étudier des maladies auparavant considérées comme « incurables ».

* ReaSyn v2

L'intégration de plans de fabrication dans le processus de découverte de médicaments garantit la viabilité synthétique des médicaments conçus par l'IA.

* KERMT

En prédisant les interactions médicament-humain, il fournit des tests de sécurité informatiques très précis à un stade précoce.

* RNAPro

Exploiter le potentiel de la médecine personnalisée en prédisant la structure tridimensionnelle complexe des molécules d'ARN.

Par ailleurs, NVIDIA a publié un ensemble de données contenant 455 000 structures de protéines synthétiques afin d’aider les chercheurs à construire des modèles d’IA plus précis.

Conclusion

Alors que les projecteurs de Las Vegas se braquent une fois de plus sur l'IA et son support matériel sous-jacent, qu'il s'agisse de l'éloquente présentation de la plateforme Rubin par Jensen Huang ou du dévoilement d'un nouveau produit majeur par Lisa Su ce soir, il ne s'agit pas seulement de lancer une nouvelle génération de puces ou de réaliser un bond en avant en matière de performances ; il s'agit plutôt de définir les limites de la prochaine étape du développement de l'IA : comment la puissance de calcul peut être organisée, comment les coûts peuvent être réduits, comment les modèles peuvent véritablement évoluer vers l'inférence et comment les agents peuvent être profondément intégrés au monde réel.

Le CES 2026 ne se résume plus à une simple bataille de spécifications entre fabricants, mais à un choix collectif concernant la forme que prendra l'infrastructure de l'IA. Il est clair que la concurrence se déplace des modèles eux-mêmes vers la capacité à soutenir de manière plus efficace et stable le déploiement à grande échelle de l'intelligence artificielle.

Références

1.https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer

2.https://blogs.nvidia.com/blog/open-models-data-tools-accelerate-ai/