Command Palette

Search for a command to run...

Rediffusion Intégrale | Shanghai Innovation Lab/TileAI/Huawei/Advanced Compiler Lab/AI9Stars : Analyse Approfondie Des Pratiques En Matière De Compilation IA

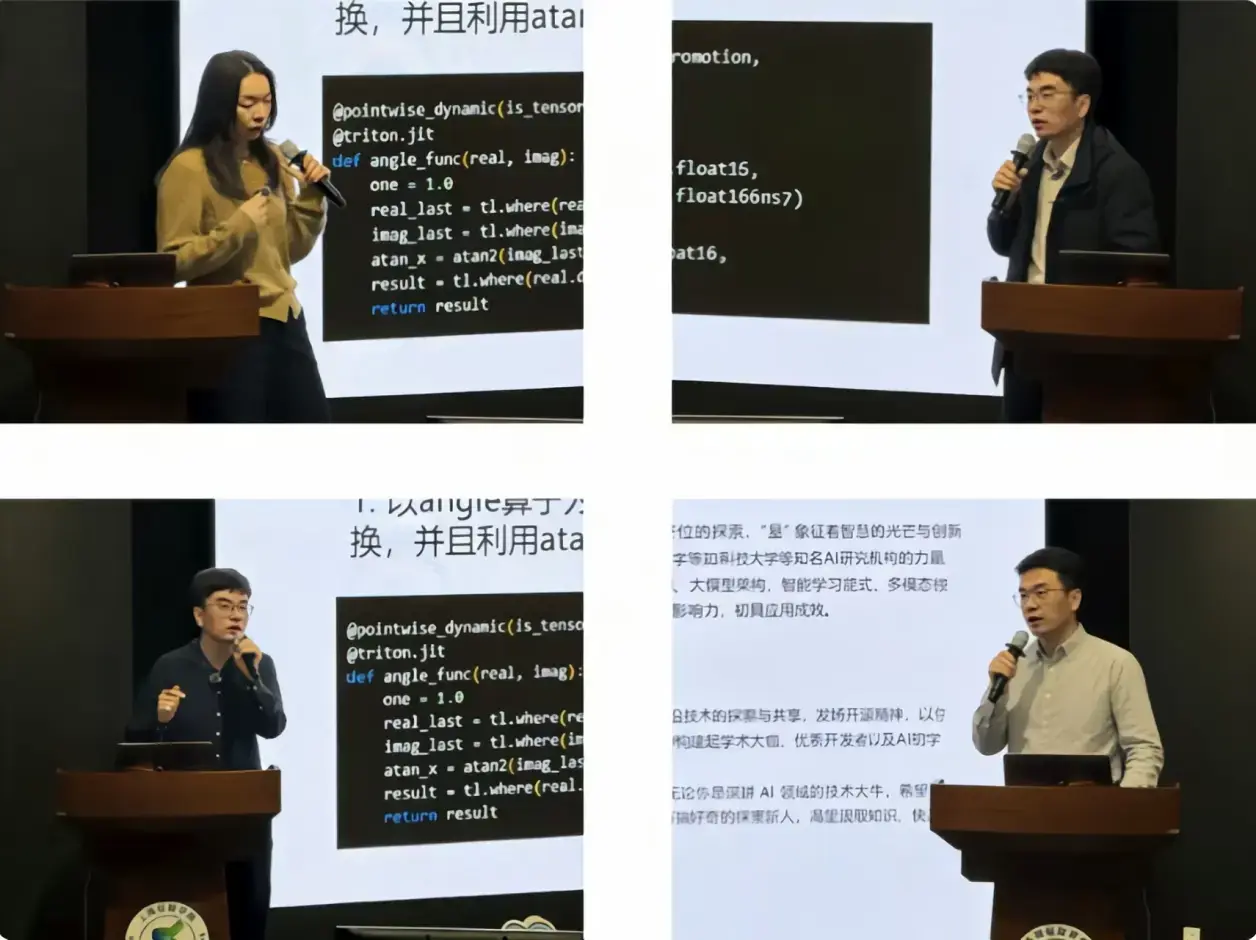

Face à l'évolution constante des technologies de compilation pour l'IA, les recherches se multiplient, s'accumulent et convergent. C'est dans ce contexte que se tiendra la huitième édition de Meet AI Compiler le 27 décembre.

Lors de cet événement, nous avons invité cinq experts de la Shanghai Innovation Academy, de TileAI Community, de Huawei HiSilicon, d'Advanced Compiler Lab et d'AI9Stars à partager leurs connaissances sur l'ensemble de la chaîne de valeur, de la conception de la pile logicielle et du développement d'opérateurs à l'optimisation des performances. S'appuyant sur les recherches menées au cours du long processus par leurs équipes, les intervenants ont présenté les méthodes de mise en œuvre et les compromis des différentes approches techniques dans des cas concrets, donnant ainsi un contexte plus tangible aux concepts abstraits.

Certains ont présenté leurs dernières découvertes, tandis que d'autres ont évoqué des défis d'ingénierie en cours. Les présentations étaient captivantes, et les discussions tout aussi animées : questions, échanges et conversations pendant les pauses ont permis d'explorer, d'enrichir et d'approfondir constamment les sujets abordés. Le partage n'était plus à sens unique, mais s'est progressivement transformé en un dialogue continu autour des compilateurs d'IA. Chacun parlait sans interruption, ce qui fait tout le charme de notre communauté de développeurs de compilateurs d'IA !

Examen du contenu de l'événement

Partage et évaluation

Partager le sujet:TVM FFI : ABI et FFI ouverts pour les systèmes d’apprentissage automatique

Contenu:TVM FFI vise à résoudre les problèmes de fragmentation des écosystèmes et d'interopérabilité des systèmes d'apprentissage automatique. En définissant des normes ABI et FFI ouvertes, le projet utilise l'ABI C stable et DLPack pour réaliser un transfert de données sans copie, comblant ainsi le fossé entre les frameworks comme PyTorch et le compilateur sous-jacent. Il prend en charge des appels interlangages efficaces, réduisant considérablement les coûts d'ingénierie liés à l'adaptation multiplateforme.

Regardez cette séance de partage et vous apprendrez :

1. Apprenez la norme universelle TVM-FFI pour réduire considérablement les coûts de développement et de maintenance des systèmes d'apprentissage automatique multilingues.

2. Comprendre et construire un écosystème d'apprentissage automatique modulaire compatible avec l'avenir

Partager la vidéo :[2025 Meet AI Compiler] TVM FFI : ABI et FFI ouverts pour les systèmes d'apprentissage automatique_bilibili

Partager le sujet:TileRT : une exploration logicielle et matérielle pour l’inférence de grands modèles à faible latence

Contenu:Alors que les grands modèles atteignent des milliards de paramètres et traitent des séquences de plusieurs millions de jetons, leurs performances battent sans cesse de nouveaux records. Cependant, la quête de la vitesse de calcul ultime pour ces modèles reste un objectif constant. D'une part, de nombreux scénarios à faible latence exigent des réponses en quelques secondes, voire millisecondes, comme la prise de décision en temps réel et la théorie des jeux. D'autre part, avec l'avènement de l'ère des agents pour l'entraînement des grands modèles, le temps de déploiement des séquences extrêmement longues est devenu un goulot d'étranglement majeur.

Ce rapport présente le projet TileRT, explorant comment construire une pile logicielle pour le calcul de modèles à grande échelle avec une latence extrêmement faible, du point de vue des compilateurs d'IA, de l'exécution et de la conception de l'architecture.

Regardez cette séance de partage et vous apprendrez :

1. Comprendre le contexte, l'importance et les perspectives d'avenir des scénarios d'inférence à faible latence pour les grands modèles.

2. Les défis techniques et le partage d'expérience pratique de TileRT

Partager la vidéo :[2025 Meet AI Compiler] TileRT : Exploration logicielle et matérielle pour l’inférence de grands modèles à faible latence_bilibili_

Partager le sujet:PyPTO : un cadre de développement d’opérateurs de fusion basé sur la compilation en boîte blanche.

Contenu:Cette présentation porte sur PyPTO, le nouveau framework de développement d'opérateurs convergents lancé par Huawei. Basé sur le paradigme de programmation Tensor/Tile, il offre un équilibre optimal entre hautes performances et simplicité d'utilisation grâce à des technologies telles que la gestion de la SRAM intégrée, les jeux d'instructions PTO multiplateformes et l'environnement d'exécution MPMD, combinées à un réglage assisté par l'humain et à une compilation en boîte blanche.

Regardez cette séance de partage et vous apprendrez :

1. Maîtriser la philosophie de conception et l'architecture de base de PyPTO, un framework de développement d'opérateurs de fusion conçu nativement pour l'architecture SIMD.

2. Maîtrisez la philosophie de compilation en boîte blanche de PyPTO, qui se concentre sur l'exploitation de l'expérience experte des utilisateurs et sur l'essence de l'optimisation Human-In-The-Loop.

3. Maîtriser le processus complet de développement rapide d'opérateurs de fusion haute performance sur la plateforme Ascend en utilisant les outils de visualisation fournis par PyPTO.

Partager la vidéo :[2025 Meet AI Compiler] PyPTO : Un framework de développement d'opérateurs de fusion basé sur la compilation en boîte blanche_bilibili_

Partager le sujet:Pratiques d'optimisation de la compilation pour le compilateur Triton

Contenu:Cette présentation est consacrée aux pratiques d'optimisation du compilateur Triton. Elle introduit de manière systématique la structure du langage et du compilateur, l'évolution de l'écosystème et les méthodes de développement de la bibliothèque d'opérateurs. Elle explore également les principales techniques d'optimisation pour différentes architectures, notamment CPU, GPU et NPU, et illustre le processus complet de conception d'un système d'opérateurs unifié haute performance.

Regardez cette séance de partage et vous apprendrez :

1. Derniers développements dans l'écosystème Triton

2. Techniques d'optimisation clés du compilateur Triton sur plusieurs architectures (CPU/GPU/NPU)

Partager la vidéo :[2025 Meet AI Compiler] Pratiques d'optimisation de la compilation pour le compilateur Triton_Bilibili_bilibili

Partager le sujet:AutoTriton : Exploration des techniques d’optimisation de l’opérateur Triton pour les grands modèles pilotés par l’apprentissage par renforcement

Contenu:La conception de noyaux performants à l'aide de langages comme CUDA relève du domaine des ingénieurs en performance. L'avènement de frameworks de programmation tels que Triton a considérablement amélioré la programmabilité des noyaux. Toutefois, les développeurs doivent encore configurer manuellement certains paramètres clés, ce qui limite la portabilité des performances et leur application à grande échelle. Ce rapport présente notre exploration de benchmarks et de modèles pour la génération d'opérateurs à grande échelle et examine l'énorme potentiel des grands modèles pour l'optimisation des opérateurs.

Regardez cette séance de partage et vous apprendrez :

1. Travaux pertinents et progrès récents en matière d'optimisation des opérateurs pour les grands modèles

2. Technologies clés des grands modèles dans l'optimisation des opérateurs

Organisateurs et partenaires

HyperAI (hyper.ai) est une communauté internationale de premier plan en matière d'intelligence artificielle et de calcul haute performance.Son objectif est d'aider les développeurs et les passionnés de l'industrie mondiale de la science des données et de l'intelligence artificielle à apprendre, comprendre et pratiquer en fournissant une série de services tels que des rapports d'information sur l'industrie, des téléchargements accélérés d'ensembles de données, des démonstrations de didacticiels en ligne, des évaluations de performances de modèles populaires, des recommandations de documents de pointe, des interprétations de résultats de grande valeur et une intégration du calendrier des conférences de premier plan, et de construire l'avenir de l'intelligence artificielle avec la communauté.

Visitez le site officiel :https://hyper.ai/

OpenBayes Bayesian Computing est un fournisseur leader de services de calcul haute performance en ChineEn greffant des écosystèmes logiciels classiques et des modèles d’apprentissage automatique sur des puces hétérogènes de nouvelle génération, il fournit aux entreprises industrielles et à la recherche scientifique universitaire des produits de calcul de science des données plus rapides et plus faciles à utiliser. Ses produits ont été adoptés par des dizaines de grands scénarios industriels ou d’instituts de recherche scientifique de premier plan.

Visitez le site officiel :https://openbayes.com/

La communauté MLC.AI a été créée en juin 2022. Chen Tianqi, le principal inventeur d'Apache TVM et un jeune chercheur bien connu dans le domaine de l'apprentissage automatique, a dirigé l'équipe pour lancer le cours en ligne MLC, qui a systématiquement présenté les éléments clés et les concepts de base de la compilation de l'apprentissage automatique.

En novembre 2022, grâce aux efforts conjoints des bénévoles de la communauté MLC.AI, la première documentation chinoise complète de TVM a été lancée et hébergée avec succès sur le site Web officiel d'HyperAI, fournissant ainsi aux développeurs nationaux intéressés par la compilation d'apprentissage automatique les paramètres de base pour accéder et apprendre une nouvelle technologie - la documentation.

Cours en ligne MLC :https://mlc.ai/

Documentation chinoise de TVM :https://tvm.hyper.ai/

L'Académie d'innovation de Shanghai est un établissement de formation de talents d'un nouveau genre, fruit d'une collaboration entre universités prestigieuses, entreprises de premier plan et instituts de recherche. Fidèle à sa philosophie de formation axée sur l'étudiant et la recherche de pointe, l'académie propose un programme de formation unique en Chine pour les futurs leaders de l'IA, grâce à un corps professoral d'exception, des méthodes pédagogiques innovantes et un environnement d'accompagnement optimal. Elle a pour ambition de former les plus grands talents en IA en Chine et de bâtir un pôle d'innovation de renommée mondiale dans ce domaine.

Soutien aux événements