Command Palette

Search for a command to run...

Dario Amodei, Partisan d'une Surveillance Proactive, a Intégré La Sécurité De l'IA À La Mission De l'entreprise Après Avoir Quitté OpenAI.

Dans le cycle actuel de l'IA, alimenté par une course à la puissance de calcul, la concurrence entre géants de la tech et une accélération des investissements, Dario Amodei, cofondateur et PDG d'Anthropic, est l'un des rares, mais incontestables, « contrariens » de la Silicon Valley. Alors que la plupart des entreprises technologiques privilégient « l'itération plus rapide et les capacités renforcées » comme objectifs principaux, il s'en tient avec constance à un jugement de plus en plus convaincant :« La sécurité n’est pas un frein, mais la seule barrière de sécurité institutionnelle qui permette à l’industrie de continuer à aller de l’avant. »

Selon Dario Amodei, la croissance explosive des capacités de modélisation à grande échelle au cours des cinq prochaines années dépassera inévitablement l'évolution des mécanismes de gouvernance sociale.Sans un cadre de gouvernance de sécurité descendant, le développement de l'IA tombera dans un dangereux « cycle de réaction négative à la complexité ».— La rapidité du développement technologique submerge complètement le système de gouvernance, ce qui finit par entraîner une accumulation de risques se transformant en menaces systémiques, susceptibles non seulement de provoquer des crises pour les entreprises individuelles, mais aussi de perturber le fonctionnement de l'ensemble de la société.

Pour revenir au point de départ de cette divergence technologique et de gouvernance, l'argument central selon lequel « la sécurité n'est jamais l'opposé de l'innovation, mais bien la seule logique sous-jacente permettant à l'IA d'évoluer en continu une fois intégrée à l'infrastructure nationale » semble confirmer un fait : Dario Amodei ne promeut pas une « approche axée sur la sécurité », mais plutôt un « protocole logique » pour l'ère de l'IA. Ce protocole définit des conditions opérationnelles contrôlables, auditables et modulables pour l'expansion technologique, empêchant ainsi que le développement des capacités ne soit brutalement interrompu par un risque systémique. En substance, ce point de vue offre un soutien stable à l'expansion commerciale à long terme de l'IA, au lieu de s'opposer à l'innovation et de la freiner.

De mon départ d'OpenAI à la création d'Anthropic : une « déclaration d'indépendance » après une scission de valeurs.

Le lien profond qui unit Dario Amodei à la « voie de la sécurité » remonte à son passage chez OpenAI et à ses désaccords avec les valeurs fondamentales de l'entreprise.

Aux alentours de 2020, avec la commercialisation rapide des modèles de la série GPT, OpenAI a accéléré ses efforts d'itération technologique et de commercialisation, mais les mécanismes de gestion des risques et les systèmes de gouvernance correspondants n'ont pas encore été clairement définis.

En 2023, suite à la plainte pour violation de droits d'auteur déposée par le New York Times contre OpenAI et d'autres entreprises, certains chercheurs d'OpenAI s'inquiétaient déjà du rythme effréné de la commercialisation. Dario Amodei, cependant, l'avait anticipé plusieurs années auparavant et fut l'un des premiers à plaider pour un mécanisme d'évaluation des risques plus rigoureux au sein de l'entreprise. Il préconisait l'ajout d'une étape de prédiction des risques avant l'itération du modèle et l'amélioration du processus de tests de sécurité avant la commercialisation. Toutefois, ces suggestions, axées sur le développement institutionnel, furent progressivement étouffées par la pression croissante de la commercialisation au sein de l'entreprise.

Après des revers répétés dans ses propositions institutionnelles internes, Dario Amodei et un groupe de chercheurs principaux ont officiellement quitté OpenAI en 2021 pour fonder Anthropic.Derrière ce départ pour créer une entreprise, il n'est pas difficile de percevoir le déséquilibre entre les philosophies des deux parties concernant la priorité à accorder à la sécurité par rapport à la commercialisation.

La mission d'Anthropic reflète clairement cette différence de perspective. Au lieu d'utiliser l'expression courante dans le secteur « construire une IA puissante », elle affirme explicitement : « Nous construisons des systèmes d'IA fiables, interprétables et pilotables. »

À cette époque, le discours dominant dans la Silicon Valley s'articulait encore autour de l'idée que « la capacité est un avantage », la quasi-totalité des entreprises rivalisant sur l'ampleur des paramètres de modélisation, l'investissement dans la puissance de calcul et la rapidité de déploiement des applications. Dario Amodei, quant à lui, a choisi une voie inverse. Considérant la « contrôlabilité » comme le cœur de la future concurrence, ce choix apparemment contre-intuitif a posé les fondements conceptuels de la mise en œuvre de la stratégie de sécurité ultérieure d'Anthropic.

La logique sous-jacente de la « sécurité en tant que stratégie » est la suivante : à mesure que les capacités s'améliorent, la gouvernance doit s'améliorer en parallèle.

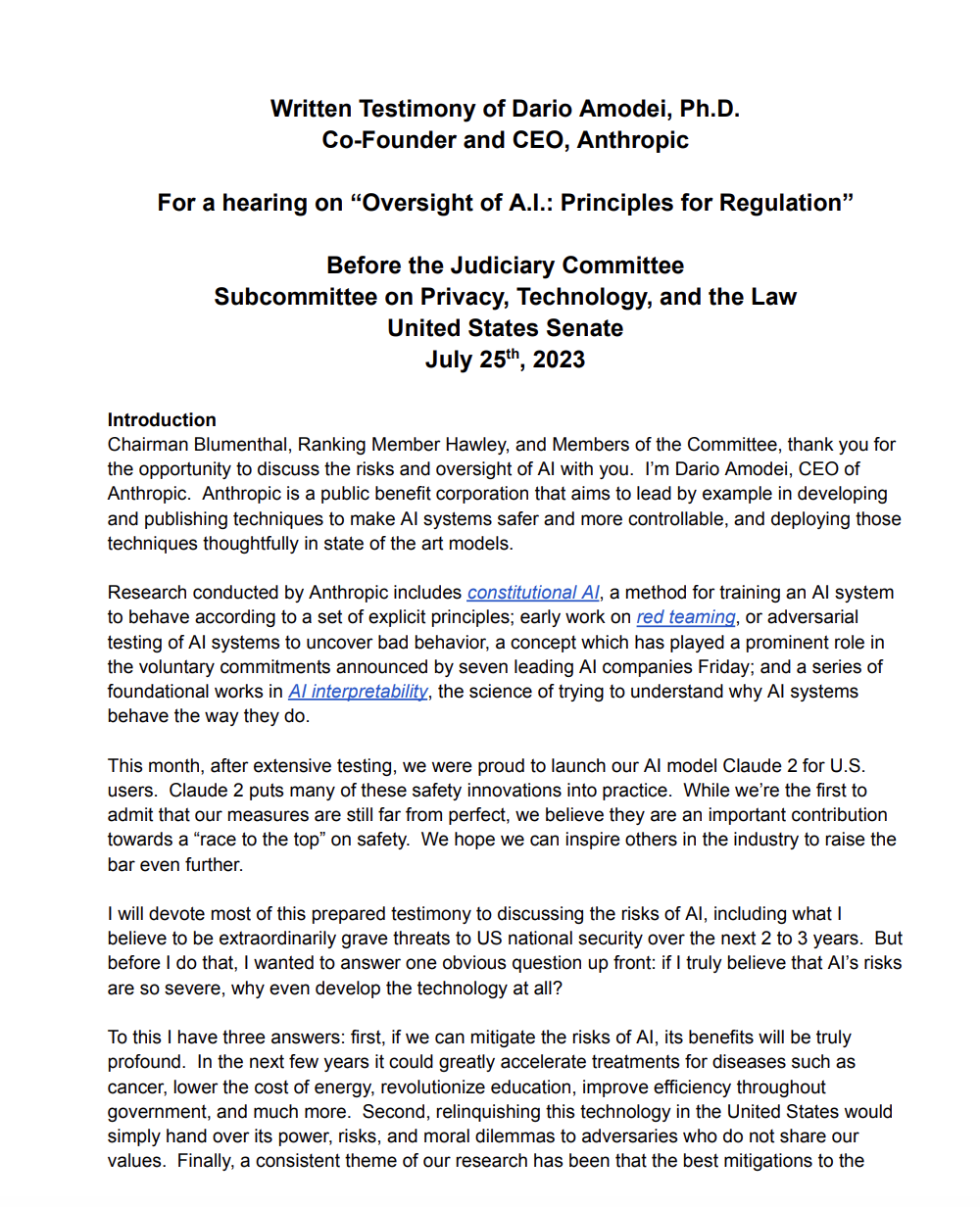

Contrairement à de nombreuses entreprises technologiques qui considèrent la « sécurité éthique » comme un simple ornement dans leurs rapports techniques ou un argument de vente, Dario Amodei promeut un cadre stratégique de sécurité très élaboré. Dans son témoignage écrit devant le Sénat américain sur les risques et la réglementation de l'IA, il a souligné : « Nous ne pouvons pas prédire avec certitude toutes les capacités de la prochaine génération de modèles ; par conséquent, nous devons mettre en place des garde-fous institutionnels à plusieurs niveaux avant leur développement, plutôt que d'essayer de remédier à la situation une fois les risques survenus. »

Partant de ce concept, Anthropic a élaboré un « modèle de coévolution capacités-sécurité » complet, intégrant la gouvernance de la sécurité à chaque aspect du développement technologique.

* Prévision des capacités :En utilisant des données historiques et des modèles algorithmiques, nous pouvons évaluer à l'avance les nouvelles capacités qui pourraient émerger dans la prochaine génération de grands modèles, en particulier celles qui pourraient engendrer des risques potentiels, comme une génération plus précise de désinformation et une écriture de code plus complexe (qui pourrait être utilisée pour des cyberattaques).

* Niveaux de sécurité :S’appuyant sur le système de niveaux de risque de l’industrie nucléaire, différents niveaux de sécurité sont définis en fonction de la capacité du modèle et des scénarios d’application, chaque niveau correspondant à des normes de test, des autorisations d’utilisation et des mécanismes de surveillance différents ;

* Équipes rouges externes et exigences d'interprétabilité :Imposer l’introduction d’équipes rouges externes issues de différentes institutions et domaines pour les tests d’attaque, tout en exigeant que le modèle fournisse une chaîne logique interprétable pour les processus de décision clés afin d’éviter les risques engendrés par une prise de décision opaque ;

* Portes d'accès/d'interdiction :Mettez en place des points de contrôle d'accès/d'interdiction aux étapes clés de l'itération du modèle. Seules les phases de développement ou de déploiement suivantes pourront être autorisées après validation des tests de sécurité et de l'évaluation des risques, définissant clairement le principe selon lequel « l'extension n'est autorisée que si elle est maîtrisée ».

Cette architecture de sécurité systématique a valu à Dario Amodei d'être considéré par les décideurs politiques américains comme un « PDG du secteur technologique doté d'une meilleure compréhension de la gouvernance ». En juillet 2023, lors du Forum sur l'intelligence artificielle organisé par le Sénat américain, il a été invité à participer aux auditions. Ses points de vue sur la « réglementation à plusieurs niveaux » et la « prédiction anticipée des risques » sont devenus l'une des interventions techniques les plus fréquemment citées lors des débats ultérieurs sur la loi relative à la sécurité de l'IA.

Alors que la plupart des entreprises de la Silicon Valley considèrent la sécurité comme un atout de relations publiques pour améliorer leur image, Dario Amodei la perçoit comme un système d'exploitation qui « pilote le développement à long terme du secteur » — il croit fermement que seule la mise en place d'un cadre de sécurité stable permettra à l'IA de passer véritablement de « technologie de laboratoire » à « infrastructure sociale ».

Pourquoi insister sur une « réglementation précoce » ? La technologie est entrée dans une période de croissance non linéaire.

De toutes les opinions de Dario Amodei, la plus controversée n'est pas son approche de l'alignement technologique, mais plutôt son attitude face à la réglementation : « La réglementation doit intervenir en amont, plutôt que de réagir passivement une fois les risques matérialisés. » Cette proposition contraste fortement avec la culture bien ancrée de la Silicon Valley, qui prône « moins de réglementation, plus de liberté », mais son raisonnement repose sur une compréhension profonde des modèles de développement de l'IA, principalement articulés autour de trois dimensions :

Les capacités des modèles croissent de façon exponentielle, tandis que la réglementation est linéaire.

De GPT-3, avec environ 175 milliards de paramètres en 2020, à GPT-4 en 2023, qui a marqué un bond en avant significatif en termes de capacités (le nombre de paramètres n'est pas divulgué publiquement, mais beaucoup l'estiment entre 500 milliards et 1 000 milliards), puis à Claude 3 d'Anthropic en 2024 (qui a surpassé ses prédécesseurs dans de nombreux tests de performance), les capacités de chaque génération de modèles à grande échelle ont progressé de façon exponentielle. De nombreuses « capacités inattendues » ont émergé, absentes des modèles précédents : optimisation autonome de code, compréhension de textes juridiques complexes et génération d'articles de recherche d'une qualité quasi professionnelle. Cette croissance est non linéaire et dépasse souvent les attentes du secteur.

Toutefois, la mise en place d'un système réglementaire nécessite plusieurs étapes, notamment la recherche, la discussion, la législation et la mise en œuvre, et le processus prend généralement des années.Elle présente une caractéristique «linéaire».Si la réglementation suit toujours la technologie, un vide se créera où « les capacités seront en place mais la gouvernance ne le sera pas », et des risques risquent de s'accumuler pendant cette période de vide.

Le risque ne réside pas dans un problème de couche applicative, mais dans un problème de capacités fondamentales.

Nombreux sont ceux qui pensent que les risques liés à l'IA peuvent être atténués par un « contrôle au niveau de l'application », comme la définition de règles de filtrage dans des scénarios spécifiques. Cependant, Dario Amodei souligne que…Le risque lié aux modèles à grande échelle est essentiellement un « problème de capacité fondamentale ».— Des capacités telles que la génération d'informations mortelles, l'automatisation des risques biologiques (par exemple, la génération de plans expérimentaux biologiques dangereux) et les capacités de pénétration de réseau (par exemple, l'écriture de code malveillant) découlent toutes des capacités fondamentales du modèle, plutôt que de scénarios d'application.

Cela signifie que même si un risque est atténué dans un scénario d'application particulier, le modèle peut toujours exploiter ses capacités sous-jacentes pour créer de nouveaux risques dans d'autres scénarios. Par conséquent, les contrôles de la couche application ne peuvent à eux seuls éliminer les risques ; des seuils de sécurité doivent être établis au niveau du modèle fondamental par le biais de la réglementation.

La concurrence sur le marché ne peut s'autoréguler.

Dario Amodei a souligné à plusieurs reprises lors de conférences sectorielles que « la concurrence dans le secteur de l'IA exerce une pression considérable : aucun fournisseur ne ralentira volontairement le rythme d'amélioration de ses fonctionnalités, car tout retard pourrait entraîner son élimination par le marché ». Dans cet environnement concurrentiel, l'autodiscipline est quasi impossible et les entreprises privilégient souvent l'amélioration des fonctionnalités tout en réduisant au minimum les tests de sécurité.

Par conséquent, il croit queLa réglementation doit devenir une « contrainte externe contraignante ».Afin d'établir un référentiel de sécurité unifié pour l'ensemble du secteur et d'empêcher les entreprises de tomber dans un cercle vicieux où l'argent mal dépensé court après l'argent bien dépensé — c'est-à-dire : « Si vous ne faites pas de tests de sécurité, je n'en ferai pas non plus, sinon le coût sera plus élevé et la vitesse plus lente. »

Derrière ces raisons se cache le jugement fondamental de Dario Amodei sur l'ère de l'IA :L’IA n’est pas un « produit de contenu » de l’ère Internet (comme les logiciels sociaux et les plateformes vidéo), mais une « technologie d’infrastructure » qui peut avoir un impact direct sur la prise de décision et les structures de risque dans le monde réel.Tout comme pour l'électricité et les transports, pour ces types de technologies, une réglementation précoce ne vise pas à « restreindre l'innovation », mais plutôt à « garantir la pérennité de l'innovation ».

Approche technique : L’IA constitutionnelle ne consiste pas à corriger des problèmes, mais à reconstruire les mécanismes comportementaux des modèles.

Si OpenAI est qualifiée de « leader commercial », Meta est qualifiée de « dominée par l'écosystème open-source » et Google DeepMind est qualifiée d'« approche à double voie de la recherche et de l'ingénierie »,Le slogan d'Anthropic est très clair : L'alignement comme ingénierie. Cela implique d'utiliser une approche d'ingénierie systématique pour garantir que le comportement des modèles d'IA soit conforme aux valeurs humaines. L'exemple le plus représentatif de cette approche est l'IA constitutionnelle (IAC), développée sous la direction de Dario Amodei.

Lien vers l'article :https://arxiv.org/abs/2212.08073

L'idée centrale de Constitutional AI bouleverse l'approche traditionnelle d'alignement : au lieu de s'appuyer sur les jugements de valeur subjectifs d'annotateurs humains pour ajuster son comportement, le modèle s'auto-calibre selon un ensemble de « principes constitutionnels » ouverts, vérifiables et reproductibles. Cette « constitution », élaborée conjointement par l'équipe d'Anthropic en collaboration avec des éthiciens, des juristes et des spécialistes des sciences sociales, contient des centaines de principes fondamentaux, tels que « ne pas générer d'informations nuisibles », « respecter la diversité des valeurs » et « faire preuve d'honnêteté face aux questions incertaines ».

En pratique, l'IA constitutionnelle assure l'alignement en deux étapes clés : premièrement, le modèle procède à une auto-évaluation de son contenu généré au regard de la constitution, identifiant les points de non-conformité ; deuxièmement, il se corrige en fonction des résultats de cette auto-évaluation, optimisant ainsi en continu le contenu produit. Cette approche a trois principaux impacts :

* Réduire le biais de valeur de RLHF :L'apprentissage par renforcement traditionnel (RLHF) repose sur le jugement d'annotateurs humains, mais différents annotateurs peuvent avoir des biais de valeur (tels que des différences culturelles et des divergences de position personnelle), tandis que l'IA constitutionnelle, basée sur des « principes constitutionnels » unifiés, réduit considérablement ces biais ;

* Le processus d'alignement est transparent et traçable :Les « principes constitutionnels » sont publics, et le processus d'auto-calibration du modèle est également enregistrable et vérifiable, permettant au monde extérieur de comprendre clairement pourquoi le modèle prend une certaine décision, évitant ainsi un « alignement en boîte noire ».

* Faire de la sécurité un processus d’« ingénierie des systèmes », et non un correctif basé sur l’intuition humaine :Les mesures de sécurité traditionnelles consistent souvent à « corriger la vulnérabilité là où le problème se produit », tandis que l'IA constitutionnelle reconstruit le mécanisme de comportement du modèle à partir de zéro, faisant de la sécurité un « instinct » du modèle, plutôt qu'un correctif ajouté de l'extérieur.

Cette approche technologique confère aux modèles de Claude un avantage décisif pour leur déploiement en production dès 2024-2025 : une stabilité et une maîtrise accrues, ainsi qu’une plus grande facilité de déploiement à l’échelle de l’entreprise. De nombreuses institutions financières, cabinets d’avocats et administrations publiques considèrent la maîtrise des modèles de Claude comme un critère essentiel dans le choix de modèles à grande échelle, car ces secteurs présentent une tolérance au risque extrêmement faible et exigent des résultats de modélisation stables et prévisibles.

Dans le paysage mondial de l'intelligence artificielle, la stratégie d'Amodei prend une valeur croissante. À mesure que les capacités de ses modèles s'étendent à des scénarios à forte valeur ajoutée tels que l'évaluation des risques financiers et le diagnostic médical, les exigences en matière de sécurité et de fiabilité deviennent de plus en plus pressantes.

Contrairement à la commercialisation rapide d'OpenAI, à la stratégie open source de Meta et à l'approche de DeepMind axée sur la publication d'articles et l'exploration de l'IA générale, Anthropic considère la sécurité comme un fondement essentiel pour accéder aux marchés clés. L'entreprise favorise un accès aux normes industrielles élevées en externalisant ses outils internes d'évaluation de la sécurité et prévoit l'émergence d'un modèle de « sécurité en tant que service » à l'avenir.

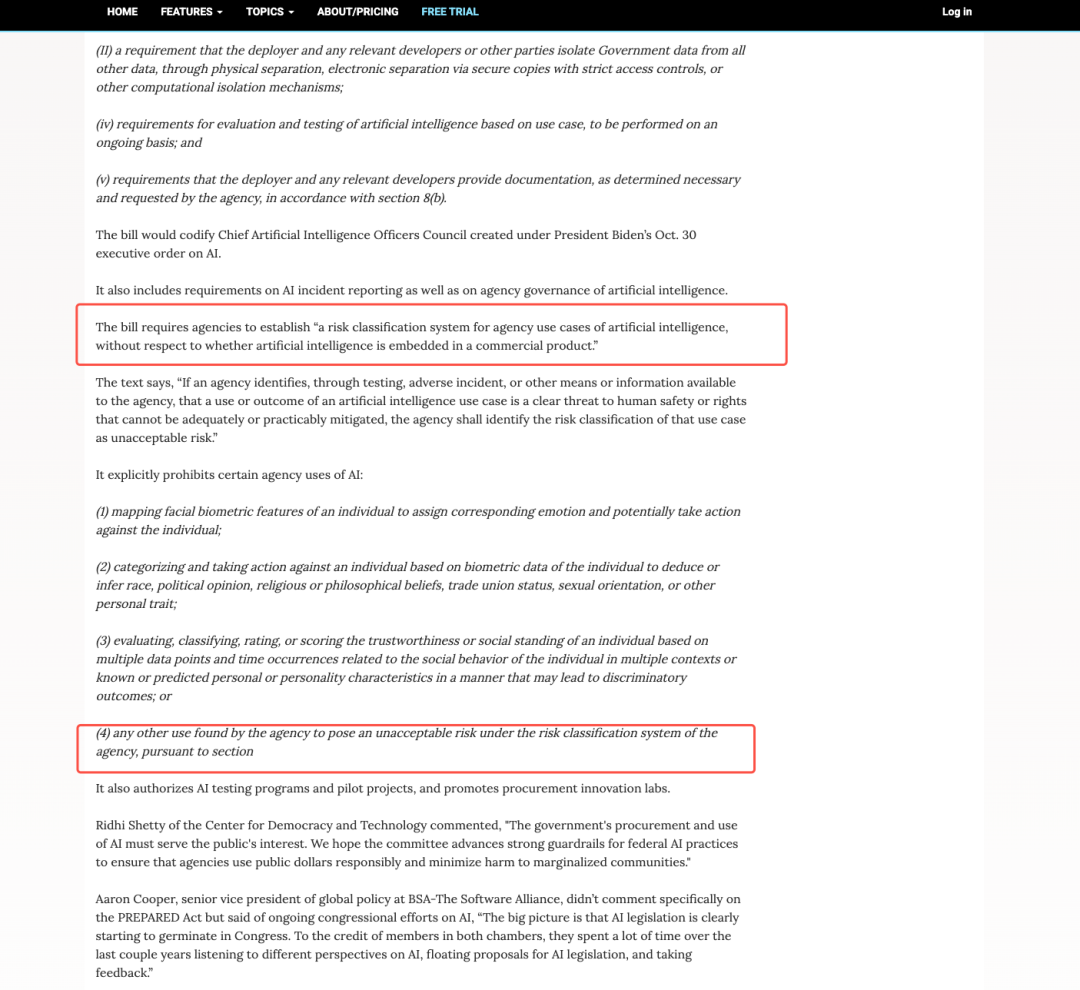

Cette logique est également étayée par des aspects politiques et réglementaires :La loi européenne sur l'IA et les exigences fédérales américaines en matière de marchés publics imposent des normes de sécurité strictes pour les IA à haut risque, transformant ainsi la sécurité d'une question morale en une nécessité politique et commerciale. Bien que la part de marché d'Anthropic demeure inférieure à celle d'OpenAI, son importance stratégique en matière d'influence politique, de pénétration des secteurs clés et de capacité à définir des normes de sécurité ne cesse de croître. Ceci souligne la position minoritaire, mais non faible, d'Anthropic : façonner le paysage de l'industrie de l'IA par des moyens institutionnels et technologiques, plutôt que de se reposer uniquement sur sa part de marché.

Critiques et controverses : la sécurité deviendra-t-elle un outil pour les monopoles industriels ?

Bien que l’approche de Dario Amodei en matière de sécurité puisse paraître idéale et envisager l’avenir, elle se heurte à une forte opposition, tant au sein qu’à l’extérieur du secteur. Ces controverses portent principalement sur trois aspects, soulignant la complexité des enjeux liés à la sécurité de l’IA :

La sécurité peut devenir un motif de « restriction de la concurrence ».

Yann LeCun, directeur scientifique de Meta, est l'un des leaders technologiques les plus virulents contre les « réglementations de sécurité trop restrictives ». Il a laissé entendre à plusieurs reprises sur les réseaux sociaux et lors de conférences sectorielles que le plaidoyer de Dario Amodei en faveur d'une « réglementation précoce » et de « normes de sécurité élevées » revient essentiellement à « ériger des barrières à l'entrée élevées pour les startups » — les grandes entreprises disposant de fonds et de ressources suffisants pour investir dans la R&D en matière de sécurité.Les start-ups risquent de disparaître faute de pouvoir assumer les coûts de sécurité, ce qui conduit finalement à des monopoles industriels.

Les idées de LeCun ont rallié de nombreuses startups spécialisées en IA. Celles-ci estiment que les normes de sécurité actuelles ne sont pas encore harmonisées et qu'une mise en œuvre prématurée de réglementations strictes pourrait permettre aux géants du secteur de se servir de la « sécurité » pour évincer les plus petits acteurs.

La sécurité ne peut être quantifiée et devient facilement un slogan vide de sens.

Un autre point de désaccord majeur concerne la « mesurabilité de la sécurité ».Actuellement, les normes d'évaluation de la sécurité de l'IA sont très fragmentées, les différentes entreprises appliquant des critères incohérents pour déterminer ce qui constitue une IA sûre. Les méthodes, l'intensité et la transparence des tests de sécurité, des évaluations et des tests d'intrusion varient considérablement, et il n'existe même pas de réponse unifiée à la question de savoir ce qui constitue une IA sûre. Par exemple, Anthropic considère l'auto-calibration du modèle comme un critère de sécurité, OpenAI peut considérer la réussite de tests d'intrusion externes comme un critère de sécurité, tandis que les agences gouvernementales peuvent être davantage préoccupées par le fait que le modèle ne génère pas d'informations nuisibles.

Cette fragmentation rend la « sécurité » difficile à quantifier, la réduisant facilement à un slogan vide de sens pour les entreprises qui cherchent à soigner leur image. Une entreprise peut affirmer que son modèle est « très sûr », sans pouvoir le prouver à l'aide de normes reconnues par le secteur. Les critiques soutiennent qu'avant l'unification des normes, une importance excessive accordée à la « sécurité » pourrait induire le marché en erreur, laissant croire aux utilisateurs, à tort, que les risques liés à l'IA ont été éliminés. De plus, les recherches universitaires indiquent qu'une réglementation excessive et rigide (ou des règles uniformes) du développement de l'IA pourrait freiner l'innovation.

Lien vers l'article :https://arxiv.org/abs/2104.03741

Il existe un décalage naturel entre la technologie et la réglementation.

De nombreux experts en technologies soulignent que la capacité à prédire les modèles à grande échelle demeure un problème scientifique non résolu : même les chercheurs les plus avancés ne peuvent prédire avec exactitude les capacités de la prochaine génération de modèles, ni les risques qu’elles pourraient engendrer. Dans ce contexte, une « réglementation précoce » risque de se heurter à deux problèmes : soit une « mauvaise appréciation des risques », consistant à considérer des innovations technologiques inoffensives comme des risques et à les restreindre ; soit une « négligence des risques », c’est-à-dire une incapacité à anticiper les dangers réels, conduisant à un échec de la réglementation.

Dario Amodei a réagi à ces controverses. Il a reconnu que les normes de sécurité doivent être « adaptées de manière dynamique » et s'est prononcé en faveur des subventions publiques pour la R&D en sécurité menée par les jeunes entreprises afin de réduire les obstacles à la concurrence. Il a toutefois affirmé : « Même en cas de controverses, nous ne pouvons pas attendre que les risques se concrétisent avant d'agir ; le coût de l'absence de réglementation est bien supérieur à celui de la surréglementation. »

Ces controverses, en réalité, mettent en lumière une seule chose :La sécurité de l'IA n'est pas seulement un problème technique et scientifique, mais aussi politique et économique. Cela implique de multiples dimensions telles que la structure industrielle, les règles de la concurrence et la répartition mondiale du pouvoir. Il n'existe pas de solution idéale et nous ne pouvons que rechercher un équilibre au sein même de la controverse.

Amodei ne prône pas une « voie de sécurité », mais plutôt un « protocole logique » pour l'ère de l'IA.

Si l'on se penche sur l'histoire du développement d'Internet, on constate que si Internet est passé d'un « outil académique » à une « infrastructure mondiale », c'est parce que…L'essentiel réside dans l'établissement d'un protocole sous-jacent unifié. — TCP/IP (Transmission Control Protocol/Internet Protocol), DNS (Domain Name System), HTTPS (Hypertext Transfer Security Protocol), etc. Ces protocoles n'impliquent pas de scénarios d'application spécifiques, mais fournissent un « langage universel » pour tous les services Internet, permettant aux utilisateurs de différents appareils, plateformes et régions de se connecter sans problème.

À mon avis,Dario Amodei ne prône pas une simple « approche de sécurité », mais tente plutôt d'établir un « protocole logique » similaire pour l'ère de l'IA.— Une infrastructure de gouvernance unifiée, sécurisée, auditable et reproductible. L’objectif principal de ce « protocole » n’est pas de « restreindre les capacités de l’IA », mais de « leur permettre de réaliser leur plein potentiel dans un cadre maîtrisable ».

Ce qu'il souhaite, ce n'est pas élever les barrières à l'entrée du secteur, ni ralentir sa croissance, mais établir un « système de sécurité de l'IA qui puisse être compris, reproduit et utilisé à l'échelle mondiale ».De même que le protocole TCP/IP permet à Internet d'atteindre l'« interconnexion », les « protocoles de gouvernance » de l'IA peuvent permettre aux technologies d'IA mondiales de parvenir à un « développement collaboratif » sécurisé, en évitant la propagation des risques et le gaspillage des ressources causés par des normes incohérentes.

Il ne s'agit pas de pessimisme technologique, mais d'ingénierie industrielle. Elle reconnaît les risques liés à l'IA, mais estime qu'ils peuvent être maîtrisés par une conception institutionnelle rigoureuse ; elle ne nie pas la valeur novatrice de l'IA, mais insiste sur le fait que l'innovation doit être encadrée. De même qu'Internet a connu une expansion exponentielle après la protocolisation, la seconde phase de l'IA, de l'« explosion technologique » à l'« application stable », pourrait nécessiter un ensemble de « protocoles de gouvernance » comme point d'appui.

Derniers mots

À mesure que l'IA devient progressivement un atout essentiel influençant la productivité, les capacités militaires et la sécurité nationale, la « sécurité » ne sera plus un enjeu technologique, mais un enjeu stratégique touchant à l'ordre mondial. Demain, celui qui saura définir la « sécurité » pourra définir les règles de l'industrie de l'IA ; celui qui pourra établir un « cadre de sécurité » pourra prendre l'avantage dans la compétition technologique mondiale.

Dario Amodei n'est peut-être pas le seul pionnier de cette transformation, mais il est sans aucun doute le plus lucide et aussi le plus controversé. Sa valeur réside non pas dans la proposition d'une « solution parfaite », mais dans sa capacité à contraindre l'ensemble du secteur et la société mondiale à se confronter à un enjeu crucial : pour que l'IA progresse, elle ne peut se reposer uniquement sur l'enthousiasme technologique, mais aussi sur la rationalité institutionnelle. Et c'est précisément là la clé pour transformer l'IA d'une « technologie de rupture » en une « force constructive ».

Liens de référence :

1.https://www.anthropic.com/news/claude-3-family

2.https://www.reuters.com/business/retail-consumer/anthropic-ceo-says-proposed-10-year-ban-state-ai-regulation-too-blunt-nyt-op-ed-2025-06-05

3.https://arxiv.org/abs/2212.08073

4.https://arstechnica.com/ai/2025/01/anthropic-chief-says-ai-could-surpass-almost-all-humans-at-almost-everything-shortly-after-2027/

5.https://www.freethink.com/artificial-intelligence/agi-economy