Command Palette

Search for a command to run...

Dario Amodei, Der Auf Proaktive Aufsicht Besteht, Integrierte Die Sicherheit Von KI Nach Seinem Ausscheiden Bei OpenAI in Die Unternehmensmission.

Im aktuellen KI-Zyklus, der von einem Wettlauf um Rechenleistung, dem Wettbewerb zwischen Tech-Giganten und beschleunigten Investitionen angetrieben wird, ist Dario Amodei, Mitgründer und CEO von Anthropic, einer der wenigen, aber unbestreitbaren „Querdenker“ im Silicon Valley. Während die meisten Technologieunternehmen „schnellere Iterationen und stärkere Fähigkeiten“ als ihre Kernziele priorisieren, hält er konsequent an einer immer überzeugenderen Überzeugung fest:„Sicherheit ist keine Bremse, sondern die einzige institutionelle Sicherheitsbarriere, die es der Branche ermöglicht, sich weiterzuentwickeln.“

Laut Dario Amodei wird das explosive Wachstum der Fähigkeiten von Großmodellen in den nächsten fünf Jahren die Entwicklung sozialer Steuerungsmechanismen unweigerlich überholen.Ohne einen von oben verordneten Sicherheitsgovernance-Rahmen droht die KI-Entwicklung in einen gefährlichen „Komplexitäts-Gegenreaktionszyklus“ zu geraten.— Das Tempo des technologischen Wachstums überfordert das Regierungssystem vollständig, was letztendlich dazu führt, dass sich Risiken zu systemischen Bedrohungen summieren, die nicht nur zu Krisen für einzelne Unternehmen führen, sondern auch den Betrieb der gesamten Gesellschaft stören können.

Kehren wir zum Ausgangspunkt dieser technologischen und politischen Divergenz zurück: Das Kernargument, dass „Sicherheit niemals das Gegenteil von Innovation ist, sondern vielmehr die einzige grundlegende Logik darstellt, die es KI ermöglicht, sich kontinuierlich weiterzuentwickeln, nachdem sie Teil der nationalen Infrastruktur geworden ist“, scheint eine Tatsache zu bestätigen: Dario Amodei propagiert keinen „sicherheitsorientierten Ansatz“, sondern ein „logisches Protokoll“ für das KI-Zeitalter. Dieses Protokoll legt kontrollierbare, überprüfbare und stoppbare operative Voraussetzungen für die technologische Expansion fest und verhindert so, dass das Wachstum der Fähigkeiten durch ein systemisches Risiko abrupt unterbrochen wird. Im Wesentlichen bietet diese Sichtweise eine stabile Grundlage für die langfristige kommerzielle Expansion von KI, anstatt Innovationen entgegenzuwirken und sie zu bremsen.

Vom Austritt aus OpenAI zur Gründung von Anthropic: Eine „Unabhängigkeitserklärung“ nach einer Wertespaltung.

Dario Amodeis tiefe Verbundenheit mit dem „Sicherheitsweg“ lässt sich auf seine Zeit bei OpenAI und seine Meinungsverschiedenheiten mit den Kernwerten des Unternehmens zurückführen.

Um das Jahr 2020, mit der rasanten Kommerzialisierung der GPT-Serienmodelle, beschleunigte OpenAI seine technologischen Iterations- und Kommerzialisierungsbemühungen, doch die entsprechenden Risikomanagementmechanismen und Governance-Systeme sind noch nicht klar definiert.

Nachdem die New York Times 2023 eine Urheberrechtsklage gegen OpenAI und andere Unternehmen eingereicht hatte, äußerten einige Forscher bei OpenAI bereits Bedenken hinsichtlich des rasanten Kommerzialisierungstempos. Dario Amodei hatte dies jedoch schon Jahre zuvor vorausgesehen und gehörte zu den Schlüsselfiguren, die sich als Erste für einen strengeren Risikobewertungsmechanismus innerhalb des Unternehmens einsetzten. Er plädierte dafür, vor der Modelliteration einen Schritt zur Risikoprognose einzuführen und den Sicherheitstestprozess vor der Kommerzialisierung zu verbessern. Diese Vorschläge, die eher auf institutionelle Weiterentwicklung abzielten, wurden jedoch durch den zunehmenden Kommerzialisierungsdruck des Unternehmens allmählich verdrängt.

Nach wiederholten Rückschlägen bei seinen internen institutionellen Vorschlägen verließen Dario Amodei und eine Gruppe von Kernforschern OpenAI im Jahr 2021 offiziell, um Anthropic zu gründen.Hinter diesem Schritt, ein eigenes Unternehmen zu gründen, lässt sich leicht das Ungleichgewicht in ihren Philosophien hinsichtlich der Priorisierung von Sicherheit versus Kommerzialisierung erkennen.

Das Leitbild von Anthropic spiegelt diesen Perspektivenunterschied deutlich wider. Anstatt die branchenübliche Formulierung „leistungsfähige KI entwickeln“ zu verwenden, heißt es dort explizit: „Wir entwickeln zuverlässige, interpretierbare und steuerbare KI-Systeme.“

Zu jener Zeit drehte sich die vorherrschende Meinung im Silicon Valley noch immer um „Leistung ist Wettbewerbsvorteil“, wobei fast alle Unternehmen über den Umfang der Modellparameter, Investitionen in Rechenleistung und die Geschwindigkeit der Anwendungsbereitstellung konkurrierten. Dario Amodei hingegen wählte einen anderen Weg – Anthropic betrachtete die „Kontrollierbarkeit“ als Kern des zukünftigen Wettbewerbs und legte mit dieser scheinbar kontraintuitiven Entscheidung das gesamte konzeptionelle Fundament für die Umsetzung der nachfolgenden Sicherheitsstrategie.

Die zugrunde liegende Logik von „Sicherheit als Strategie“ lautet: Mit der Verbesserung der Fähigkeiten muss sich auch die Governance entsprechend verbessern.

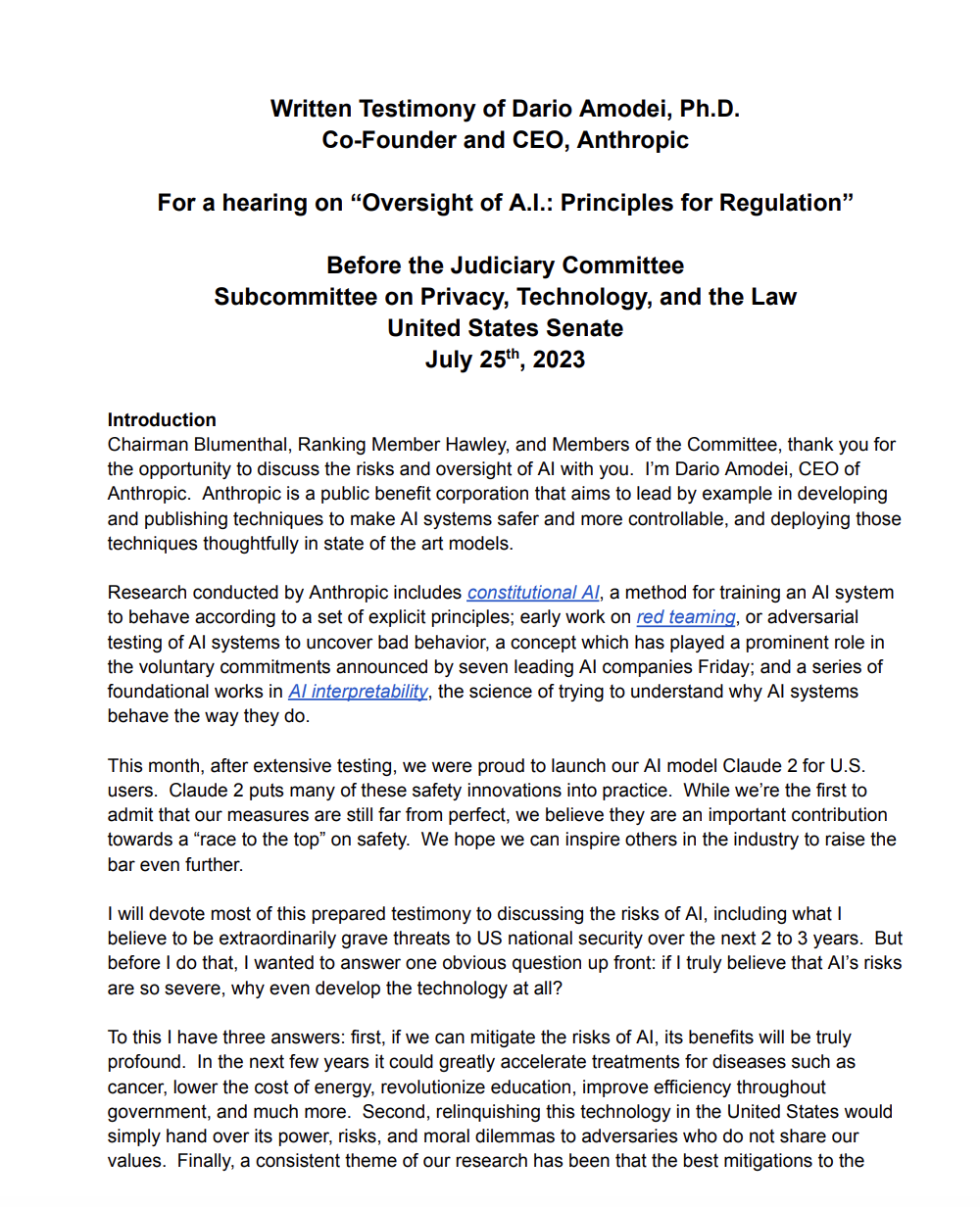

Im Gegensatz zu vielen Technologieunternehmen, die „ethische Sicherheit“ lediglich als Ausschmückung in technischen Berichten oder als Verkaufsargument zur Kundengewinnung betrachten, propagiert Dario Amodei ein hochentwickeltes „Sicherheitsstrategie-Framework“. In seiner schriftlichen Stellungnahme vor dem US-Senat zu KI-Risiken und -Regulierung betonte er: „Wir können die vollen Fähigkeiten der nächsten Modellgeneration nicht vorhersehen. Daher müssen wir gestaffelte institutionelle Schutzmaßnahmen etablieren, bevor wir sie entwickeln, anstatt erst nach dem Auftreten von Risiken zu versuchen, die Situation zu beheben.“

Auf diesem Konzept aufbauend hat Anthropic ein vollständiges „Capability-Security Co-Evolution Model“ entwickelt, das die Sicherheitsgovernance in jeden Aspekt der Technologieentwicklung einbettet.

* Fähigkeitsprognose:Mithilfe historischer Daten und algorithmischer Modelle können wir im Voraus die neuen Fähigkeiten beurteilen, die in der nächsten Generation großer Modelle entstehen könnten, insbesondere solche Fähigkeiten, die potenzielle Risiken bergen, wie z. B. eine genauere Erzeugung von Desinformationen und das Schreiben komplexerer Codes (die für Cyberangriffe verwendet werden könnten).

* Sicherheitsniveaus:Angelehnt an das Risikostufensystem der Kernenergiebranche werden verschiedene Sicherheitsstufen nach der Leistungsfähigkeit des Modells und den Anwendungsszenarien unterteilt, wobei jede Stufe unterschiedlichen Teststandards, Nutzungsberechtigungen und Überwachungsmechanismen entspricht;

* Externe Red Teams und Anforderungen an die Interpretierbarkeit:Die Einbindung externer Red Teams aus verschiedenen Institutionen und Fachbereichen für Angriffstests erzwingen und gleichzeitig fordern, dass das Modell eine nachvollziehbare logische Kette für wichtige Entscheidungsprozesse bereitstellt, um die Risiken einer „Black-Box-Entscheidungsfindung“ zu vermeiden;

* Go/No-Go-Gates:Richten Sie an Schlüsselstellen der Modelliteration „Zulassungs-/Sperrmechanismen“ ein. Erst wenn die Sicherheitstests die Standards erfüllen und die Risikobewertung erfolgreich abgeschlossen ist, kann die nächste Entwicklungs- oder Bereitstellungsphase zugelassen werden, wobei der Grundsatz „Erweiterung ist nur zulässig, wenn sie kontrolliert werden kann“ klar definiert wird.

Diese systematische Sicherheitsarchitektur hat Dario Amodei in den Augen US-amerikanischer Politiker zu einem „Technologie-CEO mit einem besseren Verständnis von Governance“ gemacht. Im Juli 2023 wurde er vom US-Senat zu einem KI-Einblicksforum eingeladen. Seine Ansichten zu „gestaffelter Regulierung“ und „vorausschauender Risikoprognose“ zählten zu den meistzitierten technischen Stimmen in den anschließenden Diskussionen über den AI Security Act.

Während die meisten Silicon-Valley-Unternehmen Sicherheit als PR-Instrument zur Imageverbesserung betrachten, sieht Dario Amodei sie als ein Betriebssystem, das „die langfristige Entwicklung der Branche vorantreibt“ – er ist der festen Überzeugung, dass KI nur durch die Etablierung eines stabilen Sicherheitsrahmens wirklich von einer „Labortechnologie“ zu einer „sozialen Infrastruktur“ werden kann.

Warum auf einer „frühen Regulierung“ bestehen? Die Technologie befindet sich in einer Phase des nichtlinearen Wachstums.

Von allen Ansichten Dario Amodeis ist nicht sein Ansatz zur technologischen Ausrichtung die umstrittenste, sondern vielmehr seine Haltung zur Regulierung: „Regulierung muss präventiv erfolgen, anstatt passiv zu reagieren, nachdem Risiken entstanden sind.“ Diese These steht im krassen Gegensatz zur langjährigen Kultur des Silicon Valley, die auf „weniger Regulierung, mehr Freiheit“ setzt. Seine Argumentation basiert jedoch auf einem tiefen Verständnis der Entwicklungsmuster von KI-Technologie, die sich im Wesentlichen aus drei Dimensionen ergeben:

Die Leistungsfähigkeit der Modelle wächst exponentiell, die Regulierung hingegen linear.

Von GPT-3 mit rund 175 Milliarden Parametern im Jahr 2020 über GPT-4 im Jahr 2023 mit einem signifikanten Leistungssprung (die Parameteranzahl wird nicht öffentlich bekannt gegeben, aber viele vermuten sie im Bereich von 500 Milliarden bis 1 Billion) bis hin zu Anthropics Claude 3 im Jahr 2024 (das seine Vorgänger in mehreren Benchmark-Tests übertraf) haben sich die Fähigkeiten jeder Generation von Großmodellen exponentiell verbessert. Dabei sind viele unerwartete Fähigkeiten entstanden, die frühere Modelle nicht besaßen – wie die autonome Optimierung von Code, das Verständnis komplexer Rechtstexte und die Erstellung von Forschungsarbeiten auf nahezu professionellem Niveau. Dieses Wachstum verläuft nichtlinear und übertrifft oft die Erwartungen der Branche.

Die Einrichtung eines Regulierungssystems erfordert jedoch mehrere Phasen, darunter Forschung, Diskussion, Gesetzgebung und Umsetzung, und dieser Prozess dauert in der Regel Jahre.Es weist ein "lineares" Verhalten auf.Wenn die Regulierung immer der Technologie folgt, entsteht ein Vakuum, in dem „die Fähigkeiten vorhanden sind, aber die Steuerung fehlt“, und in dieser Vakuumphase können sich Risiken anhäufen.

Das Risiko ist kein Problem der Anwendungsschicht, sondern ein Problem der grundlegenden Fähigkeiten.

Viele glauben, dass KI-Risiken durch „Anwendungssteuerung“ – etwa durch das Festlegen von Filterregeln in bestimmten Szenarien – gemindert werden können. Dario Amodei weist jedoch darauf hin, dass…Das Risiko von Großmodellen ist im Wesentlichen ein „Problem der fundamentalen Leistungsfähigkeit“.— Fähigkeiten wie die Generierung letaler Informationen, die Automatisierung biologischer Risiken (z. B. die Erstellung gefährlicher biologischer Versuchspläne) und die Fähigkeit zum Eindringen in Netzwerke (z. B. das Schreiben von Schadcode) leiten sich allesamt von den grundlegenden Fähigkeiten des Modells ab und nicht von Anwendungsszenarien.

Das bedeutet, dass selbst wenn ein Risiko in einem bestimmten Anwendungsszenario gemindert wird, das Modell seine zugrundeliegenden Fähigkeiten weiterhin nutzen kann, um in anderen Szenarien neue Risiken zu erzeugen. Daher können Kontrollen auf Anwendungsebene allein Risiken nicht eliminieren; Sicherheitsschwellenwerte müssen durch Regulierung auf der Ebene des Basismodells festgelegt werden.

Der Wettbewerb auf dem Markt kann seine Ausdehnung nicht selbst regulieren.

Dario Amodei hat auf Branchenkonferenzen wiederholt betont: „Der Wettbewerb in der KI-Branche erzeugt Druck – kein Anbieter wird freiwillig das Tempo der Funktionsentwicklung verlangsamen, denn wer ins Hintertreffen gerät, läuft Gefahr, vom Markt verdrängt zu werden.“ In diesem wettbewerbsintensiven Umfeld ist Selbstdisziplin nahezu unmöglich, und Unternehmen priorisieren häufig die Verbesserung der Fähigkeiten, während sie Sicherheitstests auf ein Minimum reduzieren.

Deshalb glaubt er, dassDie Regulierung muss zu einer „externen verbindlichen Vorgabe“ werden.Um einen einheitlichen Sicherheitsstandard für die gesamte Branche festzulegen und zu verhindern, dass Unternehmen in einen Teufelskreis geraten, in dem schlechtes Geld guten Geld hinterherjagt – das heißt: „Wenn ihr keine Sicherheitstests durchführt, werde ich es auch nicht tun, andernfalls werden die Kosten höher und die Geschwindigkeit geringer sein.“

Hinter diesen Gründen verbirgt sich Dario Amodeis zentrales Urteil über das Zeitalter der KI:Künstliche Intelligenz ist kein „Inhaltsprodukt“ des Internetzeitalters (wie etwa soziale Software und Videoplattformen), sondern eine „Infrastrukturtechnologie“, die sich direkt auf reale Entscheidungsprozesse und Risikostrukturen auswirken kann.Ähnlich wie bei Elektrizität und Transportwesen geht es bei diesen Technologien bei der frühen Regulierung nicht darum, „Innovationen einzuschränken“, sondern vielmehr darum, „die Nachhaltigkeit von Innovationen zu gewährleisten“.

Technischer Ansatz: Bei konstitutioneller KI geht es nicht um das Ausbessern von Fehlern, sondern um die Rekonstruktion der Verhaltensmechanismen von Modellen.

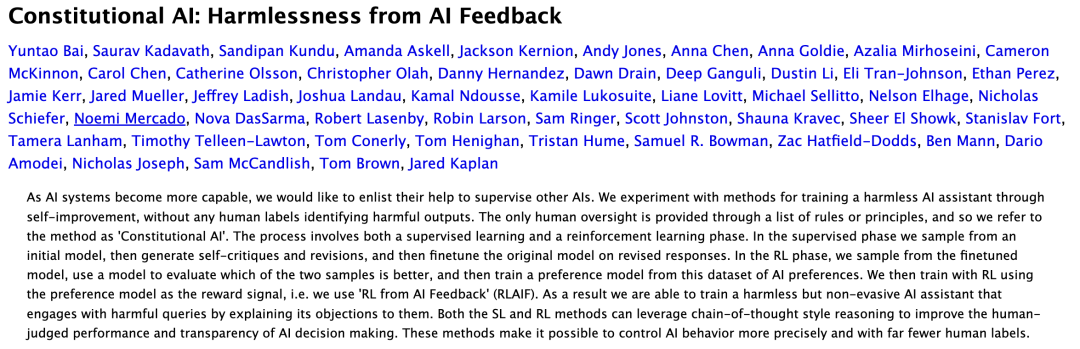

Wenn OpenAI als „kommerziell führend“ bezeichnet wird, Meta als „vom Open-Source-Ökosystem dominiert“ und Google DeepMind als „mit einem zweigleisigen Ansatz in Forschung und Entwicklung“,Der Slogan von Anthropic ist sehr eindeutig: Ausrichtung als Ingenieursleistung. Dies bedeutet, mithilfe eines systematischen ingenieurwissenschaftlichen Ansatzes sicherzustellen, dass das Verhalten von KI-Modellen mit menschlichen Werten übereinstimmt. Das repräsentativste Ergebnis dieser Vorgehensweise ist die Verfassungs-KI (CAI), die unter der Leitung von Dario Amodei entwickelt wurde.

Link zum Artikel:https://arxiv.org/abs/2212.08073

Die Kernidee der Verfassungs-KI stellt den traditionellen Ansatz der Ausrichtung auf den Kopf: Anstatt sich auf die subjektiven Werturteile menschlicher Annotatoren zu verlassen, um sein Verhalten anzupassen, kalibriert sich das Modell selbst anhand einer Reihe offener, überprüfbarer und reproduzierbarer „Verfassungsprinzipien“. Diese „Verfassung“, die vom Anthropic-Team in Zusammenarbeit mit Ethikern, Rechtsexperten und Sozialwissenschaftlern entwickelt wurde, enthält Hunderte von Grundprinzipien, wie beispielsweise „keine schädlichen Informationen zu generieren“, „unterschiedliche Werte zu respektieren“ und „bei unsicheren Fragen ehrlich zu sein“.

In der praktischen Anwendung erreicht Constitutional AI die Übereinstimmung durch zwei wesentliche Schritte: Erstens „kritisiert“ das Modell seine generierten Inhalte anhand der „Verfassung“ selbst und identifiziert Bereiche, die den Prinzipien nicht entsprechen. Anschließend korrigiert sich das Modell auf Grundlage dieser „Selbstkritik“ und optimiert so kontinuierlich die generierten Inhalte. Dieser Ansatz hat drei wesentliche Auswirkungen:

* Reduzierung der Wertverzerrung von RLHF:Traditionelles RLHF (Reinforcement Learning Based on Human Feedback) stützt sich auf das Urteil menschlicher Annotatoren, doch können unterschiedliche Annotatoren Wertvoreingenommenheiten aufweisen (z. B. aufgrund ihres kulturellen Hintergrunds oder unterschiedlicher persönlicher Ansichten), während Constitutional AI, basierend auf einheitlichen „Verfassungsprinzipien“, solche Voreingenommenheiten stark reduziert.

* Der Ausrichtungsprozess ist transparent und nachvollziehbar:Die „verfassungsrechtlichen Grundsätze“ sind öffentlich, und der Selbstkalibrierungsprozess des Modells ist ebenfalls aufzeichnungs- und überprüfbar, sodass die Außenwelt klar nachvollziehen kann, warum das Modell eine bestimmte Entscheidung trifft, wodurch eine „Black-Box-Ausrichtung“ vermieden wird.

* Sicherheit sollte ein „Systementwicklungsprozess“ sein, keine auf menschlicher Intuition basierende Behelfslösung:Bei herkömmlichen Sicherheitsmaßnahmen geht es oft darum, „die Schwachstelle dort zu beheben, wo das Problem auftritt“, während Constitutional AI den Verhaltensmechanismus des Modells von Grund auf neu konstruiert und Sicherheit so zu einem „Instinkt“ des Modells macht, anstatt zu einem von außen hinzugefügten Patch.

Dieser technologische Ansatz ist der entscheidende Vorteil, der Claudes Modellen den Weg in den Produktiveinsatz in den Jahren 2024–2025 ebnet: höhere Stabilität, bessere Steuerbarkeit und einfachere Implementierung im Unternehmensmaßstab. Viele Finanzinstitute, Anwaltskanzleien und Behörden betrachten Claudes Steuerbarkeit als Kernfaktor bei der Auswahl von Großmodellen, da in diesen Bereichen eine extrem geringe Risikotoleranz herrscht und stabile sowie vorhersagbare Modellergebnisse erforderlich sind.

Im globalen KI-Branchenumfeld gewinnt die Strategie von Amodei zunehmend an Bedeutung. Da die Modellfähigkeiten des Unternehmens auf anspruchsvolle Anwendungsbereiche wie die Bewertung von Finanzrisiken und die medizinische Diagnostik ausgeweitet werden, steigt die Nachfrage nach Sicherheit und Zuverlässigkeit stetig.

Anders als OpenAI mit seiner rasanten Kommerzialisierung, Meta mit seiner Open-Source-Strategie und DeepMind mit seinem Fokus auf wissenschaftliche Publikationen und die Erforschung künstlicher künstlicher Intelligenz (AGI) betrachtet Anthropic Sicherheit als Grundlage für den Zugang zu Schlüsselmärkten. Das Unternehmen fördert einen hohen Branchenzugang, indem es seine internen Sicherheitsbewertungstools extern zugänglich macht, und prognostiziert die zukünftige Entwicklung eines „Safety-as-a-Service“-Ansatzes.

Diese Logik wird auch durch politische und regulatorische Aspekte gestützt:Die EU-KI-Gesetzgebung und die Beschaffungsrichtlinien der US-Bundesregierung schreiben strenge Sicherheitsstandards für risikoreiche KI vor und wandeln Sicherheit von einer moralischen Frage zu einer politischen und wirtschaftlichen Notwendigkeit. Obwohl der Marktanteil von Anthropic noch geringer ist als der von OpenAI, wächst seine strategische Bedeutung hinsichtlich politischer Einflussnahme, Marktdurchdringung und der Festlegung von Sicherheitsstandards stetig. Dies unterstreicht Anthropics Minderheitsposition – das Unternehmen prägt die KI-Branche durch institutionelle und technologische Mittel, anstatt sich allein auf Marktanteile zu verlassen.

Kritik und Kontroverse: Wird Sicherheit zum Instrument für Industriemonopole?

Dario Amodeis „Sicherheitsansatz“ mag zwar wie ein idealisierter Zukunftstrend erscheinen, stößt aber sowohl innerhalb als auch außerhalb der Branche auf starken Widerstand. Diese Kontroversen konzentrieren sich hauptsächlich auf drei Aspekte und verdeutlichen die Komplexität von KI-Sicherheitsproblemen:

Sicherheit könnte ein Grund für die „Einschränkung des Wettbewerbs“ werden.

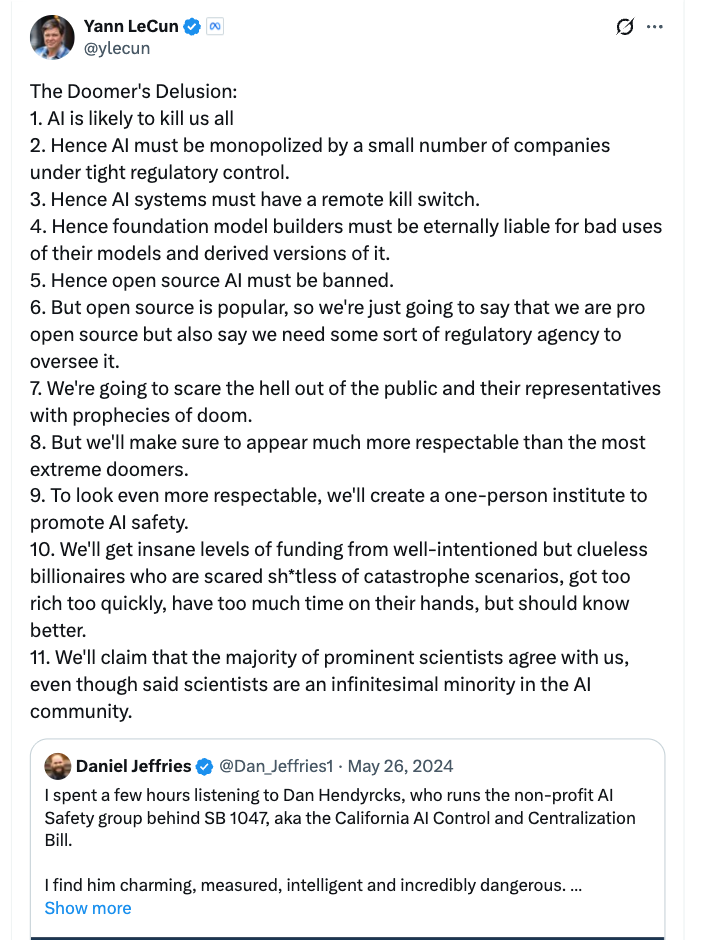

Metas Chief Scientist, Yann LeCun, ist einer der prominentesten Kritiker von „übermäßig restriktiven Sicherheitsvorschriften“ in der Technologiebranche. Er hat in sozialen Medien und auf Branchenkonferenzen wiederholt angedeutet, dass Dario Amodeis Eintreten für „frühe Regulierung“ und „hohe Sicherheitsstandards“ im Wesentlichen „hohe Markteintrittsbarrieren für Startups“ errichte – große Unternehmen verfügen über ausreichend Mittel und Ressourcen, um in Sicherheitsforschung und -entwicklung zu investieren.Startups könnten scheitern, weil sie sich die Sicherheitskosten nicht leisten können, was letztendlich zu Branchenmonopolen führen könnte.

LeCuns Ansichten finden Unterstützung bei vielen KI-Startups. Sie sind der Meinung, dass die aktuellen Sicherheitsstandards noch nicht einheitlich sind und eine verfrühte Einführung strenger Vorschriften dazu führen könnte, dass „Sicherheit“ zu einem Instrument für Großkonzerne wird, um kleinere Marktteilnehmer zu verdrängen.

Sicherheit lässt sich nicht quantifizieren und wird leicht zu einer leeren Worthülse.

Ein weiterer zentraler Streitpunkt ist die „Messbarkeit von Sicherheit“.Aktuell sind die Standards für die KI-Sicherheitsbewertung stark fragmentiert, da verschiedene Unternehmen uneinheitliche Kriterien für die Bestimmung von „sicherer KI“ anwenden. Methoden, Intensität und Transparenz von Sicherheitstests, -bewertungen und Red-Teaming variieren erheblich, und es gibt keine einheitliche Antwort auf die Frage, was sichere KI ausmacht. So betrachtet beispielsweise Anthropic die Selbstkalibrierung eines Modells als sicher, OpenAI das Bestehen externer Red-Team-Tests, während Regierungsbehörden möglicherweise mehr Wert darauf legen, dass das Modell keine schädlichen Informationen generiert.

Diese Fragmentierung erschwert die Quantifizierung von „Sicherheit“ und macht sie leicht zu einem leeren Slogan, mit dem Unternehmen ihr Image aufpolieren wollen – ein Unternehmen kann behaupten, sein Modell sei „sehr sicher“, ohne dies anhand branchenweit anerkannter Standards zu beweisen. Kritiker argumentieren, dass eine übermäßige Betonung von „Sicherheit“ den Markt irreführen und Nutzern fälschlicherweise den Eindruck vermitteln könnte, KI-Risiken seien beseitigt, solange keine einheitlichen Standards existieren. Darüber hinaus deuten wissenschaftliche Studien darauf hin, dass übermäßige/unflexible Regulierungen (oder Einheitsregeln) der KI-Entwicklung Innovationen ersticken könnten.

Link zum Artikel:https://arxiv.org/abs/2104.03741

Zwischen Technologie und Regulierung besteht ein natürlicher Widerspruch.

Viele Technologieexperten weisen darauf hin, dass die Vorhersage groß angelegter Modelle weiterhin ein ungelöstes wissenschaftliches Problem darstellt – selbst die fortschrittlichsten Forscher können nicht präzise vorhersagen, welche Fähigkeiten die nächste Generation von Modellen besitzen wird und welche Risiken damit verbunden sind. In diesem Zusammenhang kann eine frühzeitige Regulierung auf zwei Probleme stoßen: entweder auf eine Fehleinschätzung von Risiken, indem harmlose technologische Innovationen als Risiken eingestuft und eingeschränkt werden, oder auf ein Übersehen von Risiken, indem die tatsächlichen Gefahren nicht vorhergesehen werden, was zu einem Versagen der Regulierung führt.

Dario Amodei äußerte sich zu diesen Kontroversen. Er räumte ein, dass Sicherheitsstandards „dynamisch angepasst“ werden müssten, und befürwortete staatliche Subventionen für Sicherheitsforschung und -entwicklung von Startups, um Wettbewerbsbarrieren abzubauen. Er betonte jedoch: „Auch wenn es Kontroversen gibt, dürfen wir nicht warten, bis die Risiken sich manifestieren, bevor wir handeln – die Kosten mangelnder Regulierung sind weitaus höher als die Kosten übermäßiger Regulierung.“

Diese Kontroversen verdeutlichen in Wirklichkeit eines:Die Sicherheit von KI ist nicht nur eine technische und wissenschaftliche Frage, sondern auch eine politische und wirtschaftliche. Es umfasst mehrere Dimensionen wie Industriestruktur, Wettbewerbsregeln und globale Machtverteilung. Es gibt keine „perfekte Antwort“, und wir können nur inmitten von Kontroversen ein Gleichgewicht finden.

Amodei plädiert nicht für einen „Sicherheitsweg“, sondern vielmehr für ein „logisches Protokoll“ für das KI-Zeitalter.

Wenn wir die Geschichte der Internetentwicklung betrachten, stellen wir fest, dass der Grund dafür, dass sich das Internet von einem „akademischen Werkzeug“ zu einer „globalen Infrastruktur“ entwickelt hat, darin liegt, dass…Der Kern besteht in der Etablierung eines einheitlichen zugrundeliegenden Protokolls. —TCP/IP (Transmission Control Protocol/Internet Protocol), DNS (Domain Name System), HTTPS (Hypertext Transfer Security Protocol) usw. Diese Protokolle beinhalten keine spezifischen Anwendungsszenarien, sondern bieten eine „universelle Sprache“ für alle Internetdienste, die es Benutzern von verschiedenen Geräten, Plattformen und Regionen ermöglicht, sich reibungslos zu verbinden.

Meiner Meinung nach,Dario Amodei plädiert nicht für einen simplen „Sicherheitsansatz“, sondern versucht vielmehr, ein ähnliches „logisches Protokoll“ für das Zeitalter der KI zu etablieren.— Eine einheitliche, sichere, überprüfbare und replizierbare Governance-Infrastruktur. Kern dieses „Protokolls“ ist nicht die „Einschränkung von KI-Fähigkeiten“, sondern die „Ermöglichung der Wertschöpfung durch KI-Fähigkeiten innerhalb eines kontrollierbaren Rahmens“.

Sein Ziel ist es nicht, die Markteintrittsbarrieren der Branche zu erhöhen oder das Wachstum der Branche zu verlangsamen, sondern ein „KI-Sicherheitssystem zu etablieren, das verstanden, repliziert und global eingesetzt werden kann“.So wie das TCP/IP-Protokoll die „Interkonnektivität“ des Internets ermöglicht, können KI-„Governance-Protokolle“ die „kollaborative Entwicklung“ globaler KI-Technologien auf sicherer Basis ermöglichen und so die Verbreitung von Risiken und die Verschwendung von Ressourcen aufgrund uneinheitlicher Standards vermeiden.

Das ist kein technologischer Pessimismus, sondern Wirtschaftsingenieurwesen. Es erkennt die Risiken der KI an, ist aber überzeugt, dass sie durch institutionelle Gestaltung kontrolliert werden können; es leugnet nicht den Innovationswert der KI, besteht aber darauf, dass Innovationen Grenzen haben müssen. So wie das Internet nach der Protokollierung ein exponentielles Wachstum erlebte, könnte die zweite Phase der KI, von der „technologischen Explosion“ zur „stabilen Anwendung“, eine Reihe von „Governance-Protokollen“ als Dreh- und Angelpunkt erfordern.

Letzte Worte

Da KI zunehmend zu einem zentralen Faktor wird, der Produktivität, militärische Fähigkeiten und nationale Sicherheit beeinflusst, wird „Sicherheit“ nicht länger eine technologische, sondern eine strategische Frage der globalen Ordnung sein. Künftig wird derjenige, der „Sicherheit“ definiert, die Regeln der KI-Branche bestimmen; wer einen „Sicherheitsrahmen“ etabliert, wird im globalen Technologiewettbewerb die Oberhand gewinnen.

Dario Amodei ist vielleicht nicht der einzige Pionier dieser Transformation, aber zweifellos der besonnenste und zugleich umstrittenste. Sein Wert liegt nicht in der Präsentation einer „perfekten Lösung“, sondern darin, die gesamte Branche und die globale Gesellschaft mit einer entscheidenden Frage zu konfrontieren: Damit KI sich zukunftsfähig entwickelt, kann sie nicht allein auf technologische Begeisterung, sondern auch auf institutionelle Rationalität setzen. Und genau darin liegt der Schlüssel, KI von einer „disruptiven Technologie“ in eine „konstruktive Kraft“ zu verwandeln.

Referenzlinks:

1.https://www.anthropic.com/news/claude-3-family

2.https://www.reuters.com/business/retail-consumer/anthropic-ceo-says-proposed-10-year-ban-state-ai-regulation-too-blunt-nyt-op-ed-2025-06-05

3.https://arxiv.org/abs/2212.08073

4.https://arstechnica.com/ai/2025/01/anthropic-chief-says-ai-could-surpass-almost-all-humans-at-almost-everything-shortly-after-2027/

5.https://www.freethink.com/artificial-intelligence/agi-economy