Command Palette

Search for a command to run...

4200 Mal Schneller Als Herkömmliche Methoden! Die ETH Zürich Präsentiert NOBLE, Das Erste Neuronale Modellierungsframework, Das Mit Daten Der Menschlichen Hirnrinde Validiert wurde.

Wie das menschliche Gehirn kognitive Funktionen durch komplexe Schaltkreise aus Hunderten von Neuronen formt, ist nach wie vor ein tiefgreifendes und ungelöstes Rätsel der Lebenswissenschaften. Im letzten Jahrzehnt haben Wissenschaftler durch die Anhäufung multimodaler Daten aus Elektrophysiologie, Morphologie und Transkriptomik schrittweise die signifikante Heterogenität menschlicher Neuronen hinsichtlich Genexpression, morphologischer Struktur und elektrophysiologischer Eigenschaften aufgedeckt. Wie sich diese Unterschiede jedoch auf die Informationsverarbeitung des Gehirns auswirken – beispielsweise der intrinsische Zusammenhang zwischen spezifischer Genexpression und neurologischen Erkrankungen – bleibt eine offene Frage.

Traditionell verwenden Forscher Modelle, die auf dreidimensionalen partiellen Differentialgleichungen (PDEs) mit mehreren Kompartimenten basieren, um neuronale Aktivität zu simulieren. Obwohl diese Modelle die biologische Realität relativ gut wiedergeben können,Allerdings hat es einen entscheidenden Nachteil: Der Rechenaufwand ist extrem hoch.Die Optimierung eines einzelnen Neuronmodells kann etwa 600.000 CPU-Kernstunden in Anspruch nehmen, und selbst geringfügige Parameteränderungen können leicht zu erheblichen Abweichungen zwischen Simulationsergebnissen und experimentellen Daten führen. Noch wichtiger ist, dass diese deterministischen Modelle die in Experimenten beobachtete „intrinsische Variabilität“ nur schwer erfassen können; selbst bei gleichem Eingangssignal kann dasselbe Neuron unterschiedliche elektrophysiologische Reaktionen hervorrufen. Darüber hinaus führt die künstliche Einführung von Zufallselementen häufig zu nicht-mechanischen Störungen, was die Zuverlässigkeit der Modellvorhersagen weiter verringert.

Um diese Herausforderungen zu bewältigen, wurde ein gemeinsames Team von Institutionen wie der ETH Zürich, dem Caltech und der Universität von Alberta gebildet...Es wird ein Deep-Learning-Framework namens NOBLE (Neural Operator with Biologically-informed Latent Embeddings) vorgeschlagen.

Die Innovation dieses Rahmens liegt darin,Es handelt sich um das erste groß angelegte Deep-Learning-Framework, das seine Leistungsfähigkeit anhand experimenteller Daten aus der menschlichen Großhirnrinde validiert, und es ist das erste, das das direkte Lernen des nichtlinearen dynamischen Verhaltens von Neuronen aus experimentellen Daten erreicht.Der entscheidende Durchbruch besteht in der Konstruktion eines einheitlichen „neuronalen Operators“.Es kann den kontinuierlichen latenten Raum neuronaler Merkmale auf eine Reihe von Spannungsantworten abbilden, ohne für jedes Modell ein separates alternatives System trainieren zu müssen. In Tests mit dem Datensatz pvalbumin-positiver (PVALB) Neuronen reproduzierte NOBLE nicht nur präzise die Subthreshold- und Feuerungsdynamik von 50 bekannten und 10 unbekannten Modellen, sondern war auch 4.200-mal schneller als herkömmliche numerische Löser.

Die zugehörigen Forschungsergebnisse mit dem Titel „NOBLE – Neural Operator with Biologically-informed Latent Embeddings to Capture Experimental Variability in Biological Neuron Models“ wurden für die NeurIPS 2025 angenommen.

Papieradresse:

Folgen Sie unserem offiziellen WeChat-Konto und antworten Sie im Hintergrund mit „NOBLE“, um das vollständige PDF zu erhalten.

Weitere Artikel zu den Grenzen der KI:

https://hyper.ai/papers

Datensatz: Umfasst 60 HoF-Modelle, 250 Generationen evolutionärer Optimierung und 16 physiologische Indikatoren.

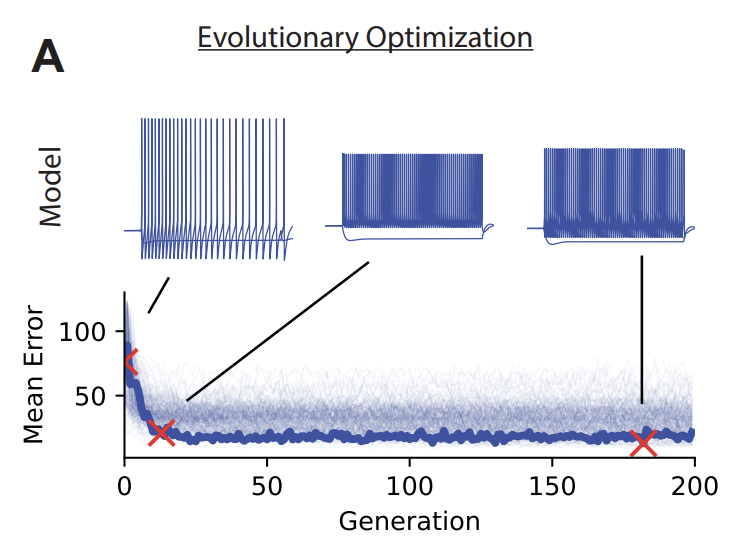

Um die Effektivität des NOBLE-Frameworks zu bestätigen, erstellte das Forschungsteam einen speziellen Datensatz mit Albumin-positiven (PVALB) Neuronen, der aus den Ergebnissen biorealistischer Modellsimulationen menschlicher kortikaler Neuronen abgeleitet wurde.Diese Modelle basieren auf der NEURON-Simulationsumgebung und verwenden eine „all active“-Ionenkanalkonfiguration.Das System wurde mithilfe eines evolutionären Mehrzieloptimierungsmodells generiert, mit dem Ziel, die in Experimenten aufgezeichneten elektrophysiologischen Eigenschaften zu reproduzieren.

Der Datensatz enthält insbesondere 60 HoF-Modelle, von denen 50 zum Training verwendet werden (In-Distribution-Modelle) und 10 als unbekannte Modelle zum Testen verwendet werden (Out-of-Distribution-Modelle).Wie in der Abbildung unten dargestellt, durchläuft jedes Modell 250 Generationen evolutionärer Optimierung, wobei Spannungsantworten aus verschiedenen Generationen erfasst werden. Anschließend werden die Kabelgleichungen durch räumliche Diskretisierung in ein System gekoppelter gewöhnlicher Differentialgleichungen transformiert. Schließlich wird die Parameterkombination ausgewählt, die den mittleren Z-Score-Fehler zwischen Simulations- und experimentellen Kennlinien minimiert.

Der Datengenerierungsprozess nutzt eine zweistufige Optimierungsstrategie: Zunächst wird das passive Unterschwellenverhalten angepasst, anschließend werden die aktive Dynamik und die vollständigen Frequenz-Strom-Kennlinien oberhalb der Spitzenschwelle erfasst. Die Zeitreihendaten werden über 515 ms mit einer Schrittweite von 0,02 ms abgetastet. Nach dreifacher Unterabtastung werden 8583 Zeitpunkte beibehalten, wodurch Aliasing-Effekte vermieden und der Rechenaufwand reduziert werden.

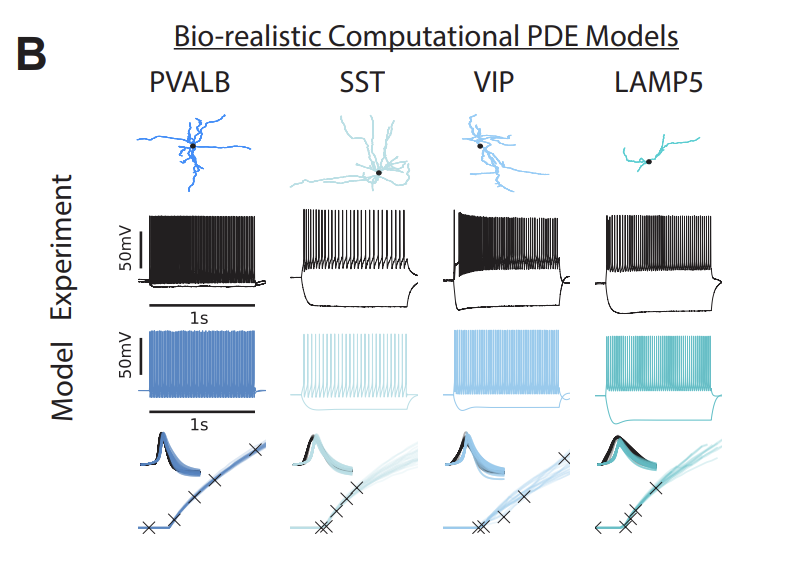

Wie in der folgenden Abbildung dargestellt, ist neben der Spannungsänderungskurve Folgendes zu sehen:Der Datensatz enthält außerdem Annotationen für 16 wichtige „physiologische Indikatoren“.Der Datensatz umfasst Darstellungsmuster (erste Zeile), experimentelle Spannungsverläufe (zweite Zeile), simulierte Spannungsverläufe (dritte Zeile), Spike-Wellenformen (vierte Zeile) und Frequenz-Strom-Kennlinien (fünfte Zeile) und bietet damit einen umfassenden Standard zur Bewertung von KI-Modellen. Dank dieses Aufbaus kann der Datensatz sowohl zum Trainieren von KI zur Vorhersage neuronaler Reaktionen als auch zur Bewertung der Vorhersagequalität genutzt werden, wodurch ein integrierter Ansatz für „Lehren, Trainieren und Testen“ erreicht wird.

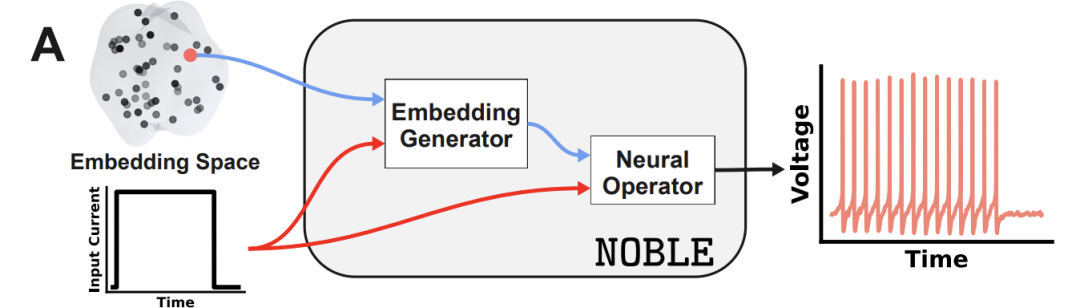

NOBLE: Ein neuronales Operator-Framework, das von FNO angetrieben wird und in duale Eingänge eingebettet ist.

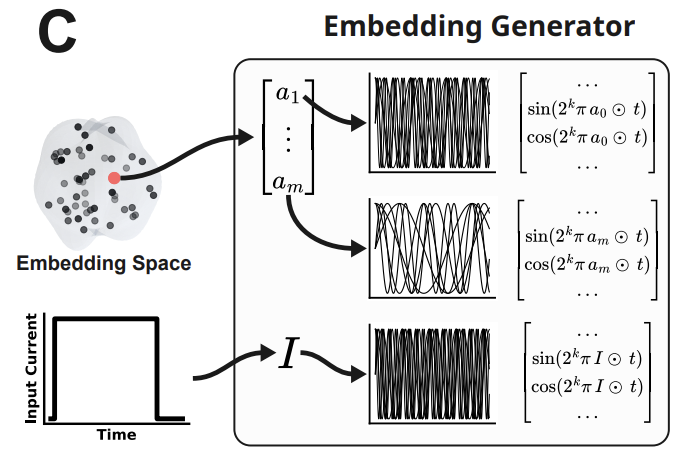

Die Kerninnovation des NOBLE-Frameworks liegt in der tiefen Integration neuronaler Operatoren mit potenziellen Einbettungstechniken in der Bioinformatik.Es wurde ein durchgängiges Mapping-System von neuronalen Merkmalen zu Spannungsantworten entwickelt, das man bildlich als „neuronalen Signalübersetzer“ bezeichnen kann. Dieses Framework nutzt Fourier-Neuronale Operatoren (FNO) als Grundlage und zeichnet sich durch seine Fähigkeit aus, raumzeitliche Sequenzdaten der neuronalen Elektrophysiologie effizient zu verarbeiten. FNO greift auf Konzepte der Audiosignalverarbeitung zurück und analysiert äquidistant abgetastete elektrophysiologische Signale im Frequenzbereich mittels schneller Fourier-Transformation. Dadurch wird es zu einem speziell für die Erforschung der neuronalen Dynamik entwickelten Computerwerkzeug.

Die „Übersetzungsfähigkeit“ des Modells beruht auf zwei zentralen Eingabe-Einbettungsdesigns: der Neuron-Feature-Einbettung und der Strominjektions-Einbettung.

Das erste Modell wählt zwei biologisch interpretierbare Indikatoren, Schwellenstrom (Ithr) und lokale Steigung (shr), als Kernmerkmale aus. Diese werden zunächst auf das Intervall [0,5; 3,5]² normiert und anschließend mithilfe trigonometrischer Funktionskodierung im NeRF-Stil in einen Zeitreihenstapel umgewandelt. Dadurch erhält das Modell im Wesentlichen ein „Hardware-Parameterhandbuch“ für Neuronen, das deren wichtigste elektrophysiologische Eigenschaften klar definiert. Das zweite Modell verwendet eine Mehrfrequenzkodierungsstrategie mit K=9, die den Eingangsstrom-Anregungsparametern entspricht. Wie in der Abbildung unten dargestellt, gleichen die beiden Sätze eingebetteter gestapelter Eingangskanäle die niedrigdimensionalen Merkmale effektiv mit der Frequenzbereichsverarbeitungsmethode von FNO ab und verbessern so die Fähigkeit des Modells, die Hochfrequenzdynamik neuronaler Signale zu erfassen, signifikant.

Hinsichtlich der Netzwerkstruktur enthält NOBLE 12 verborgene Schichten.Jede Schicht verfügt über 24 Kanäle und verwendet 256 Fourier-Moden, was zu etwa 1,8 Millionen Modellparametern führt – vergleichbar mit dem Aufbau einer simulierten neuronalen Verbindung derselben Größenordnung. Der Trainingsprozess nutzt eine Strategie des „personalisierten Lernens“: Durch die Verwendung des Adam-Optimierers mit einer anfänglichen Lernrate von 0,004, kombiniert mit der ReduceLROnPlateau-Scheduling-Strategie und dem relativen L4-Fehler als Verlustfunktion, kann das Modell die grundlegenden Prinzipien schnell erfassen und sein Lerntempo bei Trainingsengpässen automatisch anpassen. Im Vergleich zu herkömmlichen Methoden benötigt NOBLE kein separates Ersatzmodell für jedes Neuron; stattdessen erreicht es eine kontinuierliche Abbildung des gesamten neuronalen Modellraums durch einen einzigen neuronalen Operator. Dies ermöglicht die Generierung neuartiger neuronaler Reaktionen mit biologischer Realitätsnähe durch Interpolation des latenten Raums.

Darüber hinaus bietet NOBLE flexible Skalierbarkeit für „spezifische Verfeinerungen“ und unterstützt physikalisch fundierte Feinabstimmungen spezifischer elektrophysiologischer Merkmale. Durch die Einführung einer gewichteten zusammengesetzten Verlustfunktion L(λ) können Zielmerkmalen (wie der Sag-Amplitude) höhere Gewichte zugewiesen werden, wodurch die Modellgenauigkeit wichtiger Indikatoren präzise verbessert wird, ohne die Gesamtvorhersageleistung zu beeinträchtigen.

NOBLE erfasst vielfältige neuronale Dynamiken präzise und ist 4200 Mal schneller als herkömmliche Lösungsverfahren.

Um die Gesamtleistung des NOBLE-Frameworks systematisch zu bewertenDas Forschungsteam entwarf mehrdimensionale Experimente, die sich auf fünf Kernrichtungen konzentrieren: grundlegende Genauigkeit, Generalisierungsfähigkeit, Recheneffizienz, Innovationsgenerierungsfähigkeit und Wirksamkeitsprüfung der Kernmodule.Im Experiment wurden 50 HoF-Modelle von albuminpositiven (PVALB) Neuronen als Haupttrainingsdaten verwendet, und die Vorhersagegenauigkeit des Modells wurde durch den relativen L2-Fehler und mehrere wichtige elektrophysiologische Indikatoren quantifiziert.

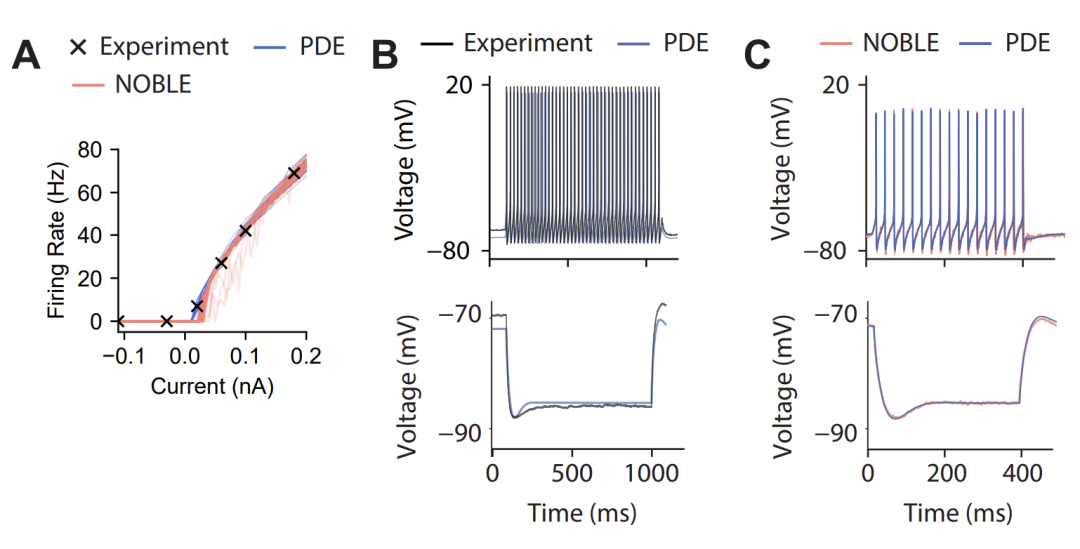

Hinsichtlich der grundlegenden Genauigkeit (Tests innerhalb der Verteilung),NOBLE zeigt weiterhin eine ausgezeichnete Vorhersagefähigkeit für nicht trainierte Strominjektionssignale mit einem relativen L2-Fehler von nur 2,18%. Wie in der Abbildung unten dargestellt, verglichen die Forscher zudem die Spannungsverläufe experimenteller Daten, PDE-Simulationen und NOBLE-Vorhersagen bei Strominjektionen von 0,1 nA und -0,11 nA. Die Ergebnisse zeigen eine hohe Übereinstimmung der PDE-Simulationen mit den experimentellen Daten, während die Abweichung zwischen NOBLE-Vorhersagen und PDE-Simulationen minimal ist. Dies deutet darauf hin, dass NOBLE die Genauigkeit des numerischen Lösers reproduziert und wichtige physiologische Dynamiken zuverlässig erfasst.

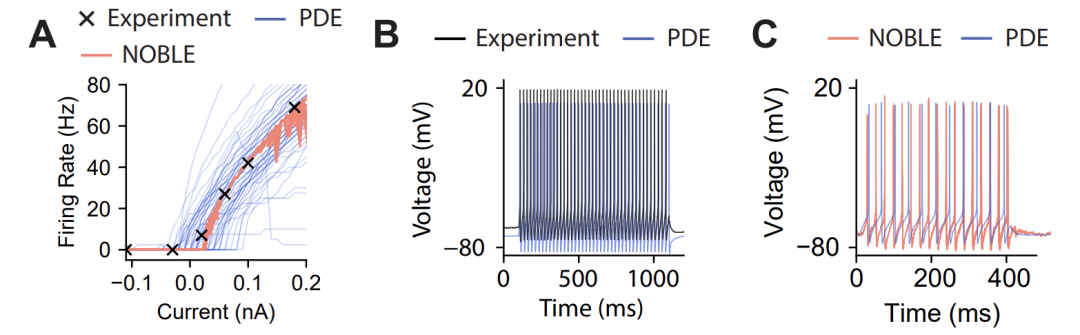

Bei der Beurteilung der Generalisierungsfähigkeit (Out-of-Distribution-Test),NOBLE behielt auch bei zehn unbekannten HoF-Modellen eine hohe Vorhersagegenauigkeit bei. Das Forschungsteam wandte es zudem auf Daten von Interneuronen des vasoaktiven intestinalen Peptids (VIP) an und erzielte ähnlich stabile Ergebnisse. Dies deutet darauf hin, dass NOBLE nicht einfach nur Merkmale des Trainingsdatensatzes auswendig lernt, sondern die elektrophysiologischen Gesetze zelltypübergreifend erfasst.

Im Hinblick auf die Recheneffizienz,NOBLE demonstriert einen bahnbrechenden Geschwindigkeitsvorteil. Testergebnisse zeigen, dass es eine einzelne Spannungstrajektorie in nur 0,5 Millisekunden vorhersagen kann, während herkömmliche numerische Löser für dieselbe Simulation 2,1 Sekunden benötigen. Dies entspricht einer Geschwindigkeitssteigerung um den Faktor 4200. Diese Effizienzsteigerung bildet die Grundlage für zukünftige Echtzeitsimulationen von Netzwerken mit Millionen von Neuronen und ermöglicht so die computergestützte Modellierung des gesamten Gehirns.

Im Hinblick auf die Innovationsfähigkeit,Das Forschungsteam konzentrierte sich auf die Validierung des Potenzials von NOBLE, neue neuronale Modelle zwischen bekannten neuronalen Merkmalen zu „interpolieren und zu erstellen“. Durch die zufällige Interpolation von 50 Punkten in einem latenten Raum bestehend aus (Ithr, sthr) generierte NOBLE erfolgreich die entsprechende Spannungsantworttrajektorie. Die Ergebnisse stimmten hochgradig mit realen experimentellen Daten überein und demonstrierten somit biologische Plausibilität. Im Gegensatz dazu erzeugen traditionelle Methoden, die Parameter partieller Differentialgleichungen direkt interpolieren, signifikante nicht-physiologische Artefakte und führen zu sogenannten „neuronalen Modellmonstern“. Dieser Vergleich verdeutlicht, dass NOBLE die zugrunde liegenden biophysikalischen Gesetze von Neuronen erlernt hat, anstatt lediglich Daten anzupassen. Weitere Validierungen durch Ensemble-Vorhersageexperimente zeigten, dass die durch parallele Inferenz basierend auf 50 trainierten Modellen generierte Spannungsverteilung hochgradig mit den Ergebnissen der numerischen Simulation übereinstimmte. Selbst bei einer Erweiterung der Abtastpunkte auf 200 behielt das generierte Modell seine biologische Plausibilität.

Experimente mit kontrollierten Variablen zeigten, dass nach dem Entfernen der neuronalen Merkmalskodierung der Vorhersagefehler von 2% auf 12% anstieg, was beweist, dass diese bioinformatische Einbettung der "Kernmotor" des Frameworks ist.

GitHub-Link: github.com/neuraloperator/noble

Die akademischen Durchbrüche und industriellen Anwendungen neuronaler Operatoren stehen in Wechselwirkung zueinander.

Die übergreifende Integration von neuronalen Operatoren und Neuronenmodellierung erzeugt eine tiefgreifende Resonanz in Wissenschaft und Industrie und treibt die Hirnforschung von der theoretischen Erkundung hin zur industriellen Anwendung voran.

An der Spitze der akademischen Forschung steht das Geometry-Aware Operator Transformation Framework (GAOT), das gemeinsam von der ETH Zürich und der Carnegie Mellon University entwickelt wurde und Multi-Scale-Aufmerksamkeitsmechanismen sowie geometrische Einbettungstechniken nutzt.Es durchbricht den Flaschenhals der Modellierung komplexer geometrischer Bereiche.Dieses Framework ermöglicht erstmals ein Training in voller Auflösung auf 9 Millionen Knotenpunkten mit industrietauglichen Daten und erzielt hervorragende Ergebnisse in Benchmark-Tests mit 28 partiellen Differentialgleichungen. Gleichzeitig verbessert es den Trainingsdurchsatz um das 501.030-fache und reduziert die Inferenzlatenz um das 151.030- bis 301.030-fache, wodurch der Weg für die präzise Simulation irregulärer neuronaler Schaltkreise geebnet wird.

Titel des Papers: Geometriebewusster Operatortransformator als effizienter und genauer neuronaler Ersatz für partielle Differentialgleichungen auf beliebigen Domänen

Link zum Artikel:https://arxiv.org/abs/2505.18781

Unterdessen hat das „miBrain“-Modell des MIT bedeutende Fortschritte beim Aufbau neuronaler Einheiten erzielt.Diese dreidimensionale Plattform integriert die sechs wichtigsten Zelltypen des menschlichen Gehirns.Die Funktion der neurovaskulären Einheit konnte mithilfe biomimetischer Hydrogele erfolgreich nachgebildet werden, und die synergistische Rolle von Gliazellen bei der Alzheimer-Krankheit wurde durch Genomeditierung aufgezeigt, wodurch eine physiologisch realistischere Verifikationsumgebung für neuronale Operatoren geschaffen wurde.

Titel der Publikation: Entwickeltes 3D-Immun-Glia-Neurovaskuläres menschliches miBrain-Modell

Link zum Artikel:https://doi.org/10.1073/pnas.2511596122

Die Industrie hingegen hat sich der Entwicklung und Anwendung wissenschaftlicher Erkenntnisse verschrieben. NVIDIAs Open-Source-Frameworks Modulus und PhysicsNeMo sind hierfür beispielhaft.Dies bildet die Grundlage für die praktische Anwendung neuronaler Operatoren und unterstützt Anwendungen in verschiedenen Bereichen, von den Lebenswissenschaften bis hin zur Ingenieursimulation.Es ermöglicht groß angelegte Trainings mit einem Netzwerk von 50 Millionen Knoten und wurde bereits von vielen Industrieunternehmen zum Aufbau digitaler Zwillinge eingesetzt.

Im Bereich medizinischer Anwendungen integrieren innovative Unternehmen neuronale Steuerungstechnologien eng mit klinischen Anforderungen. Das von Boling Brain-Computer Interface und der Zhejiang-Universität gemeinsam entwickelte Exoskelett-Rehabilitationssystem für die obere Extremität verbessert die Genauigkeit der motorischen Befehlsgenerierung durch optimierte Algorithmen zur neuronalen Signalverarbeitung. In multizentrischen klinischen Studien hat es bereits Patienten mit Halbseitenlähmung nach einem Schlaganfall geholfen, grundlegende Selbstversorgungsfähigkeiten wiederzuerlangen.

Diese kollaborative Innovation zwischen Wissenschaft und Industrie hat die Bildung eines vollständig geschlossenen Kreislaufs aus Grundlagenforschung, Technologietransfer und industrieller Anwendung beschleunigt. Ihre zentrale Bedeutung liegt in der organischen Verbindung von abstrakter Operatortheorie und konkretem Neuronenmodell, wodurch nicht nur die Recheneffizienz und der physiologische Realismus neuronaler Simulationen verbessert, sondern auch die Grenzen technischer Anwendungen erweitert werden.

Referenzlinks:

1.https://mp.weixin.qq.com/s/HWi9wNK3idpUSXCVN_nIZQ

2.https://mp.weixin.qq.com/s/YbqtmO0eU8Fn2Y-oRdBdWQ

3.https://mp.weixin.qq.com/s/UIi30fX81Xeh5dqBPxzMPQ