Command Palette

Search for a command to run...

Das Erste Multimodale Astronomische Modell, AION-1, Wurde Erfolgreich Entwickelt! Forscher Der University of California, Berkeley, Und Andere Haben Erfolgreich Ein Generalisierbares Multimodales Astronomisches KI-Framework Auf Der Grundlage Eines Vortrainings Mit 200 Millionen Astronomischen Objekten entwickelt.

Die auf der Transformer-Architektur basierenden fundamentalen Modelle haben tiefgreifende Veränderungen in Bereichen wie der Verarbeitung natürlicher Sprache und der Computer Vision bewirkt und die Technologie von einem maßgeschneiderten Paradigma („ein Modell für eine Aufgabe“) zu einer neuen Stufe der Generalisierung geführt. Wenn diese Modelle jedoch in die wissenschaftliche Forschung Einzug halten, stoßen sie auf erhebliche Herausforderungen. Wissenschaftliche Beobachtungsdaten stammen aus verschiedenen Quellen, weisen unterschiedliche Formate auf und enthalten häufig verschiedene Beobachtungsstörungen, was zu einer signifikanten „komplexen Heterogenität“ der Daten führt.Diese Realität stellt die wissenschaftliche Datenanalyse vor ein Dilemma:Wenn nur ein einziger Datentyp verarbeitet wird, ist es schwierig, sein volles Potenzial auszuschöpfen; wenn man sich auf ein manuell entworfenes multimodales Fusionsschema verlässt, ist es schwierig, sich flexibel an unterschiedliche Beobachtungsszenarien anzupassen.

Unter den vielen wissenschaftlichen Disziplinen bietet die Astronomie ein ideales Testfeld für solche Modelle. Ihre riesigen Mengen an öffentlich zugänglichen Beobachtungsdaten liefern reichlich „Nährstoffe“ für das Modelltraining; gleichzeitig sind ihre Beobachtungsmethoden äußerst vielfältig und umfassen verschiedene Ansätze wie Galaxienbildgebung, Sternspektroskopie und Astrophotometrie. Dieses multidimensionale Datenformat erfüllt naturgemäß die Anforderungen der multimodalen Technologieentwicklung.

Tatsächlich haben einige Studien versucht, multimodale Modelle der Astronomie zu entwickeln, doch diese Versuche weisen noch immer offensichtliche Einschränkungen auf: Die meisten konzentrieren sich auf einzelne Phänomene wie Supernova-Explosionen und stützen sich als Kerntechnologie auf „kontrastive Ziele“, was es den Modellen erschwert, flexibel mit beliebigen Kombinationen von Modi umzugehen und wichtige wissenschaftliche Informationen zwischen den Modi zu erfassen, die über oberflächliche Korrelationen hinausgehen.

Um diesen Engpass zu überwinden, arbeiteten Teams aus mehr als zehn Forschungseinrichtungen weltweit, darunter die University of California, Berkeley, die University of Cambridge und die University of Oxford, an dem Projekt zusammen.AION-1 (Astronomical Omni-modal Network), die erste groß angelegte multimodale Fundamentalmodellfamilie für die Astronomie, wurde gestartet.Durch die Integration und Modellierung heterogener Beobachtungsinformationen wie Bilder, Spektren und Sternkatalogdaten mittels eines einheitlichen frühen Fusions-Backbone-Netzwerks erzielt es nicht nur gute Ergebnisse in Zero-Shot-Szenarien, sondern seine lineare Detektionsgenauigkeit ist auch mit Modellen vergleichbar, die speziell für bestimmte Aufgaben trainiert wurden.

Die zugehörigen Forschungsergebnisse mit dem Titel „AION-1: Omnimodales Grundlagenmodell für die astronomischen Wissenschaften“ wurden in die NeurIPS 2025 aufgenommen.

Forschungshighlights:

* Vorschlag der AION-1-Modellfamilie, einer Reihe tokenbasierter multimodaler wissenschaftlicher Grundlagenmodelle mit Parameterskalen von 300 Millionen bis 3,1 Milliarden, die speziell für die Verarbeitung hochgradig heterogener astronomischer Beobachtungsdaten entwickelt wurden und beliebige modale Kombinationen unterstützen.

Es wurde eine maßgeschneiderte Tokenisierungsmethode entwickelt, die astronomische Daten aus verschiedenen Quellen und in unterschiedlichen Formaten in eine einheitliche Darstellung umwandeln kann, wodurch ein einziger, kohärenter Datenkorpus erstellt wird und häufig auftretende Probleme bei wissenschaftlichen Daten wie Heterogenität, Instrumentenrauschen und Quellenunterschiede effektiv überwunden werden.

* AION-1 erzielt bei einer Vielzahl wissenschaftlicher Aufgaben herausragende Ergebnisse. Selbst bei einfacher Vorwärtsanalyse erreicht es modernste Leistung (SOTA) und übertrifft überwachte Vergleichsmethoden in Szenarien mit geringer Datenmenge deutlich. Diese Eigenschaft ermöglicht es Forschern, es direkt und effizient ohne aufwendige Feinabstimmung einzusetzen.

* AION-1 bietet ein praktikables multimodales Modellierungsparadigma für die Astronomie und andere wissenschaftliche Bereiche, indem es zentrale Herausforderungen wie Datenheterogenität, Rauschen und Instrumentendiversität systematisch angeht.

Papieradresse:

https://openreview.net/forum?id=6gJ2ZykQ5W

Folgen Sie unserem offiziellen WeChat-Konto und antworten Sie im Hintergrund mit „AION-1“, um das vollständige PDF zu erhalten.

Weitere Artikel zu den Grenzen der KI:

https://hyper.ai/papers

AION-1 Vortrainingsgrundlage: MMU-Datensatz und Tokenisierungsschema für astronomische Daten verschiedener Typen

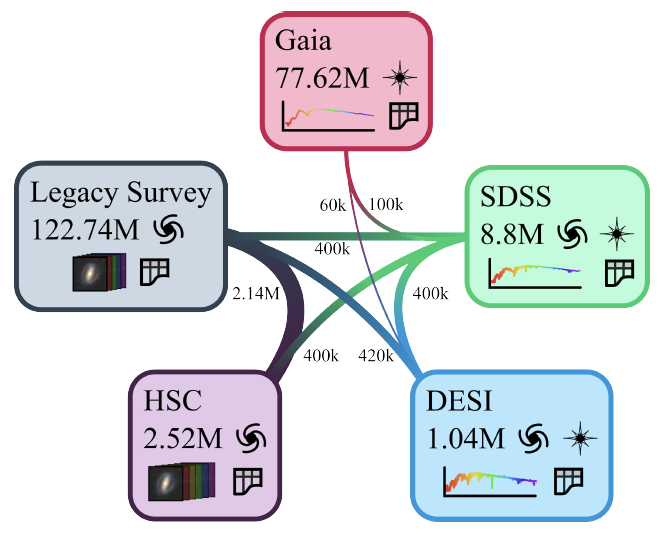

Das Vortraining von AION-1 basiert auf dem Multimodal Universe (MMU)-Datensatz.Wie in der folgenden Abbildung dargestellt, handelt es sich hierbei um eine Sammlung öffentlich verfügbarer astronomischer Daten, die speziell für maschinelle Lernaufgaben erstellt wurde und verschiedene Beobachtungsinformationen aus fünf großen Himmelsdurchmusterungsprojekten integriert.

Dies umfasst insbesondere: Galaxienbilder, die von der Supernova Camera (HSC) und dem Legacy Imaging Survey bereitgestellt werden; hochauflösende Spektren und entsprechende Entfernungsinformationen von Himmelsobjekten vom Dark Energy Spectroradiometer (DESI) und dem Sloan Digital Sky Survey (SDSS); und niedrigauflösende Spektren, die vom Gaia-Satelliten aufgezeichnet wurden und auch hochpräzise photometrische Daten und Positionsdaten von Sternen in der Milchstraße enthalten.

Um eine einheitliche Verarbeitung dieser Daten aus verschiedenen Quellen und Formaten zu erreichen, schlägt AION-1 ein universelles Tokenisierungsschema vor.Dieses Verfahren kann astronomische Daten in verschiedenen Formen, wie z. B. Bilder, Spektren und numerische Daten, in eine einheitliche Darstellung umwandeln, die das Modell erkennen und verarbeiten kann.Dies löst effektiv die zentrale Herausforderung der Vielfalt astronomischer Datenquellen und unterschiedlicher Formate. Der Tokenisierungsprozess verwendet für jeden Datentyp einen eigenen Konverter. Dadurch kann er sich an die Datenausgaben verschiedener Instrumente anpassen, die semantische Ausrichtung ähnlicher Daten gewährleisten und ein wiederholtes Modelltraining für denselben Datentyp aus verschiedenen Quellen vermeiden.

Für Mehrband-BilddatenUm die Unterschiede in Auflösung, Kanalanzahl, Wellenlängenabdeckung und Rauschpegel von Galaxienbildern auszugleichen, verwendet der Bildtokenisierer ein flexibles Kanaleinbettungsverfahren. Dieses Verfahren passt sich Eingaben mit variierender Kanalanzahl an und integriert Informationen wie den Ursprung des Teleskops in die Repräsentation. Das Kernnetzwerk basiert auf einer verbesserten ResNet-Struktur in Kombination mit einer Finite-Value-Quantisierungstechnik. Dadurch kann ein einzelnes Modell Bilddaten aus verschiedenen Beobachtungspipelines einheitlich verarbeiten. Während des Trainings verwendet das Modell eine Verlustbewertungsmethode, die Rauschgewichte berücksichtigt und bekannte Rauschinformationen aus dem Bildgebungsprozess optimal nutzt, um die Rekonstruktionsqualität zu verbessern.

Für SpektraldatenUnterschiede in Signalstärke, Wellenlängenbereich und Auflösung verschiedener Instrumente werden durch Standardisierung und Abbildung auf ein gemeinsames Wellenlängenraster ausgeglichen. Dies ermöglicht die gemeinsame Verarbeitung von Spektren mehrerer Instrumente und Ziele. Dieser Tokenizer, basierend auf der Netzwerkstruktur ConvNeXt V2, verwendet ein Quantisierungsverfahren ohne vordefinierte Codierung und nutzt eine gewichtete Rauschverlustfunktion zur Fusion der Rauscheigenschaften verschiedener Himmelsdurchmusterungen.

Bei der Verarbeitung tabellarischer/skalarer Daten,AION-1 verzichtet auf herkömmliche kontinuierliche Darstellungsmethoden, die sich nur schwer an große Zahlenbereiche anpassen lassen, und verwendet stattdessen eine stückweise Diskretisierungsstrategie, die auf Datenverteilungsstatistiken basiert. Diese Methode führt zu einer gleichmäßigeren Zahlenverteilung und minimiert Transformationsfehler in Bereichen mit hoher Informationsdichte.

Neben standardmäßigen photometrischen Bildern verfügt das Modell auch über einen speziellen Tokenizer für räumlich verteilte numerische Felddaten wie Segmentierungs- und Eigenschaftskarten. Er eignet sich für normalisierte Bilder mit Werten zwischen 0 und 1, basiert auf einem Faltungsnetzwerk, verwendet eine ähnliche Quantisierungstechnik wie Bildtokenizer und wird mit Graustufen-Galaxienbildern und den zugehörigen Segmentierungskarten trainiert.

Für elliptische Begrenzungsboxdaten, die für die Himmelspositionierung verwendet werden,Jedes Zielobjekt wird durch fünf Parameter beschrieben: Positionskoordinaten, Ellipsenform und Größe. Die Tokenisierung erfolgt durch Zuordnung der Koordinaten zum nächstgelegenen Pixel und Quantisierung der Ellipsenattribute. Um Fälle mit variabler Zielobjektanzahl im Bild zu behandeln, werden alle erkannten Ziele in eine Sequenz umgewandelt und nach ihrem Abstand vom Bildmittelpunkt sortiert. Dadurch entsteht eine einheitliche und standardisierte Darstellungsstruktur.

AION-1: Ein multimodales Fundamentalmodell für die astronomischen Wissenschaften

Die Architektur von AION-1 greift auf die Ideen aktueller Mainstream-Modelle der frühen Fusion multimodaler Modelle zurück und übernimmt insbesondere das skalierbare multimodale Maskierungsmodellierungsschema, das vom 4M-Modell (einem von Apple und der EPFL entwickelten multimodalen KI-Trainingsrahmen) vorgeschlagen wurde.Die Kernidee lautet:Nachdem alle Datentypen in eine einheitliche Token-Darstellung umgewandelt wurden, wird ein Teil des Inhalts zufällig maskiert. Anschließend lernt das Modell, den maskierten Teil wiederherzustellen. Auf diese Weise kann das Modell automatisch die inhärenten Beziehungen zwischen verschiedenen Datenformen wie Bildern, Spektren und numerischen Daten erkennen.

Speziell,Jede Trainingsstichprobe enthält M verschiedene Arten von Datensequenzen.Während des Trainings wählt das Modell zufällig zwei Teile aus: einen Teil als Eingabeinformation und den anderen Teil als zu rekonstruierendes Ziel. Da beide Teile zufällig aus dem gesamten Datensatz ausgewählt werden, kann das Modell die Merkmale jedes Datentyps erfassen und die Zusammenhänge zwischen verschiedenen Datentypen verstehen.

Hinsichtlich der technischen Umsetzung, wie in der folgenden Abbildung dargestellt,Der AION-1 verwendet eine Transformer-Encoder-Decoder-Architektur, die speziell für Multitasking entwickelt wurde.Neben Standard-Encodern und -Decodern besteht die Innovation des Modells in der Entwicklung einzigartiger Einbettungsmechanismen für jeden Datentyp. Für jeden Datentyp verfügt das Modell über eine dedizierte Transformationsfunktion, lernbare Typidentifikatorparameter und Positionsparameter.

Besonders hervorzuheben ist, dass das Modell jeder Kombination aus Datentyp und Datenquelle eine eindeutige Typkennung zuweist. Selbst innerhalb desselben Bilddatensatzes führen unterschiedliche Quellen von verschiedenen Aufnahmegeräten zu unterschiedlichen Kennungen. Dieses Design ermöglicht es dem Modell, die Quellmerkmale der Daten zu identifizieren, die oft implizit wichtige Attribute wie Datenqualität und Auflösung enthalten.

Die Trainingseffizienz eines Modells hängt maßgeblich von der geeigneten Auswahl der zu maskierenden Dateninhalte ab. Untersuchungen haben gezeigt, dass die im ursprünglichen 4M-Modell verwendete Sampling-Methode bei Daten unterschiedlicher Länge schlecht abschnitt und leicht eine große Anzahl ungültiger Trainingsbeispiele erzeugte. DaherAION-1 schlägt eine effizientere Vereinfachungsstrategie vor:Bei der Bestimmung des Eingabeinhalts wird zunächst eine Obergrenze festgelegt. Anschließend wird ein Datentyp zufällig ausgewählt und ein Teil seines Inhalts daraus extrahiert. Der verbleibende Inhalt wird durch Daten anderer Datentypen ergänzt. Um den zu rekonstruierenden Zielinhalt zu ermitteln, wird ein auf kleinere Skalen ausgerichtetes Stichprobenverfahren verwendet, um die Anzahl der benötigten rekonstruierten Datentypen zu bestimmen. Dieses Verfahren reduziert den Rechenaufwand pro Trainingsbeispiel und gewährleistet gleichzeitig die Konsistenz zwischen Trainingsprozess und realen Anwendungsszenarien.

Um die Leistungsfähigkeit des Modells umfassend zu bewerten, trainierte das Forschungsteam drei verschiedene Versionen von AION-1:Basisversion (300 Millionen Parameter), große Version (800 Millionen Parameter) und supergroße Version (3 Milliarden Parameter).Der AdamW-Optimierer wurde während des Trainings mit geeigneten Lernparametern über insgesamt 205.000 Trainingsschritte verwendet. Die Lernrate wurde zunächst erhöht und anschließend wieder verringert. Wie die Abbildung unten zeigt, verdeutlicht diese Studie den Einfluss unterschiedlicher Modellgrößen und der Einbeziehung von Gaia-Satellitendaten auf die Leistung und liefert somit eine Referenz für die nachfolgende Modellauswahl.

Nach vollständiger Schulung verfügt AION-1 über eine Vielzahl praktischer Generierungsfunktionen und unterstützt Aufgaben von der Datenvervollständigung bis zur geräteübergreifenden Datentransformation. Sein Hauptvorteil liegt in seiner Fähigkeit, die Zusammenhänge zwischen allen Datentypen zu verstehen und so auch mit nur unvollständigen Beobachtungsdaten andere Arten von Datenproben mit konsistenten physikalischen Eigenschaften zu generieren.

Experimentelle Ergebnisse: Die Genauigkeit der Rotverschiebung wurde um das 16-fache verbessert, was einen bedeutenden Durchbruch in der Leistungsfähigkeit multimodaler astronomischer KI darstellt.

Der Durchbruch von AION-1 liegt in seiner Fähigkeit, allgemeine Repräsentationen mit klarer physikalischer Bedeutung direkt und unabhängig vom Datentyp zu generieren, ohne auf komplexe, für spezifische Aufgaben entwickelte Überwachungsprozesse angewiesen zu sein. Dank dieses Mechanismus erzielt das Modell in zwei Schlüsselszenarien hervorragende Ergebnisse: der multimodalen Generierung und der skalaren A-posteriori-Schätzung.

Im Hinblick auf die multimodale Datengenerierung,AION-1 ermöglicht die bedingte Generierung hochdimensionaler Daten und unterstützt so effektiv die geräteübergreifende Datenkonvertierung und die Verbesserung der Beobachtungsqualität. Die repräsentativste Anwendung ist die Generierung hochauflösender DESI-Spektren aus niedrigauflösenden Gaia-Satellitendaten: Wie die Abbildung unten zeigt, kann das Modell trotz der 50- bis 100-fach höheren Datenstreuung der DESI-Daten die Spektrallinienzentren, -breiten und -amplituden präzise rekonstruieren. Dieser Fortschritt ermöglicht detaillierte astronomische Analysen auf Basis der weit verbreiteten niedrigauflösenden Daten.Dies ist von großer Bedeutung für die Senkung der Forschungskosten und die Verbesserung der Datennutzung.

Hinsichtlich der Parameterschätzung,AION-1 kann die Werteverteilung quantisierter Skalare direkt ableiten. Am Beispiel der Rotverschiebungsbestimmung (siehe Abbildung unten) ergeben sich für typische Galaxien unter drei Bedingungen mit steigendem Informationsgehalt folgende Ergebnisse: Bei Verwendung grundlegender photometrischer Daten ist die Verteilung relativ gestreut; sie konvergiert deutlich nach Hinzunahme von Mehrbandaufnahmen; und die Genauigkeit der Schätzung verbessert sich signifikant durch die weitere Einbeziehung hochauflösender Spektren. Dies zeigt, dass das Modell Informationen aus verschiedenen Quellen effektiv integrieren und so die Schätzergebnisse optimieren kann.

Um die Leistungsfähigkeit des Modells zu überprüfen,Das Forschungsteam führte außerdem Experimente in vier Richtungen durch:

* Schätzung physikalischer Eigenschaften

Für Parameter wie Sternmasse und Oberflächentemperatur, deren Bestimmung typischerweise hochauflösende Beobachtungen erfordert, untersucht diese Studie die Anwendung von AION-1 zur direkten Schätzung dieser Parameter aus niedrigauflösenden Daten. Tests an 120.000 Galaxienproben zeigen, dass das Modell dedizierte, überwachte Modelle übertrifft oder mit ihnen gleichzieht; in Tests an 240.000 Sternproben übertrifft es sogar speziell optimierte Basismodelle bei der Aufgabe, „hochauflösende Parameter auf Basis niedrigauflösender Gaia-Daten vorherzusagen“.

* Semantisches Lernen auf Basis von Expertenannotationen (Lernen aus semantischen menschlichen Bezeichnungen)

Bei der Klassifizierung der Galaxienmorphologie (8.000 annotierte Beispiele) übertrifft die Genauigkeit von AION-1 nicht nur die von eigens dafür trainierten Modellen, sondern erreicht auch die von hochmodernen Modellen, die mit einem Vielfachen annotierter Daten trainiert wurden. Bei der semantischen Segmentierung der Galaxienstruktur (2.800 Beispiele) stimmen die generierten Ergebnisse weitgehend mit manuell annotierten Daten überein, und die Leistung übertrifft die einfacher, vollständig konvolutioneller Vergleichsmodelle.

* Leistung bei geringer Datenmenge

Experimente zur Bewältigung des häufig auftretenden Problems der spärlichen Annotationen in der astronomischen Forschung zeigen, dass AION-1 einen deutlicheren Vorteil hat, wenn die Daten begrenzt sind, und dass seine Leistung mit überwachten Modellen mithalten oder diese sogar übertreffen kann, die eine Größenordnung mehr Trainingsdaten benötigen.

* Ähnlichkeitsbasierte Suche

Angesichts der Herausforderungen seltener Himmelsobjekte wie starker Gravitationslinsen (die etwa 0,11 TP3T ausmachen) und eines Mangels an ausreichenden Annotationen zeigt AION-1 eine überlegene Leistung in drei Kategorien von Zielen – Spiralgalaxien, verschmelzende Galaxien und Kandidaten für starke Linsen – durch die räumliche Ähnlichkeitsabfrage und übertrifft andere fortgeschrittene selbstüberwachte Modelle in den Abfrageergebnissen.

Diese experimentellen Ergebnisse zeigen insgesamt, dass AION-1 eine einheitliche und effiziente Lösung für die multimodale astronomische Datenanalyse bietet und insbesondere in Szenarien mit wenigen Daten und multimodaler Inferenz deutliche Vorteile aufweist.

Multimodale KI ermöglicht astronomische Forschung und führt zu bahnbrechenden gemeinsamen Entdeckungen zwischen Wissenschaft und Industrie.

In den letzten Jahren ist die „multimodale KI-gestützte astronomische Forschung“ in den Fokus der globalen akademischen und industriellen Gemeinschaften gerückt, und eine Reihe bahnbrechender Errungenschaften verändern die Verarbeitung und Anwendung astronomischer Daten grundlegend.

In der akademischen Forschung widmen sich Wissenschaftler der engen Verknüpfung multimodaler Fusionsverfahren mit spezifischen astronomischen Fragestellungen. Ein Beispiel hierfür ist der vom MIT Media Lab im Jahr 2025 angekündigte Weltraumforschungsplan…Durch die Kombination multimodaler KI mit erweiterter Realitätstechnologie wurde ein intelligentes Analysesystem für Mondaufenthaltsmissionen entwickelt.Dieses System kann Informationen aus verschiedenen Quellen integrieren, wie z. B. Satellitenfernerkundungsbilder, Messwerte von Umweltsensoren und den Betriebszustand von Geräten, um in Echtzeit Entscheidungshilfen für das Ressourcenmanagement und die Risikowarnung einer simulierten Mondbasis bereitzustellen.

Unterdessen hat ein Forschungsteam der Universität Oxford und anderer Institutionen ein auf Deep Learning basierendes Screening-Tool entwickelt, das aus Tausenden von Datenalarmen präzise gültige Signale von Supernova-Explosionen identifizieren kann. Dadurch reduziert sich die Datenmenge, die Astronomen verarbeiten müssen, um etwa 851 TP3T.Dieser virtuelle Forschungsassistent benötigt lediglich 15.000 Trainingsbeispiele und die Rechenleistung eines normalen Laptops, um das Training abzuschließen.Der routinemäßige manuelle Screening-Prozess wurde in einen automatisierten Arbeitsablauf umgewandelt. Das finale Modell behielt eine hohe Genauigkeit bei und hielt die Falschalarmrate bei etwa 1%, wodurch die Forschungseffizienz deutlich gesteigert wurde.

Titel des Papiers:Der virtuelle Forschungsassistent von ATLAS

Link zum Artikel:https://iopscience.iop.org/article/10.3847/1538-4357/adf2a1

Die Branche fördert den praktischen Einsatz multimodaler KI im Bereich der Astronomie durch Produktisierung.Im Jahr 2024 ging NVIDIA eine Partnerschaft mit der Europäischen Südsternwarte (ESO) ein, um seine KI-basierte Inferenzoptimierungstechnologie in den Workflow der Spektraldatenverarbeitung des Very Large Telescope zu integrieren.Durch die Nutzung von TensorRT zur Beschleunigung multimodaler Fusionsmodelle konnte die Effizienz der Spektralklassifizierung ferner Galaxien um bis zu das Dreifache verbessert werden.

Im Jahr 2025 arbeitete IBM mit der ESO zusammen, um das VLT-Planungssystem (Virtual Lightning Observation) mithilfe multimodaler KI zu optimieren. Durch die Integration verschiedener Informationen wie Wettervorhersagen, Änderungen der Himmelshelligkeit und Geräteauslastung kann das System Beobachtungspläne dynamisch anpassen.Dies erhöht die Erfolgsrate beim Aufnehmen von Zeitbereichszielen wie veränderlichen Sternen durch 30%.

Darüber hinaus entwickelte Google DeepMind in Zusammenarbeit mit LIGO und GSSI eine Regelungsmethode namens „Deep Loop Shaping“, um die Regelungsgenauigkeit von Gravitationswellendetektoren zu verbessern. Dieser Regler wurde an einem realen LIGO-System validiert, und seine tatsächliche Leistung stimmte weitgehend mit den Simulationsergebnissen überein. Im Vergleich zum ursprünglichen SystemDie neue Technologie verbessert die Geräuschdämpfung um das 30- bis 100-fache.Und zum ersten Mal wurde die instabilste und am schwierigsten zu unterdrückende Rückkopplungsschleifen-Rauschquelle im System vollständig eliminiert.

Titel des Papiers:Verbesserung der kosmologischen Reichweite eines Gravitationswellenobservatoriums durch Deep Loop Shaping

Papieradresse:https://www.science.org/doi/10.1126/science.adw1291

Es ist offensichtlich, dass die Entwicklung multimodaler allgemeiner Repräsentationen zu einem klaren Trend an der Schnittstelle von Astronomie und künstlicher Intelligenz geworden ist. Die Wissenschaft verfeinert die Kerntechnologie kontinuierlich durch die Erforschung wissenschaftlicher Fragestellungen, während die Industrie ihre Ingenieurskompetenz nutzt, um die Implementierung und großflächige Anwendung der Technologie voranzutreiben. Dieser kollaborative Fortschritt überwindet schrittweise die traditionellen Beschränkungen kostenintensiver Beobachtungen und komplexer Datenverarbeitung in der astronomischen Forschung und ermöglicht es mehr Forschern, mithilfe künstlicher Intelligenz die tieferen Geheimnisse des Universums zu erforschen.

Referenzlinks:

1.https://www.media.mit.edu/groups/space-exploration/updates/

2.https://www.eso.org/public/news/eso2408/

3.https://www.eso.org/public/news/eso2502/