Command Palette

Search for a command to run...

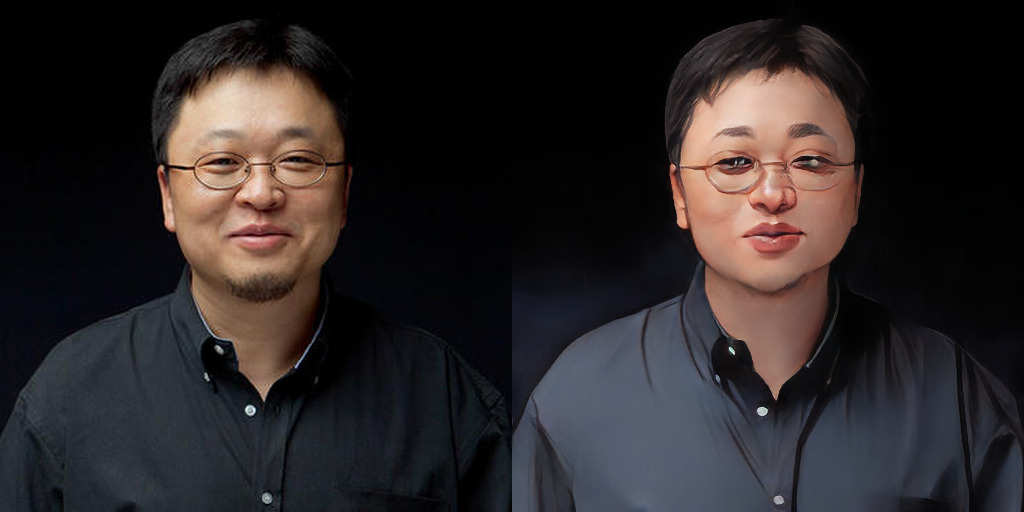

アニメ スタイルの移行 AnimeGANv2、オンライン実行デモをリリース

AnimeGANv2 は最近、コミュニティの貢献者によって開発されたアップデートをリリースしました。オンラインで実行できるデモを Gradio で実装し、huggingface で公開しました。

アクセス https://huggingface.co/spaces/akhaliq/AnimeGANv2

AnimeGANv2の処理効果をオンラインで簡単に実現できます(静止画処理のみ対応)。

AnimeGAN: 3次元コミュニケーションが2つになる

AnimeGAN は CartoonGAN をベースに改良されたもので、より軽量なジェネレーター アーキテクチャを提案しています。2019 年に AnimeGAN が初めてオープンソース化されたとき、その驚異的な結果により激しい議論が巻き起こりました。

初版発売時の紙 「AnimeGAN: 写真アニメーション用の新しい軽量 GAN」様式化されたアニメーションの視覚効果を改善するために、3 つの新しい損失関数も提案されています。

3 つの損失関数は次のとおりです。グレースケール スタイルの損失、グレースケールの敵対的損失、色の再構築の損失。

昨年 9 月にリリースされた AnimeGANv2 は、モデル効果を最適化し、AnimeGAN の初期バージョンにあったいくつかの問題を解決しました。

v2では、新海誠氏、宮崎駿氏、今敏氏の3人の漫画家による漫画風の学習データセットも追加されました。

Muskを例に挙げると、AnimeGANの初代の効果はすでに素晴らしいですが、韓国のボーイズバンドのメンバーのように公平すぎてヤンデレです。それに比べて、v2 はより自然で、実際の音律により一致しています。

AnimeGANv2 の更新ハイライト:

– 生成された画像の高周波アーティファクトの問題を解決しました。

– v2 はトレーニングが簡単で、論文で説明されている効果を直接実現できます。

– ジェネレータネットワークのパラメータの数をさらに削減します。 (ジェネレーターサイズ 8.17Mb);

– 高画質画像データを追加します。

プロジェクト情報

TensorFlow バージョンの環境構成要件

- Python 3.6

- テンソルフローGPU

- tensorflow-gpu 1.8.0 (ubuntu、GPU 1080Ti または Titan XP、cuda 9.0、cudnn 7.1.3)

- tensorflow-gpu 1.15.0 (ubuntu、GPU 2080Ti、cuda 10.0.130、cudnn 7.6.0)

- opencv

- tqd

- しびれる

- グロブ

- 引数解析

PyTorchの実装

重量換算

git clone https://github.com/TachibanaYoshino/AnimeGANv2

python convert_weights.py推論

python test.py --input_dir [image_folder_path] --device [cpu/cuda]壁の中のコラボ

プロジェクトGitHub

https://github.com/TachibanaYoshino/AnimeGANv2

オンラインデモ

https://huggingface.co/spaces/akhaliq/AnimeGANv2

壁の中のコラボ

https://openbayes.com/console/open-tutorials/containers/pROHrRgKItf