Command Palette

Search for a command to run...

Tutoriel En Ligne | L'outil De Traduction Client Open Source Hunyuan De Tencent (HY-MT1.5, Modèle 1.8B) Ne Nécessite Que 1 Go De mémoire.

Dans le domaine de la traduction automatique, les modèles traditionnels à hautes performances sont souvent confrontés à deux défis majeurs. Pour les langues courantes, les modèles commerciaux propriétaires offrent des résultats exceptionnels, mais leur mise en œuvre est coûteuse : leurs paramètres atteignent souvent des dizaines de milliards, ce qui exige une puissance de calcul considérable et les rend difficiles à déployer sur des appareils grand public tels que les téléphones mobiles. Par ailleurs, pour les langues moins répandues, où les données sont rares, et pour les textes contenant une terminologie spécialisée et des expressions culturelles spécifiques, la qualité de la traduction automatique est souvent médiocre, sujette à des illusions ou à des biais sémantiques. Les utilisateurs sont ainsi confrontés au dilemme de choisir entre des services cloud de haute qualité et onéreux et des solutions localisées et légères, mais moins performantes au quotidien et sur mobile.

Sur cette base,L'équipe Hunyuan de Tencent a récemment rendu public son nouveau modèle de traduction, HY-MT1.5.Cette version open-source comprend deux versions avec des échelles de paramètres différentes : Tencent-HY-MT1.5-1.8B, conçue spécifiquement pour les appareils mobiles, et Tencent-HY-MT1.5-7B, destinée aux scénarios hautes performances.Il prend en charge la traduction mutuelle entre 33 langues et entre 5 langues/dialectes minoritaires chinois et le chinois mandarin.Outre les langues courantes telles que le chinois, l'anglais et le japonais, il couvre également plusieurs langues moins répandues comme le tchèque et l'islandais.

* HY-MT1.5-1.8B :

Après quantification, le modèle ne nécessite qu'environ 1 Go de mémoire pour fonctionner de manière fluide sur les appareils mobiles et prend en charge la traduction hors ligne en temps réel. Il affiche une efficacité remarquable, traitant 50 jetons en seulement 0,18 seconde en moyenne. Sur des jeux de données de référence tels que Flores200, ses performances surpassent largement celles des modèles open source de taille moyenne et des API commerciales courantes, atteignant le 90e percentile des meilleurs modèles propriétaires.

* HY-MT1.5-7B :

Ce modèle est une version améliorée de celui qui a permis à Tencent de remporter 30 championnats de langues lors du concours international de traduction WMT25. Il vise à améliorer la précision des traductions et à réduire considérablement les problèmes liés aux annotations non pertinentes et au mélange des langues.

L'innovation de HY-MT1.5 réside dans sa solution technique unique qui résout efficacement la contradiction entre « déploiement léger » et « traduction de haute précision ». Elle utilise une stratégie de « distillation sur la stratégie », où un modèle 7B plus puissant joue le rôle de « professeur », guidant en temps réel un modèle « élève » de 1,8 milliard de mots pendant l'entraînement afin de corriger ses biais de prédiction. Ainsi, le modèle plus petit apprend de ses erreurs au lieu de simplement mémoriser. Il peut ainsi atteindre des capacités de traduction bien supérieures à sa propre taille.

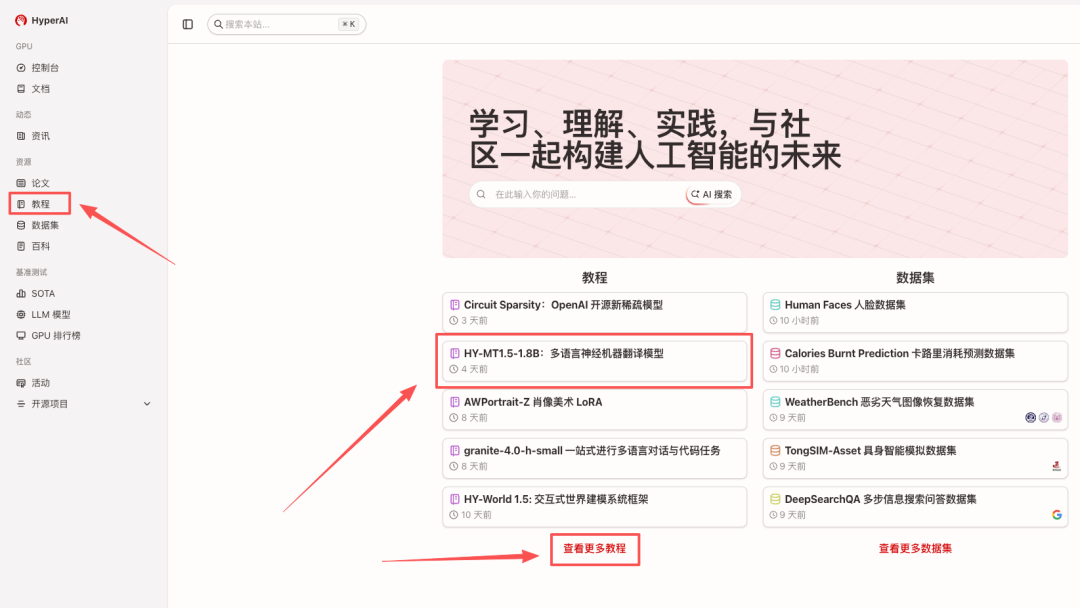

Le modèle de traduction automatique neuronale multilingue « HY-MT1.5-1.8B » est désormais disponible dans la section tutoriels du site web HyperAI (hyper.ai). Venez découvrir ses performances de traduction ultra-rapides !

HyperAI offre également des avantages en matière de puissance de calcul à tous.Les nouveaux utilisateurs peuvent obtenir 2 heures de temps d'utilisation de la carte graphique NVIDIA GeForce RTX 5090 en utilisant le code de réduction « HY-MT » après leur inscription.Quantités limitées, commandez le vôtre dès maintenant !

Exécutez en ligne :https://go.hyper.ai/I0pdR

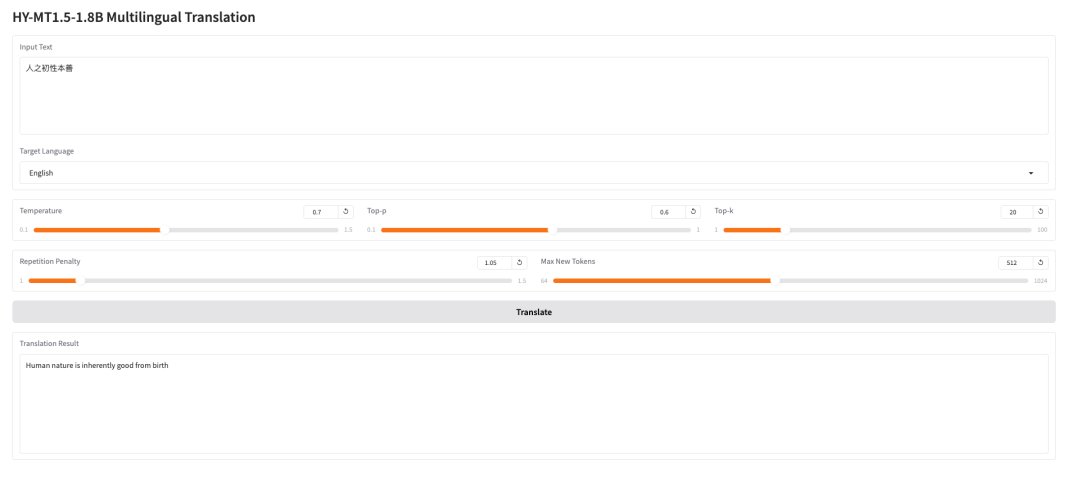

Essai de démonstration

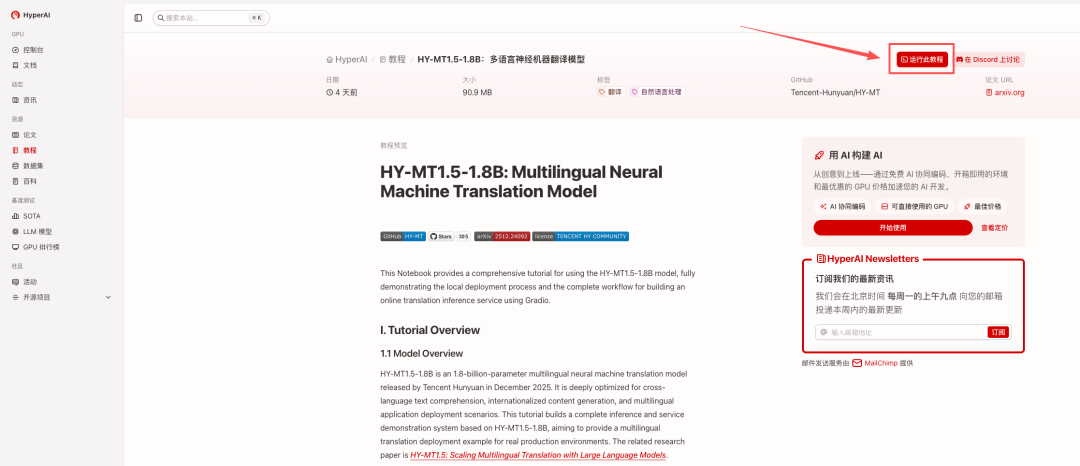

1. Sur la page d'accueil d'hyper.ai, sélectionnez « HY-MT1.5-1.8B : Modèle de traduction automatique neuronale multilingue » ou depuis la page « Tutoriels ». Une fois la page redirigée, cliquez sur « Exécuter ce tutoriel en ligne ».

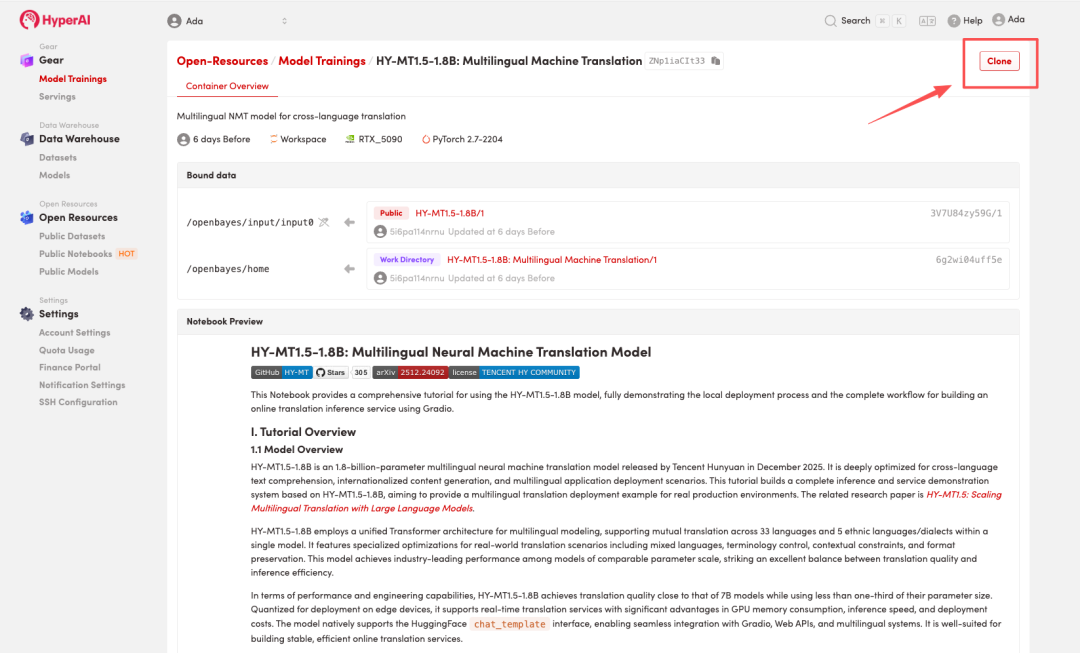

2. Une fois la page affichée, cliquez sur « Cloner » dans le coin supérieur droit pour cloner le didacticiel dans votre propre conteneur.

Remarque : Vous pouvez changer de langue en haut à droite de la page. Actuellement, le chinois et l’anglais sont disponibles. Ce tutoriel présente les étapes en anglais.

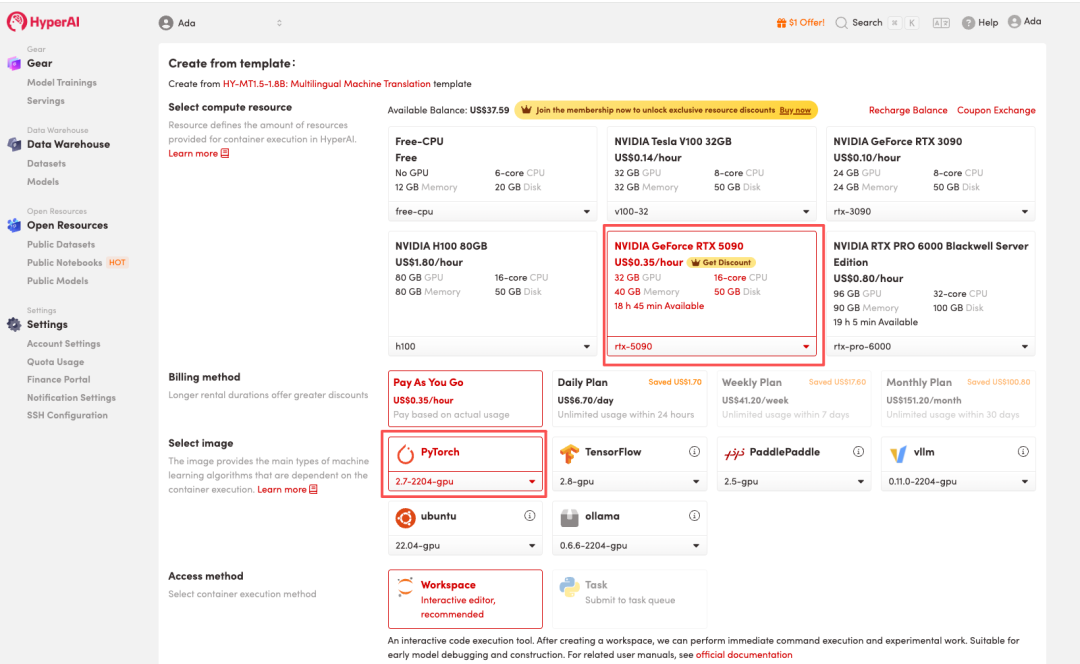

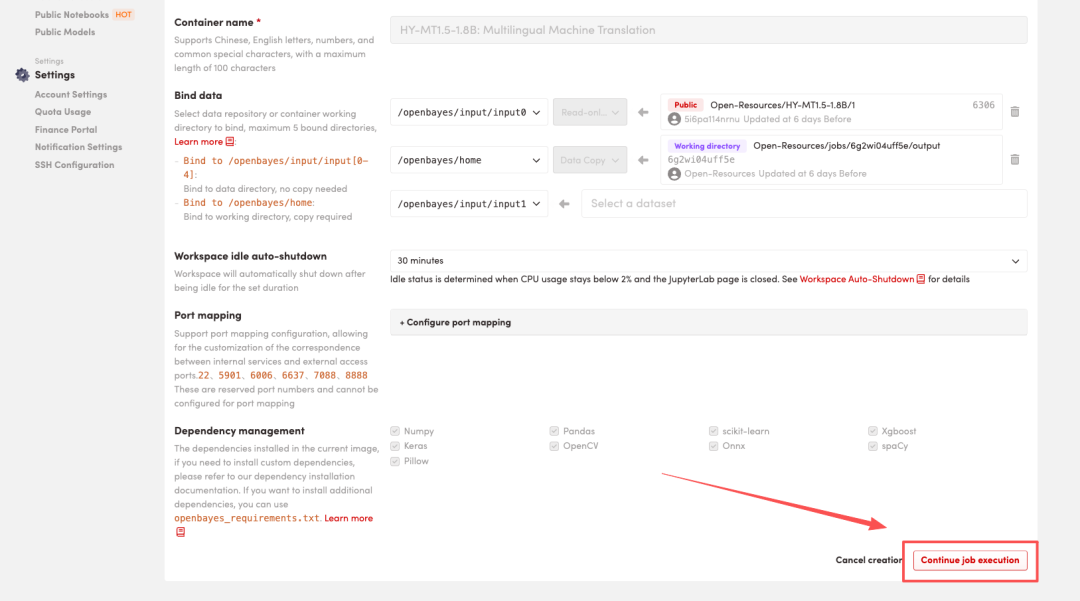

3. Sélectionnez les images « NVIDIA GeForce RTX 5090 » et « PyTorch », puis choisissez « Pay As You Go » ou « Daily Plan/Weekly Plan/Monthly Plan » selon vos besoins, puis cliquez sur « Continuer l’exécution de la tâche ».

HyperAI propose un bonus d'inscription pour les nouveaux utilisateurs : pour seulement $1, vous pouvez obtenir 20 heures de puissance de calcul RTX 5090 (au lieu de $7), et les ressources sont valables indéfiniment.

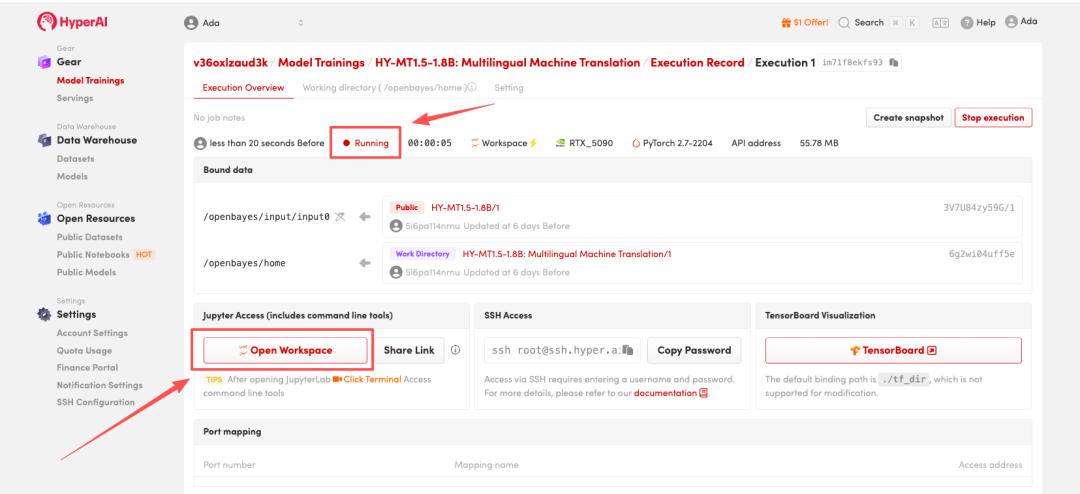

4. Attendez que les ressources soient allouées. Une fois que le statut passe à « En cours d'exécution », cliquez sur « Ouvrir l'espace de travail » pour accéder à l'espace de travail Jupyter.

Démonstration d'effet

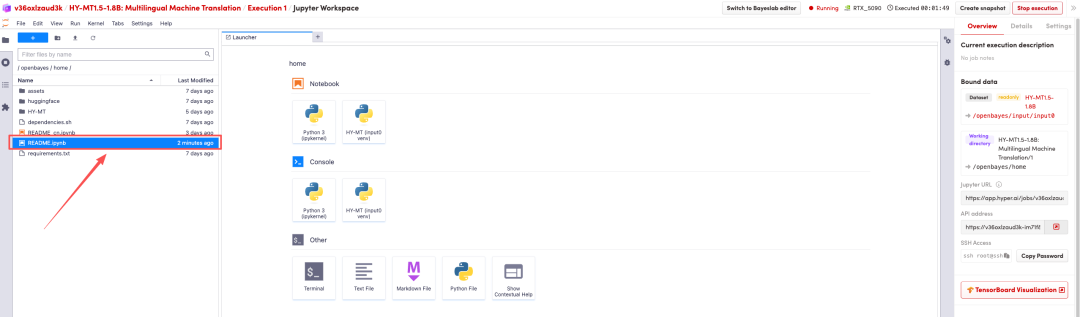

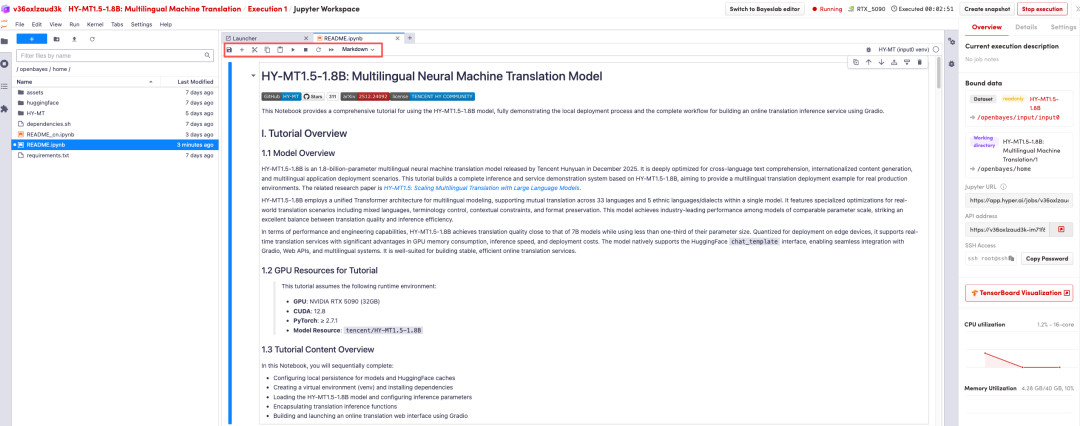

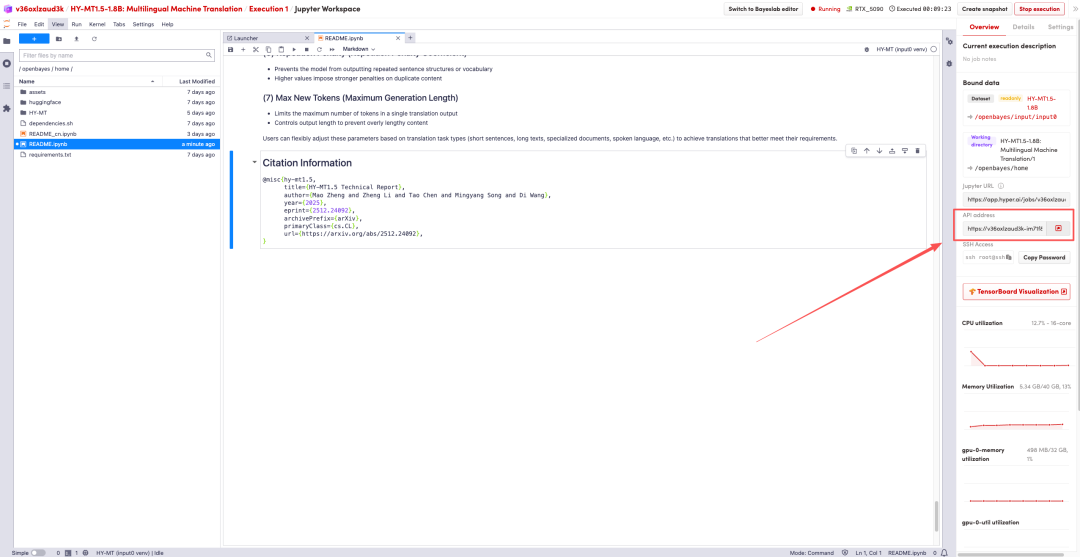

Une fois la page redirigée, cliquez sur le fichier README à gauche, puis sur « Exécuter » en haut.

Une fois le processus terminé, cliquez sur l'adresse de l'API à droite pour accéder à la page de démonstration.

Le tutoriel ci-dessus est celui recommandé par HyperAI cette fois-ci. Bienvenue à tous pour le découvrir !

Lien du tutoriel :https://go.hyper.ai/I0pdR