Command Palette

Search for a command to run...

Revue Hebdomadaire Des Articles Sur l'IA | Mécanisme d'attention / Modèle NVIDIA VLA / Modèle TTS / Réseaux Neuronaux Graphiques… Un Aperçu Complet Des Dernières Avancées En IA

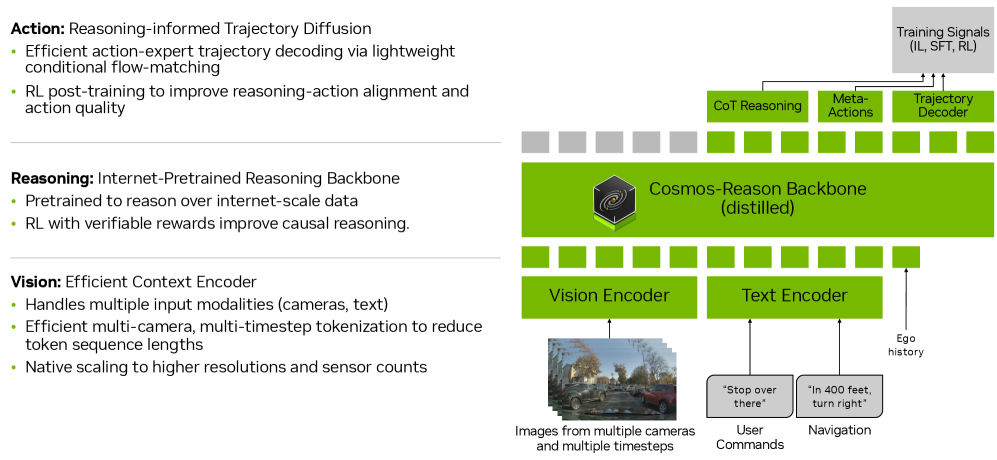

Les modèles de langage visuel (MLV) et les architectures de langage visuel (ALV) sont largement utilisés dans le domaine de la conduite autonome. Cependant, la plupart des méthodes existantes présentent des limitations évidentes : soit elles manquent de mécanismes de raisonnement explicites, soit elles effectuent un raisonnement libre et non structuré, ce qui rend difficile la généralisation des modèles au-delà des données d’entraînement.

Nvidia a présenté Alpamayo-R1 (AR1), un modèle vision-action (VA) doté de capacités de raisonnement structuré. Étendant le modèle Alpamayo-VA précédemment proposé, AR1 améliore la prise de décision dans des scénarios de conduite complexes en associant raisonnement et prédiction d'actions, contribuant ainsi à la conduite autonome générale. En combinant un raisonnement interprétable à un contrôle précis, AR1 ouvre la voie à une conduite autonome de niveau 4.

Lien vers le document:https://go.hyper.ai/Q15y9

Derniers articles sur l'IA:https://go.hyper.ai/hzChC

Afin de permettre à davantage d'utilisateurs de connaître les derniers développements dans le domaine de l'intelligence artificielle dans le milieu universitaire, le site Web officiel d'HyperAI (hyper.ai) a désormais lancé une section « Derniers articles », qui met à jour quotidiennement les articles de recherche de pointe sur l'IA.Voici 5 articles populaires sur l'IA que nous recommandons, jetons un coup d’œil rapide aux réalisations de pointe en matière d’IA de cette semaine⬇️

Recommandation de papier de cette semaine

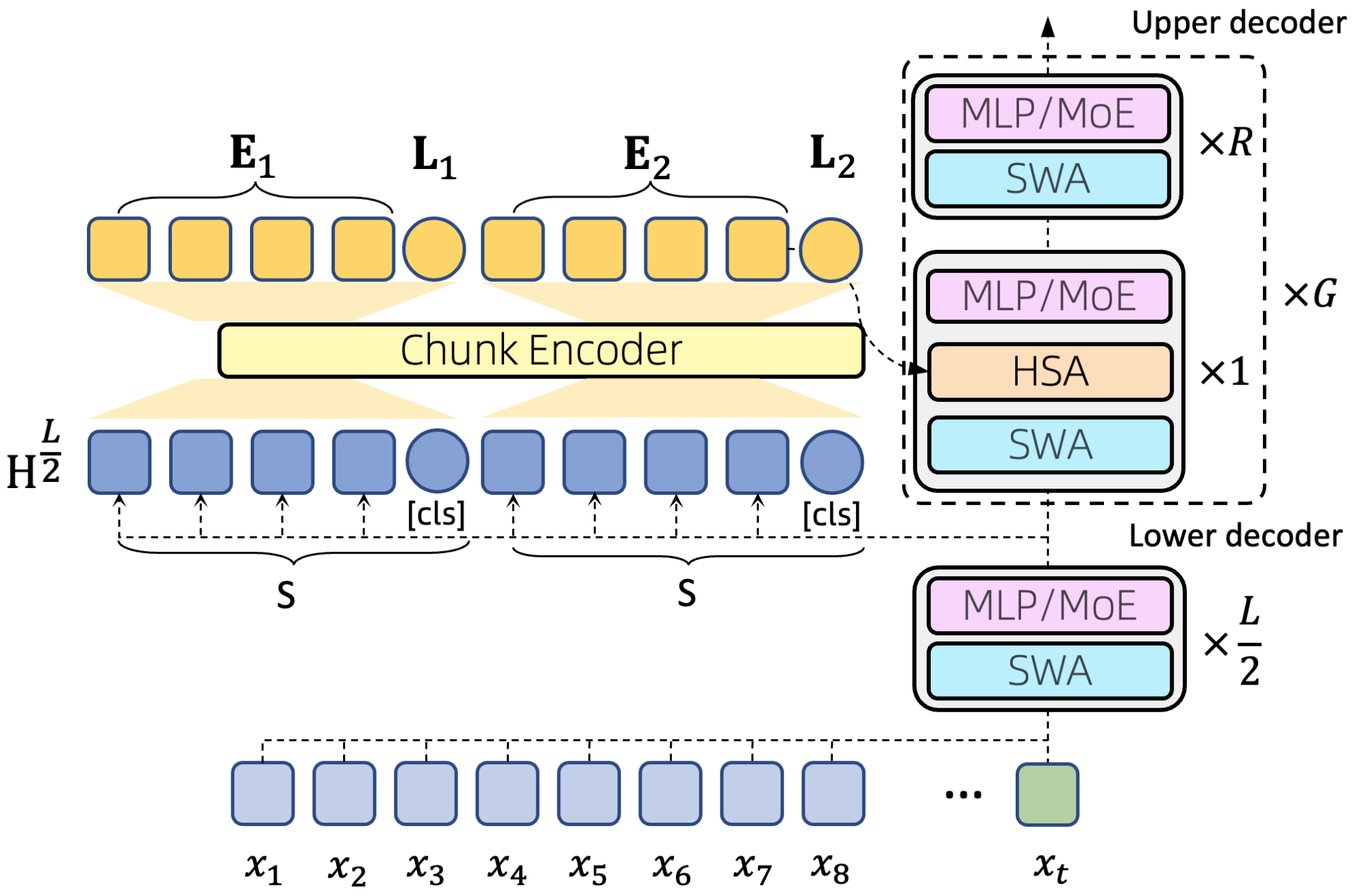

1. Chaque jeton compte : généralisation d’un contexte ultra-long de 16 millions de caractères dans de grands modèles de langage

Cet article explore le défi que représente la construction de « machines à se souvenir », en définissant le problème de la mémoire à long terme comme celui de la modélisation efficace de contextes extrêmement longs. Les chercheurs affirment que la réalisation de cet objectif requiert trois propriétés clés : la parcimonie, la flexibilité d'accès aléatoire et la capacité de généralisation de la longueur. Pour relever le défi de la modélisation de contextes extrêmement longs, cet article introduit un nouveau mécanisme d'attention – l'Attention Hiérarchique Parcimonieuse (HSA) – qui satisfait simultanément ces trois propriétés. En intégrant HSA à l'architecture Transformer, les chercheurs ont construit un modèle expert hybride (MoE), HSA-UltraLong, comportant 8 milliards de paramètres.

Lien vers l'article :https://go.hyper.ai/axKy6

2. Alpamayo-R1

Titre : Alpamayo-R1 : Faire le lien entre le raisonnement et la prédiction d’actions pour une conduite autonome généralisable dans les zones à faible trafic.

Cet article propose Alpamayo-R1 (AR1), un modèle vision-langage-action (VLA) intégrant le raisonnement causal et la planification de trajectoire afin d'améliorer la prise de décision dans des scénarios de conduite complexes. Les résultats d'évaluation montrent que, comparé à un modèle de référence basé uniquement sur la trajectoire, ce modèle améliore la précision de la planification jusqu'à 121 TP3T dans des scénarios complexes ; lors de simulations en boucle fermée, le véhicule s'écarte de la route de 351 TP3T et le taux de collisions rapprochées diminue de 251 TP3T. En combinant un raisonnement interprétable et un contrôle précis, AR1 offre une voie technique viable vers la conduite autonome de niveau 4.

Lien vers l'article :https://go.hyper.ai/Q15y9

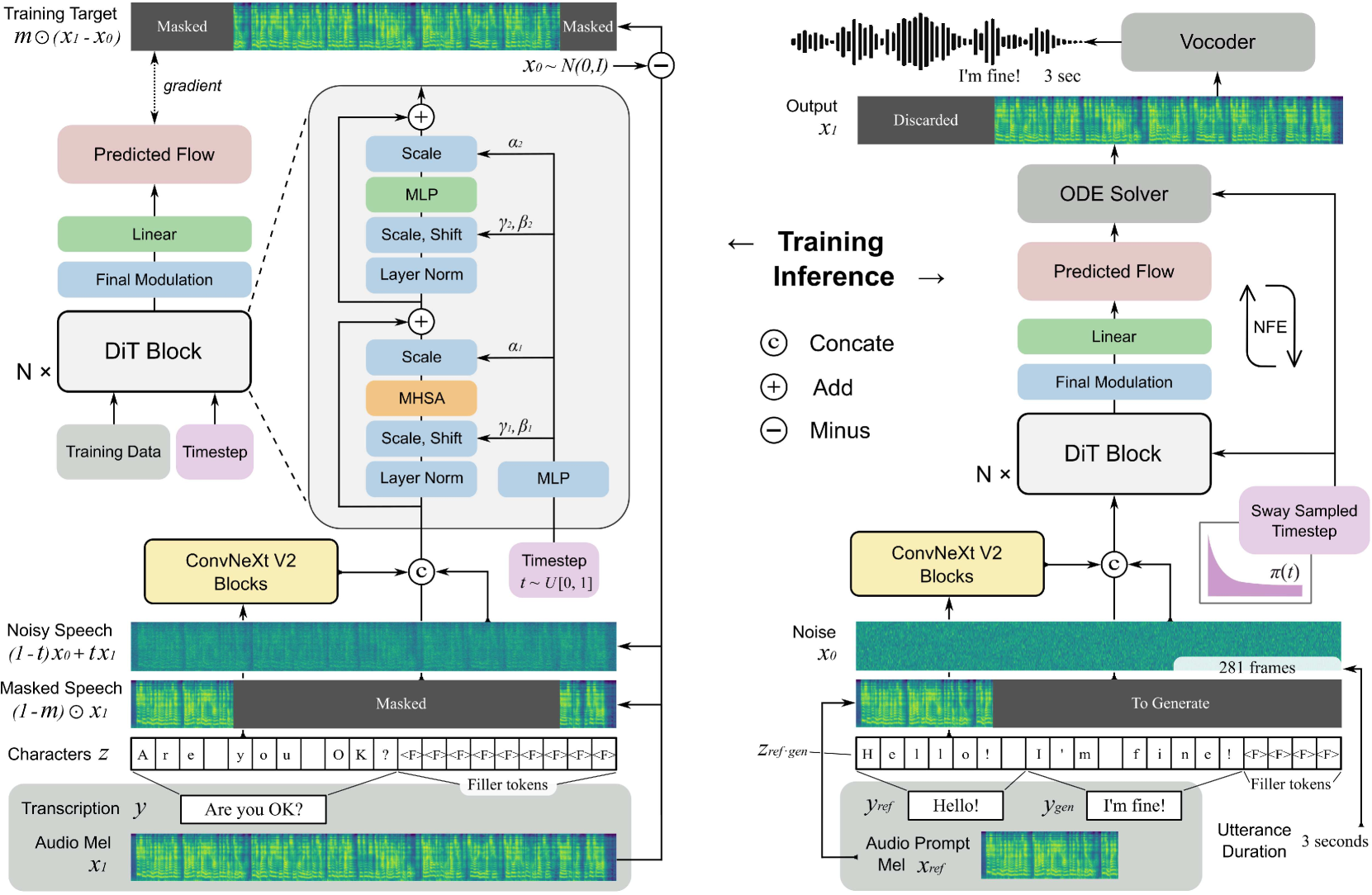

3. F5-TTS : Un conteur de contes de fées qui imite une parole fluide et fidèle grâce à une synchronisation du débit.

Cet article propose F5-TTS, un système de synthèse vocale (TTS) entièrement non autorégressif basé sur la correspondance de flux et le Diffusion Transformer (DiT). Après un entraînement sur un ensemble de données multilingues de 100 000 heures accessible au public, F5-TTS démontre des capacités de génération sans exemple très naturelles et expressives, prend en charge le changement de code de manière transparente et présente des performances de contrôle du débit de parole efficaces.

Lien vers l'article :https://go.hyper.ai/Q15y9

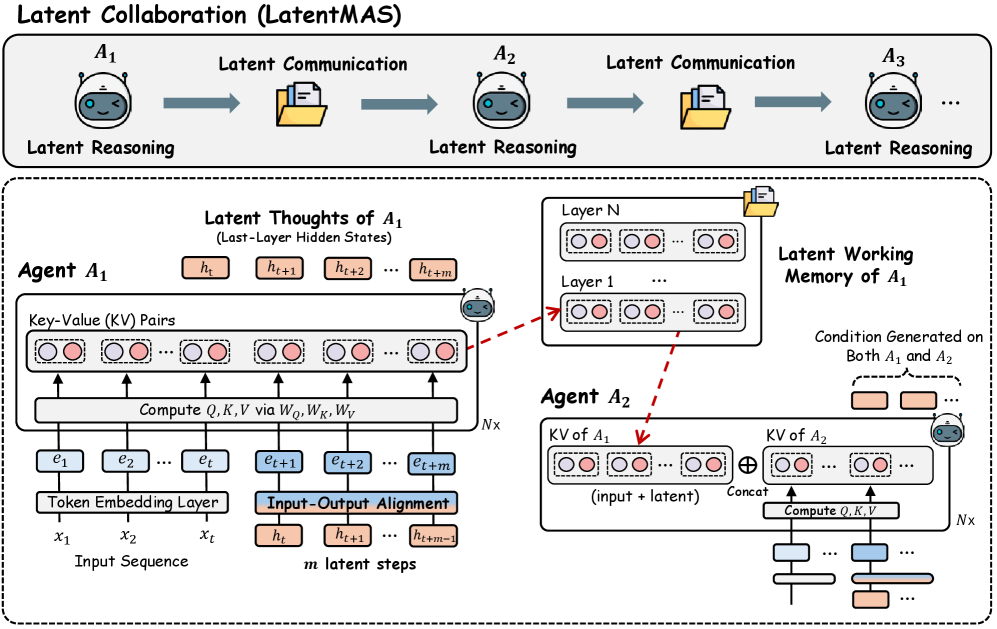

4. Collaboration latente dans les systèmes multi-agents

Cet article propose LatentMAS, un cadre de bout en bout sans apprentissage qui prend en charge la collaboration pure dans l'espace latent entre agents LLM. Dans LatentMAS, chaque agent génère d'abord des représentations de pensée dans l'espace latent de manière autorégressive par l'intégration de la dernière couche d'états cachés ; ensuite, la mémoire de travail partagée dans l'espace latent stocke et transmet les représentations internes de chaque agent, garantissant un échange d'informations sans perte.

Lien vers l'article :https://go.hyper.ai/M587U

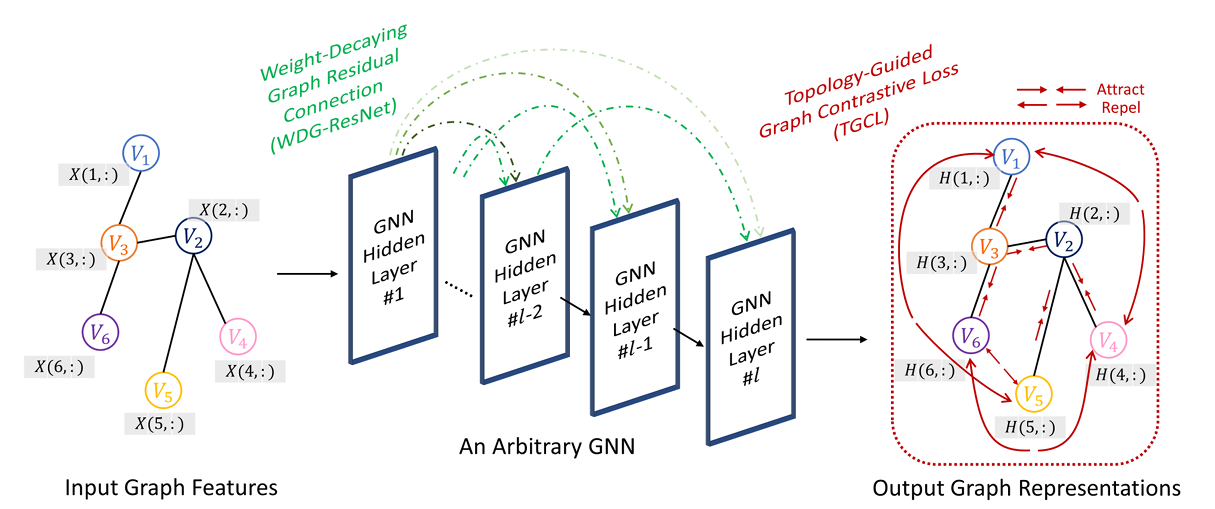

5. Deeper-GXX : Approfondissement des GNN arbitraires

Cet article propose une nouvelle méthode de réseau neuronal graphique (GNN) appelée Deeper-GXX. Cette méthode se compose de deux modules principaux : un module de connexion résiduelle de graphe à pondération décroissante (WDG-ResNet) et une fonction de perte contrastive de graphe guidée par la topologie (TGCL). WDG-ResNet atténue efficacement le problème de disparition du gradient grâce à un mécanisme dynamique de décroissance des poids, tout en supprimant l'effet des voisins fantômes. TGCL exploite la structure topologique du graphe pour guider l'apprentissage contrastif, renforçant ainsi le pouvoir discriminant des représentations des nœuds et limitant le sur-lissage.

Lien vers l'article :https://go.hyper.ai/gwM7J