Command Palette

Search for a command to run...

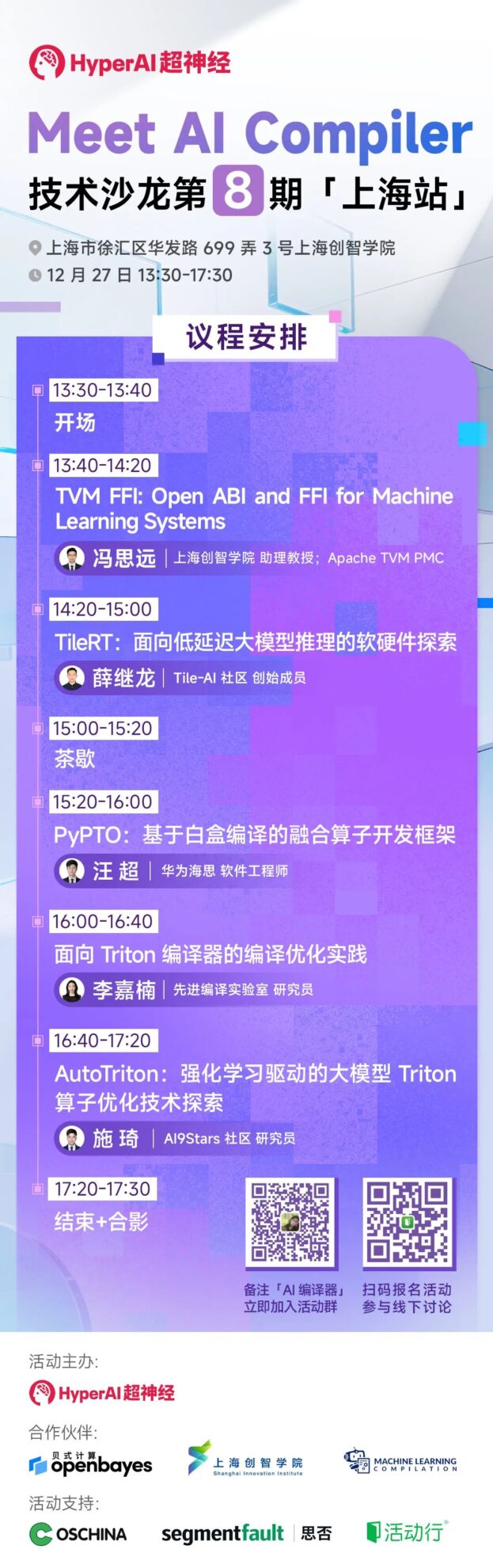

Technischer Salon | Shanghai Innovation Lab, TileAI, Huawei, Advanced Compiler Lab Und AI9Stars Treffen Sich in Shanghai Zur Eingehenden Analyse Der Gesamten Wertschöpfungskette Von Betreiberoptimierungspraktiken

Das 8. Meet AI Compiler findet am 27. Dezember in Shanghai statt!In dieser Ausgabe haben wir mehrere Experten der Shanghai Innovation Academy, der TileAI Community, von Huawei HiSilicon, dem Advanced Compiler Lab und der AI9Stars Community eingeladen, ihre Erkenntnisse entlang der gesamten Technologiekette zu teilen – vom Software-Stack-Design und der Operatorentwicklung bis hin zur Leistungsoptimierung. Die Inhalte umfassen die ökosystemübergreifende Interoperabilität von TVM, die Fusionsoperatoroptimierung von PyPTO, latenzarme Systeme von TileRT, wichtige Optimierungstechnologien von Triton für verschiedene Architekturen sowie die Operatoroptimierung von AutoTriton. Damit wird ein vollständiger technischer Weg von der Theorie zur Implementierung aufgezeigt.

Die Anmeldung ist ab sofort möglich, die Plätze sind begrenzt! Seien Sie dabei und profitieren Sie von wertvollen Einblicken – wir freuen uns auf Sie in Shanghai! 🫶

Veranstaltungsdetails

⏰ Datum: 27. Dezember (Samstag) 13:30-17:30 Uhr

📍Standort: Shanghai Innovation Academy, No. 3, Lane 699, Huafa Road, Xuhui District, Shanghai

👬 Teilnehmerzahl: 150 (Begrenzte Plätze verfügbar, bitte melden Sie sich so schnell wie möglich an)

🙌🏻 Registrieren:https://hdxu.cn/1CupU

Die vollständige Tagesordnung lautet wie folgt ⬇️

Gäste und Gesprächsthemen

Gäste teilen

13:40-17:20

Thema teilen:TVM FFI: Offene ABI und FFI für Systeme des maschinellen Lernens

Inhalt:TVM FFI zielt darauf ab, die Probleme fragmentierter Ökosysteme und der Interoperabilität in Systemen für maschinelles Lernen zu lösen. Durch die Definition offener ABI- und FFI-Standards nutzt das Projekt stabile CABI- und DLPack-Frameworks für den kopierfreien Datentransfer und schließt so die Lücke zwischen Frameworks wie PyTorch und den zugrundeliegenden Compilern. Es unterstützt effiziente sprachübergreifende Aufrufe und reduziert dadurch den Entwicklungsaufwand für die plattformübergreifende Anpassung erheblich.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Lernen Sie den universellen TVM-FFI-Standard kennen, um die Entwicklungs- und Wartungskosten von sprachübergreifenden ML-Systemen deutlich zu reduzieren.

2. Ein zukunftsfähiges, modulares ML-Ökosystem verstehen und aufbauen.

Thema teilen:TileRT: Eine Software- und Hardware-Untersuchung für latenzarme Inferenz großer Modelle

Inhalt:Da große Modelle Billionen von Parametern erreichen und Sequenzen mit Millionen von Token verarbeiten, brechen ihre Fähigkeiten ständig Rekorde. Das Streben nach maximaler Rechengeschwindigkeit für Modelle ist jedoch ungebrochen. Einerseits erfordern viele Szenarien mit geringer Latenz Reaktionen innerhalb von Sekunden oder sogar Millisekunden, beispielsweise bei Echtzeit-Entscheidungen und in der Spieltheorie. Andererseits hat sich mit dem Aufkommen des Agentenzeitalters im Training großer Modelle die Bereitstellungszeit für extrem lange Sequenzen zu einem erheblichen Engpass entwickelt.

Dieser Bericht stellt das TileRT-Projekt vor und untersucht, wie man einen Software-Stack für die Berechnung von Modellen im großen Maßstab mit extrem niedriger Latenz aufbaut, und zwar aus der Perspektive von KI-Compilern, Laufzeitumgebungen und Architekturdesign.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Den Hintergrund, die Bedeutung und die Zukunftsaussichten von Inferenzszenarien mit geringer Latenz für große Modelle verstehen.

2. Technische Herausforderungen und praktischer Erfahrungsaustausch von TileRT

Thema teilen:PyPTO: Ein Framework zur Entwicklung von Fusionsoperatoren auf Basis der White-Box-Kompilation.

Inhalt:Diese Präsentation konzentriert sich auf Huaweis neu eingeführtes Framework für die Entwicklung konvergenter Betreiberlösungen, PyPTO. Basierend auf dem Tensor/Tile-Programmierparadigma erzielt es ein ausgewogenes Verhältnis zwischen hoher Leistung und Benutzerfreundlichkeit durch den Fokus auf Technologien wie In-Core-SRAM-Management, plattformübergreifende PTO-Befehlssätze und MPMD-Laufzeitumgebung, kombiniert mit Human-in-the-Loop-Optimierung und White-Box-Kompilierung.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Machen Sie sich mit der Designphilosophie und der Kernarchitektur von PyPTO vertraut, einem Framework zur Entwicklung von Fusionsoperatoren, das nativ für die SIMD-Architektur konzipiert wurde.

2. Machen Sie sich mit der White-Box-Kompilierungsphilosophie von PyPTO vertraut, die auf der Nutzung der Expertenerfahrung der Benutzer und dem Wesen der Human-In-The-Loop-Optimierung basiert.

3. Meistern Sie den gesamten Prozess der schnellen Entwicklung von Hochleistungsfusionsoperatoren auf der Ascend-Plattform mithilfe der von PyPTO bereitgestellten Visualisierungswerkzeuge.

Thema teilen:Optimierungspraktiken für die Kompilierung des Triton-Compilers

Inhalt:Diese Präsentation konzentriert sich auf Optimierungsmethoden für den Triton-Compiler und führt systematisch in die Sprache und Compilerstruktur von Triton, die Entwicklung des Ökosystems und die Methoden zur Entwicklung von Operatorbibliotheken ein. Darüber hinaus werden wichtige Optimierungstechniken für verschiedene Architekturen, darunter CPU, NPU und GPU, erläutert und der vollständige Weg zum Aufbau eines leistungsstarken, einheitlichen Operatorsystems aufgezeigt.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Neueste Entwicklungen im Triton-Ökosystem

2. Wichtigste Optimierungstechniken des Triton-Compilers auf verschiedenen Architekturen (CPU/NPU/GPU)

Thema teilen:AutoTriton: Untersuchung von Triton-Operator-Optimierungstechniken für große, durch Reinforcement Learning gesteuerte Modelle

Inhalt:Das Schreiben effizienter Kernel mithilfe von Sprachen wie CUDA ist das Gebiet von Performance-Ingenieuren. Mit dem Aufkommen von Programmierframeworks wie Triton hat die Programmierbarkeit von Kerneln einen bedeutenden Sprung nach vorn gemacht. Dennoch müssen Entwickler weiterhin wichtige Parameter manuell konfigurieren, was die Portabilität der Performance und die breite Anwendung einschränkt. Dieser Bericht stellt unsere Untersuchung von Benchmarks und Modellen zur Generierung von Operatoren im großen Maßstab vor und erörtert das enorme Potenzial großer Modelle für die Operatoroptimierung.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Relevante Arbeiten und neueste Fortschritte bei der Optimierung von Operatoren zur Stärkung großer Modelle

2. Schlüsseltechnologien großer Modelle in der Operatoroptimierung

Veranstalter und Partner

HyperAI (hyper.ai) ist eine international führende Community für künstliche Intelligenz und Hochleistungsrechnen.Ziel ist es, Entwicklern und Enthusiasten in der globalen Datenwissenschafts- und künstlichen Intelligenzbranche beim Lernen, Verstehen und Üben zu helfen, indem eine Reihe von Diensten bereitgestellt werden, wie etwa Brancheninformationsberichte, beschleunigte Downloads von Datensätzen, Demonstrationen von Online-Tutorials, Leistungsbewertungen beliebter Modelle, Empfehlungen für topaktuelle Arbeiten, hochwertige Ergebnisinterpretationen und Integration in erstklassige Konferenzkalender, und gemeinsam mit der Community die Zukunft der künstlichen Intelligenz aufzubauen.

Besuchen Sie die offizielle Website:https://hyper.ai/

OpenBayes Bayesian Computing ist ein führender Anbieter von Hochleistungs-Computing-Diensten in ChinaDurch die Integration klassischer Software-Ökosysteme und Modelle des maschinellen Lernens in heterogene Chips der neuen Generation werden Industrieunternehmen und der wissenschaftlichen Forschung an Universitäten schnellere und benutzerfreundlichere Produkte für die Datenwissenschaft bereitgestellt. Seine Produkte werden von Dutzenden großer Industrieszenarien oder führenden wissenschaftlichen Forschungsinstituten übernommen.

Besuchen Sie die offizielle Website:https://openbayes.com/

Die MLC.AI-Community wurde im Juni 2022 gegründet. Chen Tianqi, der Haupterfinder von Apache TVM und ein bekannter junger Wissenschaftler auf dem Gebiet des maschinellen Lernens, leitete das Team bei der Einführung des MLC-Onlinekurses, der systematisch die Schlüsselelemente und Kernkonzepte der Kompilierung maschinellen Lernens vorstellte.

Im November 2022 wurde dank der gemeinsamen Anstrengungen der Freiwilligen der MLC.AI-Community die erste vollständige chinesische TVM-Dokumentation veröffentlicht und erfolgreich auf der offiziellen HyperAI-Website gehostet. Damit werden inländischen Entwicklern, die an der Kompilierung von maschinellem Lernen interessiert sind, die grundlegenden Einstellungen für den Zugriff auf und das Erlernen einer neuen Technologie – der Dokumentation – bereitgestellt.

MLC-Onlinekurse:https://mlc.ai/

Chinesische TVM-Dokumentation:https://tvm.hyper.ai/

Die Shanghai Innovation Academy ist eine neuartige Ausbildungsstätte für Nachwuchskräfte, die von führenden Universitäten, Unternehmen und Forschungseinrichtungen gemeinsam gegründet wurde. Gemäß ihrer Ausbildungsphilosophie „Studentenzentrierung und Spitzenforschung“ entwickelt die Akademie mit herausragenden Dozenten, außergewöhnlichen Trainingsmaßnahmen und exzellenten Rahmenbedingungen ein einzigartiges chinesisches Ausbildungsprogramm für KI-Führungskräfte. Ziel ist es, führende KI-Talente in China auszubilden und ein weltweit führendes Innovationszentrum für künstliche Intelligenz zu etablieren.

Veranstaltungsbetreuung

Aufgrund der begrenzten Platzverhältnisse im Veranstaltungsort stehen nur 150 Plätze zur Verfügung. Wir empfehlen Ihnen daher, sich so schnell wie möglich anzumelden, um sich Ihren Platz zu sichern.

Wir sehen uns dort am 27. Dezember von 13:30 bis 17:30 Uhr!