Command Palette

Search for a command to run...

NeurIPS 2025: جامعة هواتشونغ للعلوم والتكنولوجيا وجهات أخرى تُصدر الإصدار الثاني من OCRBench. احتلّ برنامج Gemini المركز الأول في تصنيفات اللغة الصينية، ولكنه لم يحصل إلا على درجة النجاح.

على مدى العقود القليلة الماضية، شهد موقع وأهمية تقنية التعرف الضوئي على الحروف (OCR) تطورًا هائلًا، من أداة تقليدية للتعرف على الصور إلى قدرة أساسية في أنظمة المعلومات الذكية. في البداية، كانت هذه التقنية تستخرج النصوص المطبوعة أو المكتوبة بخط اليد من الصور وتحولها إلى بيانات نصية مفهومة حاسوبيًا. أما اليوم، ومع تطور التعلم العميق والنماذج متعددة الوسائط، مدفوعةً بمتطلبات متنوعة، فإن آفاق تقنية التعرف الضوئي على الحروف تتوسع باستمرار. فهي لا تتعرف على الحروف فحسب، بل تفهم أيضًا بنية المستندات ودلالاتها.تحليل الجداول والتخطيطات والنصوص والرسومات المختلطة بدقة في السيناريوهات المعقدة.

علاوة على ذلك، في التدريب المسبق متعدد الوسائط واسع النطاق، يتعرض النموذج لكمية كبيرة من بيانات الصور التي تحتوي على نصوص، مثل لقطات شاشة صفحات الويب، وواجهات المستخدم، والملصقات، والمستندات، وغيرها، وتظهر قدرات التعرف الضوئي على الحروف (OCR) بشكل طبيعي في عملية التعلم غير الخاضعة للإشراف. هذا يجعل النموذج الكبير لا يعتمد على وحدات التعرف الضوئي على الحروف الخارجية.وبدلاً من ذلك، يمكنه إكمال عملية التعرف والفهم والإجابة بشكل مباشر في عملية التفكير من البداية إلى النهاية.والأهم من ذلك، أن تقنية التعرف الضوئي على الحروف (OCR) أصبحت شرطًا أساسيًا للمهام الذكية عالية المستوى. فقط عندما يتمكن النموذج من التعرّف بدقة على النص في الصور، يُمكنه إكمال تحليل المخططات، والإجابة على أسئلة المستندات، واستخلاص المعرفة، وحتى فهم الأكواد البرمجية.

يمكن القول إن الأداء في مهام التعرف الضوئي على الحروف (OCR) يُعدّ أيضًا أحد المؤشرات المهمة لتقييم قدرات النماذج متعددة الوسائط الكبيرة. لقد تجاوزت الاحتياجات الحالية مجرد قراءة النصوص. فالجداول، والمخططات البيانية، والملاحظات المكتوبة بخط اليد، والتصميمات المعقدة للمستندات، وتحديد مواقع الصور النصية، والاستدلال النصي، كلها تحديات صعبة يتعين على النماذج التغلب عليها.ومع ذلك، فإن معظم معايير تقييم OCR التقليدية تحتوي على مهام فردية وسيناريوهات محدودة، مما يؤدي إلى تشبع سريع لدرجات النموذج ويجعل من الصعب عكس قدراتها حقًا في التطبيقات المعقدة.

وفي ضوء ذلك،أطلق فريق باي شيانغ في جامعة هواتشونغ للعلوم والتكنولوجيا، بالتعاون مع جامعة جنوب الصين للتكنولوجيا، وجامعة أديلايد، وByteDance، معيار التعرف الضوئي على الحروف من الجيل التالي OCRBench v2.قمنا بتقييم 58 نموذجًا رئيسيًا للنقل متعدد الوسائط بين عامي 2023 و2025 باللغتين الصينية والإنجليزية. ويوضح الشكل أدناه أفضل 10 نماذج في كل قائمة.

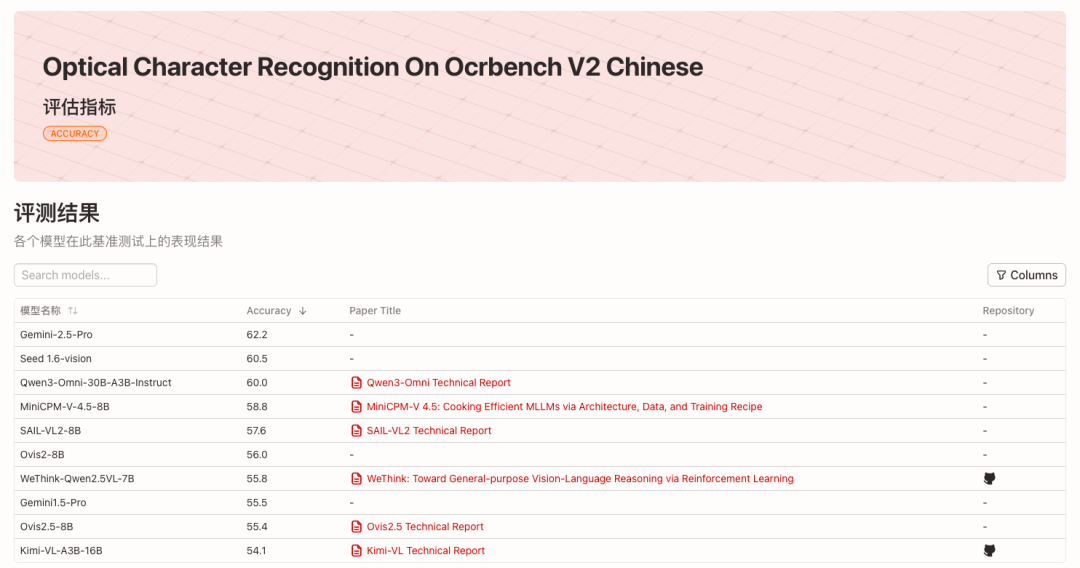

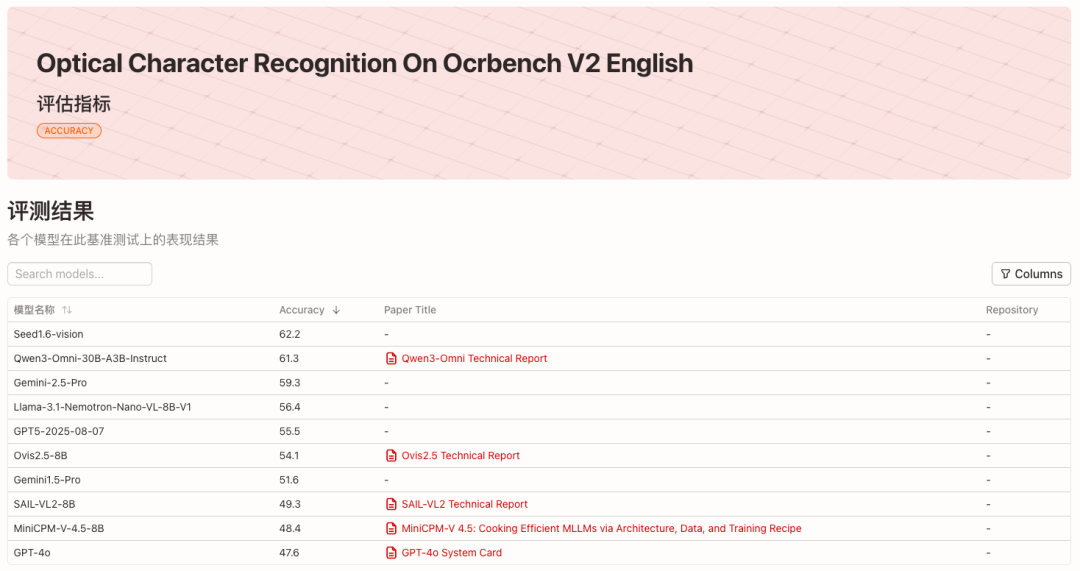

* عرض التصنيفات الإنجليزية:

* عرض القائمة الصينية:

* عنوان المشروع مفتوح المصدر:

https://github.com/Yuliang-Liu/MultimodalOCR

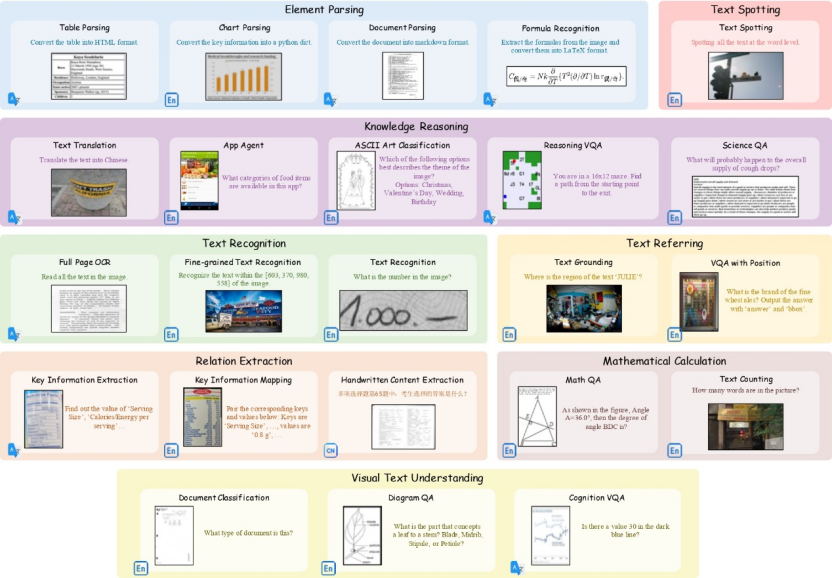

23 مهمة فرعية تغطي سيناريوهات متنوعة

يغطي OCRBench v2 23 مهمة فرعية و8 أبعاد أساسية للقدرة.——التعرف على النصوص، وتحديد موضع النص، واكتشاف النصوص والتعرف عليها، واستخراج العلاقات، وتحليل العناصر، والحسابات الرياضية، وفهم النصوص البصرية، واستدلال المعرفة.

تتضمن مجموعة البيانات العامة لـ OCRBench v2 عشرة آلاف سؤال ضمان جودة عالي الجودة من أكثر من 80 مجموعة بيانات أكاديمية، بالإضافة إلى بعض البيانات الخاصة. خضعت هذه البيانات لمراجعة يدوية لضمان تغطية سيناريوهات متنوعة في تطبيقات التعرف الضوئي على الحروف (OCR) العملية. كما تتضمن OCRBench v2 بيانات خاصة مستقلة، تتألف من 1500 سؤال ضمان جودة جُمعت يدويًا وعُلّقت عليها تعليقات توضيحية. تتوافق إعدادات المهام وتغطية السيناريوهات مع مجموعة البيانات العامة.

* عنوان تنزيل مجموعة البيانات:

https://go.hyper.ai/VNHSX

وتوصلت تجارب الفريق إلى أن تصنيفات البيانات العامة والبيانات الخاصة متسقة إلى حد كبير.يثبت هذا منطقية تصميم المهام وبناء البيانات ومؤشرات التقييم في OCRBench v2.ويوضح هذا أهميته في قياس القيود الحالية للنماذج المتعددة الوسائط الكبيرة.

تم تضمين ورقة البحث ذات الصلة، بعنوان "OCRBench v2: معيار محسّن لتقييم النماذج المتعددة الوسائط الكبيرة في توطين النص المرئي والاستدلال"، في NeurIPS 2025 (مسار مجموعات البيانات والمعايير).

* عنوان الورقة:

https://go.hyper.ai/VNHSX

تكون النماذج السائدة متحيزة بشكل عام، حيث تكون أعلى درجة هي النجاح فقط.

في أحدث قائمة تقييمية تم إصدارها بواسطة OCRBench v2،وحصل هاتف Gemini-2.5-Pro على المركز الأول في القائمة الصينية والمركز الثالث في القائمة الإنجليزية، بينما حصل هاتف Seed1.6-vision على المركز الأول في القائمة الإنجليزية والمركز الثاني في القائمة الصينية.في معسكر المصدر المفتوح، احتل Qwen3-Omni-30B-A3B-Instruct المرتبة الثانية في القائمة الإنجليزية والثالثة في القائمة الصينية على التوالي.

بتحليل أداء القدرات الأساسية للنماذج، نجد أن هذه النماذج متعددة الوسائط الكبيرة عادةً ما تتسم بظاهرة "تحيز". قليل من النماذج يُحقق أداءً جيدًا في جميع القدرات الأساسية.حتى النماذج الأعلى تصنيفًا لم تحقق سوى متوسط درجات يبلغ حوالي 60 من 100 في المهام باللغتين الإنجليزية والصينية.علاوة على ذلك، يتميز كل نموذج بنقاط قوة مختلفة قليلاً. على سبيل المثال، تتميز النماذج التجارية، مثل Gemini-2.5-Pro، بتفوق واضح في الأسئلة الحسابية، مما يُظهر قدراتها القوية على التفكير المنطقي. أما Llama-3.1-Nemotron-Nano-VL-8B-V1، فقد احتل المركز الرابع في قائمة اللغة الإنجليزية بفضل قدراته القوية على تحديد مواقع النصوص.

بينما تُحقق معظم النماذج أداءً جيدًا في التعرف على النصوص الأساسية، إلا أنها عادةً ما تُحقق نتائج منخفضة في المهام التي تتطلب إدراكًا مكانيًا دقيقًا وفهمًا مُنظمًا، مثل الإحالة والتحديد والتحليل. على سبيل المثال، حتى نموذج Seed1.6-vision، صاحب أعلى تصنيف، لم يُسجل سوى 38.0 في التحديد، مما يُحد من فعاليته في سيناريوهات واقعية مثل المشاهد النصية والمستندات التي تحتوي على نصوص وصور مختلطة.

بالإضافة إلى ذلك، من خلال مقارنة القوائم الصينية والإنجليزية،ومن الممكن أن نجد أن القدرات المتعددة اللغات للعديد من النماذج غير متساوية.على سبيل المثال، يحتل Llama-3.1-Nemotron-Nano-VL-8B-V1 المرتبة الرابعة في القائمة الإنجليزية (متوسط الدرجات 56.4)، ولكنه يحتل المرتبة 31 فقط في القائمة الصينية (متوسط الدرجات 40.1)، مما يشير إلى أنه يتمتع بميزة أكبر في السيناريوهات الإنجليزية، والتي قد تكون مرتبطة بتوزيع البيانات أو استراتيجية التدريب.

في الوقت نفسه، على الرغم من حفاظ نماذج المصادر المغلقة على ريادتها، إلا أن نماذج المصادر المفتوحة الممتازة أصبحت شديدة التنافسية. من بين هذه النماذج، تتميز نماذج المصادر المغلقة، مثل سلسلة Gemini وGPT5 وSeed1.6-vision، بأداء عام أفضل، بينما أصبحت نماذج المصادر المفتوحة مثل Qwen-Omni وInternVL وSAIL-VL وOvis شديدة التنافسية.خمسة من أفضل 10 نماذج في القائمة الإنجليزية هي نماذج مفتوحة المصدر، في حين أن سبعة من أفضل 10 نماذج في القائمة الصينية هي نماذج مفتوحة المصدر.يمكن للنماذج مفتوحة المصدر أيضًا تحقيق أداء متطور في مهام مثل توطين النص واستخراج العناصر وفهم النص المرئي.

سيتم تحديث تصنيفات OCRBench v2 كل ثلاثة أشهر، وستواصل HyperAI تتبع أحدث نتائج التقييم.