Command Palette

Search for a command to run...

MiniCPM-V 4.5: 最も強力なエッジツーエッジマルチモーダルモデル

1. チュートリアルの概要

MiniCPM-V 4.5は、清華大学自然言語処理研究所がWallfacer AIと共同で2025年8月にオープンソース化した、極めて効率的なエッジサイドAIモデルです。MiniCPM-V 4.5は8バイトのパラメータを持ち、画像、動画、OCRなど複数の領域で優れた性能を発揮し、特に高リフレッシュレートの動画理解において飛躍的な進歩を遂げています。高リフレッシュレートの動画処理とコンテンツの正確な認識が可能です。また、ハイブリッド推論モードをサポートし、パフォーマンスと応答速度のバランスを最適化しています。MiniCPM-V 4.5は、メモリ使用量が少なく推論速度が速いため、エッジサイドでの展開が容易で、自動車システム、ロボット、その他のデバイスへの応用に適しており、エッジAI開発の新たなベンチマークとなります。関連研究論文も公開されています。 MiniCPM-V: スマートフォンで動作する GPT-4V レベルの MLLM 。

このチュートリアルで使用されるコンピューティング リソースは、単一の RTX 4090 カードです。

2. エフェクト表示

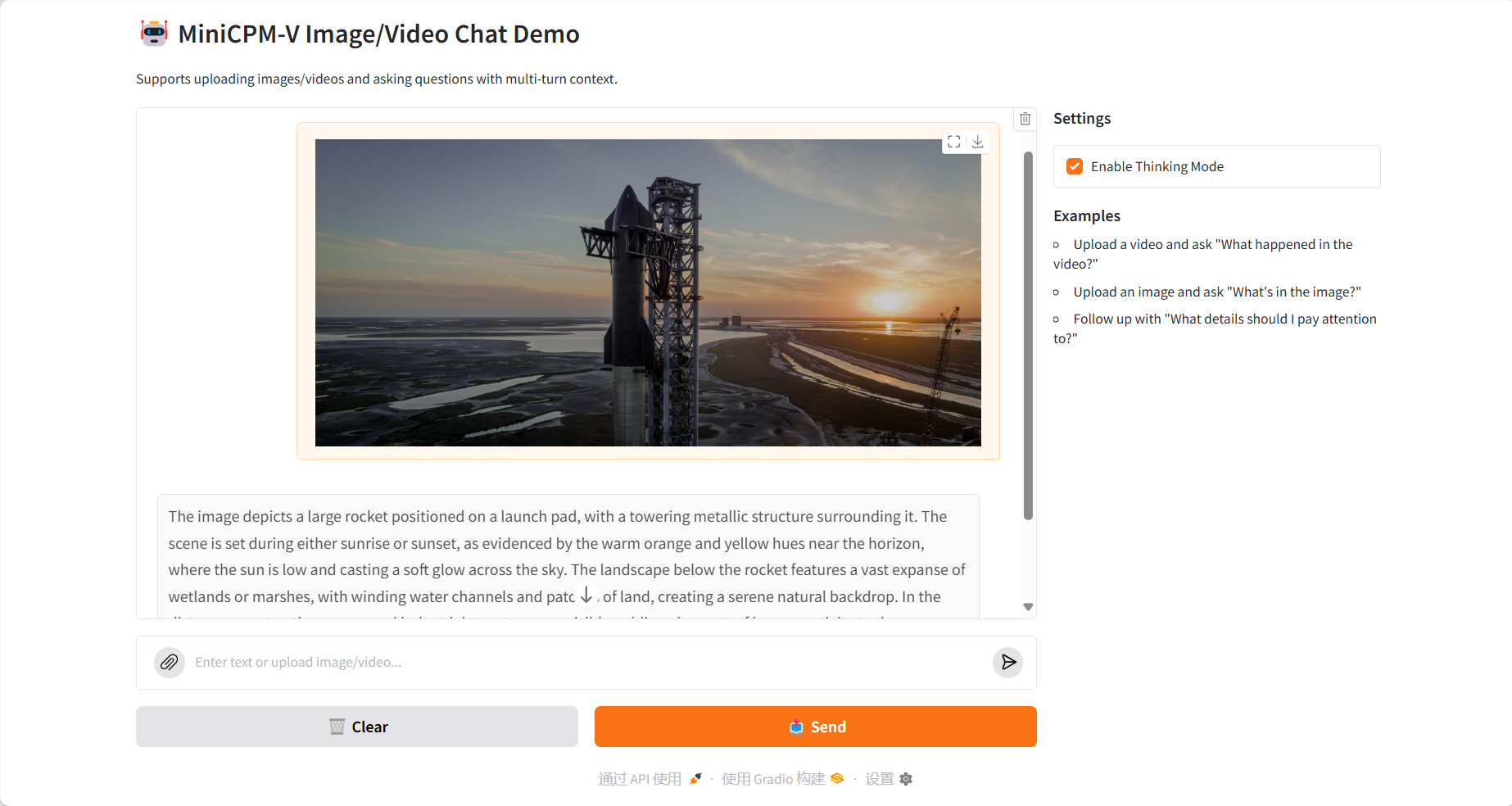

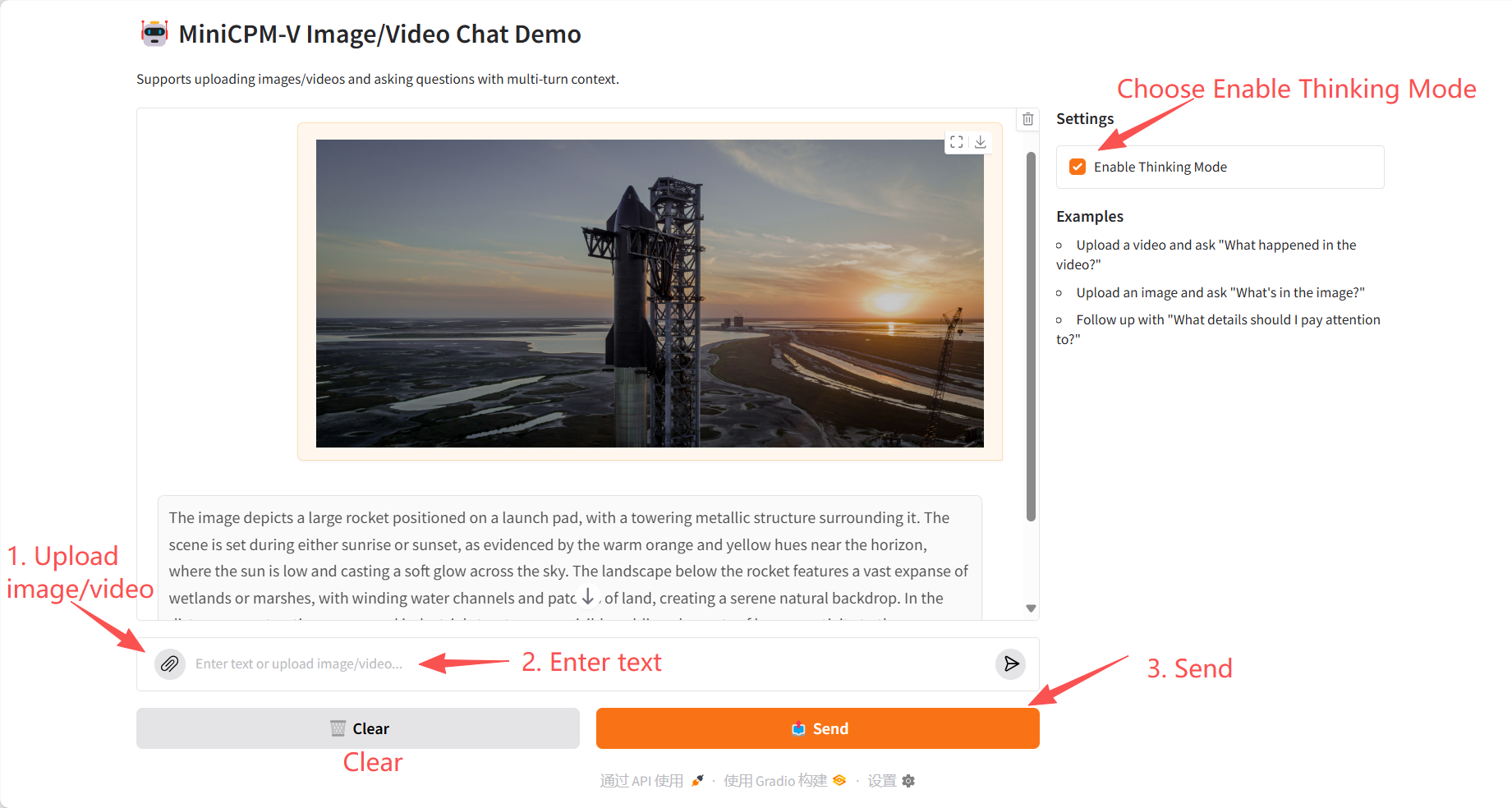

イメージ理解

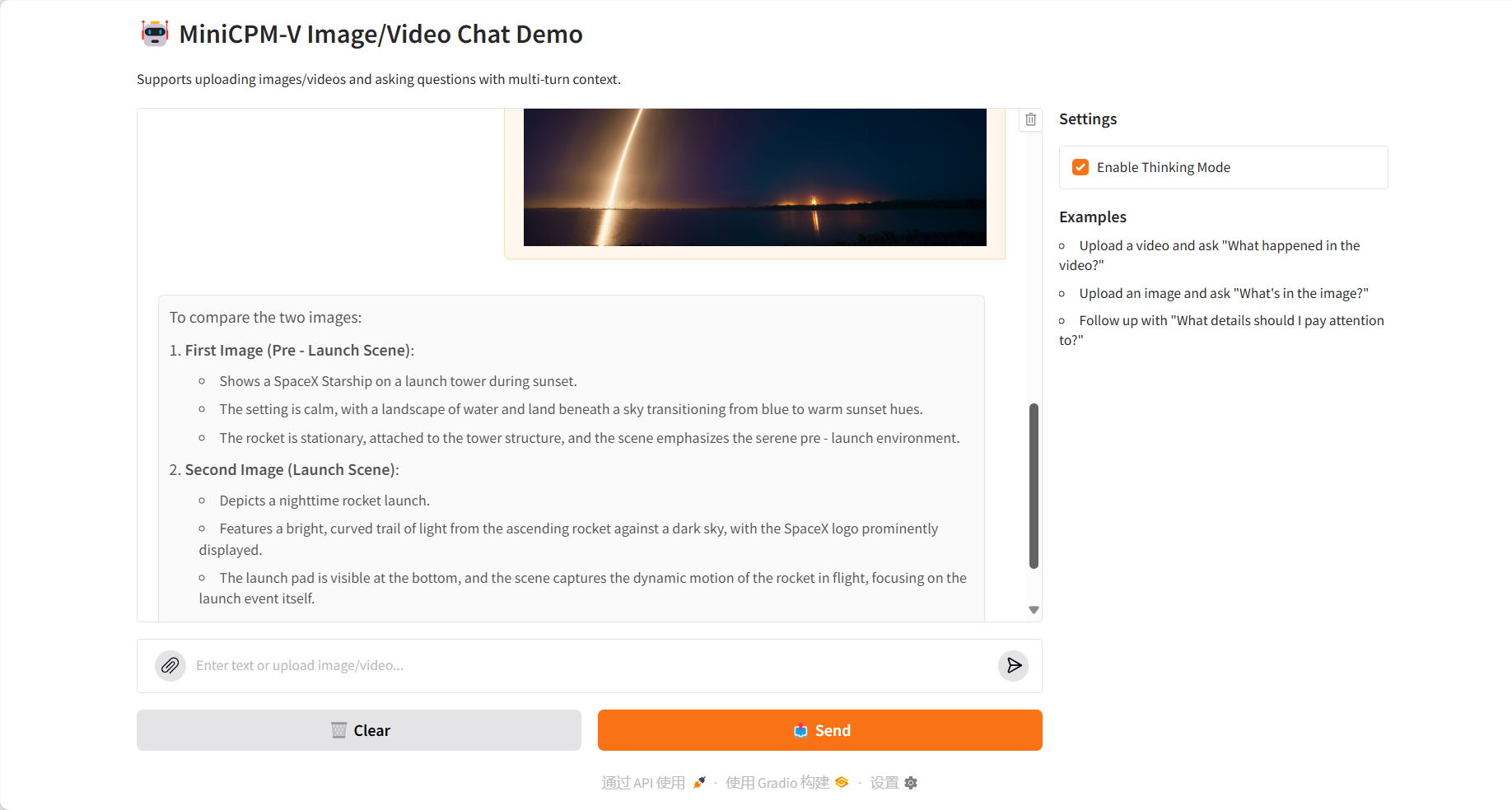

複数画像の比較

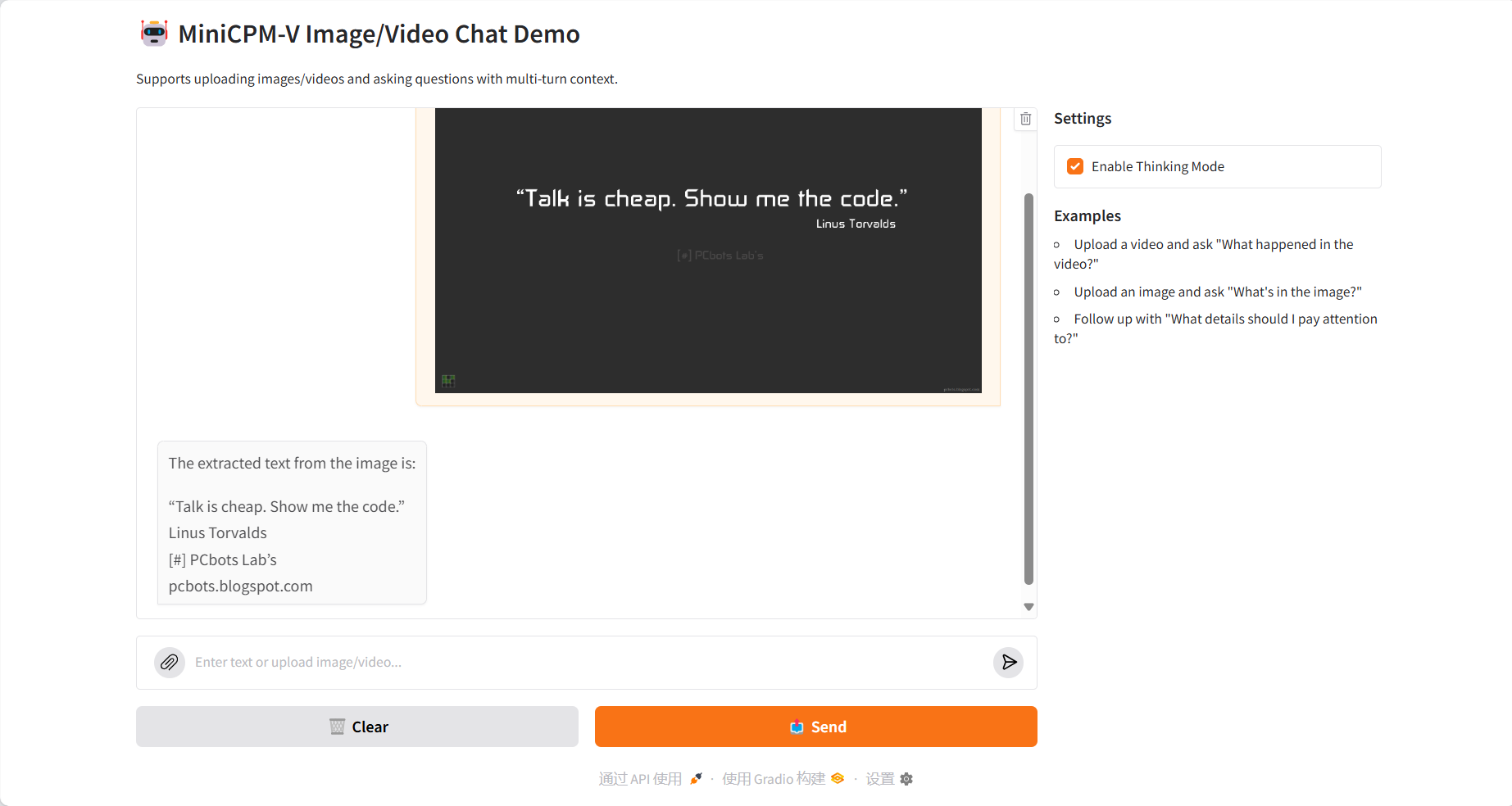

OCRテキスト抽出

ビデオの理解

3. 操作手順

1. コンテナを起動します

2. 使用手順

「Bad Gateway」と表示される場合、モデルが初期化中であることを意味します。モデルが大きいため、2〜3分ほど待ってページを更新してください。

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

引用情報

このプロジェクトの引用情報は次のとおりです。

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={arXiv preprint arXiv:2408.01800},

year={2024}

}