Command Palette

Search for a command to run...

オンラインチュートリアル | DeepSeek-OCR 2 の数式/表解析の改善により、低いビジュアルトークンコストで約 4% のパフォーマンス向上を実現

視覚言語モデル(VLM)の開発において、文書OCRは複雑なレイアウト解析や意味論的ロジックの整合といった主要な課題に常に直面してきました。従来のモデルは、視覚トークンを処理する際に、主に「左上から右下」という固定されたラスタースキャン順序を採用していました。この固定的なプロセスは、人間の視覚システムが従う意味論的なスキャンパターンと矛盾しており、特に複雑な数式や表を含む文書を処理する際には、意味論的関係を無視することで解析エラーが発生しやすくなります。モデルが人間のように視覚ロジックを「理解」できるようにする方法は、文書理解能力を向上させる上で重要なブレークスルーとなっています。

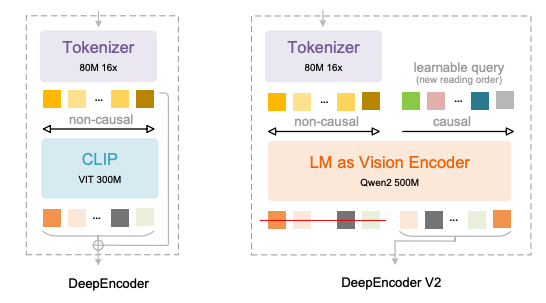

最近、DeepSeek-AI は最新の回答を提供する DeepSeek-OCR 2 をリリースしました。その中核となるのは、最新の DeepEncoder V2 アーキテクチャの採用です。このモデルは、従来のCLIP視覚エンコーダを放棄し、LLMスタイルの視覚エンコーディングパラダイムを導入します。双方向注意と因果的注意を融合することで、視覚トークンの意味駆動型再配置を実現し、2D画像理解のための「2段階1D因果推論」という新たな道筋を構築します。

DeepEncoder V2 の主な革新は、次の 4 つの側面に反映されています。

* CLIP を Qwen2-0.5B コンパクト LLM に置き換えて、約 5 億パラメータの規模で視覚エンコーディング因果推論機能を有効にします。

* ビジュアル トークンの数と同じ長さの「Causal Flow Query」を導入します。これは、カスタム アテンション マスクを使用してビジュアル トークンをグローバルに認識させながら、クエリ トークンがビジュアル順序を意味的に再編成できるようにします。

* 256~1,120 個のビジュアル トークンに対して複数のプルーニング戦略をサポートし、効率性を維持しながら主流の大規模モデルのトークン バジェットに合わせます。

* 「視覚トークン + 因果クエリ」の連結構造を使用することで、意味の並べ替えと自己回帰生成が分離され、LLM の一方向注意メカニズムに自然に適応します。

この設計により、従来のモデルの空間順序の偏りが効果的に排除され、ピクセル位置を機械的に追うのではなく、人間が読むのと同じように、意味関係に基づいてテキスト、数式、表を動的に整理できるようになります。

OmniDocBench v1.5ベンチマークテストでは、DeepSeek-OCR 2 は、視覚トークン制限 1,120 で 91.091 TP3T の総合精度を達成しました。従来モデルと比較して、性能は3.73%向上し、読み順編集距離(ED)は0.085から0.057に短縮され、視覚的論理理解能力が大幅に向上しました。具体的なタスクでは、数式解析の精度が6.17%向上し、表理解性能は2.51~3.05%向上し、テキスト編集距離は0.025減少し、すべてのコア指標において大幅な進歩を達成しました。

同時に、そのエンジニアリングの実用性も抜群です。視覚トークンの圧縮率を16倍に維持しながら、オンラインサービスの繰り返し率は6.25%から4.17%に削減され、PDFバッチ処理の繰り返し率は3.69%から2.88%に削減され、学術的イノベーションと産業応用のニーズの両方を考慮しています。同様のモデルと比較すると、DeepSeek-OCR 2 は、視覚トークンのコストが低い高パラメータ モデルに近い、あるいはそれを上回る結果を実現します。リソースが制限されたシナリオで高精度のドキュメント OCR を実現する、よりコスト効率の高いソリューションを提供します。

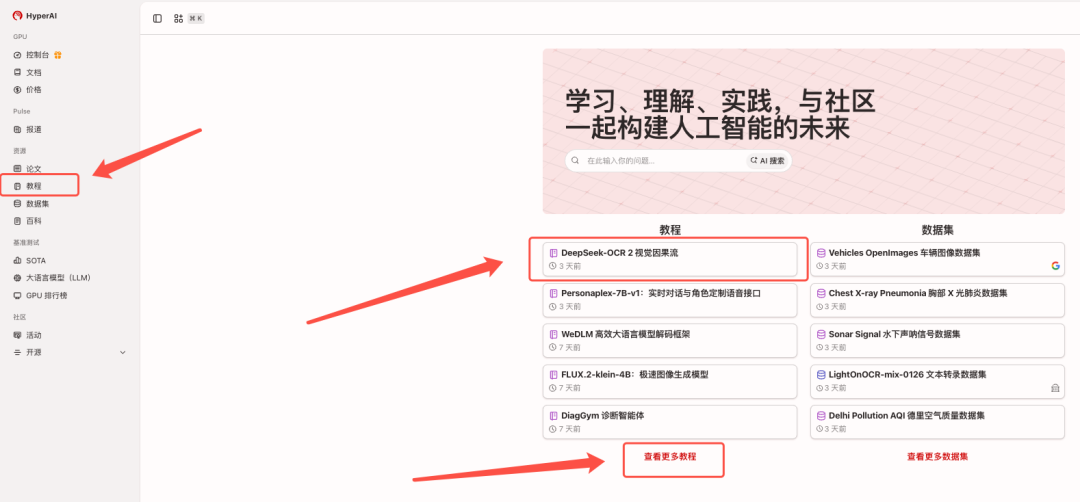

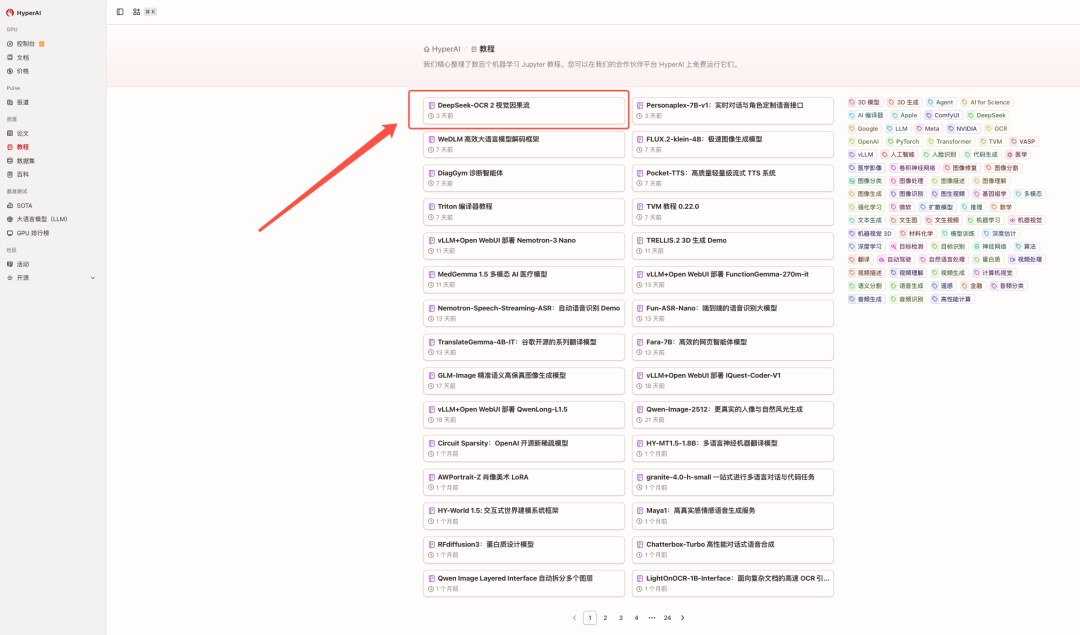

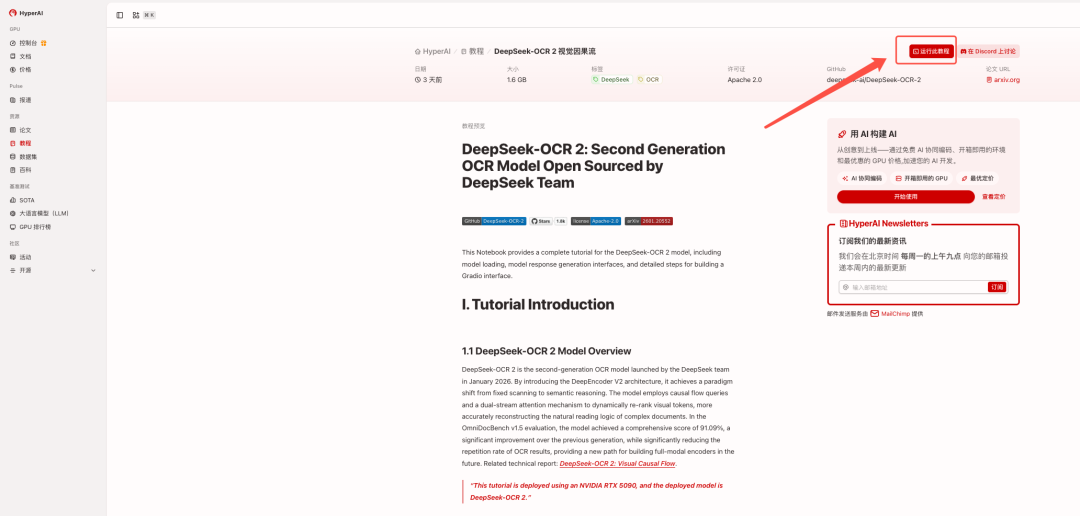

現在、「DeepSeek-OCR 2: Visual Causal Flow」はHyperAIウェブサイトの「チュートリアル」セクションで公開されています。以下のリンクをクリックして、ワンクリックで導入できるチュートリアルをお試しください⬇️

チュートリアルのリンク:https://go.hyper.ai/2ma8d

関連論文を見る:https://go.hyper.ai/hE1wW

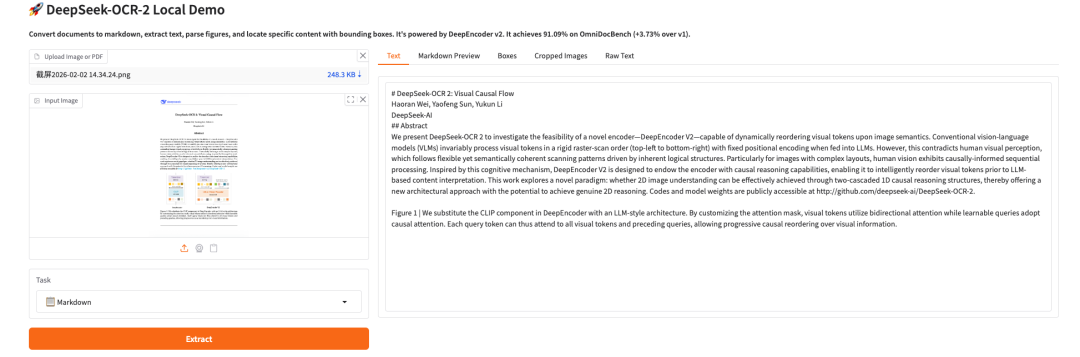

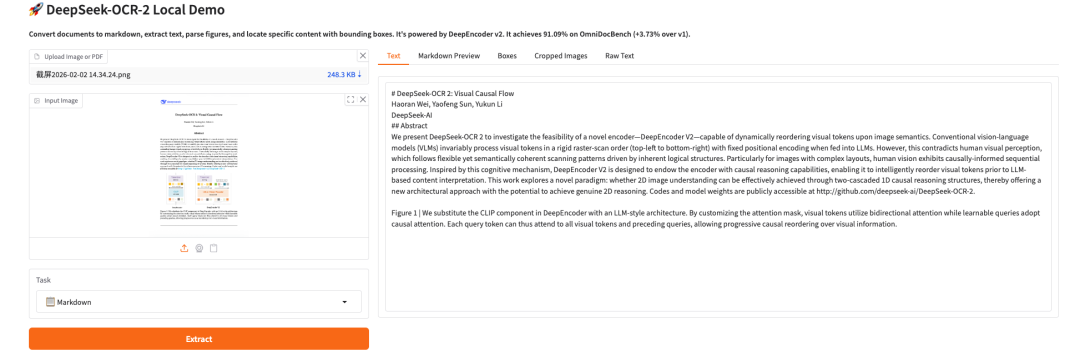

効果のデモンストレーション:

デモの実行

1. hyper.ai ホームページにアクセスした後、「チュートリアル」ページを選択するか、「その他のチュートリアルを表示」をクリックし、「DeepSeek-OCR 2 Visual Causal Flow」を選択して、「このチュートリアルをオンラインで実行」をクリックします。

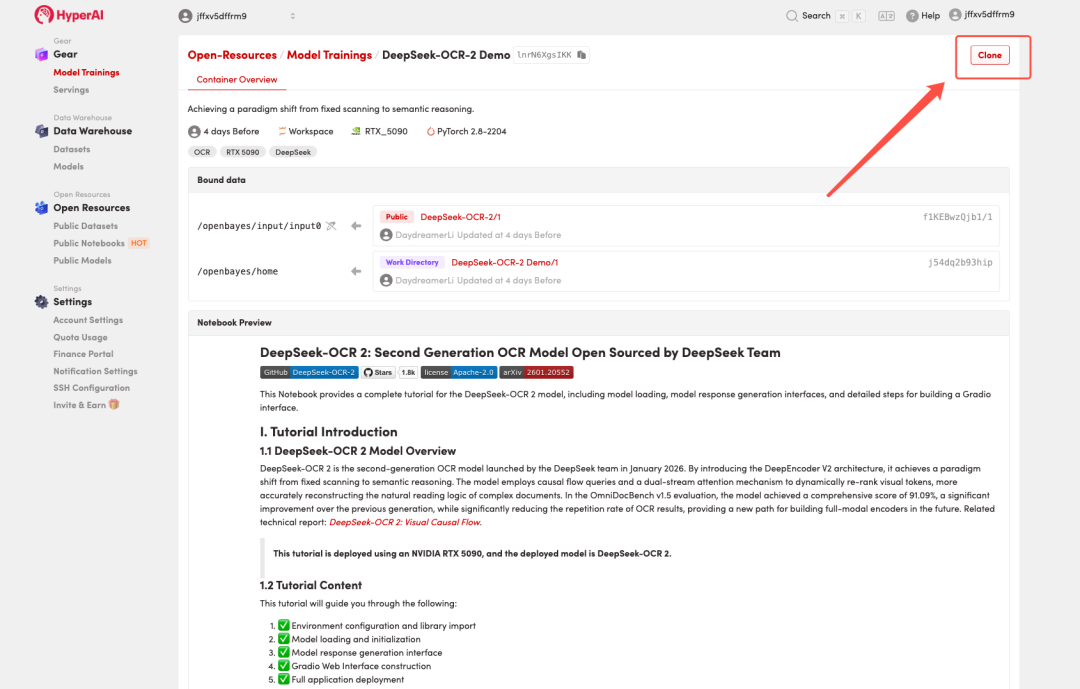

2. ページがリダイレクトされたら、右上隅の「複製」をクリックして、チュートリアルを独自のコンテナーに複製します。

注:ページの右上で言語を切り替えることができます。現在、中国語と英語が利用可能です。このチュートリアルでは英語で手順を説明します。

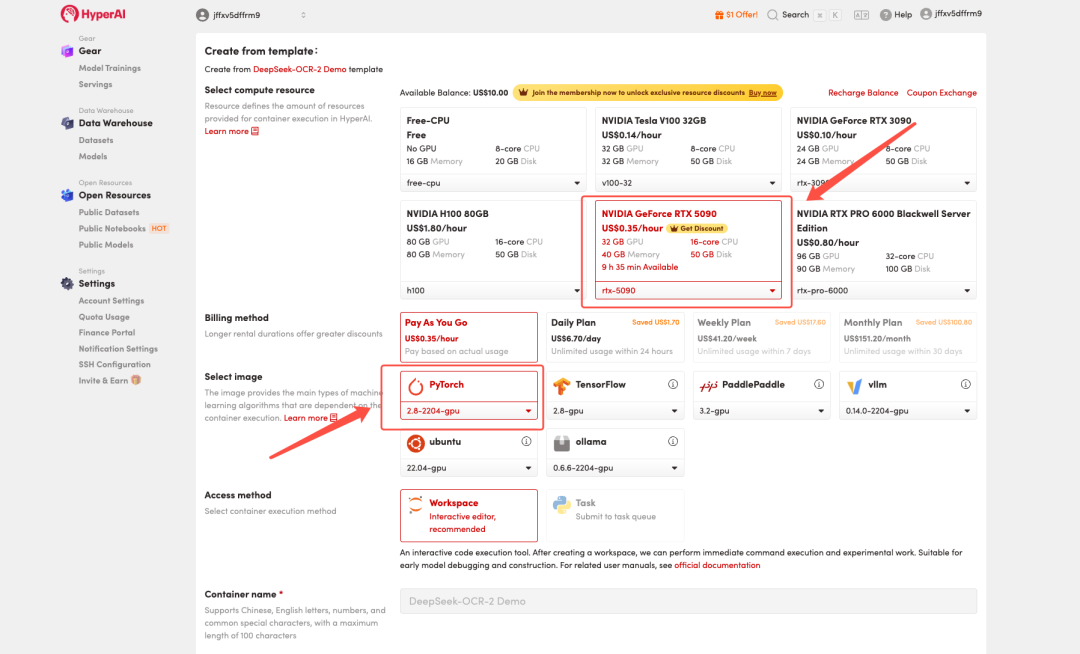

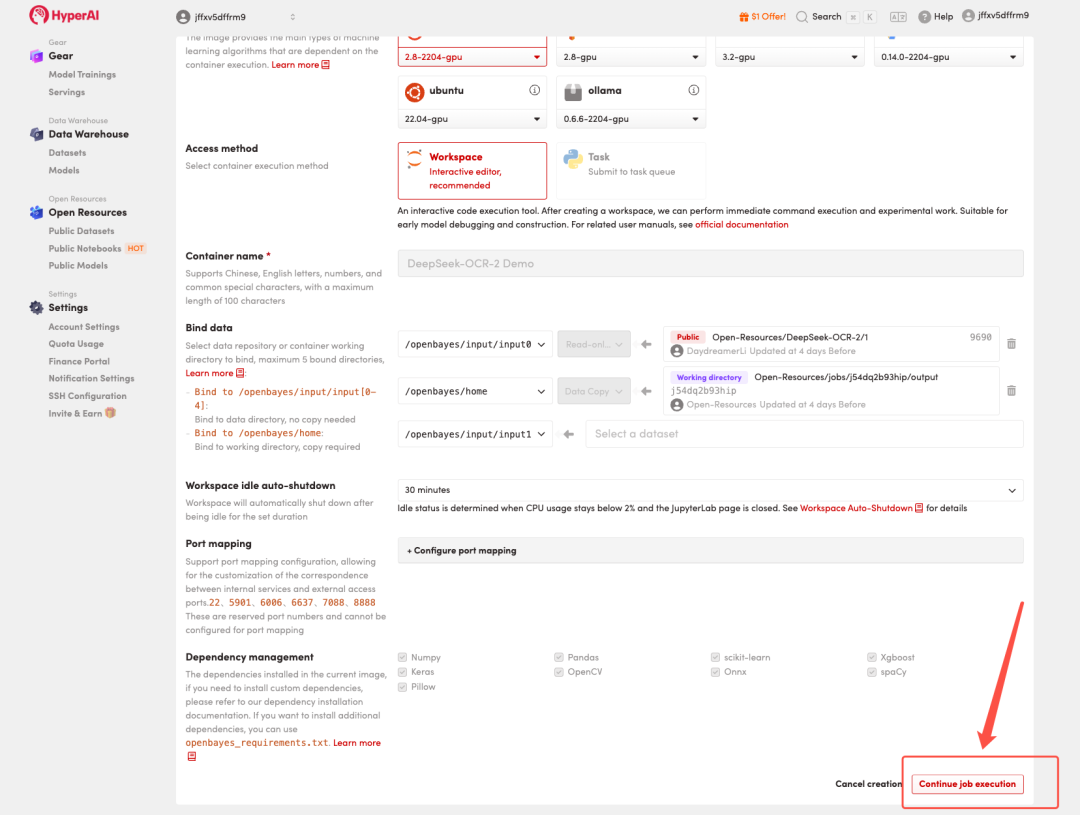

3. 「NVIDIA GeForce RTX 5090」と「PyTorch」のイメージを選択し、必要に応じて「Pay As You Go」または「Daily Plan/Weekly Plan/Monthly Plan」を選択し、「ジョブ実行を続行」をクリックします。

HyperAI は新規ユーザーに登録特典を提供しています。TP4T1 1 個だけで RTX 5090 を入手できます。 コンピューティング能力(元値$7)リソースは永続的に有効です。

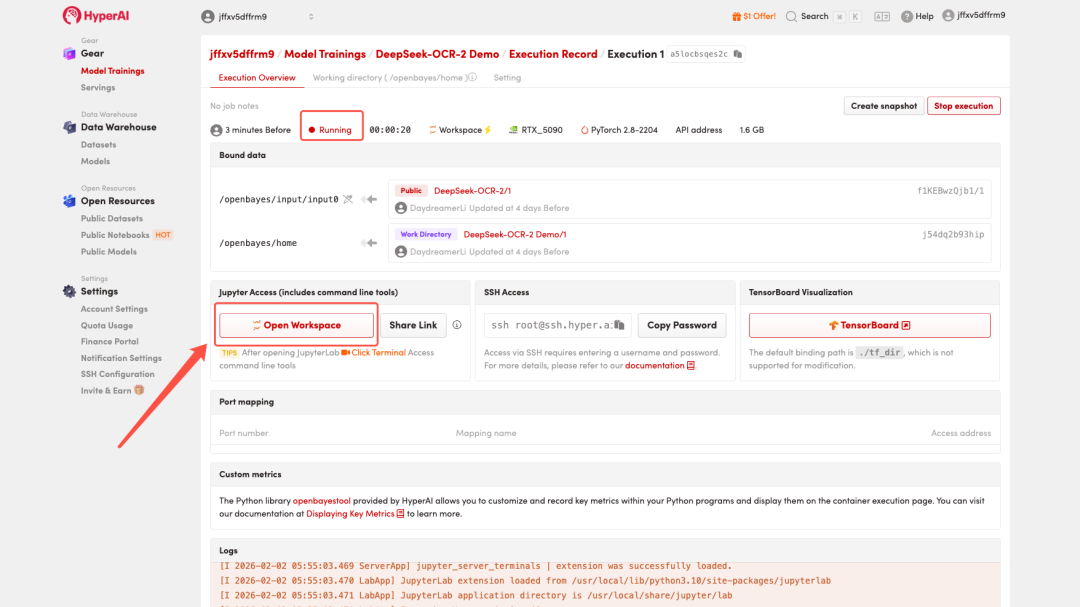

4. リソースが割り当てられるのを待ちます。ステータスが「実行中」に変わったら、「ワークスペースを開く」をクリックしてJupyterワークスペースに入ります。

効果実証

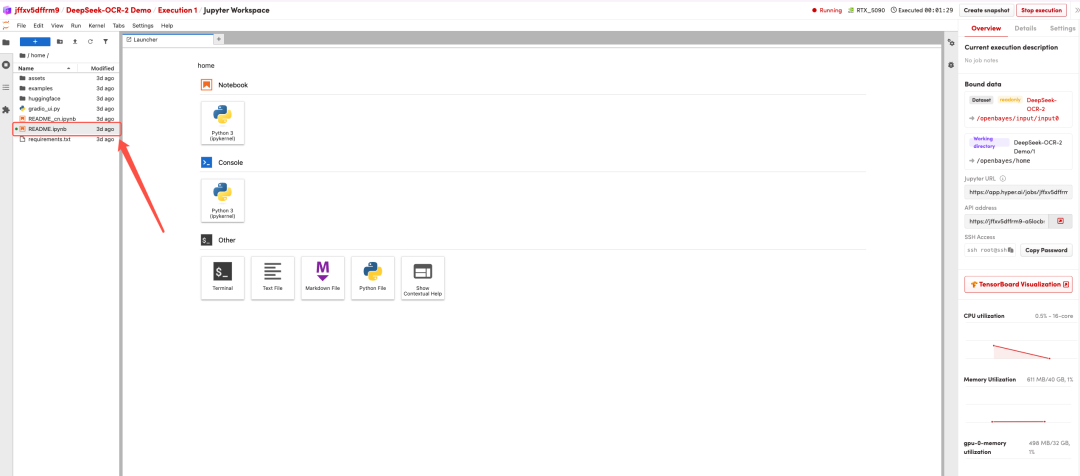

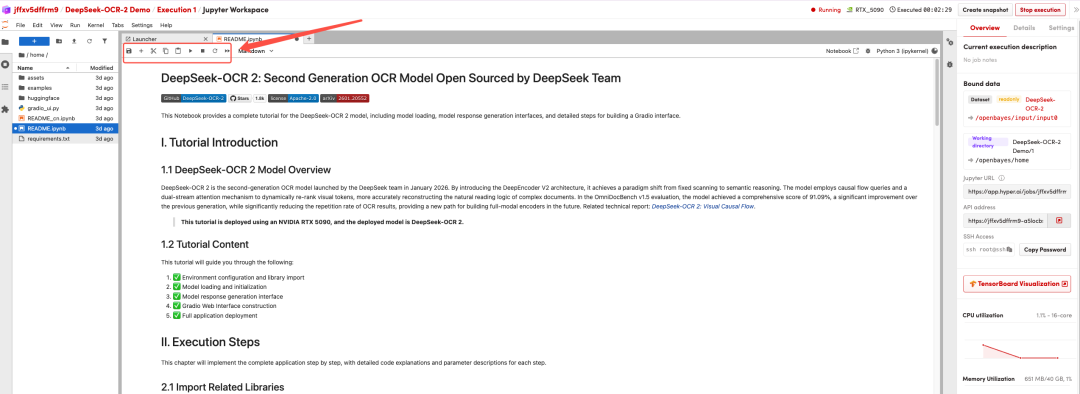

ページがリダイレクトされたら、左側の README ページをクリックし、上部の [実行] をクリックします。

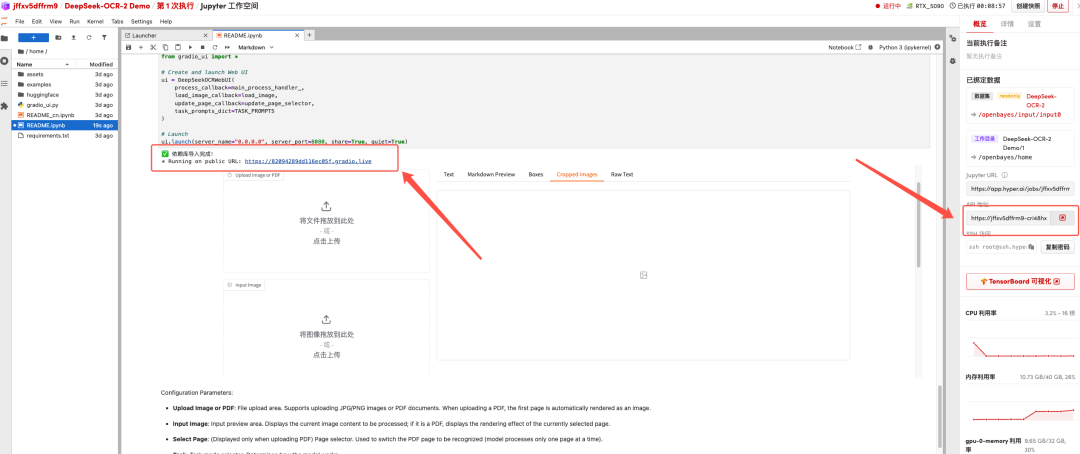

プロセスが完了したら、右側の API アドレスをクリックしてデモ ページに移動します。

以上が今回HyperAIがおすすめするチュートリアルです。ぜひ皆さんも体験してみてください!

チュートリアルのリンク:https://go.hyper.ai/2ma8d