Command Palette

Search for a command to run...

MAGI-1: Das Weltweit Erste Groß Angelegte Autoregressive Videogenerierungsmodell

Datum

Größe

31.53 MB

Lizenz

Apache 2.0

GitHub

Paper-URL

1. Einführung in das Tutorial

Magi-1, offiziell veröffentlicht am 21. April 2025 vom chinesischen KI-Unternehmen SendAI, ist das weltweit erste groß angelegte autoregressive Videogenerierungsmodell. Es generiert Videos, indem es mithilfe von Autoregression eine Reihe von Videoblöcken vorhersagt, die als Segmente aufeinanderfolgender Frames fester Länge definiert sind. Nach dem Training kann Magi-1 jeden Block von Rauschen befreien, dessen Intensität mit der Zeit monoton zunimmt, unterstützt kausale Zeitmodellierung und ermöglicht die Generierung von Streaming-Videos. Es erzielt eine hohe Leistung bei der Umwandlung von Bildern in Videos anhand von Textanweisungen und bietet hohe zeitliche Konsistenz und Skalierbarkeit. Dies wird durch mehrere algorithmische Innovationen und einen dedizierten Infrastruktur-Stack erreicht. Verwandte Forschungsarbeiten sind verfügbar. MAGI-1: Autoregressive Videogenerierung im großen Maßstab .

Dieses Tutorial verwendet Ressourcen für eine einzelne RTX 4090-Karte und der Text ist nur auf Englisch verfügbar.

2. Projektbeispiele

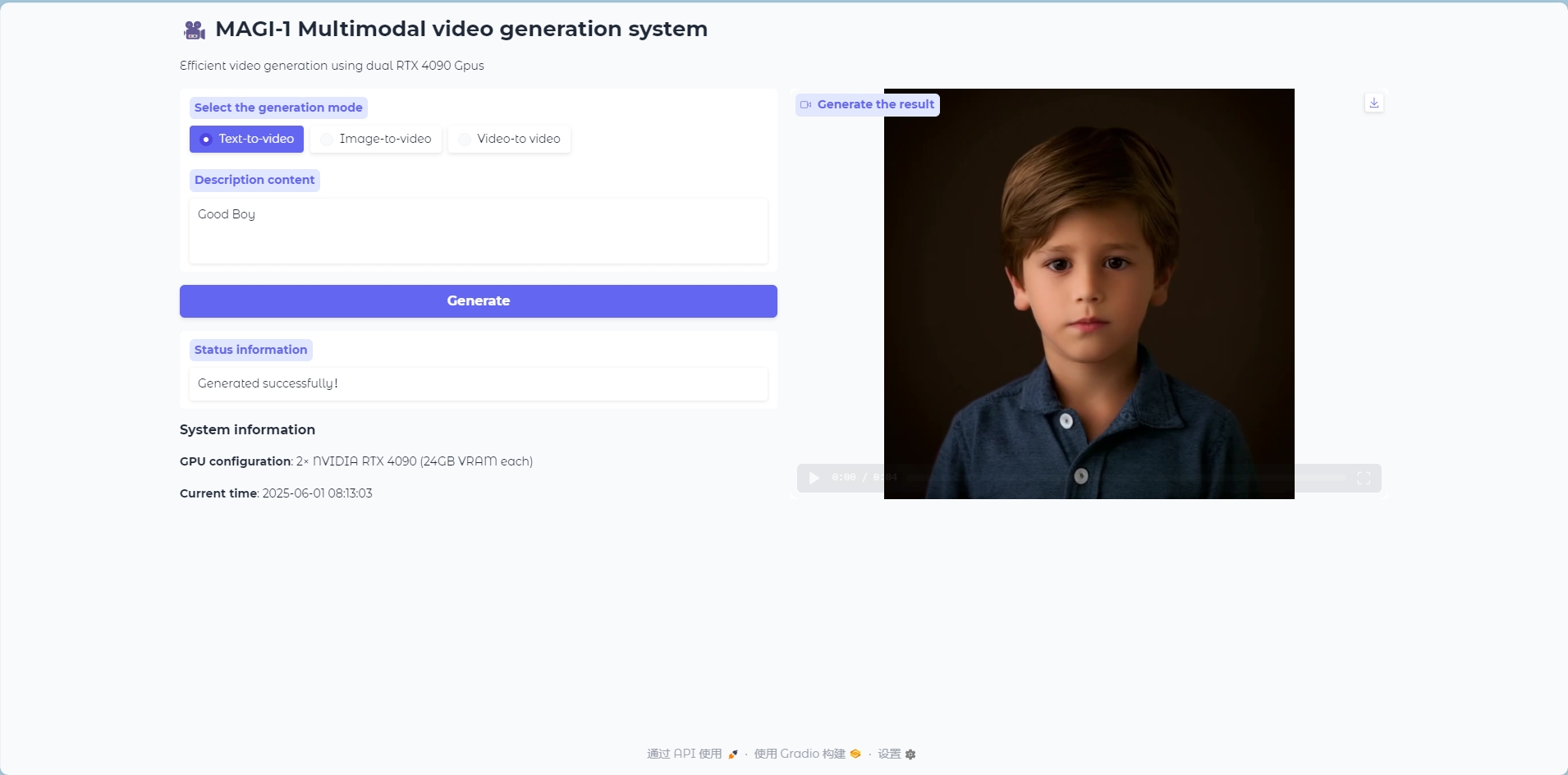

Text-zu-Video-Modus

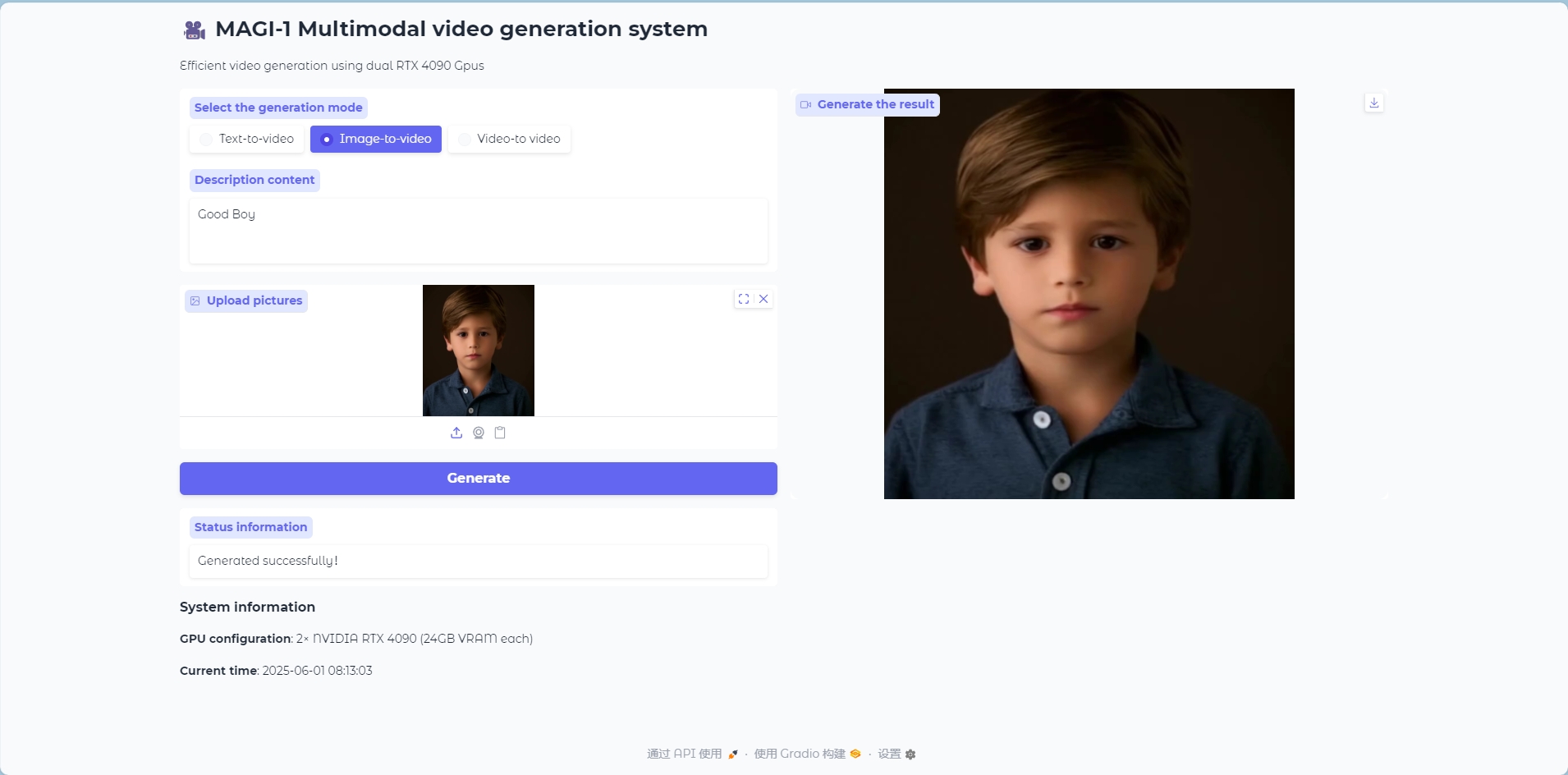

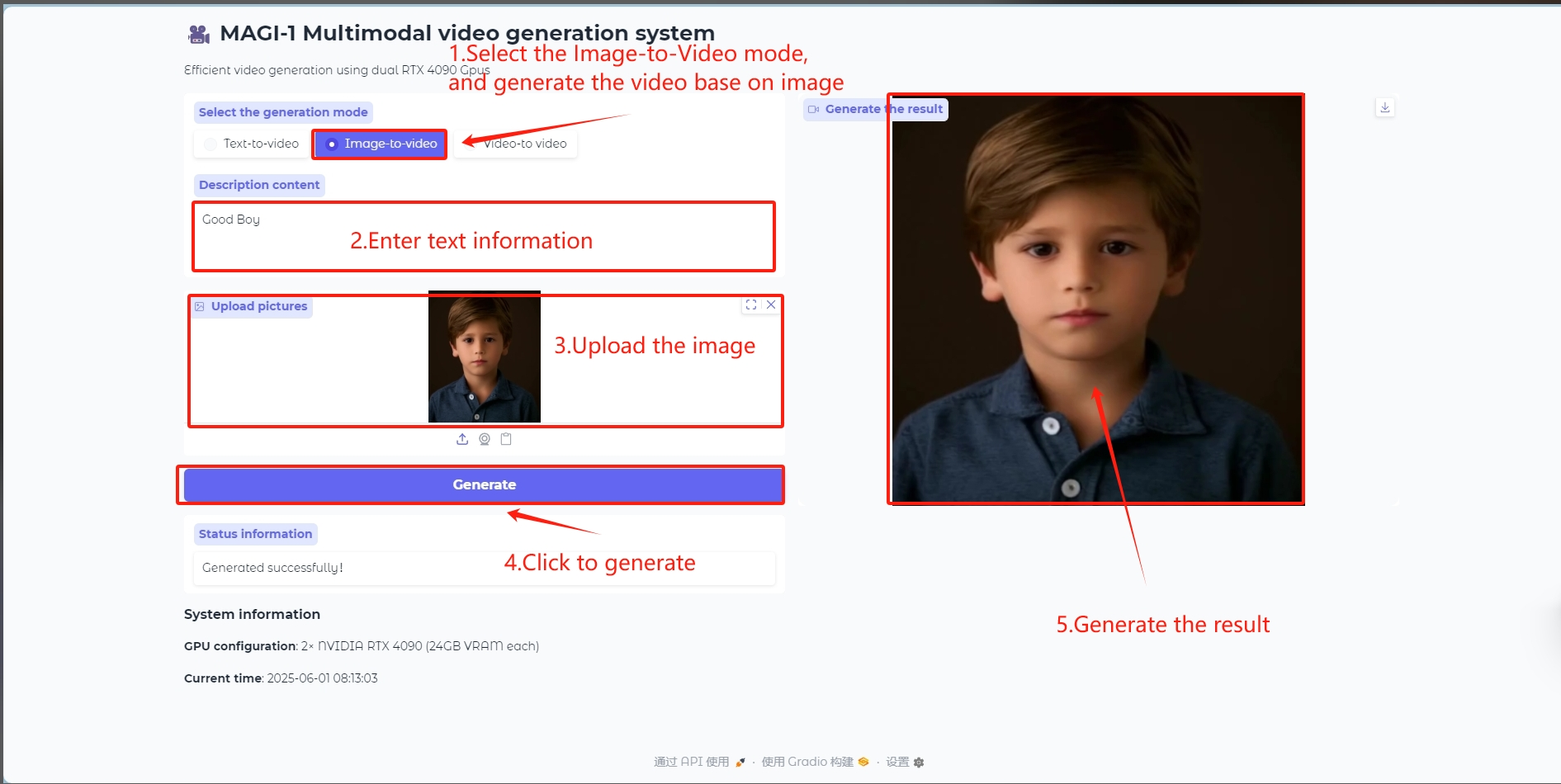

Bild-zu-Video-Modus

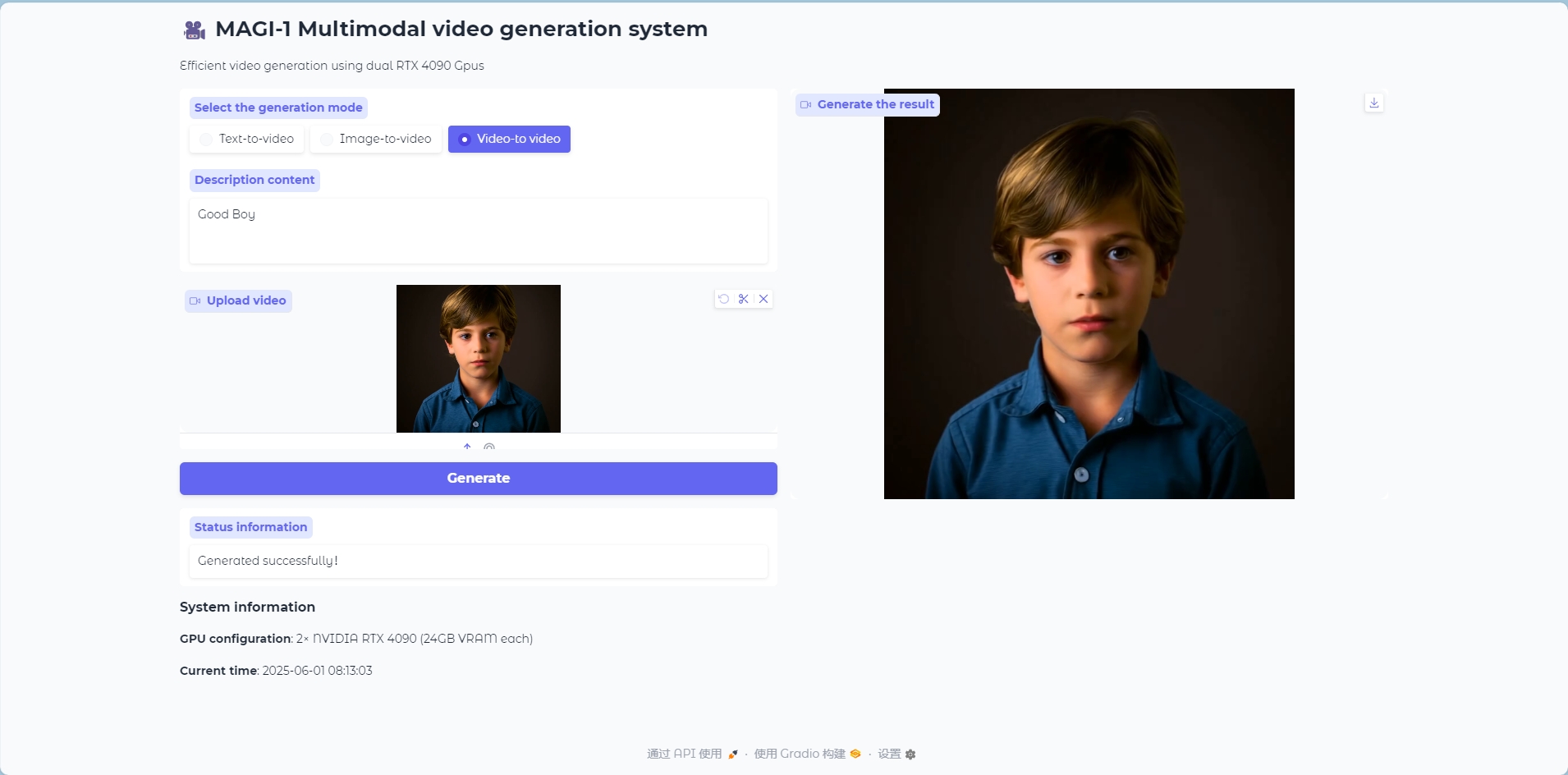

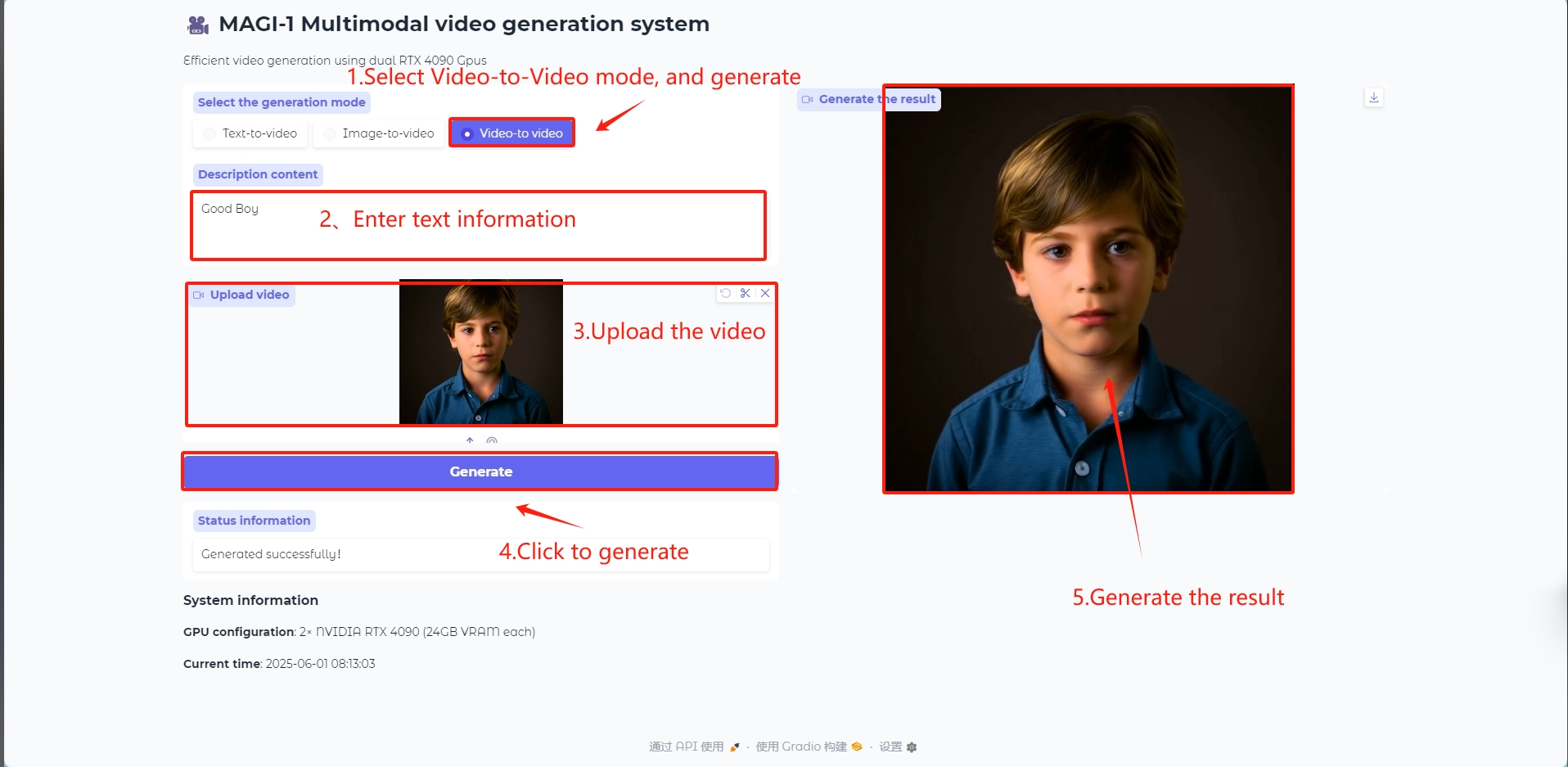

Video-zu-Video-Modus

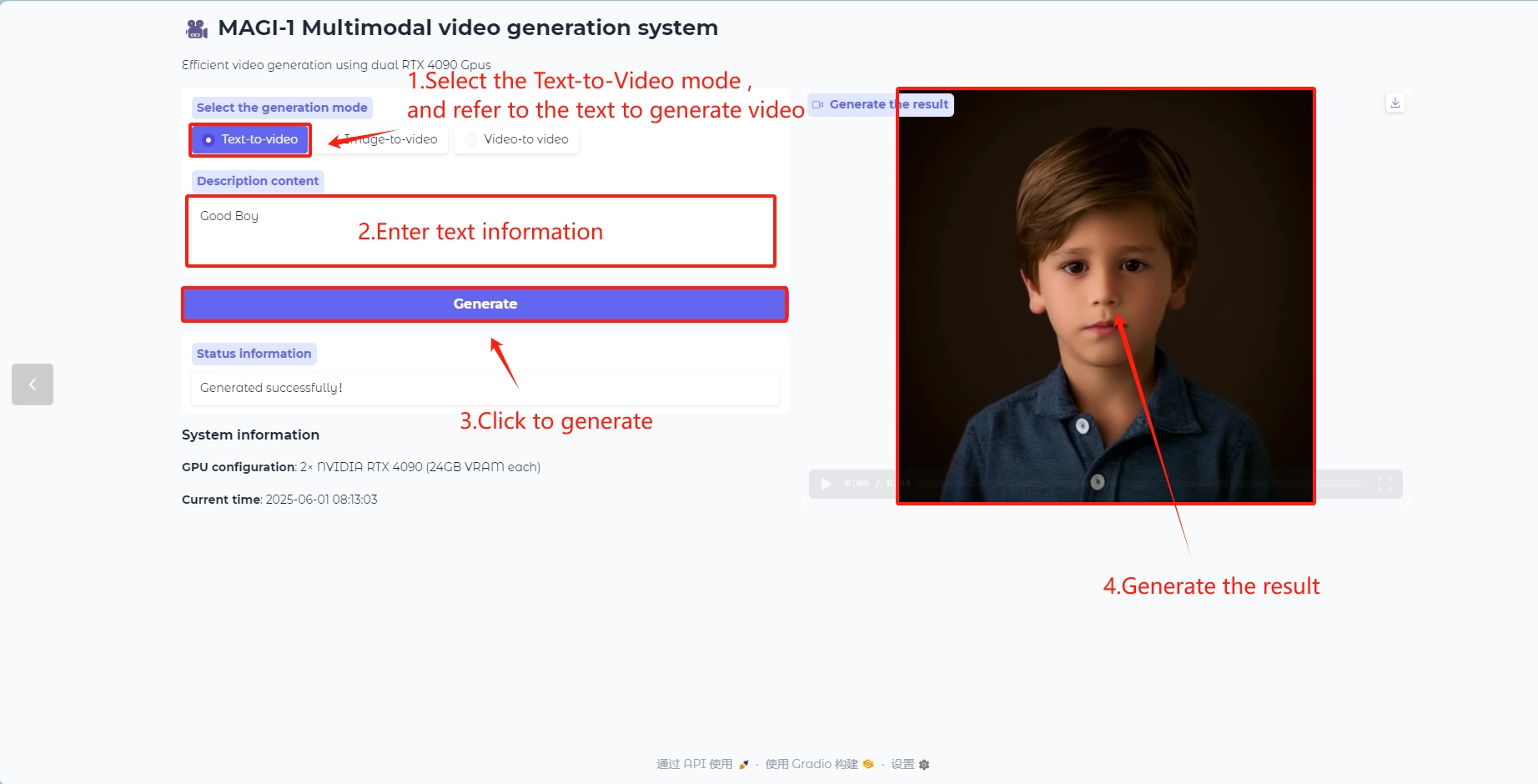

3. Bedienungsschritte

1. Klicken Sie nach dem Starten des Containers auf die API-Adresse, um die Weboberfläche aufzurufen

2. Nach dem Aufrufen der Webseite können Sie einen Sprachdialog mit dem Modell starten

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte 1–2 Minuten und aktualisieren Sie die Seite. Es dauert etwa fünf Minuten, bis das Modell ein Video generiert. Bitte haben Sie Geduld.

Anwendung

Text-zu-Video-Modell

Generieren Sie Videobilder mit Textinhalten

Bild-zu-Video-Modell

Geben Sie ein Bild als Referenz ein, um ein Videobild zu generieren

Video-zu-Video-Modell

Geben Sie ein Video als Referenz ein, um Videobilder zu generieren

In der runtime_config der Datei 4.5B_distill_quant_config.json im Pfad /openbayes/home/MAGI-1/example/4.5B können Sie die Parameter des generierten Videos ändern, z. B. num_frames, video_size_h, video_size_w und fps.

4. Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

V. Zitationsinformationen

Dank an den GitHub-Benutzer kjasdk Für die Bereitstellung dieses Lernprogramms lauten die Projektreferenzinformationen wie folgt:

@misc{ai2025magi1autoregressivevideogeneration,

title={MAGI-1: Autoregressive Video Generation at Scale},

author={Sand. ai and Hansi Teng and Hongyu Jia and Lei Sun and Lingzhi Li and Maolin Li and Mingqiu Tang and Shuai Han and Tianning Zhang and W. Q. Zhang and Weifeng Luo and Xiaoyang Kang and Yuchen Sun and Yue Cao and Yunpeng Huang and Yutong Lin and Yuxin Fang and Zewei Tao and Zheng Zhang and Zhongshu Wang and Zixun Liu and Dai Shi and Guoli Su and Hanwen Sun and Hong Pan and Jie Wang and Jiexin Sheng and Min Cui and Min Hu and Ming Yan and Shucheng Yin and Siran Zhang and Tingting Liu and Xianping Yin and Xiaoyu Yang and Xin Song and Xuan Hu and Yankai Zhang and Yuqiao Li},

year={2025},

eprint={2505.13211},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2505.13211},

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.