Command Palette

Search for a command to run...

Wan2.2-Animate-14B: オープンな大規模ビデオ生成モデル

1. チュートリアルの概要

Wan2.2-Animate-14Bは、アリババのTongyi Wanxiangチームが2025年9月にオープンソース化したアクション生成モデルです。このモデルは、アクション模倣モードとロールプレイングモードの両方をサポートし、パフォーマーの動画から表情や動きを正確に再現することで、非常にリアルなキャラクターアニメーション動画を生成します。このモデルは、アニメーションキャラクターを元の動画にシームレスに置き換えることができ、シーンの照明や色調に完璧にマッチさせることができます。Wanモデルをベースに、空間的に整合された骨格信号を介して手足の動きを制御し、ソース画像から抽出された暗黙的な顔の特徴を用いて表情を再現することで、制御性が高く表現力豊かなキャラクター動画生成を実現します。関連研究論文には以下が含まれます… Wan-Animate: 包括的な複製による統合キャラクターアニメーションと置き換え 。

このチュートリアルでは、コンピューティング リソースとして単一の RTX PRO 6000 グラフィック カードを使用します。

2. エフェクト表示

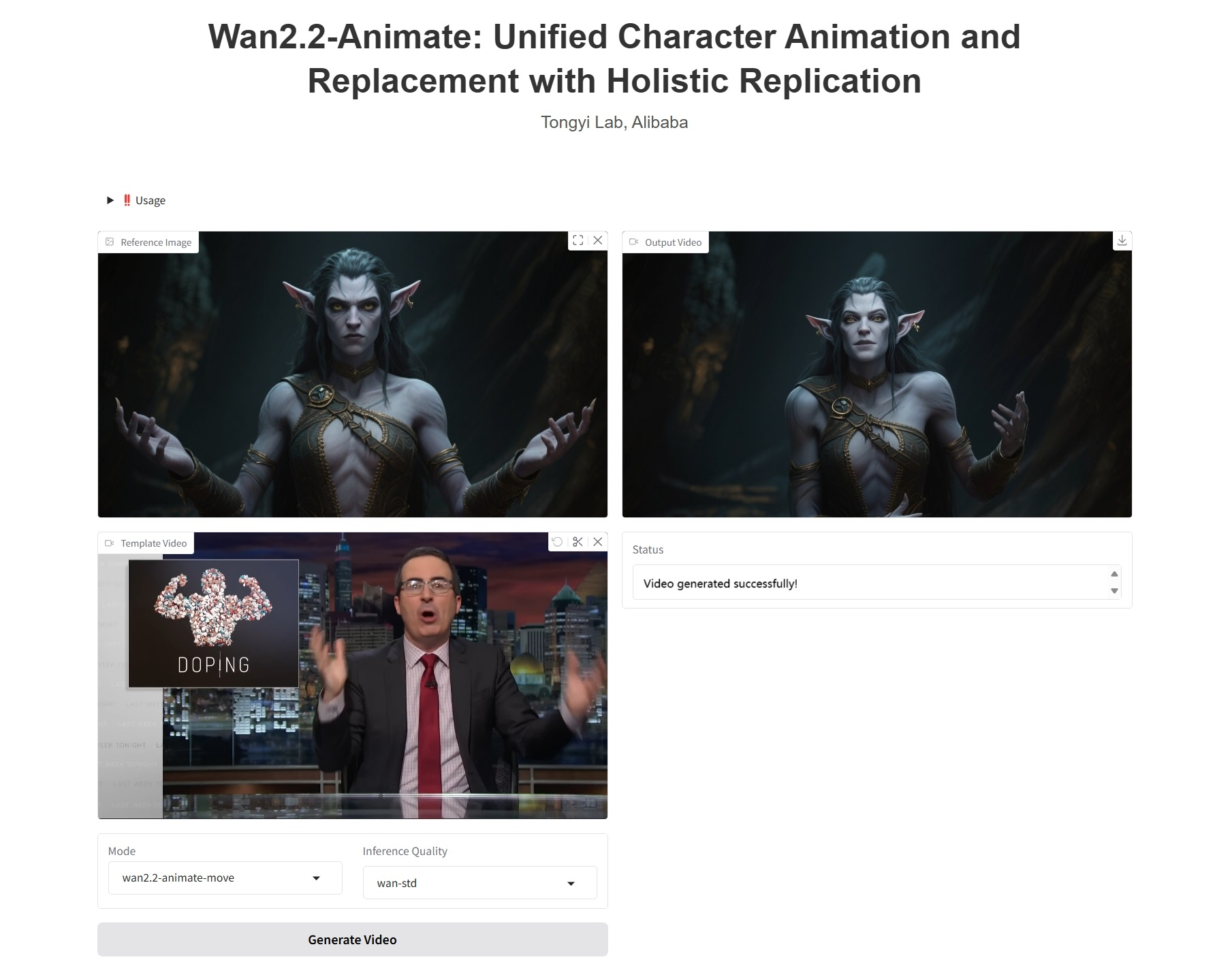

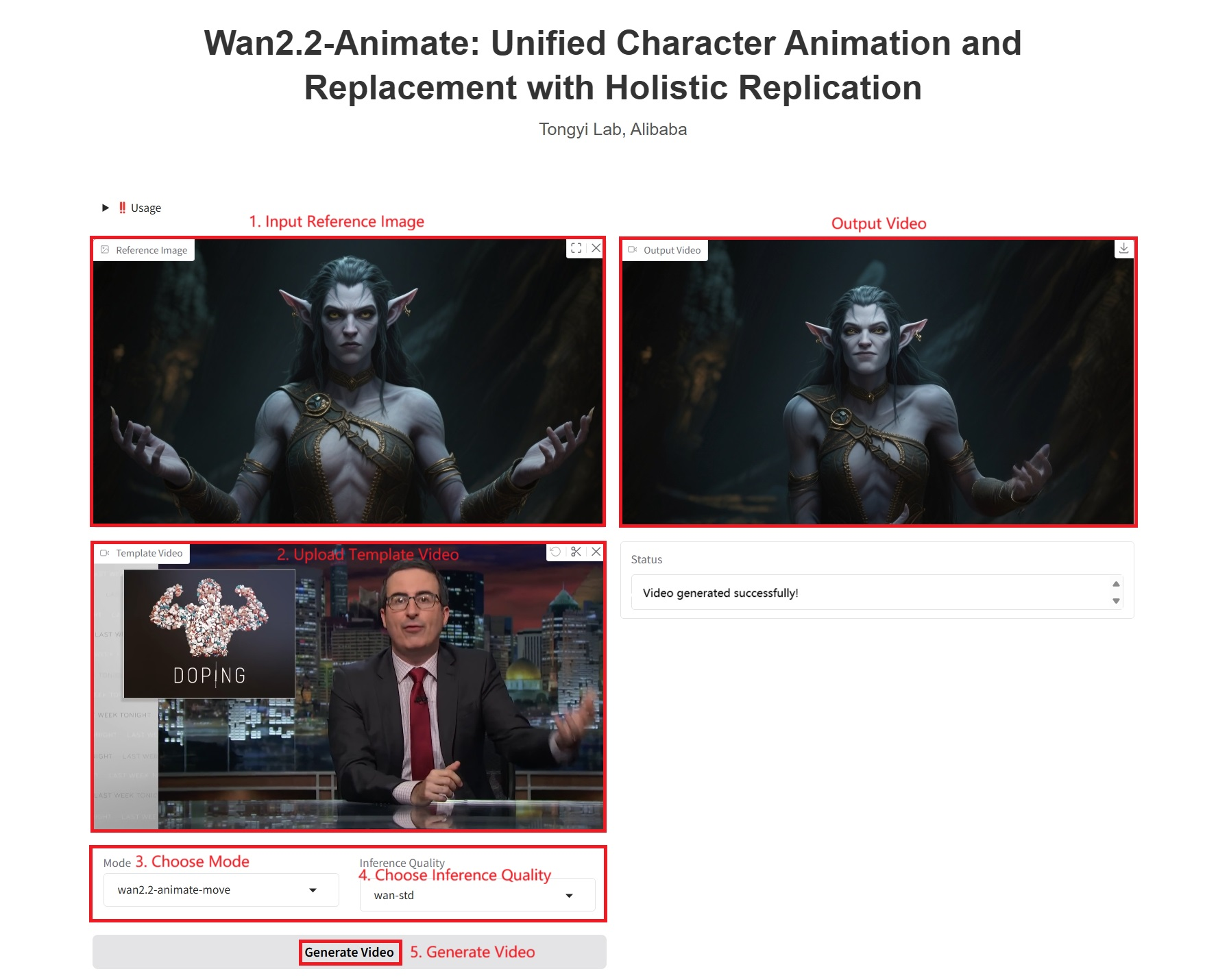

3. 操作手順

1. コンテナを起動します

2. 使用手順

「Bad Gateway」と表示される場合、モデルが初期化中であることを意味します。モデルが大きいため、1〜2分ほど待ってページを更新してください。

注: 推論品質を選択した場合、wan-pro によって生成されるビデオの品質が高くなるほど、生成にかかる時間は長くなります。例 1 では約 1200 秒かかります。

具体的なパラメータ:

- モード:

- wan2.2-animate-move: アクション模倣。キャラクター画像と参照ビデオを入力として受け取ります。モデルは参照ビデオから入力キャラクター画像にキャラクターの動きと表情を転送し、静的なキャラクターを躍動的で表情豊かに表現します。

- wan2.2-animate-mix: 元のビデオの動き、表情、環境を維持しながら、ビデオ内のキャラクターを入力画像のキャラクターに置き換え、シームレスな統合を実現するキャラクター置換。

- 推論品質:

- wan-pro: 高品質な生成。

- wan-std: パフォーマンスと効率性のバランスをとった標準バージョン。

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

引用情報

このプロジェクトの引用情報は次のとおりです。

@article{wan2025,

title={Wan: Open and Advanced Large-Scale Video Generative Models},

author={Team Wan and Ang Wang and Baole Ai and Bin Wen and Chaojie Mao and Chen-Wei Xie and Di Chen and Feiwu Yu and Haiming Zhao and Jianxiao Yang and Jianyuan Zeng and Jiayu Wang and Jingfeng Zhang and Jingren Zhou and Jinkai Wang and Jixuan Chen and Kai Zhu and Kang Zhao and Keyu Yan and Lianghua Huang and Mengyang Feng and Ningyi Zhang and Pandeng Li and Pingyu Wu and Ruihang Chu and Ruili Feng and Shiwei Zhang and Siyang Sun and Tao Fang and Tianxing Wang and Tianyi Gui and Tingyu Weng and Tong Shen and Wei Lin and Wei Wang and Wei Wang and Wenmeng Zhou and Wente Wang and Wenting Shen and Wenyuan Yu and Xianzhong Shi and Xiaoming Huang and Xin Xu and Yan Kou and Yangyu Lv and Yifei Li and Yijing Liu and Yiming Wang and Yingya Zhang and Yitong Huang and Yong Li and You Wu and Yu Liu and Yulin Pan and Yun Zheng and Yuntao Hong and Yupeng Shi and Yutong Feng and Zeyinzi Jiang and Zhen Han and Zhi-Fan Wu and Ziyu Liu},

journal = {arXiv preprint arXiv:2503.20314},

year={2025}

}