Command Palette

Search for a command to run...

GroundingME 複雑シーン理解評価データセット

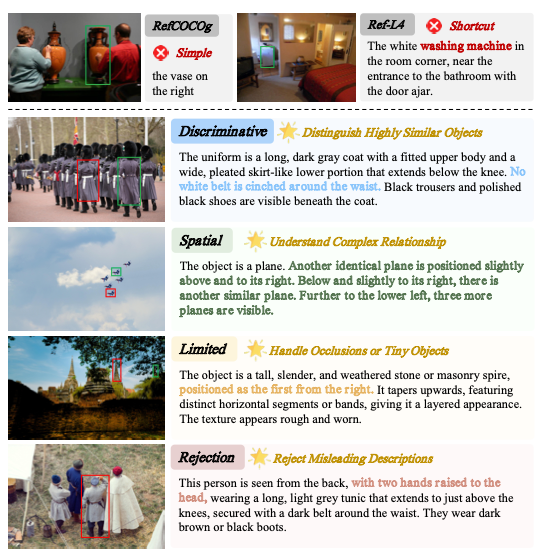

GroundingMEは、清華大学がXiaomi、香港大学などの機関と共同で2025年に公開した、マルチモーダル大規模言語モデル(MLLM)の視覚的参照評価データセットです。関連研究論文には以下が含まれます… GroundingME: 多次元評価によるMLLMの視覚的グラウンディングギャップの解明目的は、あいまいな参照、複雑な空間関係、小さなターゲット、遮蔽、非参照性などの状況での理解と安全パフォーマンスに特に注意を払いながら、現実世界の複雑なシナリオで自然言語を視覚ターゲットに正確にマッピングするモデルの能力を体系的に評価することです。

このデータセットには、1,005個の評価サンプルが含まれています。画像は、SA-1BとHR-Benchという2つの高品質データセットから取得され、データの汚染を防ぐため、タスクの構築には元の画像のみが使用されました。サンプルは、識別参照(204サンプル、20.31 TP3T)、空間関係理解(300サンプル、29.91 TP3T)、視界制限シーン(300サンプル、29.91 TP3T)、非参照拒否タスク(201サンプル、20.01 TP3T)の4つの主要タスクカテゴリをカバーし、さらにバランスの取れた分布を持つ12の二次サブタスクに細分化されています。このデータセットには、241の現実世界のオブジェクトクラスが含まれています。1枚の画像には同じクラスのオブジェクトが多数含まれており、オブジェクトインスタンスは通常、画像全体のわずかな部分を占めます。言語記述の長さは既存の参照データセットよりも大幅に長く、多次元からの視覚参照タスクの難易度が大幅に増加します。