Command Palette

Search for a command to run...

ScaleNet

ScaleNet 是由北京理工大学、华为诺亚方舟实验室及香港城市大学等高校机构的研究团队于 2025 年 10 月联合提出的,相关研究成果发表于论文 ScaleNet: Scaling up Pretrained Neural Networks with Incremental Parameters 。

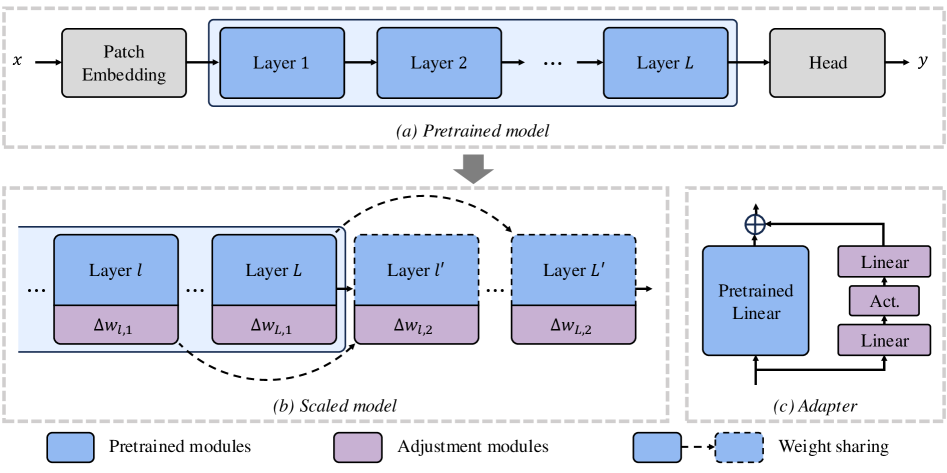

ScaleNet 是一种用于扩展 ViT 模型的效率方法。不同于从头开始的传统训练方式,该范式通过极小地增加参数量,在现有预训练模型的基础上实现快速模型扩展,这为 ViT 的扩展提供了一种经济高效的解决方案。具体而言,ScaleNet 通过在预训练的 ViTs 中插入额外层来实现模型扩展,利用逐层权重共享来保持参数效率。在 ImageNet-1K 数据集上进行的大量实验表明,ScaleNet 显著优于从头开始训练扩展模型,在 2 × 深度扩展的 DeiT-Base 模型上仅需三分之一训练周期即可实现 7.42% 的精度提升。