Command Palette

Search for a command to run...

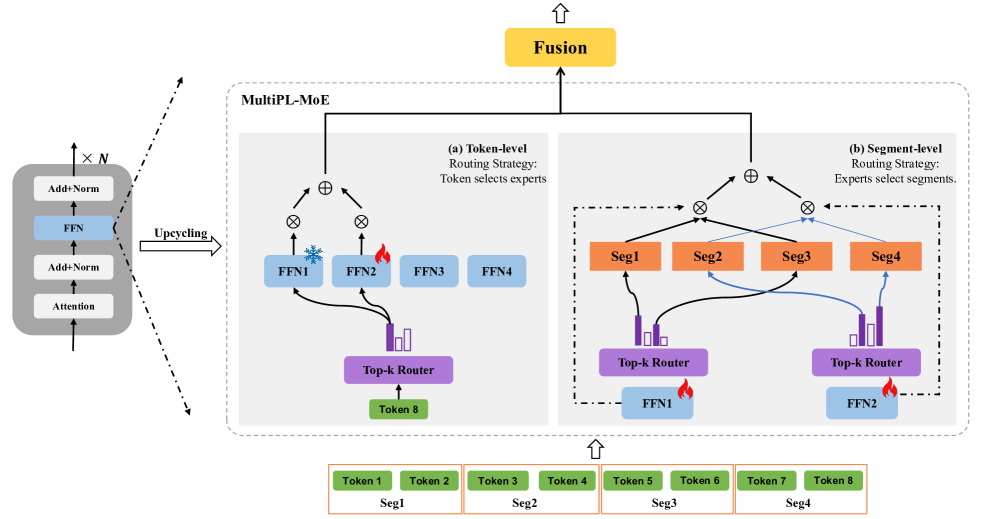

هندسة MultiPL-MoE (لغة برمجة متعددة MoE)

تم اقتراح MultiPL-MoE من قبل معهد أبحاث الهاتف المحمول الصيني في أغسطس 2025، وتم نشر نتائج البحث ذات الصلة في الورقة "MultiPL-MoE: توسعة نماذج اللغات الكبيرة متعددة اللغات من خلال مزيج هجين من الخبراءوقد تم قبول الدراسة من قبل EMNLP 2025.

MultiPL-MoE هو امتداد متعدد لغات البرمجة (MultiPL) لبرامج ماجستير إدارة الأعمال، يُنفَّذ من خلال هجين خبير هجين (MoE). بخلاف أساليب MoE السابقة لامتدادات اللغات الطبيعية المتعددة، والتي تُركِّز على اتساق اللغة الداخلي من خلال التنبؤ بالوسوم اللاحقة، لكنها تُهمِل البنية النحوية الداخلية للغات البرمجة، يستخدم MultiPL-MoE بنية MoE هجينة جديدة للتعلم الدقيق للخصائص الدلالية على مستوى الوسوم والخصائص النحوية على مستوى الأجزاء، مما يُمكِّن النموذج من استنتاج بنية الشيفرة من خلال التعرف على العناصر النحوية المختلفة وتصنيفها.

بناء الذكاء الاصطناعي بالذكاء الاصطناعي

من الفكرة إلى الإطلاق — سرّع تطوير الذكاء الاصطناعي الخاص بك مع المساعدة البرمجية المجانية بالذكاء الاصطناعي، وبيئة جاهزة للاستخدام، وأفضل أسعار لوحدات معالجة الرسومات.