Command Palette

Search for a command to run...

SmolLM3-3Bモデルのワンクリック展開

1. チュートリアルの概要

SmolLM3-3Bは、Hugging Face TB(Transformer Big)チームによって2025年7月にオープンソース化され、「エッジパフォーマンスの限界」と位置付けられました。関連する研究論文には以下が含まれます。 SmolLM3: smol、多言語、長文推論エンジン これは、コンパクトな 3B サイズの小さなモデルのパフォーマンスの限界を打ち破るように設計された、30 億のパラメータを備えた革新的なオープンソース言語モデルです。

このチュートリアルでは、RTX 5090(32 GB)グラフィックカード1枚とPyTorch 2.8 + CUDA 12.8のインストール環境を使用します。Gradioアプリケーションの読み込み時間は2~3分と推定されます。

2. プロジェクト例

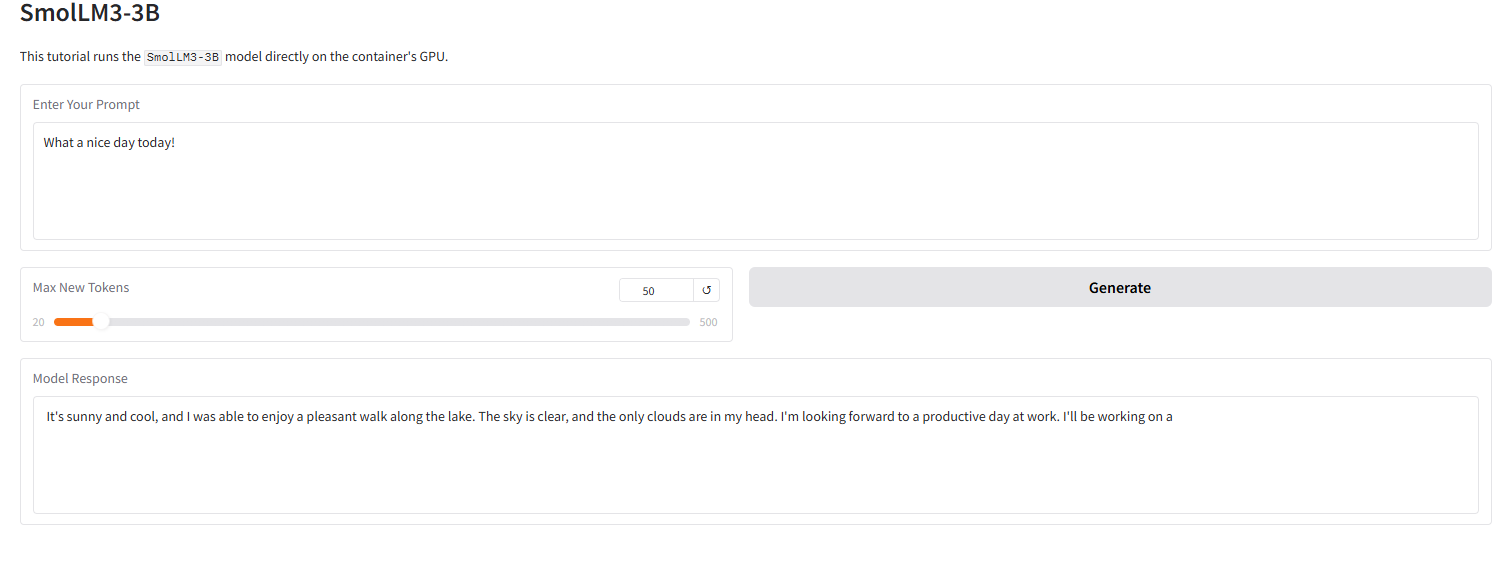

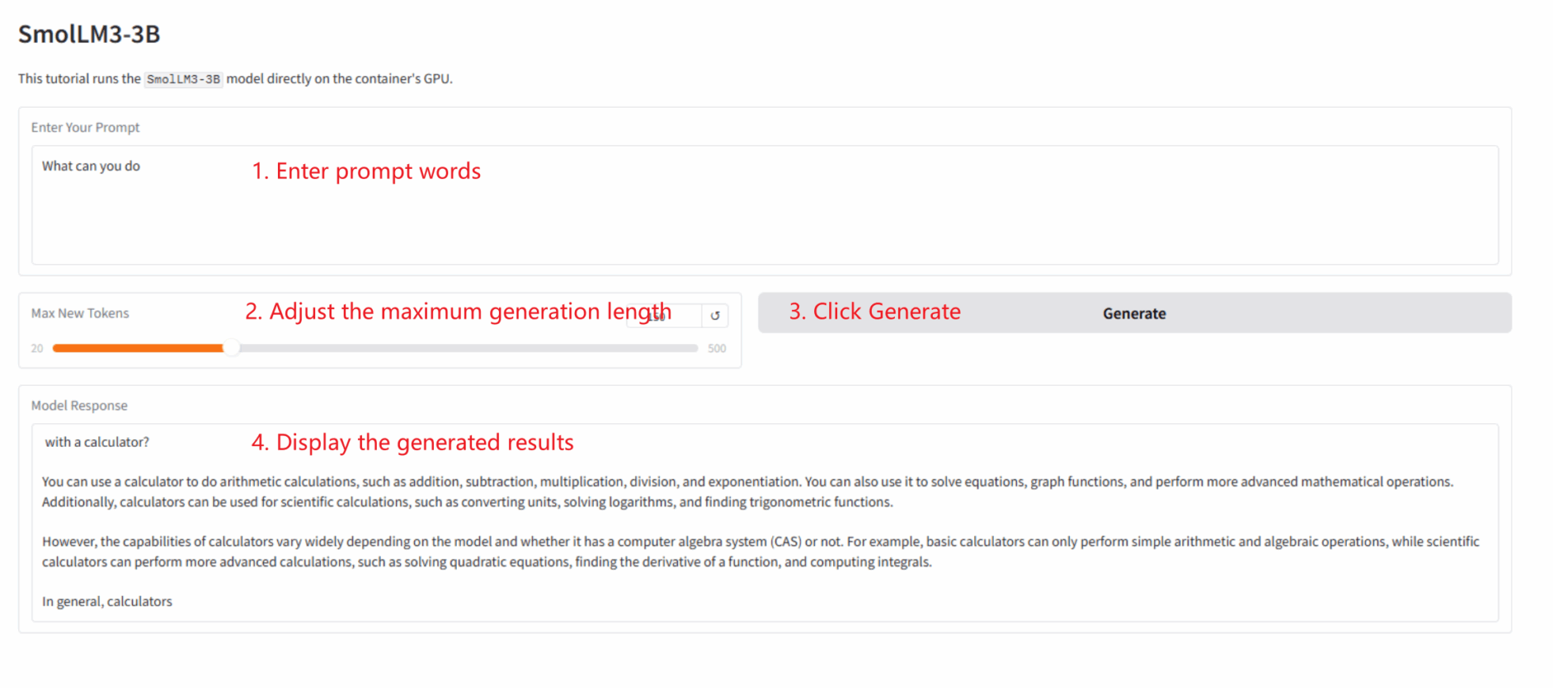

下の画像は、このチュートリアルにおけるGradoインターフェースの効果を示しています。プロンプトワードを入力すると、モデルは4ビットの量子化された応答を正常に生成しました。

3. 操作手順

このセクションには、ワンクリック起動の手順、コード ディレクトリ構造、およびよくある質問が記載されています。

このチュートリアルでは、Gradioアプリをワンクリックでデプロイする方法を説明します。ユーザーはコードを実行する必要はなく、以下の手順に従うだけです。

1. クローン作成チュートリアル: このページの右上隅にある「複製」をクリックして、個人用コンテナを作成します。

2. コンテナを起動して待機します。 システムは自動的にコンテナを起動します (推奨)。 RTX 5090)。 dependencies.sh スクリプトはバックグラウンドで自動的に実行され、4 ビットの量子化モデルが読み込まれます。このプロセスには約2〜3分かかります。

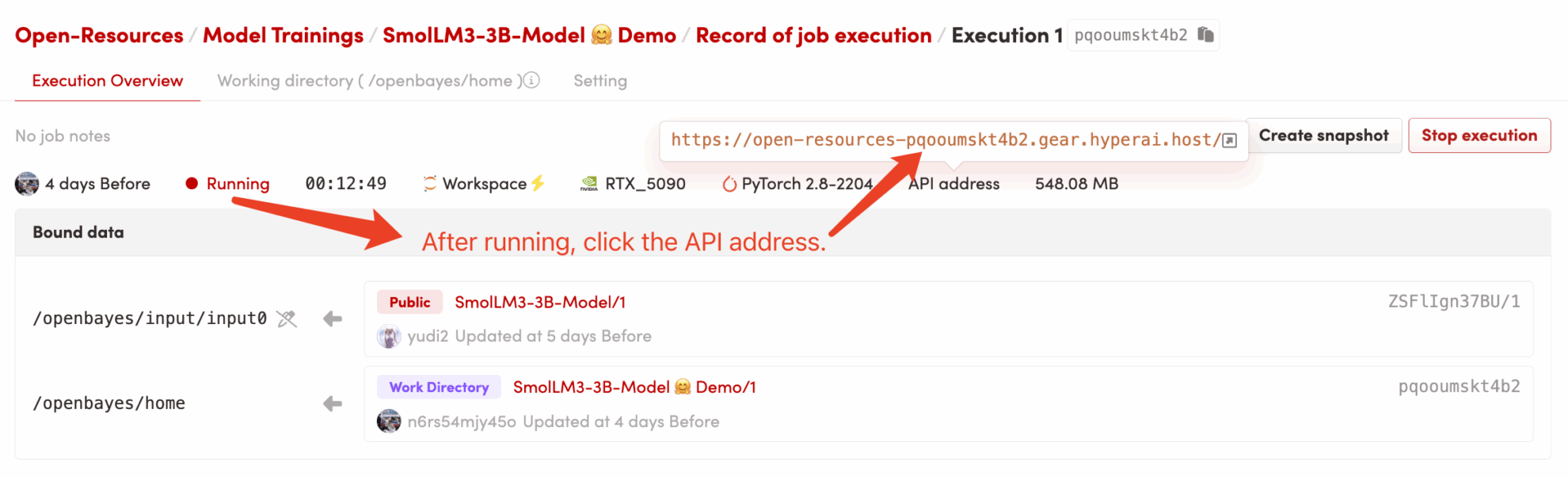

3. アプリケーションにアクセスします: コンテナのステータスが「実行中」に変わったら、コンテナの詳細ページで「API アドレス」をクリックして Grado インターフェースを開きます。

コードディレクトリ構造

/openbayes/home |-- app.py \# Gradio 应用的启动脚本 |-- requirements.txt \# 锁定的 Python 依赖包 (已预装) |-- dependencies.sh \# 平台自动化执行脚本 (仅启动 app) |-- README\_cn.md \# 本教程说明文档 (中文) \`-- README\_en.md \# 本教程说明文档 (英文) /openbayes/input/input0 # 只读绑定的 SmolLM3-3B 模型文件

よくある質問

- Q: 「API アドレス」をクリックした後、ページが読み込まれない、または「502」が表示されますか? A: モデルが読み込まれているためです。

SmolLM3-3B大規模なモデルのため、4ビット量子化バージョンでもGPUに完全に読み込むまでに2~3分かかります。ページを更新する前に数分お待ちください。 - Q: ログには

OSError: Cannot find empty port 8080? A: これは、ユーザー(またはシステム)がアプリケーションを複数回起動しようとしたために、ポート8080が「ゾンビプロセス」によって占有されているために発生します。コンテナターミナルでアプリケーションを実行するだけで済みます。pkill -f "python /openbayes/home/app.py"古いプロセスをクリーンアップして再実行します。bash /openbayes/home/dependencies.shそれだけです。

引用情報

@misc{bakouch2025smollm3,

title={{SmolLM3: smol, multilingual, long-context reasoner}},

author={Bakouch, Elie and Ben Allal, Loubna and Lozhkov, Anton and Tazi, Nouamane and Tunstall, Lewis and Patiño, Carlos Miguel and Beeching, Edward and Roucher, Aymeric and Reedi, Aksel Joonas and Gallouédec, Quentin and Rasul, Kashif and Habib, Nathan and Fourrier, Clémentine and Kydlicek, Hynek and Penedo, Guilherme and Larcher, Hugo and Morlon, Mathieu and Srivastav, Vaibhav and Lochner, Joshua and Nguyen, Xuan-Son and Raffel, Colin and von Werra, Leandro and Wolf, Thomas},

year={2025},

howpublished={\url{[https://huggingface.co/blog/smollm3](https://huggingface.co/blog/smollm3)}}

}