Command Palette

Search for a command to run...

Wan2.2-Animate-14B : Modèle Ouvert Avancé De Génération De Vidéos À Grande Échelle

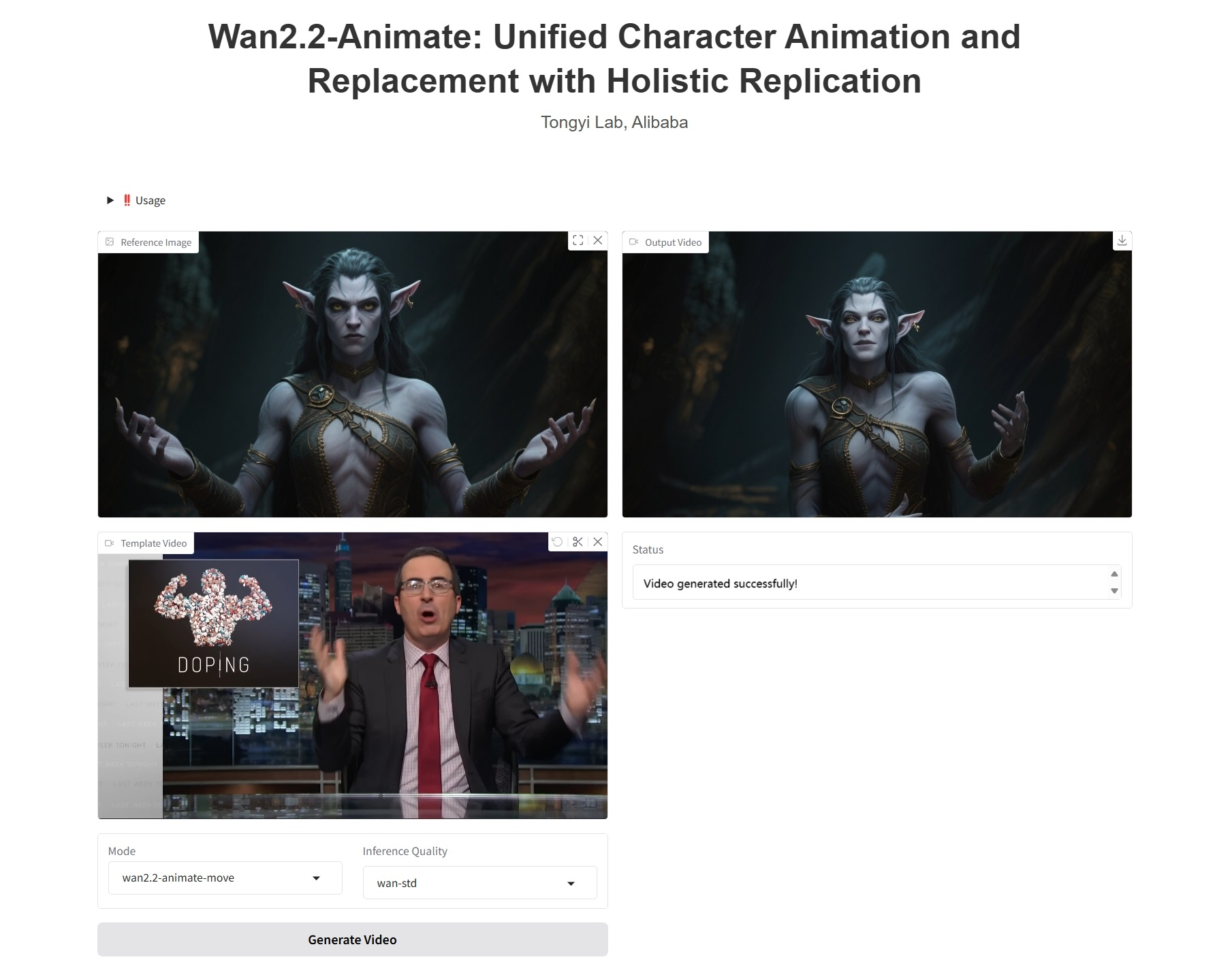

1. Introduction au tutoriel

Wan2.2-Animate-14B est un modèle de génération d'actions open source développé par l'équipe Tongyi Wanxiang d'Alibaba en septembre 2025. Ce modèle prend en charge l'imitation d'actions et le jeu de rôle, reproduisant fidèlement les expressions faciales et les mouvements des acteurs à partir de vidéos afin de générer des animations de personnages très réalistes. Il peut intégrer harmonieusement des personnages animés dans la vidéo originale, en respectant parfaitement l'éclairage et les couleurs de la scène. Basé sur le modèle Wan, il contrôle les mouvements des membres grâce à des signaux squelettiques spatialement alignés et recrée les expressions à partir de caractéristiques faciales implicites extraites de l'image source, permettant ainsi une génération de personnages expressifs et hautement contrôlables. Articles de recherche associés :… Wan-Animate : animation et remplacement unifiés des personnages avec réplication holistique .

Ce tutoriel utilise une seule carte graphique RTX PRO 6000 comme ressource de calcul.

2. Affichage des effets

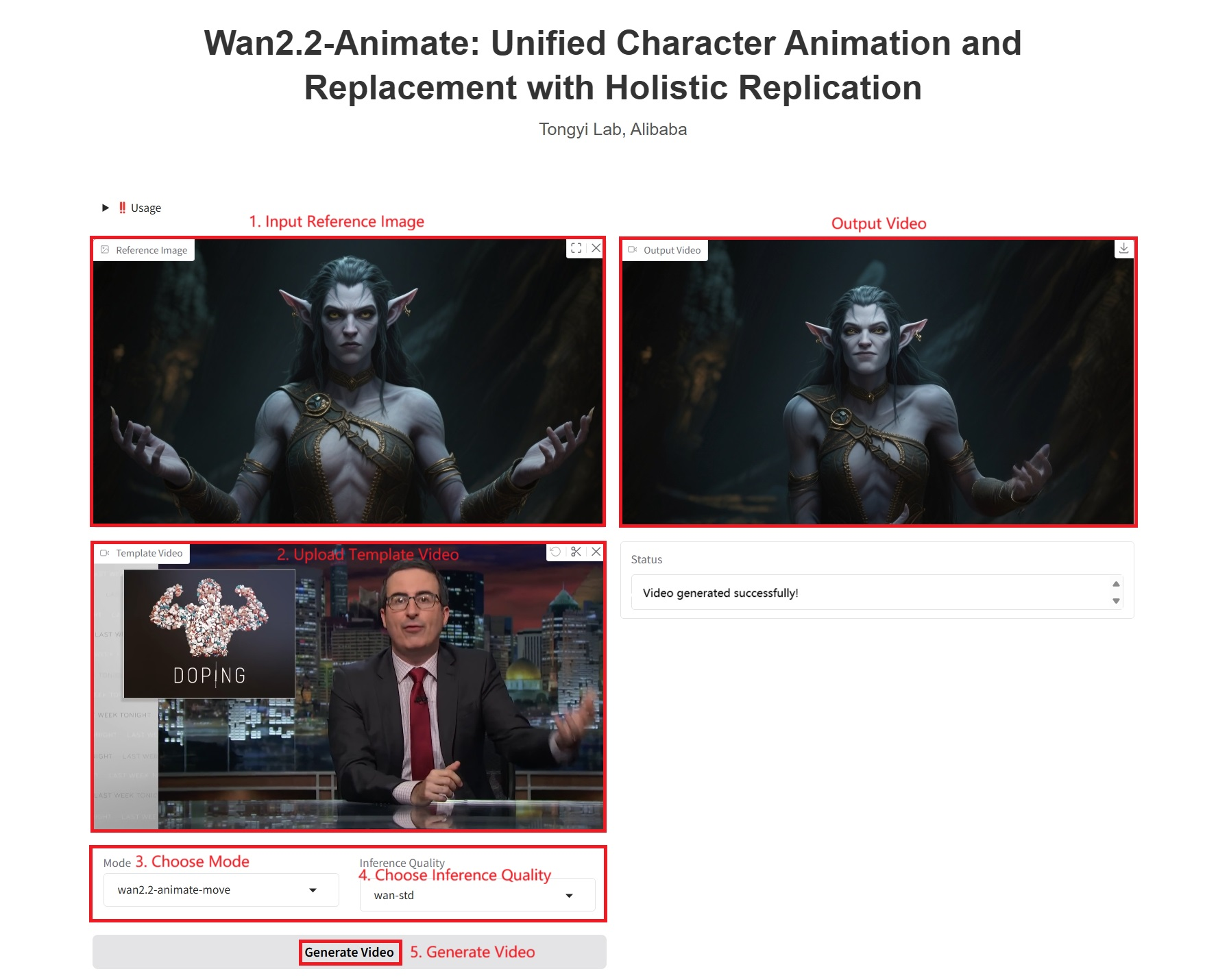

3. Étapes de l'opération

1. Démarrez le conteneur

2. Étapes d'utilisation

Si « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 1 à 2 minutes et actualiser la page.

Remarque : Lorsque vous sélectionnez « Qualité d'inférence », plus la qualité de la vidéo générée par Wan-Pro est élevée, plus la génération sera longue. L'exemple 1 prend environ 1 200 secondes.

Paramètres spécifiques :

- Mode:

- wan2.2-animate-move : Imitation d'action. Prend en entrée une image de personnage et une vidéo de référence. Le modèle transfère les mouvements et expressions du personnage de la vidéo de référence à l'image d'entrée, rendant le personnage statique dynamique et expressif.

- wan2.2-animate-mix : remplacement de caractères, qui remplace les caractères d'une vidéo par ceux d'une image d'entrée tout en préservant les mouvements, les expressions et l'environnement de la vidéo d'origine, réalisant ainsi une intégration transparente.

- Qualité de l'inférence :

- wan-pro : génération de haute qualité.

- wan-std : Version standard, équilibrant performances et efficacité.

4. Discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

Informations sur la citation

Les informations de citation pour ce projet sont les suivantes :

@article{wan2025,

title={Wan: Open and Advanced Large-Scale Video Generative Models},

author={Team Wan and Ang Wang and Baole Ai and Bin Wen and Chaojie Mao and Chen-Wei Xie and Di Chen and Feiwu Yu and Haiming Zhao and Jianxiao Yang and Jianyuan Zeng and Jiayu Wang and Jingfeng Zhang and Jingren Zhou and Jinkai Wang and Jixuan Chen and Kai Zhu and Kang Zhao and Keyu Yan and Lianghua Huang and Mengyang Feng and Ningyi Zhang and Pandeng Li and Pingyu Wu and Ruihang Chu and Ruili Feng and Shiwei Zhang and Siyang Sun and Tao Fang and Tianxing Wang and Tianyi Gui and Tingyu Weng and Tong Shen and Wei Lin and Wei Wang and Wei Wang and Wenmeng Zhou and Wente Wang and Wenting Shen and Wenyuan Yu and Xianzhong Shi and Xiaoming Huang and Xin Xu and Yan Kou and Yangyu Lv and Yifei Li and Yijing Liu and Yiming Wang and Yingya Zhang and Yitong Huang and Yong Li and You Wu and Yu Liu and Yulin Pan and Yun Zheng and Yuntao Hong and Yupeng Shi and Yutong Feng and Zeyinzi Jiang and Zhen Han and Zhi-Fan Wu and Ziyu Liu},

journal = {arXiv preprint arXiv:2503.20314},

year={2025}

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.