Command Palette

Search for a command to run...

SAM3 : Modèle De Segmentation Visuelle

Date

Taille

414.85 MB

Balises

Licence

Other

GitHub

URL du document

1. Introduction au tutoriel

SAM3 est un modèle de vision par ordinateur avancé, lancé par Meta AI en novembre 2025. Ce modèle détecte, segmente et suit les objets dans les images et les vidéos à partir de texte, d'exemples et d'indices visuels. Il prend en charge la saisie de phrases à vocabulaire ouvert, offre de puissantes capacités d'interaction intermodale et corrige les résultats de segmentation en temps réel. SAM3 surpasse les systèmes existants en matière de segmentation d'images et de vidéos, avec des performances deux fois supérieures, et prend en charge l'apprentissage zéro-shot. Le modèle permet la reconstruction 3D et trouve des applications dans divers contextes, tels que la prévisualisation de vidéos personnelles, le montage vidéo créatif et la recherche scientifique, contribuant ainsi fortement au développement futur de la vision par ordinateur. Des articles de recherche associés sont disponibles. SAM 3 : Segmenter tout ce qui contient des concepts .

Ce tutoriel utilise par défaut une seule carte graphique RTX 5090, mais peut être exécuté avec une RTX 4090 au minimum. Trois exemples sont fournis pour les tests : segmentation d’images, affichage de texte dans une vidéo et affichage de points/boîtes dans une vidéo. Le modèle ne prend en charge que la saisie en anglais.

2. Affichage des effets

3. Étapes de l'opération

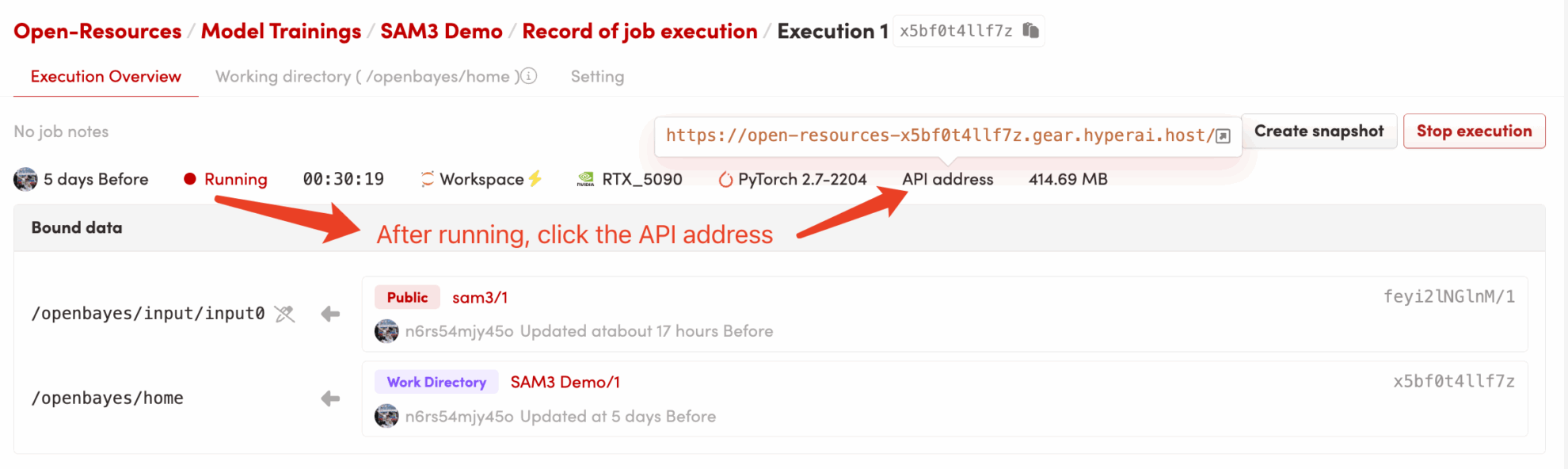

1. Démarrez le conteneur

2. Étapes d'utilisation

Si « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Étant donné que le modèle est grand, veuillez patienter environ 2 à 3 minutes et actualiser la page.

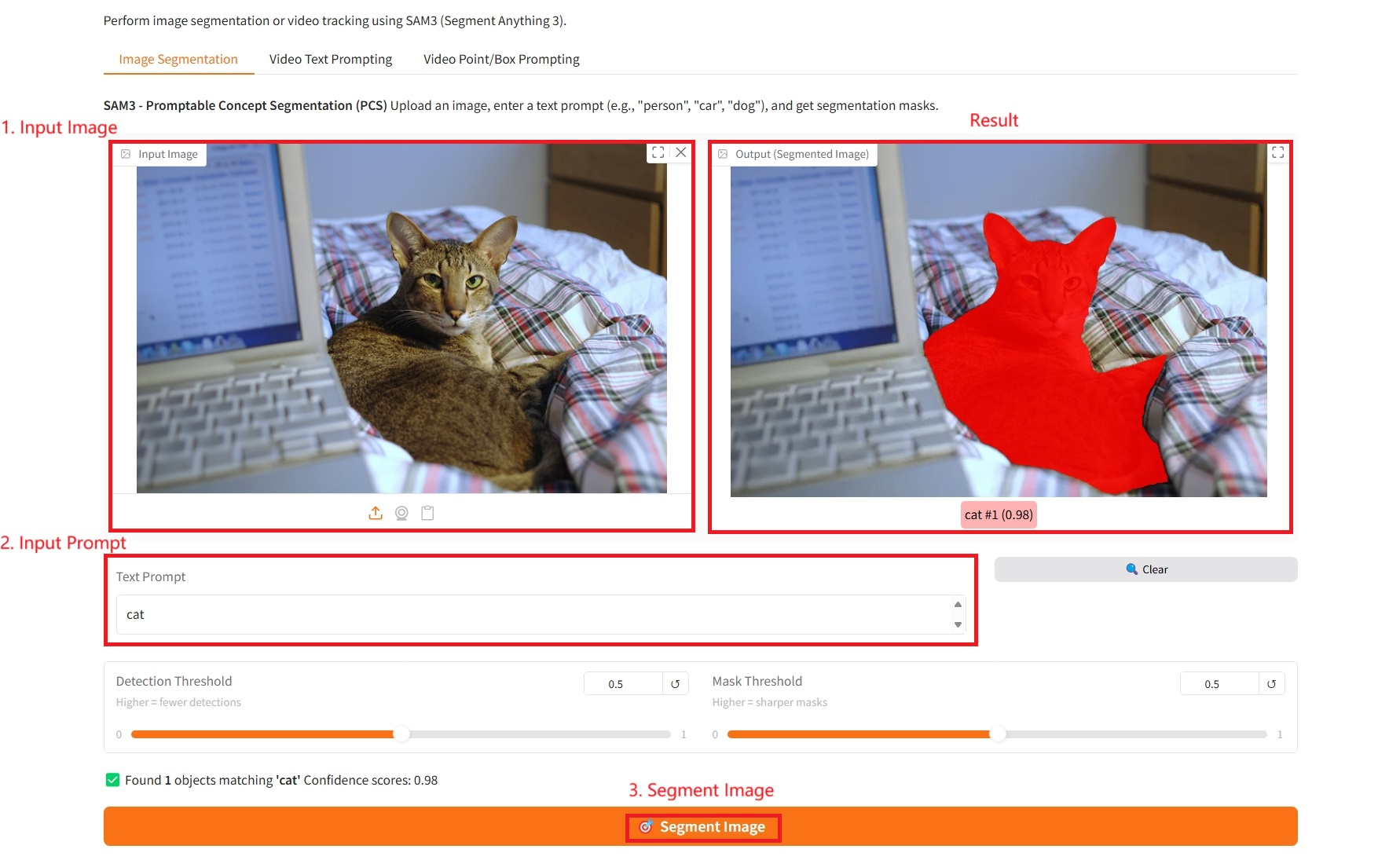

1. Segmentation d'images

Paramètres spécifiques :

- Invite de texte : Vous pouvez saisir du texte ici.

- Seuil de détection : plus le seuil est élevé, moins il y a de cibles détectées.

- Seuil de masque : plus le seuil est élevé, plus les contours du masque généré sont nets et précis.

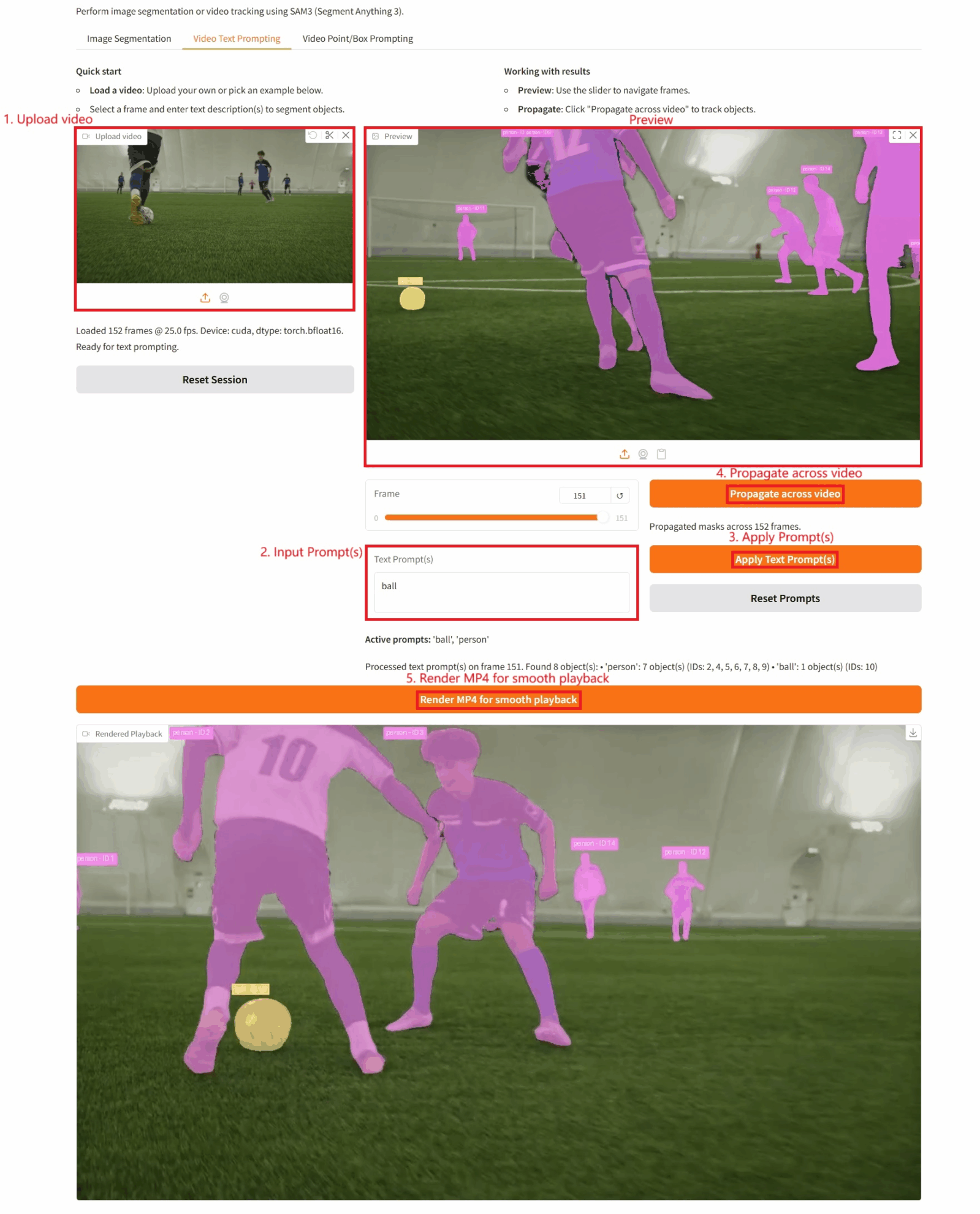

2. Invite de texte vidéo

Paramètres spécifiques :

- Invite(s) de texte : Vous pouvez saisir du texte ici.

- Propagation vidéo : Cliquez sur ce bouton pour effectuer un suivi vidéo de la cible.

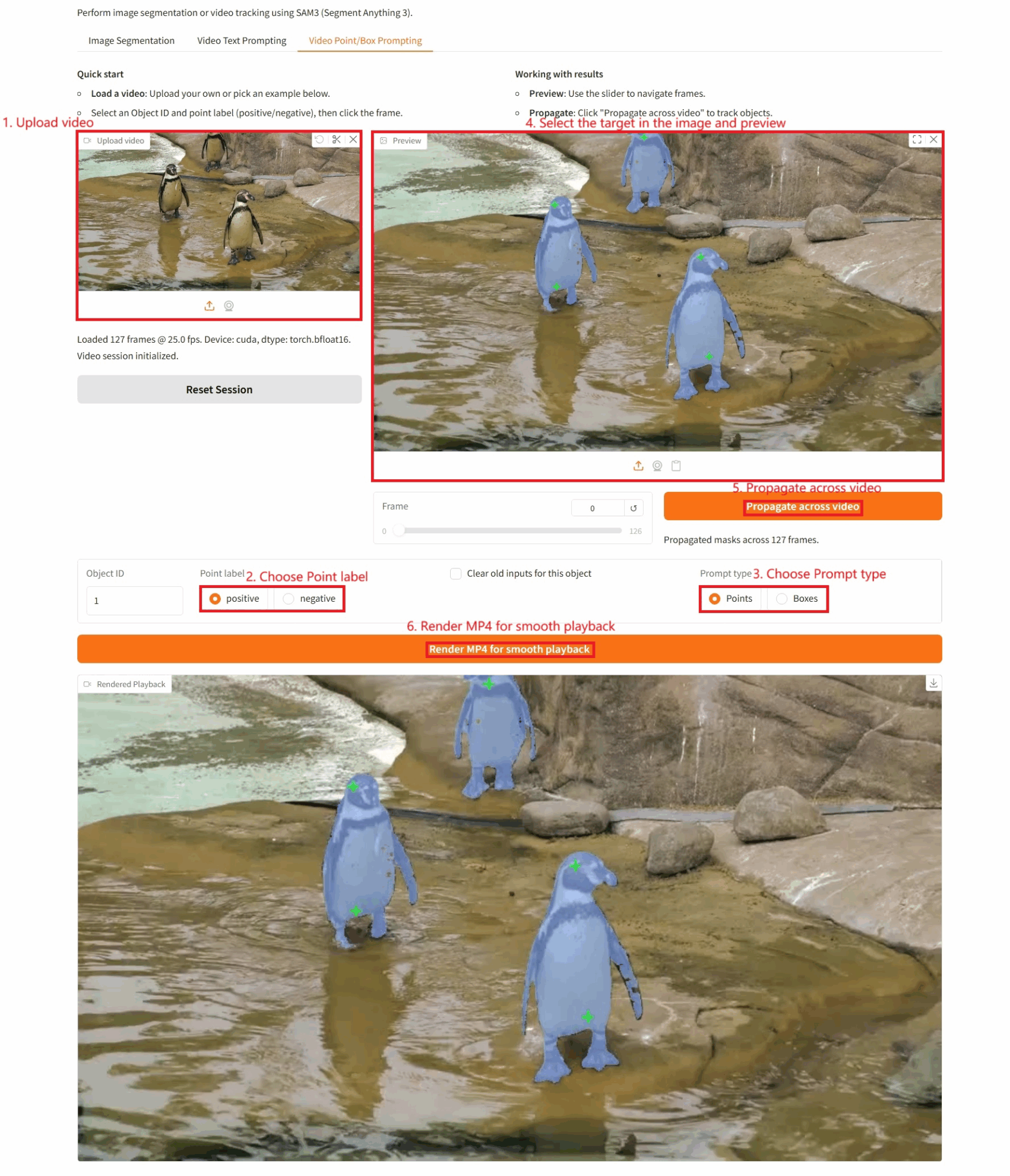

3. Invite vidéo (point/boîte)

Paramètres spécifiques :

- ID de l'objet : L'ID de la cible détectée.

- Étiquette du point :

- Positif : Lorsque vous cliquez sur un emplacement de l’image, si le résultat est positif, cela signifie que ce point appartient à l’objet cible que vous souhaitez segmenter ; veuillez donc l’inclure dans le calcul.

- Négatif : Lorsque vous cliquez sur un emplacement de l’image, si la valeur est négative, cela signifie que ce point n’appartient pas à l’objet cible (il s’agit de l’arrière-plan ou d’autre chose), veuillez le supprimer.

- Effacer les anciennes entrées pour cet objet : Indique s’il faut effacer les cibles précédemment détectées.

- Type d'invite :

- Points clés : Cliquez sur les indices visuels.

- Encadrés : repères visuels pour la sélection des articles.

Informations sur la citation

Les informations de citation pour ce projet sont les suivantes :

@misc{carion2025sam3segmentconcepts,

title={SAM 3: Segment Anything with Concepts},

author={Nicolas Carion and Laura Gustafson and Yuan-Ting Hu and Shoubhik Debnath and Ronghang Hu and Didac Suris and Chaitanya Ryali and Kalyan Vasudev Alwala and Haitham Khedr and Andrew Huang and Jie Lei and Tengyu Ma and Baishan Guo and Arpit Kalla and Markus Marks and Joseph Greer and Meng Wang and Peize Sun and Roman Rädle and Triantafyllos Afouras and Effrosyni Mavroudi and Katherine Xu and Tsung-Han Wu and Yu Zhou and Liliane Momeni and Rishi Hazra and Shuangrui Ding and Sagar Vaze and Francois Porcher and Feng Li and Siyuan Li and Aishwarya Kamath and Ho Kei Cheng and Piotr Dollár and Nikhila Ravi and Kate Saenko and Pengchuan Zhang and Christoph Feichtenhofer},

year={2025},

eprint={2511.16719},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2511.16719},

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.