Command Palette

Search for a command to run...

MAGI-1 : Le Premier Modèle De Génération Vidéo Autorégressif À Grande Échelle Au Monde

Date

Taille

31.53 MB

Licence

Apache 2.0

GitHub

URL du document

1. Introduction au tutoriel

Magi-1, officiellement lancé le 21 avril 2025 par la société chinoise d'IA SendAI, est le premier modèle de génération vidéo autorégressif à grande échelle au monde. Il génère des vidéos en prédisant une série de blocs vidéo par autorégression, définis comme des segments de longueur fixe composés d'images consécutives. Après son entraînement, Magi-1 peut débruiter chaque bloc de bruit, dont le niveau augmente de façon monotone avec le temps, prend en charge la modélisation temporelle causale et la génération en flux continu. Il offre des performances remarquables pour la conversion d'images en vidéos à partir d'instructions textuelles, garantissant une grande cohérence temporelle et une excellente scalabilité. Ces performances sont rendues possibles grâce à de multiples innovations algorithmiques et une infrastructure dédiée. Des articles de recherche associés sont disponibles. MAGI-1 : Génération vidéo autorégressive à grande échelle .

Ce didacticiel utilise des ressources pour une seule carte RTX 4090 et le texte ne prend en charge que l'anglais.

2. Exemples de projets

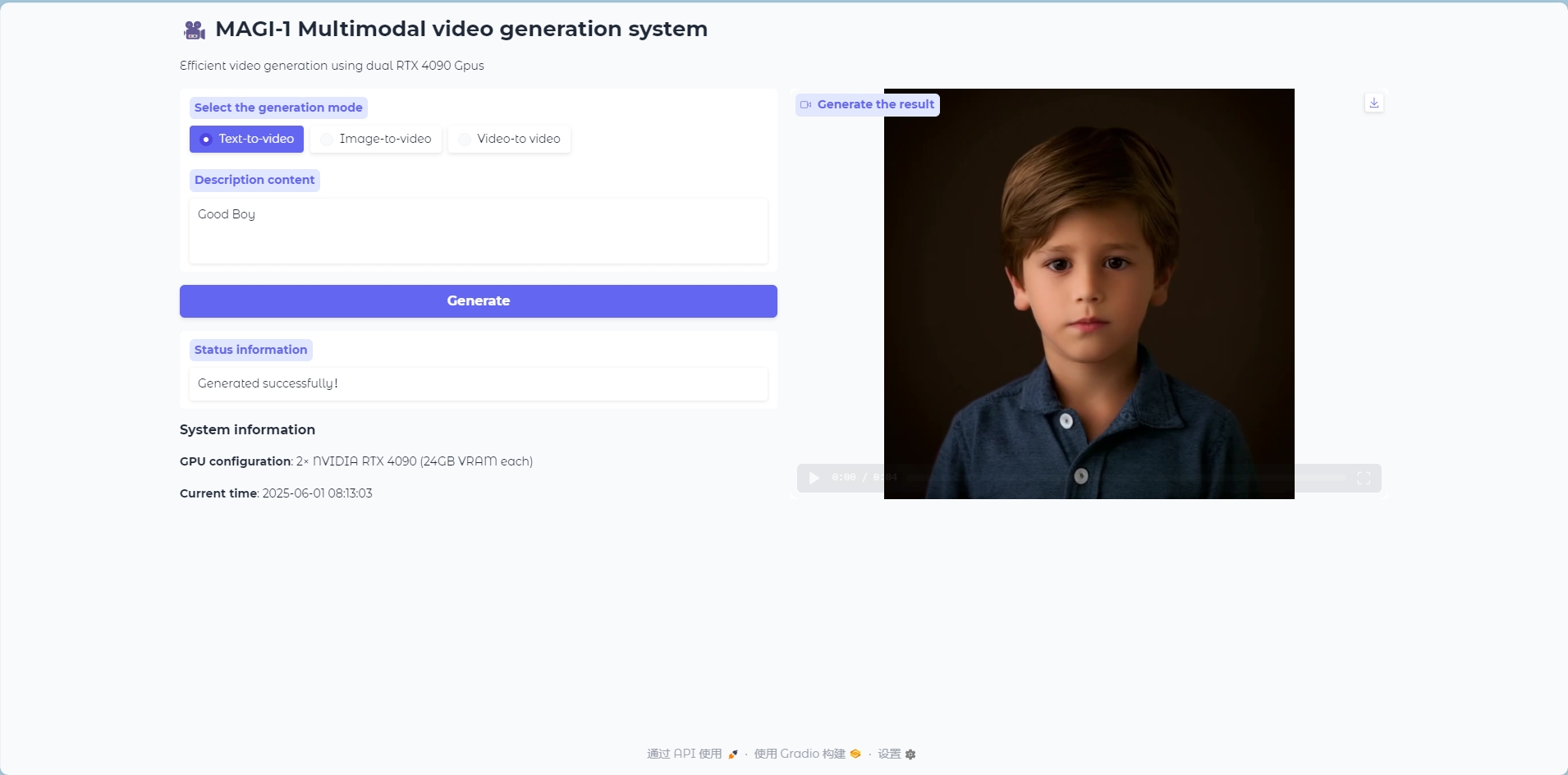

Mode texte en vidéo

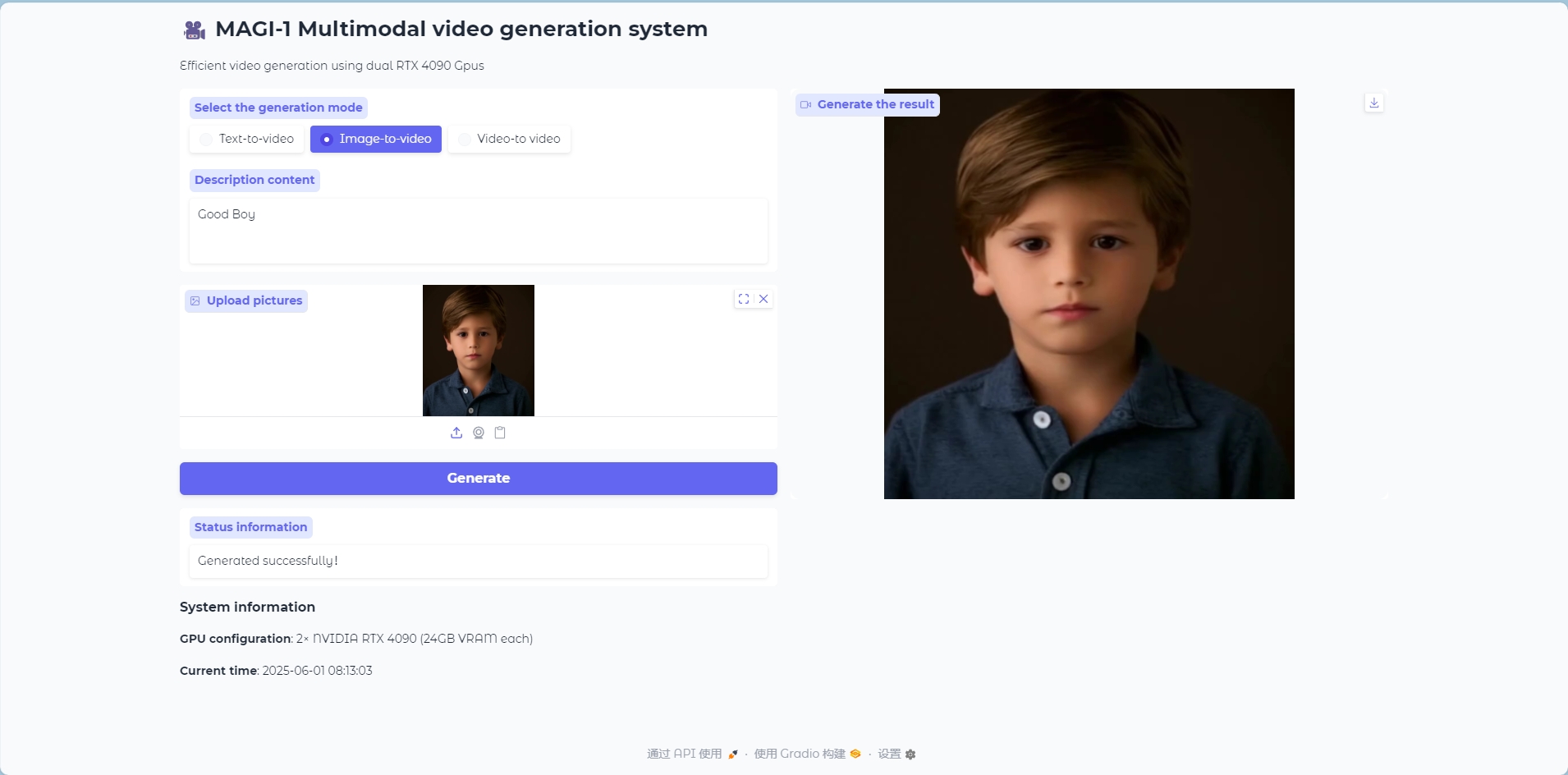

Mode image vers vidéo

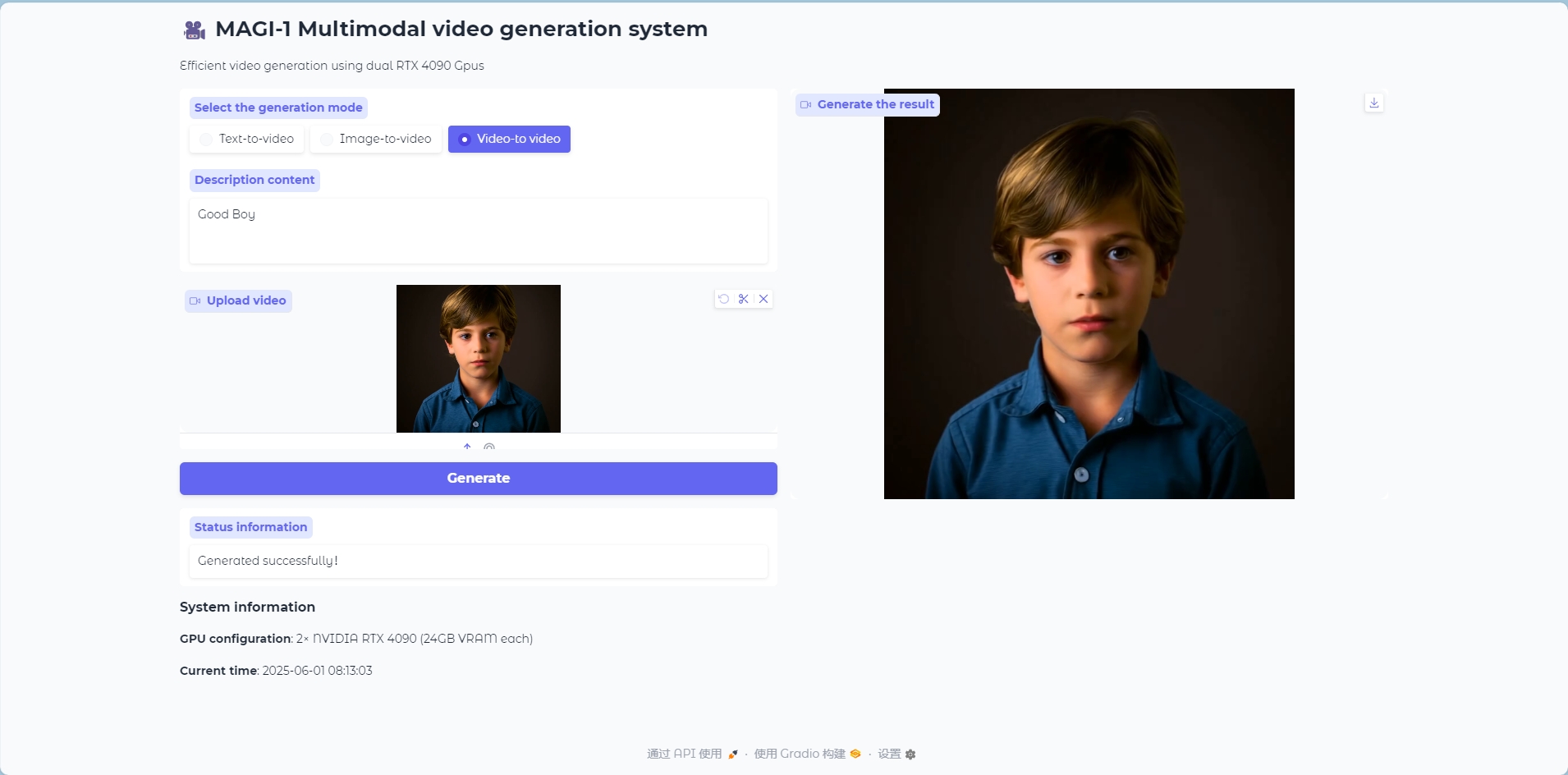

Mode vidéo vers vidéo

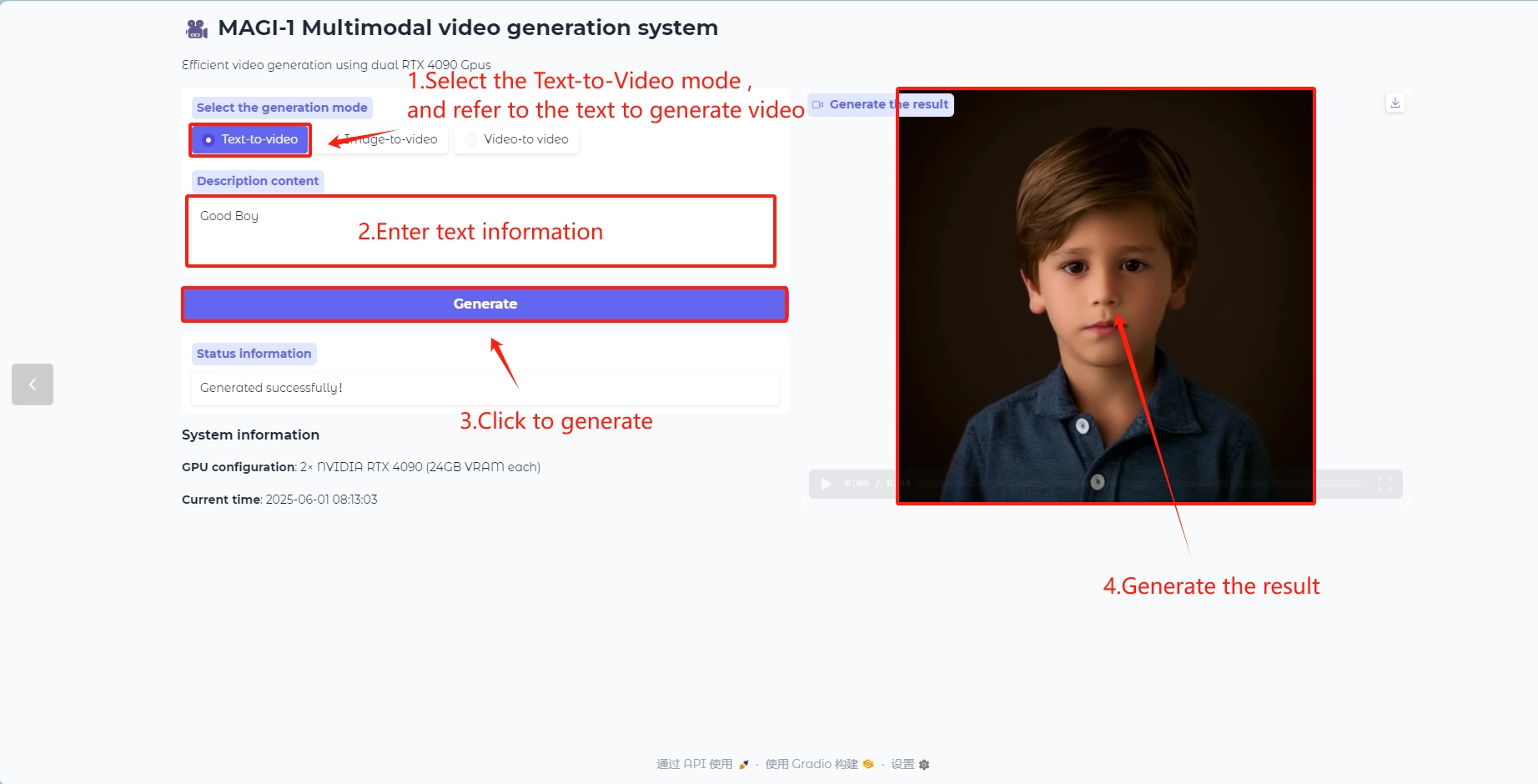

3. Étapes de l'opération

1. Après avoir démarré le conteneur, cliquez sur l'adresse API pour accéder à l'interface Web

2. Après avoir accédé à la page Web, vous pouvez démarrer un dialogue linguistique avec le modèle

Si le message « Bad Gateway » s'affiche, cela signifie que le modèle est en cours d'initialisation. Le modèle étant volumineux, veuillez patienter une à deux minutes avant d'actualiser la page. La génération d'une vidéo par le modèle prend environ cinq minutes ; merci de votre patience.

Comment utiliser

Modèle de conversion de texte en vidéo

Générer des images vidéo avec du contenu textuel

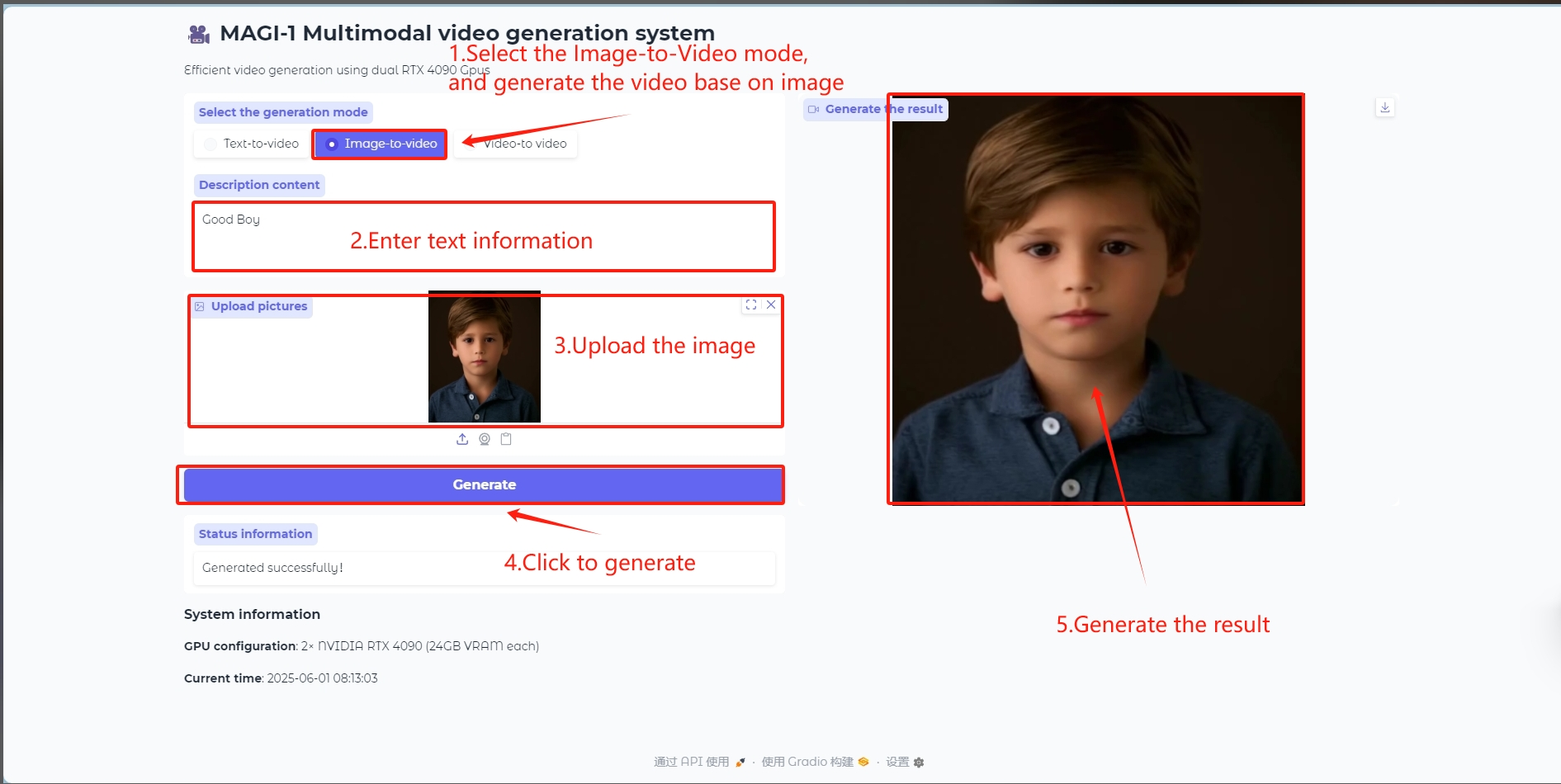

Modèle image vers vidéo

Saisissez une image comme référence pour générer une image vidéo

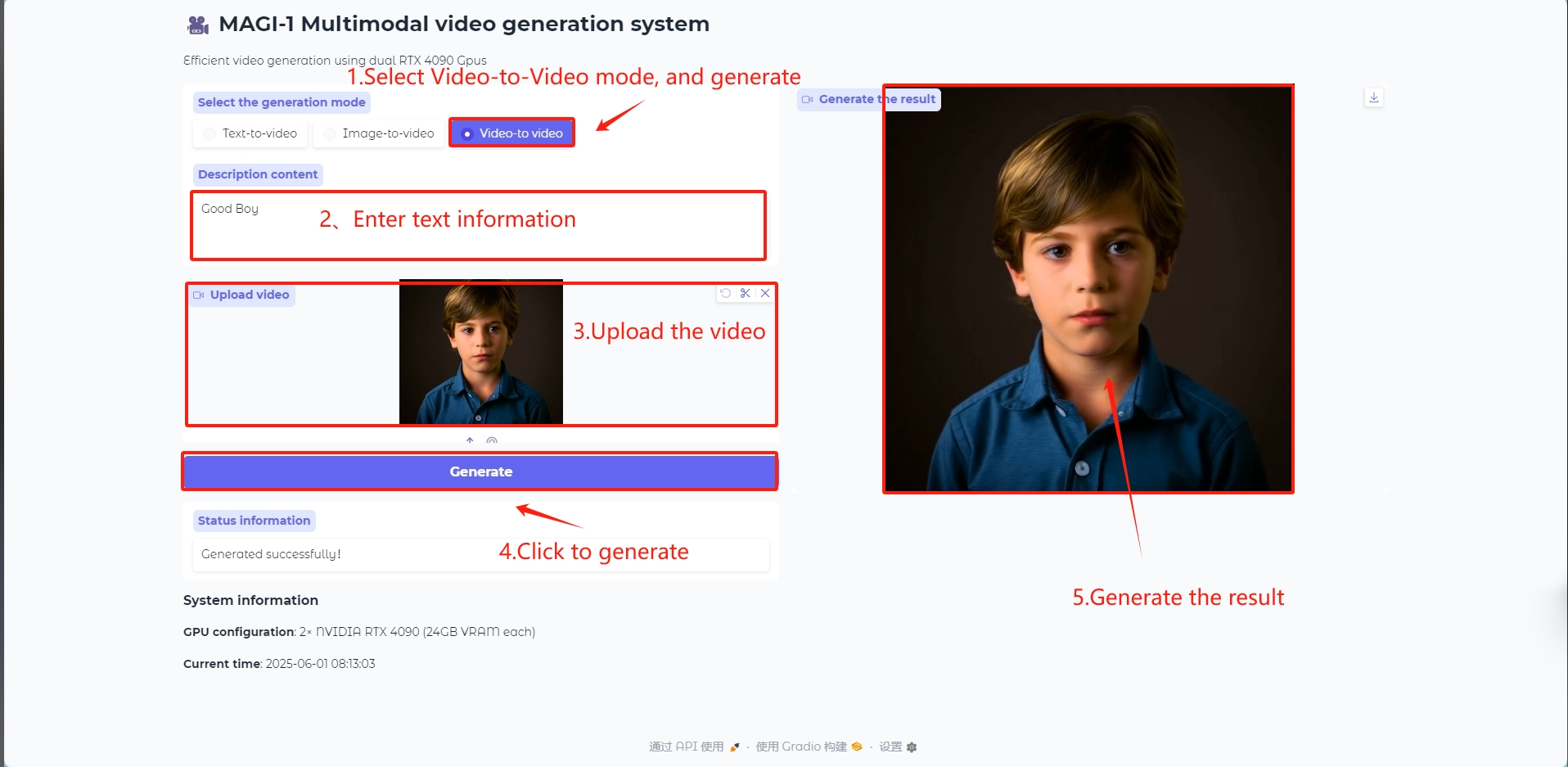

Modèle vidéo vers vidéo

Saisissez une vidéo comme référence pour générer des images vidéo

Dans le runtime_config du fichier 4.5B_distill_quant_config.json dans le chemin /openbayes/home/MAGI-1/example/4.5B, vous pouvez modifier les paramètres de la vidéo générée, tels que num_frames, video_size_h, video_size_w et fps.

4. Discussion

🖌️ Si vous voyez un projet de haute qualité, veuillez laisser un message en arrière-plan pour le recommander ! De plus, nous avons également créé un groupe d’échange de tutoriels. Bienvenue aux amis pour scanner le code QR et commenter [Tutoriel SD] pour rejoindre le groupe pour discuter de divers problèmes techniques et partager les résultats de l'application↓

V. Informations sur la citation

Merci à l'utilisateur de GitHub kjasdk Pour le déploiement de ce tutoriel, les informations de référence du projet sont les suivantes :

@misc{ai2025magi1autoregressivevideogeneration,

title={MAGI-1: Autoregressive Video Generation at Scale},

author={Sand. ai and Hansi Teng and Hongyu Jia and Lei Sun and Lingzhi Li and Maolin Li and Mingqiu Tang and Shuai Han and Tianning Zhang and W. Q. Zhang and Weifeng Luo and Xiaoyang Kang and Yuchen Sun and Yue Cao and Yunpeng Huang and Yutong Lin and Yuxin Fang and Zewei Tao and Zheng Zhang and Zhongshu Wang and Zixun Liu and Dai Shi and Guoli Su and Hanwen Sun and Hong Pan and Jie Wang and Jiexin Sheng and Min Cui and Min Hu and Ming Yan and Shucheng Yin and Siran Zhang and Tingting Liu and Xianping Yin and Xiaoyu Yang and Xin Song and Xuan Hu and Yankai Zhang and Yuqiao Li},

year={2025},

eprint={2505.13211},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2505.13211},

}Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.