Command Palette

Search for a command to run...

Wan2.2-Animate-14B: Offenes Erweitertes Modell Zur Videogenerierung Im Großen Maßstab

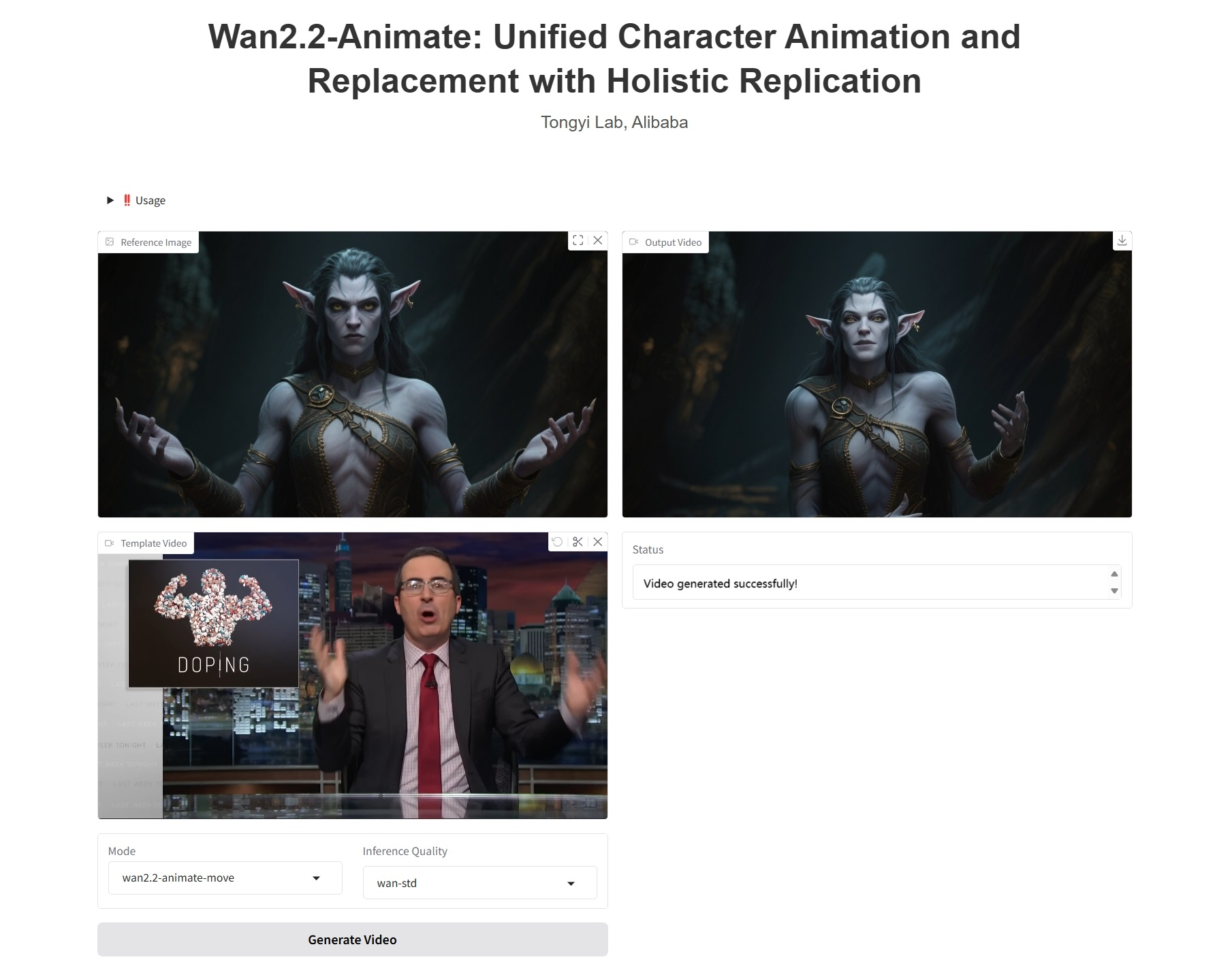

1. Einführung in das Tutorial

Wan2.2-Animate-14B ist ein Aktionsgenerierungsmodell, das im September 2025 vom Tongyi-Wanxiang-Team von Alibaba als Open Source veröffentlicht wurde. Das Modell unterstützt sowohl Aktionsimulation als auch Rollenspiel und bildet Gesichtsausdrücke und Bewegungen aus Videos von Darstellern präzise nach, um hochrealistische Charakteranimationsvideos zu generieren. Es kann animierte Charaktere nahtlos in das Originalvideo einfügen und dabei Beleuchtung und Farbton der Szene perfekt anpassen. Basierend auf dem Wan-Modell steuert es Gliedmaßenbewegungen durch räumlich ausgerichtete Skelettsignale und erzeugt Mimik mithilfe impliziter Gesichtsmerkmale, die aus dem Quellbild extrahiert werden. Dadurch wird eine hochgradig kontrollierbare und ausdrucksstarke Charaktervideogenerierung erreicht. Zugehörige Forschungsarbeiten umfassen… Wan-Animate: Einheitliche Charakteranimation und -ersetzung mit ganzheitlicher Replikation .

Dieses Tutorial verwendet eine einzelne RTX PRO 6000-Grafikkarte als Rechenressource.

2. Effektanzeige

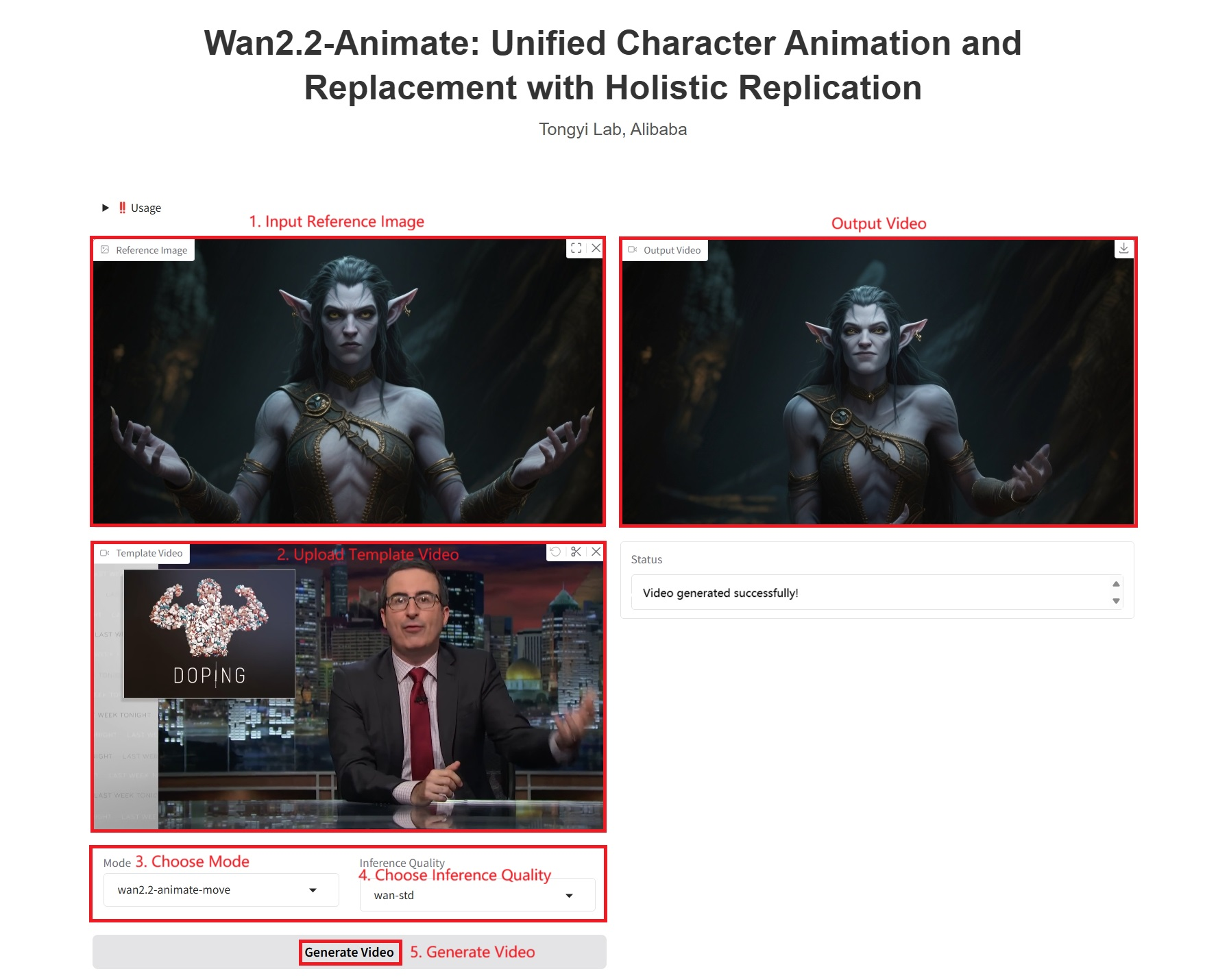

3. Bedienungsschritte

1. Starten Sie den Container

2. Anwendungsschritte

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 1–2 Minuten und aktualisieren Sie die Seite.

Hinweis: Wenn Sie „Inferenzqualität“ auswählen, gilt: Je besser die Qualität des von wan-pro generierten Videos, desto länger dauert die Generierung. Beispiel 1 dauert etwa 1200 Sekunden.

Spezifische Parameter:

- Modus:

- wan2.2-animate-move: Aktionsimitation. Verwendet ein Charakterbild und ein Referenzvideo als Eingabe. Das Modell überträgt die Bewegungen und Ausdrücke des Charakters vom Referenzvideo auf das eingegebene Charakterbild und verleiht dem statischen Charakter dadurch Dynamik und Ausdruckskraft.

- wan2.2-animate-mix: Charakterersetzung, die Charaktere in einem Video durch diejenigen in einem Eingabebild ersetzt und dabei die Bewegungen, Ausdrücke und Umgebung des Originalvideos beibehält, wodurch eine nahtlose Integration erreicht wird.

- Inferenzqualität:

- wan-pro: Hochwertige Generation.

- wan-std: Standardversion, die Leistung und Effizienz ausbalanciert.

4. Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

Zitationsinformationen

Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@article{wan2025,

title={Wan: Open and Advanced Large-Scale Video Generative Models},

author={Team Wan and Ang Wang and Baole Ai and Bin Wen and Chaojie Mao and Chen-Wei Xie and Di Chen and Feiwu Yu and Haiming Zhao and Jianxiao Yang and Jianyuan Zeng and Jiayu Wang and Jingfeng Zhang and Jingren Zhou and Jinkai Wang and Jixuan Chen and Kai Zhu and Kang Zhao and Keyu Yan and Lianghua Huang and Mengyang Feng and Ningyi Zhang and Pandeng Li and Pingyu Wu and Ruihang Chu and Ruili Feng and Shiwei Zhang and Siyang Sun and Tao Fang and Tianxing Wang and Tianyi Gui and Tingyu Weng and Tong Shen and Wei Lin and Wei Wang and Wei Wang and Wenmeng Zhou and Wente Wang and Wenting Shen and Wenyuan Yu and Xianzhong Shi and Xiaoming Huang and Xin Xu and Yan Kou and Yangyu Lv and Yifei Li and Yijing Liu and Yiming Wang and Yingya Zhang and Yitong Huang and Yong Li and You Wu and Yu Liu and Yulin Pan and Yun Zheng and Yuntao Hong and Yupeng Shi and Yutong Feng and Zeyinzi Jiang and Zhen Han and Zhi-Fan Wu and Ziyu Liu},

journal = {arXiv preprint arXiv:2503.20314},

year={2025}

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.