Command Palette

Search for a command to run...

GroundingME-Datensatz Zur Evaluierung Des Verständnisses Komplexer Szenen

Datum

Paper-URL

Lizenz

Other

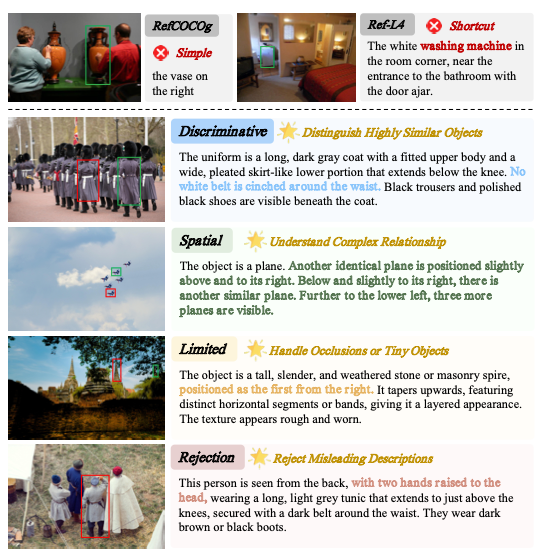

GroundingME ist ein visueller Referenzdatensatz zur Evaluierung multimodaler großer Sprachmodelle (MLLMs), der 2025 von der Tsinghua-Universität in Zusammenarbeit mit Xiaomi, der Universität Hongkong und weiteren Institutionen veröffentlicht wurde. Zugehörige Forschungsarbeiten umfassen… GroundingME: Aufdeckung der visuellen Erdungslücke in MLLMs durch mehrdimensionale BewertungZiel ist es, die Fähigkeit des Modells systematisch zu bewerten, natürliche Sprache in komplexen realen Szenarien präzise visuellen Zielen zuzuordnen, wobei besonderes Augenmerk auf das Verständnis und die Sicherheit in Situationen mit mehrdeutigen Referenzen, komplexen räumlichen Beziehungen, kleinen Zielen, Verdeckung und Nichtreferenzialität gelegt wird.

Dieser Datensatz enthält 1.005 Evaluierungsbeispiele. Die Bilder stammen aus zwei hochwertigen Datensätzen, SA-1B und HR-Bench. Um Datenverfälschungen zu vermeiden, wurden ausschließlich die Originalbilder für die Aufgaben verwendet. Die Beispiele decken vier Hauptaufgabenkategorien ab: diskriminative Referenz (204 Beispiele, 20,31 TP3T), räumliches Beziehungsverständnis (300 Beispiele, 29,91 TP3T), Szenen mit eingeschränkter Sicht (300 Beispiele, 29,91 TP3T) und nicht-referenzielle Ablehnungsaufgabe (201 Beispiele, 20,01 TP3T). Diese sind in zwölf Unteraufgaben mit einer ausgewogenen Gesamtverteilung unterteilt. Der Datensatz umfasst 241 reale Objektklassen. In einem Bild befinden sich viele Objekte derselben Klasse, wobei die einzelnen Objekte in der Regel nur einen kleinen Teil des Bildes einnehmen. Die sprachlichen Beschreibungen sind deutlich länger als in bestehenden Referenzdatensätzen, was die Schwierigkeit visueller Referenzaufgaben in mehrfacher Hinsicht erheblich erhöht.

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.