Command Palette

Search for a command to run...

OminiControl 多功能图像生成与控制

一、教程简介

OminiControl 是由新加坡国立大学 xML 实验室于 2024 年 12 月发布的一个最小但功能强大的通用控制框架,适用于 FLUX 等 Diffusion Transformer 模型。可以通过使用 FLUX 模型自定义任何控制任务(3D 、多视图、姿势引导等)来创建自己 OminiControl 模型。相关论文成果为 OminiControl: Minimal and Universal Control for Diffusion Transformer 。

通用控制 🌐 :一个统一的控制框架,同时支持主体驱动的控制和空间控制(例如边缘导向和绘画内生成)。

最小设计 🚀 : 在保留原始模型结构的同时注入控制信号。仅向基本模型引入 0.1% 的附加参数。

本教程基于 OminiControl 通用控制框架,实现了对图像的主题驱动的生成和空间控制。算力资源采用单卡 A6000 。

效果示例

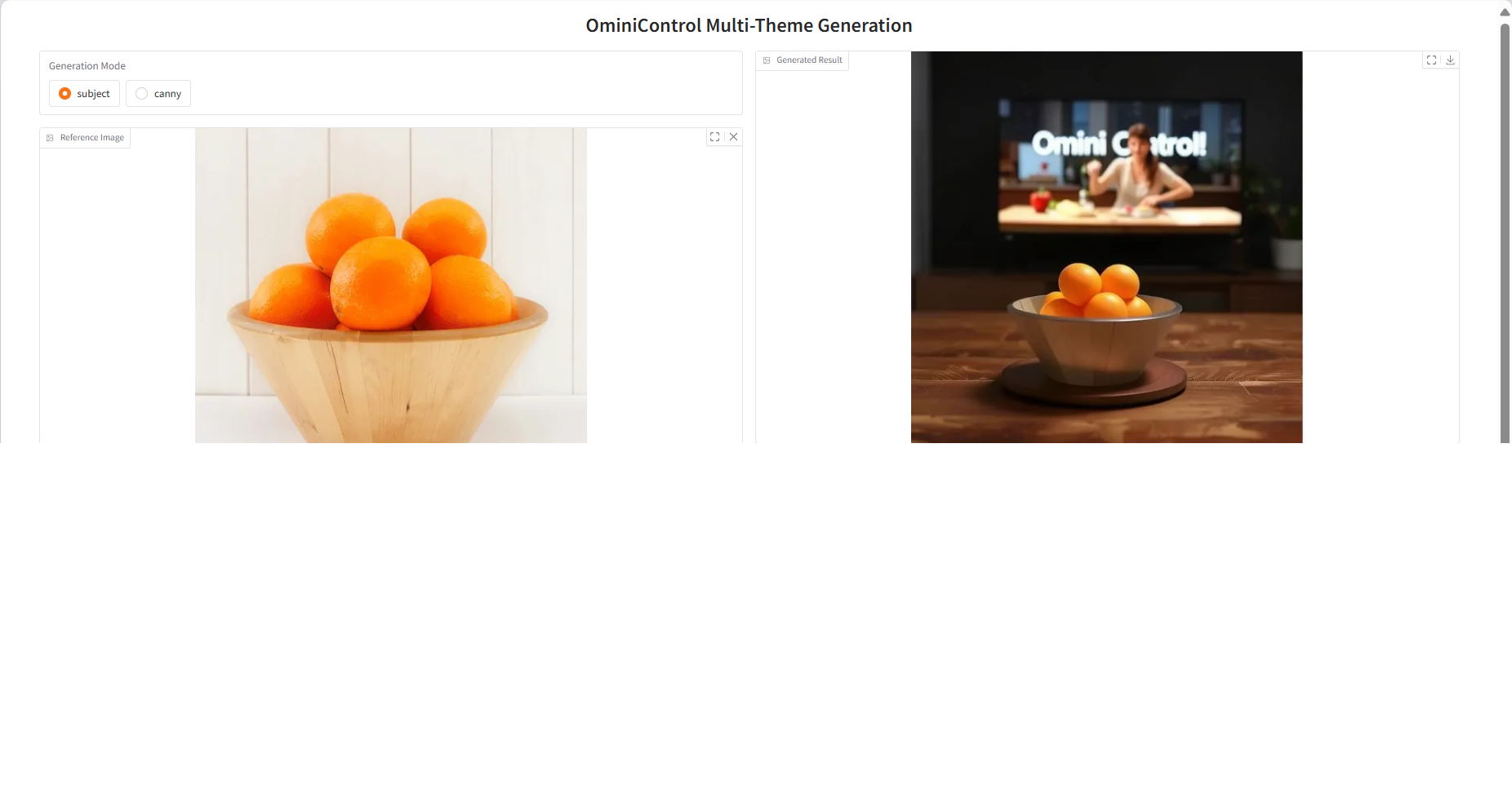

1. 主题驱动的生成

演示(左:条件图像;右:生成图像)

文本提示词

- 提示词 1:特写镜头展示该物品。放置在木桌上,背景为黑暗的房间,电视开启且屏幕正在播放烹饪节目,屏幕上显示文字 “Omini Control!”

- 提示词 2:电影风格镜头。在月球表面,该物品在月球表面行驶,车身上带有 “Omini” 字样的旗帜。背景是占据前景的巨大地球。

- 提示词 3:包豪斯风格房间内,物品放置在闪亮的玻璃桌上,旁边有一个插满鲜花的花瓶。午后阳光下,百叶窗的影子投射在墙上。

- 提示词 4:海滩上,一位女士坐在印有 “Omini” 字样的遮阳伞下,身着这件衬衫,面带灿烂笑容,身后放着冲浪板。背景是日落时分的橙紫色天空。

2. 空间对齐控制

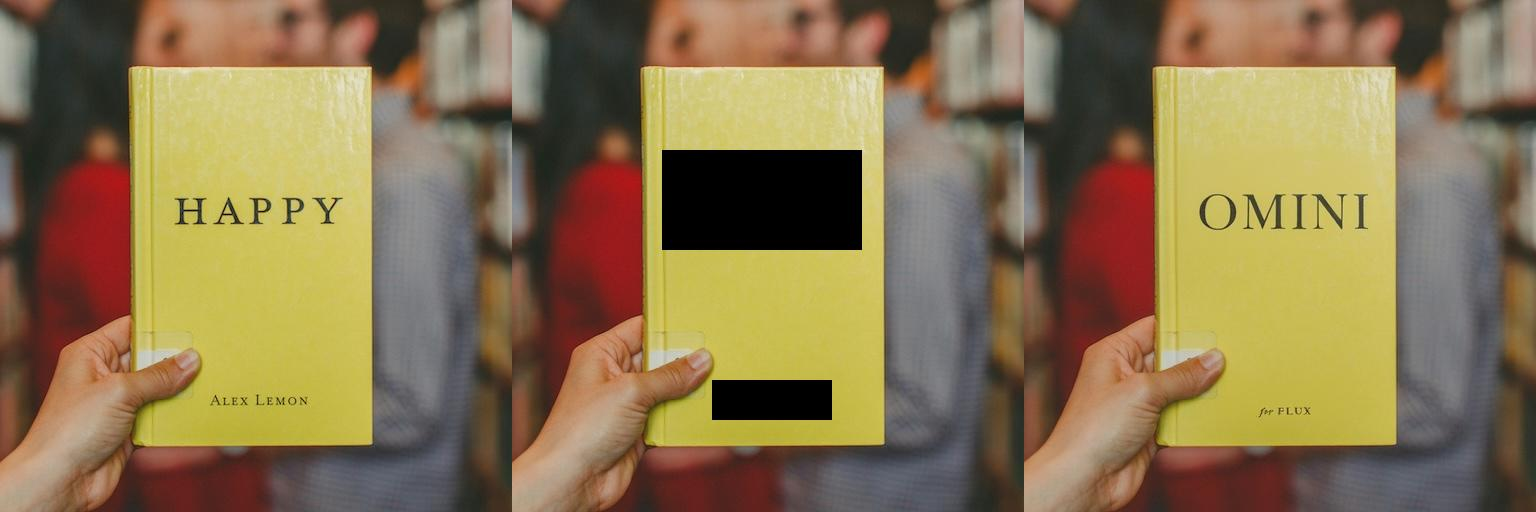

图像修复(左:原始图像;中:掩码图像;右:填充结果)

- 提示词:蒙娜丽莎戴着印有 “Omini” 字样的白色 VR 头显。

- 提示词:黄色书籍封面印有大字体 “OMINI” 字样,底部显示 “for FLUX” 文字。

二、运行步骤

若不显示「模型」,这表示模型正在初始化,由于模型较大,请等待约 1-2 分钟后刷新页面。

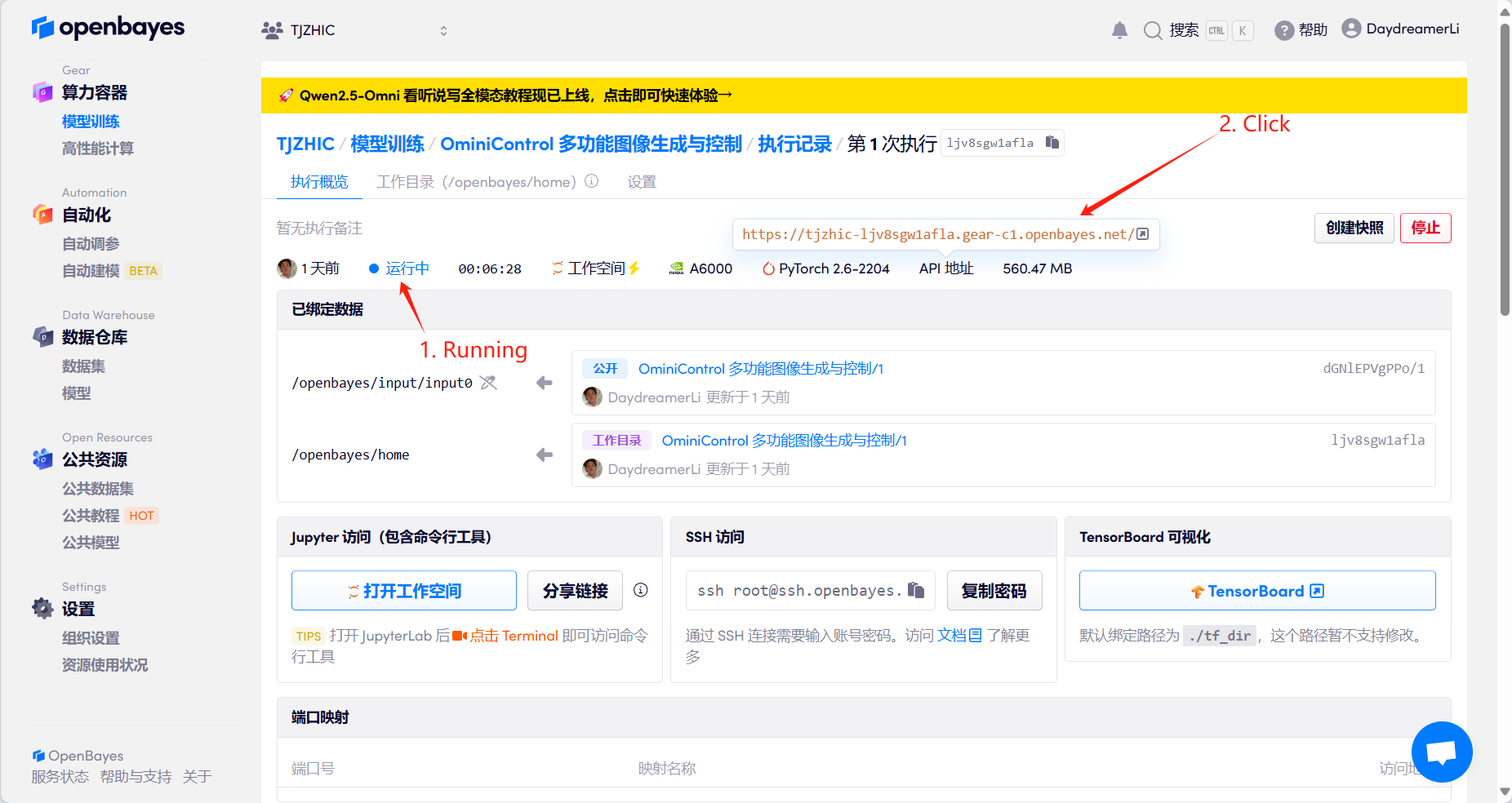

1. 启动容器后点击 API 地址即可进入 Web 界面

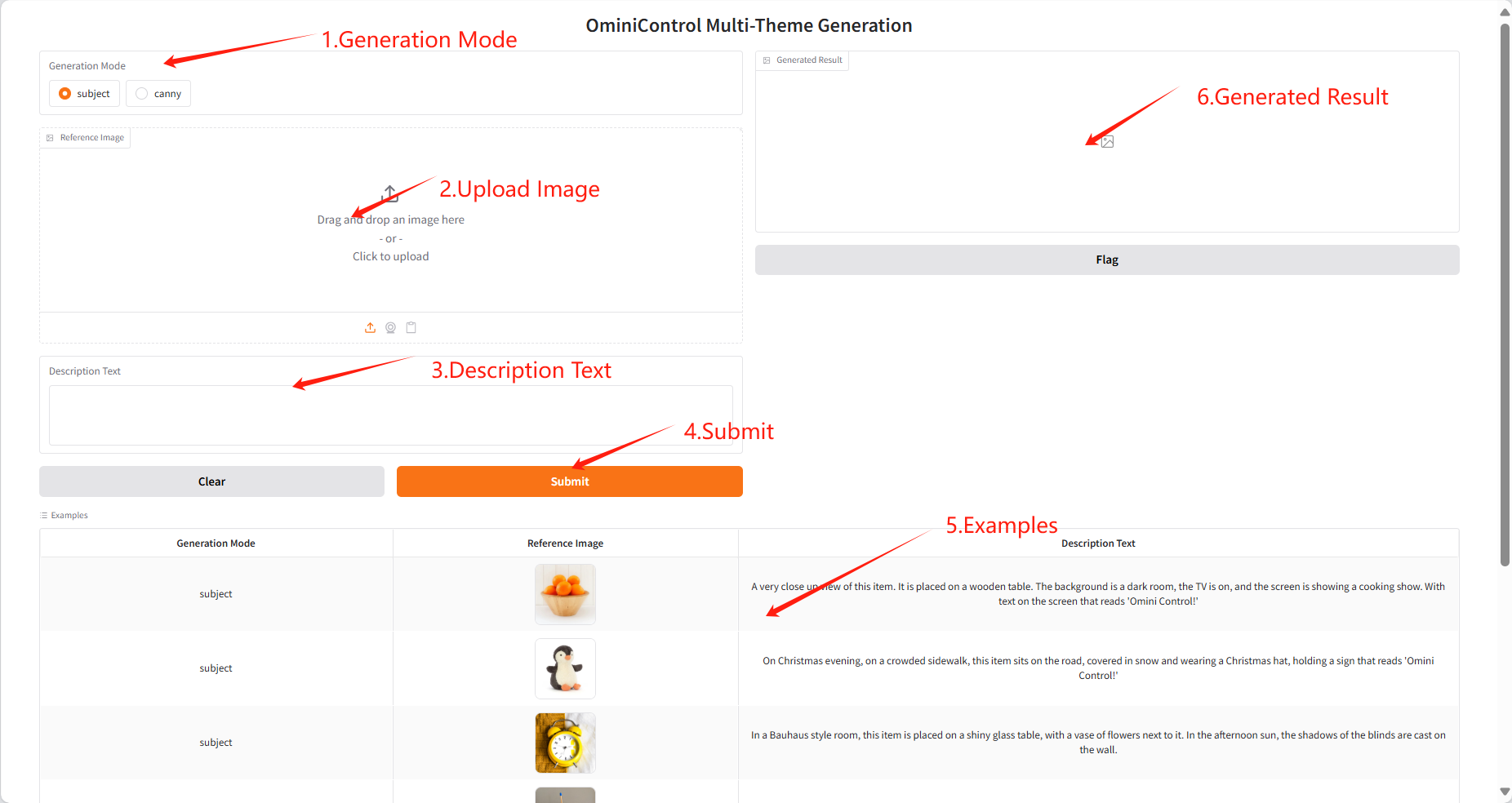

2. 进入网页后,即可体验主题驱动的生成 (Subject) 和空间控制 (Spatial)

注意:两种模型间的切换需要等待 30 到 70 秒左右,请耐心等待。

主题驱动生成: 用户提供某种物体的一张图片,以及该物体所在目标场景的文本描述,即可完成主题驱动的生成。

空间控制: 包含图像修复和 Canny 等操作,用户提供某物体的图片,以及对该物体改变的文本描述,即可完成图像的空间控制。

主题驱动生成效果 (Subject)

空间控制-图像修复效果 (Spatial)

引用信息

感谢 GitHub 用户 SuperYang 对本教程的制作,本项目引用信息如下:

@article{tan2024ominicontrol,

title={Ominicontrol: Minimal and universal control for diffusion transformer},

author={Tan, Zhenxiong and Liu, Songhua and Yang, Xingyi and Xue, Qiaochu and Wang, Xinchao},

journal={arXiv preprint arXiv:2411.15098},

volume={3},

year={2024}

}

交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓