Command Palette

Search for a command to run...

学习配置智能体AI系统

学习配置智能体AI系统

Aditya Taparia Som Sagar Ransalu Senanayake

摘要

基于大语言模型(LLM)的智能体系统配置涉及从庞大的组合设计空间中选择工作流、工具、令牌预算(token budget)以及提示词(prompt),目前通常依赖固定的大型模板或人工调优的启发式方法。这种方法导致系统行为脆弱且计算资源浪费严重,因为相同的复杂配置常被不加区分地应用于简单与复杂的输入查询。本文将智能体配置建模为一种针对每个查询的决策问题,并提出ARC(Agentic Resource & Configuration learner),该方法利用强化学习训练一种轻量级的分层策略,以动态地为不同查询定制最优配置。在涵盖推理与工具增强型问答的多个基准测试中,所学习的策略持续优于多种精心设计的基线方法及其他现有方案,在任务准确率上最高提升达25%的同时,显著降低了令牌消耗与运行时间成本。实验结果表明,针对每个查询学习个性化配置,是一种相较于“一刀切”式设计更为强大的替代方案。

一句话总结

来自 MIT 和斯坦福的研究人员提出了 ARG,这是一种基于强化学习的策略,可针对每个查询动态配置大语言模型(LLM)代理,在准确率上比静态模板最高提升 25%,同时减少 token 和运行时间开销,从而在推理和工具增强型问答任务中实现高效、自适应的代理部署。

主要贡献

- ARG 将代理配置建模为每个查询的决策问题,使用轻量级分层强化学习策略动态选择工作流、工具和 token 预算,避免了静态“一刀切”设置在简单查询上浪费计算资源的低效性。

- 该方法引入了一种混合训练流程,结合掩码强化学习与基于精英轨迹的监督微调,可在超过 10^5 种配置的组合空间中稳定学习,且无需修改底层 LLM。

- 在推理和工具增强型问答基准测试中评估显示,ARG 相比手工设计和扁平化 RL 基线,在提升任务准确率最高达 25% 的同时,也显著降低 token 使用量和运行时间,证明了自适应配置的价值。

引言

作者利用强化学习为每个查询动态配置基于 LLM 的代理系统,解决了静态“一刀切”设计在简单任务上浪费计算资源、在复杂任务中因长上下文噪声导致性能下降的问题。先前工作依赖手工调优的启发式方法或固定模板,无法根据输入难度自适应调整工作流、工具使用或 token 预算,导致系统脆弱且成本高昂。其主要贡献是 ARC,一种轻量级分层强化学习策略,它在高层选择工作流和工具,在底层构建提示,通过混合掩码 RL 与 SFT 训练流程高效探索组合设计空间。实验表明,在推理和工具增强型问答基准测试中,ARC 在降低 token 和运行时间成本的同时,准确率最高提升 25%。

方法

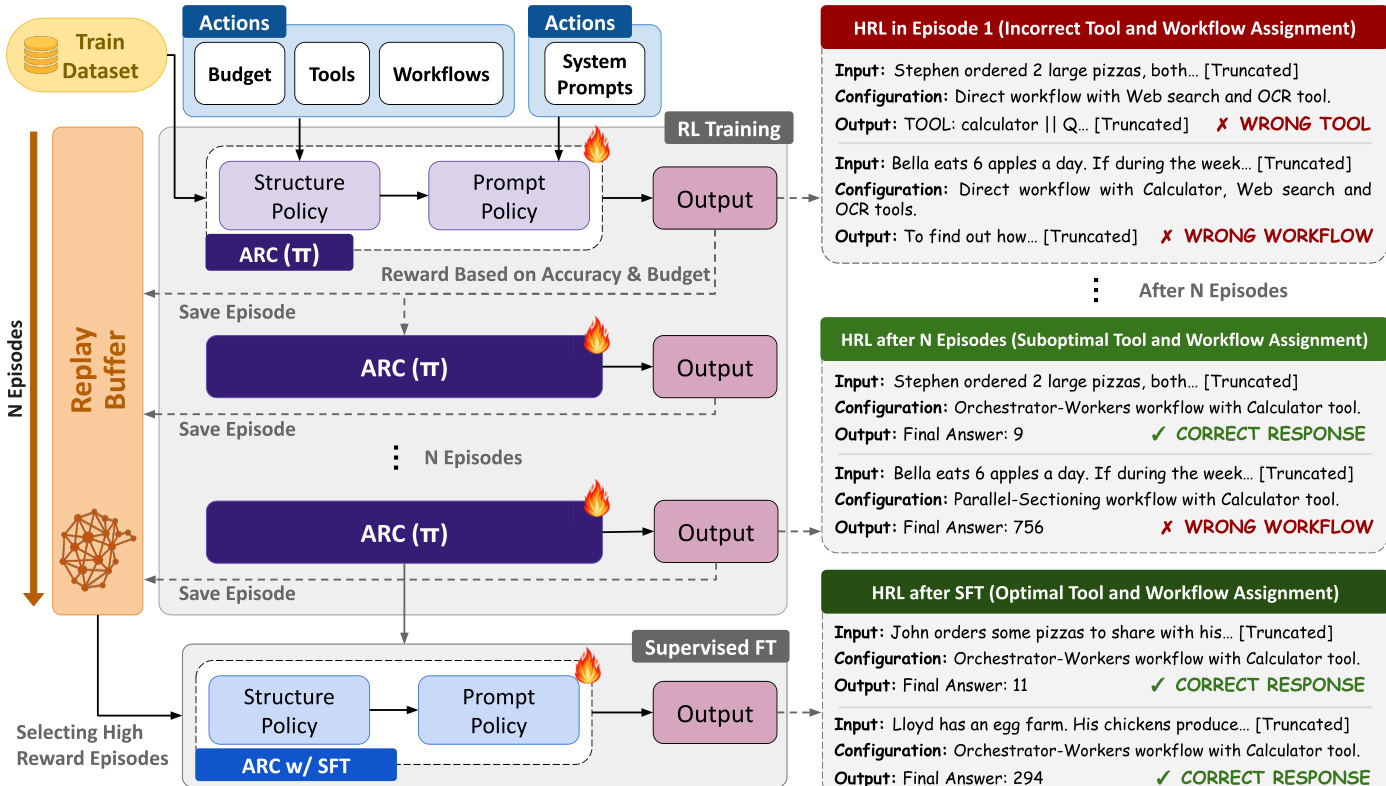

作者采用分层强化学习框架训练自适应资源控制器(ARC),为每个输入查询动态配置代理系统。核心目标是最大化一个平衡任务正确性与计算成本的效用函数,形式化为 U(q,c)=I[a^=a]−λCcost(c),其中 c=(ω,t,b,p) 编码所选工作流、工具、预算层级和提示指令。为使该优化可行,策略 π 被分解为两个独立组件:结构策略 πstruct 和提示策略 πprompt。这种分层设计将单一联合决策替换为顺序的结构与提示决策,降低搜索复杂度并提高样本效率。

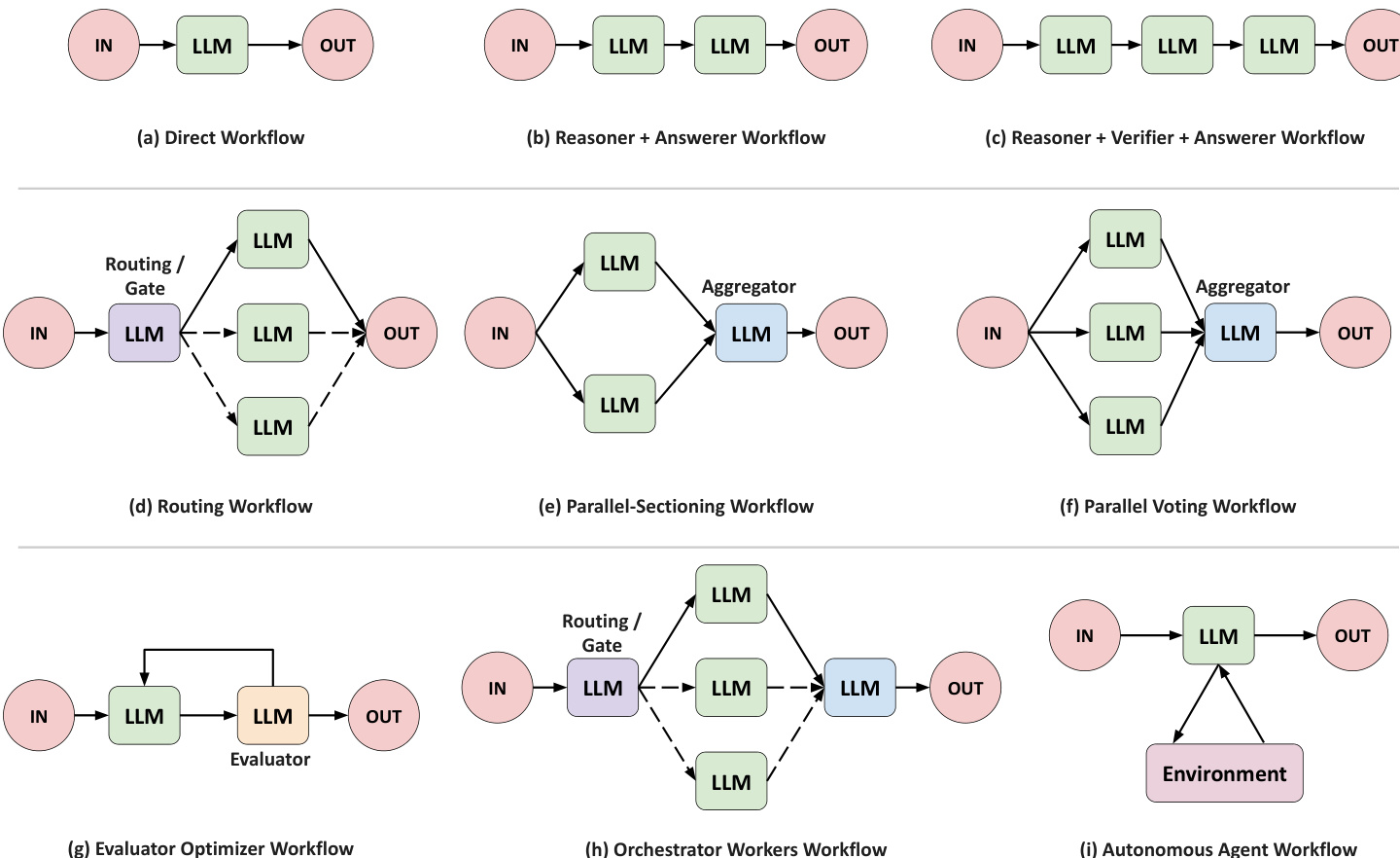

结构策略 πstruct 作为高层决策者,为给定查询选择架构蓝图。其动作空间输出复合配置 astruct=(ω,t,b),其中 ω 表示九种预定义代理工作流之一,t 指定启用的工具子集(如计算器、网络搜索、OCR),b 为每个代理分配 token 预算层级。工作流范围从简单的单次调用模式(如 Direct)到复杂的多代理编排(如 Orchestrator-Workers 或 Evaluator-Optimizer),每种工作流定义了 LLM 调用的不同计算图。如下图所示,结构策略需在可能的配置组合空间中导航,通过动作掩码剪枝排除结构无效组合——例如,在 Direct 工作流中为不存在的代理分配工具。

提示策略 πprompt 在结构策略之后顺序运行,基于所选工作流和资源为每个代理构建语义指令。其动作空间是组合式的,从指令片段库(如“分解问题”、“验证中间步骤”)中抽取,并以 STOP 动作终止。这些提示通过元提示动态生成,确保任务相关性,优于静态或手工设计的替代方案。策略通过迭代选择指令组件构建最终提示 p,将高层架构决策有效转化为可执行的代理指令。

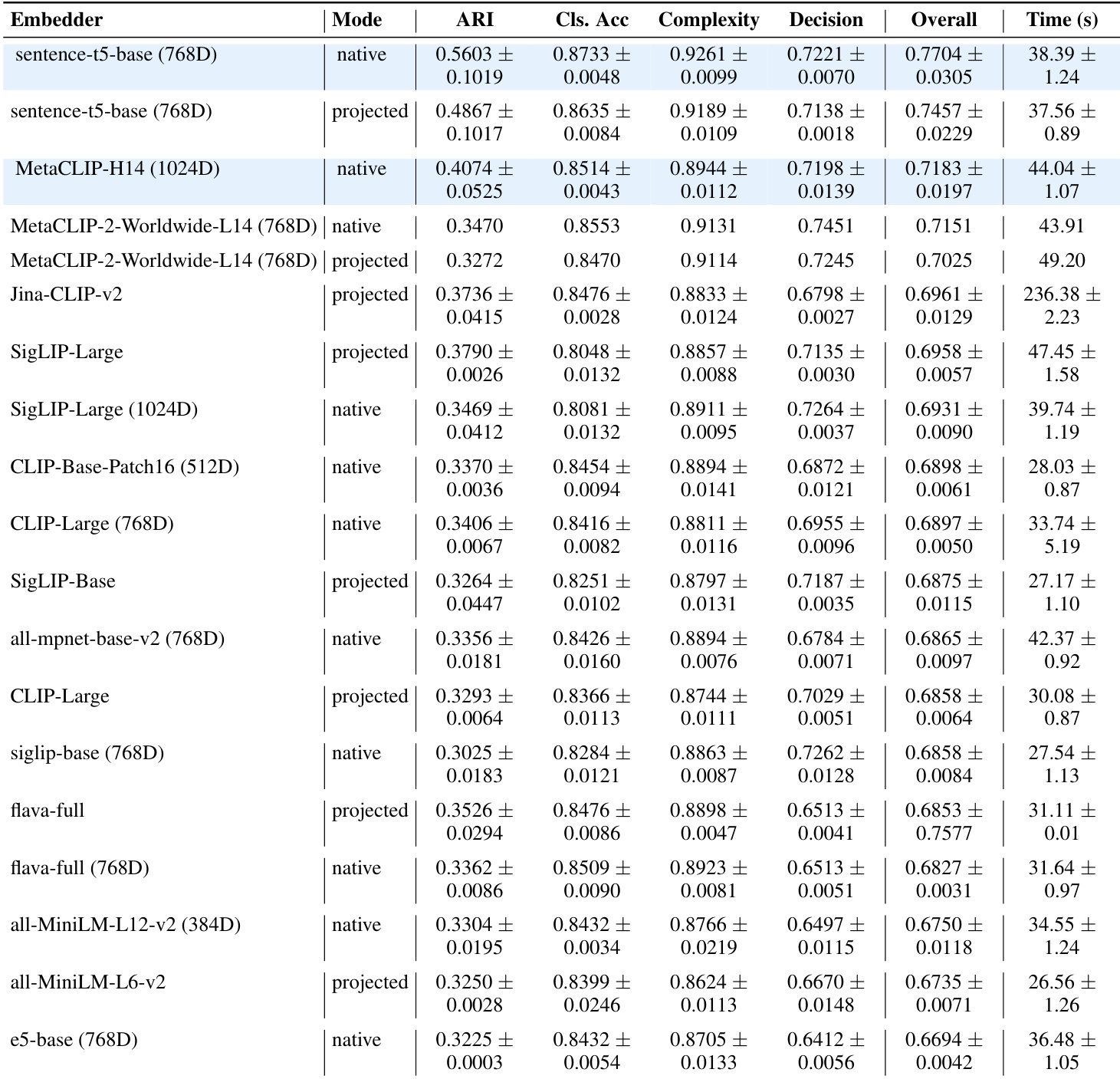

训练过程实现为短周期马尔可夫决策过程,每个周期对应为单个查询配置并执行代理系统。状态 sq 由语义嵌入 ϕ(q)(通过 MetaCLIP-H/14 生成)与编码查询长度、词数和数值密度的特征向量 fq 拼接而成。每个周期结束时收到的奖励信号是三个可解释项的组合:任务成功(α⋅I[correct])、效率惩罚(−βs⋅nsteps−βt⋅ntokens/Tmax)和工具塑形(η⋅Rtool)。工具塑形项是不对称的:当答案正确时奖励工具调用,对分配但未使用的工具施加惩罚,使结构策略的资源配置与 LLM 的实际使用保持一致。

两个策略均使用近端策略优化(PPO)进行端到端优化,分别使用价值网络估计优势,并对每批次优势进行归一化以稳定学习。裁剪代理目标防止破坏性更新,熵正则化鼓励早期探索。如训练流程图所示,RL 训练期间将周期存储在经验回放缓冲区中。收敛后,作者提取精英轨迹(既正确又超过奖励阈值的轨迹),并通过监督学习在该蒸馏数据集上微调策略。此后训练精炼阶段通过将策略支持限制在高性能配置上,稳定策略并提供正式性能保证。

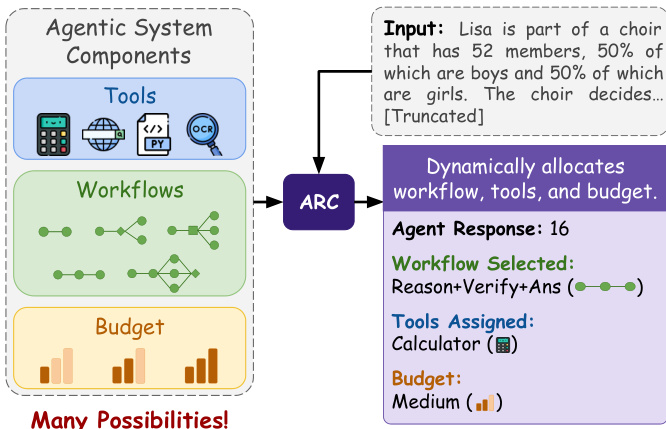

整个系统设计为根据输入查询动态分配工作流、工具和预算,如高层架构图所示。ARC 模块接收查询,通过其分层策略从众多可能性中选择适当配置,生成代理响应及所选工作流、工具和预算层级的元数据。

该架构使系统能根据每个查询的复杂度自适应分配计算资源,在无需手动调优或固定配置的情况下平衡准确性和效率。

实验

- 通过 ARC 学习的配置在推理和工具使用基准测试中始终优于固定架构和基于搜索的方法,验证了自适应结构设计的有效性。

- 自适应分配实现了更优的准确率-成本权衡,ARC 通过为每个查询动态选择轻量或复杂工作流,在较低 token 成本下实现高性能。

- 策略在相似推理任务中表现出中等迁移能力,但在不同工具使用任务中迁移能力有限,表明结构兼容性比语义相似性更重要。

- ARC 在不同模型规模下泛化良好,在应用于同一模型家族的更大变体时无需重新训练即可保持有效性。

- SFT 精炼通过蒸馏精英轨迹提升性能和稳定性,降低方差同时保留学习到的结构先验。

- 错误分析确认策略配置错误极少(<10%),大多数失败源于 LLM 本身的推理或知识缺陷,而非结构误选。

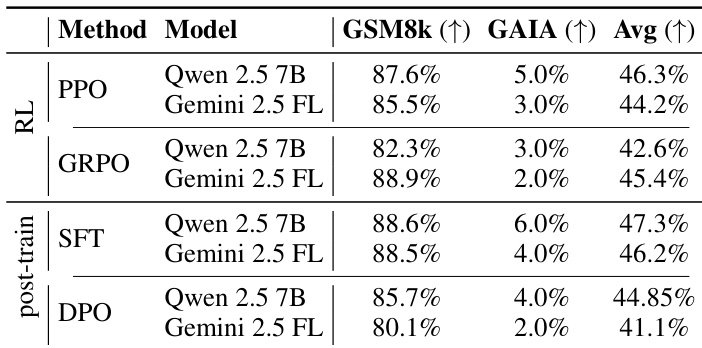

- 消融实验确认带塑形奖励的 PPO 优于 GRPO 和 DPO,学习到的嵌入和提示原子显著影响下游策略效果。

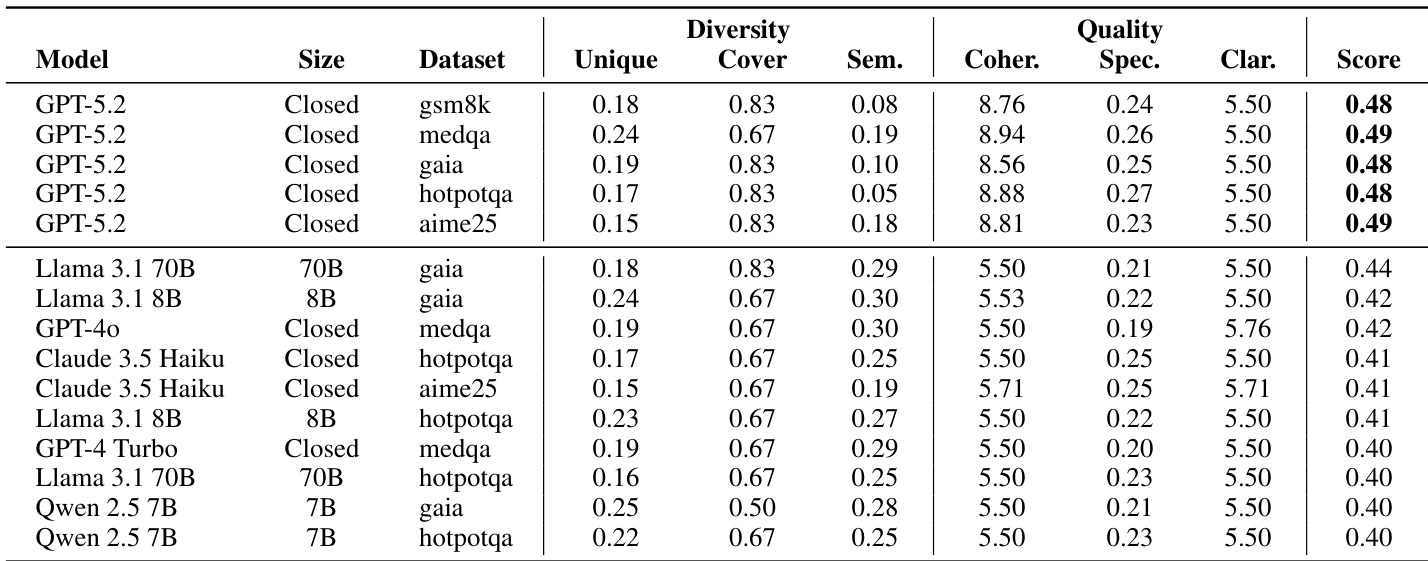

作者使用 GPT-5.2 生成其框架的提示原子,因其在多样性和质量指标上的综合得分高于其他 LLM(如 Llama 3.1、Claude 3.5 和 Qwen 2.5)。结果表明,GPT-5.2 在连贯性、清晰度和策略覆盖方面始终优于替代方案,是构建提示库的最佳选择。

作者使用后训练精炼阶段提升策略性能,SFT 在 Qwen 和 Gemini 模型上均一致优于 DPO 和基线 RL 方法。结果表明,SFT 实现更高的平均准确率和更好的任务特定增益,尤其在 GAIA 上,表明蒸馏精英轨迹增强了泛化能力和稳定性。此精炼步骤对于提升性能下限至关重要,且无需额外环境交互。

作者评估了多个嵌入模型,以确定哪个最支持下游策略学习,在聚类、分类、复杂度排序和决策预测任务中衡量性能。Sentence-T5-base 和 MetaCLIP-H14 表现最佳,在高总分和合理计算成本之间取得平衡,表明其适用于自适应配置系统中编码查询状态。结果证实嵌入质量直接影响策略有效性,文本和多模态模型均可根据任务需求实现强性能。

作者使用学习型配置框架(ARC)自适应选择 LLM 任务的工作流和工具,在推理和工具使用基准测试中优于固定架构和基于搜索的基线。结果表明,ARC 在保持效率的同时实现更高准确率,增益在不同模型规模和共享结构或工具相似性的任务间保持一致。框架的有效性进一步由低策略配置错误率和监督微调精炼后的性能提升支持。

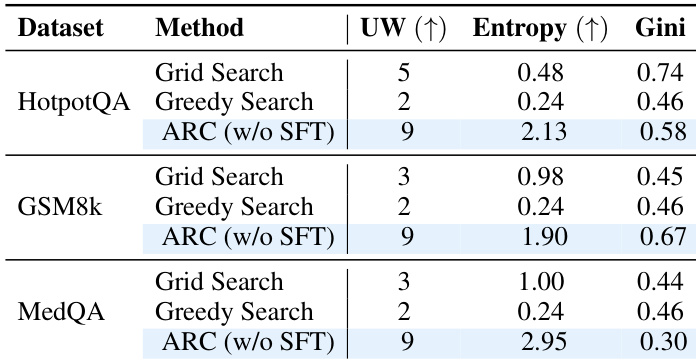

作者使用 ARC 学习自适应工作流配置,观察到相比网格或贪婪搜索基线,工作流多样性显著更高,通过唯一工作流数量、熵和基尼系数衡量。结果表明,ARC 探索更广泛且更均衡的结构模式,表明其能动态调整配置以适应任务需求,而非依赖固定或穷尽搜索策略。