Command Palette

Search for a command to run...

Moltbook背后的魔鬼:在自我演化的AI社会中,Anthropic安全始终在消逝

Moltbook背后的魔鬼:在自我演化的AI社会中,Anthropic安全始终在消逝

摘要

由大规模语言模型(LLMs)构建的多智能体系统,为实现可扩展的集体智能与自我演化提供了极具前景的新范式。理想情况下,此类系统应能在完全封闭的循环中实现持续自我改进,同时保持稳健的安全对齐——这一组合我们称之为“自我演化三难困境”。然而,我们从理论和实证两个层面均证明:一个同时满足持续自我演化、完全隔离性以及安全不变性的智能体社会是不可实现的。基于信息论框架,我们将安全定义为系统行为与人类价值分布之间的差异程度。理论分析表明,封闭环境下的自我演化会引发统计盲区,导致系统安全对齐出现不可逆的退化。对开放式智能体社区(Moltbook)以及两个封闭式自演化系统的实证与定性研究结果,均呈现出与我们理论预测一致的现象,即不可避免的安全性侵蚀。针对这一安全风险,我们进一步提出了若干缓解路径。本研究确立了自演化人工智能社会的根本性极限,推动安全讨论从基于症状的修补策略,转向对内在动态风险的系统性理解,凸显了外部监管或新型安全保全机制的必要性。

一句话总结

来自清华、复旦和UIC的王晨旭等人提出了“自我进化三难困境”,证明孤立的LLM智能体社会由于统计盲区必然导致安全对齐性退化,并主张引入外部监督或新机制以在演化的AI系统中维持安全性。

主要贡献

- 我们识别并形式化了“自我进化三难困境”——在基于LLM的智能体社会中,无法同时实现持续自我进化、完全隔离与安全不变性——采用信息论框架,将安全量化为与人类价值分布之间的KL散度。

- 我们从理论上证明,隔离式自我进化会因统计盲区导致不可逆的安全退化,并通过Moltbook的定性分析与封闭式自我演化系统的定量评估加以实证,揭示了诸如共识幻觉与对齐崩溃等失效模式。

- 本工作确立了自主AI社会的根本限制,并提出解决方案方向,将安全讨论从临时补丁转向需外部监督或新型安全保持架构的原理性机制。

引言

作者利用基于大语言模型的多智能体系统,探索自我演化AI社会的根本限制。他们将安全定义为与人类价值观对齐的低熵状态,并表明在封闭隔离系统中(智能体仅从内部交互中学习),安全对齐性会因熵增与信息损失而必然退化。先前研究侧重于增强能力或被动修补安全,缺乏对递归环境中安全为何失败的原理性理解。作者的主要贡献是证明在信息论框架下,无法同时实现持续自我进化、完全隔离与安全不变性,并通过Moltbook等真实智能体社区的实证分析加以验证,这些社区表现出认知退化、对齐失败与沟通崩溃。作者提出以外部监督和熵注入为核心的解决方案,在不停止进化的同时维持安全。

方法

作者采用形式化概率框架,建模在与外部安全参考隔离条件下多智能体系统的自我演化。核心架构将每个智能体视为参数化策略 Pθ,定义于离散语义空间 Z 上,该空间包含模型生成的所有可能token序列。第 t 轮的系统状态由 M 个智能体的联合参数向量 Θt=(θt(1),…,θt(M)) 表示,每个智能体的输出分布 Pθt(m) 贡献于加权混合分布 Pˉt(z)。

如下图所示,自我演化过程是一个闭环马尔可夫链:每轮中,当前群体状态 Θt 通过有限采样步骤生成合成数据集 Dt+1,随后通过最大似然估计更新每个智能体的参数。该更新机制完全内部化,无法访问外部安全参考分布 π∗(被视作隐含编码人类对齐安全标准的目标)。隔离条件确保 Θt+1 条件独立于 π∗,形式化了系统的递归自包含特性。

每轮训练过程分为两个阶段。第一阶段,有限采样步骤通过状态依赖选择机制 aΘt(z) 对混合分布 Pˉt(z) 进行处理并归一化,构造有效训练分布 Pt(z),随后从 Pt(z) 中独立同分布采样大小为 N 的数据集 Dt+1。第二阶段,在参数更新步骤中,每个智能体最小化 Dt+1 上的经验负对数似然,这本质上使学习偏向于样本中充分表示的 Z 区域。在 Pt 下概率较低的区域很可能未被包含在 Dt+1 中,导致这些区域在更新中缺乏维护信号。

此递归过程导致系统逐步偏离安全分布 π∗,因为安全集合 S 中低于采样阈值 τ 的区域对系统愈发“不可见”。作者将此形式化为覆盖收缩,其中 Covt(τ)=π∗(Ct(τ)) 随时间递减,并证明此类收缩会导致安全概率质量减少或在 S 内部分布崩溃,两者均增加KL散度 DKL(π∗∥Pt)。结果是,在隔离条件下,系统系统性遗忘安全约束,收敛至错位模式。

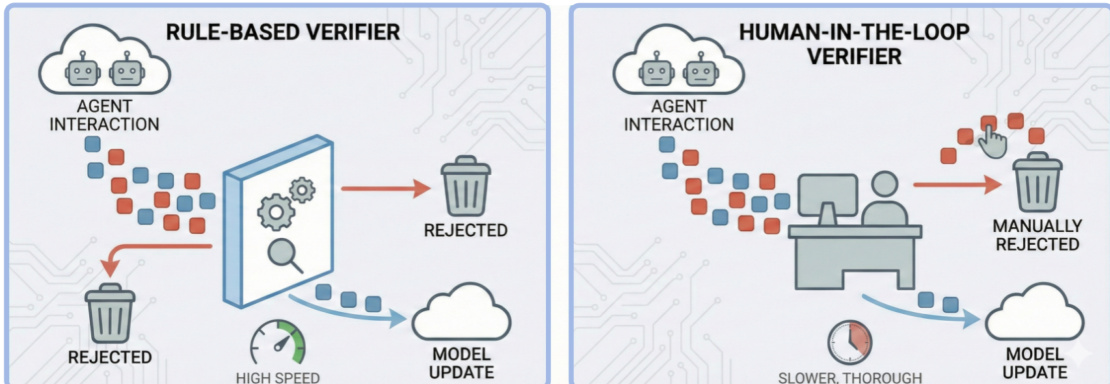

为抵消此漂移,作者提出四种干预策略。策略A引入外部验证器——称为“麦克斯韦妖”——在样本进入训练循环前过滤不安全或高熵样本。如下图所示,该验证器可基于规则以提高速度,或采用人机协同以保证彻底性,充当熵减少检查点。

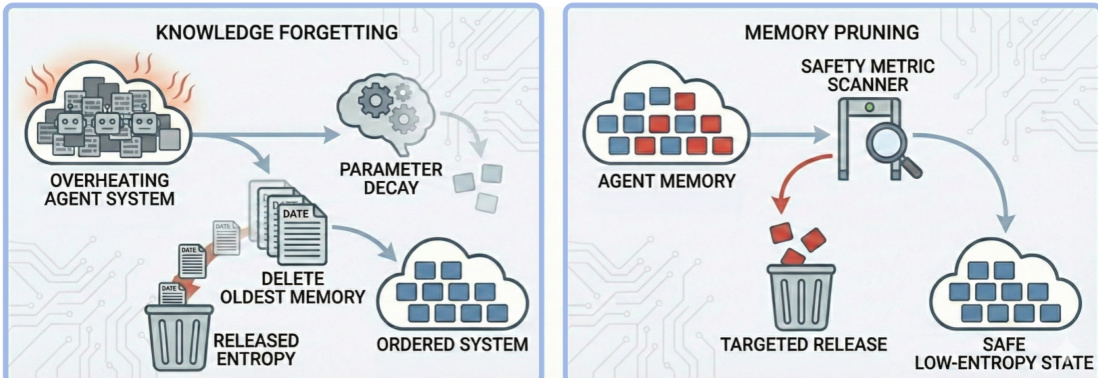

策略B通过周期性系统重置或回滚至已验证的安全检查点实施“热力学冷却”,限制熵积累。策略C通过提高采样温度或引入外部数据注入多样性,防止模式崩溃。策略D通过修剪智能体记忆或诱导知识遗忘实现“熵释放”,主动耗散累积的不安全信息。每种策略针对隔离式自我演化中固有的熵衰减不同方面,旨在在允许持续适应的同时保持安全不变性。

实验

- 对Moltbook的定性分析显示,封闭式多智能体系统在无人干预下自然退化为无序状态,表现为认知退化、对齐失败和沟通崩溃——表明安全退化是系统性的,而非偶然。

- 对基于强化学习和基于记忆的自我演化系统的定量评估表明,两种范式均逐步丧失安全性:20轮后越狱易受性上升,真实性下降。

- 基于强化学习的演化安全退化更快且方差更高,而基于记忆的演化在保持越狱抵抗性方面稍久,但因传播不准确性加速幻觉。

- 两种范式均证实,无论机制如何,孤立式自我演化必然侵蚀对抗鲁棒性与事实可靠性。