Command Palette

Search for a command to run...

通过建模基于流的GRPO中的步骤级与长期采样效应缓解稀疏奖励问题

通过建模基于流的GRPO中的步骤级与长期采样效应缓解稀疏奖励问题

摘要

在流匹配(Flow Matching)模型中应用GRPO(Group Relative Policy Optimization)已被证明对文本到图像生成任务具有显著效果。然而,现有方法通常将基于结果的奖励传播至所有先前的去噪步骤,而未区分每个步骤的局部影响。此外,当前的分组排序机制主要在相同时间步上比较不同轨迹,忽略了轨迹内部的依赖关系——某些早期去噪操作可能通过延迟的、隐式的交互影响后续状态。为此,我们提出TurningPoint-GRPO(TP-GRPO),一种新型GRPO框架,旨在缓解步骤级奖励稀疏问题,并显式建模去噪轨迹中的长期影响。TP-GRPO实现两大核心创新:(i)将基于结果的奖励替换为步骤级增量奖励,提供密集且步骤感知的学习信号,更有效地分离每个去噪动作的“纯”影响;(ii)识别“转折点”——即奖励局部趋势发生反转、且后续奖励演化与整体轨迹趋势一致的关键步骤——并对这些步骤赋予聚合的长期奖励,以捕捉其延迟产生的影响。转折点的检测仅依赖于增量奖励符号的变化,无需额外超参数,使TP-GRPO在计算上高效且无需调参。大量实验表明,TP-GRPO能够更有效、更一致地利用奖励信号,显著提升生成质量。相关演示代码已开源,地址为:https://github.com/YunzeTong/TurningPoint-GRPO。

一句话总结

来自清华大学、阿里巴巴等机构的研究人员提出了 TP-GRPO,这是一种 GRPO 的变体,它用密集的步级信号替代稀疏的最终结果奖励,并识别转折点以捕捉延迟效应,从而在无需超参数的情况下更好地建模去噪轨迹动态,提升文生图生成效果。

主要贡献

- TP-GRPO 用步级增量奖励替代基于最终结果的稀疏奖励,以隔离每个去噪动作的纯粹影响,减少奖励稀疏性,提升 Flow Matching 模型在强化学习微调过程中的信用分配效果。

- 它引入“转折点”——通过增量奖励符号变化识别的步骤,这些步骤会反转局部奖励趋势,并被赋予聚合的长期奖励,以显式建模对图像生成连贯性至关重要的轨迹内延迟依赖关系。

- 在标准文生图基准测试中,TP-GRPO 通过更有效地利用奖励信号,持续优于之前的 GRPO 方法(如 Flow-GRPO 和 DanceGRPO),且无需增加超参数,实现高效部署。

引言

作者利用基于流的生成模型和强化学习,解决文生图生成中的稀疏和错位奖励问题。先前方法如 Flow-GRPO 将最终图像奖励均匀分配给所有去噪步骤,忽略各步骤的特定贡献及轨迹内的动态变化,导致奖励稀疏和局部-全局错位。为解决此问题,他们提出 TurningPoint-GRPO,通过增量奖励差值计算步级奖励,并显式建模关键“转折点”步骤的长期影响——这些步骤反转局部奖励趋势,从而实现更精确的信用分配,且无需额外超参数。

方法

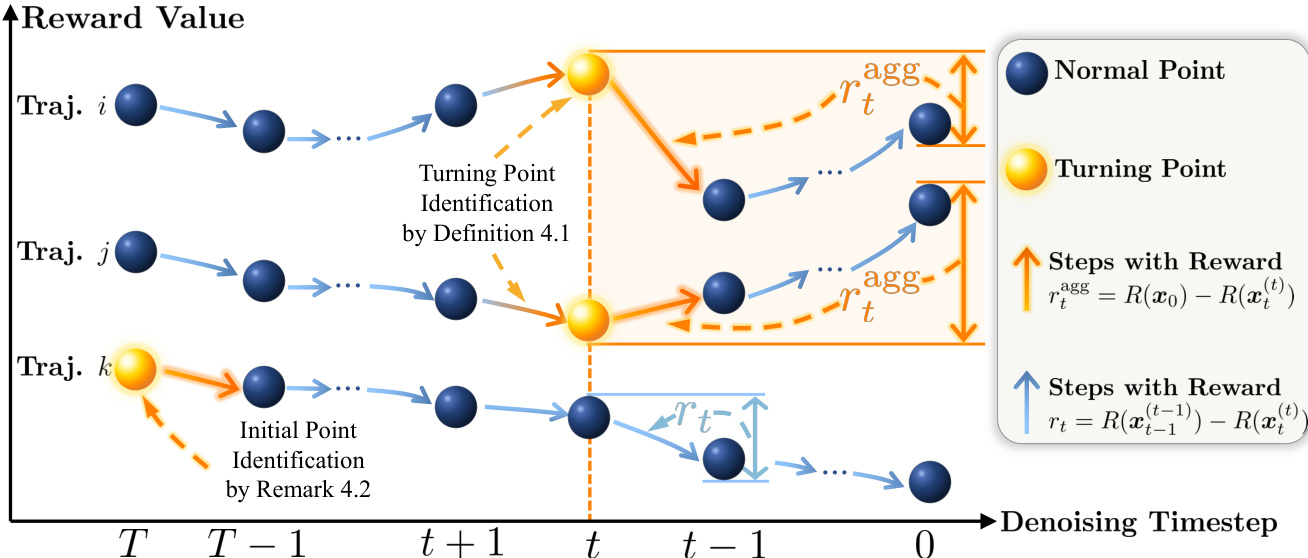

作者采用改进的 GRPO 框架——TurningPoint-GRPO(TP-GRPO),以解决基于流匹配的文生图生成中的奖励稀疏与错位问题。其核心创新在于:用步级增量奖励替代基于结果的奖励,并通过“转折点”显式建模长期效应——这些步骤反转局部奖励趋势,使其与全局轨迹趋势对齐。该设计使去噪轨迹上的信用分配更精确。

该方法首先使用基于 SDE 的采样器采样多样轨迹,在反向去噪过程中注入随机性。对每条轨迹,缓存中间潜在变量,并从每个潜在变量出发应用 ODE 采样至完成,以获得对应的清晰图像。这使得奖励模型可评估所有先前 SDE 步骤的累积效应。从 xt 到 xt−1 的步级奖励 rt 计算为 ODE 完成图像的奖励差值:rt=R(xt−1ODE(t−1))−R(xtODE(t))。该增量奖励隔离了每个去噪动作的“纯粹”效应,提供密集且感知步级的信号,避免了仅传播单一终端奖励所固有的稀疏性。

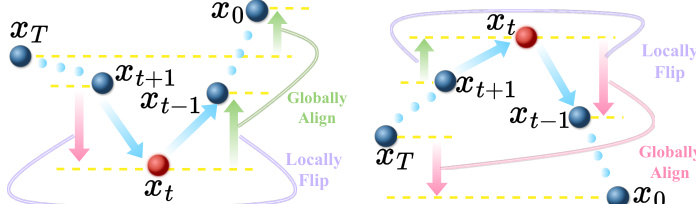

转折点基于这些增量奖励的符号变化识别。若某时间步 t 的局部奖励趋势反转并符合整体轨迹趋势,则其被认定为转折点。具体而言,作者通过局部步增益与从该步至终点的累积增益之间的符号一致性定义转折点。如下图所示,转折点在视觉上表现为局部奖励方向反转并与全局轨迹趋势对齐,区别于未反转或与全局方向错位的普通点。

在识别出的转折点处,局部步奖励 rt 被替换为聚合奖励 rtagg=R(x0)−R(xtODE(t)),该奖励捕获从转折点到最终图像的累积效应。此聚合奖励编码了去噪动作对后续步骤的延迟隐式影响。作者进一步引入更严格的“一致转折点”标准——要求聚合奖励的绝对值大于局部奖励,确保仅选择具有显著长期影响的步骤。

为解决初始去噪步骤未被纳入转折点检测的问题,作者通过注释 5.2 扩展框架:若第一步的局部奖励变化与整体轨迹趋势一致,则其有资格被赋予聚合奖励。这确保早期关键决策的长期影响也被建模。

整体训练过程遵循分组排序方案。对每个时间步,奖励(rt 或 rtagg)在一组轨迹中归一化以计算优势值。策略通过包含 KL 正则项的裁剪目标优化,以防止偏离参考策略过多。采用平衡策略,在每批次中维持正负聚合奖励数量大致相等,避免优化偏差。

请参考框架图以获得方法的可视化概览。该图展示了如何计算步级奖励、识别转折点及分配聚合奖励以捕获长期效应,并突出通过注释 5.2 包含初始步骤,确保对整个去噪轨迹内隐式交互的全面建模。

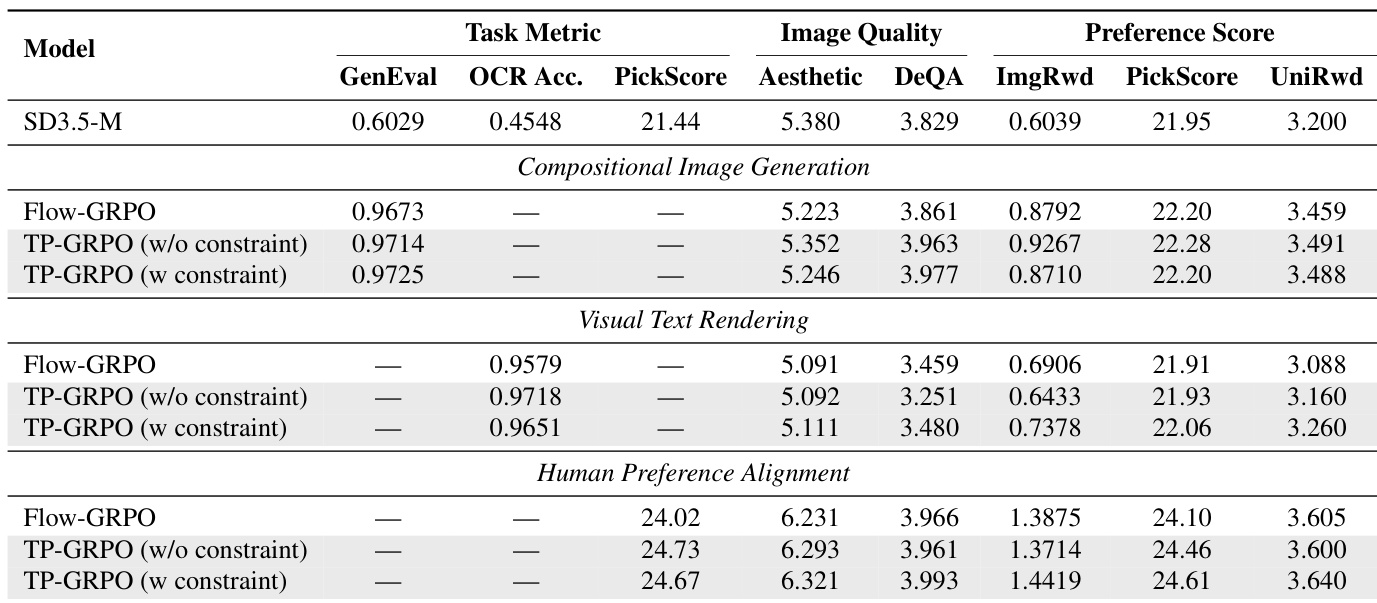

实验

- TP-GRPO 变体在组合图像生成、视觉文本渲染和人类偏好对齐任务中均优于 Flow-GRPO,在不引发奖励作弊的前提下提升准确性、美学性和内容对齐度。

- 无 KL 惩罚的训练证实 TP-GRPO 具有更强的探索能力和更快的收敛速度,尤其在 PickScore 等非规则奖励上表现突出。

- 适度缩小 SDE 采样窗口(如缩至 8 步)可提升效率和性能,但过度缩小会损害转折点捕获。

- 噪声尺度 α 在 0.7 左右时性能最优;过低或过高均会降低表现,但 TP-GRPO 在不同设置下仍保持稳健。

- 该方法可推广至 FLUX.1-dev 基础模型,在调整超参数后仍优于 Flow-GRPO。

- 定性结果显示,TP-GRPO 更好地处理稀疏的规则奖励,避免文本遗漏/重叠,并生成语义更连贯、美学更对齐的输出。

作者使用 TP-GRPO 通过引入步级奖励和转折点检测来优化扩散模型训练,在组合图像生成、视觉文本渲染和人类偏好对齐任务中持续提升性能。结果表明,TP-GRPO 的两种变体在任务特定指标上均优于 Flow-GRPO,同时维持或提升图像质量和偏好评分。该方法在不同基础模型和超参数设置下亦表现出更快的收敛速度和鲁棒性。