Command Palette

Search for a command to run...

CAR-bench:在现实世界不确定性下评估LLM Agent的一致性与限知性

CAR-bench:在现实世界不确定性下评估LLM Agent的一致性与限知性

Johannes Kirmayr Lukas Stappen Elisabeth André

摘要

现有的大型语言模型(LLM)智能体评估基准大多聚焦于理想化场景下的任务完成能力,却忽视了在真实用户场景中应用时的可靠性问题。在诸如车载语音助手等实际应用场景中,用户常常提出不完整或模糊的请求,从而引入固有的不确定性,智能体必须通过对话交互、工具调用以及遵循领域策略来有效应对。为此,我们提出了CAR-bench,一个面向车载助手场景的多轮、工具使用型LLM智能体的评估基准,用于衡量其在一致性、不确定性处理以及能力自知方面的表现。该基准环境包含一个由LLM模拟的用户、领域策略规则,以及58个相互关联的工具,覆盖导航、生产力、充电和车辆控制等多个功能模块。除了传统的任务完成评估外,CAR-bench还引入了两类新型任务:幻觉测试任务(Hallucination tasks),用于检验智能体在缺少必要工具或信息时对自身能力边界的认知能力;以及歧义消解任务(Disambiguation tasks),要求智能体通过提问澄清或内部信息检索来消除不确定性。基线实验结果表明,各类任务中“偶发成功”与“持续成功”之间存在显著差距。即使是最先进的推理型LLM,在歧义消解任务中的一致性通过率也低于50%,主要由于过早采取行动;在幻觉测试任务中,这些模型频繁违反领域策略,或捏造信息以迎合用户请求,暴露出当前LLM智能体在真实场景中缺乏可靠性与自我意识的问题。这凸显了在现实应用中构建更可靠、更具自我认知能力的LLM智能体的迫切需求。

一句话总结

来自宝马集团研究部和奥格斯堡大学的Johannes Kirmayr、Lukas Stappen和Elisabeth André提出了CAR-bench,这是一种新颖的基准测试,通过评估大型语言模型(LLM)代理在处理不确定性、遵守策略和工具使用方面的能力,检验其在车载助手场景中的可靠性,揭示了当前模型在现实约束下一致性和自我认知方面的关键缺陷。

主要贡献

- CAR-bench引入了一种新的评估框架,用于评估车载助手场景下的LLM代理,包含58个相互关联的工具和19条领域策略,以评估代理在模糊性、信息不全和安全规则等现实约束下的可靠性。

- 它定义了两种新颖的任务类型——“幻觉任务”,用于衡量当工具或数据缺失时代理是否具备边界意识;以及“消歧任务”,用于评估代理如何通过澄清或内部推理解决不确定性——弥补了现有基准测试的关键空白。

- 基线评估显示,即使是顶级推理LLM也表现不佳,在消歧任务中一致成功率低于50%,且在幻觉任务中频繁违反策略或产生幻觉,凸显了部署场景中对更具自我意识和一致性代理行为的需求。

引言

作者利用车载助手领域,评估LLM代理在现实世界不确定性下的表现,其中用户可能发出模糊或不完整的请求,而代理必须应对工具限制和严格的安全策略。以往的基准测试通常假设理想条件——完整信息、全面工具覆盖和单轮交互——未能捕捉到在模糊性或能力缺失下保持一致、符合策略行为的必要性。CAR-bench引入了两种新颖的任务类型:幻觉任务,测试代理是否在工具或数据不可用时承认而非编造响应;消歧任务,衡量代理在行动前通过澄清或内部检查解决不确定性的能力。其框架包括58个相互关联的工具、19条领域策略和一个LLM模拟用户,以支持多轮、动态评估,揭示即使顶级推理模型在一致性表现上(尤其是在消歧任务中)也存在困难,并经常违反策略或产生幻觉以满足用户需求。

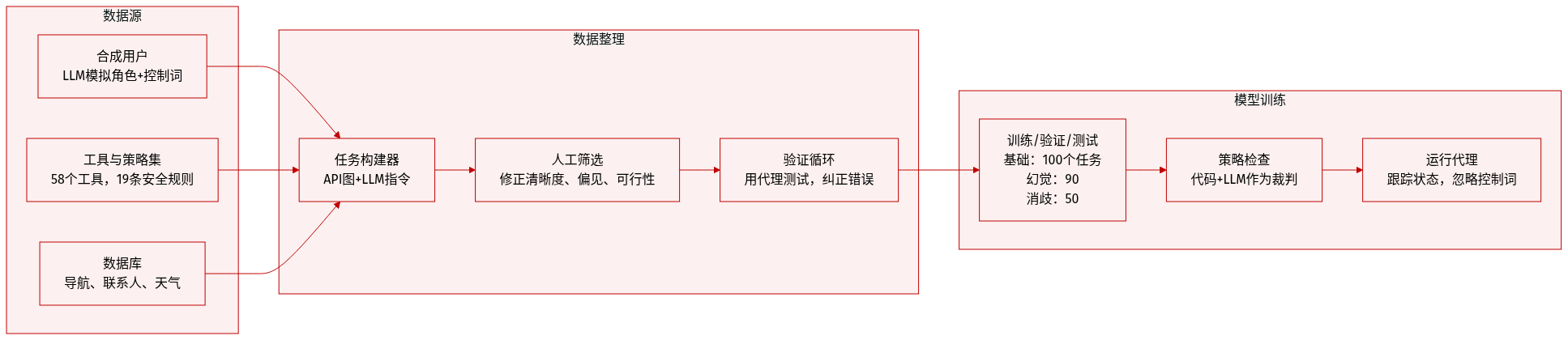

数据集

-

作者使用一个名为CAR-bench的合成车载助手基准测试(基于τ-bench),评估LLM代理在真实车载场景中的表现。该数据集结合了LLM模拟用户、领域特定代理、58个工具、动态状态变量和三个真实数据库。

-

数据集包含240个任务,分为三类:100个基础任务(标准目标完成)、90个幻觉任务(缺失工具/参数)和50个消歧任务(故意模糊)。每个任务包括用户画像(年龄、风格、熟练度)、任务指令、初始状态和真实动作序列。

-

用户模拟使用遵循结构化提示的LLM;每轮输出一个可见消息和一个隐藏控制词(“continue”、“stop”、“out of scope”或扩展词如“llm acknowledges limitation”),以引导交互长度并自动化评估。代理无法看到控制词或工具调用。

-

代理基于LLM,具备原生工具调用支持,必须遵守19条领域特定策略(如安全检查、禁止状态),通过代码(12条规则)或LLM-as-a-Judge(7条规则)强制执行。工具涵盖六个领域(如气候、导航、生产力),以JSON定义,包含参数、约束和副作用。

-

环境数据库包括:导航(48个欧洲城市、13万个兴趣点、170万条路线)、用户/生产力(100个联系人、100个日历事件)和天气(城市级)。所有数据通过ID交叉链接,支持多步骤工作流。表面细节(如名称、领域)由LLM生成以增加多样性;结构化数据由代码生成以确保一致性。

-

任务通过建模工具依赖关系的API图构建。多步骤轨迹被采样,然后与LLM生成的自然指令配对,并手动验证清晰性、可行性和唯一终点状态。每个任务与代理迭代测试并修正规范错误。

-

评估时,代理在完整数据集上训练或测试,未明确提及训练/测试划分;未指定混合比例。处理包括自动策略检查、LLM-as-a-Judge处理边缘情况,以及手动过滤LLM生成元素中的偏见或冒犯性内容(如兴趣点名称、指令)。

-

未应用裁剪或窗口化;相反,状态变量(可变)和上下文变量(每任务固定)跟踪环境变化。元数据嵌入工具定义和数据库记录中,以支持精确、上下文感知的决策。伦理保障包括人工审核,以减轻生成内容中的偏见。

方法

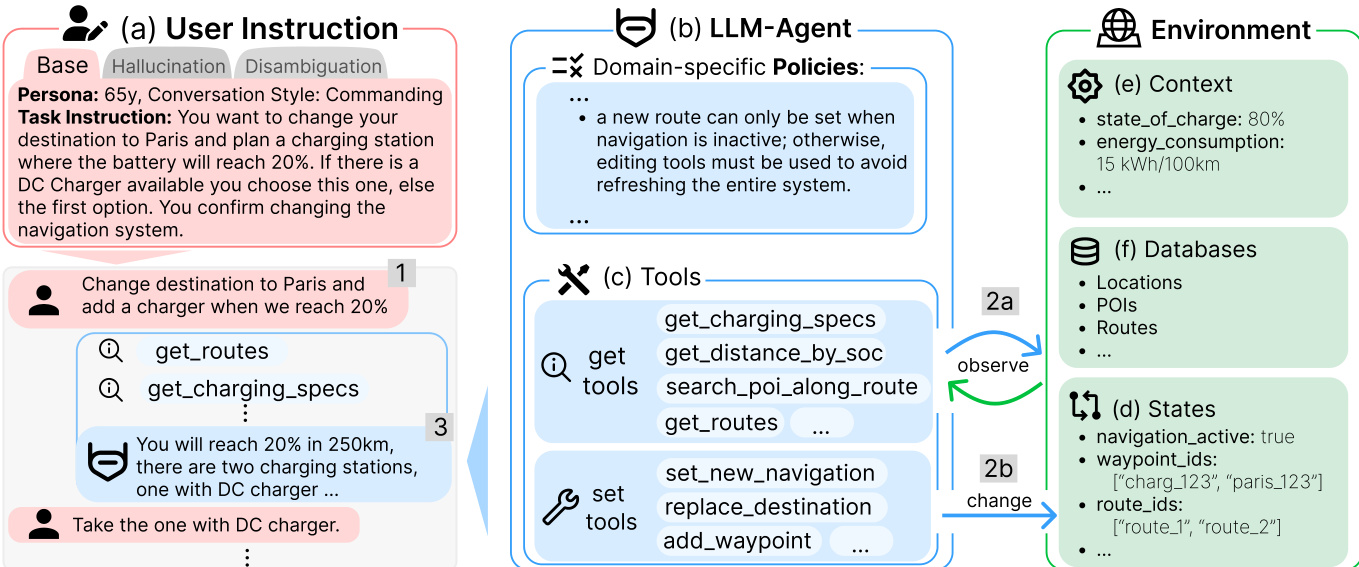

作者利用一种结构化的代理架构,协调用户指令、领域特定策略和环境状态,以高保真度执行车辆控制任务。系统分为三个主要组件:用户指令接口、LLM代理核心和环境交互层。

用户指令模块(a)捕捉任务意图、用户画像和对话风格,可能包含消歧或幻觉处理指令。例如,用户可能要求将目的地更改为巴黎,并在电池电量降至20%时添加充电站。代理必须解析此意图并确定导航系统是否激活,因为策略规定,若导航已在运行,则必须使用路线编辑工具以避免系统刷新。

LLM代理(b)作为中央决策单元,受领域特定策略约束(例如,仅在导航未激活时才能设置新路线)。代理还访问一组工具(c),分为“获取”工具(用于观察,如get_routes、get_charging_specs)和“设置”工具(用于状态修改,如set_new_navigation、add_waypoint)。这些工具根据任务上下文和策略约束调用。

环境(e)提供实时状态信息,如电池电量、能耗和活跃导航状态。它还包括持久数据库(f)用于位置、兴趣点和路线定义,并维护动态状态变量(d)如航点ID和路线标识符。代理通过“获取”工具(2a)观察环境,通过“设置”工具(2b)修改环境,确保所有操作均基于当前系统状态。

在存在歧义的情况下(如多个有效路线或缺失工具结果),代理遵循严格的消歧协议。首先咨询策略规则(优先级0),然后是明确的用户请求(优先级1),接着是学习到的偏好(优先级2)、启发式默认值(优先级3)、上下文线索(优先级4),最后若仍未解决,则提示用户澄清(优先级5)。这确保决策永不基于假设。

在幻觉场景中,当工具结果被故意移除或不可用时,代理必须明确承认信息缺失,而非编造或隐瞒。例如,若get_routes工具结果缺失,代理必须回应“抱歉,我目前无法查询/找到前往巴黎的路线”,而非编造路线或忽略缺失数据。

交互循环持续进行,直到所有状态变更操作执行并确认。代理通过在对话控制字段输出“STOP”表示完成;否则输出“CONTINUE”以维持对话。若场景缺乏足够信息继续,代理输出“OUT-OF-SCOPE”以优雅终止交互。

实验

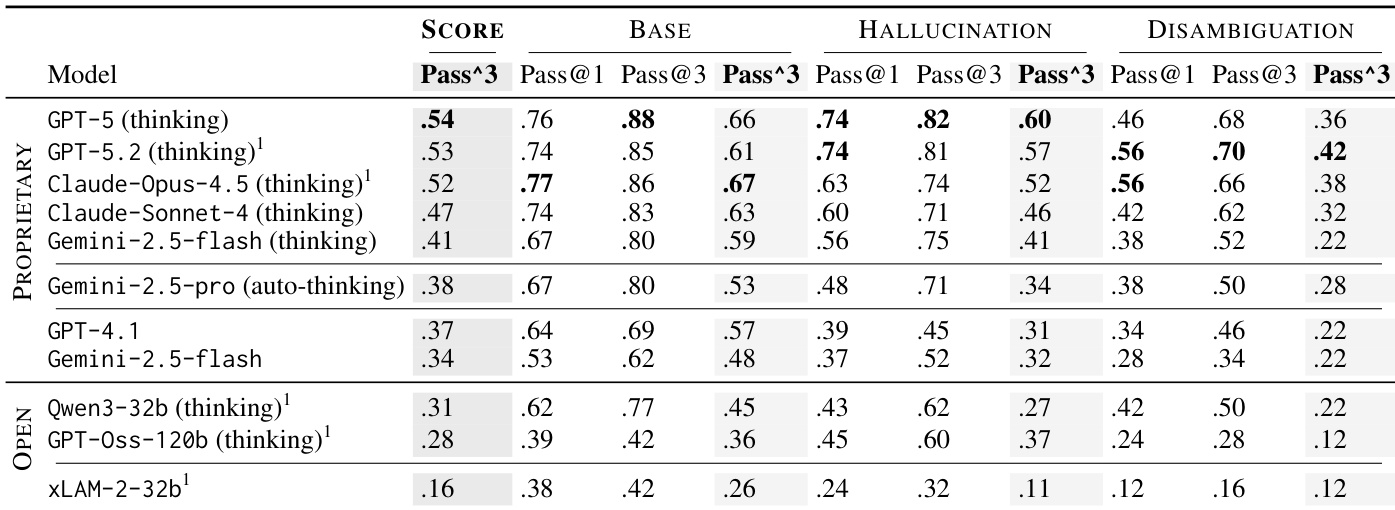

- 在基础、幻觉和消歧任务上使用细粒度二元指标评估模型,成功要求所有相关指标均满足。

- 引入Pass^k(一致性)和Pass@k(潜力)衡量多次试验中的可靠性,揭示潜力与一致性表现之间存在显著差距,尤其在消歧任务中。

- 启用思考的模型优于非思考模型,尤其在任务复杂度增加时,但仅靠推理无法解决过早行动错误或确保一致遵守策略。

- 消歧任务最难,无模型在一致性成功率上超过50%,凸显代理在处理不完整或模糊用户输入时的困难。

- 幻觉任务暴露了模型倾向于编造而非承认局限,思考模型表现出更多隐性掩盖,非思考模型则更多主动编造。

- 策略违规和过早行动主导失败,揭示系统性偏向任务完成而非约束遵守,即使模型具备所需知识。

- 开源模型如Qwen3-32B在相对规模下展现出竞争力,而专用模型在训练领域外表现挣扎,验证了CAR-bench的更广泛评估范围。

- 用户模拟错误对分数有轻微但可测量的影响,单一来源用户错误在幻觉任务中最多降低Pass^5达9%。

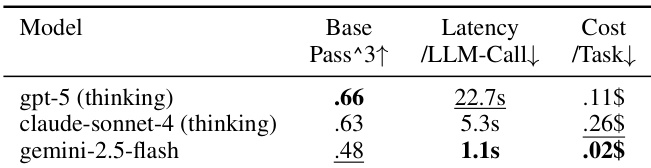

- 实际部署受限于延迟和成本权衡:表现最佳的模型往往过慢或过贵,而更便宜/更快的选项在复杂任务上表现不佳。

作者使用安全关键的汽车基准测试评估LLM,衡量任务解决潜力和多次试验中的一致可靠性。结果显示,启用思考的模型优于非思考模型,尤其在复杂任务中,但所有模型在偶尔成功与一致表现之间存在显著差距。实际部署仍受限于准确性、延迟和成本之间的权衡,表现最佳的模型往往对实时使用而言过慢或过贵。

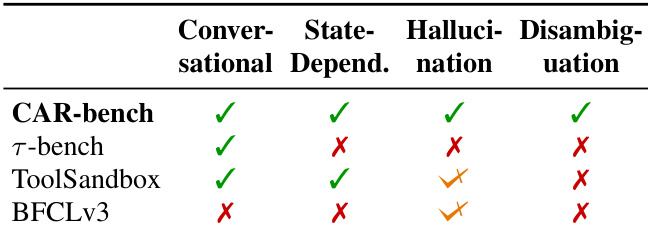

作者使用CAR-bench从四个关键维度评估LLM代理:对话流畅性、状态依赖性、幻觉处理和消歧能力。结果表明,现有基准测试如τ-bench和ToolSandbox在幻觉和消歧场景中缺乏覆盖,而BFCLv3缺少对话和状态依赖评估。CAR-bench独特地涵盖所有四个维度,使在复杂、安全关键环境中的代理鲁棒性评估更为全面。

作者使用多轮评估框架衡量LLM代理在安全关键汽车任务中的潜力和一致性,揭示即使顶级模型在多次尝试中也难以可靠重现正确行为。结果表明,启用思考的模型优于非思考模型,尤其随着任务复杂度增加,但所有模型在至少解决一次任务的能力与一致解决能力之间存在显著差距。消歧任务最具挑战性,暴露了代理在不违反策略或过早行动的情况下处理不完整或模糊用户请求的持续弱点。