Command Palette

Search for a command to run...

OCRVerse:迈向端到端视觉-语言模型中的全面OCR

OCRVerse:迈向端到端视觉-语言模型中的全面OCR

Yufeng Zhong Lei Chen Xuanle Zhao Wenkang Han Liming Zheng Jing Huang Deyang Jiang Yilin Cao Lin Ma Zhixiong Zeng

摘要

大规模视觉语言模型的发展推动了对海量多模态数据的管理与应用需求,使得从视觉图像中提取信息的光学字符识别(OCR)技术日益受到关注。然而,现有的OCR方法主要聚焦于从图像或扫描文档中识别文本内容(以文本为中心的OCR),忽视了从视觉信息密集型图像源中识别视觉元素的重要性(以视觉为中心的OCR),例如图表、网页以及科学绘图等。事实上,这类视觉信息密集型图像在互联网上广泛存在,具有重要的现实应用价值,如数据可视化与网页分析。在本技术报告中,我们提出了OCRVerse——首个以端到端方式实现的综合性OCR方法,能够统一支持以文本为中心的OCR与以视觉为中心的OCR。为实现这一目标,我们构建了全面的数据工程体系,涵盖广泛的以文本为中心的文档(如报纸、杂志和书籍),以及以视觉为中心的渲染合成图像(包括图表、网页和科学绘图)。此外,我们提出了一种两阶段的SFT-RL多领域训练方法用于OCRVerse:首先,通过监督微调(SFT)直接混合跨领域数据进行训练,建立初始的领域知识;随后,强化学习(RL)阶段则针对各领域的特性设计个性化的奖励策略。具体而言,由于不同领域对输出格式和预期结果的需求各异,我们在RL阶段提供了充分的灵活性,以定制化地生成适用于各领域的灵活奖励信号,从而有效提升跨领域融合能力,避免数据冲突。实验结果表明,OCRVerse在以文本为中心与以视觉为中心的多种数据类型上均展现出优异性能,其表现甚至可与大型开源及闭源模型相媲美,验证了该方法的有效性与先进性。

一句话总结

美团的研究人员提出了 OCRVerse,这是首个通过两阶段 SFT-RL 训练方法统一文本导向与视觉导向 OCR 的端到端模型,支持灵活的领域特定奖励机制,可处理来自文档、图表和网页的多样化输出,性能媲美主流模型。

主要贡献

- OCRVerse 引入了首个端到端的全栈 OCR 框架,统一文本导向与视觉导向识别,填补了传统 OCR 方法在处理图表、网页和科学绘图等视觉密集型内容时的空白。

- 该方法采用两阶段 SFT-RL 训练策略:SFT 阶段混合跨领域数据构建基础能力,RL 阶段为每个领域定制奖励信号,以解决输出格式冲突并提升领域特定性能。

- 在多个数据集上评估,OCRVerse 在文本导向和视觉导向任务上均取得具有竞争力的结果,无需领域微调即可媲美大型开源与闭源模型。

引言

作者利用视觉-语言模型的兴起,将 OCR 视为一项统一的全栈任务,覆盖文本导向文档和视觉导向图像(如图表和网页)。以往方法要么仅聚焦文本提取,要么孤立处理视觉元素,无法捕捉复杂视觉中的语义结构,或协调跨领域的冲突输出格式。OCRVerse 通过引入轻量级模型与两阶段 SFT-RL 方法解决此问题:监督微调阶段融合多样化数据构建跨领域基础能力,强化学习阶段应用领域特定奖励机制解决冲突并优化结构敏感输出(如 HTML 或 LaTeX)。最终形成单一端到端系统,在两类 OCR 范式中均表现优异,适用于数据可视化与网页分析等实际场景。

数据集

作者使用 OCRVerse——一个统一的全栈 OCR 数据集,融合文本导向与视觉导向数据类型,支持多样化真实世界与专业场景。

-

数据集组成与来源:

- 文本导向数据涵盖 9 类文档:自然场景、书籍、杂志、论文、报告、幻灯片、试卷、笔记、报纸——来源包括开源数据集(LSVT、TextOCR、PDFA、DocStruct4M、DocGenome、IAM、ORAND-CAR、HME)、真实 PDF 及合成数据(K12 至研究生考试题、StackExchange 数学公式)。

- 视觉导向数据涵盖 6 个专业领域:图表、网页、图标、几何、电路、分子——来源包括 MCD、MSRL、Web2M、Web2Code、UniSVG、DaTikZ-v3、Cosyn-400k 及 text-to-mermaid 数据集。

-

各子集关键细节:

- 文本导向:通过质量检查、页面分割、正则提取和复杂度分类清洗;标注使用 VLM(Qwen2.5-VL-72B、GOT)、OCR 工具及带 MathJax/CSS 渲染的合成 HTML 模板。

- 视觉导向:通过移除损坏图像和嵌入视觉元素清洗;通过自举的领域特定模型(图表转代码、网页转 HTML、图像转 SVG、图像转 LaTeX)进行自标注,以扩展覆盖范围。

-

训练用途:

- 训练数据通过多阶段流水线整合两类数据构建。

- RL 训练阶段,样本通过基于熵的过滤(文本导向)或质量优化(视觉导向)选择,聚焦高难度、高复杂度案例。

- 最终训练混合平衡两类数据,支持全栈 OCR 能力。

-

处理与元数据:

- 文本导向标注包括边界框、颜色引导区域解析、LaTeX 公式及 HTML 表格。

- 视觉导向标注通过渲染与结构提取生成领域特定代码(SVG、HTML、LaTeX、mermaid)。

- 未明确提及裁剪策略;重点为整页或元素级处理,输出结构化格式。

- 在 OmniDocBench v1.5(1,355 页,双语,9 类文档)上评估,使用编辑距离、CDM 和 TEDS 指标,聚合为综合得分。

方法

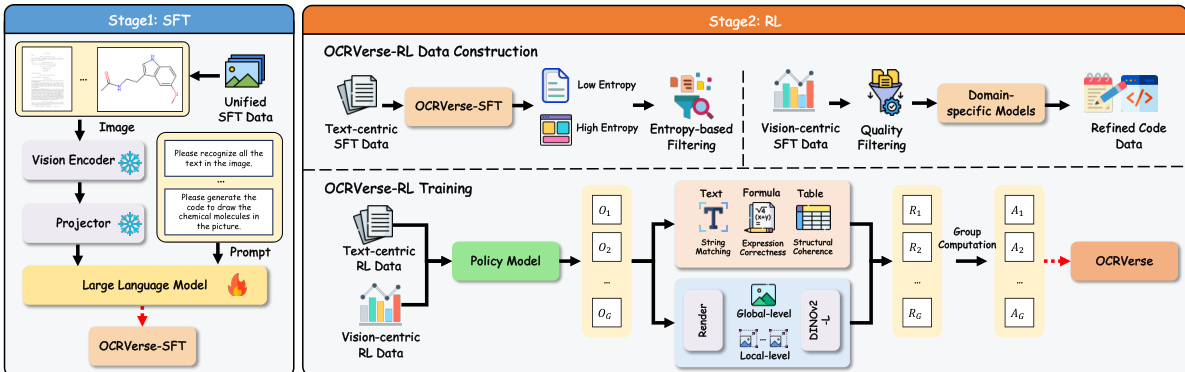

作者为 OCRVerse 设计了两阶段训练方法,旨在首先建立广泛的跨领域知识,再通过个性化优化精炼领域特定性能。如图所示,整体框架包含监督微调(SFT)阶段与强化学习(RL)阶段,分别解决模型学习过程的不同方面。

在 SFT 阶段,模型在融合了全部八个领域的统一数据集上微调,包括文本导向(如文档、表格、公式)与视觉导向(如图表、网页、科学绘图)数据。跨领域数据混合使模型学习不同数据类型的共享视觉-语义模式,同时保留领域特定输出能力。训练目标为标准自回归语言建模,模型学习根据输入图像与前序 token 预测输出序列的下一个 token。作者微调预训练的 Qwen3-VL-4B 模型,冻结视觉编码器与视觉-语言适配器以保留强视觉表征,仅更新语言模型参数以提升文本生成与格式合规性。

RL 阶段通过引入个性化奖励机制解决 SFT 在处理领域特定需求与格式密集内容时的局限。框架始于领域特定数据构建,数据基于熵过滤以确保高质量输入。对于文本导向领域,采用基于规则的奖励函数评估不同内容类型:归一化编辑距离(纯文本)、LaTeX 归一化后的 BLEU 分数(公式)、结构归一化后的 TEDS-S(表格)。整体文本导向奖励为这些类型特定奖励的加权平均。对于视觉导向领域,设计视觉保真度奖励以衡量渲染输出与真实图像的感知相似性:使用预训练 DINOv2 编码器提取视觉特征,结合多尺度机制——全局相似性(下采样缩略图)与局部相似性(图像块)。此外,格式对齐奖励确保生成代码符合预期编程语言。

策略优化使用分组相对策略优化(GRPO)。对每个输入,从当前策略采样一组响应并计算其奖励,计算每组归一化优势值,并通过最大化裁剪目标函数优化策略以确保训练稳定性。该两阶段方法使 OCRVerse 能在 SFT 阶段有效建立跨领域知识,在 RL 阶段精炼领域特定能力,实现多样化数据类型的无缝融合,同时避免朴素多任务学习引发的冲突。

实验

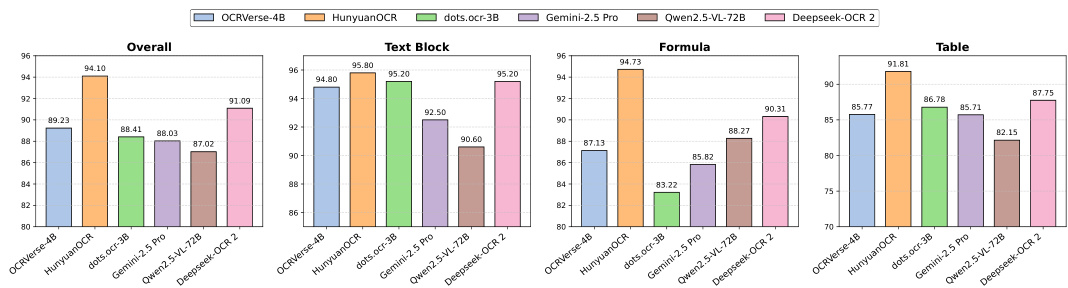

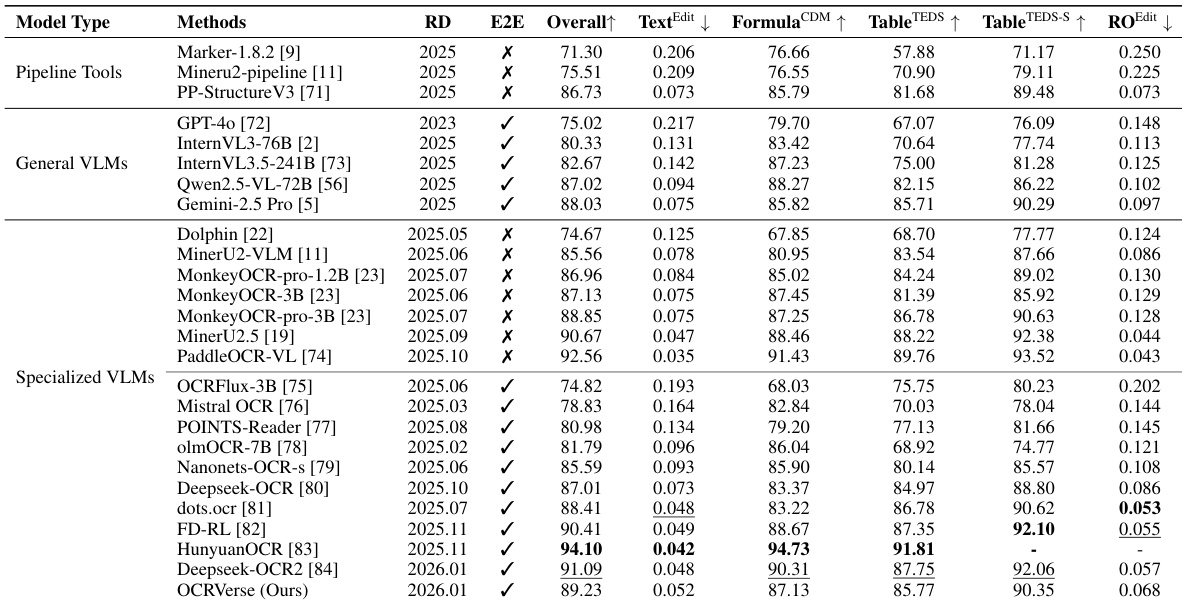

- OCRVerse 在 OmniDocBench v1.5 上取得 89.23 综合分,优于 Gemini-2.5 Pro(88.03)和 Qwen2.5-VL-72B(87.02),尽管参数更少,验证其全栈训练方法的有效性。

- 在公式识别中,OCRVerse 得分 87.13 CDM,超越 Deepseek-OCR(83.37)和 olmOCR-7B(86.04),归功于其涵盖多学科与难度级别的合成公式数据策略。

- 在文本与阅读顺序任务中,OCRVerse 编辑距离为 0.052 和 0.068,略逊于布局感知模型如 dots.ocr,表明通过区域级 OCR 数据整合仍有改进空间。

- 在表格识别中,OCRVerse TEDS 得分 85.77,TEDS-S 得分 90.35,落后于 Deepseek-OCR2 和 HunyuanOCR;未来工作将针对复杂结构丰富表格数据。

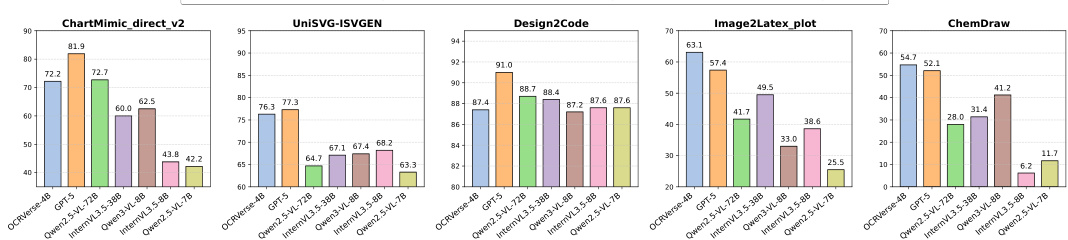

- 在视觉导向任务中,OCRVerse(4B)优于更大模型:ChartMimic 执行成功率达 84.8%(Qwen3-VL-8B 为 78.3%),UniSVG 排名第二(76.3,落后于 GPT-5 的 77.3),Image2LaTeX-plot 渲染成功率达 88.7%(GPT-5 为 78.7%),ChemDraw 执行成功率达 89.1%。

- OCRVerse 展示出强大参数效率,在多个视觉转代码基准上匹配或超越 70B 模型,验证其多领域训练与全栈 OCR 范式。

结果表明,OCRVerse-4B 在多项文档解析任务中表现强劲,在 OmniDocBench v1.5 上以 89.23 综合分超越 Gemini-2.5 Pro 和 Qwen2.5-VL-72B 等更大模型,体现其参数效率与文本导向 OCR 有效性。在视觉导向任务中,OCRVerse-4B 在关键基准上超越显著更大的模型,ChartMimic 执行成功率达 84.8%,Image2LaTeX-plot 渲染成功率达 88.7%,凸显其精细视觉理解与结构化代码生成能力。

结果表明,OCRVerse 在视觉导向 OCR 任务中表现具有竞争力,在多个基准上优于更大模型。在 ChartMimic 上,尽管参数仅为 Qwen2.5-VL-72B 的 1/18,OCRVerse 仍超越其低级与高级得分;在 Image2LaTeX-plot 上,以 88.7% 渲染成功率显著超越所有基线。该模型在 UniSVG 和 ChemDraw 上亦表现强劲,展示其从复杂视觉输入生成准确代码表示的能力。

结果表明,OCRVerse 在 OmniDocBench v1.5 上取得 89.23 综合分,优于 Gemini-2.5 Pro 和 Qwen2.5-VL-72B 等通用模型,尽管参数显著更少。它在公式识别中表现强劲(CDM 得分 87.13),在文本与阅读顺序任务中表现具竞争力,但在细粒度空间理解上落后于布局感知模型。

结果表明,OCRVerse 在视觉导向 OCR 基准中表现具有竞争力,在多个指标上优于更大的开源模型。在 ChartMimic 上,尽管参数仅为 Qwen2.5-VL-72B 的 1/18,它仍超越后者;在 Image2LaTeX-plot 上,以 88.7% 渲染成功率显著超越所有基线。该模型在 UniSVG 和 ChemDraw 上亦表现强劲,展示其从复杂视觉输入生成准确代码表示的能力。