Command Palette

Search for a command to run...

推进开源世界模型

推进开源世界模型

摘要

我们提出 LingBot-World,这是一个基于视频生成技术开源的世界模拟器。作为顶级世界模型,LingBot-World 具备以下特性:(1)在多种环境场景中保持高保真度与稳健的动力学表现,涵盖现实场景、科学模拟、卡通风格等广泛领域;(2)支持长达数分钟的预测时域,同时维持时间上的上下文一致性,即所谓的“长期记忆”能力;(3)支持实时交互,可在每秒生成16帧的情况下实现低于1秒的延迟。我们公开提供代码与模型,旨在缩小开源与闭源技术之间的差距。我们相信,此次发布将为内容创作、游戏开发以及机器人学习等多个领域提供切实可行的技术支持,推动社区创新与发展。

一句话总结

Robbyant 团队推出 LingBot-World,一款开源世界模拟器,通过新颖的三阶段训练流程与因果架构,支持跨多领域生成长达一分钟的实时交互式视频,弥合闭源模型与社区驱动创新在内容创作、游戏和具身智能领域的差距。

主要贡献

- LingBot-World 通过引入可扩展的数据引擎与分层描述机制,解耦运动控制与场景生成,填补了被动视频生成与交互式世界模拟之间的空白,支持在写实、科学、卡通等多样化领域实现精准的动作响应动态。

- 该模型采用多阶段进化训练流程——先在高保真视频先验上预训练,再以 MoE 架构进行中段训练以增强长期记忆与环境一致性,最后通过因果注意力与蒸馏进行后训练以实现毫秒级延迟(16 fps)的实时推理。

- 在与近期交互式世界模型的对比评估中,LingBot-World 在动态程度与生成时长上达到业界领先水平,同时保持完全开源,公开代码、权重与基准测试,支持内容创作、游戏与具身智能等应用。

引言

作者利用视频生成领域的进展,构建了 LingBot-World——一款开源世界模型,可跨多个领域(从照片级真实场景到风格化或科学世界)模拟动态交互环境。与先前仅生成短片段、缺乏物理基础或长期一致性的模型不同,LingBot-World 解决了关键限制:交互训练数据稀缺、分钟级序列中的时间漂移,以及阻碍实时控制的计算瓶颈。其主要贡献为三部分系统:分层数据引擎解耦运动与场景结构、多阶段训练流程将扩散模型演进为带长期记忆的自回归模拟器、以及支持亚秒级延迟的实时推理优化。该模型支持可提示的世界事件与下游应用如智能体训练和 3D 重建——全部公开发布,以加速具身智能领域的开放研究。

数据集

作者使用包含采集、分析和描述三个组件的统一数据引擎。

-

数据集组成与来源

数据集整合三大来源:- 人类、动物和车辆的第一人称与第三人称真实世界视频。

- 游戏数据,包含同步的 RGB 帧、用户操作(如 WASD)与相机参数。

- 来自 Unreal Engine 的合成视频,含无碰撞、随机相机轨迹及真值内参与外参。

-

各子集关键细节

- 通用视频策展器:筛选开源与内部视频,涵盖多样运动模式与视角(步行、骑行、通勤),优先世界探索与环境多样性。

- 游戏数据:通过专用平台采集,画面干净、控制带时间戳、记录相机路径。涵盖八类行为:导航、自由导航、环形漫游、过渡导航、观光、长尾场景、静止观察、后退导航与世界交互。

- 合成管道:使用 Unreal Engine 通过两种模式生成轨迹:

- 程序化路径生成(几何图案、多点插值)。

- 真实轨迹导入(映射人类运动,含自然抖动与速度变化)。

-

数据处理与使用

- 基础过滤移除低分辨率或短视频(依据时长、分辨率等元数据)。

- 使用 Koala 与 TransNet v2 将视频切分为连贯片段以适配训练。

- 姿态估计模型为真实视频生成伪相机参数,与游戏/合成数据对齐。

- 视觉-语言模型评估片段质量、运动与视角,优化语料库。

- 语义描述添加三层标注:全局叙事、场景静态与密集时序描述,实现多粒度理解。

-

训练用途

作者在该精选混合数据上训练模型,使用游戏与合成数据中的同步相机与动作信号,真实视频则通过估计元数据增强。该流程确保几何一致性、多样运动覆盖与语义丰富性,支持长时程规划与新视角处理。

方法

作者采用多阶段训练框架,将基础视频生成器转化为交互式世界模拟器,分三个递进阶段:预训练、中段训练与后训练。该方法确保模型先获得强通用视频先验,再注入世界知识与动作可控性,最后适配实时交互。整体训练流程如框架图所示,展示从通用视频生成器到实时世界模型的演进。

初始阶段“预训练”聚焦建立通用视频先验,通过建模自然视频序列的无条件分布实现。利用在大规模开放领域视频数据上预训练的基础视频生成器,提供强时空一致性与开放域语义理解。模型学习合成高保真物体纹理与连贯场景结构,作为后续交互动态的通用视觉“画布”。本阶段目标是建立稳健通用视频先验,支持高保真开放域生成。

“中段训练”阶段将模型提升为双向世界模型,生成连贯且交互式视觉世界。本阶段引入动作可控性与长期动态。模型在扩展视频序列上训练,增强记忆能力并缓解“遗忘”问题,确保数分钟游戏过程中的连贯性。通过自适应归一化将用户定义的动作信号注入模型,实现遵循指定指令的视觉世界生成。本阶段关键改进为长期一致性与动作可控性,使模型可生成基于动作的高保真未来轨迹。

“后训练”阶段将双向世界模型转化为支持实时交互生成的高效自回归系统。通过因果架构调整与少步蒸馏实现。模型以块因果注意力替代完整时序注意力,结合块内局部双向依赖与块间全局因果性,通过键值缓存实现高效自回归生成。少步蒸馏采用分布匹配蒸馏,辅以自滚动训练与对抗优化,蒸馏出维持动作条件动态与视觉保真度的少步生成器,避免长时间滚动中的显著漂移。本阶段目标为实现低延迟与严格因果性,支持实时交互。

模型架构基于 DiT(Diffusion Transformer)块与混合专家(MoE)设计,包含高噪声专家与低噪声专家。高噪声专家在早期时间步激活,专注于建模全局结构与粗略布局;低噪声专家在后期激活,精修细粒度时空细节。此设计保持推理时计算与 GPU 内存消耗与稠密 14B 模型相当。模型从高噪声专家初始化,因其具备更优动态建模能力,架构通过块因果注意力适配因果框架。动作信号通过 Plücker 编码器注入:输入动作投影为 Plücker 嵌入,并通过自适应归一化调制视频潜在表示。模型还包含交叉注意力层,以文本嵌入条件化视频潜在表示。训练过程采用渐进式课程学习策略,先训练 5 秒视频序列,再逐步扩展至 60 秒,使模型学习长期时序一致性并促进空间记忆的出现。多任务训练赋予模型从任意初始条件预测未来世界状态的能力,融合图像到视频与视频到视频目标。模型通过注入用户定义动作信号微调以支持交互控制,并采用参数高效微调策略保持基础模型的生成质量。训练过程由并行基础设施支持,高效分布计算与内存至多 GPU,采用完全分片数据并行 2(FSDP2)与上下文并行(CP)策略。

实验

- 在多样场景中评估 LingBot-World-Base 与 LingBot-World-Fast,确认强泛化能力:LingBot-World-Base 生成高保真、时序一致序列;LingBot-World-Fast 在 480p 下以 16 fps 运行,视觉退化极小,保持结构与物理逻辑。

- 展示涌现记忆:模型在长达 60 秒内维持静态地标(如巨石阵)的长期一致性,模拟未观测动态(如移动车辆、桥梁距离变化),无需显式 3D 表示。

- 生成长达 10 分钟的超长视频,保持稳定视觉质量与叙事连贯性,展示强大的长期时序建模能力。

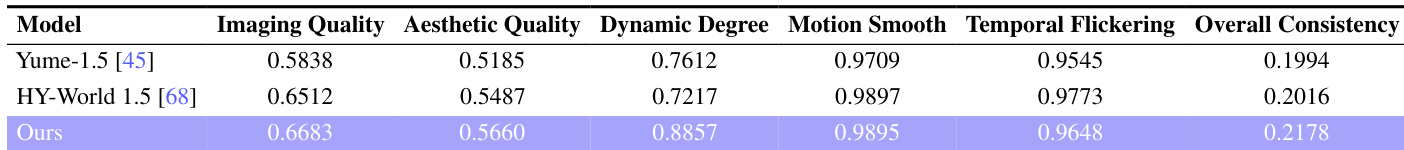

- 在 VBench 的 100+30 秒视频测试中,LingBot-World 超越 Yume-1.5 与 HY-World 1.5:在视觉保真度(成像/美学质量)与动态程度(0.8857 vs 0.7612/0.7217)上得分最高,同时保持顶级一致性与具竞争力的运动平滑度。

- 支持多模态应用:文本引导的世界事件(如“冬季”、“烟花”)、动作驱动的智能体探索、以及从视频序列进行 3D 重建,生成空间一致的点云用于具身智能训练。

结果表明,所提模型在多个指标上超越 Yume-1.5 与 HY-World 1.5,成像质量、美学质量与动态程度得分最高。同时展现优越的时序一致性与运动平滑度,表明其具备稳健的长期生成能力与高保真视频合成能力。