Command Palette

Search for a command to run...

Insight Agents:一种基于LLM的多代理数据洞察系统

Insight Agents:一种基于LLM的多代理数据洞察系统

Jincheng Bai Zhenyu Zhang Jennifer Zhang Zhihuai Zhu

摘要

如今,电子商务卖家面临诸多关键挑战,包括难以发现并有效利用现有工具与程序,以及难以理解并充分利用来自各类工具的丰富数据。为此,我们致力于开发“洞察代理”(Insight Agents, IA),一种基于对话的多智能体数据洞察系统,旨在通过自动化信息检索,为电商卖家提供个性化的数据与业务洞察。我们的假设是,IA 将成为卖家的“增效引擎”,显著降低其使用门槛与决策成本,从而提升卖家采纳率,并加快其做出优质商业决策的速度。本文介绍了一种基于大语言模型(LLM)支持的端到端智能体系统,该系统采用“规划-执行”范式构建,具备全面覆盖、高准确率与低延迟的特点。系统采用分层多智能体架构,由一名管理智能体(Manager Agent)及两个工作智能体(Worker Agents)——数据呈现智能体与洞察生成智能体——构成,以实现高效的信息检索与问题求解。我们为管理智能体设计了一种简洁而高效的机器学习方案:结合轻量级编码器-解码器模型进行跨域(Out-of-Domain, OOD)检测,并通过基于BERT的分类器实现智能体路由,从而在保证高准确率的同时显著降低延迟。在两个工作智能体中,我们为基于API的数据模型设计了策略性规划机制,将用户查询分解为细粒度组件,以生成更精准的响应;同时,动态注入领域知识以增强洞察生成智能体的能力。目前,IA 已在美国地区面向亚马逊卖家正式上线,经人工评估,系统整体准确率高达90%,P90延迟低于15秒,表现优异。

一句话总结

亚马逊研究人员提出了 Insight Agents(IA),这是一种基于大语言模型的多智能体系统,采用“规划-执行”架构,配备分层智能体与OOD感知路由机制,使美国亚马逊卖家能够在15秒内获得准确的业务洞察,人工评估准确率达90%。

主要贡献

- Insight Agents(IA)是一种新颖的、由大语言模型支持的多智能体系统,基于“规划-执行”范式构建,旨在帮助电商卖家克服工具发现与数据利用障碍,提供个性化、对话式业务洞察,具备高覆盖率、高准确率与低延迟。

- 系统采用分层架构,由管理智能体通过OOD检测与基于BERT的分类路由查询,以及两个工作智能体——数据呈现智能体与洞察生成智能体——将查询分解为细粒度API调用,并动态注入领域知识以提高响应准确率。

- 该系统已部署于美国亚马逊卖家,通过人工评估达到90%准确率,P90延迟低于15秒,证明其在真实电商决策支持中具备实用有效性。

引言

作者利用基于大语言模型的分层多智能体系统,帮助电商卖家从复杂、分散的数据工具中提取可操作的业务洞察,以满足更快速、更少认知负担的决策需求。以往系统在处理跨多个数据源的开放性、领域特定查询时,常面临准确性、延迟或覆盖范围的挑战。其主要贡献是 Insight Agents,一种“规划-执行”架构,由管理智能体通过OOD检测与BERT分类路由查询,以及两个工作智能体分解查询并注入领域知识以提升精度——在生产环境中实现90%准确率与低于15秒的延迟。

数据集

作者使用一个精选数据集用于训练和评估OOD检测与智能体路由模型,构成如下:

-

数据集组成:

- 总计301个问题:178个域内问题,123个域外问题。

- 域内划分:120个用于数据呈现智能体,59个用于洞察生成智能体。

- 另设包含100个热门问题的基准测试集,附带真实答案,用于端到端评估。

-

数据增强:

- 原始域内子集(数据呈现与洞察生成)通过大语言模型增强至每类300个问题,引入语义变体以实现均衡训练。

- 域外与基准测试集未进行增强。

-

模型使用:

- 每个智能体的增强后300问题子集用于微调轻量级BERT模型(“bge-small-en-v1.5”)。

- OOD检测使用隐藏层维度64、超参数λ = 4的模型。

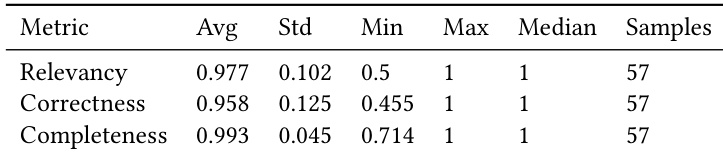

- 最终在100问题基准集上的评估由人工审核员采用三个指标完成:相关性、正确性与完整性。

- 问题级准确率定义为:在所有三个指标上得分均高于0.8的问题所占百分比。

-

处理与评估:

- 未提及裁剪或元数据构建。

- 用于增强的大语言模型:“anthropic.claude-3-sonnet-20240229-v1:0”,通过Amazon Bedrock调用。

- OOD与路由模型的评估指标包括精确率、召回率与准确率。

方法

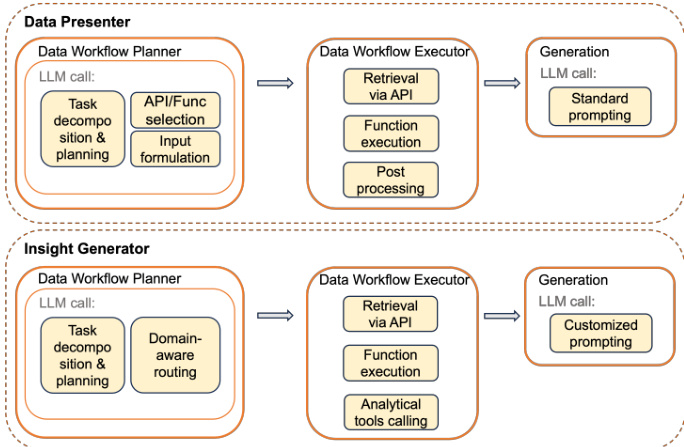

Insight Agents(IA)系统采用分层的“管理-工作”多智能体架构,通过“规划-执行”范式为卖家查询提供准确、低延迟响应。整体框架如图所示,始于卖家查询由管理智能体处理,该智能体作为中央协调者,执行初步验证与路由,再将任务委派给两个专业工作智能体之一:数据呈现智能体或洞察生成智能体。管理智能体包含三个主要组件:域外(OOD)检测、智能体路由与查询增强器。OOD检测过滤超出可用数据洞察范围的查询,确保仅相关请求继续处理。智能体路由根据查询类型确定合适的解决路径,而查询增强器通过补充上下文信息(如当前日期)解决歧义,特别是时间范围问题。处理完成后,系统应用响应护栏以防止敏感或有害内容泄露,再将最终答案返回给卖家。

两个工作智能体——数据呈现智能体与洞察生成智能体——的底层架构如图所示。两者共享相同的数据工作流规划与执行管道,但在生成策略上有所差异。数据呈现智能体专注于根据查询检索并聚合表格数据。其数据工作流规划器采用思维链方法将查询分解为可执行步骤,选择适当API或函数并生成必要输入负载。该过程基于强大的数据模型,利用公司内部数据API,通过结构化检索确保高精度。数据工作流执行器随后通过所选API检索数据,执行必要转换,并应用后处理步骤,如列重命名与语义过滤。最终响应通过标准提示生成,辅以少量示例确保格式正确。

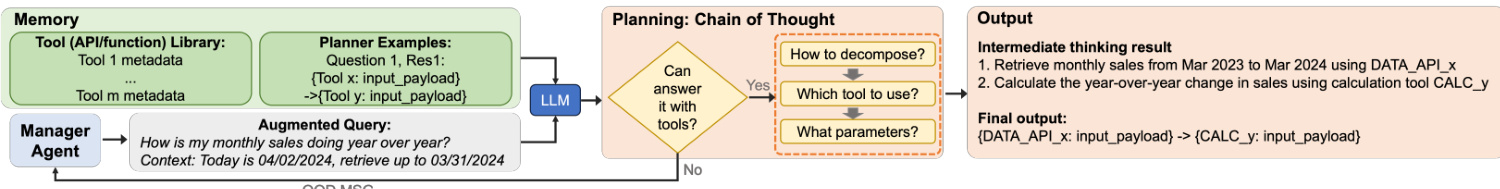

洞察生成智能体遵循类似的规划与执行结构,但旨在生成分析性洞察而非原始数据。其数据工作流规划器同样执行任务分解与规划,但额外包含领域感知路由步骤,根据查询意图选择适当的分析技术——如基准比较、趋势分析或季节性分析。规划器使用少量学习引导大语言模型选择正确的解决路径。数据工作流执行器检索数据并可能调用分析工具进行转换。洞察生成器的生成过程更为复杂,使用定制提示,结合领域特定知识、提示模板及领域专家提供的少量示例,确保生成的洞察不仅准确,而且上下文相关且可操作。整个过程由记忆系统支持,存储工具元数据与规划器示例,使大语言模型能有效规划与执行任务。下图展示了规划阶段,大语言模型评估查询,判断是否可使用可用工具回答,并将任务分解为一系列步骤,最终产生中间思维过程及包含必要API调用与计算的最终输出。

实验

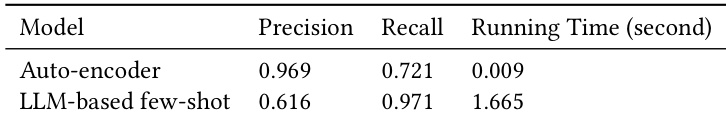

- 基于自编码器的OOD检测效率极高,样本处理时间低于0.01秒,精度高于基于LLM的方法;召回率可通过扩大域内训练集提升。

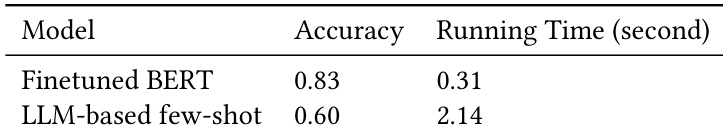

- 分支路由实现83%准确率,每例延迟0.3秒,在速度与精度上均显著优于基于LLM的分类。

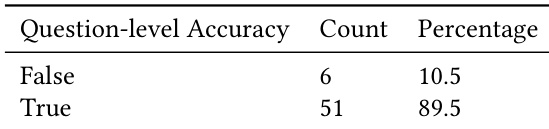

- 对端到端IA响应的人工评估显示,在100个问题中总体准确率为89.5%,其中57个被判定为在范围内;系统P90延迟平均为13.56秒。

作者使用微调的BERT模型进行分支路由,相比基于LLM的方法实现了更高准确率与显著更低延迟。结果表明,BERT模型为系统中的路由决策提供了更高效、更有效的解决方案。

结果显示,基于自编码器的方法相比基于LLM的少量样本方法实现了更高精度与显著更快的运行时间,而LLM方法表现出更好的召回率。整体性能表明速度与精度之间存在权衡,自编码器方法更适合实时应用。

结果显示,系统在问题级准确率上表现优异,89.5%的响应被正确分类为“正确”。评估表明,在识别在范围内问题方面表现强劲,错误分类率仅为10.5%。

结果显示,系统在相关性、正确性与完整性三个维度上均获得高平均分,低标准差与高样本量表明结果一致性良好。评估证明系统在生成准确且全面的响应方面表现可靠,关键维度上的稳健指标提供了有力支持。