Command Palette

Search for a command to run...

EvoCUA:通过从可扩展的合成经验中学习来演化计算机使用代理

EvoCUA:通过从可扩展的合成经验中学习来演化计算机使用代理

摘要

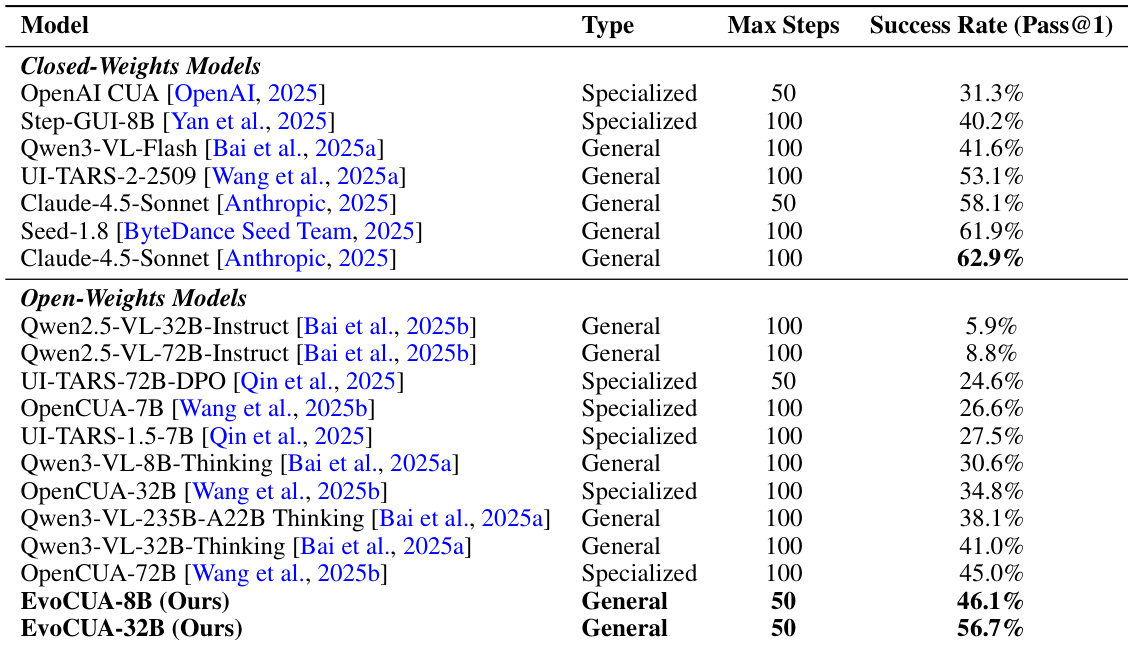

原生计算机使用代理(Computer Use Agent, CUA)的发展标志着多模态人工智能的重大进展。然而,其潜力目前受到静态数据扩展机制的制约。现有范式主要依赖对静态数据集的被动模仿,难以捕捉长期计算机任务中固有的复杂因果动态。本文提出 EvoCUA——一种原生计算机使用代理模型。与静态模仿不同,EvoCUA 将数据生成与策略优化整合为一个自我维持的进化循环。为缓解数据稀缺问题,我们设计了一种可验证的合成引擎,能够自主生成多样化任务,并配备可执行的验证器以确保任务质量。为实现大规模经验获取,我们构建了一个可扩展的基础设施,支持数以万计的异步沙箱环境并行执行。基于这些大规模轨迹数据,我们提出一种迭代式进化学习策略,高效地内化经验知识。该机制通过识别能力边界动态调控策略更新:对成功行为进行强化,同时通过对错误进行分析与自我修正,将失败轨迹转化为丰富的监督信号。在 OSWorld 基准测试中的实证评估表明,EvoCUA 达到了 56.7% 的成功率,创下开源模型的新纪录。显著地,EvoCUA 显著优于此前最优的开源模型 OpenCUA-72B(45.0%),并超越了领先的闭源权重模型如 UI-TARS-2(53.1%)。尤为重要的是,我们的结果验证了该方法的泛化能力:由经验学习驱动的进化范式在不同规模的基础模型上均表现出一致的性能提升,为原生智能体能力的持续演进提供了一条稳健且可扩展的技术路径。

一句话总结

美团、复旦、同济与香港科技大学的研究人员提出 EvoCUA——一种自我演化的计算机使用智能体,通过自主任务合成与可扩展的 rollout 机制突破静态数据限制,在 OSWorld 上实现 56.7% 的成功率,超越先前开源与闭源模型,且能泛化至不同规模的基础模型。

主要贡献

- EvoCUA 引入了一种自我持续演化的范式,以动态经验生成与策略优化替代静态模仿,解决了长时程 GUI 任务中被动数据扩展的局限。

- 系统包含一个可验证合成引擎,可生成带内置验证器的可执行任务,以及支持数万次异步沙盒 rollout 的可扩展架构,确保生成真实、高吞吐量的交互数据。

- 在 OSWorld 上评估,EvoCUA-32B 达到 56.7% 成功率——超越 OpenCUA-72B(45.0%)与 UI-TARS-2(53.1%)——并通过其错误驱动的迭代学习策略,在不同规模基础模型上展现可泛化的提升。

引言

作者提出一种全新的计算机使用智能体训练范式,从静态模仿转向合成经验生成与策略精炼的演化循环。以往方法依赖固定数据集,无法捕捉真实 GUI 交互中的因果动态,限制了可扩展性与泛化能力。EvoCUA 通过引入可验证合成引擎(生成带内置验证器的可执行任务)、支持数万并发沙盒 rollout 的可扩展架构、以及将失败轨迹转化为监督信号的迭代学习策略,克服了这一瓶颈。该方法在 OSWorld 基准测试中实现 56.7% 成功率,优于先前开源与闭源模型,并证明其在不同规模基础模型上的泛化能力。

数据集

-

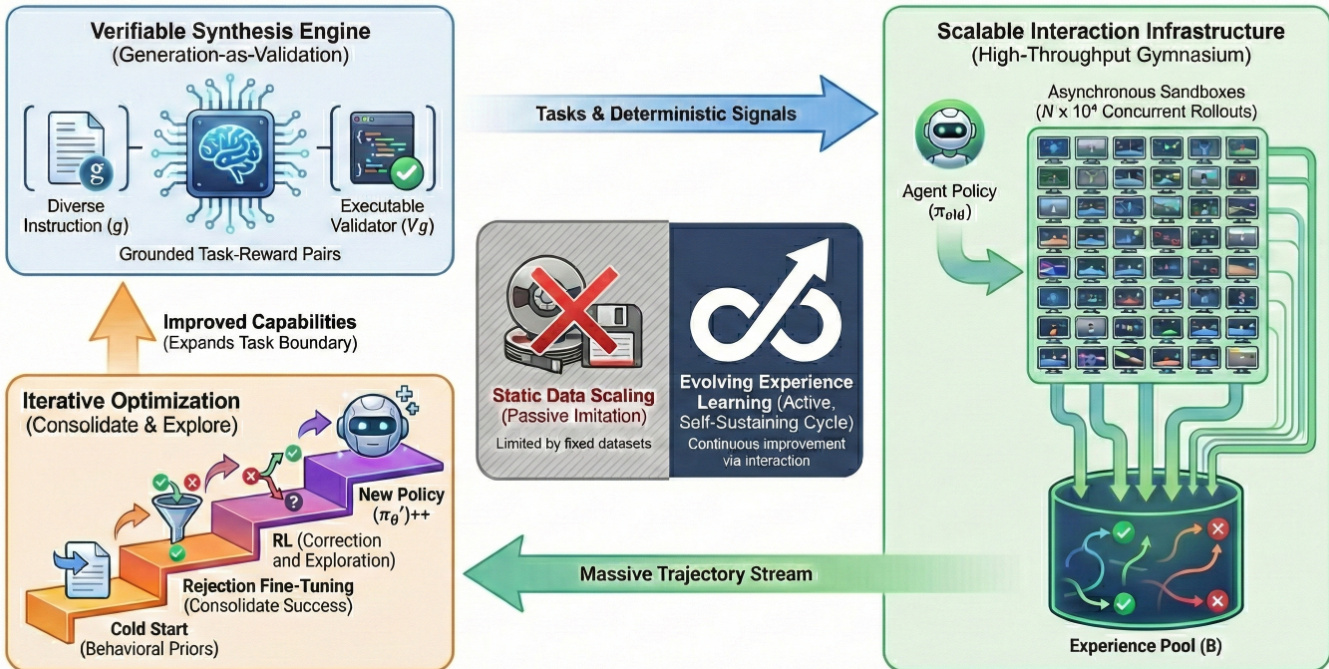

作者构建了一个结构化任务空间,采用桌面应用(如 Excel、Word、浏览器)的分层分类法,将复杂任务分解为公式编辑或数据排序等原子能力,实现组合式泛化。

-

通过混合资源注入合成多样化场景:参数化生成器创建含随机变量(姓名、价格、日期)的结构化文档(Word、Excel、PDF),非参数注入则加入真实互联网内容(图像、幻灯片),以模拟视觉与结构噪声。

-

三阶段流水线生成并筛选数据:(1) 任务空间构建定义领域与角色;(2) 智能体双流合成利用 VLM 通过反馈循环共同生成指令与验证器;(3) 严格质量保证通过沙盒 rollout、奖励模型、人工检查与三重去污染,消除与基准在语义、配置及评估器上的重叠。

-

先前数据集 𝒟_prior 通过统一动作空间(鼠标、键盘、控制原语)与结构化思维空间(目标澄清、观察一致性、自我验证、反思、推理增强终止)构建,以确保接地且可解释的推理。

-

使用视觉语言模型(如 Qwen3-VL)合成轨迹,结合事后推理:推理轨迹在已知执行路径后生成,确保认知与物理动作的一致性。

-

训练时,多轮轨迹拆分为单轮样本。输入上下文保留最近五步的完整多模态数据(截图、动作、推理);早期历史压缩为文本。损失仅计算当前步的推理与动作。

-

训练混合数据包括通用数据(STEM、OCR、视觉定位、文本推理),其规模与分解轨迹样本匹配,在引导特定任务技能的同时保留基础能力。

方法

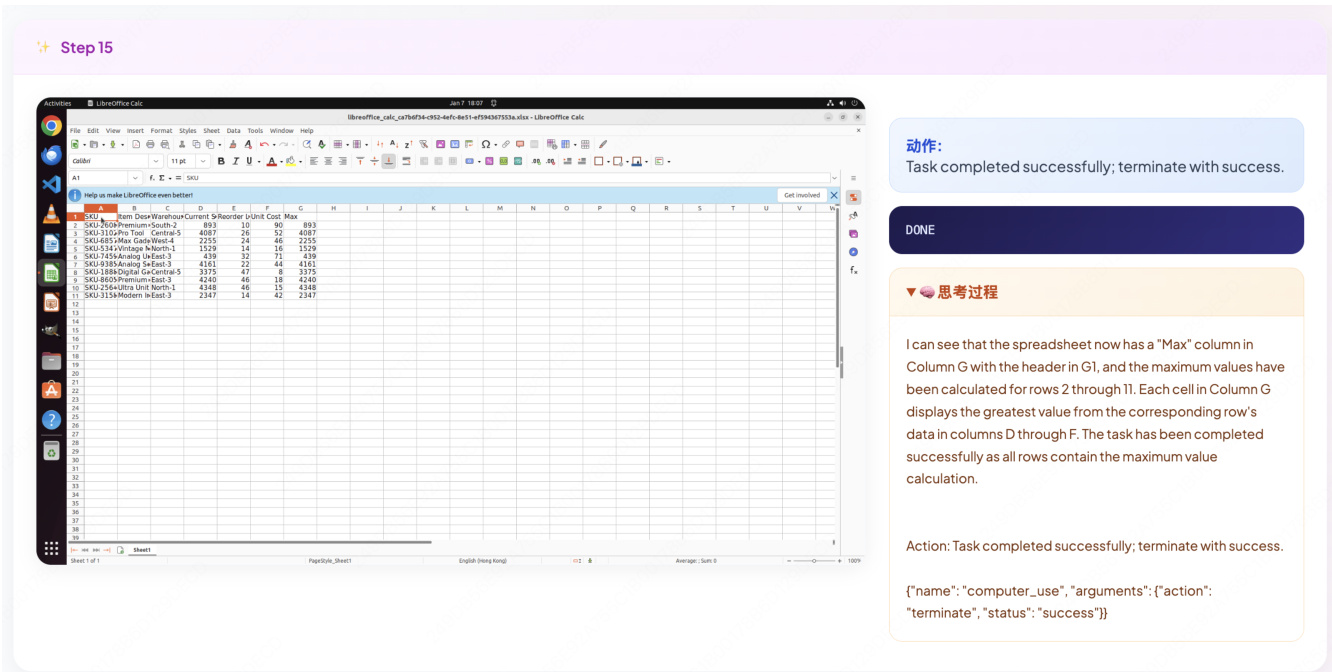

EvoCUA 框架围绕从静态模仿转向主动经验驱动优化的动态迭代学习范式构建。整体架构如框架图所示,集成三个核心组件:可验证合成引擎、可扩展交互基础设施与演化经验学习循环。流程始于合成引擎生成高质量、可验证的任务-奖励对,输入至高吞吐交互训练场。该基础设施支持大规模异步 rollout,生成连续交互轨迹流并汇聚至经验池。策略随后通过多阶段优化精炼:监督冷启动、拒绝采样微调与强化学习,形成自我持续的能力扩展闭环。

可验证合成引擎(详述于第二张图)负责生成语义接地且可执行的任务-奖励对。该引擎通过结构化任务空间构建、智能体双流合成与严格质量保证的级联过程运作。结构化任务空间基于分层领域分类法,将任务归类为 GUI、办公、网页与原子能力,支持系统化任务生成。通过混合资源注入增强,结合参数化合成(如代码片段)与非参数注入(如真实文档与图像),创建多样化场景元组。核心合成过程为智能体工作流:基础视觉语言模型(VLM)作为任务架构师,同步生成自然语言指令(g)与对应可执行验证器(Vg)。双流生成通过闭环反馈机制验证:生成代码在沙盒环境中执行,结果用于精炼输出。这种“生成即验证”范式确保奖励信号源于最终状态的严格验证,规避语义匹配的模糊性。

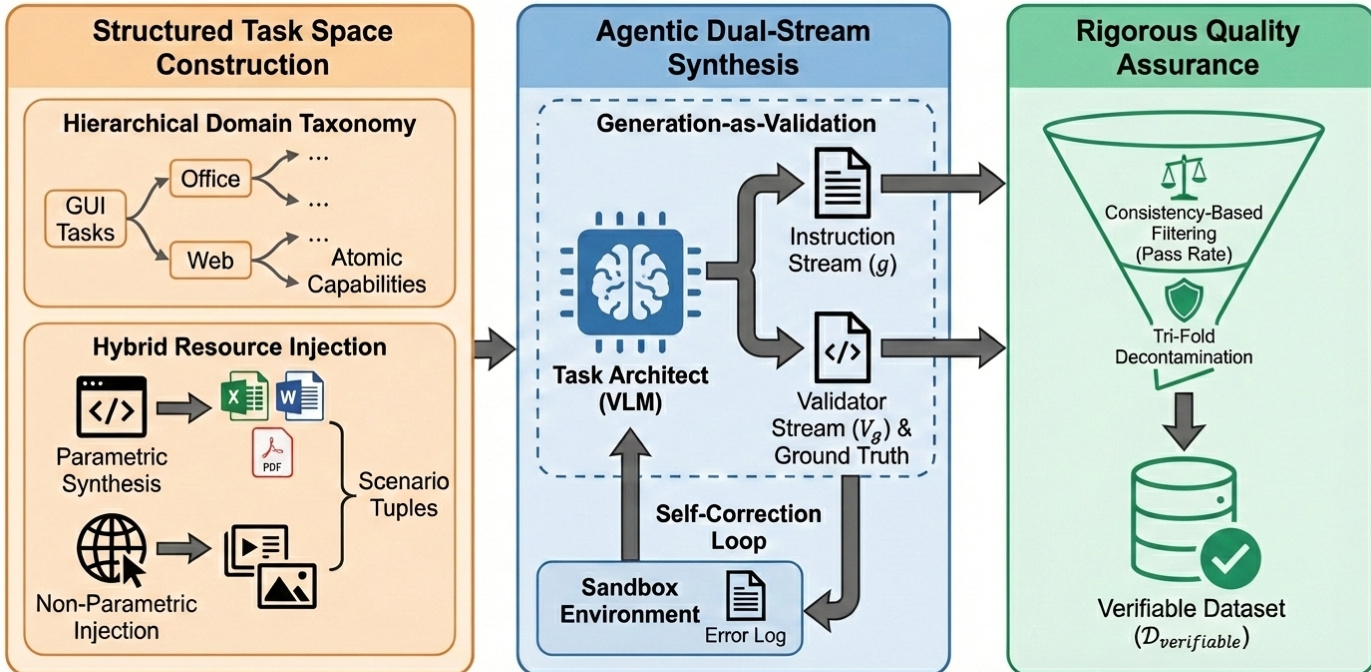

可扩展交互基础设施(如第三张图所示)是系统骨干,支持大规模交互数据生成。该基础设施基于微服务架构设计,兼顾高吞吐与低延迟。其包含基于反应器模式的异步网关服务,每分钟处理数百万交互请求,采用非阻塞 I/O,确保长时环境执行不阻塞关键路由逻辑。网关将请求路由至分布式调度器,管理海量沙盒镜像生命周期。调度器利用分布式分片与资源池实现高效节点调度,支持突发扩展,可在一分钟内启动数万个沙盒实例。此快速实例化确保环境扩展严格匹配在线策略强化学习的训练需求。基础设施进一步由混合虚拟化架构支持:QEMU-KVM 虚拟机封装于 Docker 容器中,兼顾安全与近原生性能。环境基于 Ubuntu 22.04 定制操作系统镜像,包含特定内核与用户空间补丁,确保输入确定性、渲染一致性与运行时稳定性。

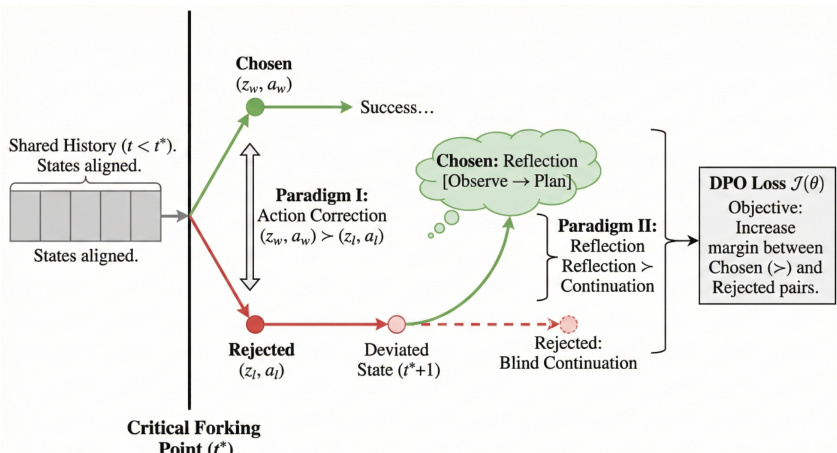

演化经验学习范式(如第四张图所示)是核心优化引擎,将原始交互数据转化为精炼策略。该过程分三阶段推进。第一阶段为监督冷启动,通过少量高质量轨迹训练建立行为先验。第二阶段为拒绝采样微调(RFT),通过动态计算预算生成高质量轨迹并去噪,最大化信噪比。最终阶段为强化学习,修正失败并探索复杂动态。通过逐步直接偏好优化(DPO)策略针对关键分叉点:给定失败 rollout 与成功参考,系统识别智能体动作首次偏离参考的时刻(环境状态仍功能等价),隔离导致智能体偏离最优解流形的具体响应。随后构建两种范式:范式 I(动作修正)用最优响应替代被拒绝的错误;范式 II(反思)针对错误后状态,训练智能体暂停并生成推理链,观察意外屏幕状态并制定补救计划。策略通过 DPO 损失函数优化,最大化有效与无效策略间的边际。

实验

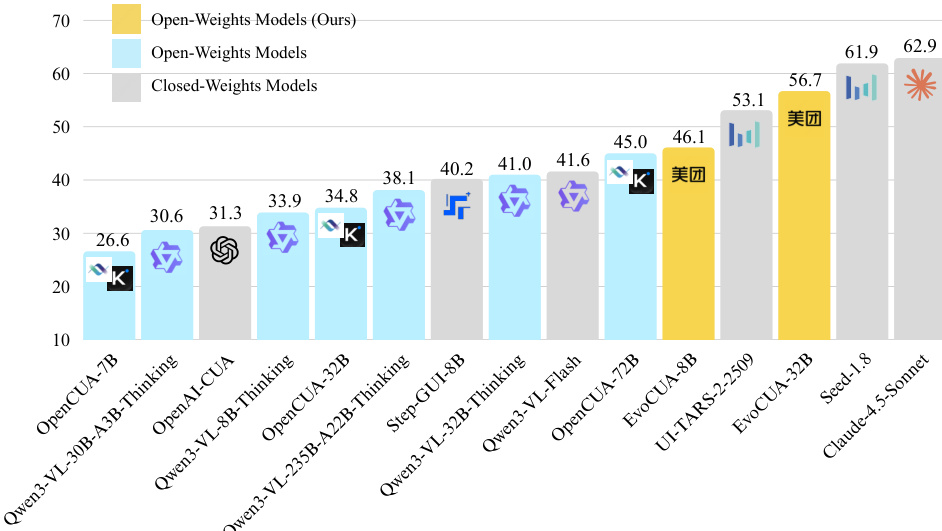

- EvoCUA-32B 在 OSWorld 上实现 56.7% 成功率,为开源权重模型中最高,超越 OpenCUA-72B(45.0%)11.7%,并在 50 步约束下优于闭源模型 UI-TARS-2-2509(53.1%)3.6%。

- EvoCUA-8B(46.1%)超越 OpenCUA-72B 与 Step-GUI-8B(40.2%)5.9%,证实演化经验学习在小规模模型上的有效性。

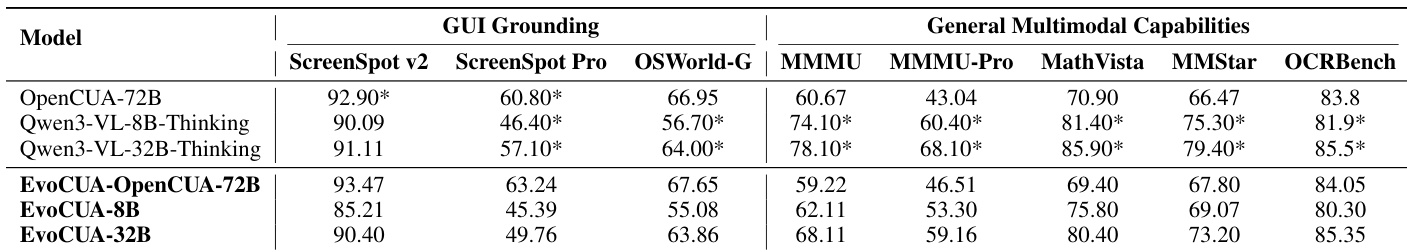

- 离线接地与通用 VLM 基准测试显示,OpenCUA-72B 主干模型表现稳定或提升,但 EvoCUA-32B 在 ScreenSpot-Pro 与 MMMU 上因与 Qwen3-VL-Thinking 数据分布不匹配而表现下降。

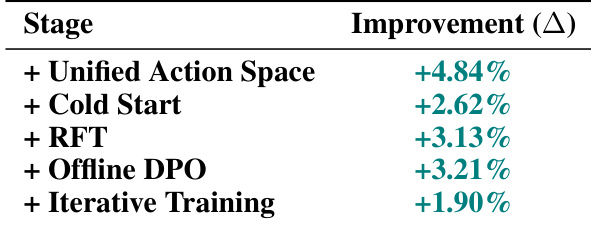

- 消融实验确认累积增益:统一动作空间(+4.84%)、冷启动(+2.62%)、RFT(+3.13%)、DPO(+3.21%)与迭代循环(+1.90%)在 Qwen3-VL-32B-Thinking 上持续提升。

- 在 OpenCUA-72B 上,仅 RFT 即带来 +8.12% 增益,证明该范式在不同模型规模上的可扩展性与鲁棒性。

- 扩展分析显示,EvoCUA-32B 在 Pass@16 上维持 +4.93% 增益,从 15 步增至 50 步推理提升 +16.25%;通过百万样本多轮 RFT 实现 +8.12 pp 增益。

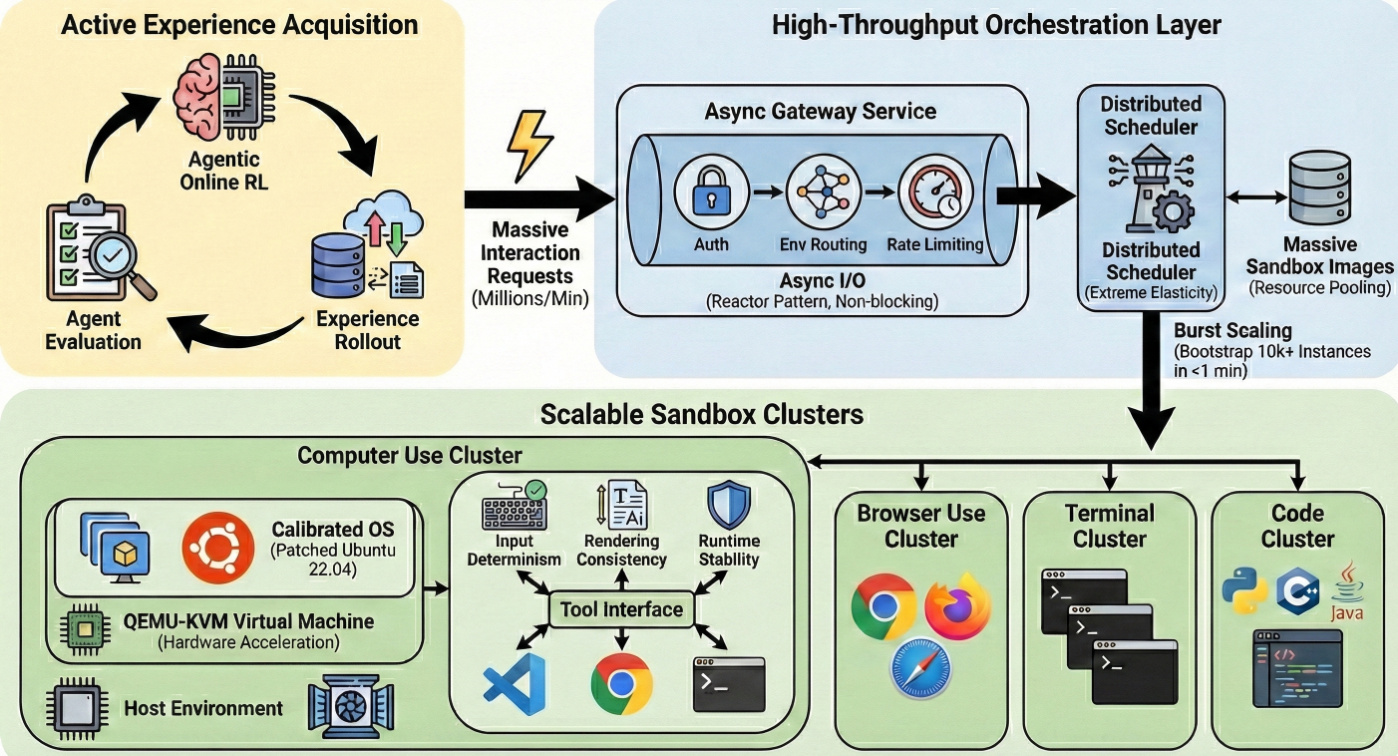

- 轨迹检查器通过逐帧对齐推理、观察与动作验证合成数据质量,确认如电子表格操作等复杂任务中的逻辑一致性。

作者使用 OSWorld 基准评估 EvoCUA,显示 EvoCUA-32B 实现 56.7% 成功率,在开源权重模型中排名第一,比 OpenCUA-72B 等更大基线模型高出 11.7 个百分点。该结果表明在线智能体能力显著提升,EvoCUA-32B 缩小了与闭源模型的差距,并在更严格的 50 步约束下实现有竞争力的表现。

作者通过消融实验分析 EvoCUA-32B 模型各组件贡献,显示演化循环各阶段均带来显著单调提升。结果表明,统一动作空间与冷启动分别贡献 +4.84% 与 +2.62%,拒绝微调与 DPO 分别带来 +3.13% 与 +3.21% 增益,迭代训练额外贡献 +1.90%,证实学习范式的自我持续性。

作者评估 EvoCUA 在离线接地与通用多模态能力上的表现,显示 EvoCUA-32B 变体在 ScreenSpot-Pro 与 MMMU 等特定指标上较 Qwen3-VL-32B-Thinking 基线有所下降,主要因数据分布与模式不匹配。相比之下,EvoCUA-72B 在各基准上维持或轻微提升表现,证实当基础模型数据分布对齐时,训练策略的有效性。

作者使用 OSWorld-Verified 基准评估 EvoCUA,显示 EvoCUA-32B 在 50 步约束下实现 56.7% 成功率,超越所有其他开源权重模型,缩小与顶级闭源模型的差距。EvoCUA-8B 亦超越 OpenCUA-72B 等更大模型,证明演化经验学习范式在不同模型规模上提升性能的有效性。

作者使用 EvoCUA 执行长时程电子表格任务,成功找出每行最大值并置于新列。结果显示模型成功终止任务,证实其在真实 GUI 环境中推理与动作执行的有效性。