Command Palette

Search for a command to run...

面向高效智能体:记忆、工具学习与规划

面向高效智能体:记忆、工具学习与规划

摘要

近年来,将大型语言模型扩展为智能体(agentic)系统引起了广泛关注。尽管智能体的有效性持续提升,但在实际部署中至关重要的效率问题却常常被忽视。为此,本文从智能体的三个核心组成部分——记忆、工具学习与规划出发,系统考察效率问题,重点关注延迟、Token消耗、执行步数等各类成本。旨在对智能体系统本身的效率展开全面研究,我们综述了近年来多种实现方式各异但普遍遵循若干高层原则的方法,包括但不限于:通过压缩与管理机制限制上下文长度、设计强化学习奖励以最小化工具调用次数、以及采用受控搜索机制提升整体效率,并对这些策略进行深入探讨。基于此,我们从两个互补维度定义效率:一是在固定成本预算下比较不同方法的有效性;二是在相近有效性水平下比较其成本开销。这一权衡关系亦可从“有效性-成本”之间的帕累托前沿(Pareto frontier)视角加以理解。从这一框架出发,本文进一步梳理了面向效率评估的基准测试体系,总结了各核心组件的评估协议,并整合了来自基准测试与方法论研究中广泛报告的效率指标。此外,本文还探讨了当前面临的关键挑战与未来发展方向,旨在为智能体系统的高效化研究提供具有前景的洞察与参考。

一句话总结

来自上海人工智能实验室、复旦大学、中国科学技术大学等机构的研究人员综述了大语言模型(LLM)智能体的效率问题,提出在记忆(压缩/管理)、工具学习(选择性调用)和规划(成本感知搜索)三个层面的优化方案,强调在实际部署中性能与资源消耗之间的帕累托权衡。

主要贡献

- 本文指出效率是基于大语言模型的智能体中一个关键但尚未充分探索的瓶颈,将高效智能体定义为在记忆、工具使用和规划等维度上最大化任务成功率并最小化资源成本的系统,而非简单缩小模型规模。

- 系统性地分类并分析了近期在三个核心领域的进展:记忆压缩与检索、通过强化学习奖励最小化工具调用、以及通过受控搜索优化规划以减少步骤数和令牌消耗。

- 提出基于帕累托权衡的有效性与成本的效率评估框架,整合各组件的基准协议与指标,并突出开放挑战以引导未来研究朝向实际部署。

引言

作者利用当前从静态大语言模型向执行多步骤、工具增强推理的智能体系统转变的趋势。尽管此类智能体支持复杂工作流,但其递归特性——反复调用记忆、工具和规划——导致令牌消耗、延迟和成本呈指数增长,使效率成为实际部署的关键。以往关于高效大语言模型的工作未解决这些智能体特有的瓶颈,且现有效率指标缺乏标准化,阻碍了公平比较。其主要贡献是系统性综述,按记忆(压缩、检索、管理)、工具学习(选择、调用、整合)和规划(搜索、分解、多智能体协调)分类效率改进,并提出基于帕累托的成本效益框架,同时指出智能体潜在推理和部署感知设计等关键挑战。

数据集

作者使用一组多样化的基准测试来评估工具学习在选择、参数填充、多工具编排和智能体推理方面的表现。以下是数据集的组成和用途:

-

选择与参数填充基准:

- MetaTool [42]:评估不同场景下的工具选择决策,包括可靠性与多工具需求。

- Berkeley Function-Calling Leaderboard (BFCL) [88]:包含多轮、多步骤对话中的真实世界工具。

- API-Bank [59]:包含73个手动标注的工具,适用于自然对话语境。

-

多工具组合基准:

- NesTools [32]:对嵌套工具调用问题进行分类,并提供长时程协调的分类体系。

- τ-Bench [173] & τ²-Bench [6]:聚焦零售、航空和电信领域,用户主动发起工具调用。

- ToolBench [95]:聚合来自RapidAPI的16,000+个API;因在线服务不稳定而存在可复现性问题。

- MGToolBench [150]:对ToolBench进行精细化整理,以更好对齐训练指令与真实用户查询。

-

细粒度与系统级评估:

- T-Eval [13]:将工具使用分解为六项能力(如规划、推理),进行逐步失败分析。

- StableToolBench [30]:使用虚拟API服务器配合缓存与基于LLM的模拟,确保可复现、高效的评估。

-

模型上下文协议(MCP)基准:

- MCP-RADAR [26]:通过工具选择、资源使用和速度衡量效率,同时兼顾准确性。

- MCP-Bench [136]:使用LLM作为评判者,对工具执行中的并行性和冗余减少进行评分。

-

智能体工具学习基准:

- SimpleQA [139]:测试对复杂问题给出事实正确简答的能力,需迭代使用搜索API。

- BrowseComp [140]:人工设计的挑战性问题,迫使依赖浏览/搜索工具。

- SealQA [89]:评估在嘈杂、冲突的网页结果下增强搜索的LLM;其SEAL-0子集(111个问题)甚至难倒前沿模型。

作者未直接在这些数据集上训练,而是用于评估模型在效率、可靠性和组合推理方面的行为。未指定训练划分或混合比例——这些纯为评估基准。未提及裁剪或元数据构建;处理重点在于模拟、标注或协议遵循,以确保结果一致且可复现。

方法

作者提出一个面向高效LLM智能体的综合框架,围绕三个核心组件构建:记忆、工具学习与规划。架构中心是一个纯LLM,作为智能体的认知核心,与外部记忆和工具学习模块交互,这些模块又反过来影响规划过程。整体系统旨在最大化任务成功率,同时最小化计算成本,其中记忆与工具学习作为高效规划的基础支撑。

记忆组件是缓解长交互历史带来计算与令牌开销的关键子系统。其生命周期包括三个阶段:构建、管理与访问。记忆构建将原始交互上下文压缩为更紧凑形式,可存储在工作记忆或外部记忆中。工作记忆在生成时可直接访问,包括文本记忆(如摘要、关键事件)和潜在记忆(如压缩激活、KV缓存),旨在减少LLM需处理的上下文长度。外部记忆存储于模型外,提供无界存储,包括基于项目、图结构和层次结构。管理阶段使用基于规则、基于LLM或混合策略对累积记忆库进行整理,以控制延迟并防止无限增长。最后,记忆访问仅检索并整合最相关的记忆子集进入智能体上下文,采用规则增强、图结构或基于LLM的检索机制,以及文本压缩或潜在注入等整合技术。

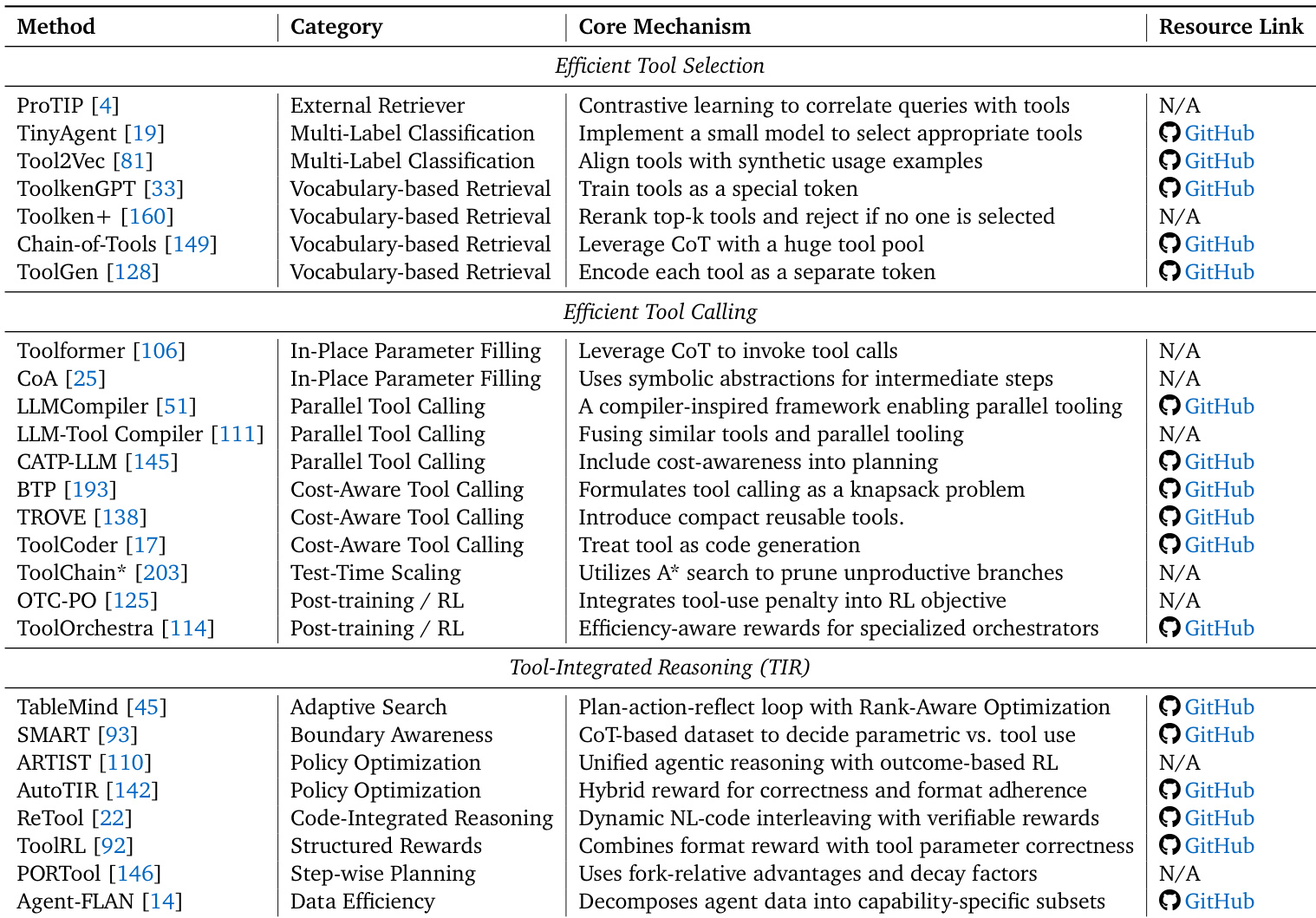

工具学习是使智能体能与外部工具交互的另一关键模块。该过程始于工具选择,智能体从大量工具池中识别最相关工具。通过三种主要策略实现:外部检索器基于语义相似性对工具排序、多标签分类模型预测相关工具,或基于词汇的检索系统将工具视为特殊标记。选定候选后,智能体进入工具调用阶段。此阶段聚焦高效执行,策略包括原位参数填充、并行调用以降低延迟,以及成本感知调用以最小化调用开销。最后阶段——工具整合推理——确保智能体推理过程高效有效。包括选择性调用(决定何时使用工具而非依赖内部知识)和策略优化(使用强化学习学习平衡任务成功与资源节约的最优工具使用策略)。

规划模块是协调智能体行动的核心引擎。它将推理视为资源受限的控制问题,智能体需在细化计划的边际效用与计算成本之间取得平衡。通过两种主要范式实现:单智能体规划与多智能体协作规划。单智能体规划聚焦最小化个体推理轨迹的成本,使用推理时策略如自适应预算、结构化搜索与任务分解,以及通过策略优化和技能习得实现的学习式进化。多智能体协作规划优化交互拓扑与通信协议以降低协调开销,技术包括拓扑稀疏化、协议压缩,以及将集体智能提炼为单智能体模型。规划过程受智能体记忆与工具学习能力影响,形成协同系统,各组件分摊彼此成本。整体架构设计为模块化与可扩展,记忆、工具学习与规划核心组件协同工作,以最小资源消耗实现高性能。

实验

- 混合记忆管理通过选择性调用LLM在成本效率与相关性间取得平衡,但增加系统复杂性,可能在LLM调用时引入延迟。

- 记忆压缩以性能换取成本:LightMem表明轻度压缩比激进压缩更能保持准确性,凸显需平衡提取策略。

- 在线记忆更新(如A-MEM)支持实时适应,但增加延迟与成本;混合方法(如LightMem)将繁重计算离线处理,减少推理时间并维持成本平衡。

- 工具选择方面,外部检索器适合动态工具池(通用性强、即插即用),MLC/基于词汇的方法适合静态集合(更高效,但需微调)。

- 工具调用通过原位参数填充、成本感知调用、测试时缩放与并行执行提升效率;并行调用若任务依赖误判,可能引发迭代优化风险。

- 单智能体策略(自适应控制、结构化搜索、任务分解、学习式进化)减少成本与冗余,但可能引发误触发、开销、错误传播或维护负担。

- 记忆有效性通过下游任务(HotpotQA、GAIA)或直接记忆测试(LoCoMo、LongMemEval)评估;效率通过令牌成本、运行时、GPU内存、LLM调用频率与步骤效率(Evo-Memory、MemBench)衡量。

- 规划有效性在SWE-Bench与WebArena等基准上评估;效率指标包括令牌使用、执行时间、工具调用轮次、通过成本(TPS-Bench)与搜索深度/广度(SwiftSage、LATS、CATS)。

作者使用表格对LLM智能体中高效工具选择、调用与推理方法进行分类,强调外部检索器与基于词汇的方法根据候选池动态提供效率权衡。结果表明,成本感知调用与测试时缩放等高效工具调用技术在管理计算成本的同时提升性能,而自适应搜索与策略优化等工具整合推理方法通过结构化与奖励驱动策略增强规划效率。