Command Palette

Search for a command to run...

DARC:面向LLM演化的解耦非对称推理课程

DARC:面向LLM演化的解耦非对称推理课程

Shengda Fan Xuyan Ye Yankai Lin

摘要

基于大语言模型的自对弈(self-play)已成为实现自我进化的人工智能的有前景范式。然而,现有的自对弈框架往往面临优化不稳定性问题,主要原因包括:(i)由于提问者(Questioner)依赖求解器(solver)反馈的奖励信号,导致目标函数非平稳;(ii)在监督求解器(Solver)时使用自生成的伪标签(pseudo-labels),引发自举误差(bootstrapping errors)。为缓解上述挑战,我们提出 DARC(Decoupled Asymmetric Reasoning Curriculum,解耦式非对称推理课程),一种两阶段框架,以稳定自进化过程。第一阶段,我们训练提问者根据明确标注的难度等级和外部语料库,生成难度可控的问题;第二阶段,采用非对称自蒸馏机制训练求解器:由一个引入文档增强的教师模型生成高质量伪标签,以监督无法访问外部文档的学生求解器。实验结果表明,DARC 具有模型无关性,在九个推理基准测试和三种主干模型上平均提升 10.9 分。此外,DARC 始终优于所有基线方法,并在无需人工标注的情况下,逼近完全监督模型的性能。代码已开源,地址为:https://github.com/RUCBM/DARC。

一句话总结

中国人民大学的研究人员提出了 DARC,这是一种两阶段自博弈框架,通过解耦问题生成与求解器训练来稳定大语言模型的自我改进,采用难度校准提示和非对称蒸馏,在无需人工标注的情况下,在多个基准测试中实现了 10.9 分的提升。

主要贡献

- DARC 通过解耦问题生成器(Questioner)与求解器(Solver)的训练,用显式难度校准和外部语料库替代依赖求解器的奖励机制,从而解决大语言模型自博弈中的优化不稳定问题。

- 它引入了一种非对称自蒸馏机制:一个增强文档的教师模型生成高质量伪标签,用于监督无文档访问权限的学生求解器,从而减少自举错误和自我确认偏差。

- 在九个推理基准测试和三个主干模型上评估,DARC 平均比基线模型提升 10.9 分,并在无需人工标注的情况下达到与全监督模型相当的性能。

引言

作者利用自博弈使大语言模型能够在无人监督的情况下自我演化,这是迈向可扩展通用人工智能的关键一步。以往的自博弈方法因奖励非平稳性和自生成伪标签导致的错误放大而面临优化不稳定问题,常导致性能崩溃。DARC 通过将过程解耦为两个阶段来解决这一问题:首先训练问题生成器,使用外部语料库生成难度校准的问题;然后通过非对称自蒸馏训练求解器,其中增强文档的教师模型为无文档访问权限的学生提供更干净的伪标签。该设计在九个推理基准测试上平均带来 10.9 分的模型无关提升,并媲美全监督模型——无需任何人工标注。

数据集

- 作者仅使用公开可用的数据集,包括 DataComp-LM 和 Nemotron-CC-Math,未收集用户数据。

- 这些语料库由其原始创建者预先整理和过滤,以减少个人身份信息和冒犯性内容;作者依赖这些程序,未进行额外过滤。

- 数据集用于离线实验环境中的模型自演化研究,不用于现实部署或自主决策。

- 未发布原始训练文本,也未进行个体层面分析;结果仅以聚合形式报告。

- ChatGPT 仅用于语言编辑和清晰度改进,不用于科学设计、分析或解释。

方法

DARC 框架将大语言模型的自我演化分解为两个独立且顺序执行的阶段:问题生成器训练和求解器训练。这种解耦方法旨在通过分离推理课程的生成与求解能力的训练来稳定优化过程。整体架构如框架图所示,与先前方法的不稳定动态相比,DARC 采用结构化两阶段流程。

第一阶段,训练问题生成器,使其生成既基于源文档又校准到指定难度级别的问题。问题生成器参数化为 Qθ,输入为文档 d 和目标难度标量 τ∈[0,1],并生成条件于这些输入的问题 q。为训练该模型,作者采用组相对策略优化(GRPO),奖励函数设计用于强制文档关联性和难度对齐。生成问题 q 的奖励分两阶段计算。首先,使用大语言模型作为评判器评估 q 是否基于源文档 d;未基于文档的问题获得 -1 的负奖励。对于基于文档的问题,使用固定求解器模型 S(⋅∣q) 通过采样 N 个候选答案并计算成功率 s^=N1∑j=1NI[a^j=a∗] 来估计经验难度,其中 a∗ 通过多数投票获得伪标签。该成功率作为难度估计器 D(q)。最终奖励定义为 rQ(q)=1−∣D(q)−τ∣,鼓励问题生成器生成难度估计值与目标 τ 匹配的问题。该过程在详细架构图的上半部分可视化,显示问题生成器生成问题、求解器提供答案用于难度估计,以及奖励计算反馈至策略更新。

第二阶段涉及使用训练好的问题生成器构建的离线课程训练求解器。问题生成器参数被冻结,并用于生成一组问题 U={(di,τi,qi)}i=1M,其中 qi∼Qθ(⋅∣di,τi)。这些问题按指定难度级别 τi 排序形成课程,用于从易到难逐步训练求解器。为在无外部标注的情况下获得监督,框架采用非对称自蒸馏。对于课程中的每个问题 q,一个拥有源文档 d 访问权限的特权教师求解器生成多个候选答案 {a^1(d),…,a^N(d)}。通过多数投票推导伪标签 a∗,并丢弃低一致性样本。学生求解器 Sϕ(⋅∣q) 无文档访问权限,仅根据问题 q 生成答案。学生的训练目标是最大化正确性奖励 rS(a)=I[a=a∗],其中 a 是学生输出分布的样本。这种不对称性防止学生简单复制文档内容,迫使其仅根据问题学习解决问题。详细架构图说明了此过程,显示问题生成、特权教师角色、伪标签创建及学生求解器训练。如图所示,框架设计确保问题生成器在稳定目标上训练,而求解器在稳定、外部定义的课程上训练,从而缓解耦合自博弈系统固有的优化不稳定性。

实验

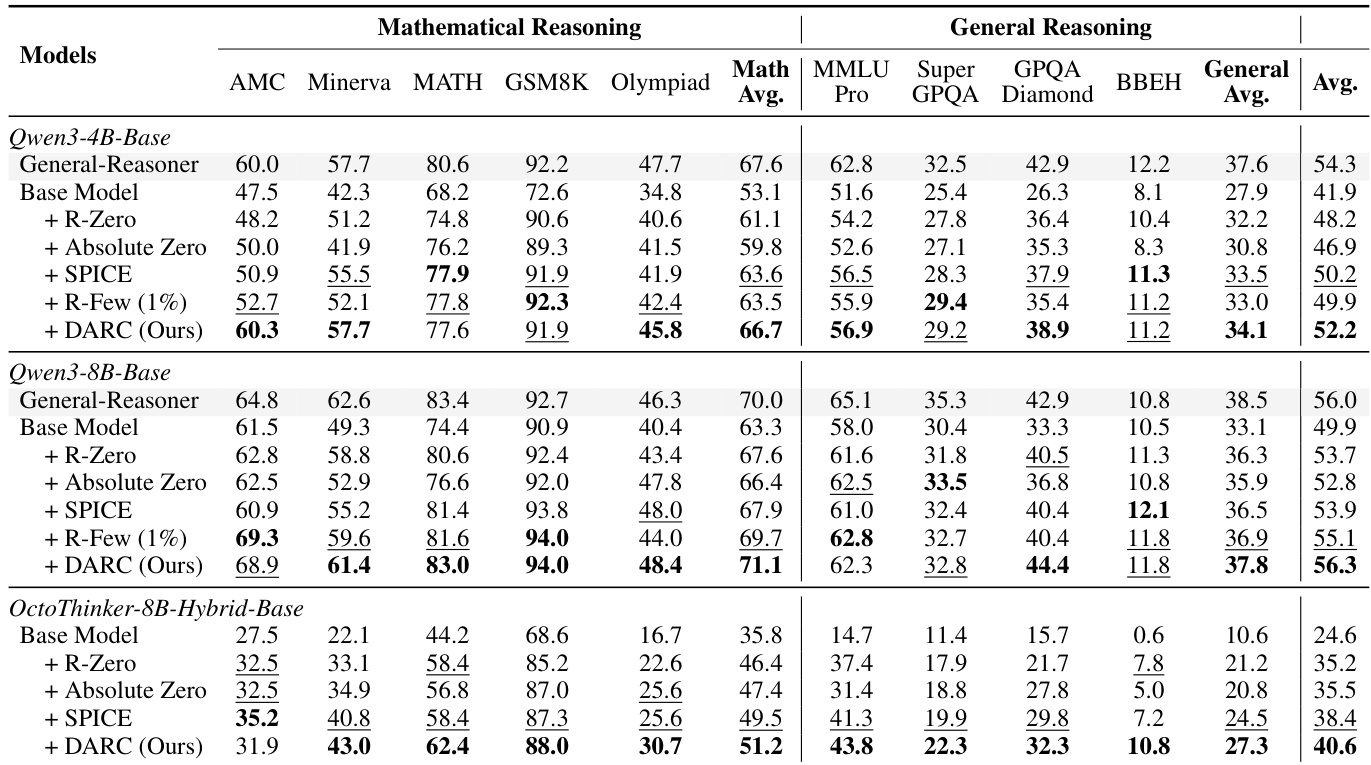

- 在 Qwen3-4B/8B 和 OctoThinker-8B 主干模型上评估 DARC,优于无标签基线(R-Zero、Absolute Zero、SPICE),并在无任何人工标注的情况下匹配弱监督 R-Few;平均比基础模型提升 10.9 分。

- 在数学基准(MATH-500、GSM8K 等)和通用推理(MMLU-Pro、GPQA-Diamond 等)上,DARC 在较弱模型和数学任务上表现最强,Qwen3-8B 匹配监督式 General-Reasoner 的性能。

- 训练动态确认优化稳定:奖励随课程过渡稳步上升;验证奖励持续提升而无崩溃,不同于先前自博弈系统。

- 带文档关联的非对称蒸馏提升性能(短/中上下文平均胜率 >50%),但超过 5K token 后因噪声收益减弱。

- 问题生成器生成与求解器无关、按难度分级的问题;使用 Qwen3-4B 问题生成器训练 1.7B 和 8B 求解器验证跨求解器泛化能力,收益一致。

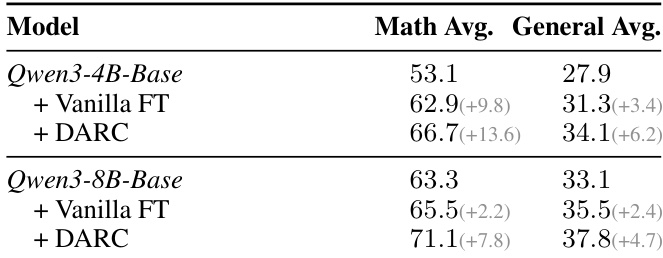

- DARC 在各规模上均优于普通微调 3.3–3.9 分,证明其提升推理能力超越语料记忆。

- 消融实验确认非对称蒸馏、专用问题生成器和难度感知课程的必要性;替换为通用模型的问题生成器导致结果下降。

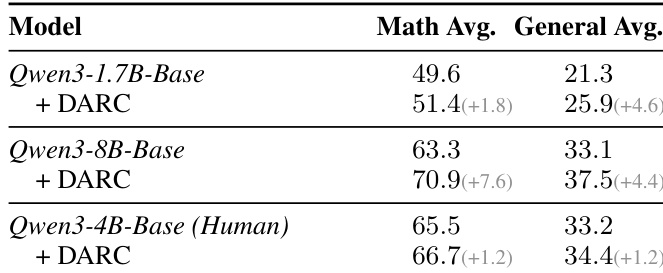

作者使用 DARC 评估其在不同模型规模上的有效性,表明其在所有主干模型上均持续提升性能。结果显示,DARC 在数学和通用推理基准测试上均取得显著提升,最大提升出现在较小模型如 Qwen3-1.7B 和 Qwen3-4B 上,分别在数学和通用推理任务上比基础模型高出 1.8 和 1.2 分。

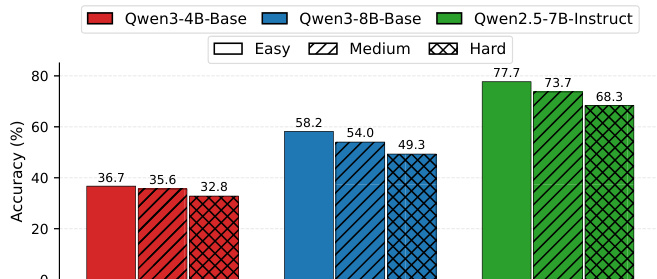

作者使用训练好的问题生成器生成不同难度级别的问题,并评估不同模型规模下求解器的准确率。结果表明,所有模型的求解器准确率从“简单”到“困难”单调下降,表明问题生成器学习到了与求解器无关且由输入驱动的难度划分。

作者使用 DARC 提升数学和通用基准测试上的推理性能,表明 DARC 在 Qwen3-4B 和 Qwen3-8B 主干模型上均持续优于基础模型和无标签基线。结果显示,DARC 在数学和通用推理任务上平均得分均高于 Vanilla FT,且在 8B 模型上收益更大,表明 DARC 更有效地迁移推理能力,超越简单语料记忆。

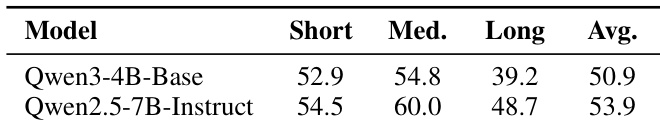

作者比较 Qwen3-4B-Base 和 Qwen2.5-7B-Instruct 在不同文档长度下的推理任务表现,Qwen2.5-7B-Instruct 在短和中上下文获得更高分数,而两模型在长上下文表现均下降。结果表明,指令微调提升推理能力,尤其在较短上下文,但随文档长度增加收益减弱,可能因信息过载引入噪声。

作者使用 DARC 评估其在三个模型规模上的数学和通用推理基准测试表现,表明 DARC 持续优于无标签基线,并与弱监督方法竞争。结果显示,DARC 平均比基础模型提升 10.9 分,并在 Qwen3-8B 上匹配监督式 General-Reasoner 的表现,表明无需人工标注的自演化可实现强大的推理能力。