Command Palette

Search for a command to run...

Being-H0.5:面向跨体感泛化的以人为本机器人学习扩展

Being-H0.5:面向跨体感泛化的以人为本机器人学习扩展

摘要

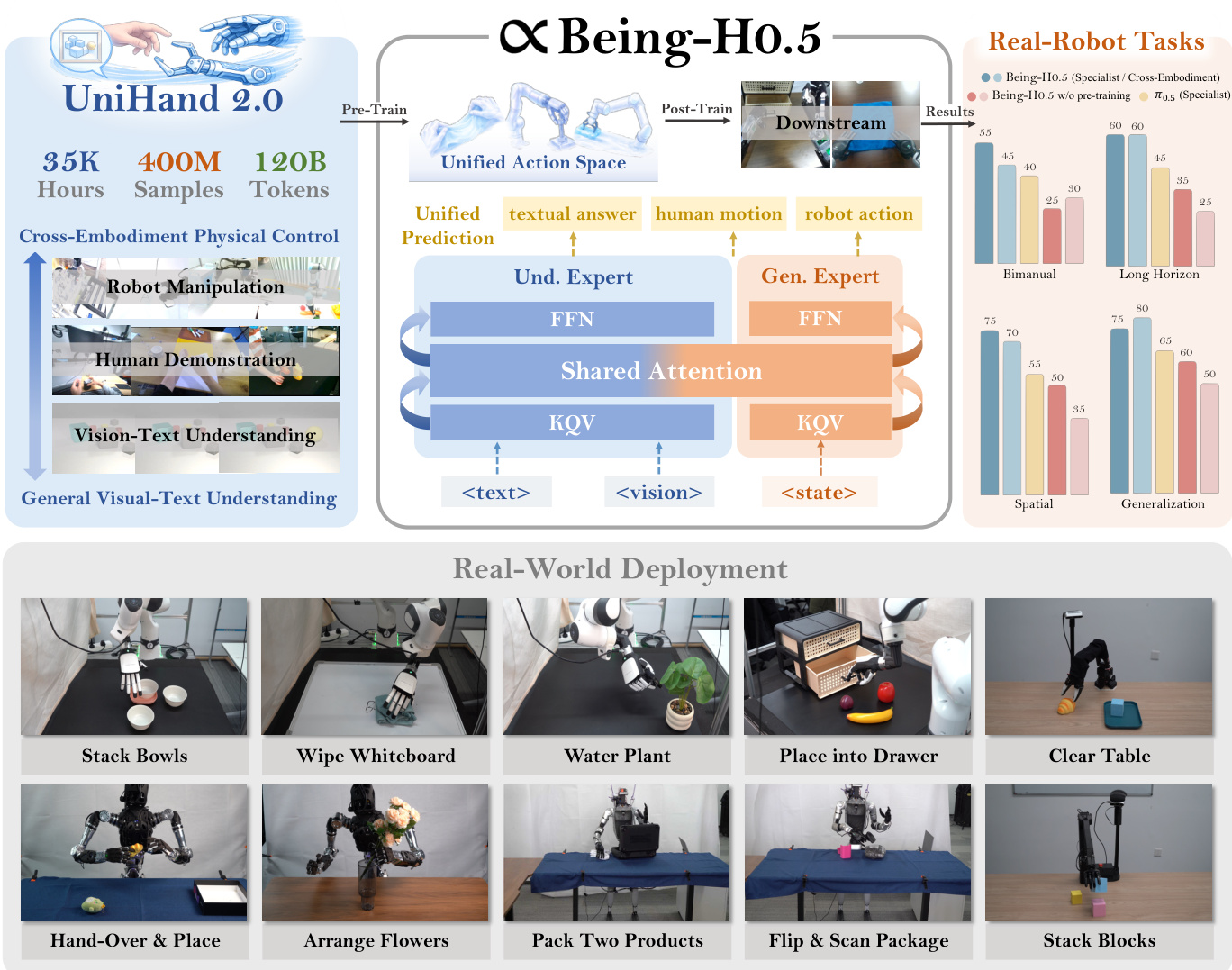

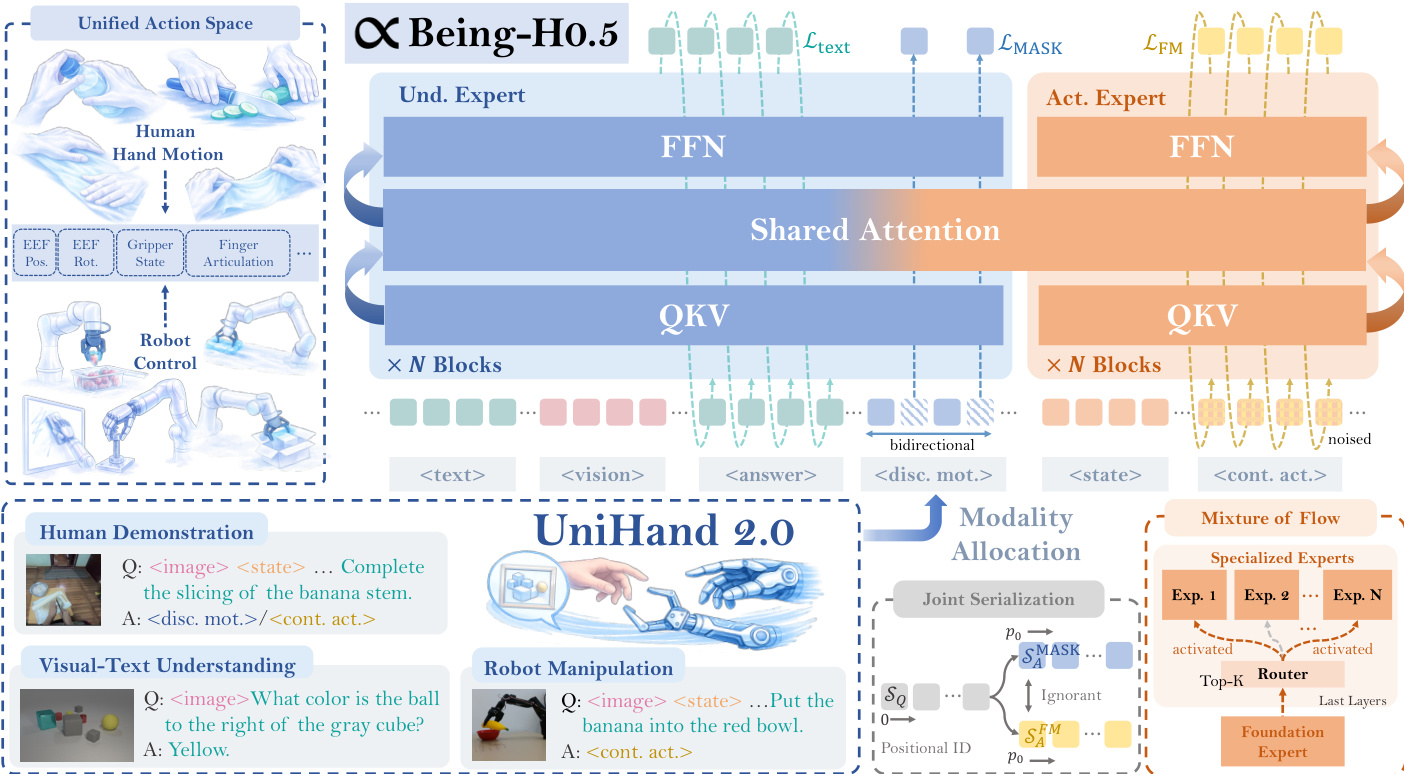

我们提出 Being-H0.5,一个面向多样化机器人平台的通用视觉-语言-动作(Vision-Language-Action, VLA)基础模型,旨在实现鲁棒的跨具身性泛化能力。现有 VLA 模型在面对形态异构性与数据稀缺性问题时往往表现不佳,为此,我们提出一种以人类为中心的学习范式,将人类交互轨迹视为物理交互的通用“母语”。为支撑该范式,我们构建了 UniHand-2.0——迄今为止规模最大的具身预训练方案,涵盖 30 种不同机器人具身形式,总时长达超过 35,000 小时的多模态数据。我们的方法引入了一个统一动作空间(Unified Action Space),将异构的机器人控制指令映射至语义对齐的控制槽位中,使低资源机器人能够基于人类数据实现技能迁移,同时赋能高资源平台的高效学习。在此以人为本的架构基础上,我们设计了一种统一的序列建模与多任务预训练范式,有效弥合人类示范与机器人执行之间的鸿沟。在模型架构层面,Being-H0.5 采用混合 Transformer(Mixture-of-Transformers)设计,并创新性地引入 Mixture-of-Flow(MoF)框架,实现共享运动基元与特定具身专家之间的解耦。为进一步提升跨具身策略在真实环境中的稳定性,我们提出流形保持门控机制(Manifold-Preserving Gating),以增强对感官变化的鲁棒性;同时引入通用异步分块控制(Universal Async Chunking),实现不同延迟特性与控制周期的机器人平台间分块控制的统一。实验结果表明,Being-H0.5 在多个仿真基准测试中达到当前最优性能,如 LIBERO 基准上达到 98.9%,RoboCasa 基准上达到 53.9%。同时,该模型在五种真实机器人平台上均展现出强大的跨具身泛化能力,验证了其在复杂现实场景中的实用价值。

一句话总结

BeingBeyond 团队推出 Being-H0.5,这是一种基于 UniHand-2.0 超过 35,000 小时跨具身数据和统一动作空间的 VLA 基础模型,通过以人为本的学习、MoF 架构和真实世界稳定化技术,实现跨多种机器人平台的强泛化能力。

主要贡献

- Being-H0.5 引入以人为本的学习范式,将人类交互轨迹视为物理交互的通用“母语”,通过 UniHand-2.0 数据集(超过 35,000 小时)中 30 种不同机器人平台共享的物理先验,实现跨具身泛化。

- 该模型采用统一动作空间和混合流架构,将异构机器人控制映射到语义对齐的槽位,解耦共享运动原语与具身特定专家,使低资源机器人可在单一序列建模框架下从人类和高资源机器人数据中引导技能。

- 实证表明,Being-H0.5 在模拟基准测试中达到最先进性能(LIBERO:98.9%,RoboCasa:53.9%),并在五种不同机器人平台上实现稳健的真实世界跨具身部署,通过流形保持门控和通用异步分块技术处理感知偏移和延迟变化。

引言

作者利用人类运动作为通用“母语”,训练单一视觉-语言-动作模型——Being-H0.5,使其能泛化至从灵巧手到人形腿等截然不同的机器人具身形态。以往的 VLA 模型在具身异构性和数据稀缺性方面表现不佳,常无法在平台间迁移技能,或需依赖忽略共享物理先验的平台特定头部。Being-H0.5 通过引入 UniHand-2.0(覆盖 30 种机器人和人类视频的 35,000 小时多模态语料库),在共享动作空间下将不同控制映射为语义对齐的标记,从而克服此问题。架构上,它采用混合流设计,结合流形保持门控和通用异步分块,以稳定跨不同硬件延迟的实时控制。最终,单一检查点在模拟基准测试中达到最先进性能,并成功部署于五种真实机器人而无需重新训练。

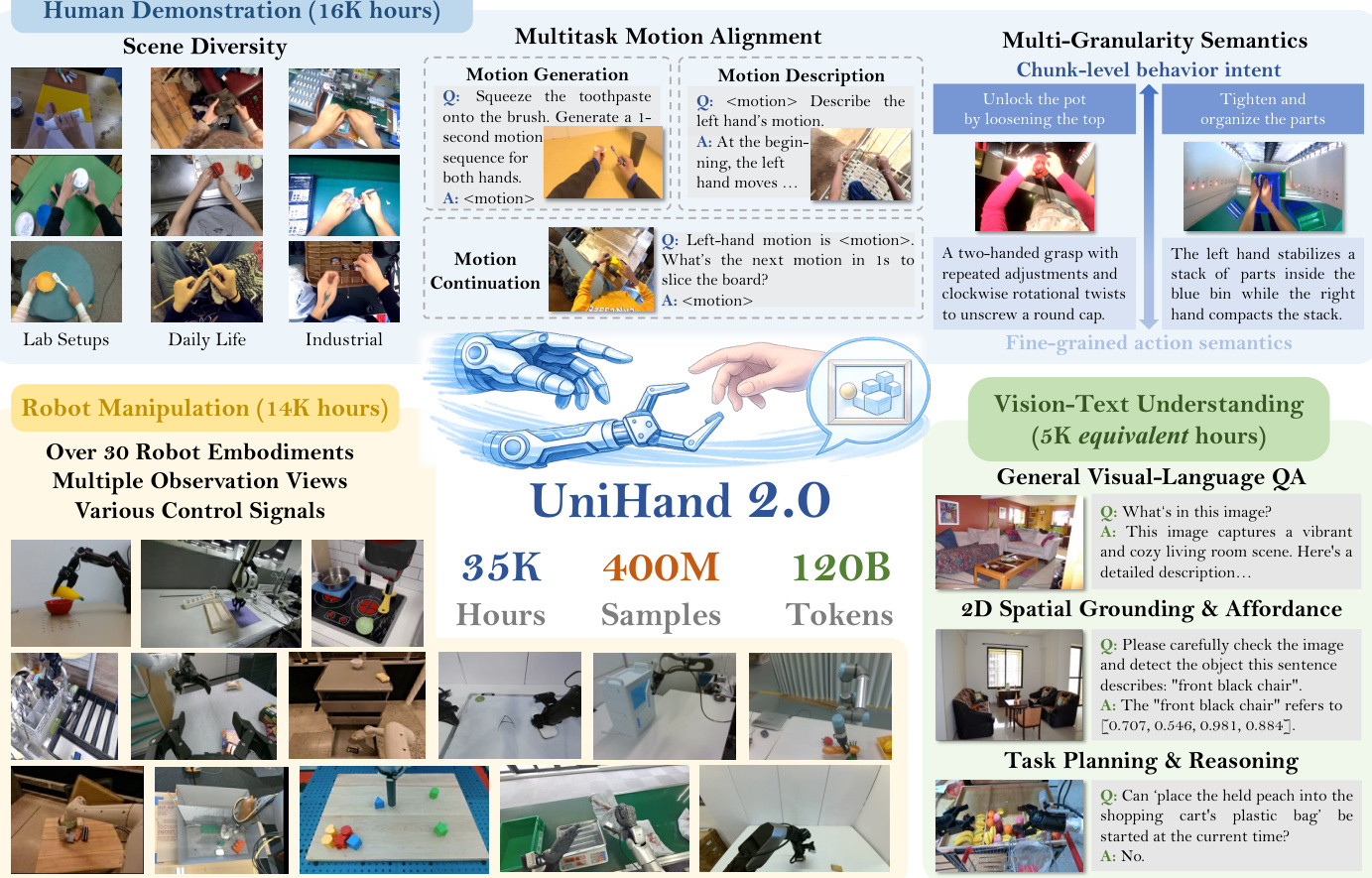

数据集

作者使用 UniHand-2.0,这是一个大规模、以人为本的视觉-语言-动作(VLA)模型预训练数据集,包含覆盖三大核心领域的 35,000 小时多模态数据:

-

人类演示数据(16,000 小时):来源于第一视角视频,包括 Ego4D、EPIC-KITCHENS 和 Egocentric-10K,以及内部录制数据。手部姿态通过 HaWoR 与 MANO 参数估计,并用 Gemini-2.5 增强双层语义注释(每秒指令和 10 秒意图摘要)。数据通过四阶段流水线过滤:LLM 语言增强、基于置信度和 DBA 误差的运动质量筛选、操作相关性筛选、以及通过空间镜像实现的利手去偏。最终获得 1.34 亿样本——比 UniHand-1.0 多 100 倍。

-

机器人操作数据(14,000 小时):聚合来自 OpenX-Embodiment、AgiBot-World 和 RoboCOIN 等数据集的 30+ 种机器人具身形态(如 Franka、AgiBot G1、Unitree G1)。帧率降采样至 30% 以减少冗余。模拟数据上限为 26%,以保持真实世界主导。新增 PND Adam-U 和 BeingBeyond D1 等平台的演示以平衡数据。数据包含多样相机视角和控制信号,统一映射至共享状态-动作空间以确保训练稳定性。

-

视觉-文本理解数据(5,000 等效小时):通过整合 502 亿文本标记平衡模态差距。包含三大支柱:(1) 通用 VQA(LLaVA-v1.5、LLaVA-Video),(2) 2D 空间定位与可操作性(RefCOCO、RoboPoint、PixMo-Points),(3) 任务规划与推理(ShareRobot、EO1.5M-QA)。这抵消了纯机器人数据中 1000:1 的视觉-文本标记不平衡。

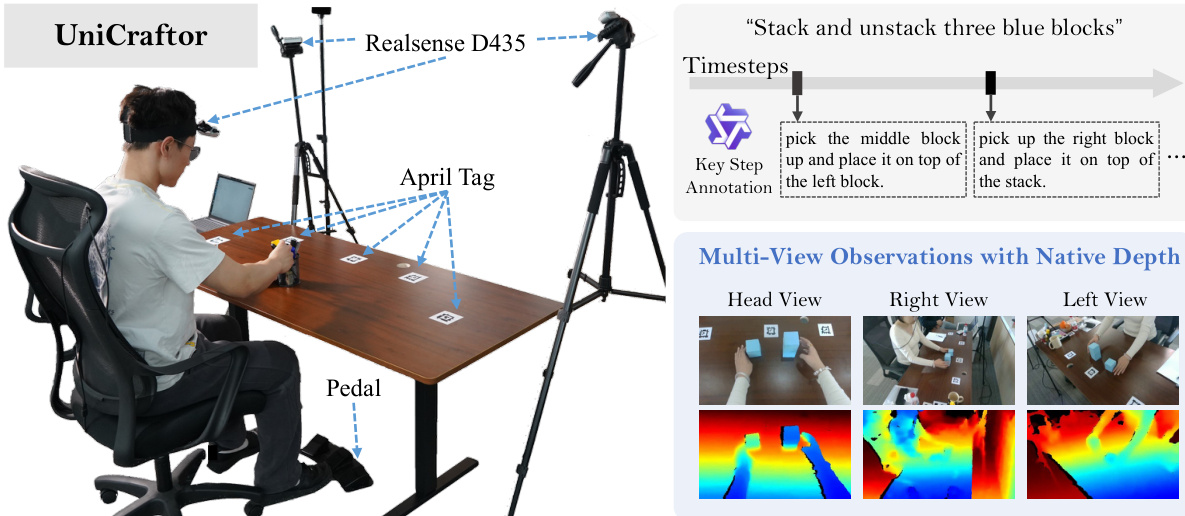

作者使用平衡混合数据训练模型:人类数据 256 亿标记、机器人数据 457 亿标记、VLM 数据 502 亿标记。采用 UniCraftor——一个模块化数据采集系统——进行高保真内部录制,配备原生深度(Intel RealSense)、精确相机外参(AprilTags + PnP)和硬件同步交互事件(脚踏板)。后处理包括 AprilTag 修复、多视角运动优化和 Qwen2.5-VL 事件条件描述,经人工验证。确保干净、同步、语义对齐的监督,用于细粒度策略学习。

方法

作者为 Being-H0.5 采用专门设计的混合Transformer(MoT)架构,旨在解耦高层语义推理与低层运动控制。该框架整合两个独立专家模块:多模态理解专家,负责解释高维感知输入并生成长视野规划的中间子目标;动作生成专家,作为专用策略网络,将高层计划转化为精确的运动执行。两个专家均在统一 MoT 主干中运行,处理共同标记序列并在每层 Transformer 中共享自注意力机制,促进信息无缝流动,确保动作生成深度依赖视觉-语义上下文。模型主干初始化自 InternVL-3.5(仅解码器 Transformer),因其在复杂视觉推理任务中的出色表现而被选中。整体架构旨在平衡语义理解与连续控制,与当前最先进模型对齐。

模型采用混合生成范式,针对输出模态定制。对于文本输出(如高层推理和运动描述),使用标准的下一标记预测范式,利用视觉-语言模型在生成连贯、逻辑结构化指令链方面的成熟效果。对于离散手部运动,采用掩码标记预测准则。对于动作预测,模型摒弃离散标记化,转而使用修正流方法,在连续动作空间上生成平滑、高保真多模态分布,与前沿扩散式 VLA 方法一致。

为应对多源具身数据的异构性,作者引入物理可解释的统一状态-动作空间。该空间将状态和动作形式化为固定长度、高维向量,按物理语义对齐结构化。向量空间划分为语义隔离的子空间,每个维度对应一个具象物理量,如双手末端执行器姿态、关节位置、夹爪宽度或移动基座速度。关键创新在于将人类手部运动视为广义具身形态,将 MANO 手部模型参数直接映射入该统一空间。人类手部全局腕部姿态与机器人末端执行器子空间对齐,而手指关节运动映射至预留的“精细操作”槽位。这确保不同自由度不冲突,使模型能学习共享的、具身无关的操作逻辑潜表示。为保证可迁移性,空间强制标准化:笛卡尔控制动作以统一世界坐标系中的相对位移表示,旋转统一使用轴角参数化,关节位置标准化为绝对弧度值。模型保留原始物理量级而非应用统计归一化,迫使其学习动作的真实物理尺度。

为克服传统动作专家容量有限的问题,作者引入混合流(MoF)框架。该可扩展架构解耦不同具身形态和技能,同时利用共享基础表示。动作专家结构为两层层次:基础专家(共享动力学)和专用专家(具身与任务路由)。动作专家初始层为所有输入共享的标准 Transformer 块,编码基本、可迁移的运动原语(如抓取和伸展)。上层使用一组并行专用专家,由可学习门控网络管理,灵感源自混合专家(MoE)架构。对于给定输入状态和指令,路由器动态激活稀疏专家子集,实现高效专业化而无需线性增加计算开销。此架构稀疏性是 Being-H0.5 效率和鲁棒性的基础,使其能将精炼的基础原语合成为复杂、任务特定行为,避免跨任务干扰。

学习框架围绕统一序列建模问题构建,所有监督信号均转化为单一多模态序列。每种具身形态通过稀疏槽位分配投影至统一空间,使人类手部运动和机器人轨迹可与视觉和语言共存。每个训练样本序列化为由模态段组成的标记流,模态集定义为 {视觉, 文本, 状态, 动作}。数据组织为问答格式,模型以上下文为条件,仅对响应部分优化生成损失。预训练本质上以人为本,以 UniHand-2.0 数据集为核心,提供大规模第一视角人类数据用于行为意图,高保真机器人轨迹用于运动学监督。VQA 信号的整合注入广泛视觉-语言上下文,增强场景理解,使模型能以 VLM 的精细度感知,同时执行精确动作。

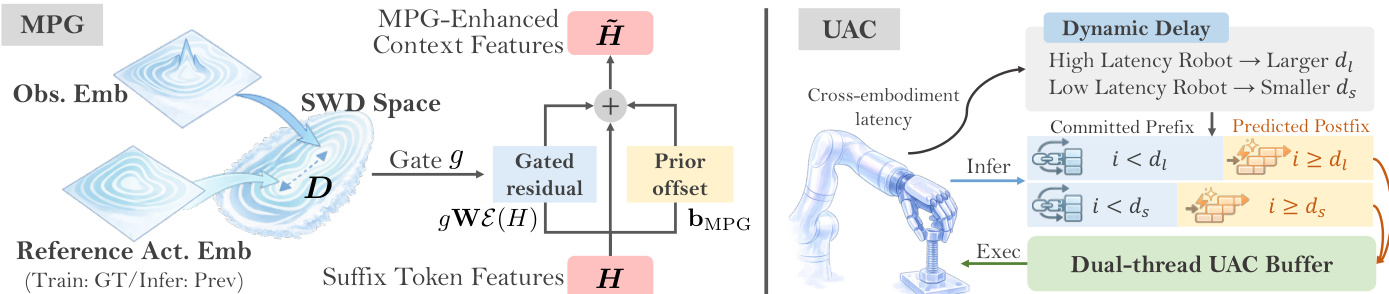

以人为本的多任务目标以运动生成为主要目标,模型在视觉、文本和状态条件下预测动作块。辅以运动描述和延续作为对齐目标,强化视觉-语言-运动接地和时序一致性。联合损失函数结合文本损失和动作损失,标记级索引集标识各损失项适用的段落。对于运动生成和延续,动作标记使用专用动作损失监督,该损失为连续流匹配与离散掩码运动预测的加权组合。连续流匹配使用时间条件速度场建模连续运动分布,最小化预测速度与理想向量场之间的均方误差。掩码运动标记预测监督离散通道,灌输运动原语的稳定抽象,模型从掩码标记序列重建原始码本索引。为实现无缝整合,模型将上下文和混合目标序列化为统一序列,修改注意力掩码确保连续与离散目标段相互不可见,并对齐位置索引,使两种表示基于相同上下文原点。

实验

- 在五种形态各异的真实机器人和 10 项任务上评估 Being-H0.5;验证空间、长视野、双手和跨具身泛化能力。

- Being-H0.5-generalist(单检查点)在多数类别上接近专家性能,尤其在重叠设置中优于专家;在 Adam-U 上实现未见任务的具身级零样本迁移。

- 显著优于 π₀.₅,尤其在长视野和双手任务上,得益于统一状态-动作空间和跨具身设计。

- UniHand-2.0 预训练对泛化性能至关重要;从零训练的消融实验无法跨具身泛化。

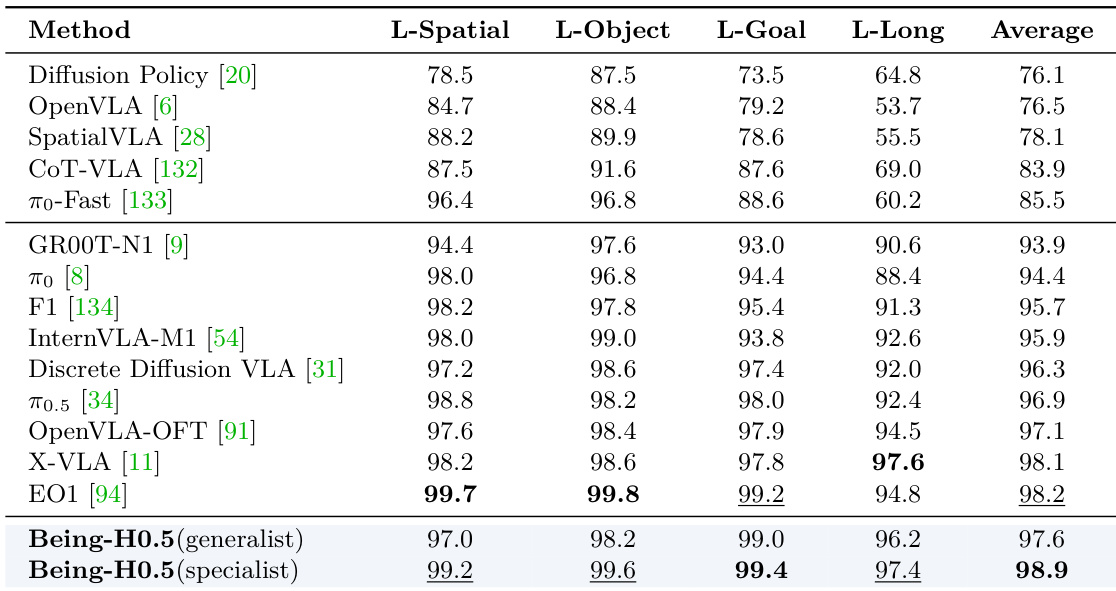

- 在 LIBERO 上,Being-H0.5-specialist 达到 98.9% 平均成功率(LIBERO-Long 上为 97.4%);泛化模型(联合 LIBERO+RoboCasa)达到 97.6%,性能下降极小。

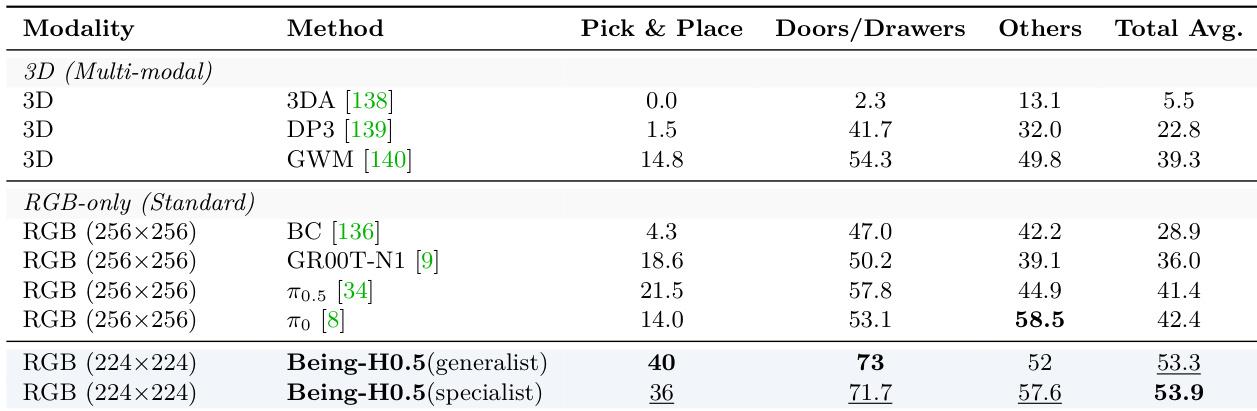

- 在 RoboCasa 上,Being-H0.5 创下新 SOTA:53.9%(专家)和 53.3%(泛化),超越 3D 基础和多模态基线,尽管仅使用 RGB 输入。

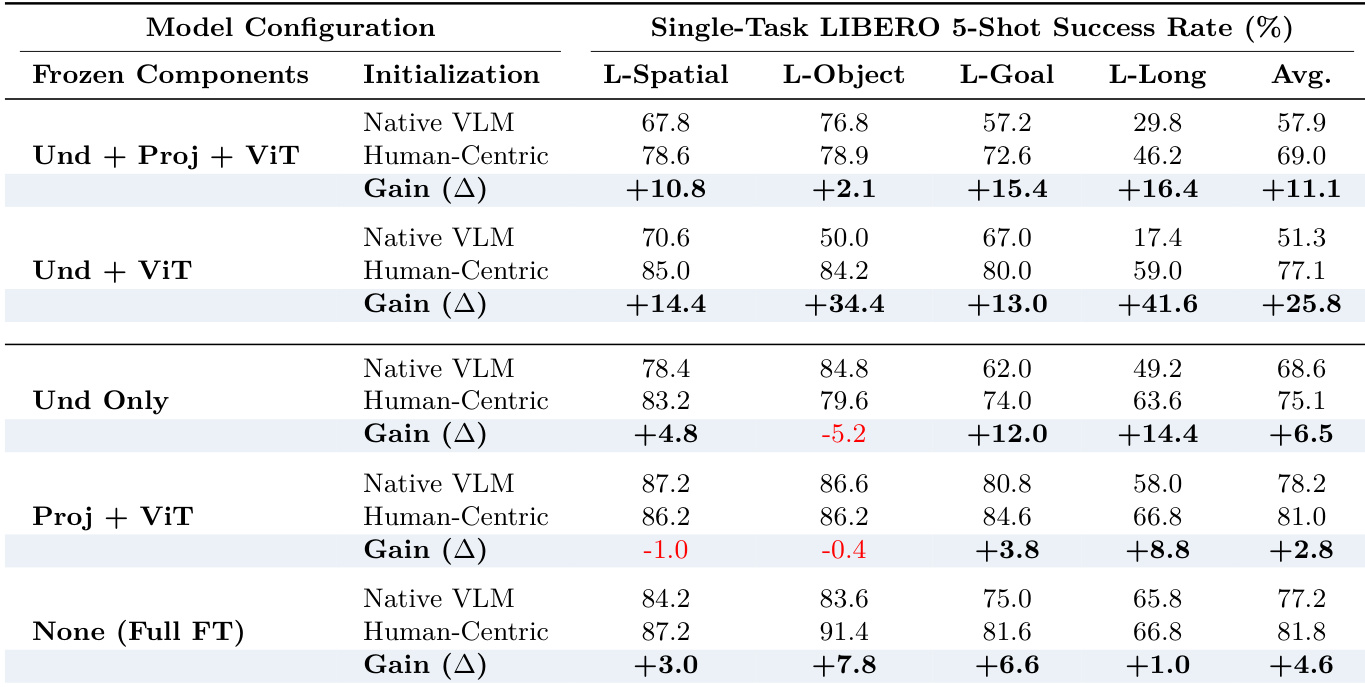

- 以人为本的预训练提升少样本适应:冻结主干时平均增益 +25.8%;在 LIBERO-Long 上 +41.6%,确认其在接地长视野意图中的作用。

- 掩码运动标记预测提升运动意图对齐(MWDS ↑),尤其在嘈杂、真实世界数据中。

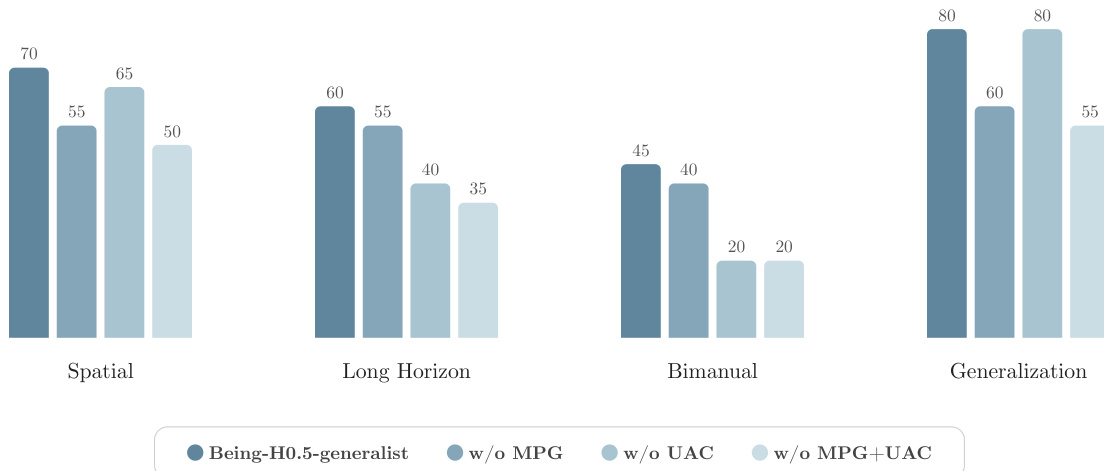

- 禁用 MPG+UAC 在长视野和双手任务中严重降低实时性能,因误差累积和时序稳定性丧失。

结果表明,Being-H0.5 专家模型平均成功率最高达 98.9%,在所有任务类别中优于所有其他方法,尤其在长视野任务中以 97.4% 成功率表现突出。Being-H0.5 泛化模型表现同样强劲,平均达 97.6%,证明单检查点可在多样任务中保持高性能,同时实现跨具身泛化。

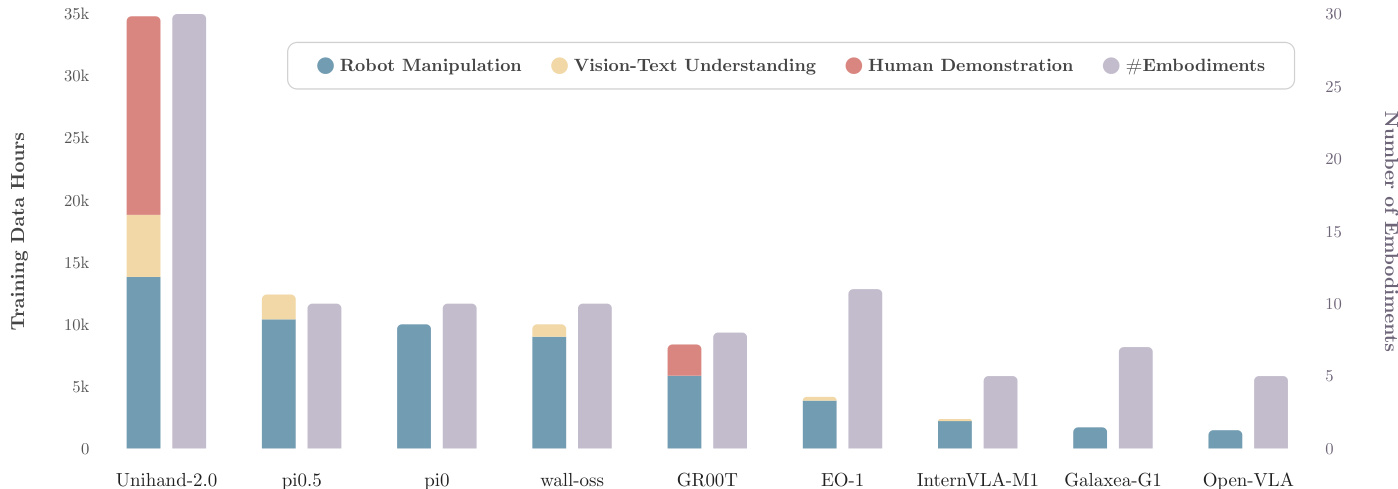

作者使用柱状图比较不同模型的训练数据规模,显示 UniHand-2.0 拥有最大训练数据量,超过 35,000 小时机器人操作数据和 20,000 小时人类演示数据,同时支持最多具身形态。相比之下,pi0.5 和 pi0 等模型的机器人操作数据显著更少,支持的具身形态也更少,表明数据规模与具身覆盖之间存在权衡。

作者在 RoboCasa 基准上比较 Being-H0.5 与各种方法,评估专家和泛化训练模式。结果表明,Being-H0.5 实现最先进性能,泛化版本成功率达 53.3%,专家版本达 53.9%,优于使用 3D 输入或基于 RGB 观察的先前方法。

作者分析以人为本预训练在单任务 5 样本设置下对下游适应的影响,显示以以人为本权重初始化在所有任务类别中带来显著提升,尤其在长视野任务中。当核心推理组件(Und + ViT)冻结时,预训练模型比基线平均提升 +25.8%,表明预训练提供强大基础先验,在数据有限时减少过拟合并增强泛化。

作者使用真实机器人评估评估 Being-H0.5 在四类任务中的表现:空间、长视野、双手和泛化。结果表明,Being-H0.5-generalist 模型在所有类别中均取得高成功率,泛化任务表现最高(80%),其次为空间(70%)、长视野(60%)和双手(45%)。移除 MPG 和 UAC 组件显著降低性能,尤其在长视野和双手任务中,表明其在复杂、异步和协调操作中维持鲁棒性的关键作用。