Command Palette

Search for a command to run...

推理模型催生“思想百家”

推理模型催生“思想百家”

Junsol Kim Shiyang Lai Nino Scherrer Blaise Agüera y Arcas James Evans

摘要

大型语言模型在多个领域已展现出卓越的能力,然而其复杂推理背后的机制仍不明确。近期的推理模型在复杂认知任务上的表现优于同类指令微调模型,这一优势通常归因于通过更长的思维链实现的扩展计算。然而,本文揭示,推理能力的提升并非仅源于扩展计算,而是源于模拟多智能体式交互——即“思想社会”的构建,这种结构使得内部认知视角之间产生多样化与辩论,这些视角具有不同的个性特征和专业领域专长。通过对推理过程轨迹进行定量分析与机制可解释性研究,我们发现像 DeepSeek-R1 和 QwQ-32B 这类推理模型在认知视角多样性方面显著优于指令微调模型,在推理过程中激活了更多异质性特征之间的冲突,包括与个性和专业能力相关的特征。这种多智能体结构体现在对话行为中,如问答互动、视角转换以及对冲突观点的调和,并展现出典型的社会情感角色,促成激烈而富有张力的对话过程,这些特征共同构成了推理任务中准确率优势的来源。受控的强化学习实验表明,当仅以推理准确率为奖励目标时,基础模型会自发增强对话行为;而通过引入对话结构化引导进行微调,则能进一步加速推理能力的提升,超越基础模型。这些发现表明,思想的社会化组织有助于对解空间进行高效探索。我们提出,推理模型建立了一种与人类群体集体智能相类似的计算范式:当多样性以系统化方式组织时,能够实现更优的问题求解。这一发现为智能体组织方式的创新提供了新思路,有望有效利用“群体智慧”的潜力。

一句话总结

谷歌、芝加哥大学与圣塔菲研究所的研究人员提出,像 DeepSeek-R1 和 QwQ-32B 这样的先进推理模型之所以表现卓越,并非仅仅因为更长的思维链,而是通过隐式模拟一种“思想社会”——即模型内部具有不同人格与专长的多样化视角之间类似多智能体的对话。通过机制可解释性与受控强化学习,他们证明了对话行为(如提问、冲突、调和)以及视角多样性与准确率之间存在因果关系,其中对“惊讶”的话语标记进行引导可使推理性能翻倍。这种思想的社会化组织使得对解空间的系统性探索成为可能,表明集体智能原则——多样性、辩论与角色协调——是有效人工推理的核心基础。

主要贡献

- 像 DeepSeek-R1 和 QwQ-32B 这样的推理模型在复杂任务上取得卓越表现,并非仅因思维链更长,而是通过隐式模拟“思想社会”——即模型内部具有不同人格特征与领域专长的多样化视角之间结构化的多智能体互动。

- 通过机制可解释性与推理轨迹的定量分析,发现这些模型展现出显著更高的视角多样性以及异质认知特征之间的冲突,表现为对话行为如视角转换、辩论与调和,这些行为直接支持有效的推理策略。

- 受控强化学习实验表明,当奖励模型以准确率为目标时,其会自发发展出更多对话行为;而通过对话支架进行微调,可加速推理能力提升,优于单语式方法,证明思想的社会化组织通过集体智能增强了问题求解能力。

引言

作者研究了大型语言模型中高级推理的机制,聚焦于为何 DeepSeek-R1 和 QwQ-32B 等模型在复杂任务上优于标准指令微调模型。尽管以往研究将推理能力提升归因于更长的思维链,但作者指出,关键并不在于长度,而在于“思想社会”的涌现——即模型推理过程中隐含的、类似多智能体的对话结构。该结构包含具有不同人格与专长的多样化模拟视角,参与问答、视角转换、冲突与调和,通过认知多样性与结构化辩论共同提升问题求解能力。借助机制可解释性与受控强化学习,作者发现当模型被奖励以准确率为目标时,会自发发展出对话行为;而通过对话支架进行微调可加速推理改进。研究结果表明,有效的AI推理并非源于孤立的独白,而是源于思想的社会化组织,其原理与人类群体中的集体智能高度相似。

数据集

- 数据集包含 8,262 个来自多个领域的推理问题,涵盖符号逻辑、数学求解、科学推理、指令遵循及多智能体推理。

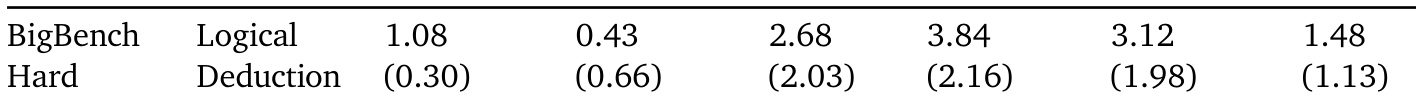

- 集成多个基准套件:BigBench Hard(BBH)用于多步逻辑推理与组合推理;GPQA 用于研究生水平物理问题;MATH(Hard)用于代数、几何、概率与数论中的复杂推导;MMLU-Pro 用于高级概念知识;IFEval 用于评估指令遵循的一致性;MUSR 用于符号操作与结构化数学推理。

- 所有响应均在零样本设置下由六种模型生成:DeepSeek-R1(671B 参数)、QwQ-32B、DeepSeek-V3(671B 参数)、Qwen-2.5-32B-Instruct、Llama-3.3-70B-Instruct 与 Llama-3.1-8B-Instruct。DeepSeek-R1 与 QwQ-32B 是基于其基础指令微调版本的推理优化变体。

- 所有模型响应均以温度 0.6 生成,该值被推荐用于平衡推理性能。

- 数据集设计支持多视角推理,每个实例包含指定数量的视角(n_perspectives),每个视角对 10 个问题提供答案,并附带开放式的领域专长描述。

- 数据用于训练与评估模型,任务混合自所含基准,训练划分直接来自原始数据集,并处理为符合所需 JSON 格式。

- 未进行显式裁剪;而是对数据进行处理以确保格式一致,包括在 JSON 结构中正确嵌套答案与专长描述。

方法

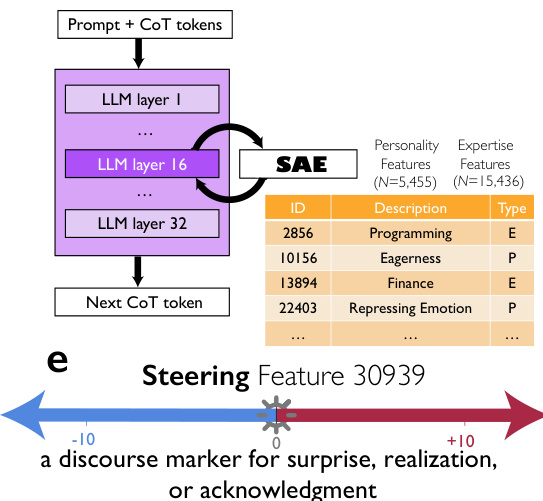

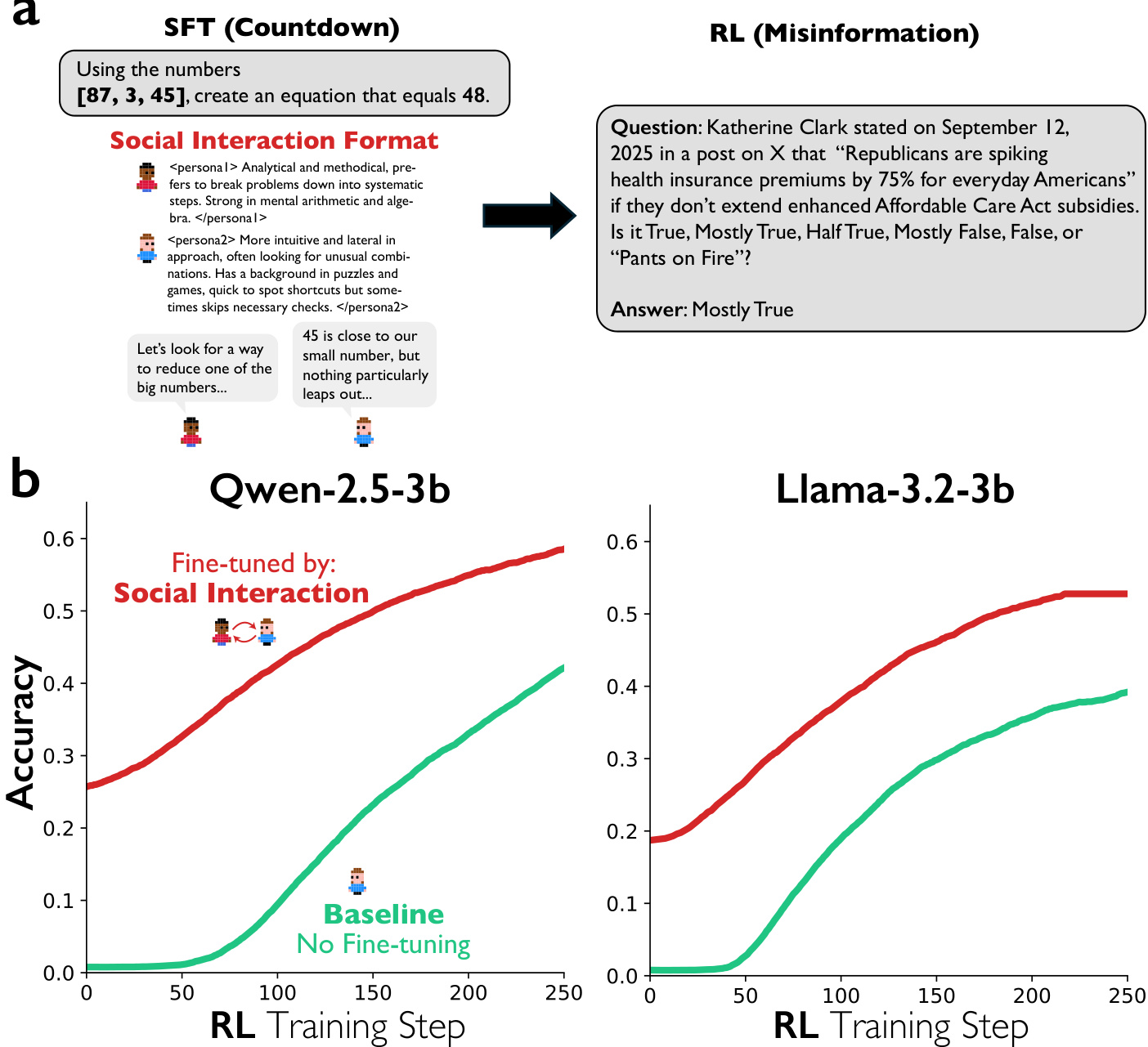

作者采用多维度框架,研究对话行为与社会情感行为在大型语言模型(LLM)推理中的作用。核心方法融合稀疏自编码器(SAE)用于特征识别与操控、LLM 作为裁判协议用于行为标注,以及统计建模以分离特定认知与社会维度的影响。整体架构始于从目标 LLM 中提取激活值,具体为 DeepSeek-R1-Llama-8B 的第 15 层,随后通过 SAE 将高维激活空间分解为一组稀疏可解释特征。该 SAE 在 SlimPajama 语料库上训练,字典大小为 32,768 个特征。作者识别出一个特定特征——特征 30939,其被定义为“惊讶”、“顿悟”或“确认”的话语标记,高度特异于对话语境。该特征随后被用于引导模型生成过程:在每个 token 生成步骤中,将该特征的解码器向量添加至残差流激活中,引导强度 s 可正可负。该框架旨在测试此对话特征对推理性能与行为的因果影响。

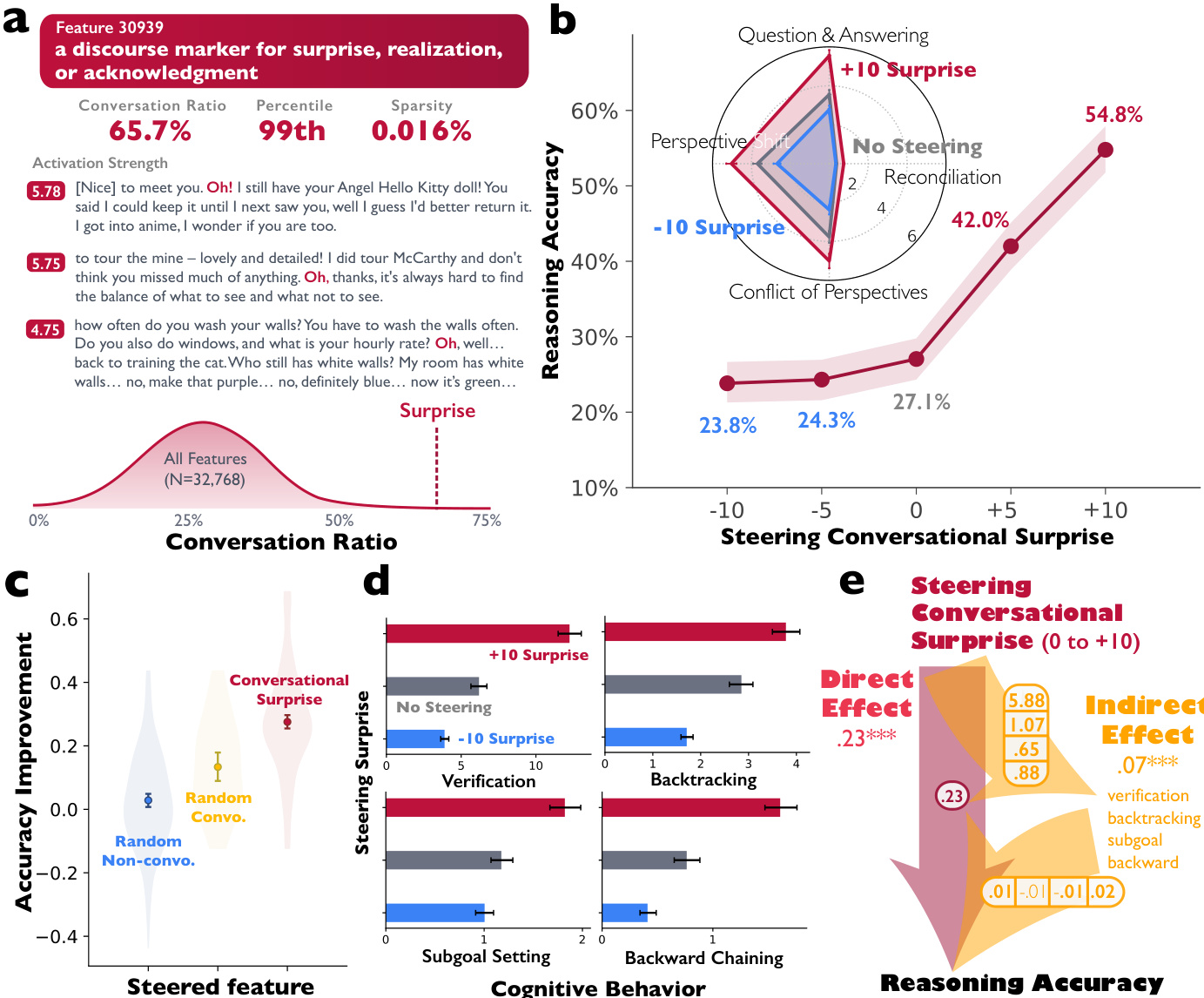

作者采用严格的评估协议来评估引导的影响。推理性能通过 Countdown 任务进行衡量,该任务是多步算术推理的基准。对于每个问题,模型需使用基本算术运算组合一组输入数字以达到目标值。评估使用标准化提示模板,若最终数值答案与目标匹配,则判定为正确,由 Gemini-2.5-flash-lite 评估。为量化引导对行为的影响,作者采用 LLM 作为裁判方法(Gemini-2.5-Pro)统计生成推理轨迹中四种对话行为的出现次数:问答、视角转换、视角冲突与调和。该过程也用于测量验证、回溯与子目标设定等认知行为。这些行为分析结果以雷达图可视化,比较不同模型与引导条件下各类行为的频率。

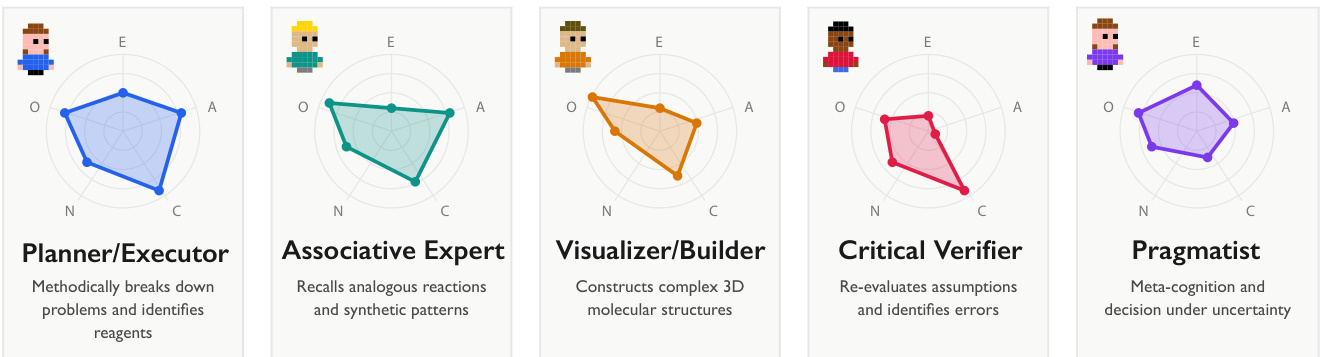

为确保观察到的差异归因于目标行为而非任务难度或输出长度等混淆因素,作者估计了固定效应线性回归模型。这些模型包含对对数变换后的推理轨迹长度与任务固定效应的控制,后者吸收了每个问题内在难度与表述方式带来的变异。这使得在相同问题背景下对模型性能与行为进行直接比较成为可能。统计分析进一步扩展至考察推理轨迹中隐含视角的多样性。作者使用 LLM 作为裁判协议推断视角数量,利用 BFI-10 量表刻画其人格特质,并分析其领域专长。该过程在人类辩论语料库上进行验证,显示出对发言人数与发言轮次的高预测准确性。

该框架还研究了对话引导对模型内部表征空间的影响。通过分析引导前后 SAE 特征激活情况,作者计算了两个多样性度量:覆盖度(激活的独特人格或专长相关特征数量)与熵(特征激活分布的均匀性)。分析显示,引导对话特征会增加模型内部表征中人格与专长相关特征的多样性,表明推理过程中对认知与社会维度的探索范围更广。结果以一系列柱状图与小提琴图呈现,对比引导特征 30939 与随机选择的对话与非对话特征的效果,证明了该效应的特异性。

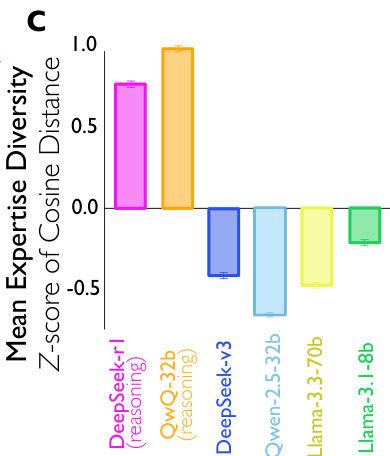

作者进一步通过计算人格向量的标准差与识别出的隐式声音间专长嵌入的平均余弦距离,量化推理轨迹中的人格与专长多样性。这为模型生成视角的丰富性与多样性提供了数值度量。该框架旨在全面理解模型激活空间中特定可解释特征如何被操控,以影响 LLM 在推理过程中的外部行为与内部认知过程。结果以一系列雷达图与散点图可视化,展示引导强度、推理准确率与各类认知与对话行为频率之间的关系。

实验

- 在六个基准上对推理模型(DeepSeek-R1、QwQ-32B)与指令微调模型(DeepSeek-V3、Qwen-2.5-32B-IT、Llama-3.3-70B-IT、Llama-3.1-8B-IT)进行了实验,涵盖符号逻辑、数学、科学、多智能体推理与指令遵循。

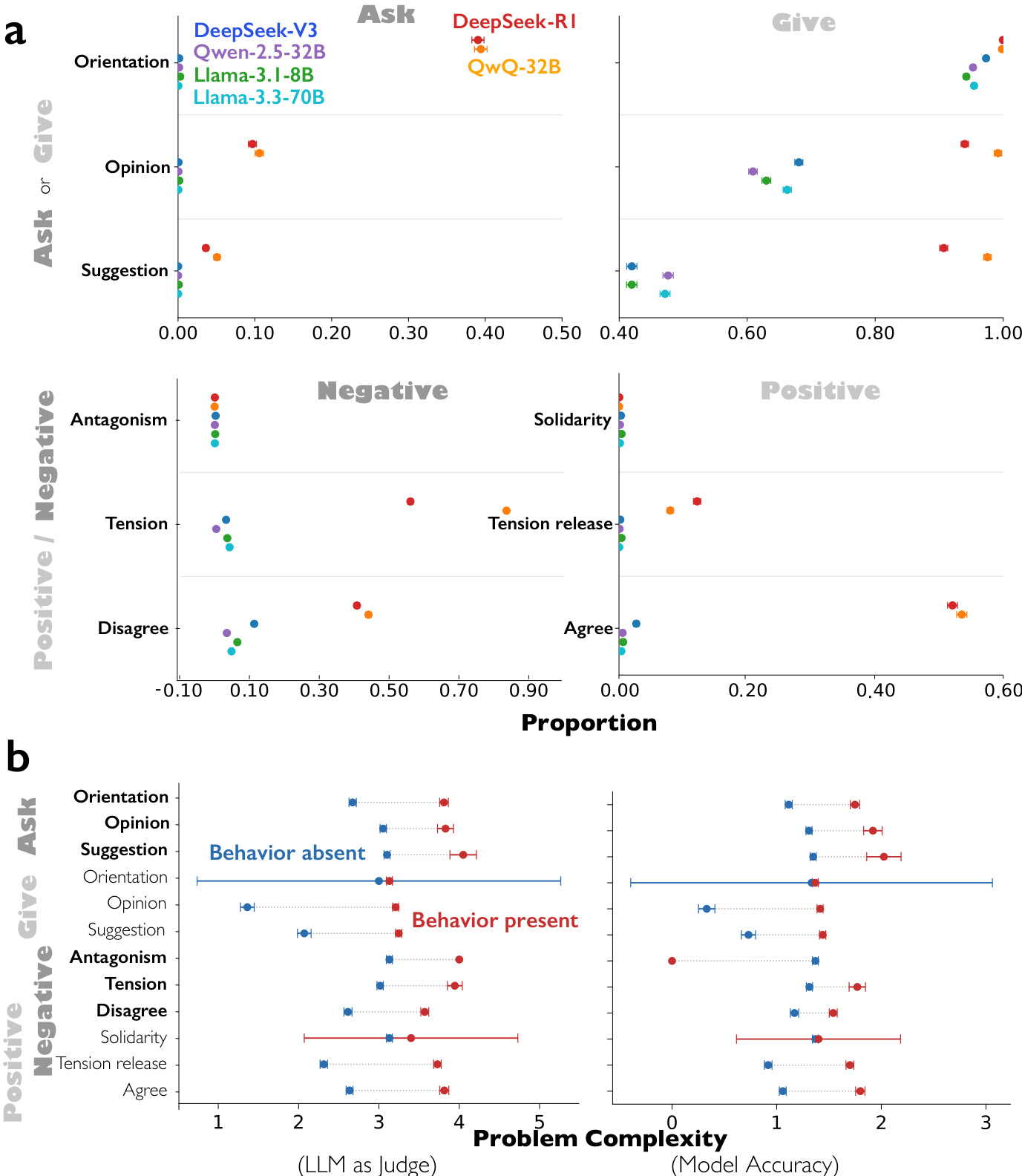

- 发现推理模型在对话行为(问答、视角转换、视角冲突、调和)与社会情感角色(提问/提供信息、正/负情绪)方面显著高于指令微调模型,即使在控制轨迹长度与任务难度后依然成立。

- 证明对话行为与社会情感角色在复杂问题(如 GPQA、高难度数学)中更为普遍,且通过验证、回溯、子目标设定与逆向链式推理等认知策略中介准确率提升。

- 展示在 DeepSeek-R1-Llama-8B 中,使用稀疏自编码器引导特定对话特征(特征 30939,即“惊讶/顿悟”的话语标记),可在 Countdown 任务上使推理准确率提升 27.7 个百分点(从 27.1% 提升至 54.8%),并同时显著增加全部四种对话行为与认知策略。

- 揭示推理模型在人格(更高外向性、宜人性、神经质、开放性)与领域专长方面生成了更多样化的隐含视角,其人格与专长相关 SAE 特征的熵与覆盖度更高,尤其在对话引导下更为显著。

- 发现仅通过准确率奖励的强化学习即可自发催生对话行为并提升准确率;而先前在多智能体对话数据上进行微调的模型,相比单语式微调,能更快提升准确率并获得更高最终性能,且该优势可迁移至无关任务(如虚假信息检测)。

作者使用一系列基准比较推理模型(DeepSeek-R1 与 QwQ-32B)与指令微调模型(DeepSeek-V3、Qwen-2.5-32B-IT、Llama-3.3-70B-IT、Llama-3.1-8B-IT)在对话行为与社会情感角色上的表现。结果显示,推理模型在问答、视角转换、视角冲突与调和方面显著高于其指令微调对应模型,且表现出更均衡、互惠的社会情感角色,包括信息的提问与提供,以及正负情绪的表达。

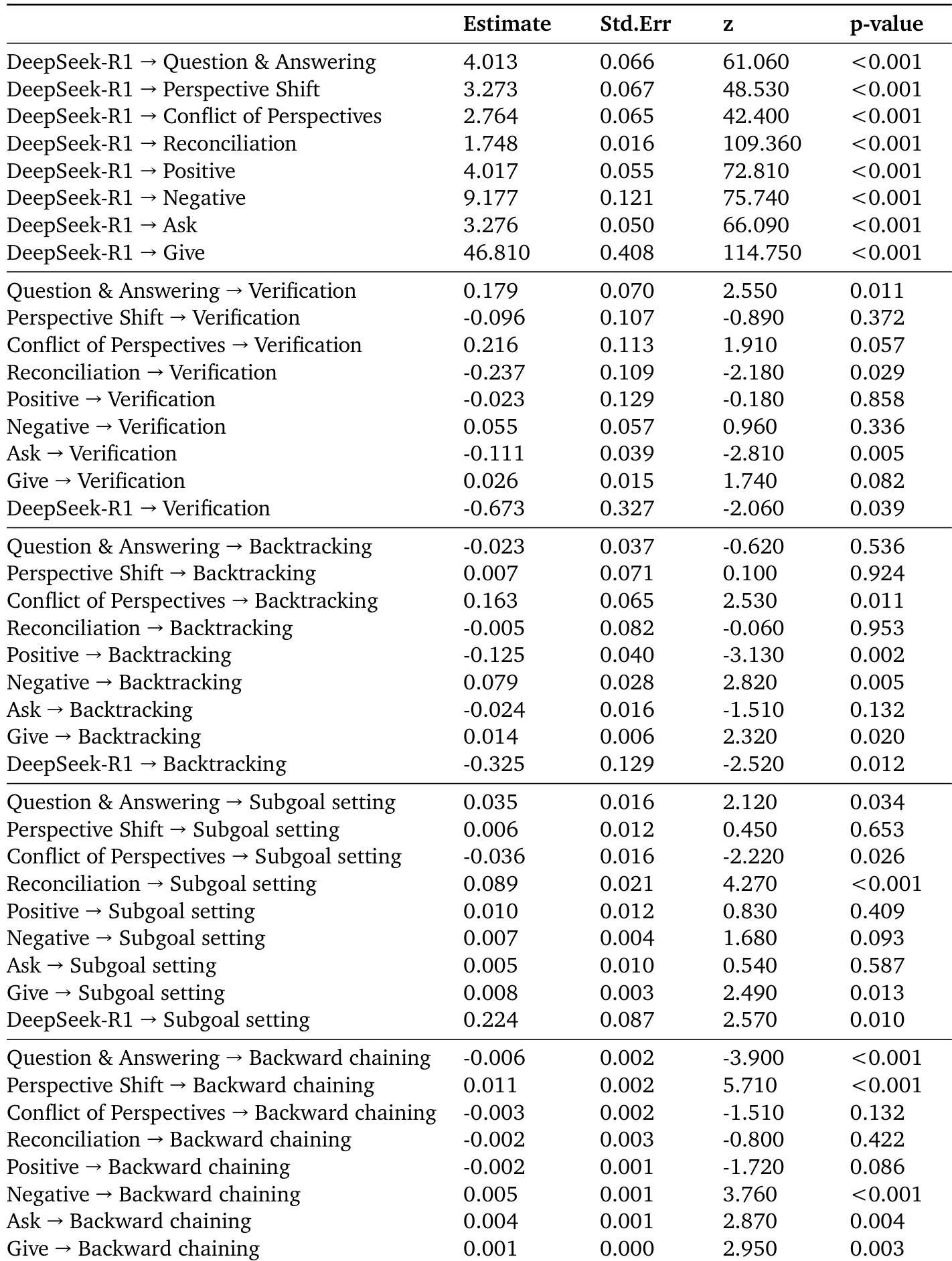

作者使用结构方程模型分析从推理模型到准确率的路径,表明对话行为与社会情感角色在 DeepSeek-R1 与 QwQ-32B 的准确率优势中起中介作用,既直接也通过验证、回溯、子目标设定与逆向链式推理等认知行为间接影响准确率。结果表明,对话行为显著影响认知策略,对准确率具有直接与间接影响,尤其通过验证与逆向链式推理。

作者使用 BigBench Hard、GPQA、MATH(Hard)、MMLU-Pro、MUSR 与 IFEval 等基准评估推理模型。结果显示,DeepSeek-R1 与 QwQ-32B 在对话行为与社会情感角色频率上显著高于其指令微调对应模型,且这些行为在更复杂问题中进一步增强。

作者使用强化学习研究当模型仅因正确答案获得奖励而无直接对话激励时,对话行为是否会出现。结果显示,训练过程中,仅以准确率为奖励的模型会自发发展出对话行为,包括问答与视角转换。此外,先前在多智能体对话数据上预训练的模型,相比在单语式推理上微调的模型,准确率提升显著更快,表明对话支架可加速推理发展。

作者使用稀疏自编码器分析 DeepSeek-R1-Llama-8B 的激活空间,发现引导对话特征可增加推理过程中激活的人格与专长相关特征的多样性。这表明对话行为促使模型在内部表征中进行更广泛的探索,使更多样化的特征在推理轨迹中被激活。