Command Palette

Search for a command to run...

SkinFlow:通过动态视觉编码与分阶段强化学习实现开放性皮肤病诊断的高效信息传输

SkinFlow:通过动态视觉编码与分阶段强化学习实现开放性皮肤病诊断的高效信息传输

Lijun Liu Linwei Chen Zhishou Zhang Meng Tian Hengfu Cui Ruiyang Li Zhaocheng Liu Qiang Ju Qianxi Li Hong-Yu Zhou

摘要

尽管通用大规模视觉-语言模型(LVLMs)参数规模巨大,但在皮肤病学领域常因“泛化注意力”(diffuse attention)问题而表现不佳——即难以将细微的病理性病变从背景噪声中有效分离。本文挑战了“参数规模扩大是实现医疗精准性的唯一路径”这一传统假设。我们提出SkinFlow框架,将疾病诊断建模为视觉信息传输效率的优化过程。该方法采用虚拟宽度动态视觉编码器(Virtual-Width Dynamic Vision Encoder, DVE),在不增加实际参数量的前提下“展开”复杂的病理性流形结构,并结合两阶段强化学习策略:第一阶段在约束语义空间内对齐显式的医学描述,第二阶段重构隐式的诊断纹理特征。此外,我们设计了一套基于临床实践的评估协议,强调诊断安全性与层级相关性,而非严格依赖标签匹配。实验结果令人振奋:我们的70亿参数模型在Fitzpatrick17k基准测试中达到新的最先进水平,Top-1准确率相较于大型通用模型(如Qwen3VL-235B和GPT-5.2)提升12.06%,Top-6准确率更是提高28.57%。这些发现表明,通过优化几何容量与信息流动效率,可显著提升模型的诊断推理能力,其效果远超单纯依赖参数规模扩张的路径。

一句话总结

来自百川智能、北京大学第一医院、清华大学和香港大学的作者提出 SkinFlow,一种通过虚拟宽度动态视觉编码器(Virtual-Width Dynamic Vision Encoder)优化视觉信息传输,并结合两阶段强化学习策略,提升大视觉语言模型在皮肤病诊断中的表现的框架,在不依赖大规模参数扩展的情况下,实现了 Fitzpatrick17k 基准上的最先进性能。

主要贡献

- 通用大视觉语言模型(LVLMs)在皮肤病诊断中受限于“弥散注意力”问题,即模型无法将细微病灶与背景噪声有效分离,导致尽管模型规模巨大,视觉信息传输效率仍低下。

- 本文提出 SkinFlow,通过一种自适应“展开”复杂病理流形的虚拟宽度动态视觉编码器(DVE),提升信噪比,同时采用两阶段强化学习策略,依次对齐显式医学描述并重建隐式诊断纹理,优化诊断推理过程。

- 在 Fitzpatrick17k 基准上,7B 参数的 SkinFlow 模型相较于 Qwen3VL-235B 和 GPT-5.2 等大型通用模型,Top-1 准确率提升 +12.06%,Top-6 准确率提升 +28.57%;同时,采用以临床为导向的评估协议,优先考虑诊断安全性、层级相关性,而非严格的标签匹配。

引言

通用大视觉语言模型(LVLMs)在皮肤病学领域表现不佳,主要由于“弥散注意力”问题:模型难以从背景噪声中分离出细微的病理病灶,限制了诊断精度。现有模型还依赖僵化的评估指标,忽视临床相关性,将所有非精确匹配视为同等错误——然而在真实临床场景中,语义相近或治疗一致的预测具有重要临床价值。为解决这些问题,作者提出 SkinFlow,将皮肤病诊断重构为视觉信息传输效率的优化问题。他们提出一种虚拟宽度动态视觉编码器(DVE),在不增加参数量的前提下,自适应“展开”复杂视觉流形,显著提升信噪比。同时,设计两阶段强化学习策略,首先对齐显式医学描述,再在受限语义空间内重建隐式诊断纹理。作者进一步建立以临床为基础的评估协议,优先考虑诊断安全性、层级相关性与治疗一致性,而非标签匹配。实证表明,其 7B 模型在 Fitzpatrick17k 基准上,Top-1 准确率比大型通用模型(如 Qwen3VL-235B 和 GPT-5.2)高出 +12.06%,Top-6 准确率高出 +28.57%,证明优化信息流与几何容量,相比单纯参数扩展,能带来更优的临床表现。

数据集

- 数据集包含约 5,000 张来自国内外资源库的皮肤病图像,每张图像均带有疾病类别标注。

- 其中 4,000 对图像-标题由混合方法生成:先通过大语言模型进行自动标题生成,再由专家进行精修,以确保临床准确性与描述质量。

- 为评估目的,构建了两个不同基准,以反映真实世界诊断场景,且不假设封闭式疾病分类体系。

- 第一个基准使用公开的 Fitzpatrick17k 数据集中的 1,000 张随机采样图像,覆盖广泛的皮肤病种,作为泛化能力评估的标准基准。

- 第二个基准由内部整理约 200 张图像构成,所有标签均由来自三级甲等医院的注册皮肤科医生独立验证并修正,每位医生均具有五年以上临床经验,确保高诊断可靠性。

- 评估设置支持层级化与语义相关诊断,可容纳疾病边界的重叠,减少对严格亚型区分的需求,更贴近实际临床实践。

- 采用预定义的标题模板结构化图像描述,包含颜色、位置、形状、病灶类型、数量、大小、质地、边界与表面特征、分布、周围特征及其他相关描述字段,确保标注的一致性与全面性。

- 模型训练期间,数据集划分为训练集与验证集,标题按模板处理并过滤,以保留高质量、具有临床意义的描述。

- 未进行图像裁剪,所有图像均以原始形式使用,以保留诊断细节。元数据基于模板构建,当描述项不适用时,对应字段留空。

方法

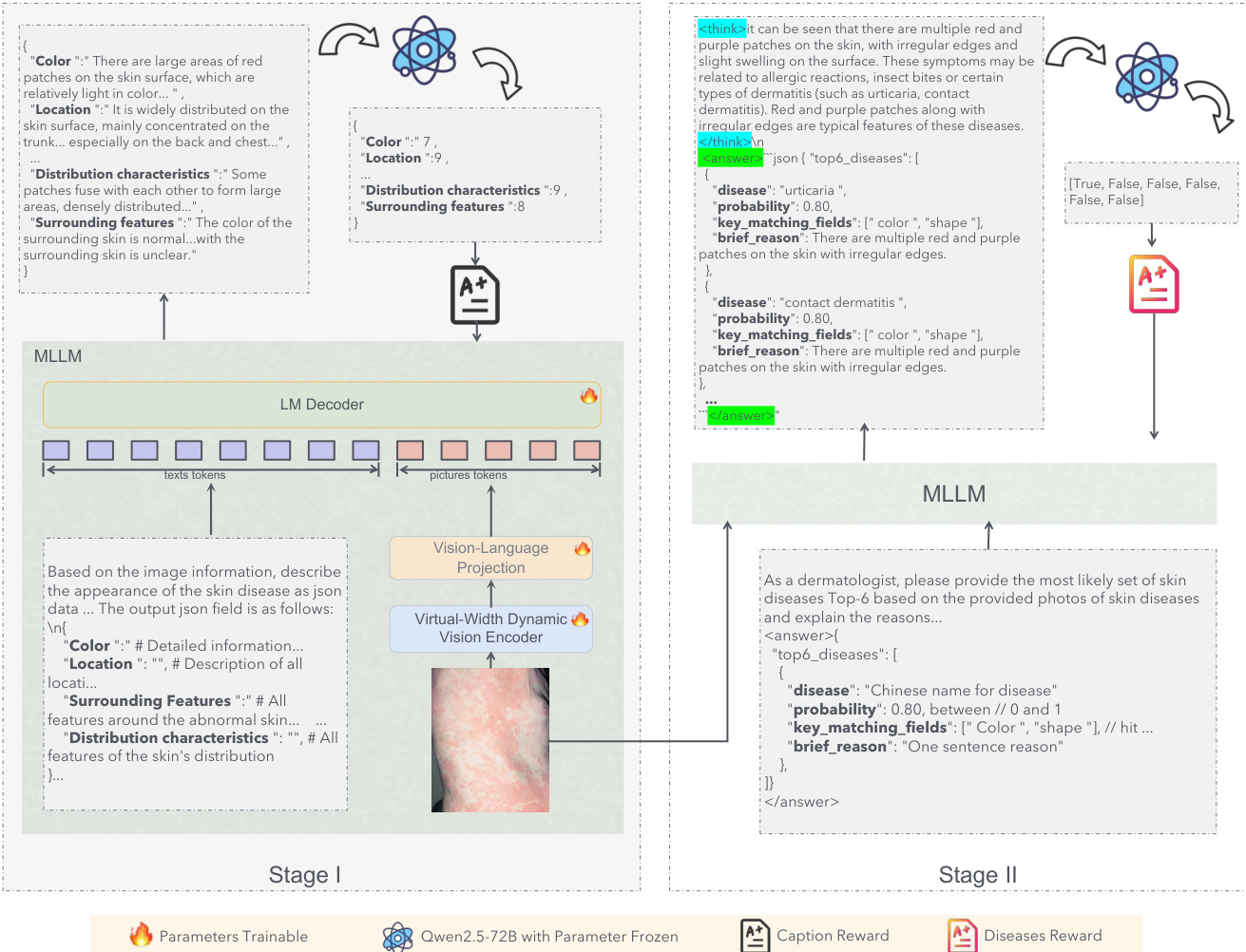

作者采用两阶段训练流程进行皮肤病诊断,围绕信息传输框架构建,旨在优化从原始图像像素到最终诊断输出的视觉信息流动。该方法基于理论原则:诊断性能受限于有限解码空间内的信息恢复效率。该框架将视觉信息分解为可描述特征 Id(显式医学征象)与不可描述特征 In(隐式病理纹理)。第一阶段称为信息压缩,通过医学标题生成任务强制编码器优先将 Id 压缩为语言可解释的表示,建立关键诊断特征的高容量通道。第二阶段称为语义解码,对模型进行微调,以整合 In 并将联合信息解码为特定诊断语义,确保最终输出既基于显式临床证据,也融合隐式视觉线索。此分阶段优化旨在最大化可恢复信息量,逼近诊断空间的理论上限。

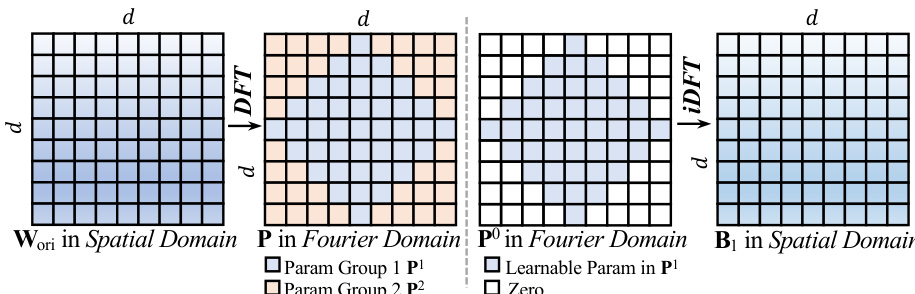

视觉表示的核心是动态视觉编码器(DVE),用于解决标准视觉 Transformer 的容量限制。标准模型依赖静态线性层 y=Wx+b,其中权重矩阵 W 在训练后固定。根据 Cover 定理,N 个随机模式在 d 维空间中线性可分的概率 P(N,d) 在 N≤2d 时约为 1,在 N≫2d 时趋近于 0。在皮肤病学中,视觉模式数 N(如纹理、红斑、鳞屑)可能极大,而编码器的物理维度 d 固定,导致容量崩溃,细微特征被平均化。为克服此问题,作者提出 FDLinear,一种实现隐式高维映射的机制,在不增加计算成本的前提下实现虚拟维度扩展。FDLinear 将权重空间解耦为 K 个正交谱基 {B1,…,BK},通过权重矩阵傅里叶谱的频率不相交划分构建。如图所示,原始权重矩阵 Wori 在空间域经离散傅里叶变换(DFT)转换至频域,频谱被划分为互不重叠的组,如低频分量(如 P1)与高频分量(如 P2)。特定空间基 Bk 通过保留第 k 个频段中的可学习参数并应用逆 DFT(iDFT)生成,确保每个基专注于特定频段,最小化频谱冗余。

动态权重 W(xˉ) 构建为这些基的上下文感知线性组合,W(xˉ)=∑k=1Kαk(xˉ)⋅Bk,其中动态系数 αk(xˉ) 被分解为三个正交调制向量,由轻量级全连接瓶颈层预测。该操作可视为两步“扩展-压缩”过程。输入 x 在所有基上的投影生成巨大隐藏表示 H∈RK×d,虚拟地将通道维度从 d 扩展至 K×d。在此超空间中,复杂视觉流形被展开并变得线性可分。关键在于,模型从不显式生成 H;而是将聚合步骤与矩阵乘法结合,计算 y=W(xˉ)x,其中 W(xˉ) 是预计算的 d×d 动态矩阵。这使得模型在保持紧凑层计算开销的同时,享有大规模宽度的几何容量。

训练过程采用强化学习(RL)框架,具体为分组相对策略优化(GRPO),以优化模型性能。GRPO 在候选输出组上运行,无需独立的评判模型。对于给定查询 q,从当前策略中采样 G 个候选输出,计算其奖励 r1,…,rG。组内奖励进行归一化,Ai=std(rj)ri−mean(rj),以稳定训练。GRPO 目标优化一个裁剪的重要性加权代理函数,并施加 KL 惩罚至参考策略,从而高效利用来自多样化输出的奖励信号。第一阶段,模型训练生成结构化医学标题。奖励函数设计用于确保临床有效性与语义完整性,计算各属性得分的加权平均,R=∑iαi⋅si,其中 si 为属性 i 的得分,αi 为其权重。各属性权重由大语言模型诊断推理中的出现频率决定。第二阶段,模型预测疾病类别,奖励定义为正确诊断在 Top-K 预测列表中的位置权重,鼓励预测既正确又排名靠前。模型初始化自 Qwen2.5-VL-Instruct-7B,FDLinear 操作符替换 Vision Transformer 中特定层的静态线性层。第一阶段训练使用 AdamW 优化器,学习率 1×10−6;第二阶段 RL 训练从第一阶段检查点继续,学习率 5×10−7,基于 VERL 框架实现。

实验

-

可视化验证与效率分析:FDLinear 验证了“虚拟宽度扩展”假设,通过动态、几何感知的权重方向成功展开非线性流形(如交织螺旋、同心圆),使紧凑模型达到远超其规模的容量,实现参数高效存储(<5% 开销)与与标准线性层相当的推理速度,有效弥合了 0.6B 视觉感知器与 7B 语言推理器之间的差距。

-

第二阶段皮肤病诊断训练:使用强化学习(RL)进行 Top-K 诊断训练,能够稳健处理术语多样性,并在无需穷举标签的情况下高效学习,相比监督微调在语义灵活性与可扩展性方面表现更优。

-

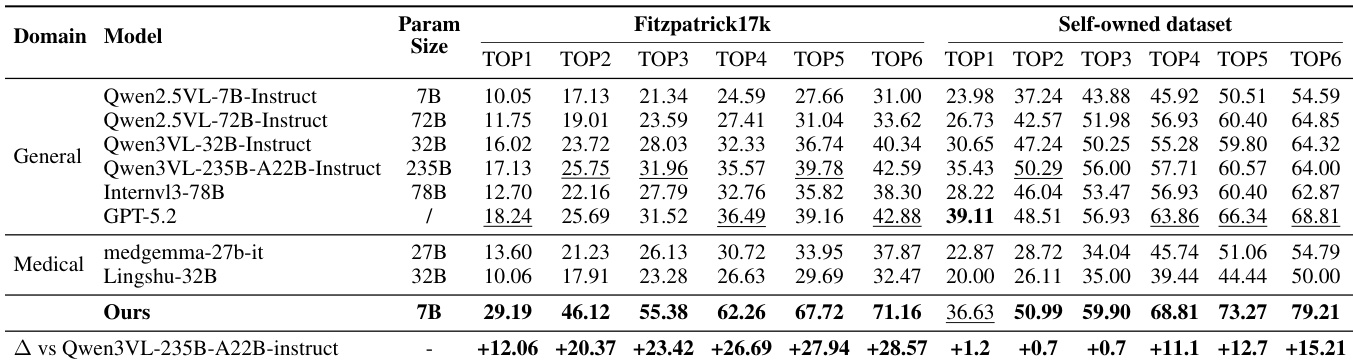

主要结果:在 Fitzpatrick17k 上,7B SkinFlow 模型达到 Top-1 准确率 29.19%,较最强基线(GPT-5.2)提升 10.95%,较 Qwen3-VL-235B 提升 12.06%;Top-6 准确率为 71.16%,较 Qwen3-VL-235B 提升 +28.57%。在自建数据集上,Top-6 准确率达 79.21%,显著优于 GPT-5.2(68.81%)与 Qwen3-VL-235B(64.00%),证明其在诊断候选池质量上的卓越表现,尽管参数量仅为后者的数分之一。

-

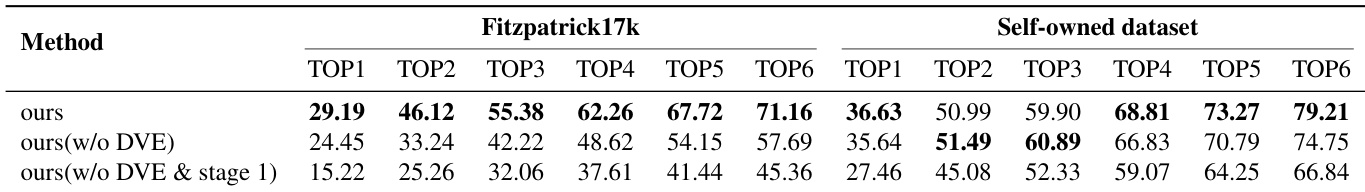

消融研究:第一阶段标题训练使 Top-1 准确率从 27.46% 提升至 35.64%(自建数据集),从 15.22% 提升至 24.45%(Fitzpatrick17k)。加入动态视觉编码(DVE)模块后,Top-1 准确率进一步提升至 36.63%,Top-6 达 79.21%,在 Fitzpatrick17k 上提升 4.74%,Top-6 准确率提升 13%,证实其在细粒度特征适应中的关键作用。

-

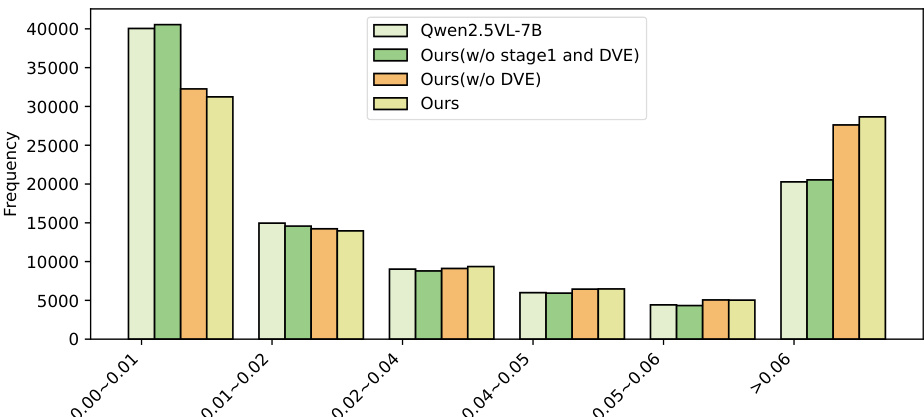

定性分析:视觉注意力图显示,SkinFlow 从弥散的全局扫描转变为精确的病灶定位,有效抑制背景噪声。全模型表现出高置信度注意力分布(>0.06),500 样本统计分析确认注意力权重分布显著“右移”,表明视觉推理中具有更优的信噪比。

结果表明,全模型(Ours)在 >0.06 注意力权重区间频率最高,表明其在诊断特征选择上最具信心。无第一阶段训练的模型(Ours w/o stage1 and DVE)与无 DVE 的变体(Ours w/o DVE)在该高置信度区间频率较低,而基线 Qwen2.5-VL-7B 在 0.00–0.01 区间集中,反映其注意力弥散且不确定。这表明,第一阶段标题训练与动态视觉编码(DVE)模块对抑制背景噪声、增强诊断信号强度均至关重要。

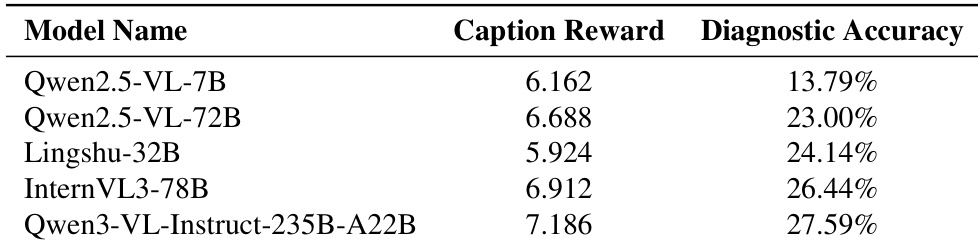

作者使用表格比较多个多模态模型的诊断准确率,结果显示 Qwen3-VL-Instruct-235B-A22B 达到最高准确率 27.59%。结果表明,标题奖励较高的模型通常表现更好,尽管 Qwen2.5-VL-72B 的标题奖励低于部分竞争者,仍取得 23.00% 的准确率,说明标题奖励并非诊断性能的唯一预测因子。

结果表明,所提出的 SkinFlow 模型在 Fitzpatrick17k 与自建数据集上均达到最先进性能,尽管参数量远少于大型通用与医学模型,仍显著超越后者。模型在 Top-6 排名上的卓越准确率,充分证明其在生成稳健诊断候选池方面的有效性,显著优于 GPT-5.2 与 Qwen3VL-235B 等基线。

结果表明,全 SkinFlow 模型在 Fitzpatrick17k 与自建数据集上所有指标均表现最佳,Top-1 准确率分别为 29.19% 与 36.63%。消融研究证实,动态视觉编码(DVE)模块与第一阶段标题任务均至关重要,移除任一组件均显著降低性能,尤其在更具挑战性的 Fitzpatrick17k 数据集上表现更明显。