Command Palette

Search for a command to run...

Klear:统一的多任务音视频联合生成

Klear:统一的多任务音视频联合生成

Jun Wang Chunyu Qiang Yuxin Guo Yiran Wang Xijuan Zeng Chen Zhang Pengfei Wan

摘要

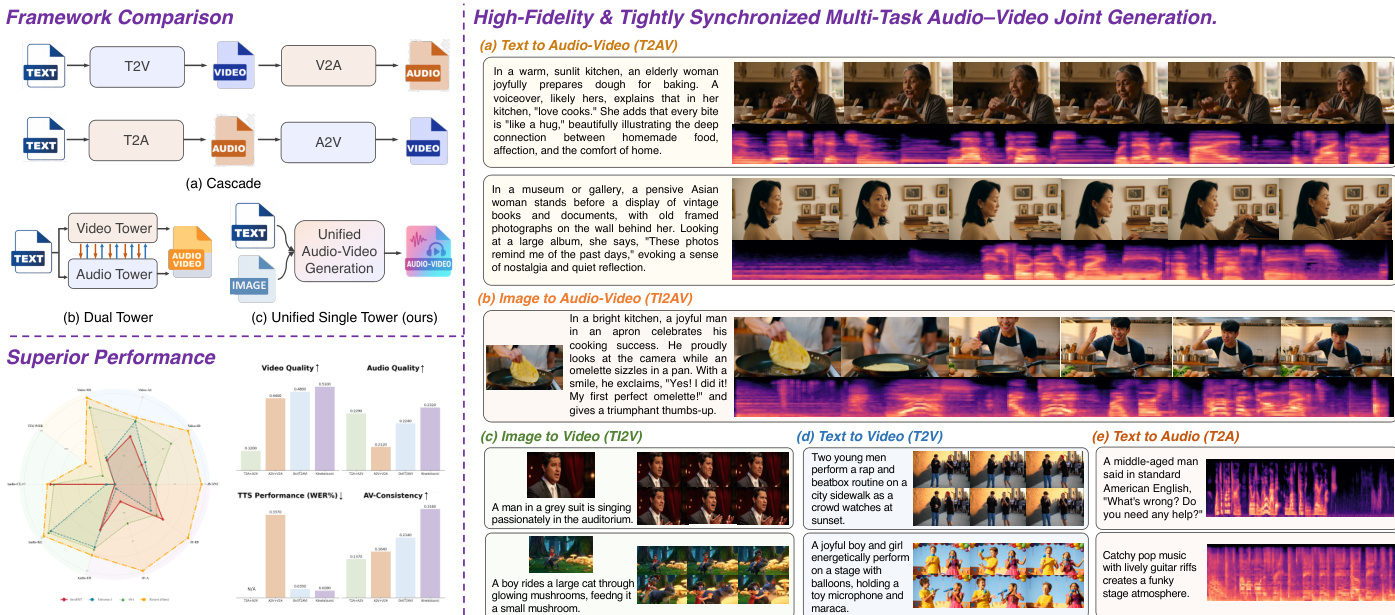

音频-视频联合生成技术已取得显著进展,但仍面临诸多挑战。当前非商业性方法普遍存在音视频不同步、唇动与语音对齐不佳以及单模态性能退化等问题,其根源在于音视频对应关系建模较弱、泛化能力有限,以及高质量密集标注数据稀缺。为解决上述问题,我们提出Klear,并从模型架构、训练策略与数据构建三个维度展开深入探索。在架构设计上,Klear采用单塔式结构,融合统一的DiT(Diffusion Transformer)模块与全范围注意力机制(Omni-Full Attention),实现了紧密的音视频对齐与强大的可扩展性。在训练策略方面,我们引入渐进式多任务学习范式:通过随机模态掩码促进跨任务联合优化,并采用多阶段课程学习,有效提升模型表征能力,强化音视频对齐的世界知识,同时避免单模态崩溃现象。在数据层面,我们构建了首个大规模带有密集标注的音视频数据集,并提出一种创新的自动化数据构建流水线,可高效标注并筛选出数百万条多样化、高质量且严格对齐的音视频-文本三元组数据。基于此,Klear能够有效扩展至大规模数据集,在联合生成与单模态生成场景下均实现高保真、语义与时间维度高度对齐的指令遵循生成能力,且在分布外(out-of-distribution)场景中展现出优异的泛化性能。在各类任务上,Klear显著超越以往方法,性能接近Veo 3水平,为下一代音视频合成技术提供了一条统一、可扩展的发展路径。

一句话总结

快手科技的作者提出 KLEAR,一种统一的单塔音视频生成框架,采用 Omni-Full Attention 与渐进式多任务训练,能够在联合与单模态任务中实现高保真、时序对齐且遵循指令的合成,性能媲美 Veo 3,同时通过大规模密集标注数据集与可扩展训练策略,克服了先前在音视频同步与单模态退化方面的局限。

主要贡献

-

我们提出 KLEAR,一种统一的多任务音视频生成框架,在联合与单模态设置下均能实现高保真、语义与时间对齐的输出,性能媲美 Veo 3,解决了音视频异步与唇语-语音错位等长期存在的问题。

-

该框架采用单塔架构,结合统一的 DiT 块与 Omni-Full Attention 机制,联合关注音频、视频及其对应字幕,实现深度跨模态融合与强对齐;同时采用带有随机模态掩码的渐进式多任务训练策略,防止单模态崩溃并提升泛化能力。

-

我们首次构建了一个大规模音视频数据集,包含 8100 万条高质量、严格对齐的三元组,通过自动化流水线生成,支持稳健训练,并在多个基准测试中展现出强大的分布外泛化能力。

引言

作者利用生成式 AI 的最新进展,应对音视频联合生成中的长期挑战,如音视频异步、唇语-语音对齐不佳以及单模态输出退化。以往工作受限于次优架构(如双塔设计与浅层融合)导致的弱跨模态交互、缺乏多样且高质量的训练数据,以及单任务训练范式带来的偏差与泛化障碍。为克服这些局限,作者提出 KLEAR,一种统一的多任务框架,采用单塔架构、统一的 DiT 块与 Omni-Full Attention 机制,联合建模音频、视频及其对应字幕,实现紧密的时空对齐。通过采用带有随机模态掩码的渐进式多任务训练策略与性能自适应课程,增强表征鲁棒性并防止单模态崩溃。此外,作者构建了一个大规模、高质量的 8100 万条密集标注音视频三元组数据集,通过自动化流水线生成。KLEAR 在联合与单模态任务中均达到最先进性能,质量媲美 Veo 3,同时展现出强大的分布外泛化能力。

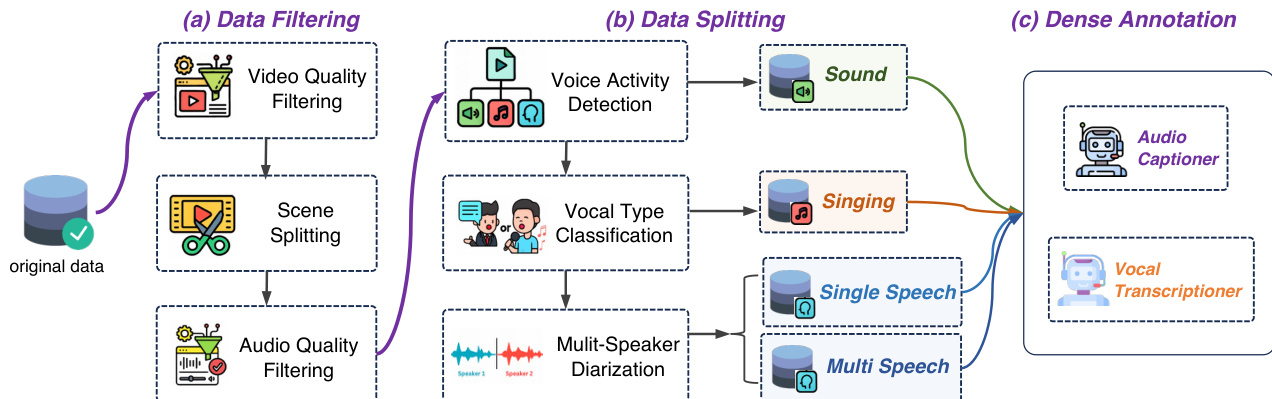

数据集

- 数据集由自动标注的音视频样本构成,包括单说话人语音、多说话人语音、演唱与自然声音片段,最终经过后处理过滤后的保留率为 27%。

- 视频过滤基于动态质量(运动比、相机稳定性)、静态质量(清晰度、美学、色彩饱和度)、内容自然性(无水印或过度特效)与安全性;低分辨率、低信噪比/ MOS、或静音时间超过 20% 的视频被剔除。场景分割确保每个样本仅包含一个连贯场景。

- 音频过滤剔除低信噪比、低 MOS、削波、失真或噪声样本,要求静音比例低于 20%,并确保高保真与格式一致。音视频对齐通过 Synchformer(时间)与 ImageBind(语义)验证,确保强同步性。

- 数据集按音频类型划分:语音与非语音。从语音子集中进一步创建三个独立划分——演唱、单说话人语音与多说话人语音,每类均进行密集标注。

- 每个划分使用专用模型进行标注:Whisper-Large-v3、SenseVoice 与 Qwen2.5-Omni 用于语音与演唱转录;Qwen2.5-Omni 与 Gemini 2.5-Pro 用于音频字幕;视频专家模型用于详细视频描述。语音内容的说话人属性(性别、年龄)被提取。

- 所有标注整合为统一的密集字幕,形成丰富标注数据集。

- 作者使用该数据集进行训练,将各划分以定制混合比例结合,平衡语音、演唱与声音类别的表征,确保模型训练输入的多样性和高质量。

方法

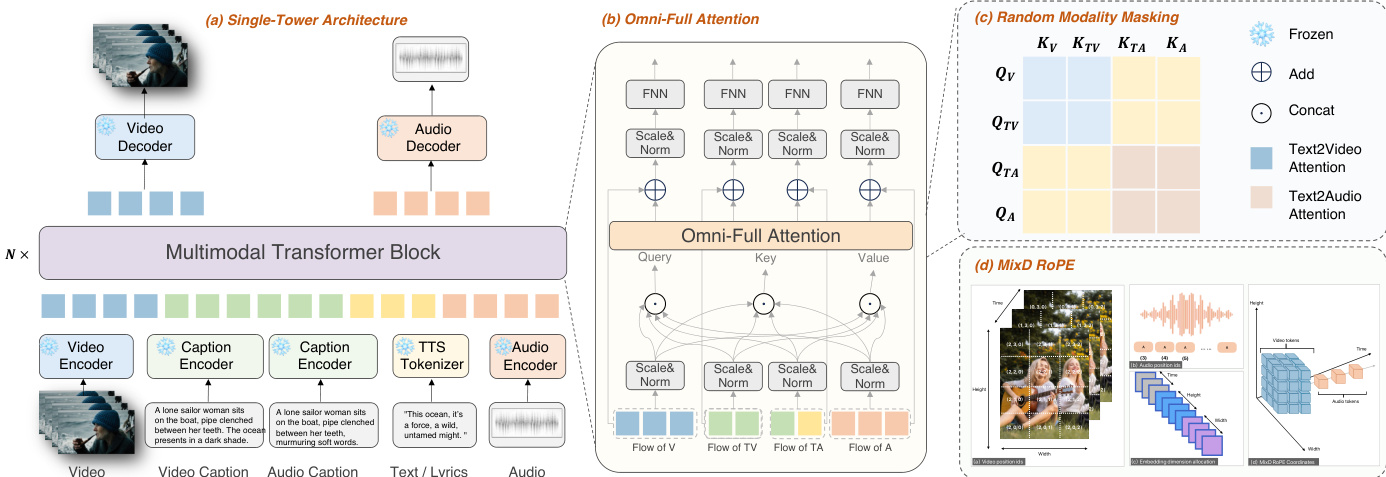

作者采用统一的单塔架构,实现联合音视频生成,克服级联与双塔方法的局限。该模型名为 KLEAR,以多模态扩散变换器(MM-DiT)为核心骨干,处理来自四个模态的输入:视频、视频相关文本、音频相关文本与音频。每个模态通过专用编码器分别编码为潜在表示——视频通过 3D 因果视觉编码器,文本与音频通过各自嵌入模型。这些编码序列随后输入 MM-DiT 模块,分别生成视频与音频的潜在变量。生成的潜在变量随后独立解码,生成最终的音视频输出。参见框架图以获取该过程的可视化概述。

MM-DiT 模块采用全注意力机制,促进全面的跨模态交互。具体而言,视频、视频相关文本、音频相关文本与音频的隐藏状态经过缩放、归一化并拼接,用于注意力计算。注意力机制为每个模态计算查询(Query)、键(Key)与值(Value)矩阵,随后合并形成注意力输出。表达式为 Q=QV⊙QVT⊙QAT⊙QA,K=KV⊙KVT⊙KAT⊙KA,V=VV⊙VVT⊙VAT⊙VA,其中 ⊙ 表示拼接。注意力输出计算为 Atn(Q,K,V)=Softmax(dkQK⊤)V。所得注意力值被重新拆分为各模态,经过缩放、归一化、残差连接与前馈处理后,传递至下一个 MM-DiT 模块。该方法确保所有模态在统一的全注意力框架中融合,实现有效整合。

为增强位置编码,模型引入混合维度旋转位置编码(MixD-RoPE)。对于视频,在时间、宽度与高度维度上应用 3D RoPE,捕捉绝对与相对位置依赖。对于音频,使用兼容的 1D 时间位置编码,位置 ID 通过递增视频模态的最大时间位置 ID 初始化。该设计确保视频与音频共享时间位置 ID,促进同步处理。模型采用流匹配目标进行训练,其中去噪网络 ϵθ(⋅) 学习预测将纯高斯噪声转换为数据分布的速度场。训练损失定义为 LFM=Et,c,x0,x1∥(x1−x0)−ϵθ(tx1+(1−t)x0,t,c)∥22,其中 t∼U(0,1),x0∼N(0,I),x1∼pdata。

实验

- KLEAR 通过多任务的全面实验验证其有效性,在音视频联合生成、单模态质量与跨模态一致性方面均达到最先进性能。

- 在 TI2AV、TI2V、T2V 与 T2A 任务中,KLEAR 超越任务专用基线,单模态质量比级联方法高出 34%,比联合基线高出 18%,并达到或超过专用模型水平。

- 定性结果表明,KLEAR 在唇形同步准确性、情感表达、演唱/说唱表现与音视频同步方面均表现卓越,实现音素级对齐与自然的语调融合,优于 Universe-1 与 Ovi。

- 消融实验确认,采用 Omni-Full Attention 的单塔架构优于双塔设计,即使在预训练塔存在分布差异的情况下,仍具备更优的跨模态对齐与鲁棒性。

- 多任务掩码提升跨模态相关性与泛化能力,使模型在下游任务(如 I2V 与 I2AV)中表现强劲。

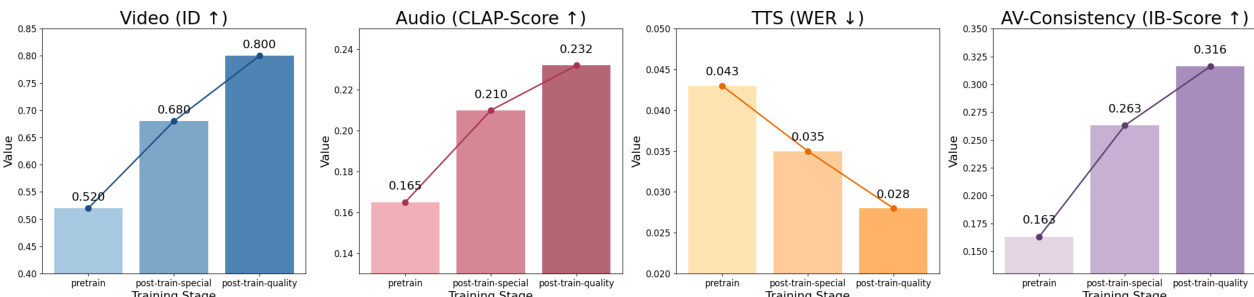

- 渐进式训练策略显著增强模型能力,高质数据后训练带来额外提升,移除训练调度则导致性能明显下降。

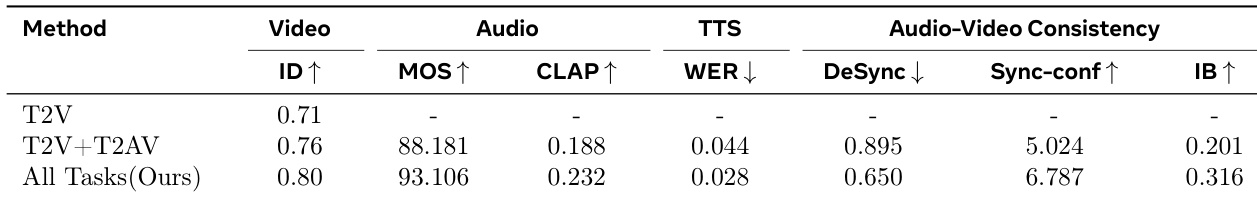

作者采用统一的单塔架构与 Omni-Full Attention,实现多个任务中音视频一致性与单模态性能的卓越表现。结果表明,其方法优于级联与联合基线,“All Tasks (Ours)” 方法在视频质量、音频质量与音视频同步方面均取得最高得分。

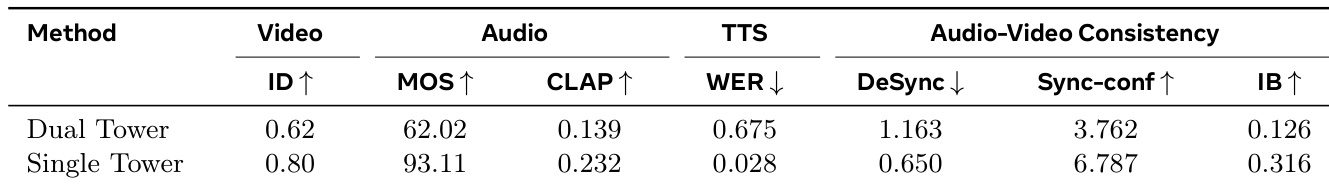

作者对比了音视频生成中的双塔与单塔架构,单塔模型在所有指标上均表现更优。结果表明,单塔方法在视频质量、音频质量与音视频一致性方面均优于双塔变体,证明了统一架构与 Omni-Full Attention 机制的有效性。

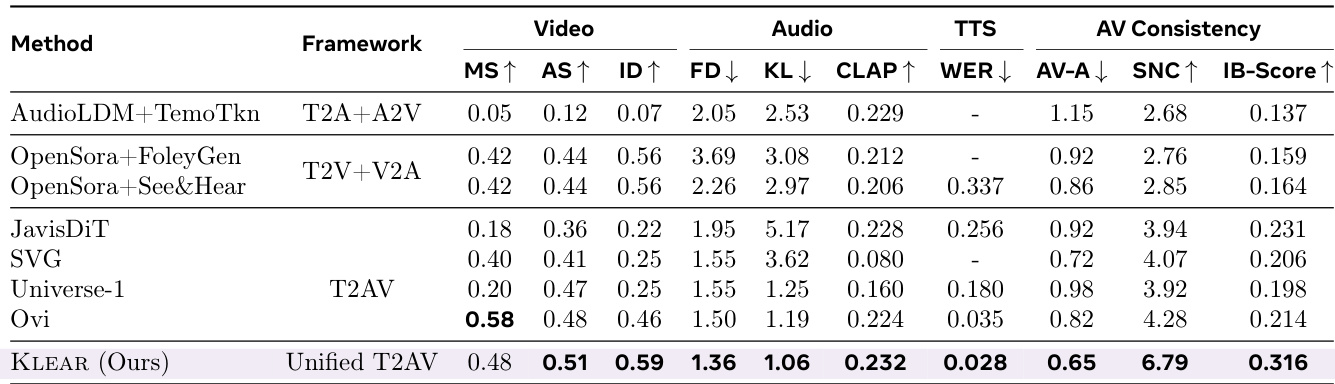

结果表明,KLEAR 在多个音视频生成任务中达到最先进性能,优于先前方法在视频质量、音频质量与音视频一致性方面的表现。统一的 T2AV 框架结合 Omni-Full Attention 实现了更优的跨模态对齐,体现在 MS、AS、ID 与 IB-Score 等指标上得分更高,优于级联与双塔基线。

作者利用提供的图表评估不同训练阶段对模型性能在多个指标上的影响。结果表明,后训练质量阶段在所有评估指标(视频身份、音频 CLAP 分数、TTS WER 与 AV 一致性)上均持续优于早期阶段,表明高质量数据与渐进式训练显著提升模型性能。