Command Palette

Search for a command to run...

NeoVerse:利用真实场景单目视频增强4D世界模型

NeoVerse:利用真实场景单目视频增强4D世界模型

Yuxue Yang Lue Fan Ziqi Shi Junran Peng Feng Wang Zhaoxiang Zhang

摘要

本文提出NeoVerse,一种通用的4D世界建模方法,具备4D重建、新轨迹视频生成以及丰富的下游应用能力。我们首先识别出当前4D世界建模方法在可扩展性方面存在一个共性瓶颈,其根源在于对昂贵且专用的多视角4D数据的依赖,或繁琐的训练前处理流程。相比之下,NeoVerse基于一种核心理念,使整个流程能够高效扩展至各类真实场景下的单目视频。具体而言,NeoVerse具备无姿态约束的前向4D重建、在线单目退化模式模拟以及其他高度对齐的技术设计。这些创新使NeoVerse在多个领域均展现出卓越的泛化能力与应用灵活性。同时,NeoVerse在标准的重建与生成基准测试中均达到了当前最优性能。项目主页详见:https://neoverse-4d.github.io

一句话总结

来自NLPR & MAIS、中科院自动化所和CreateAI的作者提出了NeoVerse,一种可扩展的4D世界模型,通过在线退化模拟实现从单目视频的无姿态、前馈式4D高斯点云重建,能够在多种真实场景下实现4D重建与新轨迹视频生成的最先进性能。

主要贡献

- NeoVerse通过支持从多样化的野外单目视频中进行前馈式、无姿态的4D重建,解决了现有4D世界模型的可扩展性限制,无需昂贵的多视角数据或繁琐的离线预处理。

- 该模型引入了基于高斯剔除和平均几何滤波的在线单目退化模拟,有效模拟了具有挑战性的渲染条件,增强了生成视频的鲁棒性与一致性。

- NeoVerse在4D重建与新轨迹视频生成基准测试中均达到最先进水平,展现出在多样化真实世界视频数据上的强大泛化能力。

引言

作者利用野外单目视频构建可扩展的4D世界模型,解决了现有方法依赖精心筛选的多视角数据或计算量巨大的离线重建所面临的重大局限。以往的4D建模工作通常依赖于难以获取的专用多视角动态视频,或需要深度估计和高斯场重建等大量预处理步骤,这些限制阻碍了模型的可扩展性与灵活性。这些约束使得真实场景中大量、多样且低成本的单目视频数据难以有效利用。为克服这一问题,作者提出NeoVerse,一种基于双向运动建模与稀疏关键帧处理的前馈式4D高斯点云(4DGS)框架,能够高效地从单目视频中实现在线重建。通过集成实时单目退化模拟(如高斯剔除与平均几何滤波),NeoVerse为生成模型创造了逼真的训练条件,支持在多达100万条未标注视频片段上进行端到端训练。该方法在4D重建与新视角视频生成任务中均达到最先进性能,同时支持视频编辑、稳定化与超分辨率等多种应用。

数据集

-

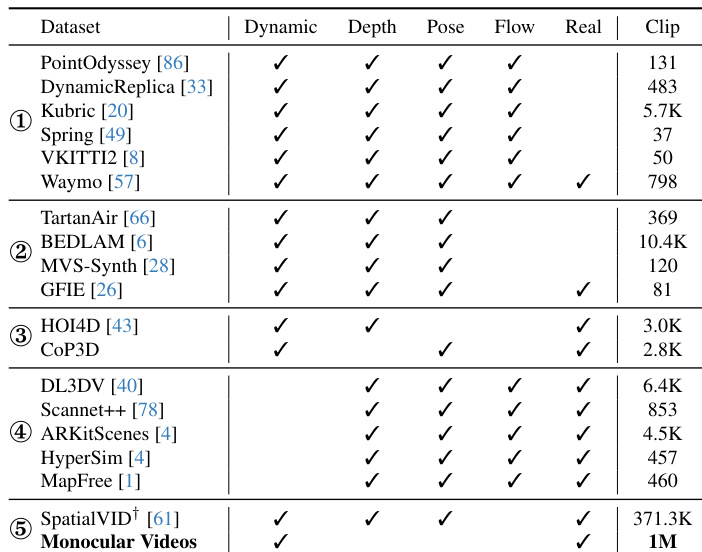

数据集分为五类用于训练:

- 包含3D光流的动态数据集,用于速度监督

- 包含深度与相机位姿的动态数据集

- 包含不完整3D信息的数据集(如仅含相机位姿或深度)

- 静态数据集,假设3D光流为零

- 单目视频,仅用于生成模型的训练

-

重建模型在类别①至④上进行训练,利用可用的3D光流、深度与位姿数据。

-

生成模型仅在类别⑤的单目视频数据上进行训练。

-

尽管SpatialVID提供3D信息,但因其深度质量不一致且不可靠,未用于重建训练。

-

未提及显式裁剪策略,但数据会根据任务需求进行处理,包括为运动与深度监督构建元数据。

-

训练采用这些子集的混合,比例由模型目标决定——重建侧重于3D一致的动态与静态场景,生成则聚焦于单目输入下的视觉真实性。

方法

作者基于VGGT主干网络构建前馈架构,实现从单目视频的无姿态4D重建。该过程始于使用预训练的DINOv2编码器提取逐帧特征,随后通过一系列交替注意力(Alternating-Attention)模块获得帧特征。为解决运动建模中的时序感知缺失问题,引入双向运动编码分支。该分支将帧特征拆分为前向与后向序列,利用交叉注意力机制生成前向运动特征 Ftfwd 与后向运动特征 Ftbwd。这些特征随后用于预测高斯基元的双向线性与角速度。4D高斯基元由3D位置、不透明度、旋转、尺度、球谐系数、生命周期以及前述的前向与后向速度参数化。3D位置由像素深度反投影得到,静态属性由帧特征预测,动态属性则由双向运动特征推导。

该框架在可扩展的流水线中集成重建与生成。为提升训练效率,作者提出仅从稀疏关键帧进行重建,而渲染时使用所有帧,得益于渲染过程的高效性。该方法通过双向运动建模实现非关键帧的高斯场插值。对于非关键帧查询时间戳 tq,高斯基元 i 在关键帧时间戳 t 的位置根据前向或后向速度进行线性插值,具体取决于 tq 是否大于 t。旋转通过角速度的四元数转换进行插值,不透明度则根据归一化时间距离与高斯生命周期衰减。为模拟生成模型训练中的退化模式,作者采用三种技术:基于可见性的高斯剔除以模拟遮挡,平均几何滤波以生成飞边像素效应,以及控制分支将退化渲染与相机运动信息作为条件输入。生成模型采用去噪扩散过程进行训练,其中退化渲染作为条件,原始视频帧作为目标。

训练方案分为两个阶段。重建模型采用多任务损失,包含光度、相机、深度、运动与正则化分量。生成模型采用Rectified Flow与Wan-T2V训练,训练目标为扩散过程中预测速度与真实速度之间的均方误差。推理阶段,模型首先从输入视频重建4DGS与相机参数。为提升表示能力,对帧间高斯进行聚合,采用全局运动追踪机制根据可见性加权的最大速度幅值分离静态与动态部分。静态与动态部分采用不同的时间聚合策略。最终,生成的高斯被渲染为新轨迹,退化渲染作为条件输入生成模型,以输出最终的新视频。

实验

- 重建与生成实验验证了NeoVerse在静态与动态3D视频重建中的有效性,在多个基准测试中达到最先进性能。在静态重建基准上,NeoVerse在所有指标上均优于现有方法,显著超越MoVieS与StreamSplat(因未开源未纳入比较)。在动态重建中,NeoVerse优于竞争对手,包括TrajectoryCrafter与ReCamMaster,尤其在处理复杂运动与保持几何保真度方面表现突出。

- 在新视角生成方面,NeoVerse在VBench上取得优异结果,涵盖400个来自多样化野外视频的测试案例,展现出高质量渲染与精确轨迹可控性。模型在保持强性能的同时实现高效推理,得益于知识蒸馏与双向运动设计的加速。

- 定性评估显示,与基线相比,NeoVerse生成的图像更准确,伪影(如鬼影与模糊)更少。其通过退化模拟有效抑制伪影,并在未观测区域(如被遮挡的人或物体)实现语境合理的想象。

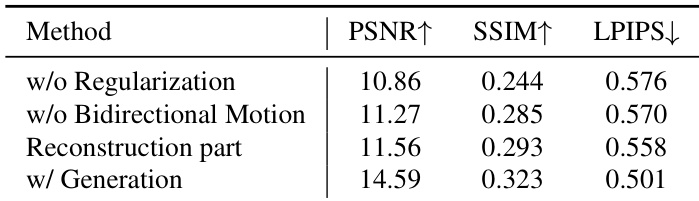

- 消融实验确认了运动建模、不透明度正则化、退化模拟与全局运动追踪的重要性。移除任一组件均导致性能下降,尤其在伪影抑制与轨迹准确性方面。

- 该模型支持多种下游应用:通过3D光流关联实现3D跟踪,利用二值与文本条件进行视频编辑,通过轨迹平滑实现视频稳定化,以及通过灵活渲染分辨率实现视频超分辨率。还可实现图像到世界与单视角到多视角生成。

- 在自收集的100万单目视频数据集与18个公开数据集上,NeoVerse展现出对多样化真实场景的可扩展性与鲁棒性,训练在32块A800 GPU上采用两阶段流水线(150K + 50K次迭代)完成。

作者使用表格总结其研究中所用数据集,按数据特征与在重建与生成任务中的角色分为五类。表格显示数据集用于静态与动态重建,部分同时支持生成,突出数据的规模与多样性,包括从互联网收集的超过100万条单目视频。

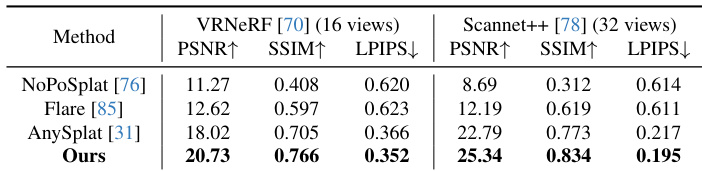

结果表明,所提方法在静态重建基准上达到最先进性能,优于现有方法,PSNR、SSIM与LPIPS指标在VRNeRF与Scannet++数据集上均表现优异。作者使用多任务损失与余弦学习率调度的重建模型,相比NoPoSplat、Flare与AnySplat取得更优结果。

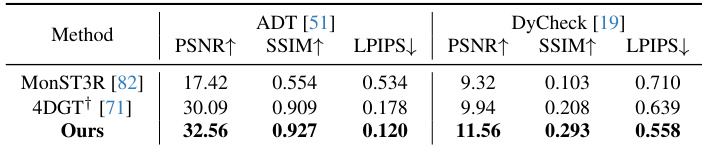

结果表明,所提方法在ADT与DyCheck基准上均优于现有方法。在ADT上,其PSNR与SSIM优于MonST3R与4DGT,LPIPS显著提升;在DyCheck上,其PSNR与SSIM达到最高,LPIPS最低,表明重建质量更高且伪影更少。

作者通过消融实验评估管道中不同组件的影响。结果表明,引入生成模块显著提升所有指标,完整模型在PSNR与SSIM上最高,LPIPS最低,优于仅重建版本。双向运动与正则化进一步提升重建质量,证明其在整体框架中的重要性。

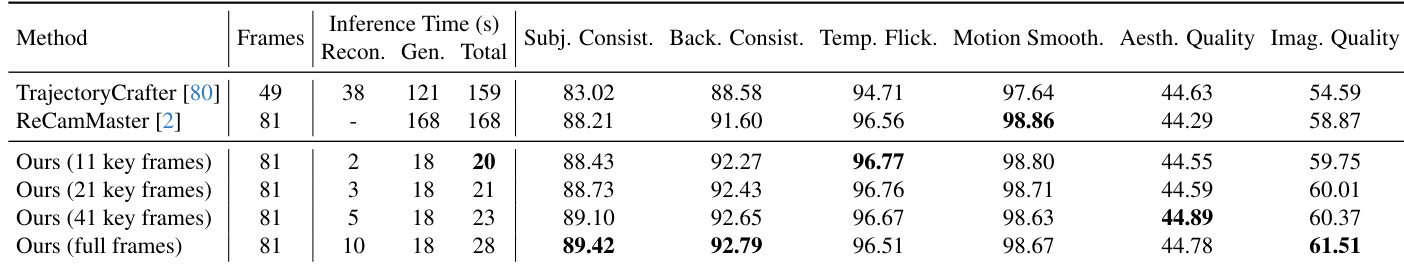

结果表明,所提方法在重建与生成任务上均优于TrajectoryCrafter与ReCamMaster。作者通过减少关键帧数量显著加速推理时间,同时保持高质量生成,全帧版本在多数指标上表现最佳。