Command Palette

Search for a command to run...

mHC:流形约束超连接

mHC:流形约束超连接

摘要

近期,以超连接(Hyper-Connections, HC)为代表的研究工作,在过去十年间广泛采用的残差连接范式基础上,通过扩展残差流的宽度并多样化连接模式,实现了进一步发展。尽管此类方法带来了显著的性能提升,但连接模式的多样化从根本上破坏了残差连接固有的恒等映射特性,导致训练过程严重不稳定、可扩展性受限,并引入了显著的内存访问开销。为应对上述挑战,本文提出流形约束超连接(Manifold-Constrained Hyper-Connections, mHC),这是一种通用框架,通过将HC的残差连接空间投影至特定流形,恢复其恒等映射性质,同时结合严格的基础设施优化,保障计算效率。实验结果表明,mHC在大规模训练中表现优异,不仅带来切实的性能提升,还展现出卓越的可扩展性。我们预期,作为HC的一种灵活且实用的扩展,mHC将有助于深化对拓扑结构设计的理解,并为基础模型的演进提供富有前景的新方向。

一句话总结

DeepSeek-AI 的作者提出 mHC,一种流形约束框架,通过将残差矩阵投影到几何流形上,恢复超连接(Hyper-Connections)中的恒等映射,从而在保持先前超连接设计灵活性与性能优势的同时,实现稳定、可扩展的训练,并显著降低内存开销。

主要贡献

- 本文解决了超连接(HC)的不稳定性与可扩展性限制问题,HC 通过扩展残差流宽度和连接模式来提升模型表达能力,但破坏了深度网络中稳定训练所必需的恒等映射性质。

- 提出流形约束超连接(mHC),通过 Sinkhorn-Knopp 算法将残差连接矩阵投影到双随机流形上,恢复恒等映射,实现稳定的大规模训练。

- 实验评估表明,mHC 在可扩展性和性能上均优于 HC,且由于采用了核融合、重计算和通信重叠等基础设施优化,计算开销几乎可忽略。

引言

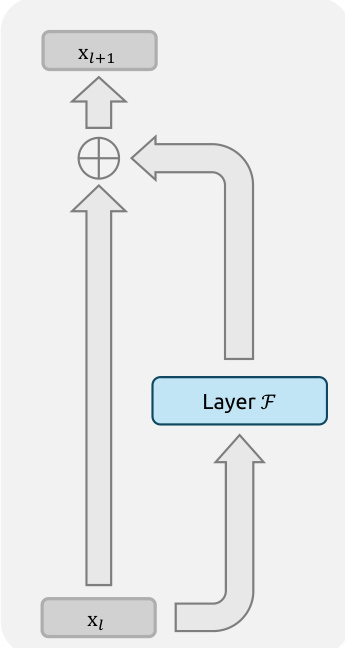

作者利用近期宏观架构设计的进展——特别是超连接(HC),其通过扩展残差流宽度并多样化层间连接模式,提升大语言模型的表达能力和性能。然而,先前的 HC 方法因恒等映射性质的丧失而面临训练不稳定和可扩展性差的问题,这破坏了跨层信号守恒,同时因特征表示的扩展导致高昂的内存访问开销。为解决这些问题,作者提出流形约束超连接(mHC),通过 Sinkhorn-Knopp 算法将残差连接矩阵投影到双随机流形上,恢复恒等映射并稳定信号传播。该几何约束确保基于凸组合的特征流动,支持鲁棒的大规模训练。此外,mHC 集成了多项基础设施优化措施——包括核融合、重计算和 DualPipe 中的通信重叠,以最小化计算开销。最终结果是,一种可扩展、稳定且高效的 HC 扩展方案,在保留性能优势的同时,支持更深更宽的模型架构。

数据集

- 数据集包含用于训练 DeepSeek-V3 模型 3B、9B 和 27B 版本的多个文本来源,数据来自多样化的公开与精选语料库。

- 训练数据被划分为多个子集,每个子集具有特定的大小、来源和过滤规则:高质量网络文本、代码仓库、学术论文以及多语言内容,所有数据均经过处理以去除低质量或重复样本。

- 作者采用混合专家(MoE)训练策略并结合动态路由机制,根据输入内容将数据分发至不同专家,模型通过加权混合这些子集进行训练,权重经过精细调优以平衡覆盖范围与质量。

- 数据预处理包括使用 128K 词汇表进行分词,对序列长度进行过滤以限制在 32K 标记以内,并采用裁剪策略从长文档中采样固定长度片段,以确保训练期间输入尺寸一致。

- 预处理阶段构建了源类型、语言和内容类别等元数据,以支持训练过程中的动态采样与课程学习。

方法

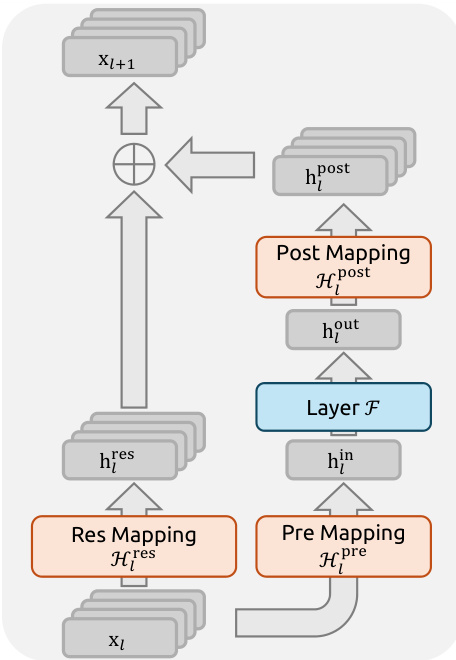

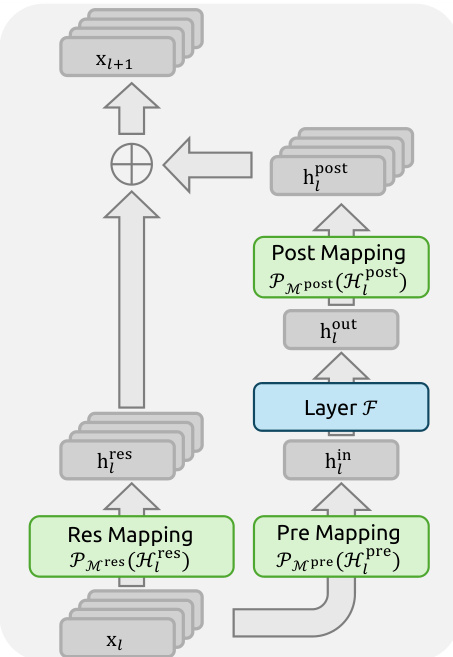

作者提出一种新颖框架——流形约束超连接(mHC),以解决超连接(HC)架构在大规模深度学习模型中面临的稳定性与可扩展性限制。mHC 的核心是一种受约束的残差连接机制,通过将残差映射投影到特定流形上,以保持恒等映射性质,这对多层间稳定信号传播至关重要。整体框架在标准残差块基础上引入多流残差设计,将输入特征向量 xl 扩展为 n×C 矩阵,形成 n 条并行残差流。该扩展增强了残差路径内的信息交换。mHC 中单层的传播定义为 xl+1=Hlresxl+Hlpost⊤F(Hlprexl,Wl),其中 F 为基函数(如前馈网络),Hlpre、Hlpost 和 Hlres 为可学习的线性映射,用于处理 nC 维残差流与 C 维层输入/输出之间的维度不匹配。关键创新在于对残差映射 Hlres 施加约束。该映射不再无约束,而是被投影到双随机矩阵流形(即 Birkhoff 多面体)上。该投影确保矩阵元素非负,且其行和与列和均等于 1。这一约束至关重要,因为它保证了操作 Hlresxl 作为输入特征的凸组合,从而守恒特征的全局均值,防止深层网络传播过程中信号的无界放大或衰减。作者进一步对输入与输出映射 Hlpre 和 Hlpost 施加非负性约束,以避免信号抵消。

mHC 映射的参数化设计兼顾高效性与可微性。可学习参数通过输入隐藏矩阵 xl 经由动态与静态映射组合生成。动态映射通过参数为 φl 的线性投影计算,静态映射则由可学习偏置 bl 表示。最终的约束映射通过对未投影参数应用特定函数获得。输入与输出映射 Hlpre 和 Hlpost 通过 Sigmoid 函数约束为非负。残差映射 Hlres 通过 Sinkhorn-Knopp 算法投影到双随机流形。该算法通过迭代归一化正矩阵的行与列使其和为 1,收敛至双随机矩阵。作者将此投影实现为自定义核,执行迭代归一化过程。

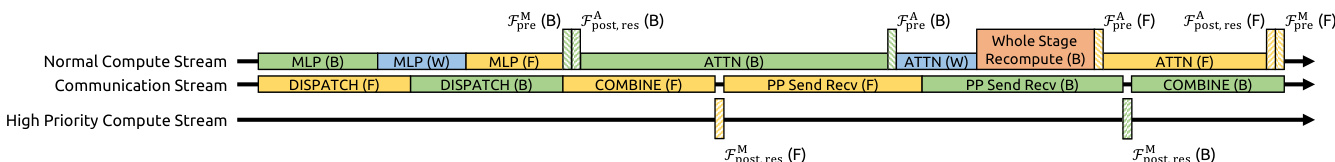

为确保实际可扩展性,mHC 集成了系列基础设施优化。作者采用核融合以减少内存带宽瓶颈并提升计算效率。将具有共享内存访问的多个操作融合为统一计算核,例如合并对输入向量 xl 的两次扫描以及反向传播中的两次矩阵乘法。同时,实现专用核用于 Sinkhorn-Knopp 迭代,并开发自定义反向核在芯片上重计算中间结果。为缓解 n 流残差设计带来的显著内存开销,作者采用选择性重计算策略。在前向传播后丢弃中间激活值,并在反向传播中按需重计算。该策略应用于连续 Lr 层的块,最优块大小通过最小化总内存占用确定。此外,为应对大规模训练中的通信延迟,作者扩展了 DualPipe 调度策略。将 mHC 的 MLP 层核在专用高优先级计算流上执行,以避免阻塞通信流。该设计支持抢占式重叠注意力计算,实现灵活调度,从而提升计算资源利用率。

mHC 的通信-计算重叠在 DualPipe 调度中得以体现。该调度设计用于应对 mHC 引入的开销,特别是流水线阶段间的通信延迟以及重计算的计算开销。图中展示了正常计算流、通信流与高优先级计算流的时间线。高优先级流用于执行 MLP 层的 mHC 核,确保其不阻塞通信流。重计算过程与流水线通信依赖解耦,因为每个阶段的初始激活已本地缓存。这使得在流水线阶段边界上实现更优的通信与计算重叠。

实验

- 数值不稳定性实验:HC 因无界复合残差映射导致信号爆炸,Amax 增益幅度峰值达 3000,引发 27B 模型的损失突增与梯度不稳定。

- 系统开销实验:HC 引入显著的内存 I/O 与通信开销,开销随 n 增长而增加,降低训练吞吐量,需依赖梯度检查点。

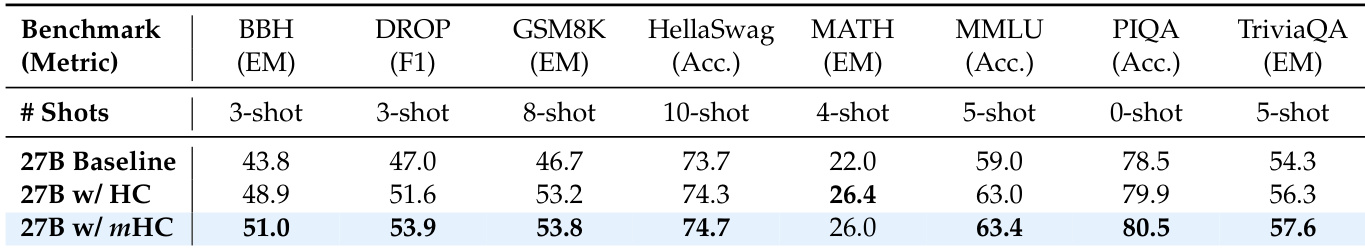

- 主要结果:在 27B 模型上,mHC 的最终损失比基线低 0.021,梯度稳定,下游性能更优,在 8 个基准测试中均优于基线与 HC,包括 BBH 提升 2.1% 和 DROP 提升 2.3%。

- 扩展性实验:mHC 在计算量与 token 扩展下保持一致性能增益,从 3B 到 27B 模型均有稳健提升,且运行内动态稳定。

- 稳定性分析:mHC 将最大 Amax 增益幅度从 HC 的 ~3000 降至 ~1.6,确保信号传播有界,正向与反向流稳定,经可视化映射验证。

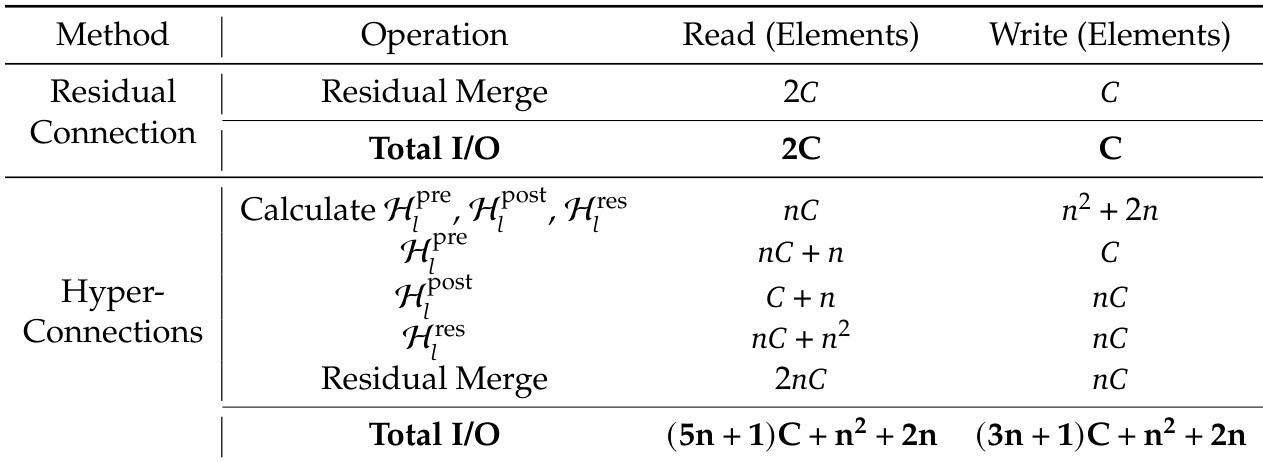

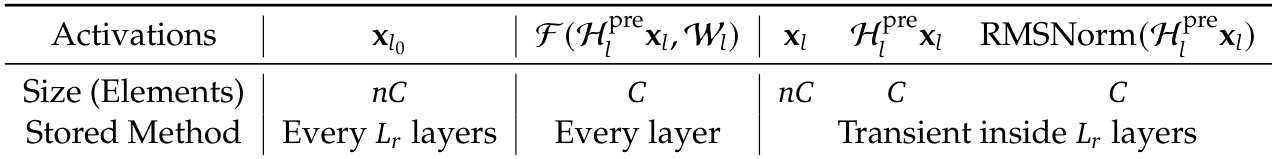

作者使用表格详细说明了超连接(HC)机制在预归一化 Transformer 架构中的内存访问模式与存储需求。结果显示,HC 的内存访问成本随残差流数量成比例增加,预激活输入的激活值每 Lr 层存储一次,后激活输入的激活值在 Lr 层内暂存,导致更高的 I/O 需求与内存占用。

作者使用 27B 模型在八个下游基准测试中对比 HC 与 mHC 相对于基线的性能。结果表明,mHC 在大多数任务上持续优于基线与 HC,包括在 BBH 上提升 2.1% 和在 DROP 上提升 2.3%。

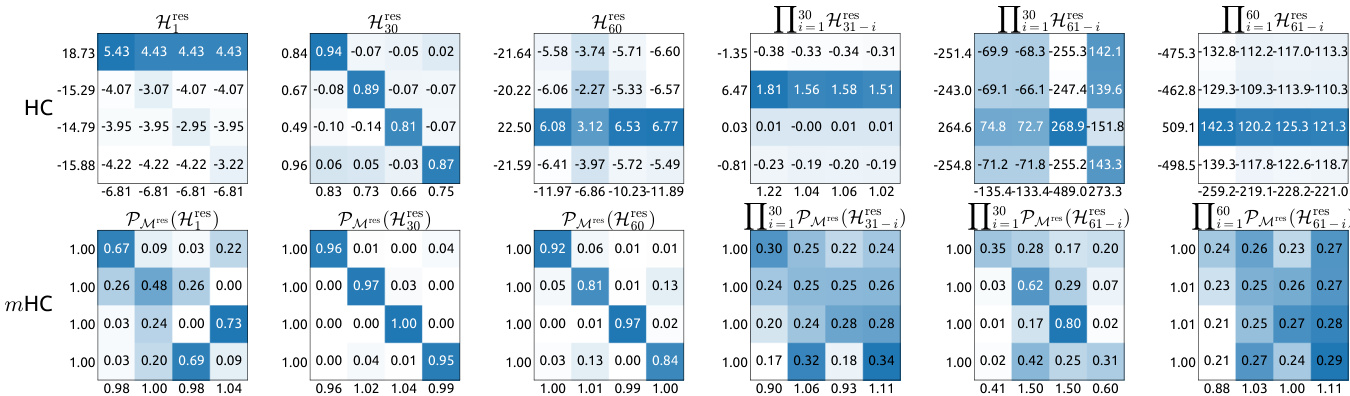

作者使用表格比较 HC 与 mHC 的传播稳定性,分析其各自残差映射的增益幅度。结果显示,HC 表现出极端信号放大,复合映射增益高达 3000,表明严重不稳定性。相比之下,mHC 保持增益有界,最大值约为 1.6,表明在正向与反向信号传播中均显著提升稳定性。

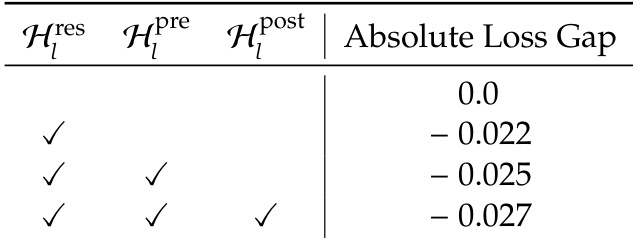

作者使用表格比较不同残差映射组件对训练稳定性的影响,显示在残差映射基础上增加预归一化与后归一化映射可减小绝对损失差距。结果显示,三者映射组合的损失差距最低,为 -0.027,表明相比组件更少的配置,稳定性显著提升。

作者使用表格量化超连接(HC)相比标准残差连接引入的内存访问开销。结果显示,HC 显著增加读写操作,总 I/O 随扩展率 n 呈二次方增长,导致系统级开销大幅上升。这一增加的 I/O 成本,尤其是写操作的二次增长,加剧了训练吞吐量下降与内存使用增加,凸显了 HC 在大规模模型中的关键局限性。