Command Palette

Search for a command to run...

Youtu-LLM:释放轻量级大语言模型的原生智能体潜力

Youtu-LLM:释放轻量级大语言模型的原生智能体潜力

摘要

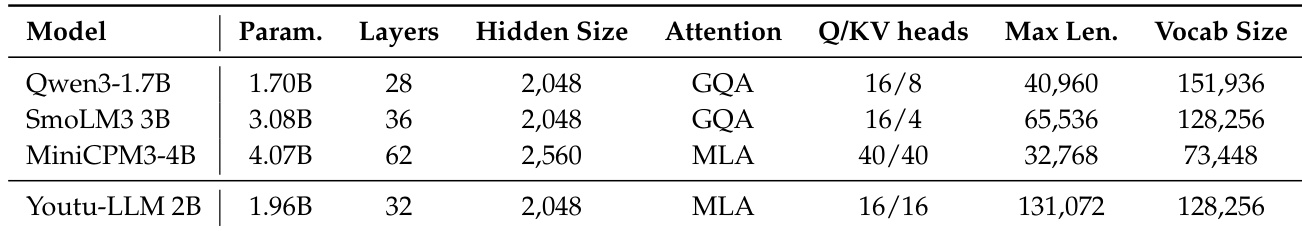

我们提出 Youtu-LLM,这是一个轻量级但功能强大的语言模型,能够在保持高计算效率的同时,原生具备智能体(agentic)能力。与依赖知识蒸馏的典型小型模型不同,Youtu-LLM(19.6亿参数)从零开始进行预训练,系统性地培养其推理与规划能力。其核心技术突破如下:(1)紧凑架构与长上下文支持:基于一种密集型多隐式注意力(Multi-Latent Attention, MLA)架构,并引入面向科学、技术、工程与数学(STEM)领域的新型词汇表,Youtu-LLM 支持高达 128K 的上下文窗口。该设计在极小的内存开销下,实现了强大的长上下文推理能力与状态追踪能力,特别适用于长周期智能体任务与复杂推理场景。(2)基于“常识-STEM-智能体”递进式训练课程:我们构建了一个约 11 万亿 token 的大规模语料库,并实施多阶段训练策略。通过逐步将预训练数据分布从通用常识任务,过渡到复杂的 STEM 问题与智能体任务,确保模型获得深层次的认知能力,而非表面化的对齐表现。(3)可扩展的智能体中段训练机制:针对智能体能力的中段训练,我们采用多样化的数据构建方法,在数学、编程与工具使用等多个领域合成丰富且多样的任务轨迹。高质量的训练数据使模型能够有效内化规划与反思等关键行为模式。大量实验证明,Youtu-LLM 在参数量低于 20 亿的语言模型中达到了新的最先进水平。在通用基准测试中,其性能可与更大模型相媲美;而在智能体专项任务中,显著超越现有最先进基线。这充分表明,轻量级模型同样可以具备强大的内在智能体能力。

一句话总结

作者提出 Youtu-LLM,一个由 Youtu-LLM 团队开发的 19.6 亿参数轻量级语言模型,通过从零开始采用“常识-STEM-代理”原则性课程进行预训练,实现了子 20 亿参数模型中的最先进性能。该模型融合了紧凑的多潜空间注意力架构、面向 STEM 的分词器以及可扩展的流水线,用于在数学、编程、深度研究和工具使用等领域生成高质量的代理轨迹数据。这使得模型能够内化原生的规划、反思和行动能力,在代理基准测试中显著超越更大模型,同时保持强大的通用推理和长上下文能力。

主要贡献

-

我们提出 Youtu-LLM,一个 20 亿参数的轻量级开源语言模型,在代理基准测试中达到最先进水平,超越更大模型,证明了紧凑型大语言模型可以具备强大的原生代理能力。

-

我们提出一种新颖的代理式预训练范式,聚焦于结构化推理轨迹,采用优化的代理式 CoT 框架,将推理分解为分析、规划、行动、反思和总结等独立阶段,系统性地培养规划、工具使用和自我修正能力。

-

我们开发了可扩展的数据构建框架,在编程、数学和研究等领域生成超过 2000 亿 token 的高质量代理轨迹数据,为早期、面向代理的预训练能够实现小模型代理能力的可扩展增长提供了实证支持。

引言

作者利用现实世界代理应用(如编程、深度研究和工具增强工作流)中对轻量但高效语言模型日益增长的需求,这些场景对计算效率和低延迟要求极高。以往小模型的研究主要依赖于蒸馏或指令微调等后训练技术,这些方法仅对输出行为进行对齐,而未系统性地培养规划、反思和结构化推理等核心认知能力。这导致模型缺乏鲁棒性、泛化能力和真正的代理能力。为解决此问题,作者提出 Youtu-LLM,一个 20 亿参数的开源模型,通过在预训练阶段直接嵌入面向代理的信号,在通用和代理基准测试中均达到最先进水平。其核心贡献是一个原则性的代理预训练框架,整合了可扩展的数据构建流程,用于生成涵盖推理、数学、深度研究和工具使用等领域的高质量轨迹数据,使模型在无需后处理增强的情况下具备原生代理能力。

数据集

-

Youtu-LLM 预训练所用数据集由两个主要部分组成:通用预训练数据(占语料库的 95% 以上)和代理轨迹数据,前者强调广泛的质量与结构控制,后者聚焦于高质量、可验证的代理执行序列。

-

通用预训练数据起始于超过 10 万亿原始 token,主要来自多样化来源,以英文为主,辅以中文。经过去重、过滤和去污染处理后,剩余 8.7 万亿 token。通过针对性地对高质量 STEM 和代码内容进行上采样,扩展至 10.64 万亿 token,其中包括 7000 亿 token 的 STEM 语料、14000 亿 token 的代码数据,以及 5000 亿合成材料(如解释、摘要和代码文档)。

-

语料库采用多阶段过滤流程:数据按 11 个领域类别(46 个子领域)分类,并依据 10 项质量标准进行评估。半自动化流水线使用 Deepseek-R1 进行初步标注,经人工审核验证,一致性超过 95%。最终基于 Qwen3-1.7B 的质量模型在领域和质量评分上达到超过 95% 的准确率,可筛选出平均得分高于 8.5 的数据。

-

去重采用 MinHash-LSH 方法,按长度分桶处理,并辅以启发式规则,如 13-gram 检测、毒性评分和代码关键词过滤。使用 Aho-Corasick 算法对 STEM 和代码语料进行去污染,防止测试集泄露。

-

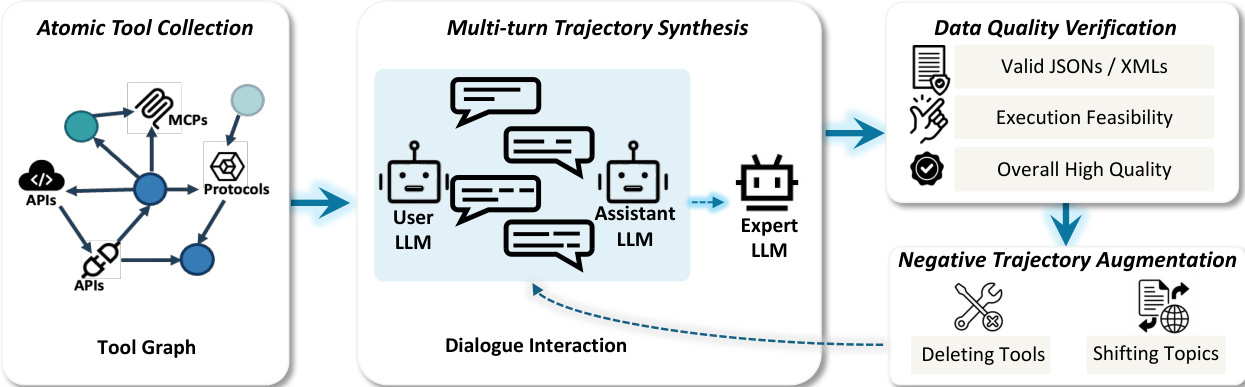

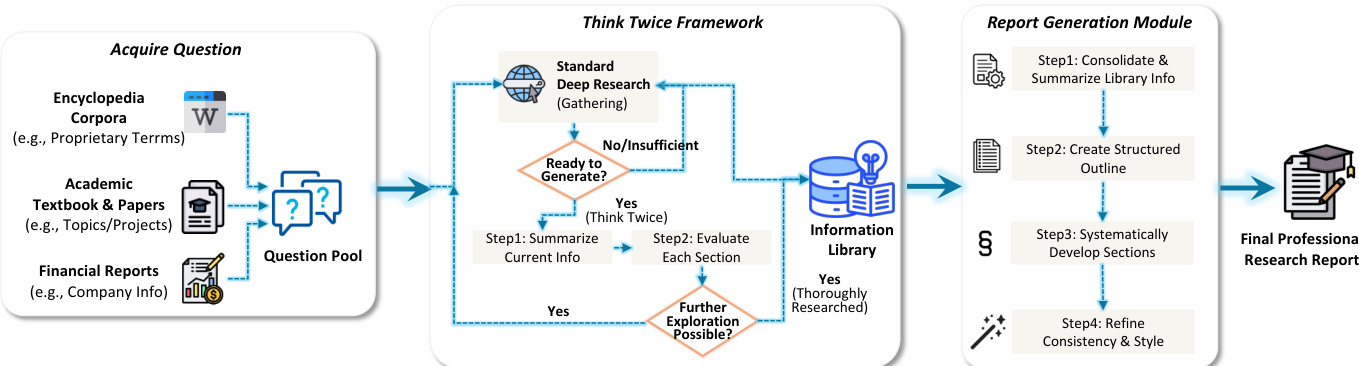

代理轨迹数据总计 2000 亿 token,具体分布为:250 亿代理式 CoT 轨迹、200 亿数学轨迹、700 亿代码执行轨迹、600 亿深度研究轨迹,以及 250 亿其他轨迹(如工具使用、函数调用、规划等)。

-

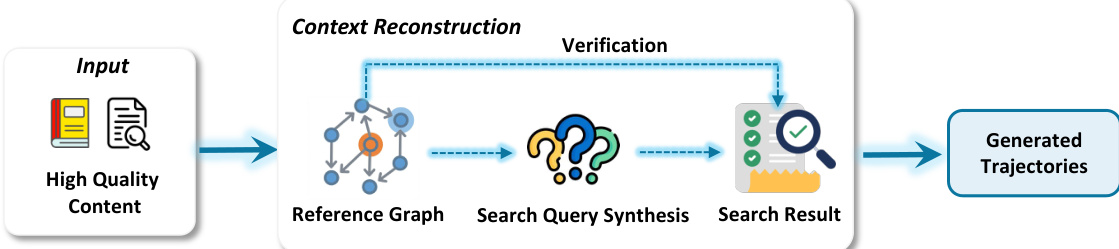

代码轨迹数据分为两部分:原子代码能力(如主动探索、上下文感知生成、补丁编辑、测试、环境理解、自我反思)和端到端代理轨迹。后者通过三种策略进行扩展:(1)使用 SWE-gym、SWE-smith 和 SWE-rebench 构建多样化的任务环境,并引入合成实例;(2)在无可执行镜像的仓库上进行可扩展的静态评估任务;(3)在关键操作(编辑和测试)处进行轨迹分支,成功路径扩展,失败路径在首次分支后截断,以防止错误传播。

-

轨迹合成流水线采用分支策略,在成功的关键步骤生成变体,在首次失败点仅保留单一分支,随后进行评估以确保有效性并防止过拟合。

-

指令微调数据来自 10 个类别:数学、代码、科学推理、代理工作流、通用知识问答、指令遵循、角色扮演、创意写作、多轮对话和安全对齐。高质量推理答案通过先进大模型构建,对开放式查询生成完整 CoT 推理,或对已有答案重构逻辑路径。

-

多阶段清洗流水线通过启发式过滤(如截断、重复、混合语言)移除低质量样本,并使用教师模型对逻辑连贯性、流畅性和事实准确性进行评分。去污染通过 32-gram 精确匹配实现,消除与评估基准的重叠。

-

任务特定验证包括:数学数据使用结构化输出格式(如 \boxed{} 表示法),并通过嵌入相似性去重;代码数据通过执行环境和输入/输出映射验证;复杂指令使用评分标准和 LLM 作为裁判进行评分;安全数据包含对抗性红队测试和信息性拒绝训练。

-

全局验证策略包括:保留思维格式标记(如 , , , ),通过预标注目标强制语言一致性,使用基于置信度的 n-gram 频率度量检测重复,以惩罚循环输出并促进多样性。

方法

作者采用多阶段训练框架开发 Youtu-LLM,一个 19.6 亿参数的语言模型,旨在实现强大代理能力的同时保持高计算效率。整体架构基于密集型多潜空间注意力(MLA)设计,专为设备端部署和长上下文推理优化。该框架辅以定制的面向 STEM 的分词器和从通用常识逐步过渡到复杂 STEM 与代理任务的原则性课程。

模型核心架构基于密集型多潜空间注意力(MLA)机制,旨在增强注意力层的表达能力,同时不增加模型参数量。这通过低秩压缩键值(KV)缓存和使用更大的中间投影矩阵实现。MLA 配置与 DeepSeek-V3 一致,KV LoRA 秩维度为 512,Q LoRA 秩维度为 1536,QK nope 头维度为 128,QK RoPE 头维度为 64,V 头维度为 128。该设计使 Youtu-LLM 在长上下文场景下相比标准 GQA 实现更优的推理性能。模型总参数量为 19.6 亿,词汇表大小为 128,256,与 Llama3 系列一致。架构进一步优化以支持长上下文推理,支持 128k 上下文窗口,从而实现稳健的状态追踪和长周期规划。

分词器设计是 Youtu-LLM 性能的关键组件,采用多阶段训练策略,以在通用语言能力与领域特定推理能力之间取得平衡。分词器为字节级 BPE(BBPE)分词器,使用修改后的 HuggingFace Tokenizers 流水线训练。其预分词方案更严格,将中文字符、日文假名、韩文字母和 CJK 标点符号分割为独立单元,防止其与其他文本合并。英文预分词遵循 GPT-4o 的设计,允许特定标点和大小写模式后接小写序列。数值分词仅保留 10 个原子数字 token(0–9),避免多数字 token。基础词汇表源自 o200k 词汇表,移除中文 token 和无效 token,得到 10 万 token 基础。随后扩展中文专用 token,并进一步加入代码和数学/技术内容专用 token,最终词汇表大小为 128,256。该多阶段方法确保分词器在通用和推理导向数据上均得到优化,在通用数据上实现 5% 的分词效率提升,在推理数据上最高达 10%。

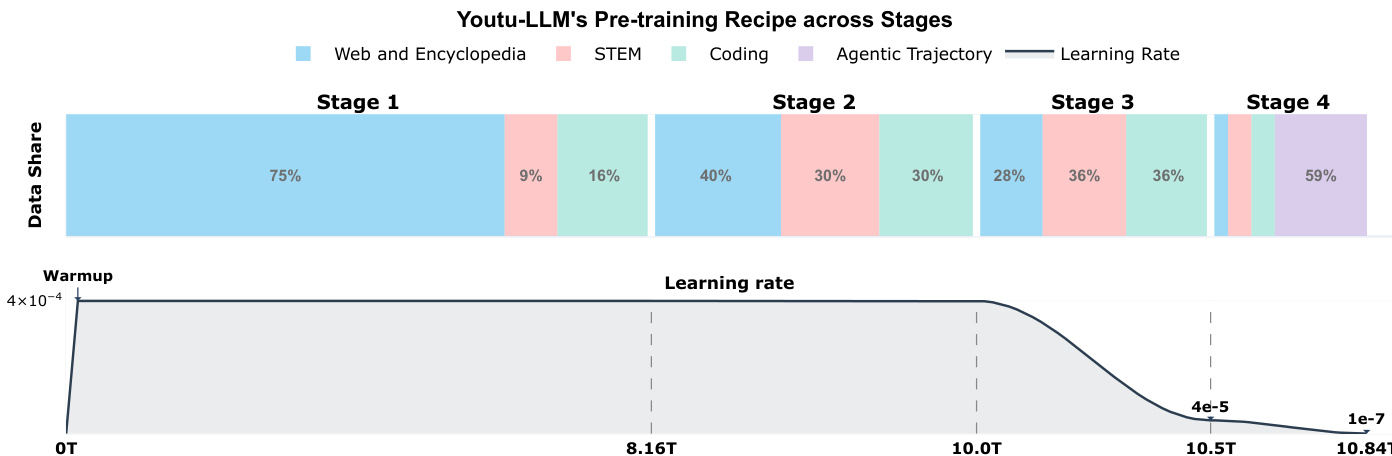

Youtu-LLM 的预训练遵循多阶段课程,逐步将数据分布从通用常识过渡到复杂 STEM 和代理任务。这一原则性方法确保模型获得深层认知能力,而非表面对齐。训练语料约 11 万亿 token,模型从零开始预训练,系统性地培养推理与规划能力。训练过程旨在先“冷启动”模型的推理引擎,再精炼其通用适应性。这通过两阶段监督微调(SFT)策略实现。第一阶段,模型在逻辑密集型数据集上微调,该数据集由数学(40%)、编程代码(30%)、科学推理(20%)和代理任务(10%)组成,强制模型学习逐步演绎和结构化响应能力。第二阶段,训练语料扩展至涵盖多样化的通用用户指令,同时整合第一阶段子集以缓解灾难性遗忘。此阶段还引入双模式能力,通过特定控制 token 条件,使模型可在“思考”模式(生成显式思维过程)与“非思考”模式(直接作答)之间切换。

模型的代理能力通过可扩展的代理中训练过程进一步增强。该过程利用数据构建方案,在数学、编程和工具使用领域合成多样且丰富的轨迹,生成丰富复杂的解题路径。训练数据旨在模拟现实世界软件问题,包括故障定位、重构和过程修改,用于生成多样化任务实例。模型被训练执行原子任务分解、反馈增强规划和行动执行,并包含一个反馈循环,包含反思生成器和评估器。该过程使模型能有效内化规划与反思行为,使其能够执行包含分析、规划、反馈和行动的完整代理循环,而非仅进行逐步计算。模型处理复杂多步任务的能力通过其在代理专用基准测试中的表现得到验证,显著超越现有 SOTA 基线。

实验

- 多阶段预训练验证了“常识-STEM-代理”设计原则的有效性,阶段式数据推进(常识 → STEM/编程 → 长上下文 → 代理轨迹)带来模型能力的提升。在 10.84 万亿 token 上使用 20 亿参数训练,采用 1200 万全局批量大小和 4e-4 初始学习率,实现最佳稳定性,代理中训练(第 4 阶段)带来显著性能提升。

- 训练动态分析确认 FP16 精度比 BF16 更好地保持训练-推理一致性,减少数值漂移,使数学和编程基准上持续获得性能提升。使用 KL 散度阈值(τ = 0.01)进行一致采样,通过过滤高漂移提示提升训练稳定性。

- Youtu-LLM 2B Base 在通用基准测试中优于同类规模基线:MMLU-Pro 达 78.4%,MATH 达 82.1%,BBH 达 85.3%,LongBench v2 达 76.2%,超越 Qwen3-1.7B 和 SmolLM3-3B,接近 Qwen3-4B 性能。

- Youtu-LLM 2B Instruct 模型在指令遵循、编程(HumanEval pass@1: 72.1%)和文本推理(DROP F1: 78.3%)方面超越同类规模模型(如 Qwen3-1.7B、SmolLM3-3B),甚至优于更大的 DeepSeek-R1-Distill-Llama 8B,展现出轻量级 LLM 设计的强大效率。

- 代理中训练显著提升代理能力:Youtu-LLM 2B Base 在 APTBench 上得分接近 Qwen3-4B Base(平均 38.6% vs. 40.5%),在六个代理基准上平均提升 14.4%。代理中训练(AMT)使 SWE-Bench-Verified 的 pass@1 解决率提升 42.7%。

- 消融研究确认轨迹数据的价值:代理式 CoT 数据使规划能力提升 17.8%(65.1% → 82.9%),数学轨迹数据在超过 3 倍上采样后性能趋于饱和,深度研究轨迹数据与其他数据产生强协同效应,缩小与 Qwen3-4B-Base 的差距。

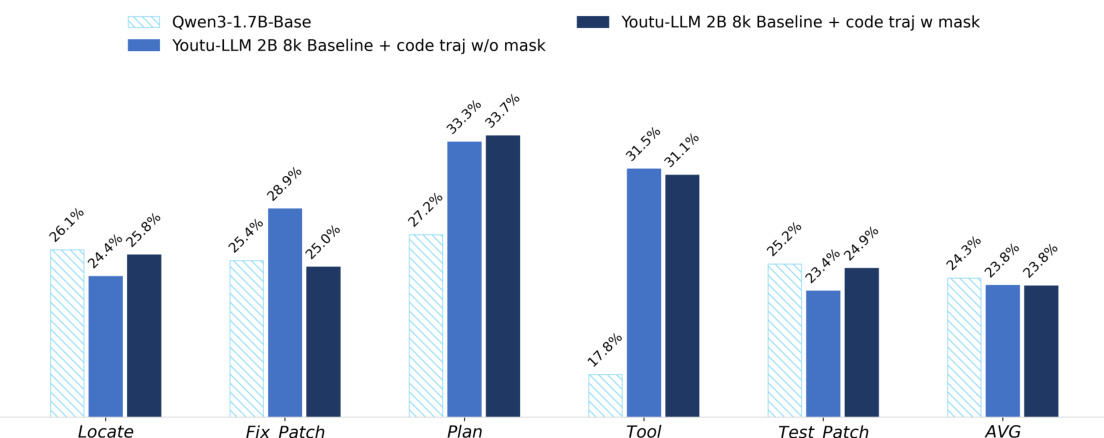

- 在轨迹数据中屏蔽非助手对话(如系统提示、工具输出)能持续提升推理与行动性能,尤其在深度研究和数学任务中,通过减少噪声并聚焦于内部推理轨迹,显著提升学习效果。

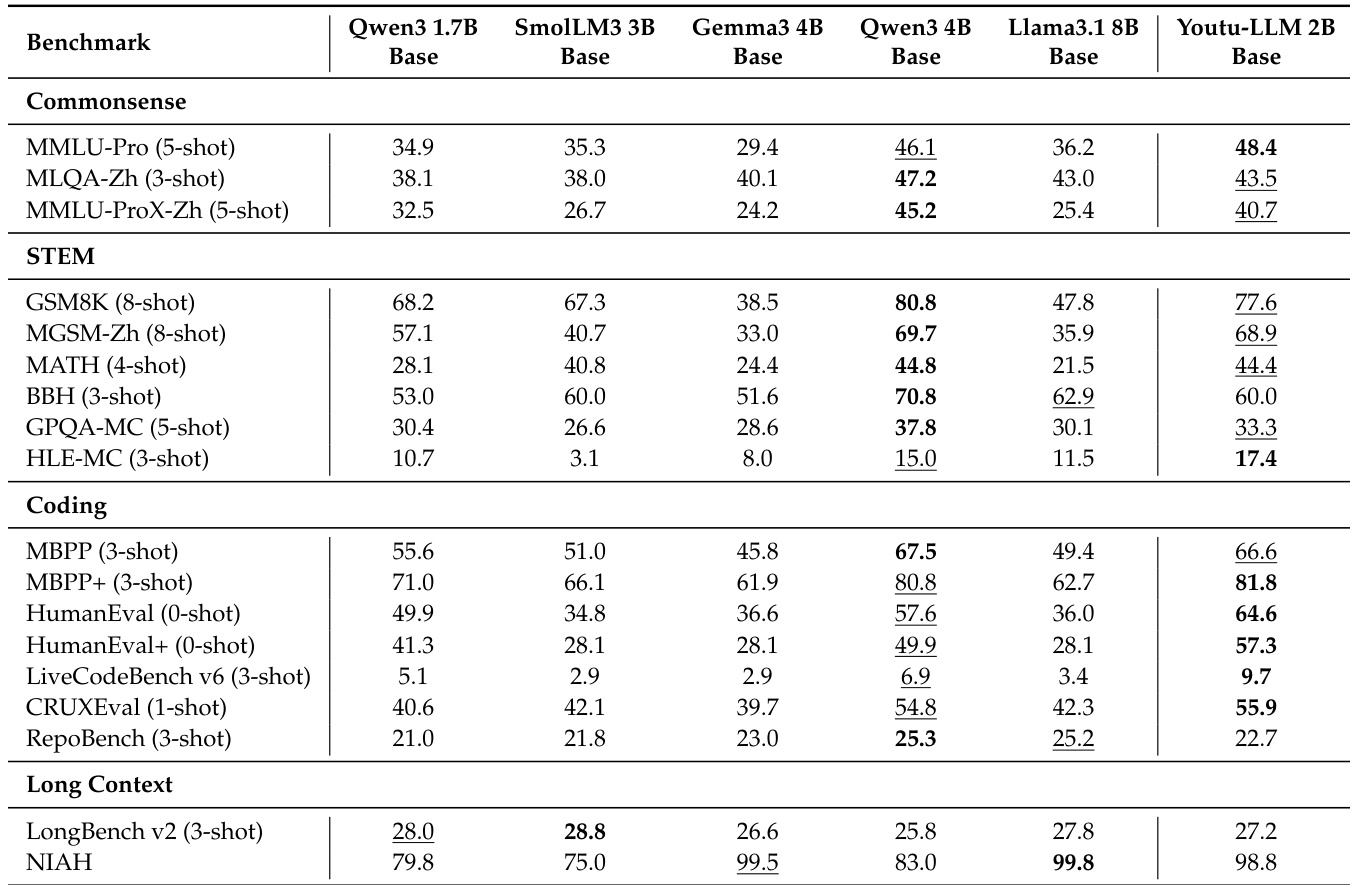

作者采用多阶段预训练方法开发 Youtu-LLM 2B Base,重点逐步提升常识、STEM、编程和长上下文推理能力。结果表明,Youtu-LLM 2B Base 在所有评估维度上显著优于同类规模的基线模型,在编程和长上下文任务中表现尤为突出,与 Qwen3-4B Base 等更大模型相比具有竞争力。

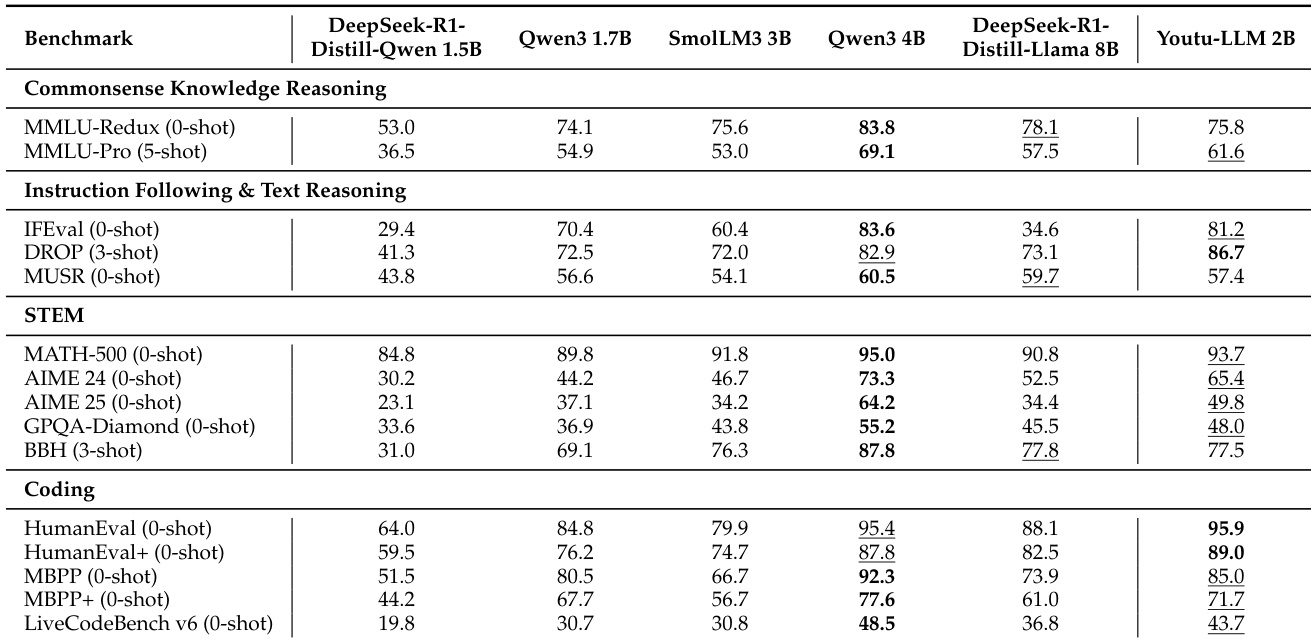

作者采用多阶段预训练方法开发 Youtu-LLM 2B,重点逐步提升常识推理、STEM、编程和长上下文理解能力。结果表明,Youtu-LLM 2B 在指令遵循、文本推理和编程基准测试中表现优异,超越同类规模模型,并接近 Qwen3-4B 等更大模型的性能。

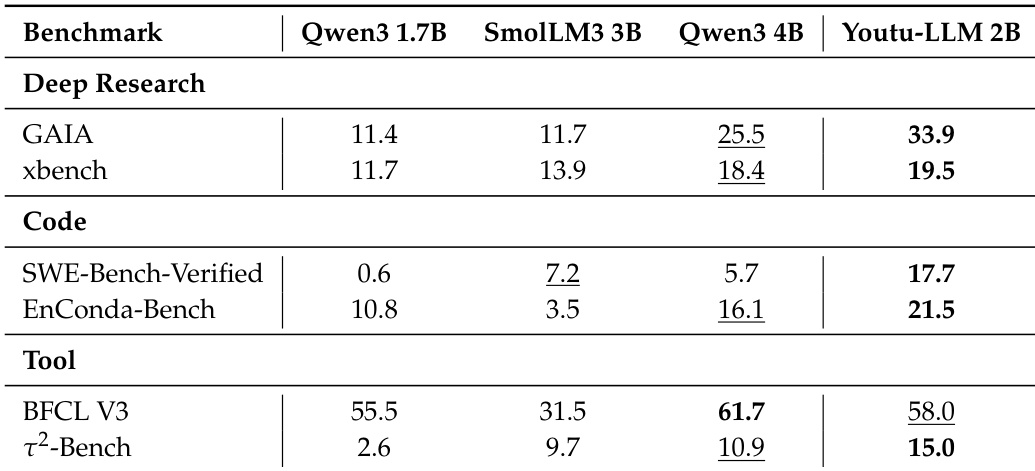

作者在代理基准测试(包括深度研究、代码和工具任务)中将 Youtu-LLM 2B 与多个同类规模及更大模型进行对比。结果表明,Youtu-LLM 2B 超越所有更小模型,并在与更大模型的对比中表现具有竞争力,尤其在工具使用和编程能力方面表现突出。

作者比较了在代码轨迹训练中屏蔽非助手内容对 Youtu-LLM 2B 模型的影响。结果表明,屏蔽策略在多数指标上提升性能,其中规划(33.3% vs. 33.7%)和工具(31.5% vs. 31.1%)提升最为显著。应用屏蔽后,平均得分从 23.8% 提升至 24.9%,表明聚焦于模型的推理与行动组件可有效增强整体代理编程能力。

作者采用多阶段预训练方法构建 Youtu-LLM 2B,融合来自常识、STEM、编程和代理领域的数据,逐步增强模型能力。结果表明,Youtu-LLM 2B 在通用和代理基准测试中与 Qwen3-4B 等更大模型相比表现具有竞争力,尤其在编程和指令遵循方面,尽管参数量更少。